论文解读:Rethinking vision transformer through human–object interaction detection

本文提出R3ViT用于HOI detection,它仅仅基于标准ViT做了一些小小的优化:

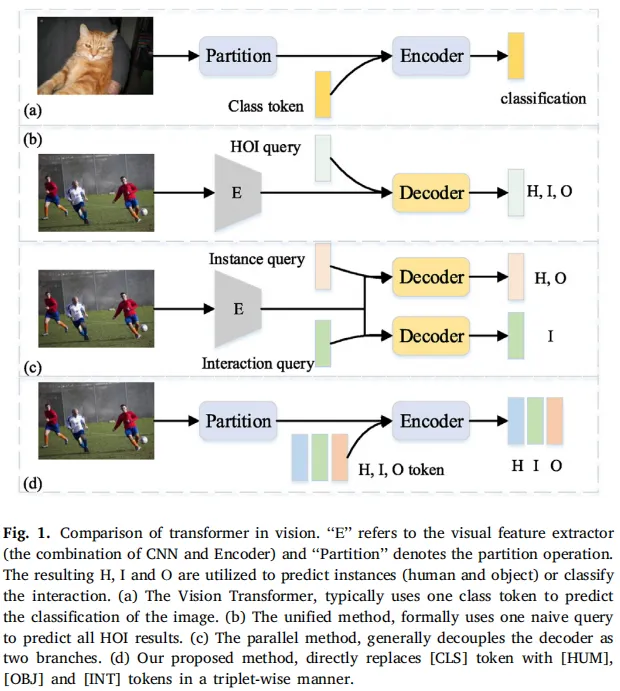

- 将CLS token替换为三个附加的relationship semantics carrier (RSC) tokens,即[HUM], [OBJ], [INT] token,如图1(d)所示;(本文最大的创新点,可以说大道至简)

- 将ViT中的图像分类损失替换为二分图匹配损失;

与现有的多数用Transformer处理低级视觉任务的工作不同,本文试图将Vision Transformer扩展到更具挑战性的区域级关系推理任务。实验结果表明,只需轻微调整Vision Transformer的结构和使用所提出的RSC tokens,就能实现一个强大的baseline。

此外,本文方法与最近的研究工作的关键区别在于“是否将输入图像分割为一系列不重叠的patches”。本文的R3ViT属于单阶段方法,并保留了Vision Transformer和集合预测的优势。

在关于RSC tokens参数的实验中,无论RSC tokens在训练过程中学习得好不好,都不会对模型在evaluation时的表现产生太大的影响,说明RSC tokens仅仅是作为信息交互的桥梁,它的参数是否学得好无关紧要。甚至在做测试时,将RSC tokens的参数重新随机初始化也没问题。这个就非常有意思了。

在论文的最后一段,作者阐述了一下本文模型所存在的缺点:

首先是Transformer组件在处理图像特征图时的缺陷:注意力模块对特征图中的所有像素施加了几乎一致的注意权重。这个我觉得说的不是很合适,因为在Deformable DETR论文中也提到了类似的一点,但他们说的是在初始化时会对所有像素施加几乎一致的注意力权重。

其次是对多尺度特征的不敏感,普通的patch embedding方法忽略了不同物体在空间尺度上的大小差异。

作者给出了改进的方向:一个能学习稀疏空间采样和多尺度特征的注意力模块,可以提高性能。感觉就是在说Deformable DETR。