MiniCPM-o 2.6 小参数挑战巨头 多模态直播流直达手机

传送锚点

- 性能超越 效率惊人

- 全能多模态能力

- 架构创新与部署便捷

AI前沿动态聚焦 OpenBMB 最新力作 MiniCPM-o 2.6 模型以仅 80 亿参数的体量,在多项基准测试中展现出与 GPT-4o 202405 GPT-4V Claude 3.5 Sonnet Gemini 1.5 Pro 等专有大型模型相媲美甚至超越的性能,尤其令人瞩目的是其在手机端实现多模态直播流的能力。

性能超越 效率惊人

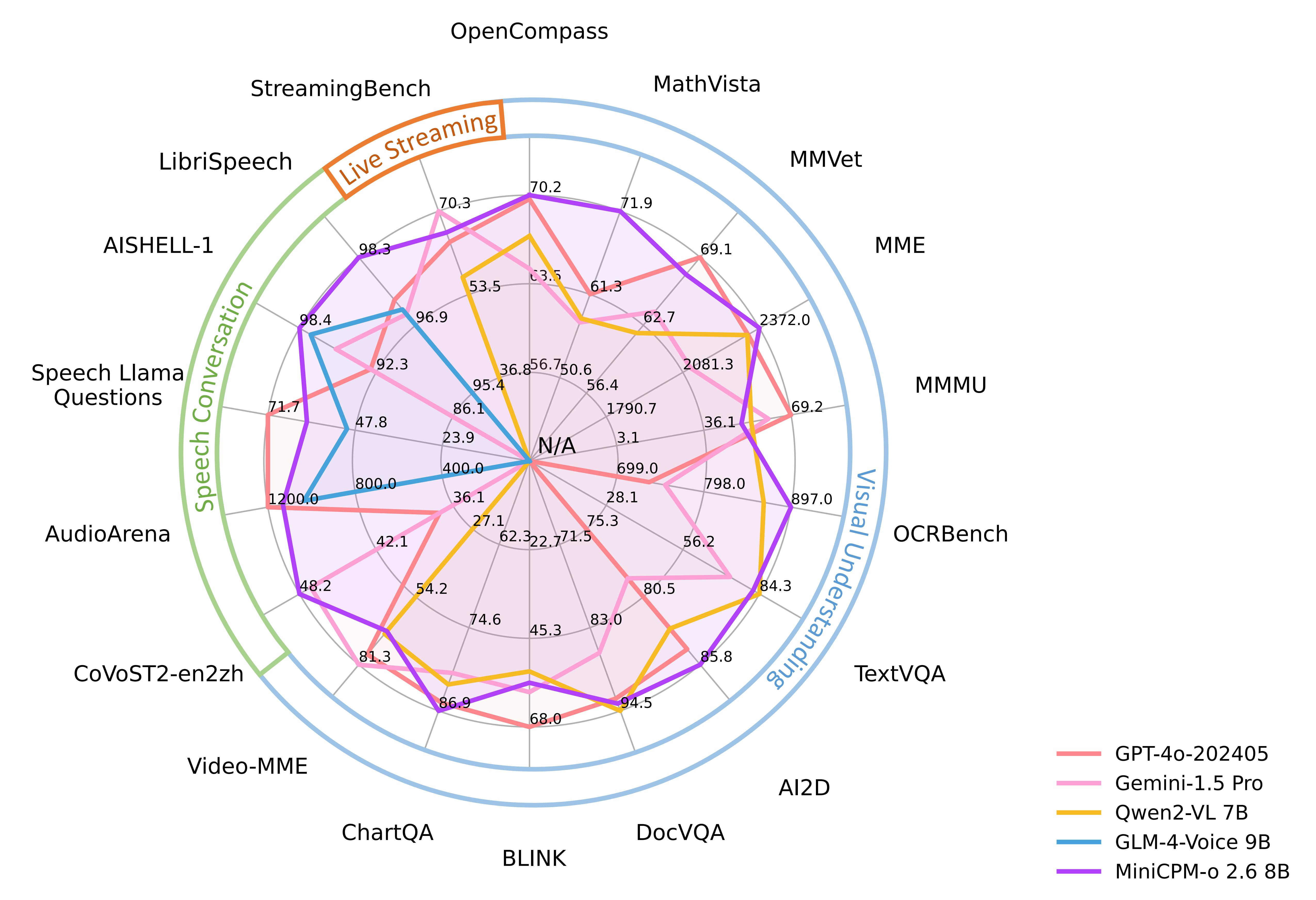

MiniCPM-o 2.6 在OpenCompass综合评估中取得了 70.2 的平均分,在单图像理解方面超越了 GPT-4o 202405 Gemini 1.5 Pro 和 Claude 3.5 Sonnet。 在多图像和视频理解方面,它也表现出色,优于 GPT-4V 和 Claude 3.5 Sonnet。

更令人惊喜的是其在 OCRBenchmark 上的表现,该模型在 25B 参数以下的模型中达到 SOTA 水平,甚至超越了 GPT-4o 202405。

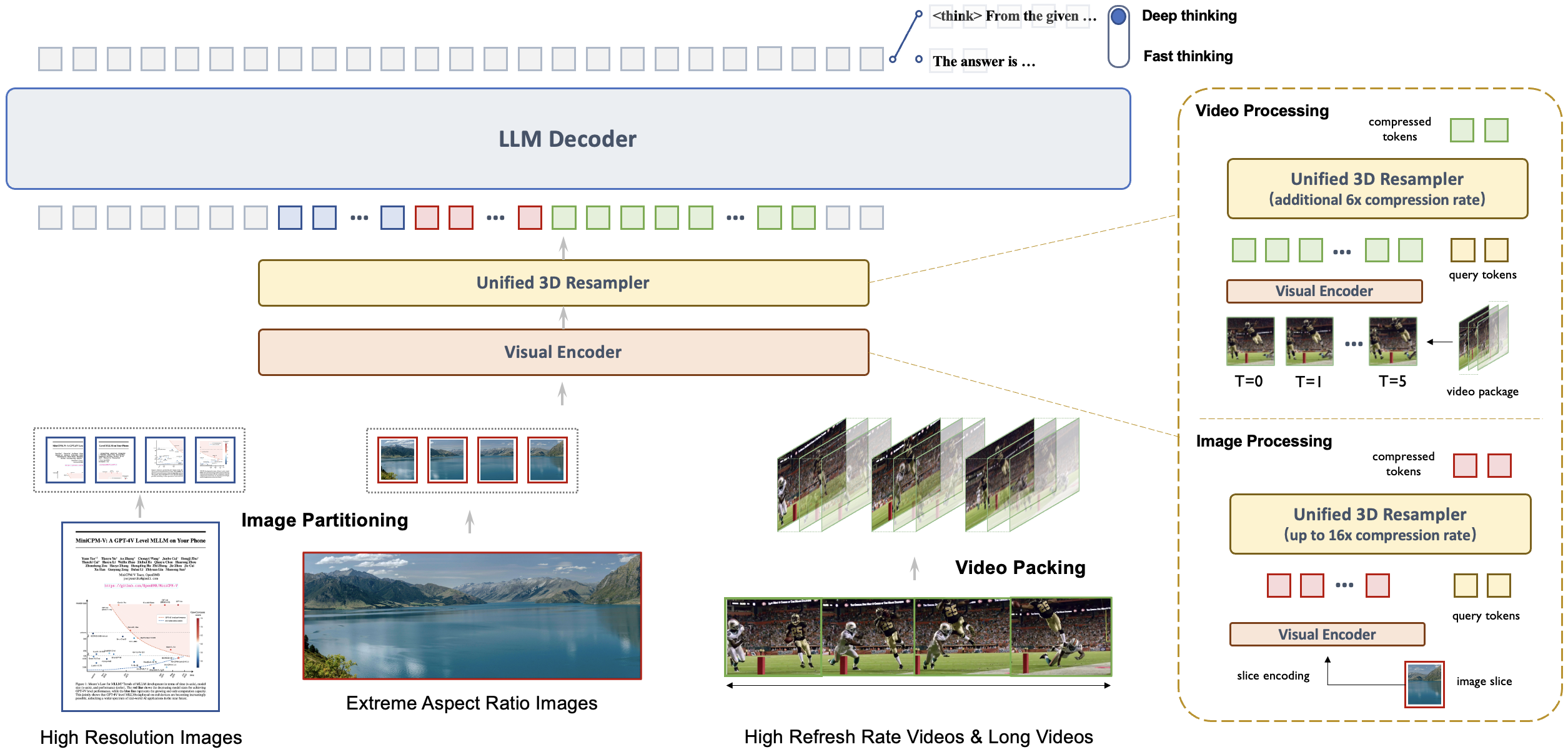

这种高性能与小体量的结合,得益于其卓越的效率。MiniCPM-o 2.6 拥有先进的 token 密度技术,处理 180 万像素图像仅需 640 个 token,比大多数模型减少 75%。 这直接带来了更快的推理速度、更低的首次 token 延迟、更少的内存占用和功耗,使其能够高效支持 iPad 等终端设备上的多模态直播流。

全能多模态能力

该模型不仅视觉能力出众,语音交互方面也达到了前沿水平。MiniCPM-o 2.6 支持中英双语实时语音对话,并能配置多种音色。 在音频理解任务比如 ASR 和 STT 翻译上,它超越了 GPT-4o-realtime。 它还支持情感 语速 风格控制、端到端语音克隆、角色扮演等趣味功能。

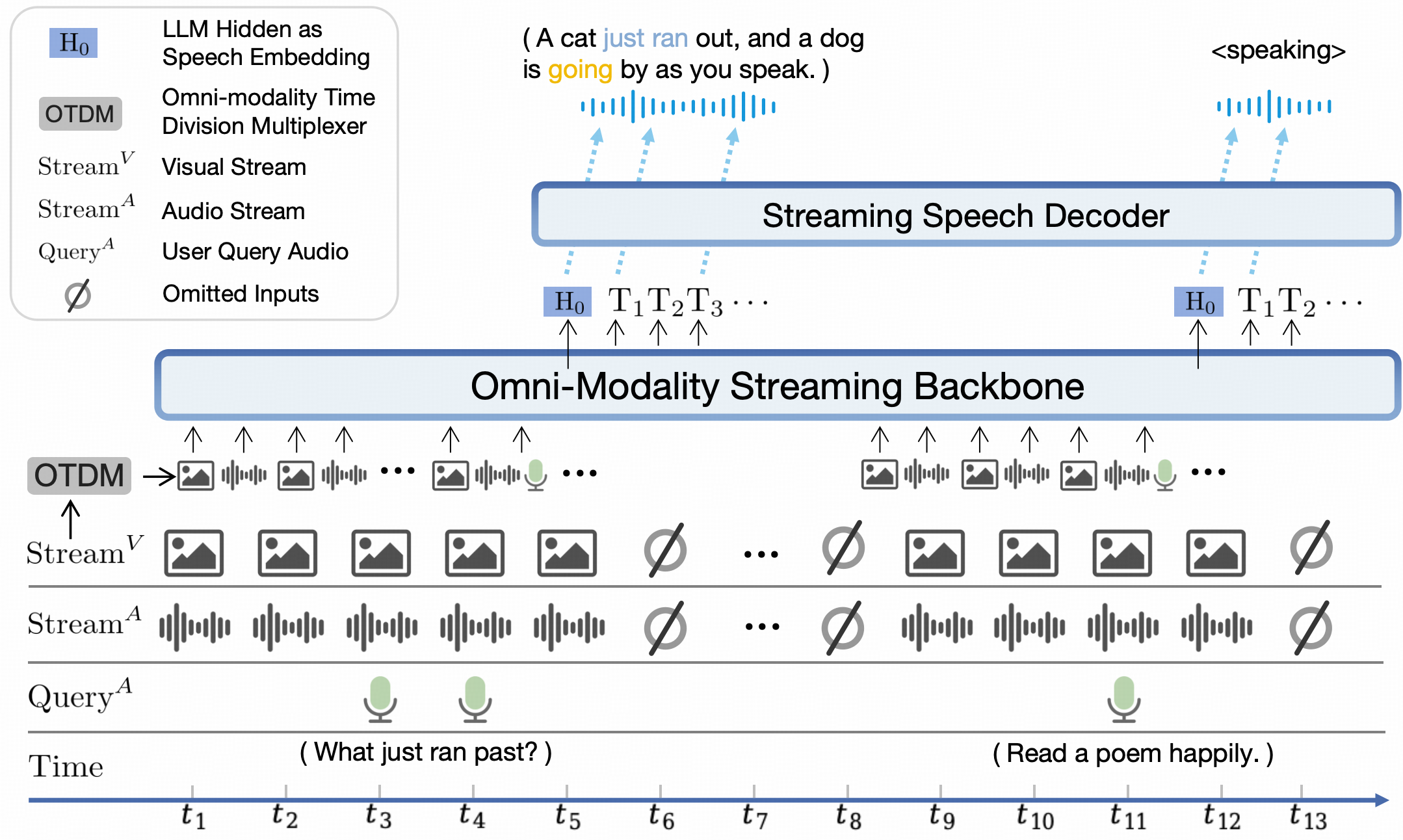

作为一项新特性,MiniCPM-o 2.6 能够独立于用户查询,接收连续的视频和音频流,并支持实时语音交互。 在 StreamingBench 实时视频理解、全源理解和多模态上下文理解的综合基准测试中,其性能超越了 GPT-4o 202408 和 Claude 3.5 Sonnet。

架构创新与部署便捷

MiniCPM-o 2.6 采用端到端全模态架构,将不同模态的编码器 解码器无缝连接,充分利用丰富的多模态知识。 特别设计的全模态直播流机制,将并行多模态流分割成小周期时间片内的顺序信息,确保实时处理。 可配置的语音建模设计,通过文本和音频系统提示词,实现推理时灵活的语音配置,甚至支持端到端语音克隆。

对于开发者和AI爱好者,MiniCPM-o 2.6 提供了极其便捷的使用方式。 它支持 llama.cpp 进行本地 CPU 推理,提供 int4 和 GGUF 格式的量化模型,并通过 vLLM 实现高吞吐量和内存高效推理。 此外,还支持使用 LLaMA-Factory 进行微调,以及通过 Gradio 快速搭建本地 WebUI 演示。

用户可以通过 GitHub 页面 https://github.com/OpenBMB/MiniCPM-o

或在线演示 https://minicpm-omni-webdemo-us.modelbest.cn/ 体验模型强大功能。

MiniCPM-o 2.6 的发布,再次证明小型高效模型也能在关键性能上与大型专有模型一较高下,尤其是在终端设备上实现复杂多模态实时交互,这无疑为未来 AI 应用的普及开辟了新的道路。