LASSO框架(Belloni高维估计微课笔记)

文章目录

- 课程内容

- 低维简单设定

- 高维问题

| Type | Notes |

|---|---|

| Title | High Dimensional Estimation: From foundations to Econometric Models |

| Instructor(s) | Alexandre Belloni |

| Year | 2014 |

| Level | Graduate |

| Location | ERPEM 14 |

| Lecture(s) | L01 / 6 |

ERPEM(Encuentro Regional de Probabilidad y Estadística Matemática)应该是一个拉丁美洲地区性的会议即Regional Meeting on Probability and Mathematical Statistics,2014年是第10届。本课程是该会议上的一次minicourse。

Belloni老师当时还是Duke的副教授,现在已经是杰出教授,并同时在Amazon任职。他于2006年在MIT拿到运筹学博士学位,师从Robert Michael Freund。截至目前,已经发表了2篇Econometrica,1篇RES,8篇AoS,1篇JRSSB,2篇JASA,4篇JoE,5篇OR,2篇Biometrika。

课程内容

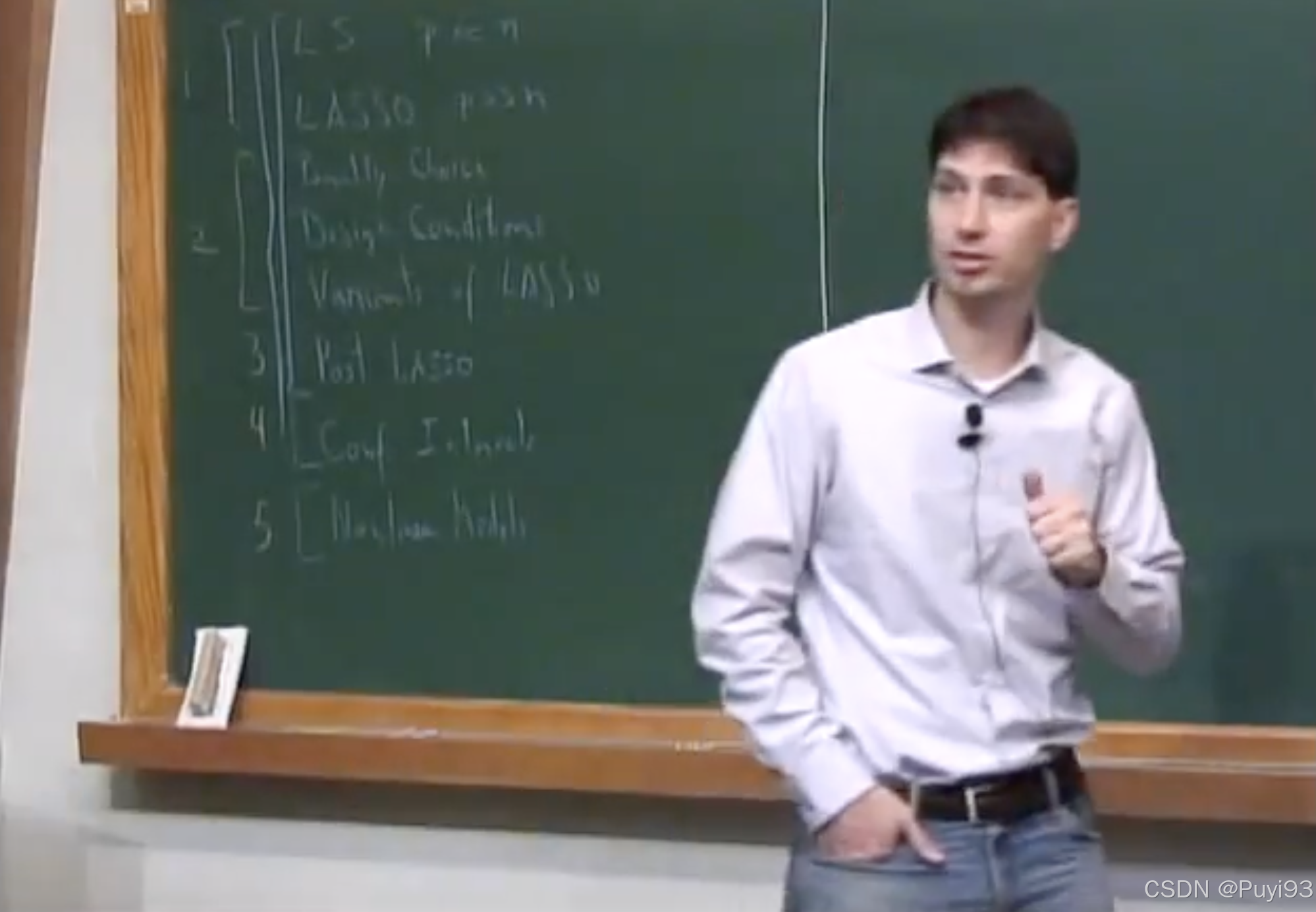

老师似乎是左撇子?

课程内容:

- LS

- LASSO

- Penalty

- Disign

- Variants

- Post LASSO

- C.I.

- Nonlinear

低维简单设定

假设DGP为

y = X β ∗ + ϵ y = X\beta^* + \epsilon y=Xβ∗+ϵ

共 N N N个i.i.d.数据, X ∈ R N × p X\in\mathbb{R}^{N\times p} X∈RN×p。我们从简单的情况开始,假设固定设计,并且homoscedasticity,即 E ϵ i = 0 \mathbb{E}\epsilon_i=0 Eϵi=0, E ϵ i 2 = σ 2 \mathbb{E}\epsilon_i^2=\sigma^2 Eϵi2=σ2。这里先考虑 N > p N>p N>p的情形。

做LS,由最优化条件,必有基本不等式

1 N ∥ y − X β ^ ∥ 2 2 ≤ 1 N ∥ y − X β ∗ ∥ 2 2 \frac{1}{N} \|y-X\hat{\beta}\|_2^2 \leq \frac{1}{N} \|y-X{\beta^*}\|_2^2 N1∥y−Xβ^∥22≤N1∥y−Xβ∗∥22

代入DGP后,可以整理为

1 N ∥ X ( β ^ − β ∗ ) ∥ 2 2 ≤ 2 N ϵ T X ( β ^ − β ∗ ) \frac{1}{N} \|X(\hat{\beta}-\beta^*)\|_2^2 \leq \frac{2}{N} \epsilon^T X (\hat{\beta}-\beta^*) N1∥X(β^−β∗)∥22≤N2ϵTX(β^−β∗)

可以发现:RHS与噪声有关,如果噪声为 0 0 0,左侧必等于 0 0 0,也就是 β ^ \hat{\beta} β^会与真实参数在某种意义上接近,而要将这个“某种意义上接近”,转化为真正的接近,从而恢复出真实信号,需要LHS中的数据 X X X是well-behaved,这就是identification问题。

对RHS用Cauchy–Schwarz,放大为 ( 2 / N ) ∥ X T ϵ ∥ 2 ∥ β ^ − β ∗ ∥ 2 (2/N) \|X^T \epsilon\|_2 \|\hat{\beta}-\beta^*\|_2 (2/N)∥XTϵ∥2∥β^−β∗∥2,其中 ∥ X T ϵ ∥ 2 \|X^T \epsilon\|_2 ∥XTϵ∥2是一个与数据和噪声同时相关的随机变量,可以用Chebyshev不等式bound它:首先利用homoscedasticity假设,有

E ∥ X T ϵ ∥ 2 2 = tr [ X T E ( ϵ ϵ T ) X ] = σ 2 tr ( X T X ) ≤ σ 2 p λ 1 ( X T X ) \mathbb{E} \|X^T \epsilon\|_2^2 = \operatorname{tr} [X^T \mathbb{E} (\epsilon\epsilon^T) X] = \sigma^2 \operatorname{tr}(X^T X) \leq \sigma^2 p \lambda_1(X^T X) E∥XTϵ∥22=tr[XTE(ϵϵT)X]=σ2tr(XTX)≤σ2pλ1(XT