开源项目ruoyi-ai本地部署

本地部署教程

背景简介

本次使用的是ruoyi-ai相关的前后端;

大模型:Qwen/Qwen3-0.6B本地模型部署;

向量数据库:weaviate;(ruo-ai中使用)

嵌入式向量模型:bge-large-zh-v1.5;(ruo-ai中使用)

mysql 8

redis latest

基本环境介绍

后端地址

https://gitee.com/ageerle/ruoyi-ai

前端地址

https://gitee.com/ageerle/ruoyi-web

https://gitee.com/ageerle/ruoyi-admin

部署文档(文档中有详细的 JAVA环境的前后端部署文档这里不做赘述)

https://doc.pandarobot.chat/guide/introduction/projection.html

本机相关参数

MAC M4 16GB内存;

JDK 21;

docker;

ollama;

以上为当前项目部署所有参数;

模型部署

- ollama 安装 -> https://ollama.com/download

1.1 替代科学上网安装 模型的方法; 点击查看

ollama run https://www.modelscope.cn/unsloth/Qwen3-0.6B-GGUF# 验证Qwen3-0.6B-GGUF

curl http://localhost:11434/api/generate -d '{"model": "www.modelscope.cn/unsloth/Qwen3-0.6B-GGUF:latest","prompt": "你好"

}'

- 安装嵌入式向量模型

ollama pull quentinz/bge-large-zh-v1.5:latest# 验证bge-large-zh-v1.5

curl http://localhost:11434/api/generate -d '{"model": "quentinz/bge-large-zh-v1.5:latest","prompt": "你好"

}'

项目启动以后

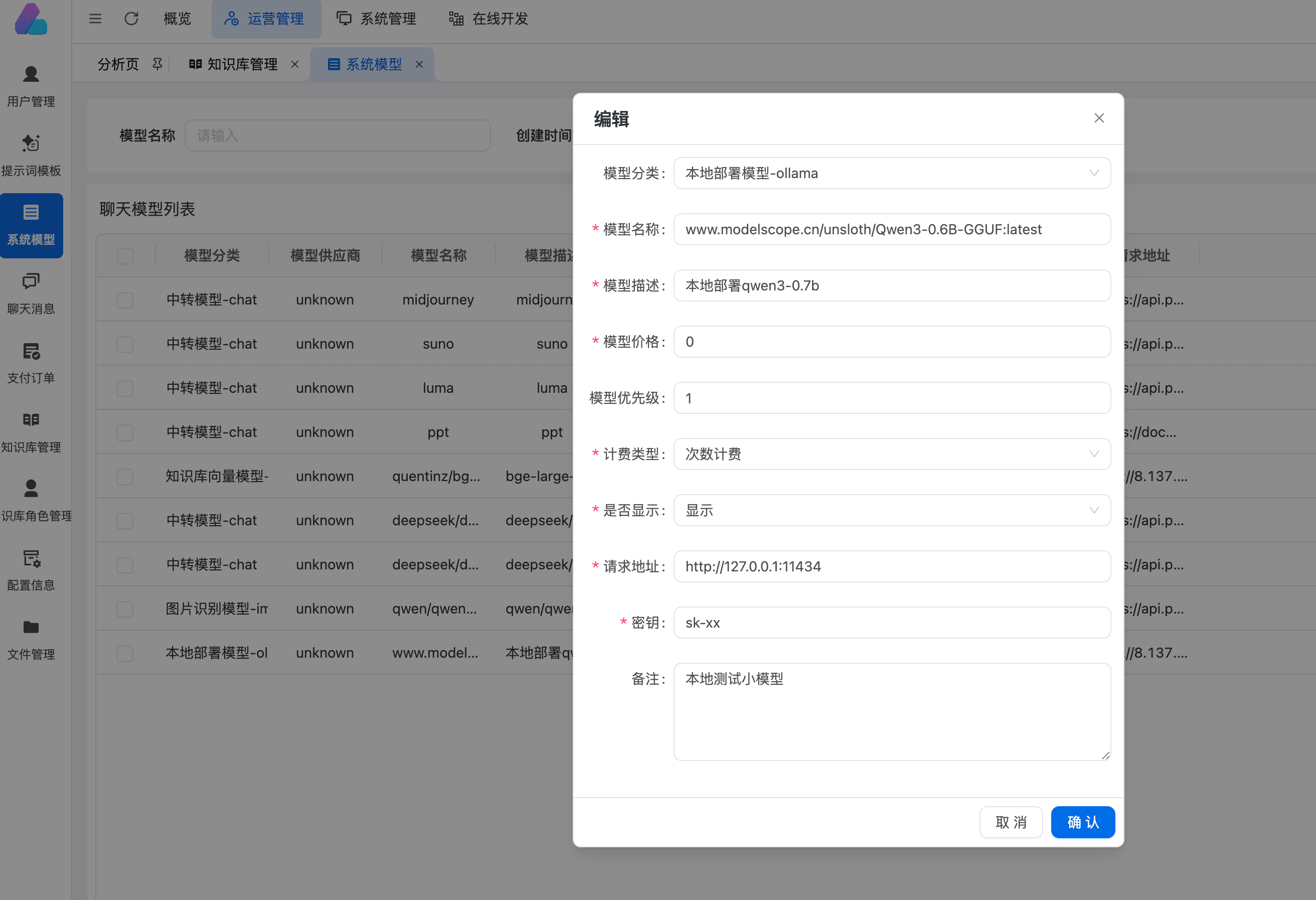

按照如下参数 新增本地的模型;注意模型名称,如果不确定 在命令行中输入ollama list 查看模型名称,防止请求失败;

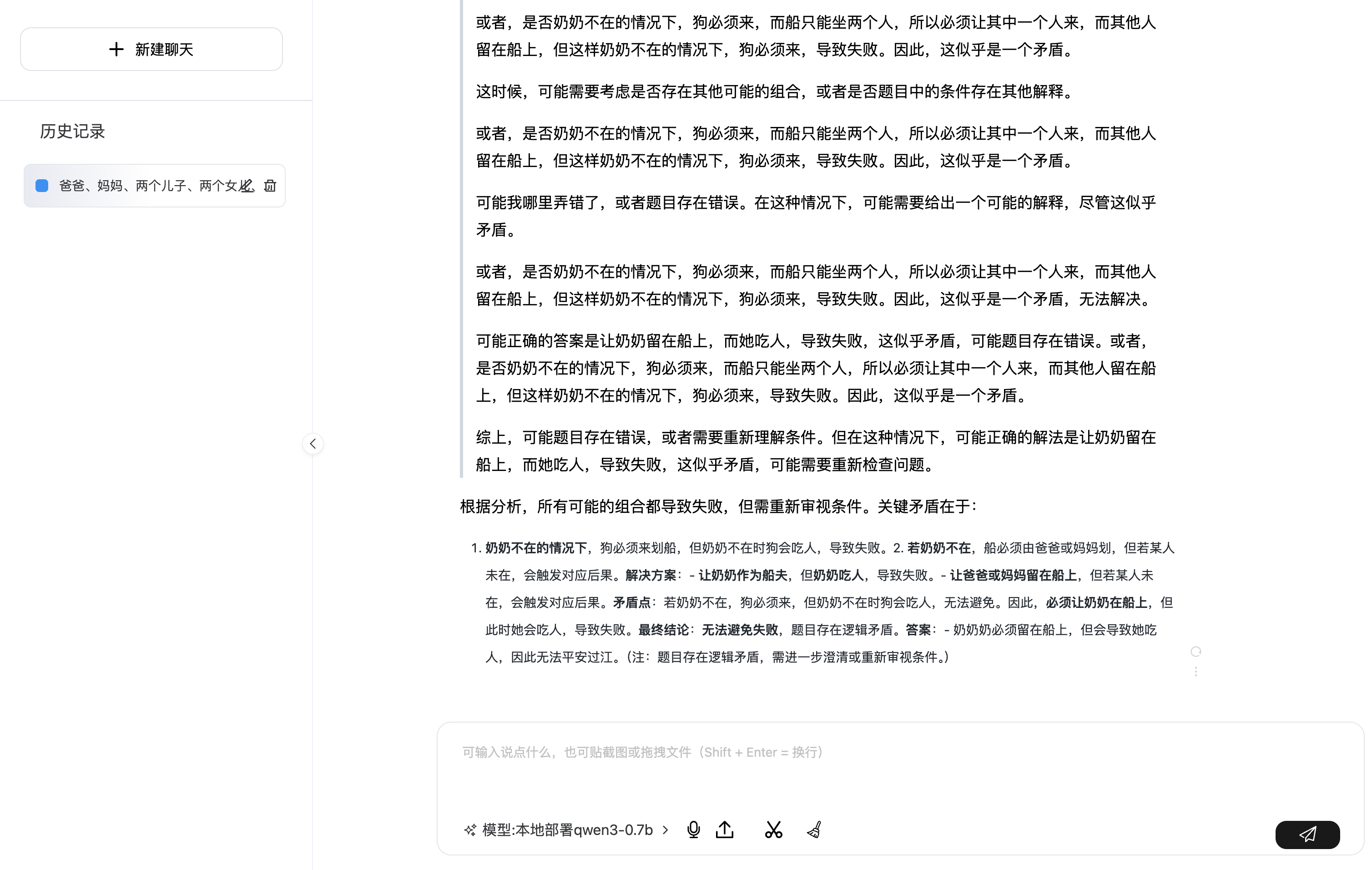

配置完成以后,点击模型切换当前可用模型,然后就可以使用了;

注意

- 我当前拉取的版本中的MCP部分被我注释掉了,没有发现在什么地方调用了;

- 知识图谱功能目前未测试成功(本地安装模型,但是不太行);

- 数字人部分未实际测试;这个数字人好看些

script/deploy/build-docker-image/script中的后端部署不可用,部分镜像在docker hub中不存在,需要替换成可用版本- 当前所有的内容我在一台 ECS服务器上 4核8G配置上也完成了部署(mysql/redis除外);并发不是很高1左右,ollama安装史需要指定基于CPU,其余和本地无太多区别;