Sora:视频生成的突破与启示

OpenAI发布的文本条件视频生成模型Sora凭借“生成一分钟高清视频”的惊人表现引爆AI领域。其背后的技术报告《Large-Scale Training of Text-Conditional Video Generation Models》虽未披露完整的模型实现细节,甚至没有给出完整的框架图,却为我们揭示了视频生成规模化发展的核心逻辑。

原文链接:Video generation models as world simulators | OpenAI

一、研究背景:视频生成的“规模化困局”与破局思路

在Sora出现之前,视频生成领域已积累了大量研究成果,涵盖循环网络、生成对抗网络(GAN)、自回归Transformer、扩散模型等多种技术路径。然而,这些研究普遍面临一个核心瓶颈——场景局限性:多数模型仅能处理特定类型的视觉数据,要么只能生成短时长视频,要么受限于固定的分辨率和宽高比,难以适配真实世界中多样化的视觉内容需求。

OpenAI的研究团队敏锐地意识到,语言模型的规模化成功或许能为视频生成提供借鉴。大型语言模型(LLM)之所以能具备通用能力,关键在于其通过“文本token”将代码、数学公式、自然语言等多样化文本模态统一为一致的表示形式,从而实现了互联网规模数据的高效训练。那么,视频生成能否找到类似的“统一表示”,打破数据多样性与规模化训练之间的壁垒?这正是Sora研究的核心出发点。

基于此,Sora确立了两大研究目标:一是构建一种能将所有类型视觉数据(不同时长、分辨率、宽高比的视频和图像)转化为统一表示的方法,支撑大规模训练;二是系统评估该方法训练出的模型(即Sora)的能力与局限。这份技术报告也围绕这两大目标展开。

二、核心框架:视觉图像块(Visual Patches)驱动的统一表示体系

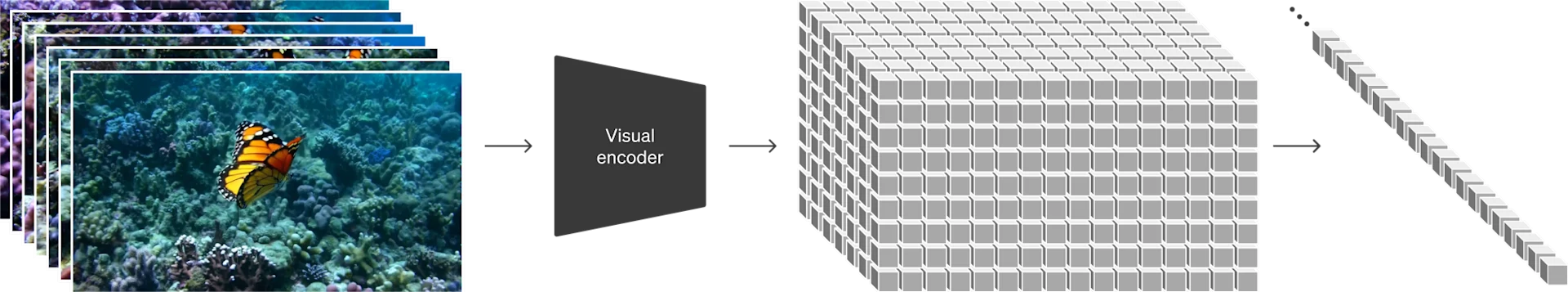

Sora的突破首先源于其创新性的视觉数据表示方法——将视频和图像统一转化为“时空图像块(Spacetime Patches)”,这一思路类比于LLM中的文本token,为规模化训练奠定了基础。整个表示体系的构建分为两个关键步骤:视频压缩网络与时空图像块提取。

2.1 视频压缩网络:降维与高效表征

直接对原始视频进行处理面临着巨大的计算成本——视频包含空间(像素)和时间(帧)双重维度的信息,数据量远超图像。为解决这一问题,Sora首先训练了一个视频压缩网络,将原始视频映射到低维的 latent 空间。

该压缩网络具备两大核心功能:一是空间维度的压缩,减少像素级冗余;二是时间维度的压缩,提取帧序列中的关键时序信息。值得注意的是,Sora的训练和生成过程均在这个压缩后的 latent 空间中进行,大幅降低了计算开销。同时,研究团队还训练了一个对应的解码器,用于将生成的 latent 表示重新映射回像素空间,形成“压缩-生成-解码”的完整链路。

这一设计借鉴了 latent 扩散模型(如Stable Diffusion)的成功经验,但针对视频的时序特性进行了优化,确保压缩过程中不会丢失关键的时空动态信息。

2.2 时空图像块提取:统一视频与图像的“通用token”

在获得压缩后的 latent 表示后,Sora进一步将其分解为时空图像块序列,这些图像块便成为了Transformer模型的输入token。这一设计的巧妙之处在于,它天然地实现了视频与图像的统一:图像本质上可以看作是“单帧视频”,同样可以被提取为时空图像块(仅时间维度长度为1)。

这种图像块化表示带来了三大核心优势:

-

适配多样化数据:无论输入视频的时长(从单帧图像到一分钟视频)、分辨率(从低清到高清)还是宽高比(横屏、竖屏、方屏),都能通过调整图像块的数量和排列方式转化为统一的序列输入,彻底打破了传统模型对数据格式的限制;

-

兼容Transformer架构:图像块序列与文本token序列的结构一致性,使得成熟的Transformer架构能够直接复用,为模型规模化提供了可能。

-

灵活的生成控制:推理阶段,只需通过调整随机初始化图像块的网格大小,就能控制生成视频的分辨率、时长和宽高比,实现“一次训练,多样生成”;

三、模型架构:规模化扩散Transformer的视频生成实践

有了统一的视觉图像块表示,Sora选择了扩散Transformer(Diffusion Transformer,DiT)作为核心生成架构。这一选择并非偶然——Transformer在语言建模、计算机视觉、图像生成等多个领域都展现出了卓越的规模化特性,而扩散模型则凭借其生成质量高、稳定性强的优势,成为图像和视频生成的主流技术路径。Sora的创新在于,将两者结合并针对视频生成场景进行规模化优化,验证了扩散Transformer在视频领域的规模化潜力。

3.1 扩散过程:从噪声到视频的迭代生成

Sora的生成逻辑遵循扩散模型的基本原理:首先初始化一组随机噪声图像块,然后在文本提示(Text Prompt)的条件约束下,通过Transformer模型迭代预测“干净”图像块与当前噪声图像块之间的差异,逐步去噪直至生成符合要求的视觉图像块序列,最后通过解码器转化为视频。

与传统扩散模型不同的是,Sora的扩散过程完全在时空图像块序列上进行,模型需要同时学习空间维度的视觉内容生成和时间维度的动态连贯性建模。文本提示的条件信息通过交叉注意力机制融入Transformer中,确保生成的视频与文本描述精准匹配。

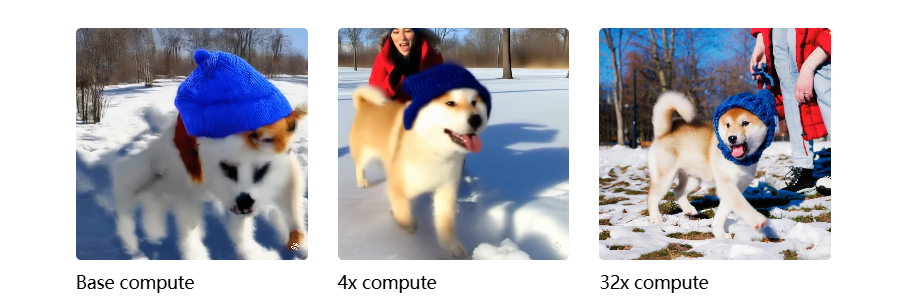

3.2 规模化验证:计算量与生成质量的正相关

报告中一个关键发现是:扩散Transformer在视频生成领域同样具备显著的规模化效应。研究团队通过控制训练计算量(从基础计算量到32倍基础计算量),对比了相同种子和输入条件下的视频生成质量。结果显示,随着训练计算量的增加,视频的清晰度、细节丰富度、动态连贯性均有显著提升。

具体来看:

-

基础计算量模型生成的视频存在明显的模糊、细节缺失和动态不连贯问题;

-

4倍计算量模型的生成质量大幅提升,主体轮廓清晰,但仍有局部细节瑕疵;

-

32倍计算量模型(即Sora)能够生成高清、细节丰富的视频,人物动作、物体运动均表现出良好的自然性。

这一结果印证了研究团队的核心假设:规模化训练是突破视频生成质量瓶颈的关键路径,而统一的视觉图像块表示则为规模化训练提供了必要的基础。

四、核心能力:从多样化生成到跨模态交互

基于统一表示体系和规模化扩散Transformer,Sora展现出了一系列超越前代模型的核心能力,涵盖多样化生成、精准语言理解、跨模态交互等多个维度。

4.1 多样化生成:打破格式限制的灵活创作

传统视频生成模型往往需要将数据统一resize、裁剪或修剪到固定格式(如256x256分辨率、4秒时长),这不仅丢失了原始数据的信息,还限制了生成结果的多样性。Sora通过“原生尺寸训练”策略解决了这一问题——直接使用不同格式的原始数据进行训练,无需预处理统一格式。

这一策略带来了两大显著优势:

-

采样灵活性:Sora能够直接生成不同宽高比(1920x1080p widescreen、1080x1920竖屏等)、不同分辨率和不同时长的视频,可直接适配手机、电脑、电视等不同设备的显示需求。同时,用户还可以先生成低分辨率原型进行快速迭代,再生成高清版本,大幅提升创作效率;

-

构图质量提升:实验对比显示,将训练数据统一裁剪为正方形的模型,常出现主体部分出镜的问题;而Sora由于保留了原始数据的构图信息,生成视频的 framing(取景)和 composition(构图)质量显著更优,主体完整且布局合理。

4.2 语言理解:从文本到视频的精准映射

文本条件视频生成的核心挑战之一是“语言-视觉对齐”——确保生成的视频精准匹配文本描述的细节。Sora通过两大技术策略实现了高效的语言理解:

-

高质量重新描述(Re-captioning):视频-文本配对数据的质量直接影响模型的对齐效果。Sora借鉴了DALL·E 3的技术,首先训练了一个高描述性的字幕生成模型,为训练集中的所有视频生成详细字幕(而非简单标签),确保模型能学习到文本与视频细节的对应关系;

-

提示词扩展(Prompt Expansion):类似DALL·E 3,Sora会利用GPT将用户输入的简短提示词扩展为详细的描述性字幕,补充场景、动作、风格等细节信息,从而提升生成视频与用户意图的匹配度。

例如,用户输入简短提示“a toy robot taking a stroll in Johannesburg during a winter storm”,GPT会将其扩展为包含“wearing a green dress and a sun hat”等细节的详细描述,Sora据此生成的视频能精准还原这些细节元素。

4.3 跨模态交互:不止于文本,支持图像与视频驱动

Sora的能力并非局限于“文本到视频”的单向生成,还支持以图像或视频为输入的跨模态交互,解锁了丰富的编辑场景:

-

图像动画:输入一张图像(如DALL·E 2/3生成的图像)和文本提示,Sora能为图像添加动态效果,生成视频。例如,将“拼写SORA的云朵图像”转化为“云朵随风飘动、保持SORA字形的视频”,或将“冲浪者的静态图像”转化为“冲浪者在巨浪中穿行的动态视频”;

-

视频扩展:支持将现有视频向前后两个时间方向扩展,生成无缝衔接的更长视频。实验中,研究团队将一段视频片段作为“结尾”,反向扩展出三个不同的“开头”,三个开头虽不同,但都能自然过渡到同一结尾;此外,还可通过双向扩展生成无限循环的视频;

-

视频风格迁移:基于SDEdit(一种扩散模型编辑方法),Sora能实现“零样本”风格迁移——输入一段视频和文本提示(如“change the setting to be in a lush jungle”),即可将视频的场景替换为指定风格(如从城市街道变为茂密丛林),同时保留主体的动作和结构;

-

视频过渡生成:能在两个不同主题的视频之间生成无缝过渡的中间视频,实现“从A到B”的自然转换,例如从“猫在睡觉”过渡到“狗在奔跑”的流畅视频序列。

4.4 图像生成:意外之喜,视频模型的“附加技能”

由于图像被统一视为“单帧视频”,Sora天然具备图像生成能力。生成时,只需将随机噪声图像块排列为“时间维度长度为1”的空间网格,即可生成不同分辨率(最高2048x2048)的图像。从报告展示的样例来看,Sora生成的图像在细节、光影和风格一致性上均达到了高水平,可与专业图像生成模型媲美。这一“附加技能”进一步印证了统一表示体系的通用性。

报告展示的图像生成样例包括:秋日女性特写肖像(浅景深、极致细节)、充满彩色鱼类的珊瑚礁、苹果树下沉思的老虎(哑光绘画风格)、极光下的雪山村庄(写实摄影风格)等,覆盖了写实、艺术等多种风格。

五、 emergent能力:规模化带来的“物理世界模拟”潜力

报告中最具启发性的部分,是对Sora“涌现能力(Emergent Capabilities)”的探讨。研究发现,当视频生成模型达到一定规模后,会自发形成一些未被显式训练的能力,这些能力使其初步具备了“模拟物理世界”的潜力——无需引入3D建模、物理引擎等外部工具,仅通过规模化数据训练即可习得。

5.1 3D一致性(3D Consistency)

Sora能够生成包含动态相机运动(如平移、旋转)的视频,且在相机运动过程中,人物、物体和场景元素会沿着三维空间轨迹做一致性运动。例如,当相机围绕一个站立的人物旋转时,人物的前后轮廓、肢体位置会自然变化,符合真实世界的透视规律。这种3D一致性并非通过显式的3D建模实现,而是模型从大量视频数据中自发学习到的空间关系知识。

5.2 长时连贯性与物体恒存性

长视频生成的核心痛点是“时序一致性”——如何确保长时间内人物身份、物体形态、场景环境的稳定。Sora在这一问题上取得了显著突破:

-

长时连贯性:能够生成一分钟的长视频,且视频前后风格、主体动作逻辑保持一致,无明显的跳变或逻辑断裂;

-

物体恒存性:当人物或物体被遮挡(如被门挡住)或离开画面后,再次出现时仍能保持一致的形态和特征。例如,一个戴红色帽子的人走出画面,5秒后再次走入时,帽子颜色和款式仍保持不变;甚至能在单段视频中多次出现同一角色,且角色外观始终一致。

5.3 世界交互模拟

Sora能够模拟简单的“主体-世界”交互行为,即主体的动作会对环境或物体产生符合直觉的影响。例如:

-

画家在画布上作画,新画的笔触会留在画布上并随时间保持稳定;

-

人吃汉堡时,汉堡会留下清晰的咬痕,且咬痕的位置和形状符合咀嚼动作的逻辑;

-

风吹过草地时,草叶会向同一方向弯曲,呈现自然的动态效果。

这些交互并非通过预设的物理规则实现,而是模型从大量真实视频数据中学习到的“动作-结果”关联。

5.4 数字世界模拟

Sora的模拟能力不仅限于真实物理世界,还能扩展到数字世界。报告中最引人注目的案例是“Minecraft模拟”——只需在提示词中提及“Minecraft”,Sora就能同时实现两大功能:一是控制游戏角色执行基础动作(如行走、挖矿),二是高保真渲染游戏世界的动态变化(如方块被破坏后的效果、场景光影变化)。这一能力是零样本实现的,无需专门针对游戏场景进行微调,充分体现了模型的通用性。

这些涌现能力共同指向一个核心结论:规模化视频生成模型是构建通用物理世界模拟器的可行路径。随着模型规模的进一步扩大,其模拟能力有望覆盖更复杂的物理规则和交互场景。

六、局限与展望:前路漫漫,未来可期

尽管Sora展现出了惊人的能力,但报告也坦诚地指出了其当前的局限性,这些局限性正是未来研究的核心方向:

-

物理规则建模不精准:对于一些复杂的物理交互,Sora的模拟仍存在明显瑕疵。例如,玻璃破碎的效果不符合真实物理规律,物体碰撞后的运动轨迹有时会出现逻辑错误;

-

物体状态变化不连贯:部分场景中,物体状态的变化缺乏逻辑。例如,一杯水被打翻后,地面没有出现水渍,或水渍的形状和扩散方向不符合液体流动规律;

-

长视频局部瑕疵:虽然整体连贯性较好,但在一分钟长视频的局部片段中,仍可能出现人物面部模糊、动作卡顿、物体形状畸变等问题;

-

因果逻辑缺失:模型能模拟“动作-结果”的表面关联,但缺乏对深层因果关系的理解。例如,能生成“下雨时地面变湿”的视频,但可能无法理解“地面变湿是因为雨水落下”的因果逻辑,因此在特殊场景(如室内下雨)中可能出现逻辑错误。

针对这些局限,报告提出了明确的未来方向:持续规模化。研究团队认为,当前Sora的涌现能力已经证明了规模化的有效性,未来通过更大规模的模型、更多样化的训练数据,有望逐步解决物理建模、逻辑连贯性等问题,最终构建出能精准模拟物理世界和数字世界的通用模拟器。

七、总结:Sora的技术启示与行业影响

Sora的技术报告虽未披露模型参数量、训练数据量等细节,但为视频生成领域提供了三大核心启示:

-

统一表示是规模化的前提:通过时空图像块将视频与图像统一为Transformer可处理的序列,打破了数据格式的壁垒,为互联网规模的视觉数据训练提供了可能;

-

扩散Transformer具备跨模态规模化潜力:Transformer的规模化优势不仅限于语言和图像,在视频等更复杂的模态中同样适用,扩散模型与Transformer的结合是生成高质量视频的有效路径;

-

涌现能力开启“模拟时代”想象:视频生成模型的规模化不仅能提升生成质量,更能自发习得物理世界的规律,为通用模拟器的构建提供了全新思路。

对行业而言,Sora的出现标志着视频生成从“特定场景工具”向“通用创作平台”的跨越,未来有望在内容创作、游戏开发、虚拟仿真、教育培训等领域产生颠覆性影响。而其暴露的局限性,则为后续研究指明了方向——如何让生成模型不仅“看起来真实”,更“符合逻辑和物理规律”,将是下一代视频生成技术的核心攻关点。

我们有理由期待,随着规模化训练的持续推进,视频生成模型将逐步逼近“数字孪生”的终极目标,为人类创造出更真实、更灵活的虚拟世界。