李宏毅机器学习笔记41

目录

摘要

1.life long learning难点

2.life long learning评估

摘要

本篇文章继续学习李宏毅老师2025春季机器学习课程,学习内容是life long learning问题的难点,以及评估life long learning好坏的方法。

1.life long learning难点

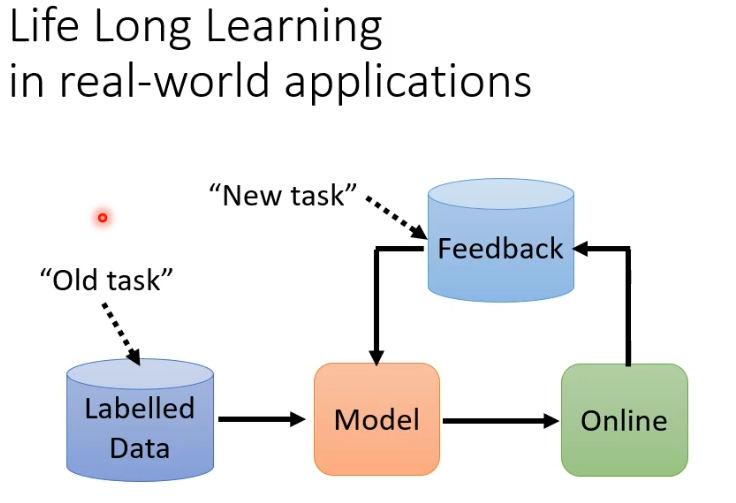

假设某个模型训练好上线后,会得到用户的反馈,把反馈作为新的资料用于更新我们模型的参数,更新后继续收集反馈,再次更新如此循环,模型会越来越好,可以把旧资料做为过去的任务,新的资料作为新的任务,这就是life long learning(LLL)问题。

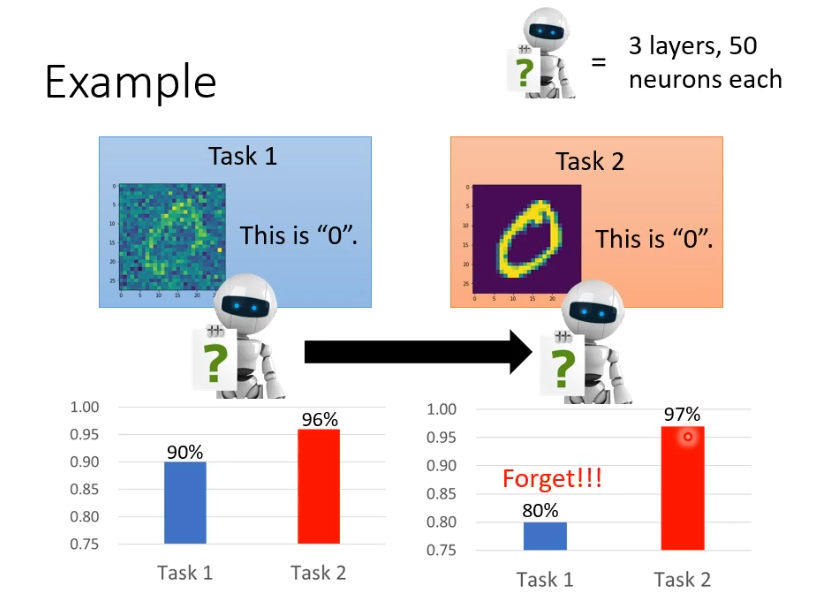

假设有两个任务都是手写数字辨识,任务1有噪音任务2没有.以三层,每层50个neuron为例,结果如下图所示,任务1学完之后有90%正确率,就算还没有看过任务2也有96%的正确率。继续让这个模型去学习任务2,得到的结果是任务2正确率变高了(97%)但是任务1的正确率降低到80%。

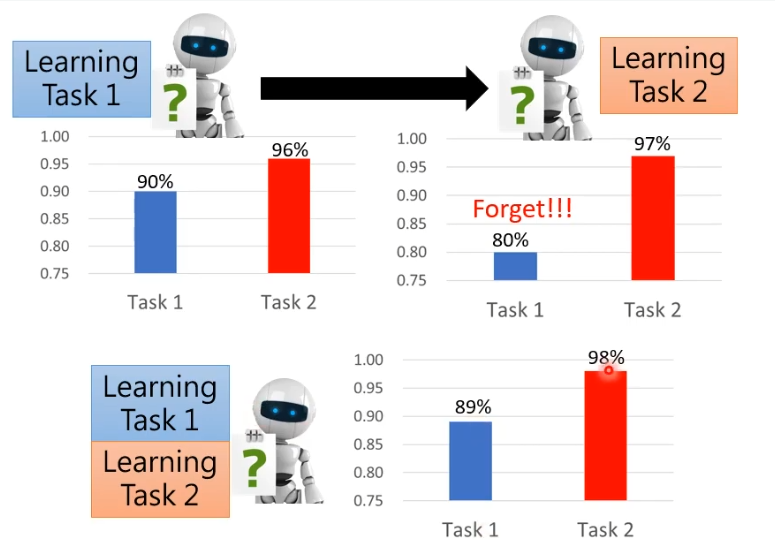

假设把任务1和任务2的资料混合到一起会得到任务1的正确率为89%,任务2的正确率为98%。可以发现机器不是不能掌握两个任务,但是新的任务学会就“忘记”旧的任务怎么做。这叫做catastrophic forgetting。

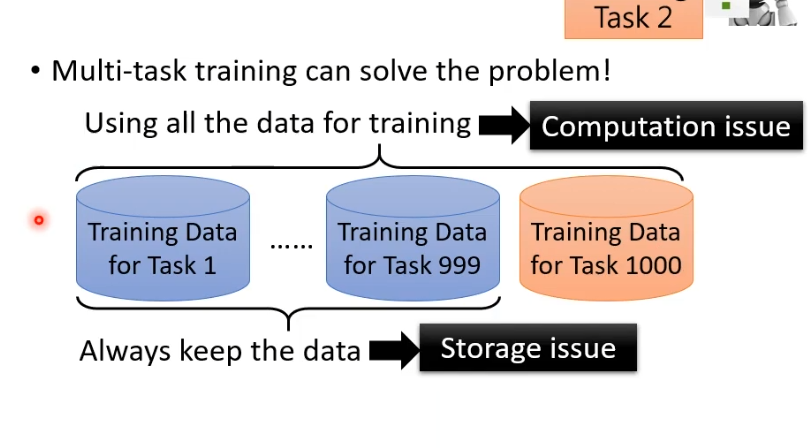

我们也发现如果把任务都混在一起学习就能解决问题,假设要让机器学习第1000个任务,为了避免遗忘就需要把前面999个任务的资料都拿出来混合在一起学习,才能同时学会1000个任务,这样会导致存储的问题,也会导致训练的时间过长。

2.life long learning评估

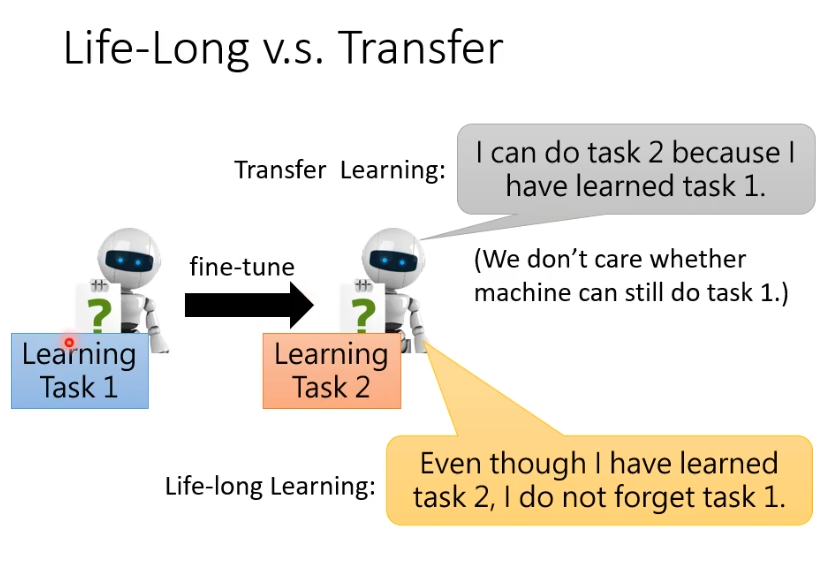

life long learning对比transfer learning,不难发现life long learning与transfer learning有些相似,transfer learning就是让机器在任务1上学习希望任务1上学到的技能可以transfer到任务2上,虽然都是让机器学多个任务但是关注点不同,transfer learning的关注点是任务1学到的是否对任务2有帮助,life long learning是学习完第二个任务后,之前的任务是否还能保持较高的正确率。

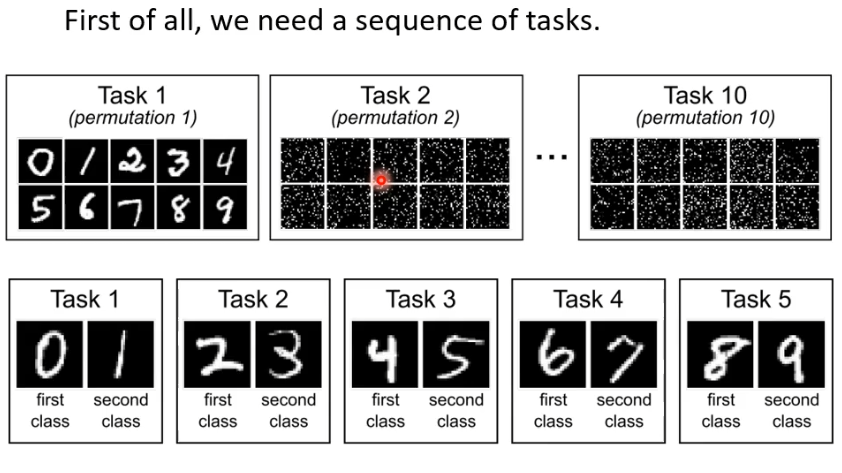

评估life long learning好不好,首先需要一堆任务让机器可以依次学习,常见的是做数字辨识,如下图所示,后续的任务都是数字辨识,只是将数字以某种方式打乱,或者是任务1学习分辨0和1,任务2学习分辨2和3等。

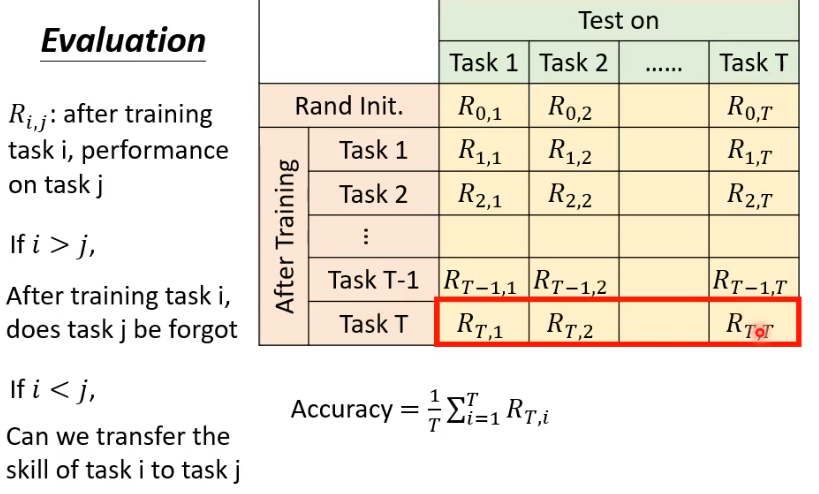

评估的方法是,一排的任务和每次学习之后的正确率(包括初始的随机参数正确率)列出如下图的表格,表中正确率表示为,i代表学习了第几个任务后的正确率,j代表在第几个任务上的正确率,如果i>j(下三角),正确率对应表示是否忘记之前学习的内容,如果i<j(上三角),正确率表示机器transfer的能力。最常见的评估方法是将最后一次的所有任务正确率平均起来代表life long learning的好坏。