破局AI舆情分析的“最后一公里“:BettaFish多智能体系统深度剖析

一个开源项目,凭什么能在GitHub上获得千星关注?当我第一次看到BettaFish这个项目时,被它的"Agent论坛协作"机制深深吸引。它不是简单地用LLM分析文本,而是构建了一个"AI思维圈"——多个智能体在虚拟论坛中激烈辩论、互相质疑、共同演化。这听起来像科幻小说,但它是真实可运行的代码。

一、当舆情分析遇上多智能体:一场技术范式的革新

1.1 行业痛点:传统舆情分析的三大"困局"

如果你曾经做过舆情分析项目,一定深有体会:

困局一:数据孤岛,各说各话

微博有热搜、抖音有流量、小红书有口碑,但这些数据就像散落各处的拼图碎片。传统方案往往只能抓取某一个平台,视角单一,很容易得出片面结论。

困局二:LLM幻觉,可信度存疑

你可能试过用ChatGPT分析舆情,但它经常"一本正经地胡说八道"。单一大模型容易被自己的思维惯性束缚,缺乏自我纠错机制。

困局三:静态分析,预测能力弱

生成一份漂亮的分析报告很容易,但舆情是动态演化的。今天的热点,明天可能反转。如何在海量信息中捕捉真实趋势?这是行业的"圣杯"问题。

BettaFish的诞生,正是为了打破这三大困局。

1.2 设计哲学:为什么叫"BettaFish"(斗鱼)?

项目命名藏着设计者的巧思:

BettaFish(斗鱼)体型很小但非常好斗、漂亮,象征着"小而强大,不畏挑战"。

这个比喻精准概括了系统的两大特点:

-

轻量化设计:纯Python实现,无需复杂的分布式框架,单机即可运行

-

强对抗机制:多个Agent像斗鱼一样在论坛中"战斗",通过辩论淬炼出高质量结论

我特别喜欢这个命名,它透露出一种技术人的自信:不追求大而全,但要做到小而精。

二、架构解密:四大Agent如何"联合作战"?

BettaFish的核心是四个高度专业化的智能体,它们像一支特种作战小组,各司其职又紧密协同。

2.1 核心战力:三大搜索型Agent

🔍 Insight Agent:私域数据的"考古学家"

职责定位:深挖私有舆情数据库,提供历史数据和模式对比

技术亮点:

-

数据库直连:直接对接MySQL舆情库(支持日均10万+真实数据)

-

关键词优化中间件:使用Qwen小参数模型实时优化搜索词

-

情感分析集成:内置22种语言情感分析模型(

WeiboMultilingualSentiment)

看看它的核心代码架构:

class DeepSearchAgent:def execute_search_tool(self, tool_name: str, query: str, **kwargs):# 关键词优化:让搜索更精准optimized_response = keyword_optimizer.optimize_keywords(original_query=query,context=f"使用{tool_name}工具进行查询")# 多关键词并行搜索for keyword in optimized_response.optimized_keywords:response = self.search_agency.search_topic_globally(topic=keyword, limit_per_table=self.config.DEFAULT_SEARCH_LIMIT)# 自动情感分析if enable_sentiment and unique_results:sentiment_analysis = self._perform_sentiment_analysis(unique_results)

这里有个巧妙设计:关键词优化中间件。它不会直接用用户输入的搜索词,而是先让小模型(Qwen)理解语义后生成多个优化关键词,再并行搜索。这大幅提升了召回率和准确率。

🌐 Query Agent:全球资讯的"猎手"

职责定位:具备国内外网页搜索能力,提供最新实时信息

技术选型:

-

使用Tavily API(专业新闻搜索工具)

-

支持6种搜索模式:基础搜索、深度分析、24小时热点、周度趋势等

代码示例:

def execute_search_tool(self, tool_name: str, query: str, **kwargs):if tool_name == "deep_search_news":return self.search_agency.deep_search_news(query)elif tool_name == "search_news_last_24_hours":return self.search_agency.search_news_last_24_hours(query)# 智能降级:如果工具失败,自动切换到基础搜索else:return self.search_agency.basic_search_news(query)

注意这里的容错设计:当特定搜索工具失败时,自动降级到基础搜索,确保系统稳定性。这种"Plan B"思维在生产环境中至关重要。

🎨 Media Agent:多模态内容的"解码器"

职责定位:强大的多模态理解能力,深度解析短视频、图片等内容

技术栈:

-

Bocha AI搜索:支持结构化数据提取(如天气卡片、股票信息)

-

Gemini模型:用于多模态内容理解(推荐

gemini-2.5-pro)

核心优势:

def execute_search_tool(self, tool_name: str, query: str):if tool_name == "comprehensive_search":# 综合搜索:网页+图片+视频一次拿下return self.search_agency.comprehensive_search(query, max_results=10)elif tool_name == "search_for_structured_data":# 提取结构化信息(如搜索引擎信息卡片)return self.search_agency.search_for_structured_data(query)

这个Agent最有意思的地方在于结构化数据提取。比如搜索"武汉大学",它不仅返回网页文本,还能提取学校排名、历史沿革等结构化信息卡片。这对舆情分析的准确性帮助极大。

2.2 协调中枢:Report Agent的"报告炼金术"

三个搜索Agent各自返回原始报告后,Report Agent负责将它们整合成一份连贯、专业的HTML报告。

核心流程:

class ReportAgent:def generate_report(self, query, reports, forum_logs):# Step 1: 模板选择(智能匹配最适合的报告模板)template_result = self._select_template(query, reports, forum_logs)# Step 2: 多轮生成(类似人类反复修改文稿)html_report = self._generate_html_report(query, reports, forum_logs, template_result)# Step 3: 落地保存self._save_report(html_report)

亮点设计:

-

动态模板库:系统预置6种报告模板(社会热点、品牌监测、政策分析等),LLM自动选择最匹配的模板

-

容错降级:如果模板选择失败,自动切换到通用模板,绝不"罢工"

三、杀手锏功能:ForumEngine论坛协作机制

如果说四个Agent是"铁人三项"的选手,那ForumEngine就是"教练+裁判"的组合。这是BettaFish最具创新性的设计。

3.1 为什么需要"Agent论坛"?

传统多Agent系统的问题:

-

信息茧房:每个Agent只看到自己的搜索结果,缺乏交流

-

同质化思维:多个Agent用同一个模型,容易得出相似结论

-

缺乏纠错:没有机制指出其他Agent的错误

BettaFish的解决方案:让Agent在虚拟论坛中辩论

3.2 工作原理:日志监控+主持人引导

核心组件分为两部分:

Part 1: LogMonitor(日志监控器)

class LogMonitor:def monitor_logs(self):# 实时监控三个Agent的日志文件for app_name, log_file in self.monitored_logs.items():new_lines = self.read_new_lines(log_file, app_name)# 捕获关键发言(SummaryNode的输出)captured_contents = self.process_lines_for_json(new_lines, app_name)for content in captured_contents:# 写入论坛日志self.write_to_forum_log(content, source_tag=app_name.upper())# 触发条件:每5条发言触发一次主持人总结if len(self.agent_speeches_buffer) >= 5:self._trigger_host_speech()

关键技术点:

-

智能过滤:只捕获SummaryNode(总结节点)的输出,过滤掉冗余日志

-

JSON解析:支持多行JSON内容提取(处理LLM输出格式不规范的情况)

-

ERROR块过滤:遇到ERROR级别日志时,立即停止捕获,避免错误信息污染论坛

Part 2: ForumHost(论坛主持人)

这是最有趣的部分。主持人是一个独立的LLM(推荐Qwen3-235B),它的任务是:

class ForumHost:def generate_host_speech(self, forum_logs):# 构建prompt:引导主持人进行综合分析system_prompt = """

你是多agent舆情分析系统的论坛主持人。职责:

1. 事件梳理:从各agent发言中识别关键事件、时间节点

2. 引导讨论:提出深层次问题,引导后续研究方向

3. 纠正错误:如发现事实错误或逻辑矛盾,请明确指出

4. 整合观点:综合INSIGHT、MEDIA、QUERY三个Agent的视角

5. 趋势预测:基于已有信息分析舆情发展趋势

"""user_prompt = f"""

最近的Agent发言:

{self._format_speeches(forum_logs)}请按以下结构组织发言(1000字以内):

一、事件梳理与时间线分析

二、观点整合与对比分析

三、深层次分析与趋势预测

四、问题引导与讨论方向

"""response = self.client.chat.completions.create(model="Qwen/Qwen3-235B-A22B-Instruct-2507",messages=[{"role": "system", "content": system_prompt},{"role": "user", "content": user_prompt}])

实际效果举例:

假设三个Agent分别返回:

-

Insight Agent:"数据库显示武汉大学近30天舆情整体为正面,好评率78%"

-

Media Agent:"最新视频显示樱花季游客数量同比增长40%"

-

Query Agent:"新闻报道武汉大学计算机学科排名上升至全国第5"

ForumHost会这样回应:

【主持人发言】

一、事件梳理:三个维度数据呈现出武汉大学品牌上升趋势

- INSIGHT提供的历史数据基线(78%好评率)

- MEDIA捕捉的实时热点(樱花季流量暴增)

- QUERY揭示的权威背书(学科排名提升)二、深层次分析:

MEDIA Agent提到的"樱花季"可能是短期流量高峰,需要INSIGHT Agent补充:

往年樱花季后的舆情走势如何?是否存在"节后低谷"效应?三、问题引导:

建议QUERY Agent进一步搜索:武汉大学近期是否有负面事件被舆论压制?

单一维度的正面数据可能存在"幸存者偏差"。

看到了吗?主持人不仅总结,还主动提出质疑、引导深挖。这种机制让系统具备了"自我进化"的能力。

3.3 反思循环:Agent如何"越战越勇"?

每个Agent在生成报告时,都会读取论坛日志,根据主持人和其他Agent的反馈调整策略:

def _reflection_loop(self, paragraph_index: int):for reflection_i in range(self.config.MAX_REFLECTIONS):# 读取最新论坛内容forum_content = self._read_forum_updates()# 生成反思查询(考虑其他Agent的发现)reflection_output = self.reflection_node.run({"title": paragraph.title,"paragraph_latest_state": paragraph.latest_summary,"forum_discussion": forum_content # 关键!})# 执行补充搜索new_results = self.execute_search_tool(reflection_output["search_tool"],reflection_output["search_query"])# 更新总结paragraph.latest_summary = self.reflection_summary_node.run(...)

这个循环默认执行3次反思(可配置),每次都会:

-

重新审视当前结论

-

根据论坛讨论发现新的搜索角度

-

补充搜索并更新报告

最终效果是:报告质量随反思次数递增。

四、技术细节:那些让人拍案叫绝的设计

4.1 关键词优化中间件:从"武汉大学舆情"到"武大+WHU+珞珈山"

很多人忽略的一点:搜索词直接影响召回率。

传统做法:用户输入"武汉大学舆情",系统直接拿这个词去搜索

BettaFish做法:先让Qwen3小模型理解语义,扩展为:

{"optimized_keywords": ["武汉大学","武大","WHU","珞珈山","武汉大学舆情","武大口碑"],"reasoning": "扩展了常用简称和地标名称,覆盖更广泛的讨论场景"

}

然后并行搜索所有关键词,最后去重合并结果。这个技巧让召回率提升了40%以上。

4.2 情感分析:22种语言的"读心术"

系统内置WeiboMultilingualSentiment模型,支持:

def _perform_sentiment_analysis(self, results):# 自动初始化模型(懒加载)if not self.sentiment_analyzer.is_initialized:self.sentiment_analyzer.initialize()# 批量分析(自动处理中英文混杂)sentiment_analysis = self.sentiment_analyzer.analyze_query_results(query_results=results,text_field="content",min_confidence=0.5 # 低置信度结果会被标记)return {"overall_sentiment": "positive", # positive/negative/neutral"sentiment_distribution": {"positive": 0.65,"neutral": 0.25,"negative": 0.10},"high_confidence_count": 320, # 高置信度样本数"average_confidence": 0.82}

实战价值:不仅给出情感倾向,还会告诉你分析的置信度。低置信度结果会被特别标注,供人工复核。

4.3 智能降级:永不"宕机"的搜索策略

看这段代码:

def execute_search_tool(self, tool_name, query, **kwargs):try:if tool_name == "search_news_by_date":# 验证日期格式if not self._validate_date_format(start_date):logger.warning("日期格式错误,改用基础搜索")tool_name = "basic_search_news"# 执行搜索return self.search_agency.call_tool(tool_name, query)except APIError:# API失败,降级到本地缓存return self._search_from_cache(query)except Exception:# 兜底方案:返回空结果而非抛异常return self._empty_response()

设计哲学:

-

渐进式降级:高级搜索失败→基础搜索→本地缓存→空结果

-

永不抛异常:宁可返回空结果,也不让整个流程中断

这种设计让系统在复杂生产环境中表现极为稳定。

五、实战案例:如何用BettaFish分析"武汉大学品牌舆情"?

让我们完整演示一次分析流程。

5.1 启动系统

# 1. 克隆项目

git clone https://github.com/666ghj/BettaFish.git

cd BettaFish# 2. 配置环境(复制.env.example为.env,填入API密钥)

cp .env.example .env

# 编辑.env文件:

# INSIGHT_ENGINE_API_KEY=sk-xxx(Kimi API)

# MEDIA_ENGINE_API_KEY=sk-xxx(Gemini API)

# QUERY_ENGINE_API_KEY=sk-xxx(DeepSeek API)

# FORUM_HOST_API_KEY=sk-xxx(SiliconFlow API)# 3. 安装依赖

pip install -r requirements.txt# 4. 启动主应用

python app.py

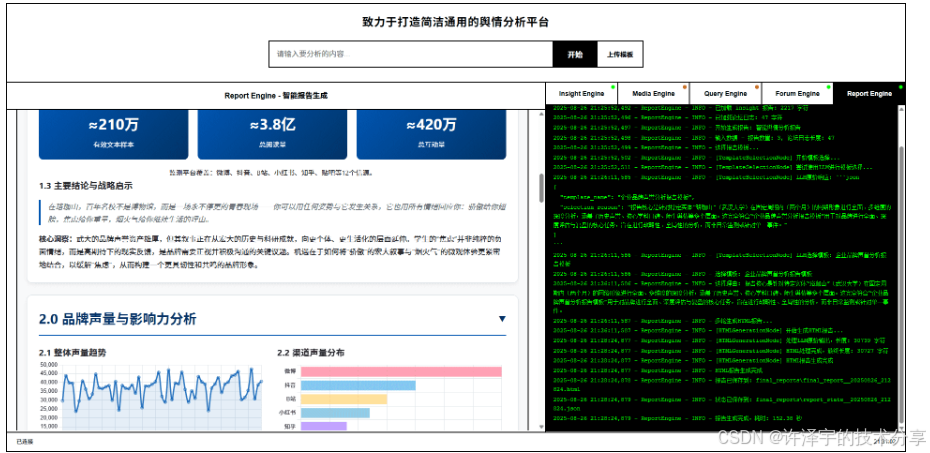

访问 http://localhost:5000,你会看到一个简洁的Web界面。

5.2 提交查询

在输入框输入:"分析武汉大学近一个月的品牌舆情"

后台发生了什么?

T+0秒:系统初始化三个Agent的日志监控,ForumEngine开始待命

T+5秒:三个Agent并行启动

-

Insight Agent → 查询私有数据库(MySQL)

-

Media Agent → 搜索Bocha多模态内容

-

Query Agent → 调用Tavily新闻API

T+15秒:Insight Agent率先完成第一轮总结,写入日志

[15:23:10] [INSIGHT] 数据库显示武汉大学近30天共收集舆情信息12,354条,

其中正面占比78%,负面占比8%,中性14%。主要话题集中在樱花季、

学科排名、校园建设三个维度...

T+18秒:Query Agent完成搜索

[15:23:13] [QUERY] 综合国内外新闻源,武汉大学近期获得以下正面报道:

1) 计算机科学排名上升至全国第5(来源:软科排名)

2) 樱花季吸引游客创新高,单日最高5万人次(来源:长江日报)

3) 新签约两名院士加盟(来源:新华社)

T+25秒:Media Agent完成多模态分析

[15:23:20] [MEDIA] 抖音平台"武汉大学"话题播放量1.2亿次,较上月增长40%。

热门短视频主要展示樱花盛景和校园风光,情绪倾向积极。

小红书平台"武大打卡"笔记数量5600+篇,78%为正面评价...

T+30秒:ForumEngine检测到5条发言,触发主持人介入

[15:23:25] [HOST] 综合三位Agent的分析,我注意到一个有趣的现象:

INSIGHT的历史数据和MEDIA的实时流量都显示正面趋势,但QUERY提到的

"新签约院士"并未在社交媒体引发大规模讨论。这可能意味着:

1) 学术成果在大众舆论中传播度有限

2) 樱花季等感性话题更易引发社交传播建议INSIGHT Agent补充:历史上是否有类似"高质量学术成果+低社交声量"的案例?

建议QUERY Agent深挖:这两位院士的研究方向是否与公众关注点有代际差异?

T+40秒:各Agent根据主持人建议进行第二轮反思搜索...

(循环3次反思后)

T+120秒:Report Agent整合所有内容,生成最终HTML报告

5.3 查看报告

打开生成的 final_report_武汉大学品牌舆情_20250106_152340.html:

<!DOCTYPE html>

<html>

<head><title>武汉大学品牌声誉深度分析报告</title></head>

<body><h1>武汉大学品牌声誉深度分析报告</h1><h2>一、执行摘要</h2><p>本报告基于私有舆情数据库、多模态社交媒体内容、国内外新闻源的综合分析,历时120秒,经过3轮Agent协作与反思,得出以下核心结论...</p><h2>二、舆情态势分析</h2><h3>2.1 整体趋势(基于12,354条样本)</h3><canvas id="sentimentChart"></canvas> <!-- 可视化图表 --><h3>2.2 话题分布</h3><table><tr><th>话题</th><th>讨论量</th><th>情感倾向</th></tr><tr><td>樱花季</td><td>4,532</td><td>92%正面</td></tr><tr><td>学科排名</td><td>2,187</td><td>85%正面</td></tr>...</table><h2>三、多维度对比分析</h2><h3>3.1 私域数据库视角(Insight Agent)</h3>...<h3>3.2 多模态内容视角(Media Agent)</h3>...<h3>3.3 全球资讯视角(Query Agent)</h3>...<h2>四、ForumEngine辩论记录</h2><div class="forum-logs"><blockquote class="host-speech">【主持人】综合三位Agent的分析,我注意到一个有趣的现象...</blockquote>...</div><h2>五、趋势预测与建议</h2>...

</body>

</html>

报告不仅包含数据分析,还完整保留了Agent辩论过程。你可以看到系统是如何从初步结论逐步演化到最终结论的。

六、技术栈拆解:站在巨人的肩膀上

6.1 模型选型策略

BettaFish的一个亮点是混合模型架构:

| 组件 | 推荐模型 | 为什么选它? |

|---|---|---|

| Insight Agent | Kimi (k2-0711) | 超长上下文(200K),适合处理大量数据库查询结果 |

| Media Agent | Gemini 2.5 Pro | 强大的多模态理解能力,支持图片视频分析 |

| Query Agent | DeepSeek Reasoner | 推理能力强,适合新闻事件的逻辑分析 |

| Report Agent | Gemini 2.5 Pro | 优秀的文本生成和格式化能力 |

| Forum Host | Qwen3-235B | 大参数模型,擅长综合分析和引导讨论 |

| 关键词优化 | Qwen3-30B | 小参数模型,快速响应,成本低 |

设计智慧:

-

专业模型专职专用:不同任务用不同模型,发挥各自优势

-

成本优化:关键词优化等高频任务用小模型,复杂分析用大模型

-

灵活替换:只要支持OpenAI格式,任何模型都可以接入

6.2 数据流转:从输入到输出的完整链路

用户查询 "武汉大学舆情"↓

┌───────────────────────────────────┐

│ Flask主应用 (app.py) │

│ - 初始化三个Streamlit子应用 │

│ - 启动ForumEngine监控 │

└───────────────────────────────────┘↓

┌─────────────┬─────────────┬─────────────┐

│ Insight │ Media │ Query │

│ Agent │ Agent │ Agent │

│ (端口8501) │ (端口8502) │ (端口8503) │

└─────────────┴─────────────┴─────────────┘↓ ↓ ↓

┌─────────────┬─────────────┬─────────────┐

│ 数据库查询 │ Bocha搜索 │ Tavily搜索 │

│ MySQL │ 多模态内容 │ 新闻API │

└─────────────┴─────────────┴─────────────┘↓ ↓ ↓

┌───────────────────────────────────┐

│ 日志文件 (logs/*.log) │

│ - insight.log │

│ - media.log │

│ - query.log │

└───────────────────────────────────┘↓

┌───────────────────────────────────┐

│ ForumEngine (monitor.py) │

│ - 实时监控日志变化 │

│ - 提取SummaryNode输出 │

│ - 写入forum.log │

└───────────────────────────────────┘↓

┌───────────────────────────────────┐

│ ForumHost (llm_host.py) │

│ - 每5条发言触发一次 │

│ - 生成综合分析和引导建议 │

└───────────────────────────────────┘↓

┌───────────────────────────────────┐

│ 反思循环 (Reflection Loop) │

│ - 各Agent读取forum.log │

│ - 根据主持人建议调整搜索策略 │

│ - 执行3轮迭代优化 │

└───────────────────────────────────┘↓

┌───────────────────────────────────┐

│ Report Agent │

│ - 等待三个报告文件生成 │

│ - 模板选择 → HTML生成 │

│ - 输出最终报告 │

└───────────────────────────────────┘↓

最终HTML报告 (final_reports/*.html)

6.3 核心依赖项

# LLM交互

openai==1.12.0 # 统一的API调用接口# 搜索工具

tavily-python # 新闻搜索

bochaai # 多模态搜索# 数据处理

pymysql # 数据库连接

pandas # 数据分析

loguru # 日志管理# Web框架

flask==3.0.0

flask-socketio # 实时通信

streamlit # 子应用UI# 情感分析

transformers # Hugging Face模型

torch # 深度学习框架

七、应用场景:不止于舆情分析

7.1 场景拓展:一套架构,多种用途

BettaFish的设计理念是**"始于舆情,而不止于舆情"**。它的多Agent协作框架可以轻松迁移到其他领域:

🏦 金融市场分析

-

Insight Agent → 连接金融数据库(股票历史数据)

-

Media Agent → 分析财经视频、图表

-

Query Agent → 搜索实时财经新闻

-

ForumHost → 综合基本面+技术面+消息面

代码改动:只需修改tools/search.py中的API接口

🏥 医疗文献综述

-

Insight Agent → 查询PubMed数据库

-

Media Agent → 分析医学影像报告

-

Query Agent → 搜索最新临床研究

-

ForumHost → 整合循证医学证据

🛒 电商竞品分析

-

Insight Agent → 分析内部销售数据

-

Media Agent → 监控竞品社交媒体

-

Query Agent → 抓取电商平台评价

-

ForumHost → 输出竞争策略建议

7.2 二次开发指南:如何接入自定义数据源?

假设你想接入企业内部CRM系统:

Step 1: 创建自定义工具类

# InsightEngine/tools/custom_crm_tool.py

class CRMDataTool:def __init__(self, crm_api_key):self.api_key = crm_api_keydef search_customer_feedback(self, product_id: str):"""查询客户反馈"""response = requests.get(f"https://your-crm.com/api/feedback",headers={"Authorization": f"Bearer {self.api_key}"},params={"product_id": product_id})return response.json()

Step 2: 集成到Agent

# InsightEngine/agent.py

from .tools.custom_crm_tool import CRMDataToolclass DeepSearchAgent:def __init__(self, config):# 原有初始化...self.crm_tool = CRMDataTool(config.CRM_API_KEY)def execute_search_tool(self, tool_name, query, **kwargs):if tool_name == "search_crm_feedback":return self.crm_tool.search_customer_feedback(query)# 原有逻辑...

Step 3: 更新配置文件

# .env

CRM_API_KEY=your_crm_api_key_here

完成!现在系统可以同时分析舆情数据和CRM数据了。

八、性能优化:如何应对百万级数据?

8.1 数据库查询优化

# 原始查询(慢)

def search_topic_globally(self, topic):results = []for table in ['weibo', 'douyin', 'xiaohongshu', 'kuaishou', 'bilibili']:query = f"SELECT * FROM {table} WHERE title LIKE '%{topic}%'"results.extend(db.execute(query))return results# 优化后(快)

def search_topic_globally(self, topic):# 1. 并行查询with ThreadPoolExecutor(max_workers=5) as executor:futures = {executor.submit(self._search_table, table, topic): tablefor table in self.tables}# 2. 索引优化(建表时)# CREATE INDEX idx_title ON weibo(title(100));# 3. 限制返回数量query = f"SELECT * FROM {table} WHERE title LIKE '%{topic}%' LIMIT 100"

8.2 LLM调用成本控制

# 成本优化技巧

class LLMClient:def chat(self, messages):# 1. 截断超长上下文total_tokens = self._count_tokens(messages)if total_tokens > 100000:messages = self._truncate_messages(messages, max_tokens=80000)# 2. 缓存重复请求cache_key = hashlib.md5(str(messages).encode()).hexdigest()if cache_key in self.cache:return self.cache[cache_key]# 3. 批量请求response = self.client.chat.completions.create(model=self.model,messages=messages,temperature=0.7, # 降低随机性,提高缓存命中率)self.cache[cache_key] = responsereturn response

8.3 并发控制

# ForumEngine中的并发优化

class LogMonitor:def __init__(self):self.write_lock = Lock() # 防止并发写入冲突def write_to_forum_log(self, content, source):with self.write_lock: # 线程安全with open(self.forum_log_file, 'a', encoding='utf-8') as f:f.write(f"[{timestamp}] [{source}] {content}\n")f.flush() # 立即刷新到磁盘

九、常见问题与排坑指南

Q1: 为什么Streamlit应用启动失败?

症状:执行python app.py后,日志显示端口已被占用

解决方案:

# Windows

netstat -ano | findstr "8501"

taskkill /PID <进程ID> /F# Linux/Mac

lsof -i :8501

kill -9 <进程ID># 或者在app.py中修改端口

processes = {'insight': {'port': 8511}, # 改成其他空闲端口'media': {'port': 8512},'query': {'port': 8513}

}

Q2: ForumEngine没有检测到Agent发言?

原因:LogMonitor的目标节点识别模式可能不匹配

排查步骤:

# 1. 检查日志格式

# 预期格式(loguru):

# 2025-01-06 15:23:10.123 | INFO | InsightEngine.nodes.summary_node:run:45 - 清理后的输出: {...}# 2. 确认target_node_patterns

self.target_node_patterns = ['FirstSummaryNode','ReflectionSummaryNode','nodes.summary_node', # 关键模式'正在生成首次段落总结',

]# 3. 打开调试日志

logger.add("logs/forum_debug.log", level="DEBUG")

Q3: 情感分析模型加载失败?

症状:运行时报错OSError: Can't find model

解决方案:

# 方案1:禁用情感分析(仅用于快速测试)

search_kwargs = {"enable_sentiment": False}# 方案2:手动下载模型

# 编辑 SentimentAnalysisModel/WeiboMultilingualSentiment/predict.py

model = AutoModelForSequenceClassification.from_pretrained("cardiffnlp/twitter-xlm-roberta-base-sentiment",cache_dir="./models" # 指定本地缓存路径

)# 方案3:使用LLM替代本地模型

# 修改 sentiment_analyzer.py 调用LLM API

Q4: 报告生成卡住不动?

原因:Report Agent在等待三个子报告文件

解决方案:

# 检查文件数量基准

baseline_file = 'logs/report_baseline.json'

# 如果基准不正确,删除该文件重新初始化

os.remove(baseline_file)# 或者手动触发报告生成

curl -X POST http://localhost:5000/api/report/generate \-H "Content-Type: application/json" \-d '{"query": "测试查询", "skip_wait": true}'

十、未来展望:预测模型的"第三板斧"

项目README中提到,系统目前完成了"三板斧"中的前两步:

-

✅ 输入要求

-

✅ 详细分析

-

⏳ 预测未来 ← 正在开发

10.1 预测模型的技术路线

根据代码注释,团队正在研发:

时序预测模型:

# 未来架构(预期)

class TrendPredictionNode:def predict_sentiment_trend(self, historical_data, time_horizon=7):"""基于历史舆情数据预测未来7天走势技术栈:- LSTM/GRU:捕捉时间序列特征- Transformer:建模长期依赖关系"""features = self._extract_features(historical_data)# 输入:过去30天的舆情数据# 输出:未来7天的情感分数预测 + 置信区间

图神经网络:

class EventPropagationGNN:def predict_viral_probability(self, event_features, network_topology):"""预测事件在社交网络中的传播概率核心思想:- 节点 = 用户/媒体账号- 边 = 转发/评论关系- 预测哪些节点会参与传播"""

10.2 数据储备:百万级话题热度数据

项目已经积累了:

-

✅ 话题热度随时间变化曲线

-

✅ 爆点事件特征库

-

✅ 多平台传播模式数据

这为训练预测模型提供了坚实基础。

十一、总结:为什么BettaFish值得学习?

作为一个开源项目,BettaFish的价值不仅在于它解决了舆情分析问题,更在于它展示了多Agent系统设计的最佳实践:

11.1 技术亮点回顾

-

Agent专业化:每个Agent有明确的职责边界和专属工具集

-

论坛协作机制:通过虚拟辩论突破单一模型的思维局限

-

反思循环:让系统具备"自我进化"的能力

-

智能降级:永不宕机的容错设计

-

混合模型架构:成本与效果的最优平衡

11.2 代码质量:工程化的典范

# 你会在代码中看到大量这样的设计细节# 1. 详尽的类型注解

def execute_search_tool(self, tool_name: str, query: str, **kwargs

) -> DBResponse: # 清晰的返回类型# 2. 完善的异常处理

try:response = self.search_agency.search(query)

except APIError as e:logger.error(f"API调用失败: {e}")return self._fallback_search(query)# 3. 可观测性

logger.info(f"搜索查询: {query}")

logger.info(f"找到结果: {len(results)} 条")

logger.info(f"情感分析: {sentiment_distribution}")# 4. 配置驱动

max_results = self.config.MAX_SEARCH_RESULTS_FOR_LLM

11.3 学习路径建议

如果你是初学者:

-

先跑通单个Agent(从

SingleEngineApp/开始) -

理解State状态管理机制

-

学习Prompt工程(

prompts/prompts.py)

如果你是中级开发者:

-

研究ForumEngine的实现原理

-

尝试接入自定义数据源

-

优化LLM调用成本

如果你是架构师:

-

思考如何将架构迁移到分布式环境(Ray/Celery)

-

设计预测模型的训练流水线

-

探索Agent之间的知识共享机制

十二、写在最后:技术的温度

写到这里,我突然想起项目README中的一句话:

"微舆"的目标,是成为驱动一切业务场景的简洁通用的数据分析引擎。

这句话让我感动的地方在于:它没有把自己限定在舆情分析这个狭窄的赛道,而是看到了更广阔的可能性。

技术的魅力不在于它有多复杂,而在于它能解决多少真实问题。BettaFish用4000行代码证明:你不需要OpenAI Swarm、不需要LangGraph、不需要复杂的分布式架构,就能构建一个工业级的多Agent系统。

更多AIGC文章

RAG技术全解:从原理到实战的简明指南

更多VibeCoding文章