机器学习日报11

目录

- 摘要

- Abstract

- 一、决策树模型

- 二、学习过程

- 1、关键决策

- 1.1、第一个关键

- 1.2、第二个关键

- 总结

摘要

今天学习了决策树这一重要的机器学习算法。通过猫分类的例子,我理解了决策树如何通过一系列特征判断来做出分类决策。决策树由根节点、决策节点和叶节点组成,每个节点根据特征值选择分支路径,最终在叶节点给出预测结果。构建决策树的关键在于选择划分特征和确定停止划分的条件,目标是让子集尽可能"纯净"(同一类别)

Abstract

Today’s study focused on decision trees, a powerful machine learning algorithm. Using a cat classification example, I learned how decision trees make predictions through a series of feature-based decisions. The tree structure consists of root nodes, decision nodes, and leaf nodes. The key challenges in building decision trees are selecting the optimal features for splitting at each node and determining when to stop splitting, with the goal of maximizing subset purity.

一、决策树模型

有一种强大的学习算法,广泛应用于许多应用当中,也被许多人用来赢得机器人学习比赛,就是决策树和树集成。

为了解决决策树的工作原理,我们会持续研究一个例子,一个猫分类的例子,假设我们开了一家猫咪收养中心,通过一些特征,我们想要训练一个分类器快速告诉我们一只动物是否是猫

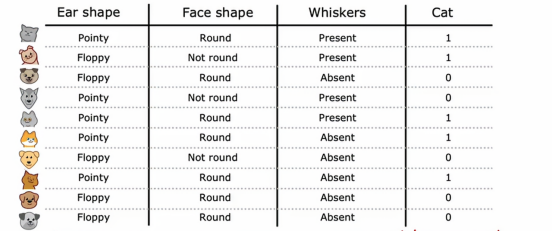

现在我们有一个10个关于判别是否为猫的例子,我们看到我们的判别依据有,耳形、脸形、是否有胡须,来看前两个例子,第一个我们观察到,耳朵形状为尖耳,脸型为圆形,是有胡须的,我们判别为猫;第二个例子,耳朵是垂耳,脸不是圆的,有胡须,我们判别为猫,接下来几个例子也是这样,这里不多赘述。

我们注意到,输出特征x是前三列,我们想预测的目标输出,y是最后一列的是不是猫,在这个例子中,特征x是分类值,换句话说,这些特征只取几个离散值,耳朵形状是尖的还是下垂的,脸型是圆的还是不圆的,胡须是有还是没有,这其实是几个二元分类问题,因为标签总是1或0,目前来看,x1、x2、x3只有2个取值,我们之后会讨论有更多的情况,那么,什么是决策树呢?

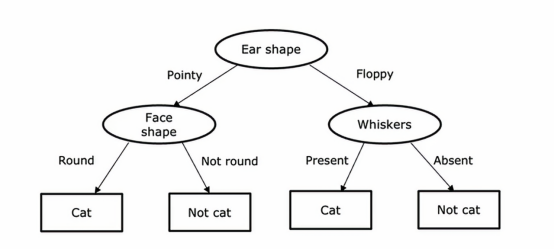

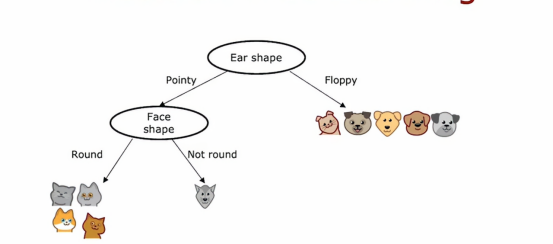

这是一个模型示例,我们可能在使用决策树学习算法对数据集 进行训练后得到该模型,学习算法输出的模型看起来像一棵树,而这样的图像,就是计算机科学家称之为的树,这些椭圆或矩形中的每一个点都称为树中的节点,树的根在顶部、叶在底部

这个模型的工作方式是 如果我们有一个新的测试样本,假如这里有一个耳朵形状尖尖的猫,脸型是圆的,并且有胡须,这个模型查看这个样本并做出分类决策的方式是,我们将从树的最顶端节点开始这个样本,我们会查看写在里面的特征,即耳朵的形状,基于这个样本的耳朵形状的值,我们可以选择向左走还是向右走,这个样本的耳朵形状是尖的,所以我们沿着这个树的左边分支向下走,然后我们查看这个样本的脸型,发现是圆脸,所以我们会沿着这个箭头往左走,算法将会推断认为这个是只猫,我们引入几个概念,首先是椭圆的我们统称为决策节点,并且最上面的决策节点我们也称为根节点,之所以叫它们决策节点是因为它们查看某个特定的特征,然后根据特征的值,决定向左走还是向右走,最后这些底部的节点,这些矩形框,我们称之为叶节点,它们负责进行预测

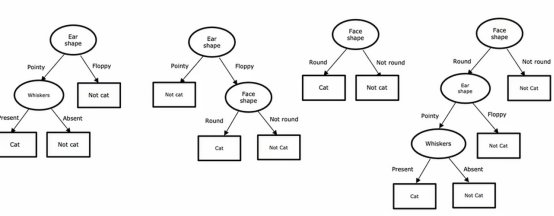

其实决策树它并不是唯一的,我们可以根据现实情况合理调整,这是四个不同情况下,我们判断是否为猫的决策树,在这些不同的决策树中,有些实是在训练集或交叉验证集和测试集上表现会更好,有些会更差

从所有可能的决策时中,试图选出一个在训练集上表现良好的,并且理想情况下能够很好地泛化到新数据,如交叉验证集和测试集,所以看起来对于给定的应用,可以构建很多不同的决策树,如何让算法根据训练集学习一个特定的决策树呢,这就是我们要引出的第二个内容

二、学习过程

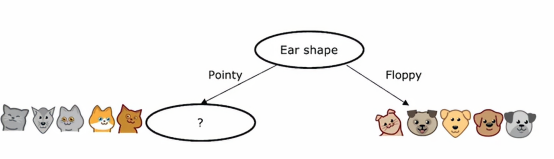

构建决策树的过程,给定一个数据集,有几个步骤,在本节中,我们来看看构建决策树的整体过程,给定一个包含10个猫和狗实例的训练集,就像上一节我们看到的那样,决策树学习的第一步是我们必须决定在根节点使用什么特征,这就是第一个节点,在决策树最顶部的位置,假设我们决定选择耳朵形状特征作为根节点的特征,这意味着我们将决定查看所有训练实例,这里显示的所有10个训练实例,并根据耳朵形状特征的值将它们分开,具体而言,我们挑选五个尖耳朵放到左边,然后挑选出五个垂耳朵的例子,把它们移到右边

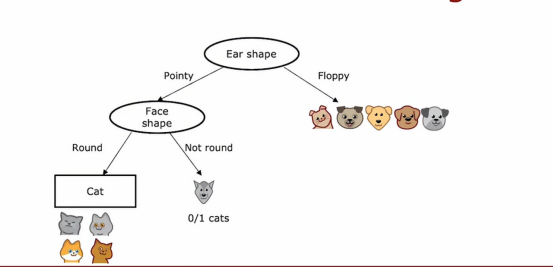

第二步是只关注左边部分,有时被称为是决策树的左分支,具体来说,我们应该选择一个特征去区分左边部分,我们将其选为面部特征

这样我们将圆脸放到左边,将不是圆脸放到右边,最后我们注意到左边的所有例子都为猫,因此不用继续区分,所以我们创建一个叶节点,该节点下全被判别为猫

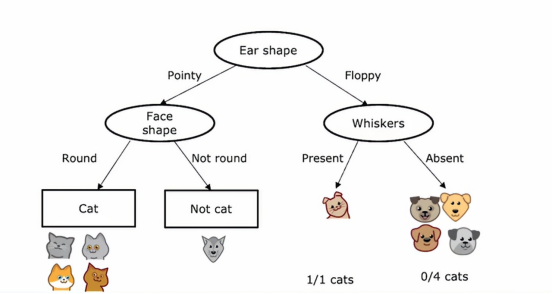

在这里我们发现右边没有一个猫,全是狗,所以我们在这里创建一个叶节点,预测为非猫,现在,我们算是完成了根节点左侧的所有工作,现在让我们把目光聚焦于右边,在这五个例子上,包含一个猫四个狗,我们同样需要一个特征来进一步地划分这五个例子,如果我们选择胡须作为特征

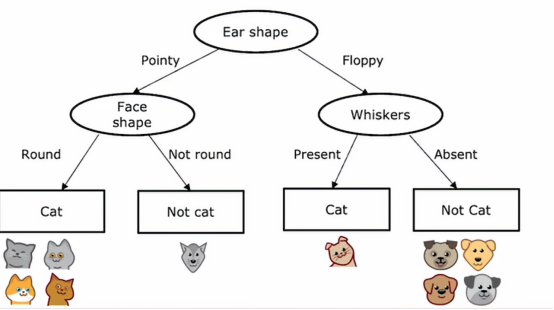

我们会发现左侧的全是猫,所以这每个节点是完全纯净的,要么全是猫,要么全不是猫,因此我们也会创建一些叶节点,在左边做出猫的预测,在右边做出非猫的预测

所以这就是构建决策树的过程,通过这个过程,在算法的不同步骤中有几个关键决策需要我们做出,我们来讨论一下关键决策

1、关键决策

1.1、第一个关键

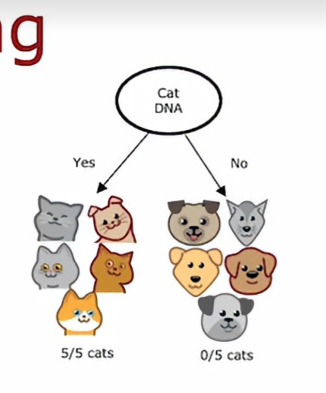

首先我们需要思考的是,如何选择在每个节点上使用哪个特征进行划分,在根节点上,以及在决策树的左分支和右分支上,我们需要决定如果该节点有一些例子是猫和狗的混合,我们是要用耳朵特征划分、还是脸型特征、或者用胡须特征,我们会在之后的学习中会知道决策树将选择哪个特征进行划分,以尽量最大化纯度,所谓纯度,是指我们希望获得尽可能接近全部是猫或全部是狗的子集,例如,我们有一个特征是,该动物是否有猫的DNA,实际上我们并没有这个特征,但如果我们有,我们可以在根节点上使用这个特征进行划分,这样左分支中会得到五只猫,右分支没有猫

这样左右两个子集数据都是完全纯净的,这意味只有一个类别,要么只有猫,要么不是猫,在这些左右两个子分支都是如此,这就是为什么猫的DNA特征将是一个很好的特征,但按照我们常识肉眼观察的话,我们不得不决定是否在耳朵形状上进行划分

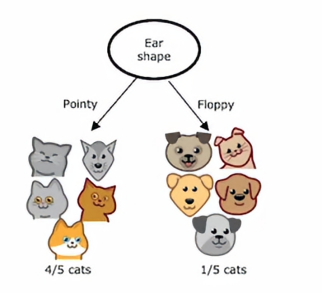

那我们会得到4个猫和1个狗在左边这个分支,1个猫个4个狗在右边这个分支

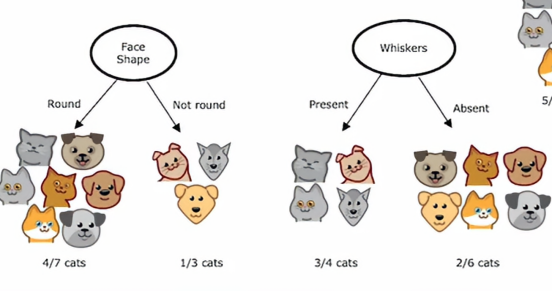

抑或是脸型和胡须之间做出选择,现在我们有一个问题,就是这么多分类的方法,我们怎样选择,决策树的效率会最高呢,答案是选择纯度最高的一个,我们看第一种方法,即按照耳朵形状进行区分,有4/5的猫被区分出来,第二种方法,有4/7的猫被区分出来,第三种方法,有3/4的猫被区分出来,相比后两者,第一种方法区分出来的猫的比例是最多的,所以我们可以选择第一个作为决策条件,即第一个条件是纯度最高的

所以在学习决策树时,我们必须做出第一个决定是如何选择在每个节点进行划分的特征

1.2、第二个关键

构建决策树的第二个关键是何时停止划分,我们刚才使用的标准是直到一个节点100%全是猫或者100%全是狗或不是猫,另外,我们也可以决定在进一步划分节点会导致树超过某个限制时停止划分,在我们允许树生长到最大深度是我们可以决定的参数,在决策树中,节点的深度定义为从根节点到达该节点所需的跳数,就是最顶端的节点到特定节点,所以根节点自身无需跳转,处于深度0,它下面的节点处于深度1,再往下面的节点属于深度2

所以,如果我们决定将决策树的最大深度设为2,那么我们会决定不再划分低于这个层次的任何节点,这样树的深度永远不会达到3,我们这么做的原因就是我们需要限制决策树深度的一个原因是首先确保树不会变的太大和难以管理,其次,通过保持树的规模较小,使其不容易过拟合

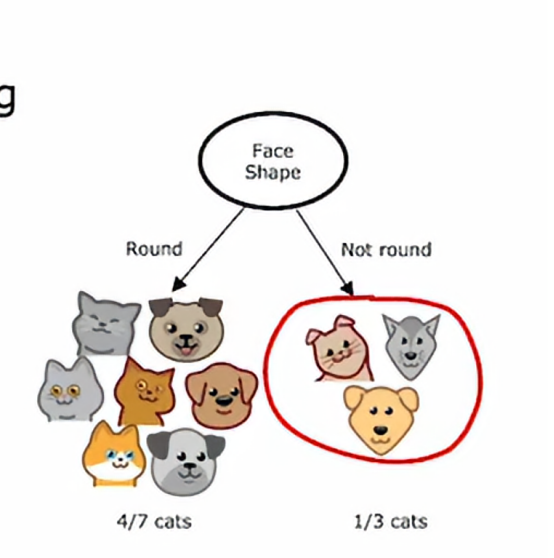

我们可能使用的另一个决定停止划分的标准是纯的得分的改进,我们会在后面具体学到,低于某个阈值,所以如果划分一个节点仅带来最低的纯度改进或者我们后面看到它实际上降低了纯度,但如果收益太小,那么我们可能不会这么做,同样,为了保持树的规模较小并减少过拟合的风险,最后如果一个节点上的示例数量低于某个阈值,那么我们也可能停止划分,比如说,如果在根节点我们按照面部形状特征进行划分,那么右侧分支将只有三个训练示例其中一个是猫,两个是狗

而不是进一步划分为更小的子集,如果我们决定不再划分仅有三个或更少示例的集合,那么我们只需要创建一个决策节点,这个右边这个节点就被预测为不是猫

我们不再决定划分的一个原因是保持树的规模较小并避免过拟合

总结

今天对决策树的学习让我掌握了一种直观易懂的机器学习方法。通过猫分类的生动例子,我明白了决策树就像一套"如果…那么…"的判断规则,从根节点开始根据特征值不断分支,直到叶节点给出最终预测。最重要的收获是理解了构建决策树时的两个关键决策:如何选择划分特征(要选能让子集最纯净的特征)和何时停止划分(可以设置最大深度、纯度改进阈值或最小样本数)。这些停止条件很重要,能防止树过于复杂导致过拟合。决策树的这种树状结构很直观,容易解释,让我对机器学习模型的可解释性有了新认识。