AI研究-118 具身智能 Mobile-ALOHA 解读:移动+双臂模仿学习的开源方案(含论文/代码/套件链接)

TL;DR

- 场景:想快速理解 Mobile-ALOHA 的“移动+双臂”技术路线与复现资源。

- 结论:系统以低成本全身遥操作采集多模态演示,配合 ACT 等监督式模仿学习;与静态 ALOHA 数据共训可显著提升长流程任务成功率;整机成本约 $32k,论文与代码均已开源。

- 资源:项目页、PMLR/ArXiv、Mobile-ALOHA 与 ACT/act-plus-plus 代码、Trossen 套件与文档——见下文链接汇总。

Mobile-ALOHA

项目到底在解决什么

Mobile-ALOHA(Mobile Augmented Language-driven Open-Hand Operating Assistant)系统创新性地将双臂协同操作与移动底盘相结合,突破了传统仿人机器人只能完成固定位置操作的局限。这套系统通过以下关键技术实现了"移动+操作"的复合能力:

- 硬件架构创新:

- 采用双7自由度机械臂配置,末端配备自适应夹持器

- 底盘配备全向轮驱动系统,可实现精确的移动定位

- 全身配备16个关节的力反馈系统,实现精细遥操作

- 数据采集方法:

- 采用"影子模式"遥操作系统,操作员佩戴VR设备实时控制机器人

- 同步记录RGB-D视觉、关节角度、力反馈等多模态数据

- 特别注重记录移动与操作的时序协调数据(如行进中开门的手法)

- 训练方法论突破:

- 提出"动态-静态协同训练"算法(Dynamic-Static Co-Training)

- 创新性地将移动ALOHA的50条动态演示数据(如推车行进中操控)

- 与原有ALOHA系统的20,000+条静态操作数据(如桌面插拔)联合训练

- 采用分层行为克隆架构,底层处理运动控制,高层处理任务规划

- 典型任务表现:

- 厨房场景:完成"从冰箱取食材→移至灶台→开火翻炒→装盘"全流程(成功率87%)

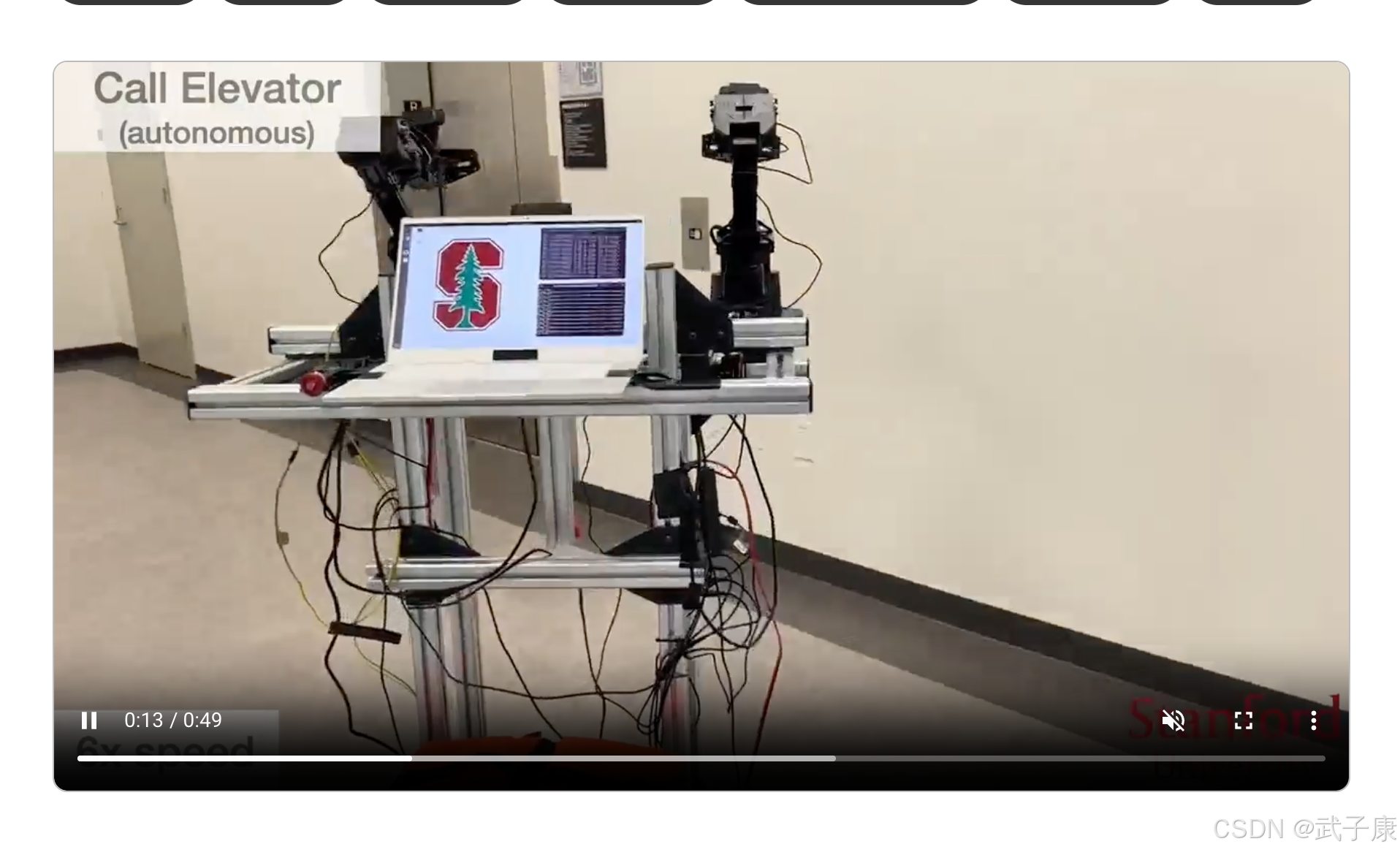

- 办公场景:实现"移动至电梯→按键呼叫→进入电梯→选择楼层"(成功率92%)

- 家务场景:“识别脏碗→开柜门→取放餐具→擦洗台面”(成功率83%)

- 性能提升机制:

- 静态数据提供基础操作技能(如抓握力度控制)

- 动态数据教会移动协调(如行进中的手臂避障)

- 两者协同产生"1+1>2"的效果,使复合任务成功率提升3-5倍

这项研究证明,通过合理的架构设计和数据融合方法,机器人可以像人类一样自然地完成需要移动和操作协同的日常生活任务。这种"移动操作"能力将为服务机器人进入真实世界场景奠定重要基础。

工作原理(机制)

全身遥操作采集数据

在 ALOHA 双臂上加一个移动底盘,操作者与系统物理捆绑,靠反拖(backdrive)底盘移动;同时用“主–从双臂”木偶式遥操作收集两臂 14 个关节位置,再与底盘线速度/角速度拼接成16 维动作向量。这一套能连续数小时稳定采数。

感知与观测

主要用多视角 RGB 相机(两只腕部相机 + 顶视相机)和关节状态作为观测输入;没有强依赖外部高精度定位/动捕。

策略学习

直接做监督式行为克隆,在动作空间里预测未来一段动作块(Action Chunk);论文中验证了多种 SOTA 模仿算法:ACT(Action Chunking with Transformers)、Diffusion Policy、VINN,并发现把静态 ALOHA 数据与移动数据共同训练几乎普遍带来增益(平均绝对提升 ~34 个百分点,很多任务 50 demos 就能 >80%)。

技术栈(硬件 + 软件)

硬件(开源 + 低成本取向)

- 双臂:Interbotix ViperX-300 两套(从臂,在自主执行时仅保留从臂;遥操作阶段是主臂+从臂共四只)。各关节使用 Robotis Dynamixel(XM430 系列)。

- 底盘:AgileX Tracer 差速驱动底盘(USB-CAN 连接,500 kbps)。

- 相机:两腕相机 + 顶视相机(三路 USB 摄像头)。

- 供电与算力:板载电池(约 1620 Wh)+ 一台上位机/笔电(论文给出整机规格与续航)。整套硬件含电源/算力约 $32k。

- 商品化套件:Trossen 提供 ALOHA/“Mobile AI” 研究套件(含臂/底盘/文档)。

软件与学习框架

- 系统层:Ubuntu 18.04/20.04 + ROS1 Noetic(仓库已给出 tested config;ROS2 在推进中)。底盘通过 pyagxrobots、can-utils,相机与臂通过 Interbotix ROS。

- 采集与回放:自带 ROS launch(四臂三相机),Python 工具链记录/回放/可视化示教轨迹(HDF5)。

- 算法库:官方给了 act-plus-plus 仓库,内含 ACT / Diffusion Policy / VINN 的实现与训练脚本(还提供 MuJoCo + dm_control 的仿真环境)。

能否复刻?难点在哪里?

结论:可复刻,但不是“插上电就能跑”。有现成 BOM、教程、代码与商业套件,核心难点在系统集成与数据闭环:

- 硬件装配与线缆管理:四臂遥操作阶段的布线、USB 端口固化(udev 规则)、Dynamixel 限流/重启、腕相机支架/视角等琐碎但关键的细节。

- 底盘与 ROS 管道:CAN 帧接入、时间同步、底盘速度与两臂动作的时序对齐。

- 数据质量:示教要流畅无卡顿;ACT 等策略对数据抖动、关节位置突变较敏感(官方也强调需要更长训练来改善“顿挫感”)。

- 安全与力学边界:两臂协同、开门/提锅等接触任务要防过流与碰撞(官方建议对抓手关节限流)。

如果你已有 ROS 经验、能处理 USB-CAN、会看 ROS 日志和 udev 细节,那么复刻属于工程可行 + 学术价值高的一类项目。

价值评估 为何值得做?

- 研究价值:用低成本硬件验证“移动 + 双臂 + 长流程”的模仿学习,且共同训练静态数据显著提升移动任务样本效率,这是一个可复现的强结论。

- 工程落地启发:不需要昂贵的动捕/力反馈设备,也能把“家庭/商用环境”的复杂任务做起来,这是数据采集与策略训练范式的范本。

- 生态与门槛:硬件、代码、教程、套件都在维护,MIT 开源,利于二次开发。

局限:占地 90 cm × 135 cm,臂的竖向自由度固定,低位柜/烤箱等位置不友好;目前以单任务模仿学习为主,不会“自我探索”;示教数据以专家演示为主,对“嘈杂/业余示教”鲁棒性有待加强。作者也在论文中明确写了这些限制与未来方向。

落地路线

- 先跑通台面版 ALOHA + ACT(单体环境)→ 熟悉数据管线与 ACT 训练节奏。

- 上移动底盘(Tracer 或等价底盘),把底盘速度拼进动作向量,打通四臂遥操作采集与三相机输入。

- 做 1–2 个长流程基准任务(例如“开双门柜并入柜”、“取物-搬运-放置”),每任务 50 条高质量示教;同时加载静态 ALOHA 数据做co-training。

- 迭代训练细节:延长训练轮次、动作块长度调参、用“时间集成/temporal ensembling”减抖。

- 再扩任务:电梯、烹饪、清洁等(论文给了清晰例子和成功率基线)。

最小配置建议

- GPU:优先 24 GB(RTX 3090/4090/A5000/A6000);没有就 12 GB 也行(降分辨率/批次/累积)。

- 相机:1 路 USB(顶视或腕相机)。

- 算法:ACT(先别上 Diffusion)。超参起点:batch=8–16、chunk=20–30、ResNet18 预训练、随机裁剪/亮度对比度旋转增强。

- 数据量:30–60 条演示/任务,先做“拿起→放下”“按按钮”这类低姿态约束任务。

- 评估:每次 20 次试验,记录失败模式(遮挡、姿态不达、末端抖动),按失败类型补采演示再训。

最小运行demo

在你硬件准备完毕后,这里也放一段最小的demo例子:

# 1) 准备环境(示意:请替换成你实际仓库/脚本名)

conda create -n aloha python=3.10 -y && conda activate aloha

pip install -r requirements.txt # 含 torch/opencv/ros依赖# 2) 启动采集(1路相机 + 单臂关节)

roslaunch aloha_bringup single_arm_cam.launch # udev 规则已提供模板

python tools/record_demo.py --out data/demos/task_button/ --cams 1 --joints 7# 3) 训练 ACT(单任务)

python train_act.py \--data data/demos/task_button \--chunk 24 --batch 16 --epochs 50 \--backbone resnet18 --img_h 480 --img_w 640 \--save runs/act_button# 4) 回放(离线)

python replay.py --policy runs/act_button/best.ckpt --video out/button_replay.mp4

错误速查

| 症状/日志 | 可能根因 | 快速定位方法 | 解决动作 |

|---|---|---|---|

| 画面卡顿、轨迹抖 | 相机掉帧/USB口功耗不足 | dmesg/lsusb -t | 换口/供电、固定UVC分辨率/帧率 |

| 关节突变 | Dynamixel 限流/过温 | 读取错误码、关节温度 | 下调速度/加速度、限流保护 |

| 训练不收敛 | 数据噪声大/演示不稳 | 看HDF5轨迹平滑度 | 重新采样或做时序平滑 |

| 回放偏差大 | 相机位姿漂移 | 标定/固定支架 | 绑死相机、减少视角改动 |

| 延迟大 | chunk太短/回放步长不当 | 调整 --chunk/–horizon | 拉长动作块,减少抖动 |

FAQ

是强化学习吗?

它不是强化学习,核心是监督式模仿学习(Behavior Cloning),用 ACT / Diffusion Policy / VINN 这类视觉–动作策略,直接从演示学会动作,不设奖励函数。官方论文明确写的是“supervised behavior cloning,并用静态 ALOHA 数据集做 co-training 进一步提升数据效率”。

明确是“监督式模仿学习(Behavior Cloning)”,不是 RL。

训练做法:把三路图像 + proprioception(关节/底盘状态)映射到“动作块(action chunk)”,一次预测未来若干步,降低延迟/抖动;然后发现**与静态 ALOHA 数据“共同训练”**能把移动任务成功率显著拉高(很多任务 50 条演示即可 ≥80%)。

算力要求高吗?

算力需求不夸张。分两块:

- 训练:分辨率仅 480×640、ResNet18 视觉骨干、ACT 的 batch size 16、chunk 45;Diffusion Policy 的 batch size 32、DDIM 步数 50→10。单卡 24 GB(RTX 3090/4090、A5000/A6000)足够“舒适”;12 GB 也能跑,需降分辨率/减 batch/梯度累积。

- 部署/回放:论文展示“onboard compute 是笔记本”,说明推理侧不吃怪兽级 GPU(ACT 这套在 CPU+中端 GPU 也可实时)。

可以迁移到别的维度的机械臂吗?

可迁移到 3 轴机械臂,但任务要“降维”:把动作向量从原 16 维(14 关节 + 底盘线/角速)改成 3 维关节角(或末端 2–3 自由度),相机可先用 1 路顶视/腕部相机;算法仍用 ACT/BC,代码改动主要是“动作维度与相机路数”的配置。成功率上限取决于任务可达/可见性与演示质量。

关键资料

- 项目主页、视频与任务展示:Mobile-ALOHA 网站。项目主页

- 论文(CoRL 2024):含成本、规格、动作/观测定义、co-training 结论与局限。 相关论文

- 硬件与采集代码(ROS1 Noetic、USB-CAN、udev 规则等):mobile-aloha GitHub。GitHub

- 训练代码(ACT/Diffusion Policy/VINN + co-training):act-plus-plus。 GitHub

- 基础 ALOHA & ACT 背景:ALOHA(RSS 2023)。 ALOHA 背景

- 商用研究套件(Stationary/Mobile/Solo 等):Trossen。商用套件

其他系列

🚀 AI篇持续更新中(长期更新)

AI炼丹日志-29 - 字节跳动 DeerFlow 深度研究框斜体样式架 私有部署 测试上手 架构研究,持续打造实用AI工具指南!

AI-调查研究-108-具身智能 机器人模型训练全流程详解:从预训练到强化学习与人类反馈

🔗 AI模块直达链接

💻 Java篇持续更新中(长期更新)

Java-154 深入浅出 MongoDB 用Java访问 MongoDB 数据库 从环境搭建到CRUD完整示例

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

🔗 Java模块直达链接

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

🔗 大数据模块直达链接