【AI论文】PICABench:我们在实现物理逼真图像编辑的道路上究竟走了多远?

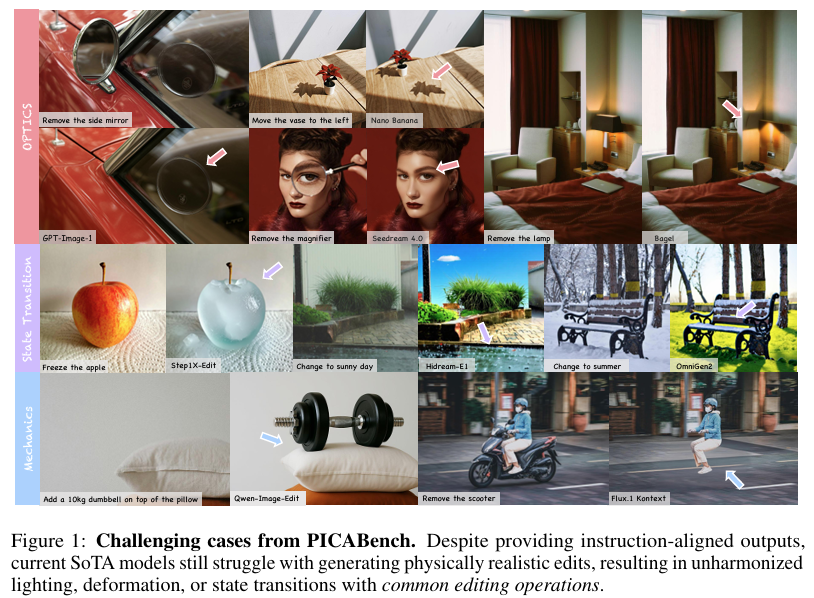

摘要:近期,图像编辑技术取得了显著进展。现代编辑模型已能够遵循复杂指令对原始内容进行操作。然而,除了完成编辑指令外,伴随产生的物理效果是决定生成结果真实感的关键。例如,移除一个物体时,还应同时移除其阴影、反射以及与附近物体的交互效果。遗憾的是,现有模型和基准测试主要聚焦于指令完成度,却忽视了这些物理效果。那么,就目前而言,我们在实现物理逼真图像编辑的道路上究竟走了多远?为解答这一问题,我们推出了PICABench,它针对大多数常见编辑操作(如添加、移除、属性更改等),从光学、力学和状态转换这八个子维度对物理真实感进行系统性评估。此外,我们还提出了PICAEval这一可靠评估协议,它采用视觉语言模型(VLM)作为评判者,并结合逐案例、区域级的人类标注和问题。除了基准测试外,我们还通过从视频中学习物理知识来探索有效解决方案,并构建了训练数据集PICA-100K。在对大多数主流模型进行评估后,我们发现,物理真实感仍是一个具有巨大探索空间的挑战性问题。我们希望,我们的基准测试和提出的解决方案能够为未来从简单内容编辑迈向物理一致的真实感研究奠定基础。Huggingface链接:Paper page,论文链接:2510.17681

研究背景和目的

研究背景:

近年来,图像编辑技术取得了显著进展,现代编辑模型已经能够根据复杂的指令对原始内容进行操作。

然而,除了完成编辑指令外,伴随的物理效应是图像真实感的关键。例如,移除一个物体不仅应移除其阴影、反射以及与附近物体的交互,还需确保这些物理效应在编辑后的图像中保持一致。尽管现有的图像编辑模型和基准测试已经关注到了指令完成的重要性,但它们往往忽视了这些物理效应,导致生成的图像在物理一致性上存在缺陷。

研究目的:

本研究旨在填补这一研究空白,通过引入PICABench,一个系统评估图像编辑物理真实感的基准测试,以及PICAEval,一个可靠的评价协议,来推动图像编辑技术从单纯的内容编辑向物理一致性现实感的方向发展。具体研究目的包括:

- 系统评估:构建一个全面的基准测试PICABench,涵盖光学、力学和状态转换等多个物理维度,以评估图像编辑模型在物理真实感方面的表现。

- 可靠评价:提出PICAEval评价协议,利用VLM(视觉语言模型)作为评估者,结合人类注释的关键区域和具体问题,提供可解释且可靠的评价。

- 解决方案探索:通过从视频中学习物理知识,构建一个大规模的训练数据集PICA-100K,并展示在该数据集上微调后的模型能够显著提升物理一致性,同时保持语义准确性。

研究方法

1. PICABench基准构建:

PICABench是一个系统评估图像编辑物理真实感的基准测试,涵盖了光学、力学和状态转换三个核心维度,进一步细分为八个子维度:光传播、反射、折射、光源效应、变形、因果关系、全局状态转换和局部状态转换。

基准测试包括900个编辑样本,每个样本都针对特定的物理维度进行设计,以全面评估图像编辑模型的物理真实感。

数据收集:

使用GPT-5生成与八个子维度相关的关键词,并利用这些关键词从授权和公共来源检索多样化的图像。

人类标注者对图像进行筛选和标注,确保图像具有显著的物理特征。

指令构建:

为每个保留的图像编写人类编写的自然语言指令,这些指令旨在诱导与场景物理属性相关的编辑。

指令分为三个复杂度级别:表面指令、中间指令和明确指令,以评估模型在不同提示复杂度下的表现。

2. PICAEval评价协议:

PICAEval是一个基于VLM的区域感知、问答式评价协议,用于评估图像编辑的物理真实感。该协议通过生成与编辑图像和指令相关的具体问题,并利用VLM进行回答,来评估编辑后的图像是否保持了物理一致性。

问题生成:

使用GPT-5根据编辑指令和关键区域生成一系列二元问答对,这些问题专注于可观察的物理现象,如阴影、反射、物体接触等。

评估流程:

在评估时,VLM接收编辑后的图像、指令、区域和问题,并生成回答。

PICAEval计算VLM回答与参考标签匹配的比例,作为物理真实感的度量。

3. PICA-100K数据集构建:

为了提升模型在物理一致性方面的表现,本研究构建了一个大规模的合成数据集PICA-100K。

该数据集通过视频生成技术模拟物理变换,生成具有物理一致性的编辑对。

视频生成:

利用文本到图像模型(如FLUX.1-Krea-dev)生成静态源图像,并使用图像到视频模型(如Wan2.2-14B)合成描述物理变换的短视频。从视频中提取首尾帧,形成(源图像,编辑后图像)对。

标注与细化:

使用GPT-5自动标注每对图像,标记编辑后的图像为首选输出。

这一过程消除了手动标注的需要,同时保持了标注的一致性。

研究结果

1. 基准测试结果:

在PICABench上的评估结果显示,现有模型在物理真实感方面仍存在显著差距。

即使是领先的闭源模型(如GPT-Image-1和Seedream4.0)也仅略微超过60分的门槛,而开源模型则普遍低于60分。这表明,当前图像编辑模型在生成物理一致性编辑方面仍有很大提升空间。

2. 提示复杂度的影响:

模型性能随着提示复杂度的增加而提升。

明确提示下的模型表现优于中间提示和表面提示,这表明更详细的提示有助于模型更好地理解并应用物理知识。

3. PICA-100K数据集的有效性:

在PICA-100K数据集上微调后的模型(如FLUX.1Kontext+SFT)在物理一致性方面表现出显著提升。

与基线模型相比,微调后的模型在多个物理维度上的准确性和一致性均有所提高,验证了从视频中学习物理知识的有效性。

4. 与人类偏好的相关性:

通过Elo排名系统进行的人类研究表明,PICAEval与人类偏好具有较高的相关性。

这表明,PICAEval评价协议能够准确反映人类对图像编辑物理真实感的判断。

研究局限

1. PICA-100K数据集的规模与多样性:

尽管PICA-100K数据集在提升模型物理一致性方面表现出色,但其规模仍有限,且生成过程相对简单。

未来工作可以进一步扩大数据集规模,并引入更复杂的生成管道,以提升数据的多样性和复杂性。

2. 模型训练方式的局限性:

当前模型主要通过监督微调(SFT)进行训练,这虽然带来了性能提升,但可能未充分利用数据的全部潜力。未来工作可以探索强化学习(RL)等更先进的训练方法,以进一步提升模型性能。

3. 多图像与多条件上下文的支持:

当前框架仅支持单图像输入,缺乏对多图像或多条件上下文的支持。未来工作可以扩展模型架构,使其能够处理更复杂的输入条件,提升模型的实用性和灵活性。

未来研究方向

1. 自适应渲染与生成:

未来的研究可以探索自适应渲染技术,根据任务类型或用户查询生成定制化的视觉表示,以在压缩率和性能之间找到更优的平衡点。

同时,可以研究更先进的生成模型,以生成具有更高物理真实感的图像。

2. 跨模态对齐与知识蒸馏:

通过跨模态监督和知识蒸馏技术,加强视觉文本模型与纯文本模型之间的对齐,可以缩小两者在泛化能力上的差距。

未来工作可以研究如何有效地将文本知识迁移到视觉模型中,提升模型在多模态任务中的表现。

3. 更广泛的应用场景:

将PICABench和PICAEval框架扩展到更广泛的应用场景中,如视频编辑、三维重建等,以验证其在不同领域中的有效性和普适性。

同时,可以探索将物理一致性评估应用于实际产品开发中,提升产品的用户体验和市场竞争力。

4. 持续迭代与优化:

随着技术的不断进步和新数据集的出现,持续迭代和优化PICABench和PICAEval框架至关重要。

未来工作可以定期更新基准测试和数据集,引入新的评估指标和挑战任务,以推动图像编辑技术的持续发展和创新。