多模态大模型开发实战 -- OCR 基础入门

一、多模态文档检索技术介绍

1.1 多模态RAG系统开发背景

在当今信息环境中,单一模态的检索已无法满足人们的需求。随着图像、视频、音频以及文本等多模态数据的高速增长与普及,知识的呈现方式不再局限于纯文本,更多地以丰富的多模态形式存在。从医学影像到工业监控,从视频课程到社交媒体,核心信息往往蕴含在多模态内容的交叉中。传统的文本检索无法充分利用这些异质信息,导致知识获取存在片面与缺失。多模态RAG(Retrieval-Augmented Generation)系统正是在这一背景下显得愈发重要。它能够跨模态整合信息,提升知识覆盖率与语义理解能力,为用户提供更准确、更全面的回答与洞察。这不仅是技术演进的趋势,更是应对现实复杂信息环境的必然选择。

多模态包括很多种类型,比如:

-

风景图

-

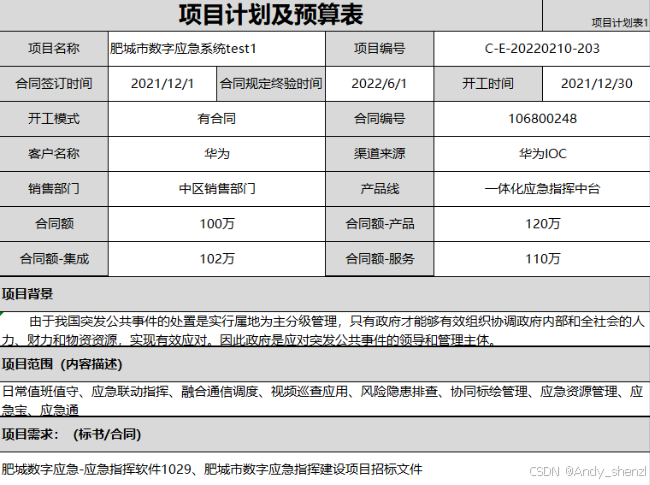

表格

-

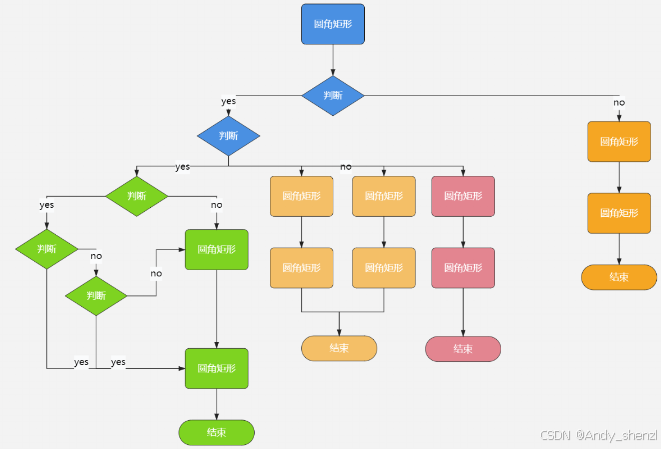

流程图

-

产品原型图

-

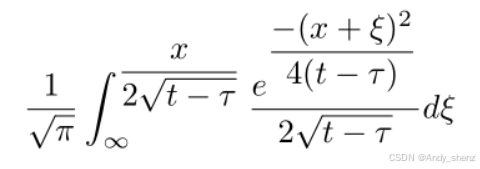

数学公式

-

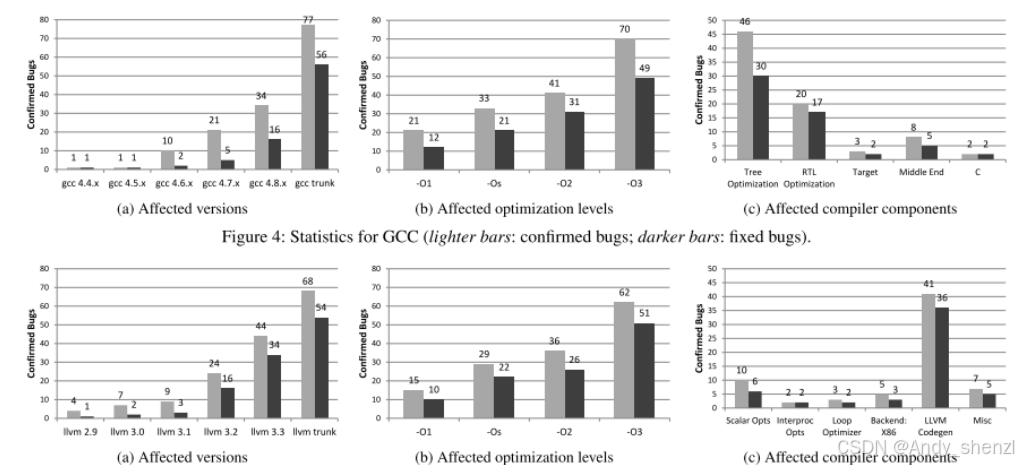

论文图表

-

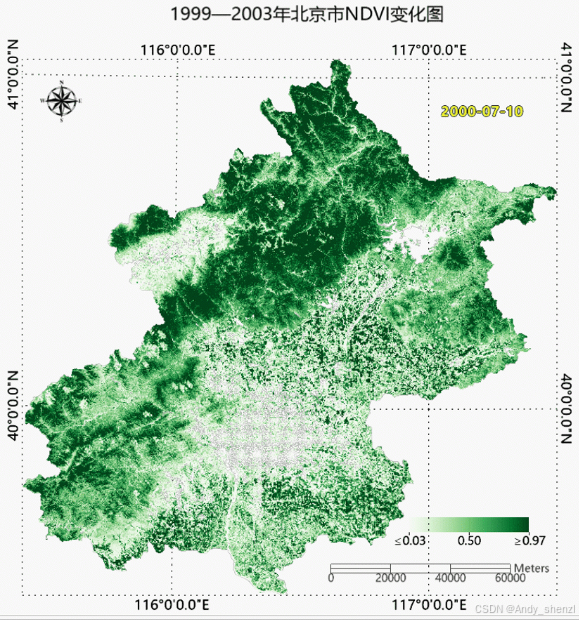

地理时空图

-

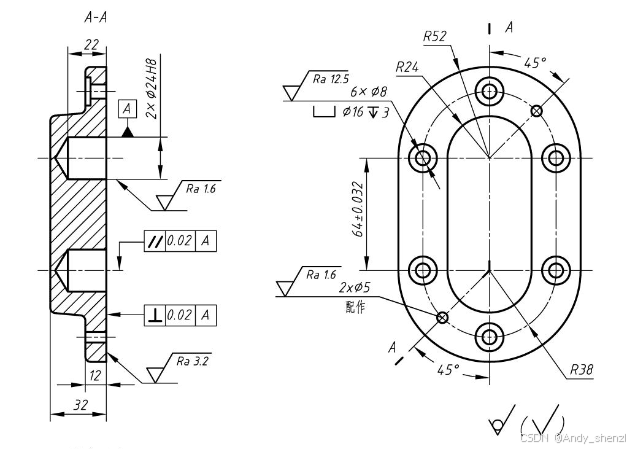

工程图

在现实中文档存在的方式还有很多种样式,所以在进行多模态开发时,第一步就是需要先确定文档存储的类型,然后针对文档的类型来进行识别。

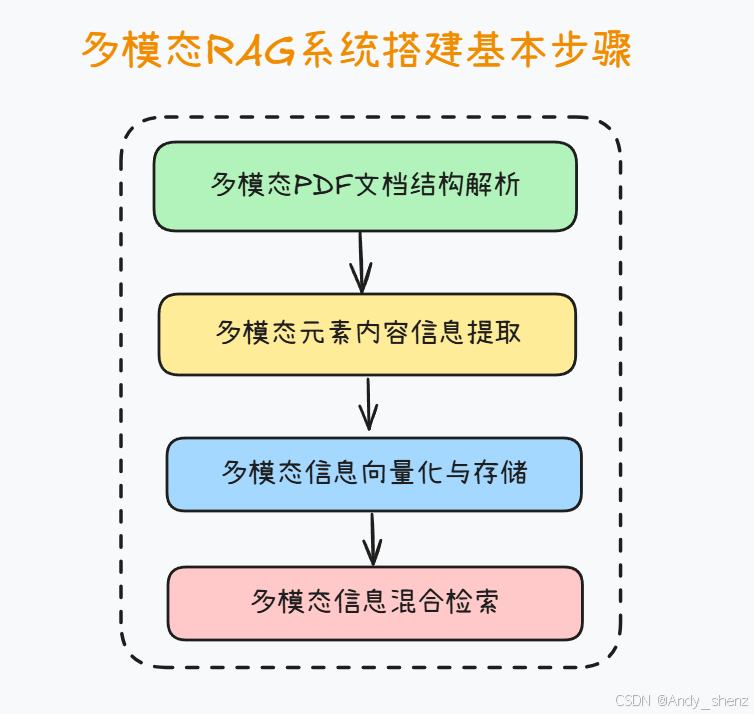

1.2 多模态系统开发的步骤

在构建多模态RAG系统的过程中,通常需要经过四个核心步骤。

- 首先是文档解析,即将原始的多模态资料(如PDF、视频、音频、图像等)进行结构化处理,确保不同格式的数据能够被系统统一理解和管理。

- 其次是多模态内容信息提取,在这一环节中,借助OCR、语音识别、图像标注等技术,将文本、语音、视觉要素转化为可计算的中间表示,从而捕捉潜在的知识点与语义线索。

- 第三步是多模态信息向量化与存储,通过预训练的跨模态嵌入模型,将不同模态的内容映射到同一语义空间,并结合向量数据库进行高效存储和索引。

- 最后是多模态信息检索方法,在实际应用中通过语义检索、跨模态对齐与重排序等策略,快速定位与用户问题最相关的内容,并将结果交由生成模型进行增强式回答。这一流程既保证了信息处理的系统性,又奠定了多模态RAG在复杂任务中提供精准洞察的基础。

这里需要注意,在绝大多数工程环节中,文档结构解析与多模态内容解析是同步进行的。多模态文档检索的核心思路:将文档转化为Markdown格式文档再进行检索

在多模态RAG系统的实践中,将PDF等复杂文档转化为Markdown格式后再进行检索,已成为一种通用且高效的做法。原因在于,PDF本身是一种排版与展示导向的格式,内部结构常常包含大量冗余信息、复杂布局和非线性内容(如表格、脚注、分页元素等),这使得直接检索难以保证准确性和一致性。而Markdown则提供了一种轻量级的结构化表达方式,能够在保持文档层级、段落与语义逻辑的同时,大幅简化格式复杂度。通过这一转换,文本信息被规整化,图像、表格等多模态元素也能以引用或标记的方式统一嵌入,进而更便于向量化处理与跨模态检索。换言之,Markdown既保留了信息的结构完整性,又为后续多模态信息抽取与语义检索奠定了清晰的基础,从而提升了整个RAG系统的稳定性与可扩展性。

1.3 多模态文档结构解析技术介绍

而在围绕多模态文档进行检索的过程中,首先需要围绕多模态文档中的多模态元素进行精准的识别。在实际的多模态文档检索过程中,单纯依靠文本层面的分词与索引往往难以满足需求,因为PDF、扫描件等文档通常包含复杂的 版面结构。因此,必须引入 文档结构化解析 作为关键步骤。例如实现如下流程:

- 版面区域划分(Layout Analysis)

首先需要对页面进行几何级别的分区,将文档中的 标题、正文、表格、图像、脚注、页眉页脚 等区域进行标注和切分。这一过程通常依赖 OCR 模型的检测能力,或使用专门的版面分析模型(如 LayoutLM、DocTr)来理解文档的空间排布。 - 层次结构建模(Hierarchical Structuring)

在完成区域划分后,需要识别文档的 逻辑层级,例如“章节 → 小节 → 段落 → 句子”。这一结构不仅有助于保持语义上下文的完整性,还能让后续的检索模块能够更好地进行分层召回。例如,当用户检索某一章节主题时,系统能直接定位到对应段落,而非无序的全文搜索。 - 表格与图表解析(Table & Figure Understanding)

对于包含数据的文档而言,表格和图表的解析是难点之一。表格需要经过 行列结构抽取,再转化为可索引的结构化数据;图表则需要通过 图像识别 + 语义标注 的方式提取数据点和趋势描述。这些信息可以作为检索时的重要补充。 - 跨模态信息融合(Multimodal Fusion)

在多模态场景下,单独处理文本或图像并不足够。解析过程中,需要将 文本信息、图像内容、表格数据 进行统一建模。例如,某一科学论文的实验结果可能同时存在于“正文描述 + 数据表格 + 折线图”中,完整检索必须能够跨模态聚合这些信息。

通过上述步骤,文档从最初的“视觉排版格式”被转化为具有 层次化、结构化和语义化 的知识表示,从而为后续的向量检索(RAG)、问答生成和多模态分析提供高质量的输入。

需要注意的是,一般当我们完成多模态PDF文档解析,就能够顺利的将PDF转化为Markdown了,此时图片会单独保存在本地某个文件夹里,并且以链接的方式插入在当前Markdown中。但如果无法对图片内容信息进行提取,则无法获得完整的文档信息。

1.4 多模态内容信息提取:图片内容信息提取方法介绍

在已完成文档结构化解析之后,图片内容的信息提取是多模态处理的关键组成部分。目前来说,最主流的两类提取图片内容信息的方案是使用OCR(光学字符识别)系统/模型,或者使用多模态大模型(VLM)对图片内容进行理解。这两个技术方案各自有各自不同的侧重点:

- 一般来说,OCR系统往往非常轻量高效,甚至无需GPU(或少量GPU算例)、仅需CPU即可完成图片内容的识别,而且OCR系统发展至今,已能拥有非常强悍的识别能力,无论是手写体还是表格文档,都能精准识别。

- 但问题是,OCR只能识别字符,对于一些高度结构化且主要以文本内容为主的图片(例如表格、发票、公式等)拥有较好的识别效果,但OCR系统无法对图片的含义进行理解,例如产品示意图、流程图等,都无法顺利识别。

- 此外,得益于光学字符识别的技术特性,OCR模型还能够对文档中的各元素结构进行识别,因此在文档解析阶段,最常用的模型就是OCR模型。

- 而相比之下,多模态大模型(VLM)则拥有更加通用的识别能力,无论是图片识别还是图片识别推理,都不在话下。但唯一的问题就是只有最顶尖的大模型才具备如此高精准度的识别+推理能力,调用费用不菲,而且还会面临数据隐私安全性风险,虽然有部分开源VLM模型,但往往参数规模较大,本地部署需要较高的硬件成本。

1.5 多模态PDF文档切分&检索常用流程

在 RAG 技术落地过程中,如何高效解析 PDF 并统一成可检索的多模态数据格式,是一个绕不开的核心问题。常见的通用套路主要包括以下几类:

-

基于结构解析的完整重建法

这一流程的核心思想是:先整体识别 PDF 的版面结构,再逐一解析其中的元素。具体步骤如下:- 版面解析:识别文档的整体结构,包括页面、段落、标题、表格、图片与公式等元素。

- 元素分离:

- 文本部分保留原有的段落与层级结构,避免丢失上下文语义;

- 图片、表格、公式等多模态内容单独提取,并在本地保存为独立文件;

- 筛选识别:

- 对于承载关键信息的多模态内容(如表格、公式、示意图),调用 OCR 或其他专用模型进行文字化处理;

- 对于装饰性图像或无关插图,则直接忽略,减少冗余。

- 统一转换:将上述内容转化为 Markdown 文档,文本与多模态对象通过占位符或链接进行关联。

- 检索阶段:最终将生成的 Markdown 作为知识库输入 RAG 系统,既能保证文本段落的连续性,又能保留多模态内容的溯源能力。

这种方法的优点在于:结构还原最完整,适合对学术论文、技术白皮书等结构化程度高的 PDF 进行精细化检索。

-

轻量化切分与多模态并行存储法

这种方法更强调效率,流程如下:

- 将 PDF 切分为多个逻辑单元(如页、段落、图片对象),不追求完整的版面还原;

- 文本单元直接进行向量化嵌入;

- 图片、表格等非文本元素,保留原始文件路径或转存为图像向量(通过 CLIP、BLIP2 等视觉模型处理);

- 检索时,文本查询可直接匹配文本嵌入,多模态查询(如带图的检索)则在视觉向量库中进行比对;

- 最终结果由融合器进行多模态合并与排序。

该方法的优点是:速度快、扩展性强,特别适合对非结构化 PDF(如报告、说明书、合同)进行快速索引和多模态查询。

- 知识单元抽取与语义增强法

该流程偏向语义驱动,重点在于信息抽取而非格式还原:

- 在解析 PDF 后,不仅保留原始元素,还通过信息抽取模型识别出 关键实体、关系和事件;

- 对表格进行结构化存储,例如转为 CSV 或数据库格式,便于后续 SQL/RAG 混合查询;

- 对公式、代码等特殊元素,转为 LaTeX 或结构化 AST 表示,以便在后续查询中更精确地匹配;

- 将提取出的知识单元与上下文文本一起送入向量库,形成“结构化 + 语义化”的复合检索能力。

优点在于:不仅支持常规的语义检索,还能支持结构化查询(如“查找文档中所有涉及 A 与 B 的关系”),更适合科研、金融、法律等场景。

| 流程名称 | 核心思路 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| 结构解析重建法 | 先识别 PDF 的整体结构,再逐一解析文本、图片、表格、公式等元素,最终统一转为 Markdown | 结构保留最完整,文本与多模态内容可溯源,适合精细化检索 | 处理复杂、耗时较长 | 学术论文、技术白皮书、科研报告 |

| 轻量化并行存储法 | 将 PDF 切分为文本单元和多模态单元,分别存入文本向量库和图像向量库,检索时并行查询 | 效率高、扩展性强,支持文本和图片混合检索 | 版面和层次结构缺失,语境关联弱 | 报告、说明书、合同等非结构化文档 |

| 知识单元抽取与语义增强法 | 在解析后进一步抽取实体、关系、表格、公式等知识单元,结合文本向量库构建复合检索 | 支持语义检索 + 结构化查询,适合知识发现与推理 | 前处理复杂,需额外的抽取模型 | 金融分析、法律文档、科研数据 |

二、多模态RAG系统相关模型&开源项目介绍

2.1 热门OCR模型介绍

在多模态 RAG 技术体系中,OCR(Optical Character Recognition,光学字符识别)模型依旧是最基础也最重要的一环。它们的核心价值在于,能够从 PDF、扫描件、票据、图像等文档中,快速而高效地识别出文本信息和基本的版面结构,为后续的向量化与语义检索提供输入。相比大型视觉语言模型(VLM),OCR 模型参数规模更小,推理成本低,甚至可以直接在 CPU 上运行,因而在大规模批处理和轻量化部署场景中有着无可替代的优势。不过,它们的局限也非常明显——通常只能做到文字级别的检测与识别,缺乏对图像内容的语义理解和推理能力。因此,OCR 常常作为「底层解析引擎」存在,与上层的 VLM 模型或产品工具相配合,形成完整的多模态信息处理流水线。

- dots.ocr

dots.ocr是小红书近期发布的OCR大模型。不同于传统 OCR 工具链依赖「检测 → 识别 → 版面重构」的多阶段流水线,dots.ocr 采用了统一的 Vision-Language Transformer 架构,将版面检测、文字识别和结构解析融为一体。这种设计极大减少了模块之间的对齐误差,使得模型在多语种文档、复杂版面和表格场景中表现出色。凭借仅 1.7B 的参数规模,dots.ocr 兼顾了轻量与高精度,被视为在“端到端文档解析”方向的重要突破。它的出现不仅推动了 OCR 技术向一体化演进,也为构建更高效的多模态 RAG 系统提供了新的底层支撑。

- 优势:单模架构减少流水线对齐误差;在多语言与复杂版面上表现突出;易用的 prompt 化任务切换(布局/表格/文本)。

- 局限:社区反馈在少数复杂表格(合并单元格)场景仍需微调或后处理。

- 适用:论文/报告、票据类文档的端到端解析;希望降低多模型编排成本的团队。

- 项目地址:https://github.com/rednote-hilab/dots.ocr

- olmOCR(Allen AI)

在轻量 OCR 工具中,olmOCR 的特色在于对复杂 PDF 与扫描文档进行“线性化还原”。它由 Allen Institute for AI (AI2) 团队于 2024 年开源,核心目标是最大限度地保持文档阅读顺序的完整性,同时兼顾表格、公式以及手写体等特殊内容的识别。olmOCR 的模型规模属于中小尺寸,总共7B参数,可以在常规 GPU 环境甚至部分 CPU 配置下运行,适合科研与生产场景的快速部署。与传统 OCR 偏重“字符识别”不同,olmOCR 更强调文档的整体可读性与内容一致性,因此在大规模 PDF 转文本的批处理场景下表现突出,是学术界和产业界逐渐关注的高保真 OCR 工具。

- 优势:对复杂排版的读序恢复能力强;手写体/公式覆盖;开箱即用。

- 局限:定位于“文本线性化”,对图像语义本身不做高级理解(需上层 VLM)。

- 适用:海量 PDF 到可检索文本的高质量批处理;RAG 预处理。

- 项目地址:https://github.com/allenai/olmocr

- PaddleOCR

作为最成熟的开源 OCR 工具链之一,PaddleOCR 由 百度飞桨(PaddlePaddle)团队自 2020 年起持续维护与迭代,至今已覆盖数十种模型和场景。其模型规模从轻量级 3–10M 参数的 CPU 可运行版本,到上百 MB 的高精度模型均有覆盖,用户可以根据硬件条件与精度需求灵活选择。PaddleOCR 的优势在于模型生态完整,涵盖文本检测、识别到版面分析的全流程,且原生支持多语种(含中文、英文、日文、韩文等 80+ 语言)。凭借优化的推理性能和丰富的部署方案(服务器、移动端、嵌入式),它已经在票据识别、发票解析、工业表单处理等领域被广泛应用。虽然在复杂表格、跨页排版等语义层面仍需额外规则或上层模型辅助,但凭借其大规模用户群体与长期工程化打磨,PaddleOCR 已成为工业界 OCR 的事实标准。

- 优势:生态完善、文档与示例丰富、轻量模型可 CPU 运行;在特定流水线中官方示例强调“毫秒级”预测与灵活服务部署。

- 局限:对复杂表格/图表/跨页关系仍需规则/二次建模;语义理解需与上层模块结合。

- 适用:端侧/低成本批处理、工程化稳定大规模 OCR 服务。

- 项目地址:https://github.com/PaddlePaddle/PaddleOCR

| 模型 | 发布团队 | 参数规模 | 核心特点 | 优势 | 局限 | 适用场景 |

|---|---|---|---|---|---|---|

| dots.ocr | HiLab 社区 / 开源社区 | ~1.7B | 统一 VLM 架构,版面检测+字符识别一体化,多语种 | 精度高,结构保持好,复杂表格/论文解析表现突出 | 合并单元格等极端结构仍需微调;需 GPU 运行 | 论文、技术文档、票据类端到端解析 |

| olmOCR | Allen Institute for AI (AI2) | 7B | 高保真文档线性化,保持阅读顺序,支持表格/公式/手写体 | 可在普通 GPU/部分 CPU 上运行,文本还原度高 | 偏重文本线性化,缺乏图像语义理解 | 大规模 PDF 转文本,科研/学术批处理 |

| PaddleOCR | 百度飞桨(PaddlePaddle) | 轻量模型 3–10M;高精度百 MB 级 | 工业级 OCR 工具链,覆盖检测/识别/版面分析,多语种 | CPU/移动端可运行,文档与社区完善,部署稳定 | 表格/跨页结构复杂时需规则或上层模型配合 | 工业票据识别、大规模生产环境 OCR 服务 |

2.2 热门VLM模型介绍

- 在线VLM模型

在多模态 RAG 技术体系中,在线 VLM 模型是目前能力最全面的语义理解引擎。这类模型往往由顶尖大厂训练并托管在云端,参数规模达到数百亿甚至上千亿,具备强大的多模态感知与推理能力。典型代表包括 OpenAI 的 GPT-5(原生支持文本、图像、音频等模态,提供完善的 API 与生态)、Google 的 Gemini 2.5(强调长上下文、多语言和与搜索/Workspace 的无缝集成)、以及 Anthropic 的 Claude 4.1(在多步推理与代理式任务中表现突出,并已在多云环境提供企业级接入)。这类在线模型的优势在于即开即用、功能齐全、语义理解能力极强,但与此同时也存在调用成本高、隐私合规受限的现实问题。因此,在线 VLM 更适合作为复杂问题的“上层大脑”,在需要深度语义理解、跨模态推理和企业级可靠性的场景下发挥核心价值。 - InternVL 3.5模型

InternVL 3.5 由 上海人工智能实验室 (Shanghai AI Lab) 联合多家科研团队于 2025 年发布,是继 InternVL 2.x 系列后的重大更新版本。该模型参数规模覆盖 8B 至 40B,在图像理解、表格解析、跨模态检索和复杂推理方面均有显著提升。特别是提出了 Cascade RL(级联强化学习) 策略,用于增强模型的多步推理稳定性,使其在图表问答、科学文献解析等任务中表现优于同类开源模型。

- 优势:推理链条长、跨模态任务表现强,支持多语言和科研级任务;社区生态活跃。

- 局限:大尺寸模型的显存占用较高,对硬件配置有一定门槛。

- 项目地址:https://github.com/OpenGVLab/InternVL

- Qwen3-VL

Qwen3-VL 是 阿里巴巴达摩院 在 2025 年推出的最新一代视觉语言模型,是 Qwen2.5-VL 的升级版。其参数规模从 3B、7B 到 72B,覆盖轻量部署与高性能需求,具备目标检测、图表理解、视频解析等全面能力。Qwen3-VL 在 跨语言文档解析、长视频理解 上有增强优化,并延续了 Qwen 系列在企业级开源社区中的强大影响力。

- 优势:参数规模覆盖广,性能与成本可灵活平衡;对文档/图表解析能力突出。

- 局限:大尺寸模型需要高端 GPU,推理延迟较大。

- 适用场景:企业文档检索、长视频内容解析、多语言跨模态问答。

- Qwen2.5模型开源地址:https://github.com/QwenLM/Qwen2.5-VL

- SmolVLM

SmolVLM 由 Hugging Face 社区在 2024 年末发起,是一类 轻量级 Vision-Language Model,参数规模通常在 1B–2B 左右,主打 低算力环境可运行。与大型 VLM 相比,SmolVLM 的目标不是追求极致性能,而是通过紧凑模型结构,在笔记本或中低端 GPU 上也能实现图文问答、图像 caption 等多模态任务。

- 优势:模型小巧,部署门槛低;训练与调用成本显著低于大型 VLM。

- 局限:在复杂表格解析、多步推理上的表现明显落后于大模型;在专业场景(科研、法律文档)效果有限。

- 适用场景:教学实验、个人项目、边缘设备上的轻量多模态应用

- 项目地址:https://github.com/huggingface/smollm

- Gemma 3

Gemma 3 是 Google DeepMind 在 2025 年开源的最新多模态模型,提供 4B、12B、27B 三个参数规模,支持文本与图像输入。Gemma 3 延续了 Gemma 系列开源、透明、注重轻量化的设计理念,并针对 图像问答、图表解析 等任务做了优化。它兼顾了学术研究的可复现性与企业应用的可落地性,尤其在中小规模下提供了性能与算力需求的良好平衡。

- 优势:覆盖轻量到中型参数规模,支持多模态输入;Google 官方维护,生态完善。

- 局限:相比更大规模的 VLM(如 GPT-5、InternVL 40B),在复杂推理和长文档解析上能力有限。

- 适用场景:科研探索、企业试点项目、对成本敏感的多模态应用。

- 模型地址:https://huggingface.co/google/gemma-3-4b-it

| 模型 | 发布团队 | 参数规模 | 类型 | 核心特点 | 优势 | 局限 | 适用场景 |

|---|---|---|---|---|---|---|---|

| GPT-5 | OpenAI | 百亿+ | 在线 API | 原生多模态(文本/图像/音频),API 生态完善 | 功能最全,推理强,生态成熟 | 成本高,需考虑隐私合规 | 高阶语义推理,企业级 RAG,代理任务 |

| Gemini 2.5 | Google DeepMind | 数百亿 | 在线 API | 长上下文(百万级),文本/图像/音频/视频融合 | 与搜索/Workspace 深度整合,多模态能力强 | 部署受地区/合规限制 | 长文档检索,复杂企业场景 |

| Claude 4.1 | Anthropic | 百亿+ | 在线 API | 多步推理与代理式任务突出 | 长程任务表现好,企业接入灵活 | 成本与速率受限,图像能力因版本而异 | 工程/科研多步任务,企业合规环境 |

| InternVL 3.5 | 上海人工智能实验室 | 8B–40B | 开源 | Cascade RL 增强推理,图表/跨模态理解 | 推理强,科研友好,社区活跃 | 大模型需高端 GPU | 科研论文解析,图表问答 |

| Qwen3-VL | 阿里巴巴达摩院 | 3B/7B/72B | 开源 | 文档解析、目标定位、长视频理解 | 尺寸覆盖广,性能灵活 | 大尺寸算力要求高 | 企业文档、多语言跨模态应用 |

| SmolVLM | Hugging Face 社区 | 1B–2B | 开源 | 轻量 VLM,低算力可运行 | 部署门槛低,适合个人/教育 | 复杂任务效果弱 | 教学、轻量个人项目 |

| Gemma 3 | Google DeepMind | 4B/12B/27B | 开源 | 轻量到中型参数,图像问答/图表解析 | 成本低,生态完整 | 性能弱于超大模型 | 成本敏感型企业/科研试点 |

2.3 多模态PDF转Markdown产品级解决方案

- MinerU:高精度 PDF 转 Markdown 的一体化工具

MinerU 由 阿里巴巴达摩院与 OpenDataLab 社区联合开源,是当前性能最突出的 PDF → Markdown 转换工具之一。它集成了 OCR 模型、版面解析与结构化抽取,能够处理学术论文、扫描件和复杂排版文档。MinerU 特别在 公式、表格、图片引用 等细节保留上表现优异,使得输出的 Markdown 更加接近原始文档语义。

- 优势:输出结构清晰、对数学公式/表格解析精度高;社区活跃、CLI 使用方便。

- 局限:使用 AGPL-3.0 许可证,对闭源商用有限制;在极端复杂排版场景仍可能需要人工后处理。

- 适用场景:科研 PDF 批量解析、技术文档转换、构建高质量 RAG 知识库的前置步骤。

- 项目地址:https://github.com/opendatalab/MinerU

- Docling:企业级文档解析与知识抽取框架

Docling 由 IBM Research 在 2024 年开源,定位为一个 企业级文档智能解析平台。与 MinerU 相比,Docling 的目标并非单一的 PDF → Markdown,而是构建一个覆盖 PDF、Word、PPT、HTML 等多格式的完整解析管线。它内置 OCR 与布局分析组件,同时支持开发者通过插件方式接入 VLM 模型(如 LLaVA、Qwen-VL、InternVL 等),从而实现更强的多模态理解能力。

- 优势:支持多种文件格式,输出可为 Markdown/HTML/JSON;MIT 许可更宽松,适合企业商用;工程化完备,集成 LangChain/LlamaIndex 等生态。

- 局限:默认配置下对某些复杂图表或领域专用排版可能需要自定义 pipeline;对硬件环境要求略高于轻量工具。

- 适用场景:企业级大规模文档解析、知识抽取与合规环境下的离线知识库构建。

因此,Docling 非常适合作为 研发人员在早期原型开发阶段的快速文档解析工具,既能保证输出质量,又能降低开发成本。目前它在社区中逐渐流行,被认为是 介于“轻量工具”和“工业级解析引擎”之间的理想选择。 - 项目地址:https://github.com/docling-project/docling

- MarkItDown:轻量化的通用文档转 Markdown 工具

MarkItDown 由 微软(Microsoft) 在 2024 年开源,定位为 轻量通用的文件 → Markdown 转换工具。它支持 PDF、Office 文档、图像、网页等多种格式,并提供 插件机制,可调用 Azure Document Intelligence 或 LLM(如 GPT-4o)对图像、表格等内容进行增强式解析。与 MinerU 和 Docling 相比,MarkItDown 更强调「简单、快速、易集成」,适合开发者在 RAG 项目中快速预处理多格式文档。

- 优势:MIT 许可,开源宽松;支持格式最广,插件体系灵活,可调用 LLM 提升精度;部署轻量,安装简单。

- 局限:对复杂科研论文或结构化表格的还原精度不如 MinerU;默认输出更注重可读性而非高精度复现。

- 适用场景:需要快速集成多格式文档解析的 RAG 应用;轻量项目或对精度要求不高的知识库构建。

- 目地址:https://github.com/microsoft/markitdown/

| 工具 | 发布团队 | 许可证 | 支持格式 | 核心特点 | 优势 | 局限 | 适用场景 |

|-------------|-----------------------------|-----------|------------------------|-------------------------------------------------------|------------------------------------------------|---------------------------------------------------|----------------------------------|

| MinerU | 阿里巴巴达摩院 & OpenDataLab | AGPL-3.0 | PDF/图像 | 集成 OCR+版面解析,高精度公式/表格支持 | 输出精细,科研 PDF 友好,CLI 简洁 | 商用许可受限,复杂排版仍需人工校正 | 科研论文/技术文档批量转 Markdown |

| Docling | IBM Research | MIT | PDF/Word/PPT/HTML 等 | 企业级文档解析,支持接入 VLM,输出 Markdown/JSON | 多格式支持,工程化完备,可离线运行 | 默认复杂图表需自定义管线 | 企业合规环境,知识库构建 |

| MarkItDown | Microsoft | MIT | PDF/Office/图片/网页/音频等 | 轻量通用工具,插件可接入 Azure/LLM | 格式覆盖广,插件灵活,部署简单 | 精排不及 MinerU,偏重可读性 | 快速预处理,通用 RAG 项目集 |