利用腾讯开源 Hunyuan3D 2.1:在 DigitalOcean GPU Droplet 上快速搭建 3D 模型

你是否曾幻想将脑海中的创意或精美的 2D 图像,瞬间转化为能在虚拟世界中使用的 3D 模型?

在人工智能逐渐成为创意“引擎”的今天,我们见证了图像和视频生成模型(如 Flux、Hi-Dream、Wan 等)带来的巨大飞跃,它们让“所思即所得”成为可能。然而,对于渴望将这些概念带入游戏、动画、元宇宙或其他三维项目的创作者而言,“如何跨越 2D 到 3D 的鸿沟” 仍是一个巨大的挑战。

长久以来,将 2D 概念转化为高质量 3D 模型,意味着耗时耗力的手工建模过程,这需要艺术家投入如苦行僧般的耐心和技艺。但现在,这一切都改变了。

图像到 3D 建模,作为计算机视觉领域的一个颠覆性分支,正在以惊人的速度进化。我们正在进入一个新时代——一个由强大的 AI 模型驱动,能够从单张图像直接生成具备纹理和色彩的 3D 网格的时代。

在本教程中,我们将带你深入探索这一前沿技术。我们将逐步指导你,如何在 DigitalOcean GPU Droplet 上,利用开源的顶尖模型 腾讯 Hunyuan3D 2.1,将你精心制作的 2D 图像转化为可用于 3D 项目的高质量模型。你将全面掌握从图像生成、环境配置到 3D 模型导出的完整流程,亲身感受 AI 如何以前所未有的速度和效率,实现你的 3D 创意。

腾讯 Hunyuan3D 2.1 模型是什么?

按照惯例,还是先介绍一下我们教程里要用到的大语言模型。

在图像到 3D 建模领域,开源的基础模型长期以来一直是一个空白。腾讯的研究人员敏锐地捕捉到了这一市场空缺,并着手填补这一日益明显的人工智能领域缺失。他们为此推出了首个 Hunyuan3D 和 Hunyuan3D 2.0 模型,一经发布便在业界引起轰动,吸引了众多工程师和开发者的关注。

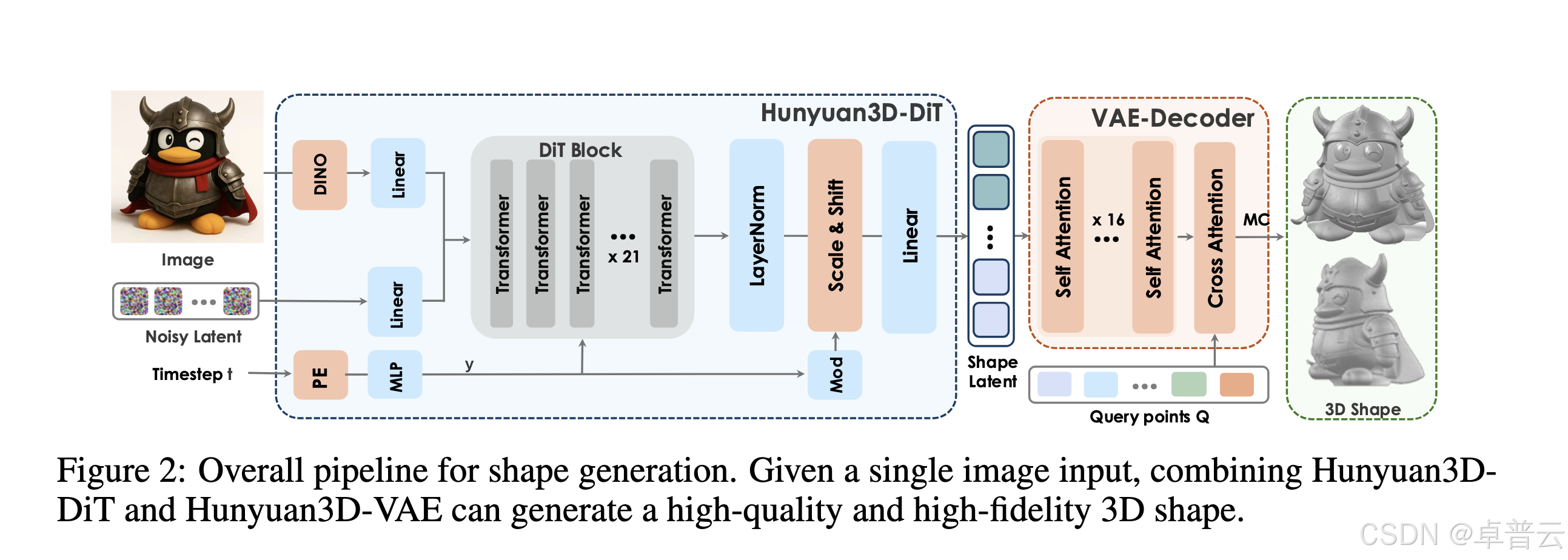

为了进一步提升成果,他们最近推出了 Hunyuan3D 2.1。Hunyuan3D 2.1 是“一个全面的 3D 模型创建系统,可从单张图像输入生成带纹理的网格”。它主要由两个完全公开的基础模型组成,即 Hunyuan3D-DiT ——“一种结合了基于流的扩散架构与高保真网格自编码器(Hunyuan3D-ShapeVAE)的形状生成模型”,以及 Hunyuan3D-Paint ——“一种基于网格条件的多视角扩散模型,用于生成 PBR 材质,产出高质量、多通道对齐且视角一致的纹理”。

简而言之,在形状生成方面,他们利用 Hunyuan3D-ShapeVAE 和 Hunyuan3D-DiT 实现高质量、高保真的形状生成。具体而言,Hunyuan3D-ShapeVAE 采用网格表面重要性采样以增强锐利边缘,并使用变分 token 长度来提升复杂几何细节的表现力。Hunyuan3D-DiT 则继承了最新的先进流匹配模型,构建了一个可扩展且灵活的扩散模型。

上图展示了整个流程的结构。我们从一个二维对象的单张图像输入开始。首先,Hunyuan3D-DiT 接收输入并生成原始对象的高质量形状表示。接着,Hunyuan3D-ShapeVAE 利用网格表面采样来检测并增强边缘、优化几何细节,并输出 3D 形状对象。

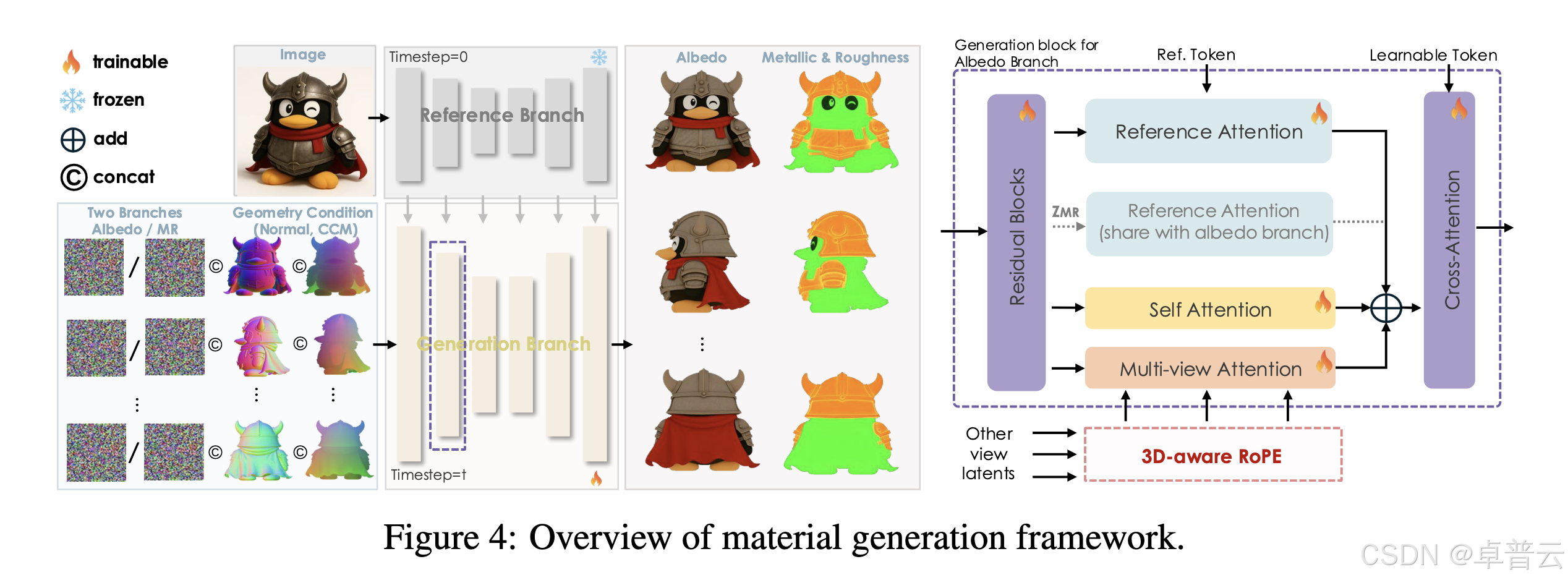

在纹理合成方面,Hunyuan3D-Paint 引入了一种多视角 PBR 扩散机制,为网格生成反照率(albedo)、金属度(metallic)和粗糙度(roughness)贴图。值得注意的是,Hunyuan3D-Paint 采用了空间对齐的多注意力模块,以对齐反照率与金属度/粗糙度(MR)贴图;使用 3D 感知的 RoPE(旋转位置编码)来增强跨视角一致性;并采用光照不变的训练策略,以生成对不同光照条件鲁棒的无光照反照率贴图。Hunyuan3D 2.1 将形状生成与纹理生成分为两个独立阶段,这是一种经先前大型重建模型验证有效的更先进策略。这种模块化设计允许用户仅生成无纹理网格,或为自定义模型应用纹理,从而提升工业应用的灵活性。

使用 Hunyuan3D 2.1 从图像创建 3D 素材

设置 GPU Droplet

要实际运行该流程,我们需要一台配备足够显存(VRAM)的 GPU 服务器,以同时支持纹理绘制和 3D 建模阶段。因此,我们推荐使用 DigitalOcean Gradient 平台上的 NVIDIA GPU Droplet 云服务器(按需实例),至少配备 40GB VRAM,例如 NVIDIA L40S、A6000、H100 或 H200 GPU。如需开始配置你的 GPU Droplet 及环境,建议遵循 DigitalOcean 基础教程中的设置说明。

如果你需要进一步了解 DigitalOcean 的 GPU 按需实例或裸金属服务器,可直接咨询 DigitalOcean 中国区独家战略合作伙伴卓普云 aidroplet.com。

为 Hunyuan3D 2.1 创建 GPU Droplet 环境

安装运行 Hunyuan3D 2.1 所需的所有库只需几分钟。首先,我们将创建一个虚拟环境,然后克隆代码仓库、安装依赖包,并最终下载超分模型。要执行安装和下载,请将以下命令粘贴到远程机器的命令行中:

git clone https://github.com/Tencent-Hunyuan/Hunyuan3D-2.1

cd Hunyuan3D-2.1

vim requirements.txt # 注释掉 numpy, pymeshlab, ninja, open3D, onnxruntime, 和 bpy 的安装行

pip install -r requirements.txt

pip install pymeshlab open3D onnxruntime ninja numpy

pip install fake-bpy-module-2.80

cd hy3Dpaint/custom_rasterizer

Python -m setup.py install

cd ../..

cd hy3Dpaint/DifferentiableRenderer

bash compile_mesh_painter.sh

cd ../..wget https://github.com/xinntao/Real-ESRGAN/releases/download/v0.1.0/RealESRGAN_x4plus.pth -P hy3Dpaint/ckpt

完成后,我们即可开始制作模型。

在 DigitalOcean GPU Droplet 上运行 Hunyuan3D 2.1 创建 3D 模型

要开始制作 3D 模型,我们首先需要启动作者提供的 Gradio 应用程序。由于环境已配置完毕,我们只需粘贴以下启动命令:

python3 gradio_app.py \--model_path tencent/Hunyuan3D-2.1 \--subfolder hunyuan3D-dit-v2-1 \--texgen_model_path tencent/Hunyuan3D-2.1 \--low_vram_mode

然后复制输出的链接,并通过 VS Code 或 Cursor 的简易浏览器功能在本地浏览器中访问该链接。

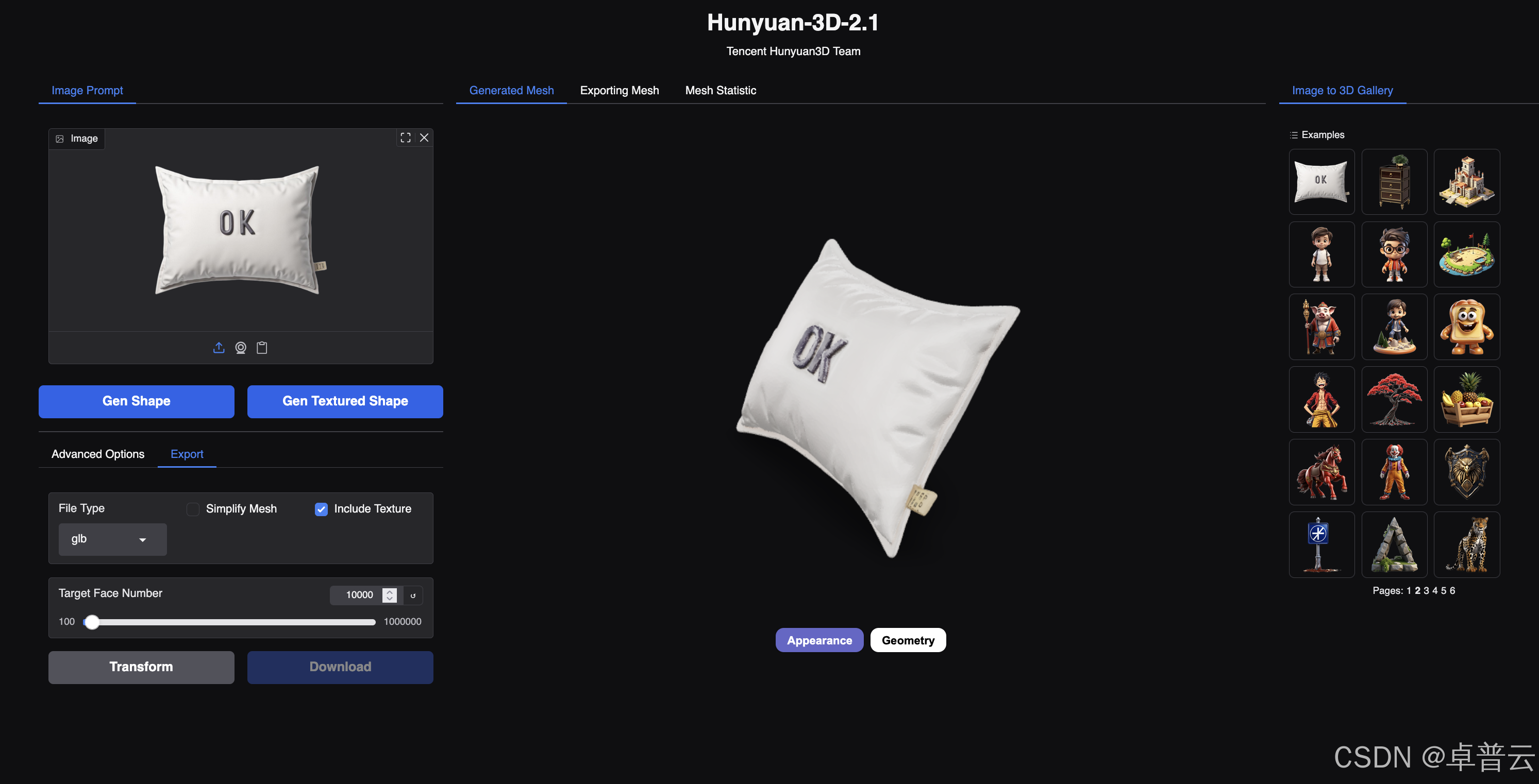

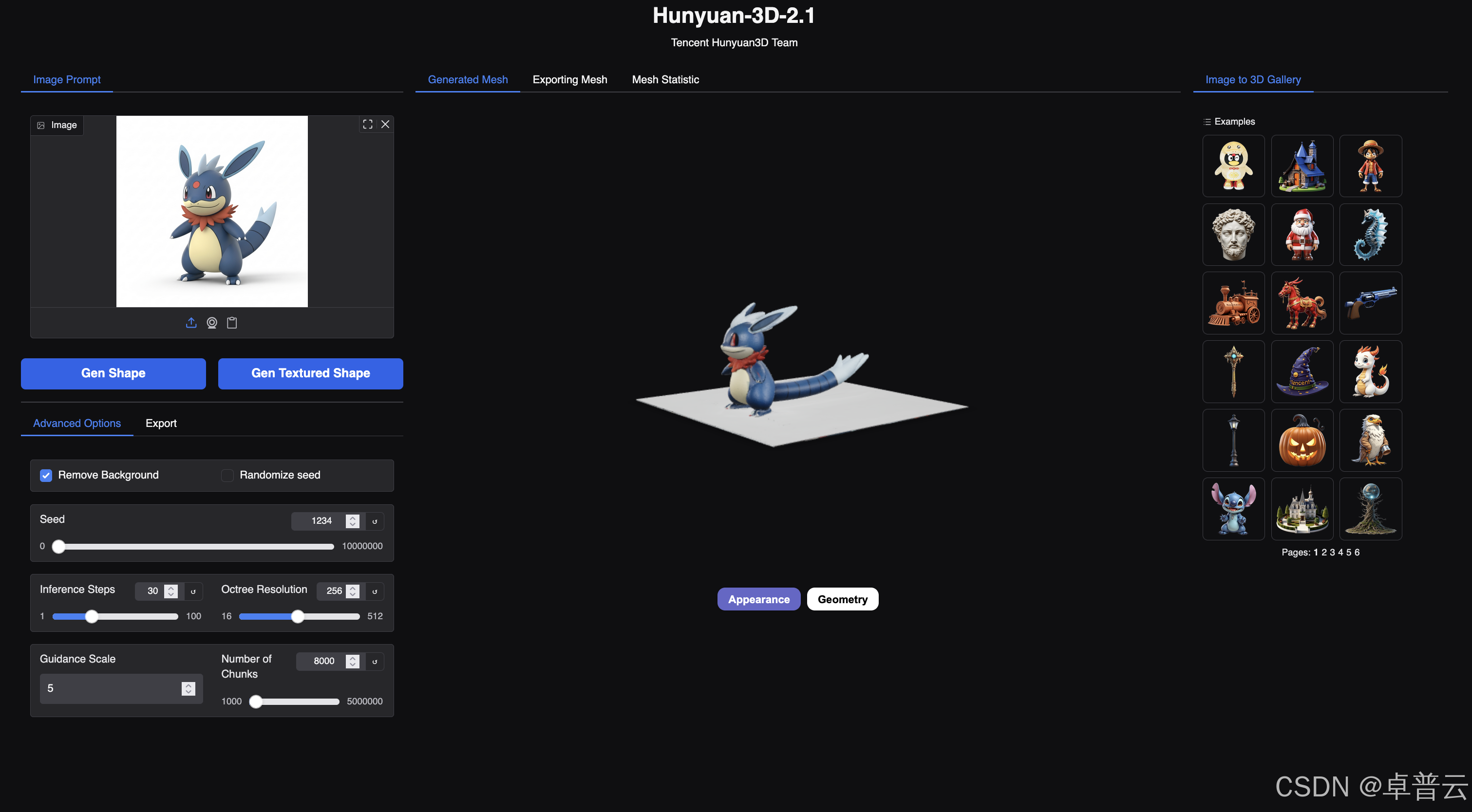

此时,我们将看到如上所示的 Web 图形界面。上传你选择的图像,或从右侧图库中挑选一张,并根据需要调整相关高级选项。我们建议取消勾选“随机种子”按钮以增强可控性,并增加推理步数以获得更清晰的输出。

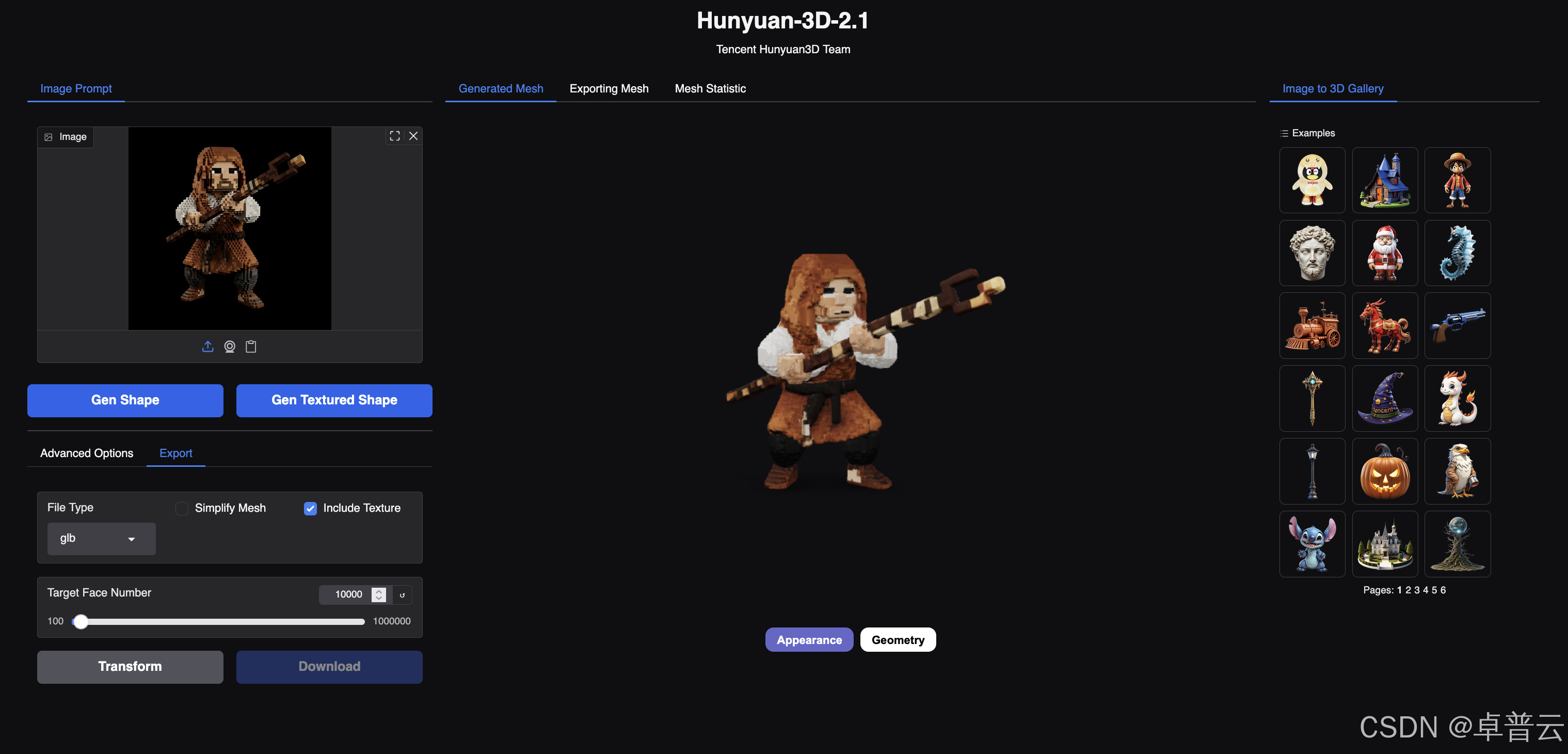

在图像选择方面,我们推荐使用无背景的清晰 3D 风格图像。在我们的实验中,纯黑背景效果最佳。我们的示例使用 Imagen 4 和 Flux.1 生成,并在提示词中加入“纯黑背景,3D 风格”等标签。如果你向流程提交高质量图像,将能生成准确的形状与纹理 3D 表示。随后,我们可以按需转换并下载这些模型,支持 glb、ply、stl 和 obj 等格式。

该流程的局限性有两点:一是表示模型的准确性,二是无法建模 2D 对象。我们生成的模型在正面捕捉方面表现优异,但在原始输入未见的侧面常出现问题。例如,在上文示例中,我们可以看到被极度拉长的尾巴和地面平台。至于 2D 风格图像,我们发现模型需要圆润的特征和边缘才能准确将图像投影到 3D 空间,而这些特征在 2D 绘图或动画中天然缺失。因此,我们建议为 Hunyuan3D 2.1 使用“3D 风格”图像,如渲染图或照片。

结语

总体而言,Hunyuan3D 2.1 是我们目前所见 AI 领域中用于即时创建 3D 模型最强大的工具。借助它,我们可以在数小时内创建数百个 3D 模型,而过去这一过程需要数天时间。

不仅如此,像 HunyuanWorld Mirror 这样的项目甚至能仅凭图像就将你带入 3D 世界并自由漫游。我们期待看到这项技术在未来持续进步。

最后,如果你还希望进一步了解 DigitalOcean GPU Droplet 还有哪些型号的 GPU,可直接访问 DigitalOcean 中国区独家战略合作伙伴卓普云 aidroplet.com 的官网,或与他们的技术支持、商务团队进行咨询。