网站模版带后台酒类招商网站大全

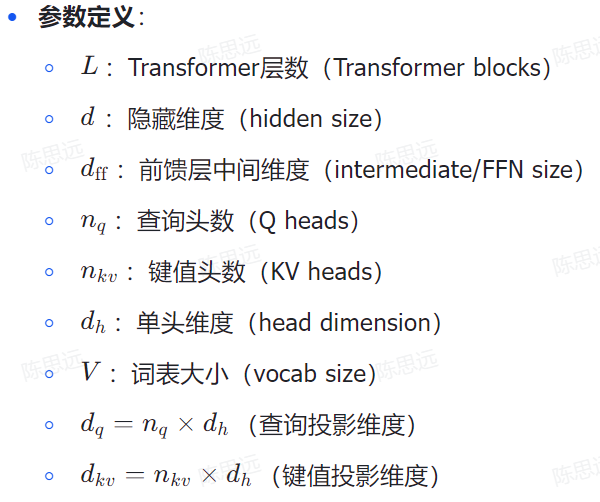

模型参数量计算

Transformer参数量计算

Transformer架构组成:

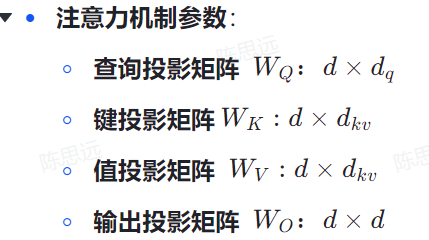

多头注意力机制

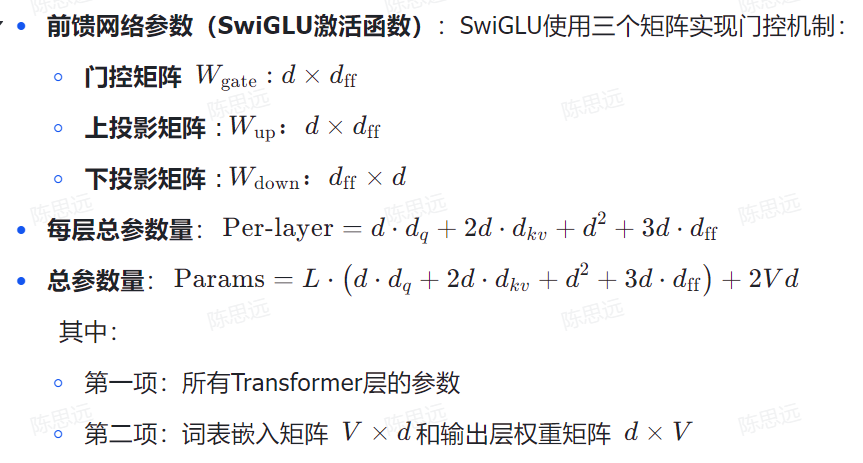

前馈神经网络

层归一化

残差连接

各参数的具体影响

L(层数)的影响:

# 层数越多

优点:

- 可以学习更深层的特征

- 表达能力更强

- 可以处理更复杂的任务

缺点:

- 训练更困难(梯度消失/爆炸)

- 计算量呈线性增长

- 需要更多内存

d(隐藏维度)的影响:

# 隐藏维度越大

优点:

- 每个token的表示更丰富

- 可以编码更多信息

- 模型容量更大

缺点:

- 参数量呈平方增长

- 内存占用增加

- 计算复杂度增加

d_ff(前馈网络维度)的影响:

# 前馈网络维度越大

优点:

- SwiGLU有更大的中间表示空间

- 可以学习更复杂的非线性变换

- 门控机制更精细

缺点:

- 参数量增加(3d·d_ff)

- 计算量增加

- 可能过拟合

3. 注意力机制参数的影响

n_q(查询头数)的影响:

# 查询头数越多

优点:

- 可以关注不同类型的模式

- 并行处理能力更强

- 表达能力更丰富

缺点:

- 参数量增加

- 计算复杂度增加

- 可能冗余

n_kv(键值头数)的影响:

# GQA/MQA中的键值头数

优点:

- 减少参数量和计算量

- 保持查询的多样性

- 提高训练效率

缺点:

- 可能损失一些表达能力

- 需要仔细平衡n_q和n_kv的比例

词表大小V的影响

# 词表大小越大

优点:

- 可以处理更多词汇

- 减少未知词问题

- 更精确的表示

缺点:

- 参数量显著增加(2Vd)

- 训练更困难

- 内存占用大

优化策略的影响

学习率设置:

# 参数量大的模型

- 需要更小的学习率

- 需要更长的预热期

- 需要更精细的学习率调度

# 参数量小的模型

- 可以使用较大的学习率

- 收敛更快

- 训练更稳定

优化器选择:

# 大型模型通常使用

- AdamW:自适应学习率

- 权重衰减:防止过拟合

- 梯度裁剪:防止梯度爆炸

# 小型模型可以使用

- SGD:简单有效

- 较少正则化

- 更简单的训练策略

训练策略的影响

批次大小:

# 参数量大的模型

- 需要更大的批次大小

- 梯度更稳定

- 需要更多GPU内存

# 参数量小的模型

- 可以使用较小的批次大小

- 训练更灵活

- 内存需求较小

训练时间:

# 参数量与训练时间的关系

- 参数量越大,训练时间越长

- 需要更多的训练步骤

- 收敛更慢