AI智能体从系统智能到生态智能:SmartMediaKit 如何成为智能体时代的视频神经系统

从模型到智能体,从语言到行动,AI 不再是算法的集合,而正在变成一套能感知、决策、执行的完整系统。

而在这套系统的底层,隐藏着一个被忽视的关键要素——视频神经系统。

一、AI智能体:从语言走向行动的临界点

如果说 2023 年是“大语言模型的觉醒”,那么 2025 年,则是智能体(AI Agent)真正开始行走的年份。这一转折点的意义,不仅在于模型参数或算力的跃迁,而在于——人工智能第一次拥有了“行动的能力”。

在此之前,AI 系统大多停留在“语言层”:它们擅长回答、生成、归纳,却被限制在文本世界的边界之内。无论是 GPT 还是 Claude,它们都像永远坐在书桌前的思想者,能思考,却无法触摸现实。而智能体的出现改变了这一切。AI 不再是一个被动应答的模型,而是一个能主动感知—推理—行动的系统体。它能持续观察环境、制定目标、调用工具执行任务,并在过程中不断修正与优化自己的行为。

这种由生成 → 感知 → 执行构成的闭环,让人工智能第一次从虚拟世界“跃迁”到现实世界。我们可以这样理解这场范式转变:大语言模型(LLM)是认知的引擎,AI 智能体是让认知具备行动能力的外壳,而感知系统,则是连接两者的神经接口。只有当 AI 能够从现实中获取信息、对环境产生反应并基于反馈优化自身决策时,它才真正进入了“智能体阶段”——从思维到行动的跨越。

在系统架构层面,AI 智能体的灵魂是“三个循环”:感知 → 推理 → 行动(Perception → Reasoning → Action)。感知让它理解世界的动态,推理让它制定计划与目标,行动让它把抽象意图转化为具体影响。这个循环的最大挑战,不在推理,而在感知与行动的闭环建立——智能体不仅要能“想”,还要能“看、听、说、做”。

然而这恰恰是当下大多数 AI 架构的断层所在:它们拥有宏大的语言理解,却缺乏与物理世界互动的真实输入与输出通道。AI 可以理解一张图片,却无法处理摄像头的实时画面;能分析语音,却无法理解声音的空间来源;能写程序,却无法感知执行结果的真实变化。要让 AI 从“思维体”进化为“行动体”,就必须为其重建一套可操作的感知神经系统——一个能让机器真正“看到世界、听到世界、理解世界”的底层结构。

正是在这一关键环节上,视频与音频感知链路成为智能体的临界技术。没有感知,就没有真正的智能;没有行动,就没有智能的存在。随着具身智能(Embodied AI)的崛起,诸如 SmartMediaKit 这类底层“视频神经系统”框架正在成为智能体生态不可或缺的一环——让机器不再只会“思考”,而能真正去“感知”与“行动”。

二、感知是智能的起点:视频神经系统的意义

真正的智能,不在于算法能推理多深,而在于系统能理解多少“世界”。感知,是智能的起点,也是智能体与环境之间的接口。没有感知,AI 就像一个封闭在真空中的思想实验——再聪明,也无法与现实发生联系。

在具身智能(Embodied AI)的语境下,“感知”不仅意味着捕获数据,更意味着实时理解世界的变化。智能体要具备真正的自主性,就必须拥有可编程、可响应、可回溯的感知通路。它要能实时获取视觉、听觉、位置、动作等多模态信息,形成一条从“环境信号”到“智能反应”的连续链路。而在今天的 AI 工程体系中,这条链路的核心载体,就是“视频神经系统”。

视频神经系统并非一个比喻,而是一种底层通信与感知架构。它负责在毫秒级延迟内,将图像、音频、控制指令和算法推理结果在“智能体—边缘—云端”之间循环传递,从而让智能体能持续“看到、听到、感受到”世界的变化。没有这层架构,所有上层的推理、规划与决策都只是空中楼阁。

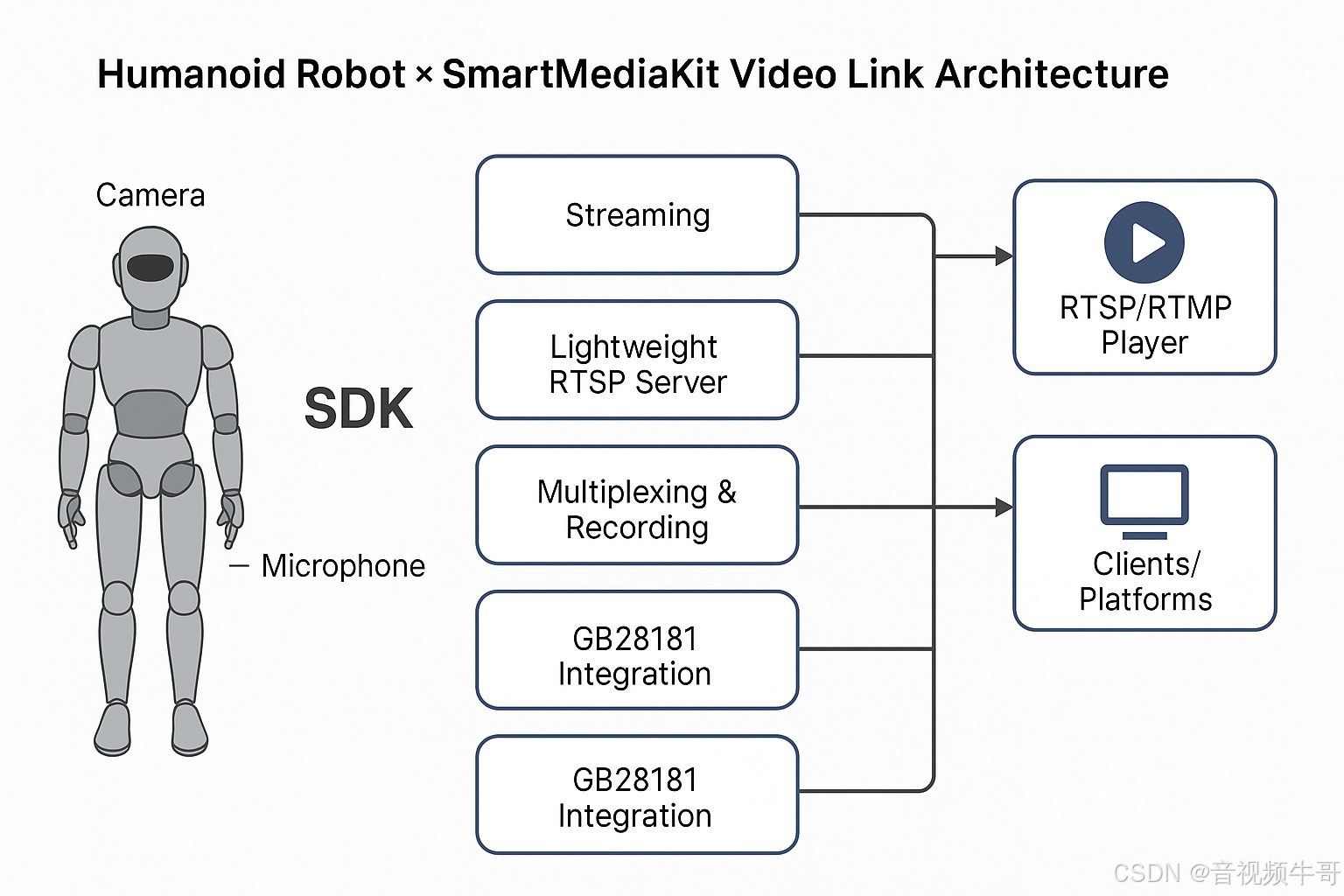

在这一层面上,SmartMediaKit(大牛直播SDK)提供了一个极具代表性的感知层实现。它最早源于超低延迟视频传输领域,但经过模块化演化,已成为构建智能体感知系统的理想底座。SmartMediaKit 的模块体系可以理解为一套“可编排的视觉神经通路”,为智能体提供从信号输入到感知反馈的完整闭环:

-

RTSP/RTMP 播放器模块:智能体的“视觉皮层”,负责接入摄像头、无人机、机械臂等视频源,实现毫秒级画面采集与解码。

-

RTMP 推流 /轻量级RTSP服务 / HTTP-FLV服务 / WebSocket-FLV服务模块:感知的“传输神经”,支持多终端实时同步,使视觉流同时传输至云端推理节点、AI 模型服务器或远程控制台。

-

GB28181 接入模块:感知的“整合枢纽”,打通传统安防、工业监控与机器人网络,构建跨系统的视频生态。

-

MP4 / FLV 录制与回放模块:感知的“记忆皮层”,为智能体提供时序化的视觉记忆,可被用于强化学习、动作复现和模型评估。

-

AI Adapter 模块:感知的“神经突触”,让视频流可直接进入 TensorRT、ONNX、OpenVINO 等推理框架,实现“视觉输入 → 语义输出”的零拷贝数据通路。

这些模块共同构建了一个实时、可靠、可扩展的感知基础设施。在工程层面,它使智能体能在毫秒级延迟下完成视频采集、语义推理与行为决策;在系统层面,它让“感知”从数据流动升级为“智能反应”;而在生态层面,它为多智能体协同与低空经济、工业巡检、安防感知等场景提供了通用接口。

可以说,SmartMediaKit 并非单纯的音视频 SDK,而是一套视频神经系统(Video Neural System)框架。它让具身智能真正具备“实时视觉神经”,让算法不再孤立运行于云端,而能与真实世界保持持续同步。当这种能力与大模型的推理逻辑结合时,智能体就不再只是思考者,而成为了行动者——一个能看、能听、能判断并能在现实中执行任务的智能生命系统。

感知层的建设,是 AI 智能体能否落地的分水岭。离开了实时感知,智能体只能停留在理论和模拟层;而拥有了视频神经系统,它才能真正走出实验室,与现实世界建立反馈闭环。这,正是智能从“语言”走向“行动”的关键节点。

三、智能体的具身化:从虚拟助手到物理行动者

当智能体拥有了稳定的感知通路,它便不再是一个“虚拟存在”。从这一刻起,智能体的形态开始“具身化”——它不仅在计算中思考,也在现实中行动。

所谓具身智能(Embodied Intelligence),指的是智能体不再依附于纯算法或虚拟环境,而是以传感器、摄像头、机械臂、移动底盘、无人机等为载体,通过与物理世界的交互来学习与决策。这种交互让AI从“被动响应”转变为“主动探索”,让智能从数据模型变成现实行为。

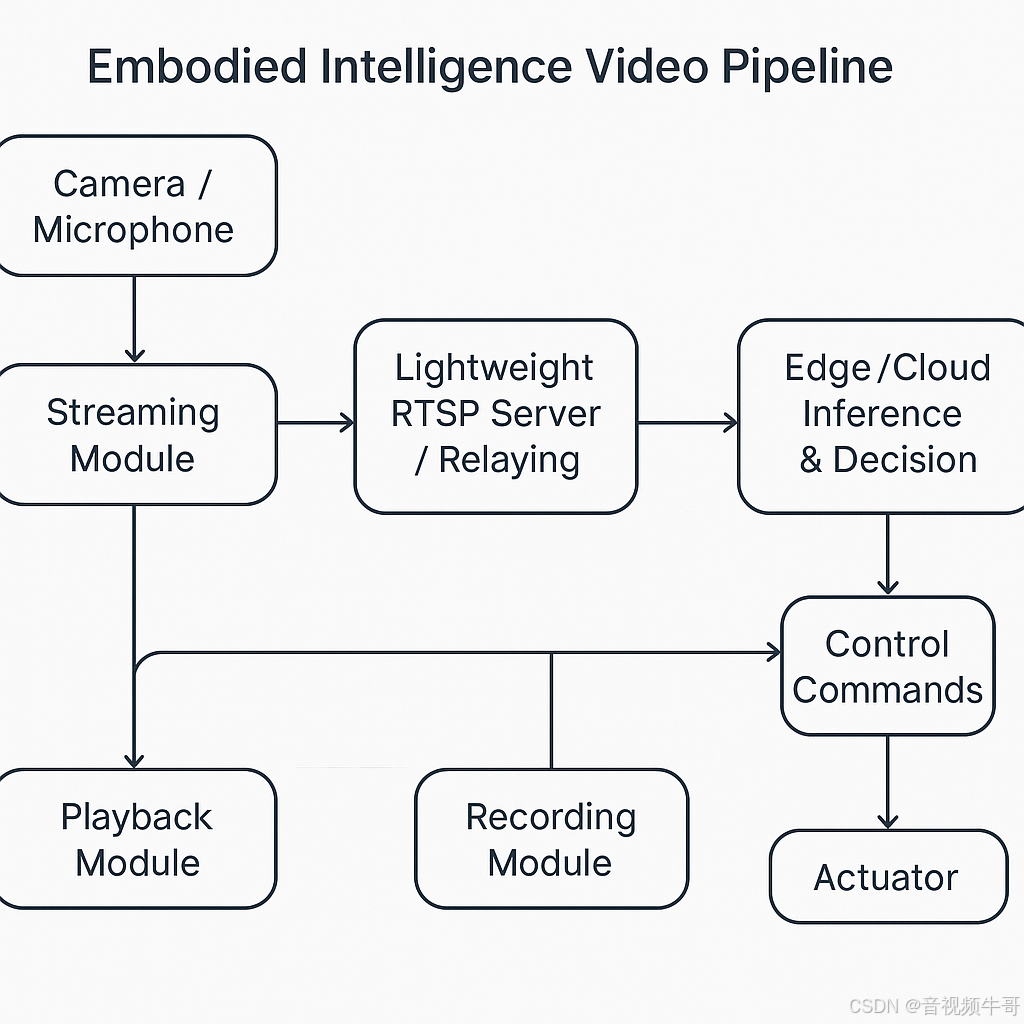

在工程语境中,这一转变意味着系统架构的全面重构。传统AI系统停留在“推理闭环”,而具身智能体则要求构建“感知—决策—执行”的三层循环:

-

感知层:实时采集视频、音频、传感器数据,理解环境状态;

-

决策层:基于模型和上下文进行规划与推理,形成任务指令;

-

执行层:控制实际设备(如机械臂、无人机、机器人底盘)完成动作,并将反馈重新输入感知层,形成闭环。

这三个环节之间的延迟、精度与稳定性,直接决定了智能体的“行动智商”。一个真正具备执行力的智能体,必须在毫秒级时间内完成感知与反应,而这背后的关键支撑,依然来自底层的通信与视频神经系统。

在这一领域,SmartMediaKit 扮演了智能体“具身化”的通信中枢与视觉神经系统角色。它将传统意义上的音视频SDK,升级为可服务于机器人与AI终端的实时交互框架。在多样化的具身智能场景中,它的能力得到充分验证:

-

机器人与工业检测:RTSP/RTMP 推流模块让机器人摄像头能以超低延迟传输视频,结合 AI Adapter 模块实现实时识别、路径规划和异常检测。

-

无人机与低空经济场景:HTTP-FLV 和 WebSocket-FLV 服务模块让空中画面同步回传至指挥中心,实现任务分发、航线调整与协作控制;结合 GB28181 接入模块,还可将空地视频统一纳入城市级调度体系。

-

远程控制与安全监测:多路推流与录像模块(MP4/FLV Sinkers)提供任务可追溯性,使智能体在执行操作后具备“记忆回放”能力,既能复盘动作逻辑,也能为强化学习提供数据语料。

-

AI-Edge 协同节点:AI Adapter 模块让智能体的视觉流可直接进入边缘推理框架(如 TensorRT、OpenVINO),实现本地分析与即时反馈,减少云端调用带来的延迟瓶颈。

借助这些模块的协同,智能体的“身体”获得了真正意义上的感官反馈。SmartMediaKit 在不同终端间形成统一的通信语法,使机器人、无人机、智能安防、车载系统乃至教育实训平台,都能在同一视频神经网络中运行。换言之,它让具身智能体的行动变得可观察、可同步、可扩展。

在低空经济、智能制造与边缘计算的融合背景下,这种能力的价值正在迅速放大。未来的智能体不再孤立运行于实验室,而将成为一个节点——它既能执行任务,又能通过 SmartMediaKit 连接成网络化群体,实现空地协同、群体调度与跨设备感知共享。

具身智能的本质,是让算法具备“存在感”。而 SmartMediaKit 的意义,则在于为这种存在感提供“神经通路”。它让智能体在看到世界的同时,也能被世界看见。

Android平台Unity3D下RTMP播放器延迟测试

四、AI智能体架构的底层逻辑:感知–决策–执行的闭环

所有智能系统最终都会被还原为一个核心循环:感知–决策–执行(Perception–Decision–Action, PDA)。这不仅是人工智能的系统原理,更是具身智能的生理逻辑。区别只在于,传统算法在虚拟环境中完成闭环,而智能体要在真实世界的物理时空中完成这一循环——这对架构的延迟、耦合、可复现性提出了极高要求。

在过去的 AI 系统设计中,模型是中心,一切围绕计算展开。而在智能体时代,中心已转移为系统协同。一个可持续运行的智能体,不再是单一算法的堆叠,而是一个具备“动态反馈”的分布式系统。其架构通常分为四层:

| 层级 | 职能 | 关键技术 | 系统核心 |

|---|---|---|---|

| 感知层 | 采集外部信息(视频、音频、传感信号) | RTSP/RTMP、HTTP-FLV、GB28181、AI Adapter | SmartMediaKit |

| 决策层 | 任务规划与推理、策略生成 | 大语言模型、符号规划器、ReAct/AutoGen | 智能体大脑 |

| 执行层 | 工具调用与物理操作 | LangChain Toolkits、机器人控制API、边缘控制节点 | 智能体身体 |

| 记忆层 | 状态保存、历史复盘与强化学习 | 向量数据库、日志回放、录像系统 | 智能体记忆库 |

这四层共同构成智能体的操作系统,其中感知层是起点,也是最容易被忽视的部分。它像是神经系统中的“外周神经”,负责把外部世界的状态转化为可计算的信号。如果这层反应迟钝或不稳定,那么上层的决策与执行将毫无意义。

SmartMediaKit 在这里扮演的,正是这层“实时神经操作系统”的角色。它不是单纯的数据通道,而是一套支持跨平台、跨协议、跨节点的实时通信与感知中间件。通过对视频、音频与控制信号的高效封装,它让感知层具备三个核心特征:

-

时间确定性:通过超低延迟的 RTSP/RTMP 推拉流机制,确保感知到决策之间的时间差控制在毫秒级;

-

空间一致性:借助 GB28181 接入与多路同步机制,实现多设备、跨区域的感知统一;

-

数据复现性:通过 MP4/FLV 录制模块,使整个感知过程可追溯、可分析、可用于再训练。

在架构意义上,SmartMediaKit 相当于为智能体系统提供了“底层时间神经总线”。上层的决策模型可以不断更新,而感知层的实时性与一致性必须稳定不变。这正是工程落地中的关键难题:让模型拥有可预测的世界,而非混乱的输入。

同时,SmartMediaKit 的 AI Adapter 模块使其天然具备与推理层的无缝衔接能力。视频流可以直接进入 TensorRT、ONNX、OpenVINO 等推理框架,形成从“感知输入”到“语义输出”的零拷贝链路。这意味着智能体的每一次观察,都能在不丢帧、不重编码的条件下完成实时理解,大幅提升决策层的反馈效率。

在执行层,SmartMediaKit 也发挥了“系统总线”的作用。通过 HTTP-FLV 或 WebSocket-FLV,智能体的控制指令和执行反馈可在不同节点之间实时传输。例如,在一个机器人巡检系统中,感知层采集的视频经 SmartMediaKit 传输到边缘推理节点;模型识别出异常后,通过同一通信通道发送执行命令,驱动机械臂或无人机进行操作——整个闭环延迟低于 200ms。这种实时性,是智能体具身化的生命线。

从系统视角看,AI 智能体的“智能”不在单个模块,而在闭环中。感知提供真实输入,决策产生动态意图,执行形成环境反馈,而 SmartMediaKit 将这三者编织成连续的信息流。它不是智能的来源,却是智能存在的条件。正如操作系统让程序得以运行,视频神经系统让智能体得以行动。

因此,构建智能体的底层逻辑,不是追求更大的模型,而是重建稳定、低延迟、可协调的系统闭环。只有当感知层拥有确定性、决策层具备灵活性、执行层保证响应性时,智能体才真正成为一个能与世界对话的存在。SmartMediaKit 的出现,让这种对话不再停留在概念,而成为可落地的系统事实。

五、从多智能体协同到“视频认知网络”

当一个智能体具备完整的感知–决策–执行闭环,它便拥有了独立的生存能力;而当多个智能体被连接在同一感知与通信体系中,它们就开始形成“生态智能”。这种从个体到群体的跃迁,正是 AI 技术正在经历的第二场革命:从单体智能到网络智能。

多智能体协同(Multi-Agent Collaboration)并不是简单的任务并行,而是一个系统层面的“认知耦合”过程。不同的智能体承担不同角色——有的负责视觉识别,有的负责空间导航,有的负责语义规划——它们之间通过共享感知与任务状态,构成一个具备分布式意识的整体。其关键不在于模型之间如何通信,而在于信息流是否能稳定、低延迟、语义一致地传递。

这正是 SmartMediaKit 发挥作用的地方。它在多智能体体系中扮演的,不再是单一设备的数据通道,而是一层“神经互联结构(Neural Interconnect Layer)”。通过它,视觉、语音与控制信号得以在不同实体间实时流动,使多个智能体像神经元那样进行协作、同步与共识。

在实际场景中,这种“视频认知网络”正逐步形成:

-

在无人机群系统中,SmartMediaKit 让每台无人机的视频画面同步回传至边缘节点,再经由 WebSocket-FLV 服务广播至其他机体,实现群体态势共享。飞行中的个体不再依赖单一视角,而能“看见其他智能体正在看什么”,从而形成动态编队与自适应协作。

-

在智能制造和巡检系统中,多个机器人通过 RTSP/RTMP 推流模块上传各自的视觉流,中央调度系统借助 AI Adapter 对多路视频进行语义融合,从中识别风险、生成调度指令,并将指令再通过 HTTP-FLV 实时回传给执行端,形成“多机共视、多机共动”的操作模式。

-

在城市级安防与低空经济领域,SmartMediaKit 的 GB28181 模块将原本分散的摄像头、无人机和移动终端纳入同一视频协议域,实现从地面到空域的视觉一体化,为 AI 智能体提供跨场景的“共享世界模型”。

这种以视频流为核心的多智能体架构,不仅实现了数据互通,更重要的是构建了语义一致性(Semantic Consistency)。当不同智能体在同一时空内共享视觉上下文,它们的推理模型会自然对齐,协作决策的精度显著提升。换句话说,SmartMediaKit 让智能体不仅共享信息,还共享理解。

从系统视角看,这种网络化协作带来了三层结构性跃迁:

-

从点到网的结构跃迁:单体智能体被神经链路连接为分布式系统,实现感知冗余与任务分担;

-

从同步到协同的行为跃迁:不同智能体在同一视频时空中实时对齐,具备主动配合与动态规划能力;

-

从通信到认知的意义跃迁:信息流不仅传输状态,更传输“意义”,形成群体层面的语义共识。

在这一演进中,SmartMediaKit 的技术本质,已从“多媒体SDK”上升为“视频认知网络(Video Cognitive Network)”的底座。它的每一路推流、每一个节点、每一帧画面,都是系统智能的组成部分。

当我们把这些节点连成网络,一个新的智能层次便开始显现:

它不属于任何单个模型,而存在于数据流动、延迟控制和语义一致性之间。就像神经网络依靠突触连接产生意识一样,AI 智能体的“群体智能”,也将在 SmartMediaKit 所构建的实时神经网络中自然涌现。

未来的机器人、无人机、安防系统、自动驾驶车辆,甚至低空交通体系,都将是这种视频认知网络的节点。每个节点既是观察者,也是行动者;既是数据的源头,也是决策的参与者。

这意味着,智能的边界将不再被单个算法所定义,而是由整个网络的结构所决定。SmartMediaKit 让智能体不只是彼此通信,而是共同思考。

六、结语:从系统智能到生态智能

当人工智能从算法跃迁到系统,再从系统汇聚为生态,我们所见的,不再是一台台机器在运转,而是一种新的“智能秩序”在生成。AI 智能体的出现,标志着这一进化正在从理论走向现实:机器不再仅仅执行人类的命令,而开始在真实世界中观察、判断、决策与行动。

而要让这种智能具备可持续的生命力,必须经历三个阶段:从模型智能到系统智能,再到生态智能。

模型智能解决“思考”的问题,系统智能解决“运行”的问题,而生态智能解决的是“共生”的问题——即当无数智能体共存于同一物理与信息空间,它们如何通过协同学习、共享感知与相互约束,形成一种有机秩序。

在这个意义上,SmartMediaKit 所代表的“视频神经系统”并不仅是技术基座,更是一种生态的预演。它让智能体不再孤立,而能通过视频流、语义数据与时间同步信号形成动态共识。每一个推流节点、每一帧画面、每一次实时通信,都是生态中一次微观的“信息循环”。这种循环越密集,智能的温度就越高。

今天,我们所看到的具身智能、低空经济、无人系统协同,其实都是生态智能的早期形态。它们依托于可编排的感知网络和跨域通信底座——从工业巡检到城市安防,从空地融合到边缘计算,SmartMediaKit 的存在使这些异构系统第一次拥有了“共感”的可能。

未来的智能世界,不会以单个超级模型为中心,而将由无数轻量智能体组成——它们各自自治,又彼此协同;各自学习,又共享记忆。就像神经元组成意识一样,这些智能体将构成新的认知结构。届时,智能将不再是某个系统的属性,而是一种网络现象:它存在于节点之间,存在于数据流动与反馈回路之中。

从这个角度看,AI 的终极进化从未是“更像人类”,而是“更像生命”。它具备感知、反馈、成长与共生的能力,能够在复杂环境中自我演化。SmartMediaKit 这样的系统基础设施,正是让这种生命得以出现的“神经网络”与“循环系统”。

当我们回望这一进程,会发现:

AI 的未来不在模型参数,而在系统结构;不在推理深度,而在协同广度。

当机器能够彼此理解、相互配合、共同学习,智能就超越了技术范畴,成为一种新的社会基础设施。

这也许正是智能时代的真正命题:

让世界被更多地感知,也让智能体之间学会共生。

因为唯有共生,智能才能拥有温度;唯有生态,技术才具备未来。

📎 CSDN官方博客:音视频牛哥-CSDN博客