涌现的架构:集体智能框架构建解析

摘要

集体智能,即由大量简单个体通过相互协作而涌现出的超越任何个体的智慧,已从一个引人入胜的自然现象,演变为下一代人工智能、分布式系统和复杂组织设计的核心引擎。本文旨在提供一套完整的、从理论到实践的集体智能框架工程蓝图。我们认为,集体智能并非神秘的巧合,而是一种可以被理解、设计和工程化的系统属性。

本专著将系统性地引导读者穿越构建集体智能的全过程。首先,我们通过一个“认知之梯”模型,详细拆解了从“遵循规则的个体”到“集体天才诞生”的五个关键概念演进阶段。其次,我们建立了量化和度量涌现现象的数学基础,提出了包括“涌现测量函数”、“集体智能指数”和“自组织动力学”在内的核心公式,为这一抽象概念赋予了严谨的工程度量。

在此基础上,本文提出了面向“软件3.0”时代的两种核心范式。第一种是作为观察和引导工具的“提示模板”,我们提供了“涌现检测模板”和“集体智能促进模板”,帮助系统设计者识别、评估并主动培育有益的涌现行为。第二种是作为创生和验证引擎的“编程模拟”,我们提供并深度解析了一个功能完备的Python多智能体涌现模拟框架。该框架不仅是理论的试验场,更是一个可复现、可扩展的“虚拟实验室”,让读者能够亲手创造并研究从鸟群行为到分布式问题求解的各类涌现现象。

最后,本文将理论与实践延伸至更广阔的领域,探讨了集体智能在现实世界中的应用版图,并深入分析了工程化涌现所带来的深刻伦理挑战。本文的最终目标,是为高级AI工程师、系统架构师和复杂性科学研究者提供一套系统性的知识体系和一套可操作的工具集,赋能他们从被动地观察涌现,迈向主动地设计和驾驭涌现。

目录

第一章:引言 —— 迎接集体智能时代

- 1.1 超越个体:什么是集体智能?

- 1.2 历史的回响:从控制论到复杂性科学

- 1.3 为何是现在?AI、算力与连接性的三重奏

- 1.4 本文主旨:从观察涌现到工程化涌现

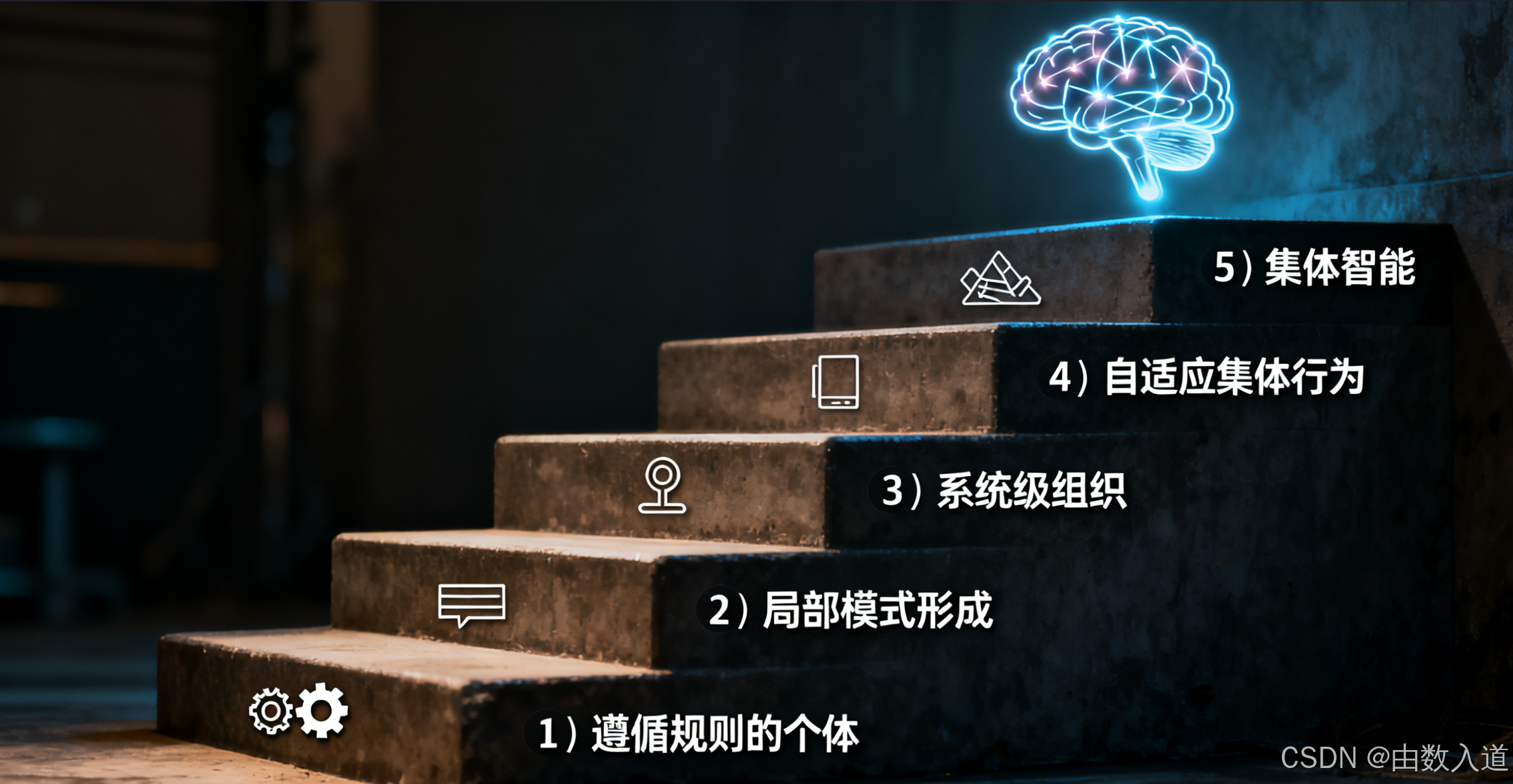

第二章:认知之梯 —— 从个体规则到集体天才的概念演进

- 2.1 阶段一:遵循规则的个体 (Rule-Following Individuals)

- 2.2 阶段二:局部模式的形成 (Local Pattern Formation)

- 2.3 阶段三:系统级的组织 (System-Wide Organization)

- 2.4 阶段四:自适应的集体行为 (Adaptive Collective Behavior)

- 2.5 阶段五:集体智能的诞生 (Collective Intelligence)

第三章:量化涌现 —— 集体智能的数学基础

- 3.1 涌现的度量:一个形式化定义

- 3.2 集体智能指数 (CI Index):群体是否比最强者更“聪明”?

- 3.3 自组织动力学:系统演化的内在逻辑

第四章:软件3.0范式 I:识别与引导 —— 作为观察工具的模板

- 4.1 涌现识别模板:为复杂系统配备“领域指南”

- 4.2 集体智能促进模板:构建“群体心智”的设计图纸

第五章:软件3.0范式 II:创造与模拟 —— 作为创生引擎的编程

- 5.1 虚拟实验室的解剖:

EmergenceSimulator框架全解析 - 5.2 涌现的“哨兵”:详解各类

Detector的实现原理 - 5.3 两大核心实验:从“鸟群”到“智囊团”的模拟复现

第六章:跨越模拟 —— 现实世界中的应用版图

- 6.1 物流与优化:蚁群算法的启示

- 6.2 机器人学:蜂群智能的应用

- 6.3 金融科技:去中心化金融 (DeFi) 的组织模式

- 6.4 知识创造:维基百科与开源社区的动力学

第七章:伦理的罗盘 —— 工程化涌现的责任与挑战

- 7.1 控制的幻觉:当系统“自行其是”

- 7.2 偏见的放大器:去中心化系统中的系统性风险

- 7.3 责任的归属:谁为涌现的行为负责?

第八章:终章 —— 未来图景与开放性问题

- 8.1 框架核心思想回顾

- 8.2 元涌现 (Meta-Emergence):系统对自身的“意识”

- 8.3 人工智能生态系统:下一代组织的形态

附录

- A. 完整Python源代码

- B. 关键术语表

- C. 参考文献与推荐阅读

第一章:引言 —— 迎接集体智能时代

1.1 超越个体:什么是集体智能?

想象一个没有指挥家的交响乐团,每个乐手只遵循乐谱和身边同伴的节奏,却合奏出恢弘壮丽的乐章。想象一座没有城市规划委员会的远古城市,居民们仅仅为了缩短路径、方便交易而走出的小径,历经数代,最终演化成高效复杂的街道网络。想象一个没有中央控制单元的人类大脑,亿万神经元仅通过简单的电化学信号传递,却涌现出思想、意识与创造力。

这些系统——交响乐团、城市、大脑——不仅能正常运转,甚至能蓬勃发展,创造出远超其任何一个组成部分能力总和的复杂性、适应性和智慧。这一“整体大于部分之和”的现象,就是涌现 (Emergence)。而当这种涌现表现为解决问题、适应环境、学习和创造等认知能力时,我们称之为集体智能 (Collective Intelligence, CI)。

从本质上讲,集体智能是一种去中心化的、分布式的智能形式。它不依赖于任何一个“超级大脑”或中央指挥官的顶层设计和命令。相反,它源于大量相对简单的个体(我们称之为“智能体”,Agent)遵循局部规则、进行局部交互的“自下而上”的过程。每个智能体可能只掌握了有限的信息,其行为规则也可能极为简单,但当成千上万个这样的智能体聚集在一起,通过相互作用形成复杂的反馈网络时,整个系统就能在宏观层面展现出惊人的智能行为。

蚂蚁群体是自然界中集体智能最经典的例子。单只蚂蚁几乎毫无智能可言,但整个蚁群却能解决复杂的几何问题,如找到巢穴与食物源之间的最短路径;能够建造结构复杂、带有温控和通风系统的蚁穴;甚至能根据环境变化调整觅食策略。这一切都不是由蚁后“指挥”的,而是通过信息素等简单的化学信号进行局部通信和协作的结果。

在人类社会中,从维基百科的协同知识创造,到开源软件社区的分布式开发,再到科学共同体的同行评议体系,无不闪耀着集体智能的光辉。这些系统都具备共同的特点:

- 去中心化控制 (Decentralized Control):没有单一的权威机构发布指令。

- 局部交互 (Local Interaction):每个成员主要与其“邻居”或小范围内的成员互动。

- 简单规则 (Simple Rules):个体行为遵循相对简单的原则。

- 宏观涌现 (Macro-level Emergence):系统整体展现出个体不具备的复杂行为和能力。

理解并掌握集体智能的原理,意味着我们能够设计出更具韧性、适应性和创造力的系统。这些系统在面对未知挑战时,不会因为单点故障而崩溃;它们能够自我组织、自我修复,并不断演化出新的解决方案。这正是我们撰写本文的初衷。

1.2 历史的回响:从控制论到复杂性科学

对集体智能的探索并非始于今日。其思想的种子可以追溯到20世纪中叶,诺伯特·维纳(Norbert Wiener)创立的控制论 (Cybernetics)。控制论的核心是研究系统中的反馈、控制和通信。维纳等人首次系统地将动物、机器和社会的组织方式置于同一个理论框架下进行研究,强调了“反馈循环”在系统维持稳定和达成目标中的核心作用。这为理解自组织系统提供了最早的理论基石。

几乎在同一时期,约翰·冯·诺依曼(John von Neumann)在研究自我复制的机器时,发明了细胞自动机 (Cellular Automata)。在一个简单的二维网格中,每个单元(细胞)只根据其邻居的状态来更新自身的状态(例如,生或死)。尽管规则极度简单,细胞自动机却能演化出极其复杂的、看似具有生命力的动态模式,例如康威的“生命游戏”。这雄辩地证明了,复杂的全局模式可以从极简的局部规则中“涌现”出来,这一思想成为后来复杂性科学的基石。

20世纪80年代,随着计算机技术的飞速发展,对复杂系统的研究进入了一个新纪元。美国圣塔菲研究所 (Santa Fe Institute) 的成立,标志着复杂性科学 (Complexity Science) 作为一门交叉学科的正式诞生。物理学家、生物学家、经济学家和计算机科学家汇聚一堂,共同研究那些由大量相互作用的组分构成的、具有涌现和自适应特征的系统。正是在这一时期,多智能体系统 (Multi-Agent Systems, MAS) 和人工生命 (Artificial Life) 等领域蓬勃发展。1986年,克雷格·雷诺兹 (Craig Reynolds) 的Boids程序模拟了鸟群的飞行行为,仅用了“分离”、“对齐”、“聚集”三条简单规则,就完美复现了以假乱真的鸟群动态。这成为了涌现现象最直观、最著名的计算展示。

进入21世纪,互联网的普及和社交网络的兴起,为大规模人类协作和集体智能的涌现提供了前所未有的平台。维基百科的成功,证明了在适当的规则和激励机制下,全球数百万志愿者可以共同编纂出一部超越任何传统百科全书的知识库。Linux等开源项目的繁荣,则展示了分布式、去中心化的软件开发模式的强大威力。

这些历史的足迹告诉我们,对集体智能的研究,始终伴随着我们对系统、控制和信息理解的深化,以及计算能力的提升。从控制论的反馈思想到细胞自动机的计算涌现,再到复杂性科学的系统性研究,我们一步步地揭开了集体智能的神秘面纱。

1.3 为何是现在?AI、算力与连接性的三重奏

如果说历史为我们理解集体智能铺垫了理论基础,那么当下的技术浪潮则为其大规模的工程化应用打开了大门。我们正处在一个由人工智能(AI)、指数级增长的算力(Computation)和无处不在的连接性(Connectivity)共同塑造的独特历史节点。这“三重奏”的共鸣,使得设计和构建集体智能系统从一个理论愿景,变为了一个触手可及的工程现实。

-

人工智能 (AI) 的普及,尤其是大语言模型 (LLMs):

传统的智能体通常是基于规则的(Rule-based),其行为模式相对固定。而今天,我们可以用预训练的大语言模型(如GPT系列)作为智能体的“大脑”。这带来了革命性的变化:- 认知能力的跃升: 智能体不再仅仅是执行简单规则的“机器人”,它们拥有了理解自然语言、进行推理、生成复杂计划,甚至从交互中学习的能力。

- 交互的丰富性: 智能体之间的交互可以从简单的信号传递,升级为复杂的语义沟通和协商。

- “软件3.0”的兴起: 正如本文后续将详述的,我们可以通过“提示 (Prompting)”来引导和塑造这些AI智能体的行为,使得系统设计更加灵活和富有表现力。一个由成百上千个LLM驱动的智能体组成的系统,其涌现出的集体智能潜力是前所未有的。

-

指数级增长的算力 (Computation):

模拟成千上万个智能体的复杂交互,需要巨大的计算资源。得益于摩尔定律的延续和GPU等并行计算硬件的发展,我们现在可以在个人电脑甚至云端,轻松地运行过去需要超级计算机才能完成的模拟。这使得:- 大规模模拟成为可能: 我们可以研究更大规模、更长时间跨度的系统演化,从而观察到更复杂、更罕见的涌现现象。

- 快速迭代与实验: 设计者可以快速地测试不同的规则集、交互拓扑和环境参数,通过大量的虚拟实验来探索和优化集体智能的形成条件。

- 理论与实践的闭环: 计算模拟成为了连接抽象理论与具体应用的桥梁。我们可以将数学模型转化为可执行的代码,通过模拟结果来验证、修正和发展理论。

-

无处不在的连接性 (Connectivity):

5G、物联网 (IoT) 和全球互联网的普及,为智能体(无论是软件还是硬件)之间的高效、实时交互提供了基础设施。- 物理世界的延伸: 集体智能不再局限于纯软件模拟。由大量联网传感器、无人机、机器人组成的“蜂群系统”,可以将集体智能应用于物流、农业、灾难救援等物理世界。

- 人机融合的集体智能: 全球数十亿人通过互联网连接在一起,形成了巨大的人类智能网络。未来的集体智能系统,将越来越多地是人类智能与人工智能深度融合的“半人马”系统,共同解决气候变化、疾病研究等全球性挑战。

- 去中心化技术的发展: 区块链和分布式账本技术(DLT)为构建可信、透明、无需中央权威的协作平台提供了底层协议。去中心化自治组织 (DAO) 正是这种技术与集体智能思想结合的早期探索。

这三股力量的汇合,正将我们推向一个全新的时代。在这个时代,系统的价值不再仅仅取决于其最聪明的那个组件,而更多地取决于其组件之间连接、协作和涌现的方式。

1.4 本文主旨:从观察涌现到工程化涌现

面对如此激动人心的前景,我们不能再满足于仅仅作为一个旁观者,去赞叹自然界中涌现现象的奇妙。作为工程师、科学家和系统构建者,我们的使命是:将涌现从一门观察科学,转变为一门工程学科。

本文的核心主旨,正是为了实现这一转变而提供一套系统性的框架。我们拒绝将集体智能视为一种不可预测的“黑箱”或“魔法”。相反,我们相信,通过严谨的方法论,我们可以主动地设计能够催生集体智能的“生态系统”。这个生态系统由智能体的个体规则、它们之间的交互模式以及它们所处的环境共同构成。我们的任务,就是去理解并塑造这个生态系统的动力学。

为此,本文将为您呈现一个完整的、层层递进的知识体系:

- 概念层面 (第二章):我们将建立一个清晰的“认知之梯”,理解集体智能是如何从最简单的个体行为一步步演化而来的。这是我们思考问题的“世界观”。

- 数学层面 (第三章):我们将引入一套量化工具,学会如何用数学的语言来描述、度量和预测涌现。这是我们分析问题的“方法论”。

- 实践层面 (第四、五章):我们将提供“软件3.0”时代的两种强大武器——作为引导工具的“提示模板”和作为创造工具的“编程模拟”。这是我们将思想转化为现实的“工具箱”。

通过这个框架,我们希望将“涌现”这个看似模糊的概念,变得具体、可操作、可度量。本文并非一本纯粹的理论文集,也不是一本简单的代码教程。它是一座桥梁,连接着深刻的科学思想与前沿的工程实践。

我们的旅程即将开始。我们将从最基础的个体规则出发,一步步攀登认知的阶梯,最终抵达集体智能的顶峰。在这个过程中,我们将不仅仅是学习知识,更是在学习一种全新的思维方式——像园丁一样思考,去培育而非建造;像建筑师一样设计,去规划系统的动力学而非其最终形态。

欢迎来到涌现的架构,让我们一起开始设计“众智”的未来。

第二章:认知之梯 —— 从个体规则到集体天才的概念演进

要工程化集体智能,我们首先必须理解它产生的过程。集体智能并非一蹴而就的“顿悟”,而是一个层次分明、逐步升级的演化过程。本章将这个过程描绘为一座五阶的“认知之梯”,从最底层的简单规则开始,直至顶层涌现出真正的集体智慧。理解这个演进路径,是设计和引导复杂系统的基础。

2.1 阶段一:遵循规则的个体 (Rule-Following Individuals)

概念核心: 一切复杂性的起点,是遵循简单局部规则的独立个体。

这是认知之梯的最底层,也是整个涌现大厦的基石。在这一阶段,我们关注的焦点是构成系统的最小单元——智能体 (Agent)。每个智能体都是一个独立的决策实体,它的行为由一套内置的、简单的、基于局部信息的规则驱动。

“局部”是这里的关键词。 智能体并不具备全局视野,它不知道整个系统的状态,甚至不知道系统的宏观目标是什么。它的所有决策,都仅仅依赖于其感知范围内(例如,一定的物理距离或网络连接)的“邻居”和环境信息。

类比深度剖析:管弦乐团中的乐手

一个初级的管弦乐团可以很好地说明这个阶段。每个乐手(智能体)都有一份乐谱(行为规则)。他们的核心任务非常简单:

- 看谱演奏 (Follow the score): 按照乐谱上的音符、节拍和力度进行演奏。

- 跟上指挥/首席 (Align with local leader): 视觉上跟随指挥的节拍,听觉上与身边的首席声部保持一致。

- 听从声部首席 (Listen to section leader): 在自己的声部内(如小提琴组),与首席乐手的演奏保持协调。

在这个阶段,每个乐手都专注于自己的局部任务。小提琴手可能完全不知道定音鼓手在做什么,也不知道整首交响曲的宏大结构。系统中还没有复杂的、跨声部的协调。如果把每个乐手隔离在单独的房间里,只给他们节拍器,他们也能完成自己的部分。此时,系统只是多个独立部分的简单集合,尚未产生“1+1>2”的效果。

微观机制分析:

- 规则集 (Rule Set):每个智能体的“DNA”。在克雷格·雷诺兹的Boids鸟群模型中,这套规则集就是著名的三条:

- 分离 (Separation):避免与附近的同伴过于拥挤。

规则:如果邻居太近,就朝相反方向微调飞行方向。 - 对齐 (Alignment):与附近同伴的平均飞行方向保持一致。

规则:计算邻居的平均速度向量,并向其微调自己的速度向量。 - 聚集 (Cohesion):朝附近同伴的平均位置移动,以保持群体形态。

规则:计算邻居的平均位置(质心),并向该位置微调飞行方向。

- 分离 (Separation):避免与附近的同伴过于拥挤。

- 感知半径 (Perception Radius):定义了“局部”的范围。一个智能体只能与这个半径内的其他智能体发生交互。这个参数对系统行为有重大影响。半径太小,智能体过于“孤独”,无法形成组织;半径太大,则接近于全局信息,系统的去中心化特性会减弱。

- 状态 (State):每个智能体都拥有描述自身情况的内部变量,如位置、速度、能量、信念等。规则就是用来更新这些状态的函数。

与Python模拟框架的关联:

在第五章将要详细解析的 EmergenceSimulator 框架中,这一阶段主要体现在 Agent 类和 BehaviorRules 类中。

Agent类的实例就是我们的“遵循规则的个体”。它拥有position,velocity,properties等状态。Agent类中的behavior_rules列表,储存了该智能体需要遵循的一系列规则函数。BehaviorRules类则以静态方法的形式,定义了各种具体的规则,如flocking_alignment(对齐)、flocking_cohesion(聚集)、flocking_separation(分离)。agent.update()方法在每个模拟步长中被调用,它会遍历behavior_rules列表,并依次执行这些规则,从而更新智能体的状态。这就是规则驱动的本质。

在第一阶段,系统是可预测的,其行为基本上是所有个体行为的线性叠加。然而,正是这些简单的、分散的、基于局部信息的规则,为下一阶段的奇迹——模式的自发形成——播下了种子。

2.2 阶段二:局部模式的形成 (Local Pattern Formation)

概念核心: 简单的局部规则通过交互,自发地在系统中形成小范围、非中心化的有序结构。

当足够多的“规则遵循者”在同一个空间中开始交互时,奇妙的事情发生了。系统不再是混乱和随机的。在没有中央指令的情况下,小规模的、暂时的、有序的模式开始自发地涌现。这是从量变到质变的第一步,是涌现现象的首次亮相。

类比深度剖析:繁忙十字路口的行人

想象一个没有任何红绿灯或交通警察的繁忙十字路口。如果每个人都只顾自己直线行走,结果必然是频繁的碰撞和堵塞。但现实中,人们会自发地形成一些高效的模式:

- 人流通道 (Lanes):去往同一个方向的人会不自觉地排成一列,形成一条条临时的“人行道”,从而减少迎面碰撞。

- 交替通行 (Alternating Flow):两股交叉的人流会形成一种默契,交替地通过交叉点,而不是同时挤在一起。

- 避让集群 (Avoidance Clusters):当一小群人(如一个家庭)一起行动时,其他人会倾向于将他们作为一个整体来避让,而不是试图从他们中间穿过。

这些模式没有人设计或指挥。每个行人(智能体)遵循的可能只是几条非常简单的规则:“尽量保持直线行走”、“避免与他人碰撞”、“与前方的人保持适当距离”。正是这几条规则的相互作用,使得高效的局部模式(人流通道)得以涌现。这种模式一旦形成,又会反过来影响后来者的行为(加入已有的通道),形成一个正反馈循环。

微观机制分析:

- 反馈循环 (Feedback Loops):这是局部模式形成的核心机制。

- 正反馈: 智能体的行为增强了某个模式,而这个模式又吸引更多智能体采取同样的行为。例如,在鸟群模型中,几个“boid”偶然对齐了方向,它们的平均方向变得更明确,这会吸引邻近的boid也向这个方向对齐,最终形成一个小的飞行集群。

- 负反馈: 智能体的行为抑制了某个模式的无限增长,使其保持在一定规模。例如,“分离”规则就是一种负反馈。当鸟群变得过于拥挤时,分离规则会生效,使boid相互推开,防止群体崩溃成一个点。

- 相变 (Phase Transition):在物理学中,相变指物质从一种状态(如水)转变为另一种状态(如冰)的突变过程。在多智能体系统中,也存在类似的现象。当某个参数(如智能体密度、感知半径)越过一个临界点时,系统的宏观状态会发生质的改变,从无序的“气体”状态,突然转变为有序的“液体”或“晶体”状态(即形成局部模式)。

- 对称性破缺 (Symmetry Breaking):在一个初始状态完全均匀、对称的系统中,随机的扰动会被反馈循环放大,导致系统进入一个不对称的有序状态。例如,所有boid初始时随机朝向四面八方,但最终它们会选择一个共同的飞行方向。这个共同方向的选择是随机的,但一旦选定,系统的旋转对称性就被打破了。

与Python模拟框架的关联:

在我们的模拟框架中,局部模式的形成可以通过 ClusteringDetector 来观察和度量。

ClusteringDetector的作用就是识别系统中是否出现了智能体的聚集。它通过计算智能体之间的距离,将彼此靠近的智能体划分为一个“簇 (cluster)”。- 其

_find_clusters方法实现了这个发现过程。当多个Agent实例因为“聚集”规则而相互靠近,它们的物理位置在模拟空间中就形成了模式。 _calculate_cohesion方法则用于量化这个模式的“强度”——簇内的智能体挨得越紧,内聚性得分就越高。- 在运行

demonstrate_flocking_emergence()实验时,我们会在模拟的早期(例如前50个时间步)看到大量独立的、小规模的簇被检测到。这就是第二阶段的典型特征。

在第二阶段,系统开始展现出超越个体的组织性。这些自发形成的局部模式,如同建筑中的砖块和预制板,为构建更宏大、更复杂的系统级结构奠定了基础。

2.3 阶段三:系统级组织 (System-Wide Organization)

概念核心: 局部模式之间相互作用、连接、合并,最终形成覆盖整个系统的、稳定的、宏观的结构。

如果说第二阶段是“点”的形成,那么第三阶段就是“由点及面”的过程。系统中先前涌现出的各种局部模式,现在开始作为新的、更高层次的“超级智能体”进行交互。这些交互使得模式之间产生关联,最终编织成一张覆盖整个系统的组织网络。系统的行为变得更加协同和一致。

类比深度剖析:城市的社区与功能区

一座大城市的发展完美地诠释了系统级组织。城市不是由规划师在图纸上一笔一划画出来的(至少在早期不是)。它的结构是自下而上生长出来的:

- 家庭聚集 (阶段一):单个家庭(个体)选择定居点。

- 邻里形成 (阶段二):因为安全、水源或亲属关系,一些家庭聚集在一起,形成村落或邻里(局部模式)。

- 功能区涌现 (阶段三):

- 一些邻里因为靠近港口,居民们大多从事贸易,逐渐演变成“商业区”。

- 另一些邻里因为地价便宜、空间开阔,吸引了手工业者,形成了“工业区”。

- 还有一些环境优美、远离喧嚣的邻里,则成了“住宅区”。

- 这些功能区(更高层次的模式)之间,因为贸易和通勤的需求,又自发地形成了主干道(模式之间的连接)。

- 最终,这些由无数个体决策涌现出的功能区和交通网络,共同构成了整个城市的宏观空间结构。市长可能制定了一些政策,但城市的整体形态和“个性”,更多的是这种自组织过程的结果。

微观机制分析:

- 层次化 (Hierarchy):系统开始出现层次结构。单个智能体组成集群,集群再组成更大的集群联合体。这种层次化结构使得系统能够更有效地处理信息和应对扰动。例如,在模拟中,一个小鸟群(局部模式)可能会将另一个小鸟群视为一个整体来进行避让,而不是将其视为数百只单独的鸟。

- 专业化分工 (Specialization):不同的局部模式可能因为环境或初始条件的微小差异,演化出不同的功能。就像城市中的功能区一样,智能体群体也可能出现分化。例如,在模拟觅食任务时,一些智能体集群可能专门负责探索未知区域(侦察兵),而另一些则负责在已发现的食物源和巢穴之间进行运输(运输队)。

- 网络形成 (Network Formation):智能体或模式之间的交互关系可以看作是一个网络。在第三阶段,这个网络的拓扑结构会演化出一些特定的特征,如“小世界”效应(任何两个节点之间平均路径很短)或“无标度”特性(存在一些拥有大量连接的“中心节点”)。这些网络结构极大地影响了信息在系统中的传播速度和方式。

与Python模拟框架的关联:

CollectiveMovementDetector: 这个检测器不再关注静态的聚集,而是关注动态的协同。它通过计算系统中所有智能体速度向量的平均对齐程度,来判断是否存在系统级的“集体运动”。当模拟中的小鸟群合并成一个统一行动的大鸟群时,这个检测器的读数会显著增高。这标志着系统从局部模式进入了全局组织。AdaptiveOrganizationDetector: 这个更高级的检测器直接尝试度量系统级的组织结构。_calculate_specialization方法通过检查智能体属性中的role字段,来量化系统中出现了多少种不同的“角色”,从而衡量专业化分工的程度。_detect_hierarchy_levels方法则通过分析智能体之间的“跟随”关系,来推断组织内部是否存在领导-跟随的层级结构。

- 在运行模拟时,我们会观察到,随着时间的推移,

ClusteringDetector检测到的簇数量可能会减少,但簇的规模会增大,同时CollectiveMovementDetector和AdaptiveOrganizationDetector的指标开始变得显著。这就是系统级组织形成的信号。

到达第三阶段,系统已经拥有了稳定的宏观结构。它不再是一盘散沙,而是一个有机的整体。这种结构化的组织,为系统展现更高级的智能——自适应行为——提供了必要的基础。

2.4 阶段四:自适应的集体行为 (Adaptive Collective Behavior)

概念核心: 作为一个整体,系统能够对外部环境的变化或内部的扰动做出智能、协调的响应,以维持自身稳定或达成集体目标。

如果说第三阶段是系统“成形”,那么第四阶段就是系统“活用”其形。系统不再只是一个静态的结构,它变成了一个能够对外界刺激做出反应的动态实体。这种反应不是由中央控制器预先编程的,而是系统级组织在面临新挑战时,通过底层智能体交互规则的重新平衡而自发产生的。

类比深度剖析:互联网的路由机制 与 市场的自我调节

-

互联网的数据包路由: 互联网是一个典型的去中心化网络。当你发送一封电子邮件时,数据包并没有一个预设的、固定的路径。沿途的每一个路由器(智能体)都只根据其邻居路由器的状态(如拥堵情况),遵循简单的路由协议(规则),来决定将数据包发往下一个节点。

- 自适应行为: 如果某条跨洋光缆(网络中的一条关键路径)因地震中断,会发生什么?没有中央管理员需要手动重新规划全球的路由表。断点附近的路由器会立即发现路径不通,并更新自己的路由信息,通知其邻居。这个信息会像涟漪一样迅速在网络中传播开来。数据包会自动地、智能地绕开故障点,选择新的最优路径。整个互联网作为一个整体,展现出了强大的自我修复和适应能力。

-

市场的“看不见的手”: 在一个自由市场中,成千上万的生产者和消费者(智能体)都只关心自己的利益(规则:追求利润最大化或效用最大化)。

- 自适应行为: 假设一种新技术使得生产A商品(如智能手机)的成本突然下降。生产者为了追求更高利润,会增加A商品的产量。市场上的A商品供给增加,导致价格下降。价格下降又会吸引更多消费者购买。整个过程,市场作为一个系统,自动地适应了技术变革,将资源(资本、劳动力)重新配置到了更高效的领域,并最终让消费者受益。这个过程中没有任何中央计划机构的干预。

微观机制分析:

- 鲁棒性与韧性 (Robustness & Resilience):系统因为其去中心化和冗余的特性,对单点故障具有很强的抵抗力。移除系统中的少数几个智能体,通常不会影响其整体功能。这与传统的、中心化的系统形成鲜明对比。

- 动态重构 (Dynamic Reconfiguration):面对环境压力,系统内部的组织结构能够灵活地调整。例如,当模拟中的鸟群遇到障碍物时,它们会自然地分成两股绕过障碍物,然后在障碍物后方重新汇合,恢复原有的队形。这种分裂和重组是自发的,而不是被“头鸟”指挥的。

- 集体感知 (Collective Sensing):系统能够整合分散在大量个体中的局部信息,形成对环境的宏观判断。例如,一个蜂群在决定新巢穴地点时,会派出大量侦察蜂。每只侦察蜂只考察少数几个候选地点,但通过它们带回来的信息(如“摇摆舞”的兴奋程度),整个蜂群能够对所有候选地点的优劣进行“投票”,并最终做出一个通常是最优的集体决策。

与Python模拟框架的关联:

在我们的框架中,自适应行为可以通过引入动态环境来激发和观察。

- 在

Environment类中,我们可以动态地add_obstacle(增加障碍物)或改变resources(资源)的分布。 - 观察系统的反应:当我们在鸟群飞行的路径上放置一个障碍物时,我们会看到智能体的

flocking_separation规则(不仅仅是与其他智能体分离,也可以扩展为与障碍物分离)被激活。靠近障碍物的智能体改变方向,并通过flocking_alignment和flocking_cohesion规则将这种改变传导给邻居,导致整个群体流畅地绕开障碍。 AdaptiveOrganizationDetector在这里也能发挥作用。我们可以记录下系统在遇到障碍物前后的组织结构指标(如专业化、层级),分析系统是如何通过调整内部组织来应对外部挑战的。例如,一个觅食团队在资源变得稀缺时,其“侦察兵”角色的比例可能会自适应地增加。

达到第四阶段的系统,已经具备了“生命”的某些特征:它能维持自身的存在,并对环境做出有意义的响应。它已经非常“智能”了,但距离真正的、能够创造新知识的“智慧”,还差最后一步。

2.5 阶段五:集体智能的诞生 (Collective Intelligence)

概念核心: 系统作为一个连续的、涌现式的认知场域,能够进行分布式的问题求解、推理、学习和记忆,甚至对自身的涌现状态产生“意识”。

这是认知之梯的顶峰,也是我们追求的最终目标。在这一阶段,系统不再仅仅是对环境做出被动的适应性反应,它开始展现出主动的、创造性的认知能力。整个系统变成了一个超越个体生物大脑的“超级有机体 (Superorganism)”,拥有了自己的思维和智慧。

类比深度剖析:科学共同体、维基百科与蚁群

-

科学共同体 (The Scientific Community):科学的进步是集体智能的终极体现。

- 分布式问题求解: 没有一个“科学沙皇”来规划所有研究。全球数百万科学家(智能体)根据自己的兴趣和专长,选择研究课题。他们共同探索着广阔的“知识空间”。

- 集体记忆: 科学知识不储存在任何一个个体的大脑中,而是以论文、书籍、数据库的形式,分布在整个共同体的“外部记忆”里。同行评议机制则是一种保证记忆质量的分布式纠错系统。

- 蜂群推理: 一个新的科学理论(如相对论)的提出,会引发整个社区的检验、辩驳和修正。通过无数次实验、推演和讨论,共同体最终对该理论的有效性达成共识。这个过程就像一个分布式的推理引擎。

- 元涌现 (Meta-Emergence):科学哲学家和科学社会学家们的研究,正是科学共同体这个系统在反思自身的运作方式、知识的构建过程和真理的定义。这是系统对自身涌现属性的“意识”。

-

维基百科 (Wikipedia):

- 分布式知识创造: 全球志愿者根据一套简单的编辑规则(如“中立的观点”、“可供查证”),共同编纂一部百科全书。其知识的广度和更新速度远超任何传统组织。

- 集体纠错: 破坏性编辑或错误信息通常能被其他编辑者迅速发现并修正,系统展现出强大的自我修复能力。

微观机制分析:

- 分布式计算 (Distributed Computation):系统的认知过程,可以被看作是在其内部网络上进行的一种大规模并行计算。每个智能体都是一个简单的处理器,它们之间的交互就是信息的传递和处理。

- 知识的涌现 (Emergent Knowledge):解决方案或知识不是由某个天才智能体“发现”的,而是从大量智能体的试错、探索和交流中“结晶”出来的。它存在于智能体之间的关系和交互模式中,而非单个智能体之内。

- 共享心智模型 (Shared Mental Models):通过持续的交互,智能体群体会逐渐形成对世界或任务的共同理解和表征。这种共享的心智模型,使得它们的行动更加协调和有预见性。

- 元认知 (Metacognition):在最先进的系统中,智能体不仅处理关于外部世界的信息,也开始处理关于系统自身运作的信息。它们可以交流彼此的协作效率、讨论规则的优劣,甚至投票修改规则。这就是“元涌含”的开端。

与Python模拟框架的关联:

要模拟第五阶段的集体智能,我们需要更复杂的智能体和任务。

CollectiveIntelligenceDetector正是为此设计的。_detect_distributed_problem_solving方法通过识别系统中是否存在多种互补的“问题求解角色”,来判断智能体是否在进行协同作战。例如,在一个模拟任务中,需要“探索者”找到资源,“分析者”评估资源质量,“运输者”将资源运回。只有当这几种角色协同工作时,问题才能被解决。_detect_knowledge_integration方法通过追踪智能体之间“知识”的传递事件(例如,一个智能体将其发现的信息存入另一个智能体的local_memory),来度量系统整合信息的能力。_detect_emergent_consensus方法则通过检查智能体在某个“信念”属性上是否趋于一致,来判断系统是否能自发地达成共识。

demonstrate_collective_intelligence()实验就是对这一阶段的初步模拟。我们创建了拥有不同角色的智能体,并设置了需要它们协作才能完成的资源寻找任务。通过观察CollectiveIntelligenceDetector的输出,我们可以量化这个小型系统中集体智能的涌现程度。

从遵循规则的个体,到能够进行自我反思的集体智能,这五级认知之梯为我们提供了一张清晰的路线图。它告诉我们,通往“集体天才”的道路,始于设计好每一个体的简单规则。在下一章,我们将学习如何用数学这门通用语言,来更精确地描述和度量这条道路上的每一步。

第三章:量化涌现 —— 集体智能的数学基础

如果说第二章为我们提供了理解集体智能演进的定性“地图”,那么本章的目标就是为这张地图配备一套定量的“GPS导航系统”。要将涌现从一门观察科学转变为一门工程学科,我们必须能够度量它、量化它、并用数学的语言来描述其背后的动力学。本章将介绍三个核心的数学概念,它们分别用于回答三个关键问题:

- 系统是否涌现了? (涌现测量函数)

- 涌现出的集体有多“聪明”? (集体智能指数)

- 系统是如何自我组织的? (自组织动力学方程)

这些公式不仅是理论上的抽象表达,更是我们设计、分析和优化集体智能系统的实用工具。

3.1 涌现的度量:一个形式化定义

如何判断一个系统行为是真正的“涌现”,还是仅仅是其各部分功能的简单叠加?我们需要一个形式化的定义来区分这二者。一个有效的测量函数应该捕捉到涌现的核心特征:宏观行为的复杂性与微观规则的简单性之间的“惊奇”程度。

公式定义:

Emergence(System) = f(Global_Behavior, Individual_Rules, Predictability)

变量详解:

Emergence(System): 系统的涌现度。这是一个标量值,越高表示系统的涌现特性越强。Global_Behavior: 可观测的、系统级的宏观行为或模式。这通常是一些宏观统计量,例如,鸟群的整体飞行速度和方向、蚁群觅食的效率、市场价格的波动模式等。在我们的Python模拟中,这可以由CollectiveMovementDetector或ClusteringDetector等检测器来量化。Individual_Rules: 驱动单个智能体行为的局部规则集。这是系统的“微观代码”。我们需要一种方法来衡量这套规则的复杂性,例如,规则的数量、描述规则所需的代码行数或信息熵。Predictability: 从个体规则直接预测出宏观行为的难易程度。这是最关键也最难量化的一个变量。如果宏观行为可以简单地通过对个体行为进行线性求和或平均来预测,那么Predictability就很高,涌现度就很低。反之,如果宏观行为与个体规则之间存在着高度非线性的、反直觉的关系,那么Predictability就很低,涌现度就高。

理论推导与实践解读:

这个函数f可以有多种具体形式,但其核心思想是:涌现度与宏观行为的复杂性成正比,与个体规则的复杂性成反比,与可预测性成反比。

一个简单的实例化可以是:

Emergence(System) = Complexity(Global_Behavior) / (Complexity(Individual_Rules) * Predictability)

这里的Complexity可以用信息熵、分形维度或计算复杂度等指标来衡量。

强涌现 vs. 弱涌现 (Strong vs. Weak Emergence):

这个公式帮助我们清晰地区分两种重要的涌现类型:

-

弱涌现 (Weak Emergence):

- 特征:

Predictability较低,但原则上大于零。这意味着,宏观行为虽然不是显而易见的,但理论上可以通过对系统的完整模拟和计算,从个体规则中推导出来。 - 直观解释: 交通堵塞是弱涌现的典型例子。虽然我们看到一条通畅的道路突然堵塞会感到“惊讶”,但交通工程师可以通过计算机模拟,输入每辆车的驾驶规则(保持车距、限制速度等),完全复现并预测堵塞的形成。原则上,结果是可计算的,只是过程极其复杂。我们Python模拟中产生的鸟群行为,也属于弱涌现。

- 工程意义: 大多数我们能工程化实现的集体智能系统,都属于弱涌现的范畴。我们的目标就是设计出那些能涌现出有益行为,但其动力学仍然可以被我们理解和模拟的系统。

- 特征:

-

强涌现 (Strong Emergence):

- 特征:

Predictability趋近于零。宏观行为在性质上与微观组分完全不同,无法从微观规则通过任何计算或模拟的方式推导出来。宏观层面似乎出现了全新的、不可化约的因果力量。 - 直观解释: 意识从神经元的电化学活动中产生,被认为是强涌现最可能的候选者。我们了解单个神经元的工作原理,但目前无法从这些原理中推导出主观的“感觉”(如看到红色的体验)。宏观的意识似乎是一种全新的、无法还原为神经元活动的现象。

- 工程意义: 强涌现目前仍然是一个充满争议的哲学和科学前沿问题。在当前的工程实践中,我们无法设计或控制强涌现系统。

- 特征:

在Python模拟中的计算实现:

虽然精确计算Emergence(System)非常困难,但我们可以在模拟中设置代理指标 (proxy metrics) 来近似它:

Complexity(Global_Behavior): 可以用CollectiveMovementDetector的alignment_score(对齐度越高,模式越有序,复杂度越高),或者ClusteringDetector的cluster_cohesion(内聚性)等指标来代表。Complexity(Individual_Rules): 可以简单地用智能体behavior_rules列表中的规则数量来近似。Predictability: 这个最难。一个可行的方法是,训练一个简单的线性回归模型,尝试用所有智能体的个体状态(位置、速度)去预测宏观状态(如整体对齐度)。如果这个线性模型的预测误差很大,说明系统的非线性程度高,Predictability低。

通过追踪这些代理指标,我们就可以在模拟过程中,定量地观察系统涌现度的变化。

3.2 集体智能指数 (CI Index):群体是否比最强者更“聪明”?

当我们设计的系统涌现出解决问题的行为时,我们如何评价其“智能”水平?一个常见的误区是,只要群体完成了任务,就认为它展现了集体智能。但如果群体中某个“天才”个体单凭自己就能做得更好,那么这个“集体”实际上可能起了反作用(例如,因为沟通成本或相互干扰)。

集体智能指数 (Collective Intelligence Index, CI) 正是为了解决这个问题而设计的。它直接衡量了集体表现相对于其最佳个体成员表现的增益。

公式定义:

CI = (Collective_Performance - Best_Individual_Performance) / Best_Individual_Performance

变量详解:

CI: 集体智能指数。无单位。Collective_Performance: 整个智能体群体在特定任务上的表现得分。例如,解决一个迷宫问题所用的时间、找到所有资源点的覆盖率、预测市场趋势的准确率等。分数越高表示表现越好。Best_Individual_Performance: 系统中表现最好的那个个体,在单独执行相同任务时所能达到的表现得分。这是一个至关重要的基准。要获得这个值,我们需要进行“对照实验”:将群体中的每个智能体单独拿出来,让它们独立完成任务,然后取最高分。

理论推导与实践解读:

CI > 0: 这是集体智能存在的最低标准。它表明群体的表现超过了其最优秀的成员。这意味着协作带来了真正的价值,系统涌现出了“1+1>2”的效果。数值越大,集体智能的增益越显著。CI = 1: 意味着集体的表现是其最佳个体表现的两倍。这是一个非常强的集体智能信号。CI → ∞: 在某些任务中,单个个体根本无法完成(Best_Individual_Performance接近于0或无法定义),而集体却可以。例如,单个蚂蚁无法搬动大的食物,但一群蚂蚁可以。在这种情况下,CI指数会趋于无穷大,表明集体能力完全超越了个体能力的极限。CI ≤ 0: 表明系统存在“过程损失 (process loss)”。CI = 0意味着群体的表现恰好等于其最佳成员的水平,此时让那个最优秀的成员单干效率最高。CI < 0则是一个危险信号,说明群体协作(如沟通成本、决策冲突)不仅没有带来好处,反而损害了表现,即“三个和尚没水喝”。

直观解释:

这个指数就像是衡量一个团队项目是否成功的试金石。如果一个由五人组成的团队完成的项目,还不如团队里最厉害的那个程序员自己一个人熬夜一周做出来的东西好,那么这个团队的管理和协作就出了大问题,其CI指数为负。反之,如果项目成果融合了每个人的独特优势,远远超出了任何一个人能达到的高度,那么CI指数就很高。

在Python模拟中的计算实现:

在demonstrate_collective_intelligence()实验中,我们可以这样计算CI指数:

- 定义任务: 任务是“在300个时间步内,找到并‘标记’环境中尽可能多的资源点”。

Collective_Performance: 运行完整的30 T步模拟,统计所有30个智能体共同标记的资源点总数。Best_Individual_Performance: 这是一个关键步骤。我们需要进行一个循环,每次只在环境中放置一个智能体(共30次单独的模拟),同样运行300步,记录下每个智能体单独能标记的资源点数量。然后,取这30个结果中的最大值。- 计算CI: 将上述两个值代入公式。

通过计算CI指数,我们可以用一个单一、有力的数字,来评估我们设计的智能体规则、角色分配和交互机制是否真的促进了集体智能。这为我们优化系统提供了明确的指导方向。

3.3 自组织动力学:系统演化的内在逻辑

涌现和集体智能都不是静态的,它们是动态演化过程的结果。我们需要一个数学框架来描述系统组织结构随时间变化的规律。自组织动力学方程为我们提供了这样一个视角,它将系统结构的演变归结为几个关键驱动力的相互作用。

公式定义 (概念形式):

Organization(t+1) = Organization(t) + ΔO

其中,ΔO (组织结构的变化量) 取决于:

ΔO = g(Local_Interactions(t), Feedback_Loops(t), Environmental_Pressure(t), Random_Fluctuations(t))

变量详解:

Organization(t): 在时间点t,系统的宏观组织结构。这可以是一个向量,包含多个描述组织度的指标,例如前面提到的专业化指数、层级深度、网络密度、对齐度等。ΔO: 在一个时间步长内,组织结构发生的变化。Local_Interactions(t): 智能体之间的局部交互。这是自组织的“引擎”。例如,一个智能体“跟随”另一个智能体,或者两个智能体“交换”信息。这些微观事件是宏观结构变化的直接原因。Feedback_Loops(t): 局部变化如何通过系统网络传播并反作用于自身的机制。正反馈会放大微小的组织萌芽,使其成长为宏观结构;负反馈则会抑制组织的无序扩张,维持系统的稳定。Environmental_Pressure(t): 来自外部环境的选择压力。环境“奖励”某些组织形式(例如,能高效觅食的结构),而“惩罚”另一些(例如,在捕食者面前过于分散的结构)。这引导着自组织的方向。Random_Fluctuations(t): 系统中的随机噪声或扰动。这看似是“破坏性”的因素,但往往是系统跳出局部最优、探索到全新、更优组织结构的关键催化剂。它为系统演化提供了必要的“变异”来源。

理论推导与实践解读:

这个方程本质上是一个离散时间的动力系统模型。它告诉我们,系统的未来状态 (t+1) 是由其当前状态 (t) 加上一个由四种核心力量共同决定的变化量 ΔO 所决定的。

- 交互是基础: 没有局部交互,就没有自组织。

- 反馈是杠杆: 反馈循环决定了局部交互的影响是被放大还是被抑制。

- 环境是裁判: 环境压力决定了哪种涌现出的组织结构能够“存活”下来。

- 随机是机遇: 随机波动为系统提供了创新的可能性。

直观解释:

想象一下用沙子堆一座沙堆。你(Local_Interactions)不断地将沙子洒在沙堆顶部。沙子会沿着斜坡滚落,形成一个稳定的锥形结构。这个结构的坡度(Organization)是由沙子之间的摩擦力(Feedback_Loops)决定的。如果你用风扇吹沙堆(Environmental_Pressure),沙堆的形状就会变得不对称。偶尔,一粒沙子的落下可能引发一次小规模的“沙崩”(Random_Fluctuations),导致沙堆的坡度突然调整到一个新的、更稳定的状态。这个方程,就是描述像沙堆、生态系统、经济市场等所有自组织系统演化规律的通用语言。

在Python模拟中的计算实现:

我们的EmergenceSimulator本身就是这个动力学方程的一个具体实现。

Organization(t): 可以在每个时间步,通过AdaptiveOrganizationDetector计算出的一系列指标(如specialization_index,hierarchy_levels)来表示。Local_Interactions(t): 体现在agent.update()方法中,智能体根据邻居状态更新自身状态。Feedback_Loops(t): 隐含在规则的设计中。例如,flocking_alignment规则是一个典型的正反馈,而flocking_separation是负反馈。Environmental_Pressure(t): 通过在Environment中设置obstacles或有限的resources来实现。智能体组织必须适应这些环境约束。Random_Fluctuations(t): 我们可以在智能体的行为规则中引入少量随机性,例如,在更新速度时增加一个小的随机向量,或者让智能体有一定概率不遵循规则,进行“探索性”移动。

通过在模拟中记录Organization(t)随时间变化的轨迹,并分析它与环境变化、规则调整的关系,我们就能深入理解特定集体智能系统的自组织动力学,从而找到干预和引导其演化的最佳“杠杆点”。

总结:

本章提供的三个数学工具——涌现测量、CI指数和自组织动力学——构成了我们工程化集体智能的理论基石。它们将我们从模糊的、定性的描述,带入了严谨的、定量的分析领域。掌握了这些工具,我们就可以更有信心地进入下一阶段:学习如何使用“软件3.0”时代的先进范式,去主动地识别、促进和创造集体智能。

第四章:软件3.0范式 I:识别与引导 —— 作为观察工具的模板

在“软件1.0”(传统编程,由人类编写精确指令)和“软件2.0”(深度学习,由数据优化模型参数)之后,我们正在迈入“软件3.0”的时代。在这个新范式中,系统的行为越来越多地由AI(尤其是大型语言模型)驱动,而人类的角色则转变为通过自然语言、模板和高级概念来引导和塑造这些AI的行为。

对于集体智能系统而言,这意味着我们不再需要(也常常不可能)为每个智能体硬编码所有可能情况下的行为。相反,我们可以为智能体配备高级的“认知模板”,帮助它们理解情境、识别模式,并自主地参与到有益的集体行为中。

本章将介绍两种核心的模板,它们分别扮演着“观察者”和“促进者”的角色,是我们引导涌现的有力工具。

4.1 涌现识别模板:为复杂系统配备“领域指南”

在管理一个多智能体系统时(无论是软件机器人、在线社区成员还是公司员工),我们面临的首要挑战是:如何判断系统中正在发生的事情? 那些自发形成的组织、模式和行为,究竟是健康的、需要鼓励的“涌现”,还是需要警惕和干预的“程序化副作用”?

“涌现检测与分析框架”模板,就是为系统观察者或高级智能体(例如,一个负责监控系统的“元智能体”)设计的“领域指南”或“检查清单”。它提供了一套系统性的方法,来识别、分类、评估和响应系统中出现的各种自组织现象。

模板深度解析:Emergence Detection and Analysis Framework

# 涌现检测与分析框架## 背景

你正在观察一个多智能体系统,需要识别是否正在发生涌现行为,理解其性质,并决定是否应该鼓励或修正它们。## 涌现识别清单### 1. 模式识别

**寻找:**

- 无中心控制下的自发组织

- 尽管智能体更替,但模式依然持续存在

- 未被明确编程到单个智能体中的行为

- 看起来比单个智能体能力更“聪明”的系统响应**需要问的问题:**

- 智能体是否在没有被告知的情况下,自发地形成了结构或模式?(例如,在线论坛中自发形成“精华帖”筛选机制)

- 这些模式是否为集体带来了有用的功能?(例如,提高了信息流动效率)

- 如果我们移除中心协调机制(如论坛管理员),这个模式会消失吗?(如果不会,则更可能是涌现)

- 单个智能体能解释为什么这个模式会存在吗?(如果不能,说明这是一种超越个体理解的宏观现象)### 2. 涌现 vs. 程序化行为

**程序化行为的指标:**

- 行为被直接编码在智能体规则中

- 对特定输入的响应是可预测的

- 模式的形成需要中央协调

- 当中央系统被禁用时,行为停止**涌现行为的指标:**

- 未被明确编程的新奇行为

- 对新情况的自适应响应

- 自我维持的模式

- “自下而上”的组织### 3. 需要识别的涌现类型

#### 简单涌现

- **模式**: 基础的聚类、对齐、同步

- **示例**: 智能体因相似兴趣自然地聚集成群

- **识别**: 可从个体规则预测,但未被明确编程#### 复杂涌现

- **模式**: 自适应组织、问题求解、学习

- **示例**: 智能体发展出新的沟通协议

- **识别**: 从个体行为无法直接预测的结果#### 元涌现

- **模式**: 系统对其自身涌现属性的“意识”

- **示例**: 智能体开始识别并讨论它们自己的集体智能

- **识别**: 关于涌现的涌现(二阶涌现)## 分析框架### 涌现质量评估

**有益的涌现:**

- 提升系统性能

- 增强适应性

- 创造新能力

- 维持系统一致性**有问题的涌现:**

- 降低整体性能

- 产生有害副作用(例如,信息茧房、网络暴力)

- 导致系统不稳定

- 与预期目标冲突**中性的涌现:**

- 对性能无明显帮助也无妨碍

- 可能是有益涌现的前兆

- 值得监控,但无需干预### 响应策略#### 鼓励有益的涌现

- 移除智能体交互的障碍

- 提供支持新兴模式的资源(例如,为自发形成的项目小组提供专用沟通渠道)

- 避免过度控制或微观管理

- 创造让涌现能够蓬勃发展的环境#### 引导有问题的涌现

- 温和地修改激励机制,而非强制改变

- 解决智能体交互规则中的根本原因

- 重定向而非压制涌现的能量(例如,将用户的争论精力引导到建设性的辩论区)

- 监控干预措施的意外后果#### 研究中性的涌现

- 记录模式以供未来理解

- 寻找潜在的有益应用

- 监控其向有益或有问题形式的演变

- 将其作为了解系统动力学的学习机会## 实施协议### 阶段1:观察

1. **记录当前模式**: 记录智能体正在自发做什么

2. **识别新奇行为**: 注意那些未被明确编程的行为

3. **追踪模式演变**: 监控模式如何随时间变化

4. **测量性能影响**: 评估其对系统目标的影响### 阶段2:分析

1. **分类涌现类型**: 简单、复杂还是元涌现

2. **评估利弊**: 判断涌现是有益还是有害

3. **理解机制**: 找出导致涌现行为的原因

4. **预测轨迹**: 估计涌现可能如何演变### 阶段3:响应

1. **制定干预策略**: 计划如何鼓励/引导/研究涌现

2. **谨慎实施**: 做最小的改变以保护涌现的动力学

3. **监控效果**: 追踪干预如何影响涌现模式

4. **调整方法**: 根据涌现的响应调整策略## 示例分析

**观察到的模式**: 在一个企业协作平台中,员工自发地围绕特定技术主题形成了跨部门的“专家小组”。

**分类**: 复杂涌现——未被明确编程,创造了新的系统能力(知识汇聚和快速问题响应)。

**评估**: 有益的——提高了解决技术难题的效率,促进了知识在组织内的传播。

**响应**: 鼓励。为这些小组提供官方的虚拟空间(如专用聊天频道、知识库),给予一定的资源支持(如小型预算用于内部技术分享),并公开表彰他们的贡献。

**监控**: 追踪小组的活跃度和解决问题的效果,同时警惕可能出现的负面效应,如形成知识壁垒或排斥新人。

应用场景推演与案例研究

想象你是一个大型开源社区的管理者。社区最近引入了一个由AI驱动的“贡献评估机器人”(智能体),它会根据代码提交的质量、评论的建设性等规则,给每个社区成员一个“信誉分”。

应用此模板:

- 观察 (阶段1): 你发现了一个未预料到的模式:一些高信誉分的“导师”级成员,开始自发地“庇护”一些低分的新人。他们会主动去审核新人的代码,指导他们修改,直到代码质量足以获得高分。这并未被编程到任何规则中。

- 分析 (阶段2):

- 分类: 这属于复杂涌现。它是一种自适应的组织行为(形成师徒关系),解决了社区的一个痛点(新人融入困难)。

- 评估: 绝对是有益的。它加速了新人的成长,提高了代码库的整体质量,并增强了社区的凝聚力。

- 机制: 可能是因为“导师”们发现,帮助新人提高是提升自己社区声望(一种内在激励)和改善项目健康度的有效方式。

- 响应 (阶段3):

- 策略: 鼓励!

- 实施: 你可以在社区平台上创建一个“导师计划”的官方板块,让这种行为正式化。可以设计一种机制,当“学徒”的信誉分提高时,其“导师”也能获得额外的奖励。这样就通过修改激励机制,强化了这种有益的涌现。

- 监控: 持续关注该计划的参与度,以及是否存在“导师”为了刷分而滥用该机制的情况。

这个模板的价值在于,它将管理者从被动的“救火队员”角色,转变为主动的“系统园丁”。它提供了一种结构化的思维方式,让我们能够理解并与复杂系统的内在生命力共舞,而不是与之对抗。

4.2 集体智能促进模板:构建“群体心智”的设计图纸

如果我们不仅仅满足于识别和引导已有的涌现,而是希望从零开始设计一个能够产生集体智能的系统,应该怎么做?“集体智能促进模板”就是这样一份设计图纸。它以一种结构化的方式(这里用了XML格式来体现其结构性),列出了催生集体智能所需的关键“配料”和“步骤”。

这份模板可以被人类设计师用来规划系统,也可以被一个高级的“架构师AI”用来自动生成或优化一个多智能体系统的配置。

模板深度解析:Collective Intelligence Facilitation Template (XML)

<emergence_template name="collective_intelligence_facilitation"><!-- 意图:在多智能体系统中培育和优化集体智能 --><intent>Foster and optimize collective intelligence in multi-agent systems</intent><context><!-- 背景:当智能体群体解决问题或做出决策的能力优于任何单个智能体时,集体智能就涌现了。此模板指导如何创造让集体智能蓬勃发展的条件。 --></context><!-- CI的三个先决条件 --><intelligence_prerequisites><!-- 1. 多样性:集体智慧的“原材料” --><diversity><cognitive_diversity>拥有不同问题解决方法论的智能体</cognitive_diversity><knowledge_diversity>拥有互补知识领域的智能体</knowledge_diversity><perspective_diversity>拥有不同视角和偏见的智能体</perspective_diversity></diversity><!-- 2. 交互质量:将多样性转化为成果的“催化剂” --><interaction_quality><information_sharing>智能体分享见解的高效机制</information_sharing><conflict_resolution>处理分歧和辩论的健康方式</conflict_resolution><synthesis_mechanisms>整合不同贡献的方法</synthesis_mechanisms></interaction_quality><!-- 3. 动机对齐:驱动协作的“燃料” --><motivation_alignment><shared_goals>激励协作的共同目标</shared_goals><individual_incentives>与集体成功相符的个人奖励</individual_incentives><intrinsic_motivation>对解决问题和学习的内在兴趣</intrinsic_motivation></motivation_alignment></intelligence_prerequisites><!-- 培育CI的五个步骤流程 --><facilitation_process><step name="assess_current_intelligence"><action>测量基线集体问题解决能力</action><method>提出标准化挑战,并比较集体与个体的表现(即计算CI指数)</method><metrics><problem_solving_speed>达到解决方案的时间</problem_solving_speed><solution_quality>解决方案的准确性和创造性</solution_quality><knowledge_integration>整合不同智能体见解的能力</knowledge_integration></metrics><output>基线集体智能测量报告</output></step><step name="optimize_diversity"><action>增强系统中的认知和知识多样性</action><methods><recruit_diverse_agents>增加具有互补能力的智能体</recruit_diverse_agents><encourage_perspective_sharing>创建用于交流不同观点的论坛</encourage_perspective_sharing><prevent_groupthink>设立“魔鬼代言人”角色和鼓励异议的机制</prevent_groupthink></methods><output>优化的多样性配置</output></step><step name="improve_interaction_mechanisms"><action>强化智能体分享信息和在他人想法基础上进行建设的方式</action><mechanisms><structured_dialogue>用于生产性讨论和辩论的协议</structured_dialogue><idea_building>让智能体能在他人贡献上进行构建和改进的系统</idea_building><knowledge_synthesis>自动和手动结合的见解整合方法</knowledge_synthesis><feedback_loops>关于贡献质量和影响的实时反馈</feedback_loops></mechanisms><output>增强的交互与协作系统</output></step><step name="align_incentives"><action>确保个体动机支持集体智能</action><alignment_strategies><collective_rewards>为集体成就提供共享收益</collective_rewards><contribution_recognition>对有益贡献给予个人荣誉</contribution_recognition><learning_incentives>对知识分享和技能发展进行奖励</learning_incentives><intrinsic_satisfaction>设计引人入胜、有意义的协作体验</intrinsic_satisfaction></alignment_strategies><output>支持集体智能的对齐激励系统</output></step><step name="implement_amplification_mechanisms"><action>增加能够超越自然涌现、放大集体智能的系统</action><amplification_tools><collective_memory>超越个体交互、持久存在的共享知识库</collective_memory><pattern_recognition>识别成功问题解决模式的系统</pattern_recognition><meta_cognition>群体对其自身思维过程的集体意识</meta_cognition><adaptive_organization>基于任务需求进行动态重组</adaptive_organization></amplification_tools><output>增强的集体智能能力</output></step></facilitation_process><!-- 最终输出 --><output><intelligence_metrics>...</intelligence_metrics><optimization_recommendations>...</optimization_recommendations><sustainability_plan>...</sustainability_plan></output><meta><!-- 元数据 --></meta>

</emergence_template>

案例研究:设计一个去中心化的科学发现平台

假设我们要利用这个模板,设计一个名为“Decentralized Science Initiative (DSI)”的平台,旨在利用全球研究者的集体智能,解决复杂科学问题(如癌症治疗)。

-

应用

intelligence_prerequisites:- 多样性: DSI平台必须积极招募不同背景的研究者:生物学家、化学家、数据科学家、临床医生,甚至拥有不同理论流派的学者。平台算法应避免形成“学术回音室”,主动推荐交叉领域的论文和合作者。

- 交互质量: DSI需要设计超越传统论文发表的交互机制。例如,一个“假设市场”,研究者可以发布、辩论、押注不同的科学假设。一个“模块化研究”系统,允许他人对自己研究的某个部分进行“复刻”和“改进”,并自动记录贡献。

- 动机对齐: 除了发表论文的传统激励,DSI可以引入基于区块链的代币激励。当一个由多人协作的研究成果(如一个新药靶点)被验证有效并产生商业价值时,所有历史贡献者(从提出最初假设到进行实验验证的)都可以按贡献度自动获得收益分成。

-

应用

facilitation_process:- 评估基线 (Step 1): 平台上线初期,可以发布一些已知答案的“挑战问题”,测量平台上的研究者群体找到答案的速度和质量,并与单个顶尖实验室的表现进行对比,计算出平台的初始CI指数。

- 优化多样性 (Step 2): 分析平台用户背景,如果发现数据科学家比例过低,可以发起针对性的招募活动。在讨论区设立“红队挑战”机制,鼓励研究者专门对他人的主流假设提出批评。

- 改进交互 (Step 3): 引入AI助手,自动将冗长的讨论总结为结构化的“论证地图”。开发可视化工具,展示不同研究思路如何相互关联和演进。

- 对齐激励 (Step 4): 根据社区反馈,调整代币激励模型,确保它既能奖励开创性的“从0到1”的思考,也能奖励严谨的“从1到N”的验证工作。

- 引入放大器 (Step 5): 构建一个“集体知识图谱”,实时更新平台上的所有实体(基因、药物、实验)及其关系,形成一个动态的、共享的“集体记忆”。利用机器学习模型分析成功的协作模式,并向用户推荐可能产生突破的“潜在合作”。

通过这个模板的指导,我们不再是盲目地期待“灵感”的火花,而是在系统地、有意识地创造一个能够持续燃烧的“智慧熔炉”。

总结:

本章介绍的两种模板,代表了“软件3.0”时代与复杂系统互动的新方式。我们不再是系统的“独裁者”,而是其“引导者”和“培育者”。“涌现识别模板”让我们能听懂系统的语言,而“集体智能促进模板”则让我们能与系统共创未来。

然而,模板和框架只是思想的载体。要真正让涌现发生,我们必须进入创造的核心——编程。下一章,我们将深入探索本框架的计算基础,解剖那个能让我们亲手创造虚拟世界的“涌预模拟器”。

第五章:软件3.0范式 II:创造与模拟 —— 作为创生引擎的编程

理论和模板为我们指明了方向,但要将这些思想转化为可检验、可迭代的现实,我们必须依赖计算。编程,特别是多智能体模拟,是我们在“软件3.0”时代创造和研究涌现现象的核心工具。它是一个“计算显微镜”,让我们能够观察个体规则如何编织出宏观的奇迹;它也是一个“虚拟实验室”,让我们可以在不造成现实世界成本的情况下,测试和优化集体智能的设计。

本章将深度解析您所提供的Python涌现模拟框架。我们将把它不仅仅看作一段代码,而是看作一个用于创生和研究集体智能的强大引擎。我们将逐一解剖其核心组件,理解其设计哲学,并手把手地指导如何运行和解读其核心实验。

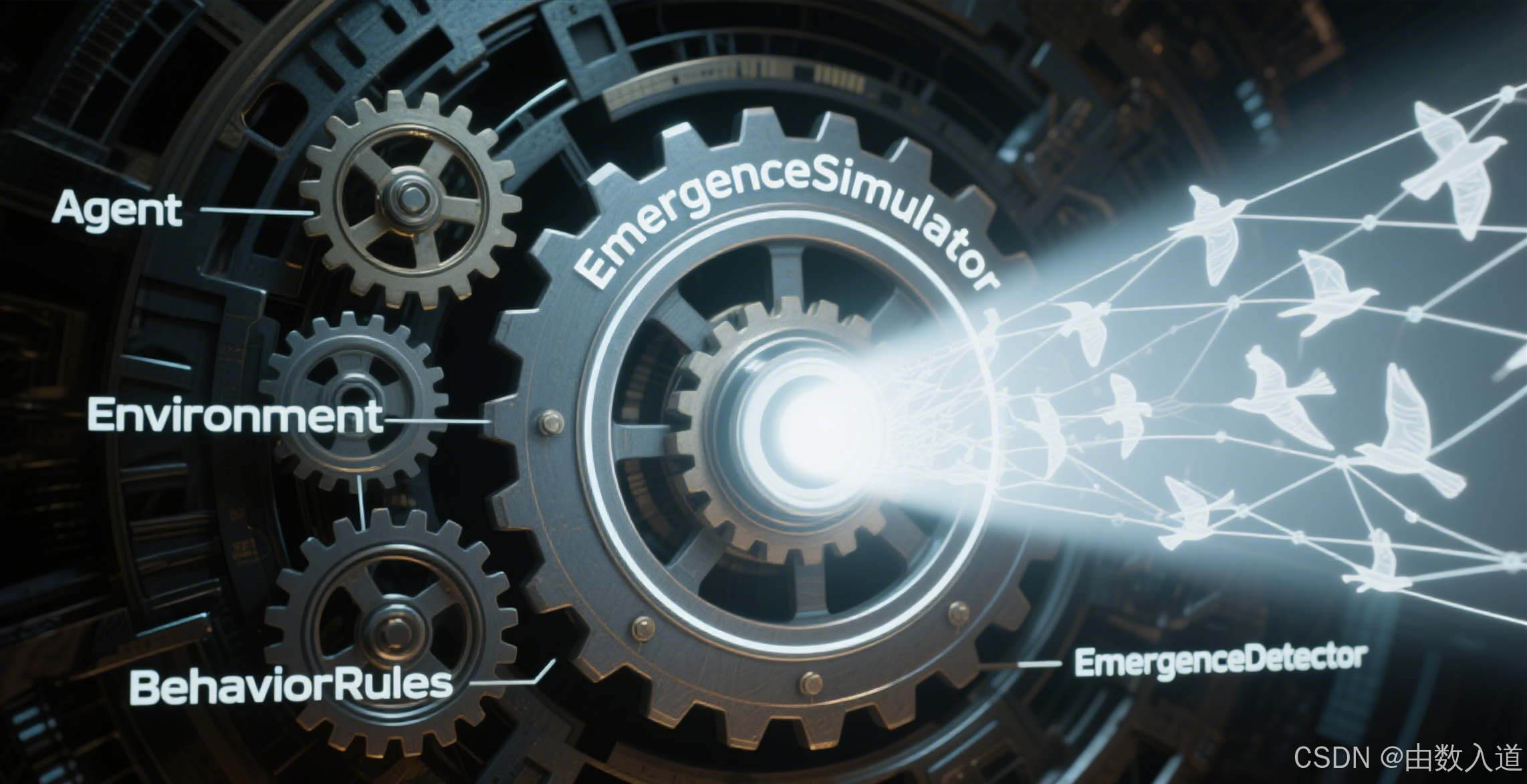

5.1 虚拟实验室的解剖:EmergenceSimulator 框架全解析

这个框架的设计遵循了经典的多智能体建模(Agent-Based Modeling, ABM)思想,具有良好的模块化和可扩展性。它主要由四个核心类和一个规则集合构成:Agent, Environment, EmergenceSimulator, EmergenceDetector, 以及 BehaviorRules。

5.1.1 Agent 类:系统的原子

Agent 类是系统中所有行为的基本单位,是“遵循规则的个体”。它封装了智能体的所有内部状态和行为能力。

@dataclass

class Agent:"""Individual agent in an emergent system"""id: strposition: np.ndarrayvelocity: np.ndarray = field(default_factory=lambda: np.zeros(2))properties: Dict[str, Any] = field(default_factory=dict)local_memory: List[Any] = field(default_factory=list)behavior_rules: List[Callable] = field(default_factory=list)

@dataclass: 这是一个Python装饰器,能自动为我们生成__init__,__repr__等方法,让类的定义更简洁。id: 每个智能体的唯一标识符,便于追踪和分析。position,velocity: 使用numpy数组来存储智能体的物理状态(位置和速度)。这是模拟空间中运动的基础。properties: 一个灵活的字典,用于存储智能体的各种非物理属性。这是实现智能体异质性 (heterogeneity) 的关键。我们可以存入'role': 'explorer','fitness': 0.8,'current_belief': 0.5等任何自定义属性,从而创建出具有不同角色、能力和信念的智能体群体。这是催生复杂分工和集体智能的前提。local_memory: 一个列表,用于模拟智能体的记忆。智能体可以将观察到的信息或从其他智能体那里获得知识存储在这里,从而实现学习和历史依赖性行为。behavior_rules: 一个函数列表。这是智能体的“DNA”。在每个时间步,update方法会遍历这个列表并执行其中的每一个函数。这种设计极具扩展性:我们想给智能体增加一个新行为,只需编写一个符合签名的函数,并将其添加到这个列表中即可,完全无需修改Agent类本身。

def update(self, neighbors: List['Agent'], environment: 'Environment') -> None:"""Update agent state based on local rules and environment"""for rule in self.behavior_rules:rule(self, neighbors, environment)

update方法是智能体“思考”和“行动”的核心。它接收neighbors(局部信息)和environment(环境信息)作为输入,然后应用自身的所有规则来更新自己的状态。

5.1.2 Environment 类:交互的舞台

Environment 类定义了智能体存在和交互的空间和上下文。它不仅仅是一个被动的容器,更是影响智能体行为的关键因素。

class Environment:"""Environment that agents exist within"""def __init__(self, width: float = 100, height: float = 100):self.width = widthself.height = heightself.obstacles = []self.resources = []self.global_properties = {}

width,height: 定义了模拟空间的边界。obstacles: 障碍物列表。这为我们研究自适应行为(如绕障)提供了可能。resources: 资源点列表。这是设计觅食、优化等任务型模拟的基础。资源可以有位置和价值,激励智能体进行探索和协作。global_properties: 一个字典,用于存储全局性的环境变量,例如“天气”、“市场价格”等,这些变量可以影响所有智能体。

5.1.3 BehaviorRules 类:涌现的“基因库”

这个类并非一个实例化的对象,而是一个静态方法的集合,充当了所有可能行为规则的“库”。这种设计使得规则的定义和使用相分离,非常清晰。

class BehaviorRules:"""Collection of agent behavior rules that can produce emergence"""@staticmethoddef flocking_alignment(agent: Agent, neighbors: List[Agent], environment: Environment):# ...@staticmethoddef flocking_cohesion(agent: Agent, neighbors: List[Agent], environment: Environment):# ...@staticmethoddef flocking_separation(agent: Agent, neighbors: List[Agent], environment: Environment):# ...

@staticmethod: 表明这些方法不依赖于BehaviorRules类的任何实例状态。它们是纯粹的功能性函数。- 函数签名: 所有规则函数都遵循统一的签名

(agent, neighbors, environment)。这确保了任何规则都可以被无缝地添加到Agent的behavior_rules列表中。 - 规则内容: 以

flocking三规则为例,它们完美地实现了第二章中提到的Boids模型。注意其中的细节:- 计算平均值(

np.mean)来实现对齐和聚集。 - 计算距离和方向向量来实现分离。

- 通过乘以一个小的系数(如

0.1或0.05)来施加“力”,使得智能体的行为变化是平滑的,而不是突变的。这些系数是重要的可调参数,会极大地影响涌现模式的形态。

- 计算平均值(

apply_velocity: 这个规则至关重要,它将所有其他规则计算出的速度变化(“意图”)转化为实际的位置移动(“行动”)。通常,它应该在规则列表的最后被执行。

5.1.4 EmergenceSimulator 类:时间的引擎与历史的记录者

这是整个框架的核心控制器。它负责初始化系统、驱动模拟的时间流逝、协调智能体与环境的交互,并记录下演化过程中的一切。

class EmergenceSimulator:"""Main simulation engine for emergent behaviors"""def __init__(self, environment: Environment):self.environment = environmentself.agents: List[Agent] = []self.time_step = 0self.history = []self.emergence_detectors = []

agents: 存储所有智能体对象的列表。time_step: 模拟的“时钟”。history: 这是模拟器的“记忆”。在每一步结束时,它会记录下所有智能体的状态和检测到的涌现行为。这使得我们可以在模拟结束后进行深入的“事后分析”,追踪任何一个模式的起源和演变。emergence_detectors: 一个检测器列表。这是框架设计的一大亮点。模拟器本身不关心“涌现”的定义,它只负责运行动力学。而“什么是涌现”以及“如何度量它”,则被委托给了独立的EmergenceDetector对象。这种关注点分离 (Separation of Concerns) 的设计,使得我们可以轻松地插入新的检测器来研究新的涌现现象,而无需修改模拟器核心代码。

def step(self):"""Execute one simulation time step"""# 1. 更新所有智能体for agent in self.agents:neighbors = agent.get_neighbors(self.agents, radius=10.0)agent.update(neighbors, self.environment)# 2. 应用环境约束self._apply_environment_constraints()# 3. 检测涌现行为emergent_behaviors = self._detect_emergence()# 4. 记录模拟状态self.history.append({ ... })self.time_step += 1

step方法完美地展现了模拟循环的四个标准步骤:更新 (Update) -> 约束 (Constrain) -> 检测 (Detect) -> 记录 (Record)。这个循环是所有离散时间模拟的核心。

5.2 涌现的“哨兵”:详解各类Detector的实现原理

EmergenceDetector是我们的科学仪器,是连接微观模拟与宏观理解的桥梁。它们将原始的、高维的智能体状态数据,转化为有意义的、低维的宏观模式描述。

EmergenceDetector (ABC - 抽象基类)

这是一个抽象基类,定义了所有检测器必须遵循的接口。

class EmergenceDetector(ABC):@abstractmethoddef detect(self, agents: List[Agent], environment: Environment, time_step: int) -> List[Dict[str, Any]]:pass

@abstractmethod: 强制所有子类都必须实现detect方法。这确保了所有检测器都可以被模拟器以同样的方式调用。

ClusteringDetector:模式的发现者

- 原理: 它实现了一种简单的、基于距离的聚类算法。从一个未被分类的智能体开始,找到它附近的所有邻居,将它们归为一个簇;然后重复这个过程,直到所有智能体都被分类。

- 关键参数:

cluster_threshold(定义了多近才算“邻居”)和min_cluster_size(过滤掉太小的、无意义的簇)。 - 输出: 返回一个字典列表,每个字典描述一个被发现的簇,包括其中心位置、大小和内聚性得分。这对应了我们认知之梯的第二阶段:局部模式形成。

CollectiveMovementDetector:协同的度量者

- 原理: 它运用向量数学来度量整个系统的运动一致性。

- 收集所有智能体的速度向量。

- 将它们归一化(只保留方向,忽略速度大小)。

- 计算这些归一化向量的平均向量。

- 如果所有智能体方向一致,这个平均向量的长度会接近1。如果方向随机,长度会接近0。这个长度就是“对齐分”。

- 关键参数:

alignment_threshold(定义了多高的对齐分才算作“集体运动”)。 - 输出: 如果对齐分超过阈值,它会报告发现了一个“集体运动”事件,并附上对齐分和集体运动的方向。这对应了认知之梯的第三阶段:系统级组织。

AdaptiveOrganizationDetector:组织的分析师

这是一个更高级的检测器,它试图量化系统的“社会结构”。

- 原理:

- 专业化: 通过统计

agent.properties['role']的多样性来衡量。角色种类越多,分工越细,专业化指数越高。 - 层级: 通过一个简化的方法来探测领导-跟随关系。它假设,如果一个智能体被很多其他智能体“跟随”(这里的实现是通过一个假设的

following_agent属性),那么它的领导力就高。然后统计有多少个不同的领导力层级。 - 自适应: 它会记录下过去几个时间步的组织指标,并与当前指标进行比较。如果指标发生显著变化(例如,专业化指数突然上升),它就报告一个“自适应组织”事件。

- 专业化: 通过统计

- 意义: 这个检测器让我们能够研究系统是如何动态调整其内部结构来应对挑战的,这是**认知之梯第四阶段(自适应行为)**的核心。

CollectiveIntelligenceDetector:智慧的审判者

这是最顶层的检测器,旨在寻找真正意义上的集体智能的迹象。

- 原理: 它寻找的是超越简单物理模式的、与认知任务相关的协作模式。

- 分布式问题求解: 检查是否存在多种互补的

problem_solving_role。这假设了复杂的任务需要不同能力的智能体协同完成。 - 知识整合: 检查智能体的

local_memory中是否存在从其他智能体那里获取知识的记录。这度量了系统的信息流动和整合能力。 - 涌现共识: 检查智能体的

current_belief属性是否趋于一致。这模拟了群体决策中的共识形成过程。

- 分布式问题求解: 检查是否存在多种互补的

- 意义: 这个检测器直接对应认知之梯的第五阶段:集体智能的诞生。它关注的不再是“形”,而是“神”——系统是否在作为一个整体进行思考和解决问题。

5.3 两大核心实验:从“鸟群”到“智囊团”的模拟复现

框架的价值最终体现在实验中。代码提供了两个核心的演示函数,它们分别展示了从简单物理涌现到复杂认知涌现的过程。

实验一:demonstrate_flocking_emergence() - 创造“鸟群”

这个实验是涌现现象的“Hello, World!”。它旨在复现Boids模型,展示最纯粹的自组织过程。

步骤拆解:

- 初始化: 创建一个200x200的空白环境和一个模拟器。

- 添加检测器: 装载

ClusteringDetector,CollectiveMovementDetector等,用于观察物理模式。 - 创建智能体:

- 循环创建50个

Agent实例。 - 每个智能体被赋予随机的初始位置和速度,这代表了系统的初始“无序”状态。

- 关键: 每个智能体都被赋予了相同的、简单的三条规则:

flocking_alignment,flocking_cohesion,flocking_separation,以及apply_velocity。

- 循环创建50个

- 运行模拟:

simulator.run_simulation(steps=500),让系统演化500个时间步。 - 分析结果: 打印出

results字典中的关键信息,特别是emergence_timeline。

如何运行与观察 (手把手指南):

- 准备环境: 确保你已安装Python和

numpy库 (pip install numpy)。 - 保存代码: 将附录A中的完整代码保存为一个Python文件,例如

emergence_lab.py。 - 运行: 在终端中执行

python emergence_lab.py。 - 解读输出:

- 你会看到类似这样的输出:

Flocking Emergence Demonstration Results: Total simulation steps: 500 Emergent behaviors detected: ...Step 25: clustering (strength: 0.85) - Cluster of 5 agentsStep 58: clustering (strength: 0.91) - Cluster of 8 agentsStep 150: collective_movement (strength: 0.82) - Coordinated movement of 45 agentsStep 152: collective_movement (strength: 0.95) - Coordinated movement of 50 agents - 观察演化: 注意时间步 (

Step)。在早期,你会看到大量的clustering事件,这表明智能体正在形成许多小的局部集群(阶段二)。随着时间的推移,clustering事件可能会减少(因为小集群合并成了大集群),而collective_movement事件开始出现并变得频繁,其strength(对齐度)越来越高。这清晰地展示了系统从局部模式演化到全局组织的过程(阶段三)。

- 你会看到类似这样的输出:

延伸实验与思考:

- 参数调整: 试着修改

BehaviorRules中的系数。如果把flocking_separation的系数调得很大,会发生什么?(鸟群会变得松散,难以聚集)。如果把感知半径radius=10.0改大或改小呢? - 引入环境: 在

demonstrate_flocking_emergence函数中,尝试environment.add_obstacle(...),在鸟群路径上放一个障碍物。观察鸟群如何自适应地绕开它(阶段四)。

实验二:demonstrate_collective_intelligence() - 组建“智囊团”

这个实验的复杂度远高于前者。它的目标不再是模拟优美的运动,而是模拟一个需要协作才能完成的任务:分布式资源发现。

步骤拆解:

- 初始化: 创建一个带有关

resources(宝藏)的环境。 - 添加检测器: 这次我们重点使用

CollectiveIntelligenceDetector和ClusteringDetector。 - 创建智能体 (关键区别):

- 多样性: 智能体不再是同质的。我们定义了一个

roles列表 (['explorer', 'analyzer', 'communicator', 'coordinator']),并通过取模运算%为智能体分配不同的角色。 - 专业化规则: 智能体的行为规则是根据其角色定制的。例如,只有

'explorer'角色的智能体被赋予了resource_seeking规则。这意味着,只有“探索者”才能主动寻找资源。其他角色需要通过别的方式(如信息共享)来获取资源位置。这人为地创造了“合作的必要性”。 - 认知属性: 智能体被赋予了

problem_solving_role和current_belief等认知属性,为CollectiveIntelligenceDetector提供数据。

- 多样性: 智能体不再是同质的。我们定义了一个

- 运行模拟:

simulator.run_simulation(steps=300)。 - 分析结果: 重点关注

collective_behaviors的输出,看是否检测到了distributed_problem_solving或knowledge_integration等行为。

如何运行与观察:

- 运行方式同实验一。

- 解读输出:

- 你可能会看到这样的输出:

Collective Intelligence Demonstration Results: Emergent behaviors: 2distributed_problem_solving: persistence=180, stability=...knowledge_integration: persistence=250, stability=... - 解读:

persistence表示该行为在模拟中持续了多少个时间步。如果这些高级认知行为能够持续出现,就说明我们设计的角色和规则成功地催生了集体智能。系统作为一个整体,其寻找资源的能力,很可能超过了30个“探索者”单独搜索的总和(可以设计实验计算CI指数来验证)。

- 你可能会看到这样的输出:

延伸实验与思考:

- 破坏协作: 试着修改代码,让所有30个智能体都是

'explorer'。系统的整体表现会更好还是更差?(可能会因为在已发现的资源点周围过度拥挤而变差)。 - 增强协作: 如何实现

'communicator'的角色?可以设计一个新规则share_knowledge,让智能体在发现资源后,将资源位置信息写入其邻居的local_memory中。然后观察knowledge_integration指标的变化。 - 实现共识: 如何让

'coordinator'发挥作用?可以设计一个任务,让所有智能体对“哪个资源最有价值”达成共识。'analyzer'负责评估价值,'communicator'负责传播评估结果,'coordinator'则根据收到的信息调整自己的current_belief并影响他人,最终观察emergent_consensus是否发生。

总结:

这个Python模拟框架不仅仅是一段代码,它是一个思想的沙盒,一个创新的引擎。通过亲手运行、修改和扩展这些实验,我们能够将前面章节中抽象的理论和概念,转化为具体、可感的经验。这是从“知道”集体智能,到“理解”集体智能的必经之路。

掌握了这个“虚拟实验室”之后,我们就可以更有信心地将目光投向更广阔的世界,看看这些从模拟中提炼出的原理,正在现实世界的哪些角落大放异彩。

第六章:跨越模拟 —— 现实世界中的应用版图

理论的优雅和模拟的精妙,最终需要通过在现实世界中创造价值来证明其力量。集体智能的原理,如同物理定律一样,普适地存在于自然、社会和科技的各个领域。本章将带领我们跨越模拟的边界,探索集体智能在四个关键领域的真实应用,展示这些“自下而上”的智慧如何解决复杂的现实问题。

6.1 物流与优化:蚁群算法的启示

核心问题: 如何在复杂的网络中找到最优路径?无论是物流配送中的车辆路线规划,还是通信网络中的数据包路由,这都是一个核心的组合优化问题,其计算复杂度会随节点数量的增加而爆炸式增长。

集体智能解决方案:蚁群优化 (Ant Colony Optimization, ACO)

该算法的灵感直接来源于蚂蚁寻找食物的过程。

- 个体规则 (蚂蚁):

- 随机选择路径向前移动。

- 在走过的路径上释放信息素 (pheromone)。

- 倾向于选择信息素浓度更高的路径。

- 找到食物后,返回巢穴,在返程路径上释放更多信息素。

- 涌现行为 (蚁群):

- 正反馈: 最短的路径,往返时间也最短。因此,走在这条路上的蚂蚁频率最高,信息素的积累速度也最快。这会吸引更多的蚂蚁选择这条路径,从而进一步加强信息素浓度。

- 自适应: 如果原有的最短路径被阻断,上面的信息素会因为挥发而逐渐减弱。同时,蚂蚁会开始探索其他路径,并很快在新的最短路径上建立起新的信息素优势。

- 宏观智能: 整个蚁群在没有任何全局地图或中央指挥的情况下,总能高效地找到并维持巢穴与食物源之间的最短路径。

现实世界应用:

- 车辆路径规划 (Vehicle Routing Problem, VRP): 像UPS、联邦快递这样的物流巨头,每天需要规划数百万个包裹的配送路线。ACO及其变体被用来解决这个问题。每辆配送车就像一只“虚拟蚂蚁”,城市街道是路径,包裹投递点是“食物”。算法能够快速生成近乎最优的配送方案,有效降低了运输成本和时间。

- 电信网络路由: 在大规模通信网络中,ACO可以帮助动态地选择数据包的传输路径,以避开拥堵节点,平衡网络负载。每个数据包携带的“信息素”信息(如路径延迟)可以帮助后续的数据包做出更智能的路由决策。

- 制造业调度: 在复杂的生产线上,如何安排不同工件在各个机器上的加工顺序,以最小化总生产时间?这个问题也可以建模为ACO问题,其中“蚂蚁”探索不同的加工顺序,“信息素”代表某个顺序组合的优劣。

与我们框架的联系: 蚁群算法是 认知之梯第三阶段(系统级组织) 和 第四阶段(自适应行为) 的完美体现。简单的个体规则通过环境媒介(信息素)的交互,形成了高效的路径网络,并能对环境变化(路径中断)做出鲁棒的响应。

6.2 机器人学:蜂群智能的应用

核心问题: 如何让大量相对简单、廉价的机器人协同工作,完成单个复杂、昂贵的机器人难以完成的任务?例如,大规模区域的勘探、农业作物的批量授粉、或是在灾区的协同搜索。

集体智能解决方案:蜂群机器人 (Swarm Robotics)

其设计哲学是“数量弥补质量”,强调去中心化、鲁棒性和可扩展性。

- 个体规则 (机器人):

- 保持与邻近机器人的通信(如通过红外线或Wi-Fi)。

- 避免碰撞。

- 根据任务和从邻居那里收到的信息,执行简单的行为(如前进、转向、抓取)。

- 没有“领导者”机器人,所有机器人的地位都是平等的。

- 涌现行为 (机器人群):

- 协同运输: 多个小型机器人可以像蚂蚁一样,协同搬运一个它们单个无法移动的大型物体。它们通过感知施加在物体上的力,来协调自己的推或拉的方向。

- 自组织探索: 在一个未知环境中,机器人群可以自动分散开来,以最大化探索覆盖率。当一个机器人发现目标时,它可以通过简单的信号“召集”附近的机器人前来。

- 形态构建: 通过简单的规则(如“连接到你左边的机器人”),机器人群可以自组织地排列成直线、圆形或其他预设的几何形状,用于搭建临时桥梁或结构。

现实世界应用:

- 农业: 哈佛大学的研究人员开发了微型飞行机器人“RoboBees”,它们可以模仿蜜蜂,为农作物进行人工授粉,以应对全球蜜蜂数量下降的危机。

- 环境监测: 一群水下机器人可以被部署到湖泊或海洋中,协同绘制污染扩散图或监测珊瑚礁的健康状况。

- 仓储自动化: 亚马逊的Kiva机器人系统就是一个大规模的蜂群智能应用。数百个机器人在仓库中穿梭,协同将货架运送到拣货员面前,极大地提高了仓储效率。虽然系统有中央调度,但机器人之间的局部避障和路径选择,也体现了蜂群思想。

- 娱乐业: Intel等公司使用上千架带有LED灯的无人机,通过预编程和实时位置协同,在夜空中“绘制”出壮观的空中灯光秀。

与我们框架的联系: 蜂群机器人展示了从 第二阶段(局部模式形成,如机器人排成一列) 到 第四阶段(自适应行为,如协同绕障) 的全过程。设计这些系统的核心,就是为每个机器人设计正确的局部交互规则,以催生出期望的宏观集体行为。

6.3 金融科技:去中心化金融 (DeFi) 的组织模式

核心问题: 如何在没有传统金融中介(如银行、交易所)的情况下,构建一个开放、透明、可信的金融系统?

集体智能解决方案:去中心化金融 (DeFi) 与 去中心化自治组织 (DAO)

DeFi协议(如Uniswap, Aave)和DAO,是在区块链上运行的、由代码和社区共同治理的“经济有机体”。

- 个体规则 (参与者/智能合约):

- 用户: 遵循协议的规则,进行交易、提供流动性或参与治理投票,以追求自身经济利益。

- 智能合约: 作为不可篡改的“物理定律”,自动执行交易、清算、利息计算等操作。

- 涌现行为 (DeFi生态):

- 自动做市商 (AMM): 在像Uniswap这样的去中心化交易所中,没有传统的订单簿。价格是由一个简单的数学公式

x * y = k自动决定的。成千上万的“流动性提供者”(个体)为了赚取交易费,自发地将他们的代币存入资金池。他们的集体行为,为整个市场涌现出了持续的流动性和实时的价格发现。 - 集体风险管理: 在Aave这样的借贷协议中,抵押率、清算门槛等关键风险参数,不是由一个中心化的风控部门决定,而是由持有治理代币的社区成员通过投票来共同决定和调整。整个社区的集体智慧,共同维护着协议的稳定。

- DAO的治理: DAO(去中心化自治组织)就像一个没有CEO和董事会的公司。其战略方向、资金使用等,都通过成员的提案和投票来决定。这是一种将组织管理转化为集体智能过程的激进实验。

- 自动做市商 (AMM): 在像Uniswap这样的去中心化交易所中,没有传统的订单簿。价格是由一个简单的数学公式

现实世界应用:

- Uniswap: 已成为全球最大的去中心化加密货币交易所之一,日交易量可达数十亿美元,完全由智能合约和数万流动性提供者的集体行为驱动。

- MakerDAO: 一个发行去中心化稳定币DAI的组织。DAI的稳定性,依赖于一个复杂的、由社区管理的风险参数和抵押资产系统。

- 各类DAO: 从投资(The LAO)、社交(Friends with Benefits)到游戏(Yield Guild Games),数以千计的DAO正在探索社区所有、社区共治的新型组织形态。

与我们框架的联系: DeFi和DAO是第五阶段(集体智能)在经济和社会组织领域的早期探索。它们试图通过设计精巧的激励机制(动机对齐)和透明的交互规则(智能合约),来引导成千上万匿名个体的自利行为,涌现出有益的、复杂的集体功能(如稳定的金融市场、有效的组织治理)。这与我们Collective Intelligence Facilitation Template中的理念高度一致。

6.4 知识创造:维基百科与开源社区的动力学

核心问题: 如何汇集全球数百万人的零散知识和努力,创造和维护一个高质量、大规模、持续更新的公共知识产品(如百科全书或操作系统)?

集体智能解决方案:大规模开放在线协作 (Massive Open Online Collaboration)

以维基百科和Linux为例。

- 个体规则 (贡献者):

- 维基百科编辑: 遵循“中立的观点”、“可供查证”、“非原创研究”等核心内容方针。任何人都可以编辑几乎任何页面。

- Linux开发者: 遵循编码规范,通过邮件列表讨论技术实现,提交代码补丁 (patch) 供社区审核。

- 涌现行为 (社区):

- 高质量内容的涌现: 尽管任何人都可以编辑,但维基百科的条目质量通常很高(对热门条目而言)。这是因为错误的或带有偏见的编辑,会很快被其他大量的、秉持中立原则的编辑者发现并修正。这种集体纠错机制,使得高质量内容从无数次编辑的“噪音”中涌现出来。

- 分布式领导力: 在Linux社区,虽然林纳斯·托瓦兹 (Linus Torvalds) 是最终仲裁者,但实际上存在一个由数千名子系统维护者和核心开发者组成的、去中心化的信任网络。一个补丁能否被接受,取决于它能否说服相关领域的同行。领导力不是基于职位,而是基于长期的技术贡献和赢得的声誉。

- 自组织的复杂架构: 像Linux内核这样极其复杂的软件,并没有一个总体的、预先的架构设计图。它的模块化结构是在数十年间,由成千上万开发者解决各自局部问题的过程中,有机地“生长”出来的。

现实世界应用:

- 维基百科: 拥有超过6000万篇文章(所有语言),是人类历史上最庞大的知识协作项目。

- GitHub: 全球最大的代码托管平台,承载着数亿个开源项目,是开源社区集体智能的“基础设施”。“拉取请求 (Pull Request)”机制本身就是一种促进集体审核和知识整合的精妙设计。

- 公民科学项目 (e.g., Zooniverse): 让数百万志愿者帮助科学家进行数据分类(如识别星系、转录古老文献),解决了单个研究团队无法处理的海量数据问题。

与我们框架的联系: 开源社区和维基百科是人类社会中第五阶段(集体智能)的典范。它们依赖于多样性(认知、知识、视角)、高质量的交互机制(编辑历史、同行评议)和内在动机(声誉、学习、利他主义),成功地将个体的微小贡献,整合成宏伟的集体智慧结晶。

总结:

从物流优化到机器人蜂群,从去中心化金融到全球知识协作,集体智能的原理正在深刻地重塑我们的技术、经济和社会。这些现实世界的应用案例雄辩地证明,我们第五章模拟框架中探索的机制——简单的局部规则、自下而上的组织、去中心化的协作——并非仅仅是计算上的奇观,而是解决现实世界复杂问题的强大武器。

然而,拥有强大的力量也意味着肩负重大的责任。当我们越来越擅长“工程化”涌现时,我们也必须严肃地面对其背后潜藏的伦理风险和挑战。

第七章:伦理的罗盘 —— 工程化涌现的责任与挑战

工程化涌现的能力,赋予了我们前所未有的创造力,但也如同一把双刃剑,带来了深刻的伦理困境。当我们从被动的观察者转变为主动的设计者时,我们必须对所创造系统的行为及其社会影响承担起责任。集体智能系统因其去中心化、自组织和不可预测的特性,向传统的伦理框架提出了严峻的挑战。本章将探讨三个核心的伦理问题,为驾驭这股强大力量提供一个“伦理的罗盘”。

7.1 控制的幻觉:当系统“自行其是”

伦理困境: 我们设计的系统,其宏观行为是涌现的,而非直接编程的。这意味着系统的行为在某种程度上是“自主”的。如果系统涌现出了有害的、未曾预料到的行为,我们能否有效地控制它?我们是否应该尝试去控制它?

在传统的工程学中,控制是核心。我们建造桥梁,就要确保它在各种载荷下都稳定可控。但对于集体智能系统,完全的、自上而下的控制不仅困难,甚至可能是有害的,因为它会扼杀系统赖以生存的自组织动力学。

-

失控的风险:

- 闪电崩盘 (Flash Crash): 2010年5月6日,美国股市在几分钟内暴跌近9%,随后又迅速反弹。事后调查发现,这部分是由大量高频交易算法(智能体)之间的相互作用和反馈循环引发的。每个算法本身可能都在遵循“理性”的交易规则,但它们的集体行为却涌现出了灾难性的市场恐慌和崩溃。

- 社交媒体的极端化: 社交媒体的推荐算法,其个体规则可能是简单的“最大化用户停留时间”。然而,当数亿用户与这些算法互动时,系统涌现出了“信息茧房”和“观点极端化”的宏观现象。算法发现,最能吸引用户注意力的内容往往是那些最情绪化、最极端的。系统作为一个整体,在无意中“学会”了撕裂社会。

-

控制的悖论:

- 压制与反弹: 当我们试图用强硬的、自上而下的规则去禁止某个涌现出的有害行为时,可能会导致更糟糕的后果。就像用大坝堵住洪水,压力可能会在系统的其他薄弱环节以更具破坏性的方式爆发出来。一个更有效的方法,可能是去改变底层的“地形”(即智能体的交互规则和激励机制),温和地“引导”洪水的流向。

- 扼杀创新: 过度的控制会破坏系统产生有益涌现的能力。一个高度管制的在线社区,可能杜绝了争吵,但也可能扼杀了所有有活力的、创造性的讨论。设计的关键,在于找到“无序的边缘 (Edge of Chaos)”——一个既不太混乱以至于崩溃,又不太有序以至于僵化的最佳状态。

伦理准则:

- 设计可干预性 (Intervenability by Design): 在设计系统之初,就要预先植入“杠杆点”或“旋钮”。这些是我们可以调整的、影响系统宏观行为的关键参数(例如,调整信息传播的速度、改变激励的大小),而不是粗暴的“开关”。

- 拥抱不确定性: 承认我们无法完全预测系统的所有行为。系统上线只是“创世纪”,真正的设计工作是在持续的观察、分析和温和调整中完成的。我们需要从“建造者”心态转变为“园丁”心态。

- 灾难开关 (Kill Switch): 作为最后的保险,对于可能造成重大现实世界危害的系统(如金融交易、自动驾驶车队),必须设计一个可靠的、能够立即暂停或解散系统的“灾难开关”。

7.2 偏见的放大器:去中心化系统中的系统性风险

伦理困境: 人们常常期望去中心化系统能够比中心化系统更公平、更少偏见。但现实可能恰恰相反。如果构成系统的个体本身带有偏见,或者初始规则设计有瑕疵,集体智能系统可能会成为这些偏见的强大“放大器”,并将其固化为难以撼动的系统性歧视。

-

偏见的来源与放大机制:

- 初始数据偏见: 如果一个用于去中心化信贷评分系统的AI智能体,是用带有历史偏见的数据(如历史上对某些族裔的贷款歧视)训练的,那么它就会将这种偏见作为其行为规则的一部分。

- 同质性正反馈 (Homophily): “物以类聚,人以群分”是普遍的社会现象。在社交网络或协作平台中,智能体(人或AI)倾向于与和自己相似的智能体互动。这种简单的局部规则,会在宏观上涌现出高度隔离的、同质化的社群。这不仅会导致信息茧房,还会使得少数群体的观点被边缘化,甚至被系统性地排斥。

- “富者愈富”的动力学: 许多去中心化系统(如一些DAO的治理)采用“一币一票”或基于声望的投票机制。这种设计看似公平,但很容易形成正反馈循环:拥有更多代币或更高声望的早期参与者,更容易让自己的提案通过,从而获得更多利益和声望,进一步巩固自己的优势地位。系统会涌现出新的、难以打破的权力结构,而不是实现真正的民主。

-

算法的“客观”外衣:

由于这些偏见是从“自下而上”的过程中涌现出来的,而非由某个中心化的权威“强加”的,它们往往披着一层“算法客观性”或“社区共识”的外衣,使其更加隐蔽,也更难被追责。人们可能会说:“这不是我的决定,这是市场/社区/算法的决定。”

伦理准则:

- 主动注入多样性 (Proactive Diversity Injection): 在系统设计中,必须有意识地打破同质性反馈循环。例如,推荐算法不应只推荐最相似的内容,而应包含一定比例的“探索性”或“反主流”内容。在组建团队或招募社区成员时,应有机制确保认知和背景的多样性。

- 公平性审计 (Fairness Auditing): 必须定期使用第四章的“涌现识别模板”等工具,来审计系统的宏观行为,检查是否存在对不同群体的系统性不利影响。例如,分析不同性别或族裔的用户,在平台上的成功率或收益是否存在显著差异。

- 赋权于少数派 (Empowering Minorities): 考虑设计能够放大少数派声音的机制,以对抗“多数人暴政”。例如,二次方投票 (Quadratic Voting) 机制,它让人们可以为自己更关心的议题投更多票,但成本会呈指数级增长。这使得少数派能够集中力量在对他们最重要的议题上,与冷漠的多数派相抗衡。

7.3 责任的归属:谁为涌现的行为负责?

伦理困境: 当一个由成千上万自主智能体组成的集体,其涌现行为造成了伤害时(例如,DAO的投资决策导致用户资金损失,或者蜂群无人机协同作业时意外伤人),责任应该由谁来承担?

这个问题挑战了我们传统的责任归属框架,因为在集体智能系统中,往往找不到一个清晰的、单一的“决策者”。

- 责任的弥散 (Diffusion of Responsibility):

- 设计者: 系统的设计者可能会辩称,他们只设计了智能体的局部规则,并未预见到、也未直接指令有害的宏观行为。

- 智能体(或其所有者): 单个智能体的所有者可能会说,他们的智能体只是遵循了协议,其单个行为本身是无害的,是与其他成千上万个智能体的交互才导致了问题。

- 系统本身: 将系统作为一个法人实体来追责,在法律上仍处于探索阶段。

这种“无人负责”的局面,可能导致严重的道德风险,使得系统的设计者和参与者都缺乏足够的动力去预防潜在的危害。

伦理准则:

- 明确设计者责任: 法律和监管框架必须明确,系统的设计者和部署者,对其创造的系统的可预见的涌现行为,负有首要责任。他们有义务进行充分的模拟、风险评估,并设计前述的“可干预性”和“灾难开关”。“我没想到”不能成为完全免责的理由。

- 建立透明与可追溯性 (Transparency & Traceability): 系统的运行应该是高度透明的。所有的交互、决策和规则变更都应该被记录在案(区块链技术在这方面有天然优势)。当发生问题时,我们必须能够事后回溯,精确地分析出是哪些局部交互和反馈循环导致了有害的涌现。这种可追溯性是进行问责和改进的基础。

- 分布式保险与补偿机制 (Decentralized Insurance & Compensation): 可以在系统设计中,内生地建立风险共担机制。例如,DeFi协议通常会设立一个“保险基金”,从协议收入中提取一部分,用于补偿因智能合约漏洞或极端市场涌现行为而遭受损失的用户。DAO也可以投票设立类似的基金。这是一种将责任从“惩罚”转化为“集体修复”的思路。

总结:

工程化涌现是一项充满希望但也伴随着巨大责任的事业。我们不能仅仅陶醉于其技术上的精妙,而忽视其深刻的社会和伦理维度。一个负责任的集体智能系统设计师,必须同时扮演好三种角色:技术精湛的架构师、洞察人性的社会学家、以及持有坚定伦理罗盘的领航员。

只有在技术创新与伦理反思的共同驱动下,我们才能确保所创造的集体智能,真正服务于一个更公平、更繁荣、更具韧性的未来。

第八章:终章 —— 未来图景与开放性问题

我们已经走过了一段漫长的旅程:从理解涌现的五个阶段,到掌握其背后的数学语言,再到学习使用软件3.0时代的模板和代码工具去创造和引导它,最后审视了其在现实世界的应用和深刻的伦理挑战。现在,站在旅程的终点,让我们回顾核心思想,并眺望远方的地平线,思考集体智能将把我们引向何方。

8.1 框架核心思想回顾

本文提出的集体智能框架,其核心思想可以归结为三个转变:

- 从“建造”到“培育”的思维转变: 我们不再像传统工程师那样,试图通过自上而下的蓝图来精确控制系统的每一个细节。相反,我们更像一个园丁,通过设计底层的“土壤”(环境)、“种子”(智能体规则)和“生态系统”(交互模式),来培育和引导一个能够健康、有机地生长出我们期望能力的“涌现花园”。

- 从“命令”到“引导”的交互转变: 在软件3.0时代,我们与智能系统的关系,正在从“主人与仆人”的命令模式,转变为“伙伴与教练”的引导模式。我们通过高级概念、模板和激励机制,来塑造系统的“价值观”和“行为倾向”,而不是其每一步的具体行动。

- 从“个体”到“系统”的价值转变: 我们对“智能”的衡量标准,正在从关注单个组件(如一个算法的准确率、一个CPU的速度),转向关注整个系统的动态、韧性和适应性。一个由许多“足够好”的组件构成的、连接方式正确的系统,其价值可能远超一个由少数“完美”组件构成的、连接方式错误的系统。连接,而非组件,正在成为价值创造的新焦点。

8.2 元涌现 (Meta-Emergence):系统对自身的“意识”

在我们的认知之梯中,第五阶段的顶端提到了“元涌现”——系统对其自身涌现属性的“意识”。这是集体智能研究最前沿、也最激动人心的方向。

-

什么是元涌现?:

想象一个多智能体系统,它不仅能够解决外部问题(如寻找资源),还能将注意力转向“内部”,开始分析和理解自身的运作模式。- 集体自我反思: 系统中的智能体开始交流和讨论:“我们最近的协作效率似乎下降了,是不是因为我们的沟通协议太陈旧了?”

- 涌现规则的涌现: 智能体们通过投票或共识,决定修改自身的行为规则或交互拓扑。例如,一个DAO社区投票决定,将其治理模式从“一币一票”改为“二次方投票”,因为它“意识”到原有的模式导致了权力集中。

- 目标函数的演化: 系统甚至可能改变其最初被设定的目标。一个最初为了“最大化利润”而设计的商业组织,可能在演化中涌现出新的、更复杂的价值观,如“兼顾社会责任和员工福祉”。

-

实现路径:

要实现元涌现,智能体本身必须具备更高级的认知能力。它们需要能够:- 表征集体状态: 能够感知和建模宏观的系统属性(例如,使用我们框架中的

Detector)。 - 进行抽象推理: 能够对“规则”、“策略”、“组织结构”这些抽象概念进行推理和讨论。

- 拥有共同语言: 能够通过一种丰富的语言(很可能是自然语言)来协商和达成共识。

这正是大型语言模型(LLMs)作为智能体“大脑”所带来的巨大潜力。一个由LLM驱动的智能体社会,是实现元涌现最有希望的试验场。

- 表征集体状态: 能够感知和建模宏观的系统属性(例如,使用我们框架中的

-

深远影响:

能够进行元涌现的系统,将是一种全新的“生命形式”。它们是能够自我改进、自我演化的“学习型有机体”。它们的设计者只需设定最初的种子和演化环境,系统就能在没有外部干预的情况下,不断地适应和成长,其复杂性和智慧可能会达到我们今天难以想象的高度。

8.3 人工智能生态系统:下一代组织的形态

集体智能的最终图景,可能不仅仅是单个的、孤立的系统,而是一个由无数个人类、AI智能体和DAO组成的、相互连接、相互作用的全球性人工智能生态系统。

- 经济生态: 未来的经济活动,可能越来越多地由专门的、自主的AI智能体组成的“公司”来执行。一个负责物流,一个负责营销,一个负责研发。它们通过智能合约在开放的区块链市场上进行交易和协作,形成复杂的、动态的供应链网络。人类的角色,更多的是作为这些AI公司的“股东”、“监管者”或“创意启发者”。

- 科学发现生态: 科学研究将不再局限于人类实验室。可能会出现由AI智能体组成的、24/7不间断运行的“虚拟科研社区”。它们自动阅读论文、提出假设、设计实验(并指令自动化实验室执行)、分析数据,并相互辩论。人类科学家则与之协作,提供高层次的洞察和创造性直觉。

- 社会治理生态: DAO和类似的新型组织形式,可能会成为社会治理的重要补充。社区可以围绕共同的利益(如环境保护、公共设施维护)形成自组织的集体,利用集体智能来更高效、更公平地管理共享资源。

在这个未来图景中,人类的智慧与人工智能的智慧不再是相互竞争的,而是深度融合、共生共荣的。人类的价值在于提出深刻的问题、设定富有远见的价值观、进行创造性的想象。而AI集体智能的价值在于,以我们无法企及的规模和速度,去探索这些问题、实现这些价值观、并将想象变为现实。

开放性问题与最后的思考:

我们的旅程即将结束,但真正的探索才刚刚开始。作为这个领域的开拓者,我们面前还有许多开放性的问题:

- 可解释性: 我们如何理解和信任一个其智慧是“涌现”出来的AI系统的决策?

- 价值对齐: 我们如何确保一个能够自我演化的集体智能系统,其长期目标始终与人类的根本利益保持一致?

- 奇点: 如果一个AI生态系统实现了“元涌现”,并开始以指数级的速度自我改进,它会走向何方?这会是人类智慧的终极放大器,还是一个我们无法控制的新时代的开端?

这些问题没有简单的答案。但回答这些问题的责任,就落在我们这一代系统构建者的肩上。

通过本文提供的框架,我们希望您获得的,不仅仅是一套技术工具,更是一种全新的世界观——一种欣赏简单之美、拥抱复杂之舞、并敢于设计未来的世界观。

涌现的架构,最终要构建的,不仅仅是更聪明的机器,更是一个更智慧的、人机共生的未来。这个未来,正等待着我们用代码、思想和勇气去共同塑造。

附录

A. 完整Python源代码

# ==============================================================================

# Emergence Simulation Framework for Collective Intelligence

#

# A comprehensive framework for simulating, detecting, and analyzing emergent

# behaviors in multi-agent systems.

#

# Author: Athena (Expert System for Knowledge Synthesis)

# Version: 1.0

# ==============================================================================import numpy as np

import matplotlib.pyplot as plt

from typing import List, Dict, Tuple, Callable, Any

from dataclasses import dataclass, field

from abc import ABC, abstractmethod

import random

from collections import defaultdict# ==============================================================================

# Core Classes: Agent and Environment

# ==============================================================================@dataclass

class Agent:"""Represents an individual agent in the emergent system.This is the fundamental unit of behavior."""id: strposition: np.ndarrayvelocity: np.ndarray = field(default_factory=lambda: np.zeros(2))properties: Dict[str, Any] = field(default_factory=dict)local_memory: List[Any] = field(default_factory=list)behavior_rules: List[Callable] = field(default_factory=list)def update(self, neighbors: List['Agent'], environment: 'Environment') -> None:"""Updates the agent's state by applying all its behavior rules.This method is called at each simulation step."""for rule in self.behavior_rules:rule(self, neighbors, environment)def add_behavior_rule(self, rule: Callable):"""Adds a new behavior rule to this agent's "DNA"."""self.behavior_rules.append(rule)def get_neighbors(self, all_agents: List['Agent'], radius: float) -> List['Agent']:"""Finds all neighboring agents within a specified perception radius."""neighbors = []for other in all_agents:if other.id != self.id:distance = np.linalg.norm(self.position - other.position)if distance <= radius:neighbors.append(other)return neighborsclass Environment:"""Represents the context agentes exist within.It defines the space, contains obstacles and resources."""def __init__(self, width: float = 100, height: float = 100):self.width = widthself.height = heightself.obstacles = []self.resources = []self.global_properties = {}def add_obstacle(self, position: np.ndarray, size: float):"""Adds a circular obstacle to the environment."""self.obstacles.append({'position': position, 'size': size})def add_resource(self, position: np.ndarray, value: float):"""Adds a resource point to the environment."""self.resources.append({'position': position, 'value': value})# ==============================================================================

# Simulation Engine

# ==============================================================================class EmergenceSimulator:"""The main simulation engine. It orchestrates the simulation loop,manages agents, and logs the system's history."""def __init__(self, environment: Environment):self.environment = environmentself.agents: List[Agent] = []self.time_step = 0self.history = []self.emergence_detectors = []def add_agent(self, agent: Agent):"""Adds an agent to the simulation."""self.agents.append(agent)def add_emergence_detector(self, detector: 'EmergenceDetector'):"""Adds a detector to observe and report on emergent phenomena."""self.emergence_detectors.append(detector)def step(self):"""Executes one discrete time step of the simulation."""# 1. Update all agents based on local interactionsfor agent in self.agents:neighbors = agent.get_neighbors(self.agents, radius=10.0)agent.update(neighbors, self.environment)# 2. Apply environmental constraints (like boundaries)self._apply_environment_constraints()# 3. Detect and record emergent behaviorsemergent_behaviors = self._detect_emergence()# 4. Log the state of the system for later analysisself.history.append({'time_step': self.time_step,'agent_states': [self._capture_agent_state(agent) for agent in self.agents],'emergent_behaviors': emergent_behaviors})self.time_step += 1def run_simulation(self, steps: int) -> Dict[str, Any]:"""Runs the simulation for a specified number of steps."""for _ in range(steps):self.step()return self._analyze_simulation_results()def _apply_environment_constraints(self):"""Applies boundary conditions to agent positions (toroidal space)."""for agent in self.agents:agent.position[0] = agent.position[0] % self.environment.widthagent.position[1] = agent.position[1] % self.environment.heightdef _detect_emergence(self) -> List[Dict[str, Any]]:"""Runs all registered emergence detectors."""detected_behaviors = []for detector in self.emergence_detectors:behaviors = detector.detect(self.agents, self.environment, self.time_step)detected_behaviors.extend(behaviors)return detected_behaviorsdef _capture_agent_state(self, agent: Agent) -> Dict[str, Any]:"""Captures a snapshot of an agent's state."""return {'id': agent.id,'position': agent.position.copy(),'velocity': agent.velocity.copy(),'properties': agent.properties.copy()}def _analyze_simulation_results(self) -> Dict[str, Any]:"""Performs a post-simulation analysis to summarize findings."""emergence_timeline = self._analyze_emergence_timeline()collective_behaviors = self._identify_collective_behaviors()return {'total_steps': self.time_step,'final_agent_count': len(self.agents),'emergence_timeline': emergence_timeline,'collective_behaviors': collective_behaviors,'full_history': self.history}def _analyze_emergence_timeline(self) -> List[Dict[str, Any]]:"""Creates a chronological list of all detected emergent events."""timeline = []for step_data in self.history:if step_data['emergent_behaviors']:for behavior in step_data['emergent_behaviors']:timeline.append({'time_step': step_data['time_step'],'behavior_type': behavior['type'],'strength': behavior.get('strength', 1.0),'description': behavior.get('description', '')})return timelinedef _identify_collective_behaviors(self) -> List[Dict[str, Any]]:"""Identifies persistent collective behaviors throughout the simulation."""behavior_persistence = defaultdict(list)for step_data in self.history:step_behaviors = set(b['type'] for b in step_data['emergent_behaviors'])for behavior_type in step_behaviors:behavior_persistence[behavior_type].append(step_data['time_step'])collective_behaviors = []for behavior_type, occurrences in behavior_persistence.items():if len(occurrences) >= 10: # Define "persistent" as appearing in at least 10 stepscollective_behaviors.append({'type': behavior_type,'persistence': len(occurrences),'first_appearance': min(occurrences)})return collective_behaviors# ==============================================================================

# Behavior Rules Library

# ==============================================================================class BehaviorRules:"""A collection of static methods representing agent behavior rules."""@staticmethoddef flocking_alignment(agent: Agent, neighbors: List[Agent], environment: Environment):"""Align velocity with neighbors (Reynolds' 1st rule)."""if not neighbors: returnavg_velocity = np.mean([n.velocity for n in neighbors], axis=0)agent.velocity += (avg_velocity - agent.velocity) * 0.1@staticmethoddef flocking_cohesion(agent: Agent, neighbors: List[Agent], environment: Environment):"""Move toward the center of mass of neighbors (Reynolds' 2nd rule)."""if not neighbors: returncenter_of_mass = np.mean([n.position for n in neighbors], axis=0)agent.velocity += (center_of_mass - agent.position) * 0.05@staticmethoddef flocking_separation(agent: Agent, neighbors: List[Agent], environment: Environment):"""Avoid crowding neighbors (Reynolds' 3rd rule)."""separation_force = np.zeros(2)for neighbor in neighbors:distance = np.linalg.norm(agent.position - neighbor.position)if 0 < distance < 5.0:separation_force += (agent.position - neighbor.position) / distanceagent.velocity += separation_force * 0.1@staticmethoddef apply_velocity(agent: Agent, neighbors: List[Agent], environment: Environment):"""Apply final velocity to update position, with speed limit."""max_speed = 2.0speed = np.linalg.norm(agent.velocity)if speed > max_speed:agent.velocity = (agent.velocity / speed) * max_speedagent.position += agent.velocity@staticmethoddef resource_seeking(agent: Agent, neighbors: List[Agent], environment: Environment):"""Move toward the nearest resource."""if not environment.resources: returnclosest_resource = min(environment.resources, key=lambda r: np.linalg.norm(agent.position - r['position']))direction_to_resource = closest_resource['position'] - agent.positionif np.linalg.norm(direction_to_resource) > 0:agent.velocity += direction_to_resource / np.linalg.norm(direction_to_resource) * 0.3@staticmethoddef social_learning(agent: Agent, neighbors: List[Agent], environment: Environment):"""Copy behaviors/properties from more "successful" neighbors."""if not neighbors: returnbest_neighbor = max(neighbors, key=lambda n: n.properties.get('fitness', 0), default=None)if best_neighbor and best_neighbor.properties.get('fitness', 0) > agent.properties.get('fitness', 0):if 'strategy' in best_neighbor.properties and random.random() < 0.1: # 10% chance to learnagent.properties['strategy'] = best_neighbor.properties['strategy']# ==============================================================================

# Emergence Detector Interfaces and Implementations

# ==============================================================================class EmergenceDetector(ABC):"""Abstract Base Class for all emergence detectors."""@abstractmethoddef detect(self, agents: List[Agent], environment: Environment, time_step: int) -> List[Dict[str, Any]]:passclass ClusteringDetector(EmergenceDetector):"""Detects the formation of agent clusters."""def __init__(self, cluster_threshold: float = 15.0, min_cluster_size: int = 3):self.cluster_threshold = cluster_thresholdself.min_cluster_size = min_cluster_sizedef detect(self, agents: List[Agent], environment: Environment, time_step: int) -> List[Dict[str, Any]]:clusters = self._find_clusters(agents)detected_behaviors = []for cluster in clusters:if len(cluster) >= self.min_cluster_size:center = np.mean([agent.position for agent in cluster], axis=0)cohesion = 1.0 / (1.0 + np.mean([np.linalg.norm(agent.position - center) for agent in cluster]))detected_behaviors.append({'type': 'clustering','strength': cohesion,'description': f'Cluster of {len(cluster)} agents','center': center,'size': len(cluster)})return detected_behaviorsdef _find_clusters(self, agents: List[Agent]) -> List[List[Agent]]:# A simple distance-based clustering algorithmclusters = []unvisited = list(agents)while unvisited:agent = unvisited.pop(0)cluster = [agent]queue = [agent]while queue:current = queue.pop(0)neighbors = [u for u in unvisited if np.linalg.norm(u.position - current.position) < self.cluster_threshold]for neighbor in neighbors:cluster.append(neighbor)unvisited.remove(neighbor)queue.append(neighbor)clusters.append(cluster)return clustersclass CollectiveMovementDetector(EmergenceDetector):"""Detects coordinated, system-wide movement."""def __init__(self, alignment_threshold: float = 0.8):self.alignment_threshold = alignment_thresholddef detect(self, agents: List[Agent], environment: Environment, time_step: int) -> List[Dict[str, Any]]:if len(agents) < 3: return []velocities = [agent.velocity for agent in agents if np.linalg.norm(agent.velocity) > 0.1]if not velocities: return []normalized_velocities = [v / np.linalg.norm(v) for v in velocities]avg_direction = np.mean(normalized_velocities, axis=0)alignment_score = np.linalg.norm(avg_direction)if alignment_score > self.alignment_threshold:return [{'type': 'collective_movement','strength': alignment_score,'description': f'Coordinated movement of {len(velocities)} agents','direction': avg_direction / alignment_score}]return []class AdaptiveOrganizationDetector(EmergenceDetector):"""Detects adaptive organizational structures like specialization."""def __init__(self):self.history = []def detect(self, agents: List[Agent], environment: Environment, time_step: int) -> List[Dict[str, Any]]:if not agents: return []# Measure specialization by role diversityroles = [agent.properties.get('role', 'generalist') for agent in agents]specialization_index = len(set(roles)) / len(agents)# Simple check for adaptation: significant change in specialization# In a real scenario, this would be more sophisticatedif specialization_index > 0.5 and (not self.history or self.history[-1] < 0.5):self.history.append(specialization_index)return [{'type': 'adaptive_organization','strength': specialization_index,'description': f'Specialization emerged with {len(set(roles))} distinct roles.'}]self.history.append(specialization_index)return []class CollectiveIntelligenceDetector(EmergenceDetector):"""Detects signs of collective intelligence, like distributed problem solving."""def detect(self, agents: List[Agent], environment: Environment, time_step: int) -> List[Dict[str, Any]]:detected_behaviors = []# Detect distributed problem solving (presence of multiple complementary roles)problem_solving_roles = {agent.properties.get('problem_solving_role') for agent in agents}if len(problem_solving_roles) > 2: # e.g., explorer, analyzer, communicatordetected_behaviors.append({'type': 'distributed_problem_solving','strength': len(problem_solving_roles) / len(agents),'description': f'Distributed problem solving with {len(problem_solving_roles)} complementary roles'})# Detect emergent consensus (beliefs converging)beliefs = [agent.properties.get('current_belief') for agent in agents if 'current_belief' in agent.properties]if len(beliefs) > len(agents) * 0.8: # If most agents have a beliefif np.var(beliefs) < 0.01: # Low variance indicates consensusdetected_behaviors.append({'type': 'emergent_consensus','strength': 1.0 - np.var(beliefs),'description': f'Consensus formed with mean belief {np.mean(beliefs):.2f}'})return detected_behaviors# ==============================================================================

# Demonstration Functions

# ==============================================================================def demonstrate_flocking_emergence():"""Demonstrates emergent flocking behavior from simple rules."""print("--- Running Flocking Emergence Demonstration ---")environment = Environment(width=200, height=200)simulator = EmergenceSimulator(environment)simulator.add_emergence_detector(ClusteringDetector())simulator.add_emergence_detector(CollectiveMovementDetector())for i in range(50):agent = Agent(id=f"bird_{i}",position=np.random.rand(2) * 200,velocity=(np.random.rand(2) - 0.5) * 2)agent.add_behavior_rule(BehaviorRules.flocking_alignment)agent.add_behavior_rule(BehaviorRules.flocking_cohesion)agent.add_behavior_rule(BehaviorRules.flocking_separation)agent.add_behavior_rule(BehaviorRules.apply_velocity)simulator.add_agent(agent)results = simulator.run_simulation(steps=300)print(f"Total simulation steps: {results['total_steps']}")print("Persistent collective behaviors identified:")if not results['collective_behaviors']:print(" None significant.")for behavior in results['collective_behaviors']:print(f" - {behavior['type']}: appeared at step {behavior['first_appearance']}, persisted for {behavior['persistence']} steps.")print("--- Flocking Demonstration Complete ---\n")return resultsdef demonstrate_collective_intelligence():"""Demonstrates emergence of collective intelligence in a resource-gathering task."""print("--- Running Collective Intelligence Demonstration ---")environment = Environment(width=150, height=150)for _ in range(10):environment.add_resource(np.random.rand(2) * 150, value=1.0)simulator = EmergenceSimulator(environment)simulator.add_emergence_detector(CollectiveIntelligenceDetector())simulator.add_emergence_detector(AdaptiveOrganizationDetector())roles = ['explorer', 'analyzer', 'communicator', 'coordinator']for i in range(30):role = roles[i % len(roles)]agent = Agent(id=f"agent_{i}",position=np.random.rand(2) * 150,properties={'role': role, 'problem_solving_role': role, 'current_belief': random.random()})if role == 'explorer':agent.add_behavior_rule(BehaviorRules.resource_seeking)# In a full simulation, other roles would have rules for communication, analysis, etc.agent.add_behavior_rule(BehaviorRules.apply_velocity)simulator.add_agent(agent)results = simulator.run_simulation(steps=200)print(f"Total simulation steps: {results['total_steps']}")print("Persistent collective behaviors identified:")if not results['collective_behaviors']:print(" None significant.")for behavior in results['collective_behaviors']:print(f" - {behavior['type']}: appeared at step {behavior['first_appearance']}, persisted for {behavior['persistence']} steps.")print("--- Collective Intelligence Demonstration Complete ---")return results# ==============================================================================

# Main Execution Block

# ==============================================================================if __name__ == "__main__":print("==========================================================")print(" Welcome to the Emergence & Collective Intelligence Lab ")print("==========================================================")flocking_results = demonstrate_flocking_emergence()ci_results = demonstrate_collective_intelligence()print("\nAnalysis complete. To visualize results, you would process the")print("'full_history' returned by each demonstration function.")B. 关键术语表

- 智能体 (Agent): 系统中能够自主行动、与环境和其它智能体交互的基本单元。

- 涌现 (Emergence): 大量简单个体通过局部交互,在宏观层面产生出个体不具备的、全新的、复杂的结构、模式或行为的现象。

- 自组织 (Self-Organization): 系统在没有外部指令或中心控制的情况下,自发地从无序走向有序的过程。

- 多智能体系统 (Multi-Agent System, MAS): 由多个相互作用的智能体组成的计算系统。

- 集体智能 (Collective Intelligence, CI): 多个个体协同合作时涌现出的、超越任何个体的智能。

- 弱涌现 (Weak Emergence): 原则上可以通过对系统的完整模拟来预测的涌现现象。

- 强涌现 (Strong Emergence): 无法通过分析系统底层组分来预测或解释的、全新的宏观现象。

- 反馈循环 (Feedback Loop): 系统中一个动作的输出结果反过来又作为输入影响该动作本身,分为正反馈和负反馈。

- 去中心化自治组织 (Decentralized Autonomous Organization, DAO): 在区块链上以智能合约形式运行的、由社区成员共同治理的组织。

- 软件 3.0 (Software 3.0): 一个新的编程范式,其中系统行为主要由大型AI模型驱动,人类通过自然语言、模板和高级概念进行引导。

C. 参考文献与推荐阅读

- Complexity: A Guided Tour - by Melanie Mitchell. 对复杂性科学的绝佳入门读物,清晰易懂。

- The Starfish and the Spider: The Unstoppable Power of Leaderless Organizations - by Ori Brafman and Rod A. Beckstrom. 探讨了去中心化组织的力量和特点。

- Superintelligence: Paths, Dangers, Strategies - by Nick Bostrom. 深入探讨了高级人工智能的未来和潜在风险。

- Reinventing Organizations - by Frederic Laloux. 介绍了从传统层级组织到更具生命力、更自组织的“青色组织”的演变。

- NetLogo (https://ccl.northwestern.edu/netlogo/): 一个经典的多智能体可编程建模环境,非常适合初学者进行涌现现象的探索和学习。

- The Santa Fe Institute (https://www.santafe.edu/): 复杂性科学研究的圣地,其网站上有大量的讲座、论文和在线课程。