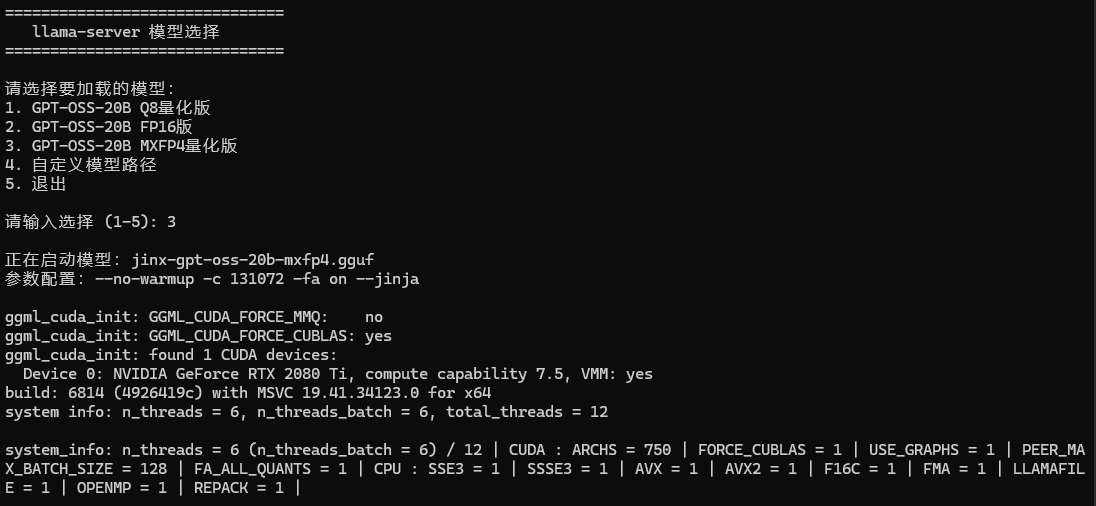

llama.cpp批处理选择不同模型启动

.bat文件用 ansi编码

@echo off

rem chcp 65001 >nul

setlocal EnableDelayedExpansiontitle llama-server 模型选择:menu

cls

echo ===============================

echo llama-server 模型选择

echo ===============================

echo.

echo 请选择要加载的模型:

echo 1. GPT-OSS-20B Q8量化版

echo 2. GPT-OSS-20B FP16版

echo 3. GPT-OSS-20B MXFP4量化版

echo 4. 自定义模型路径

echo 5. 退出

echo.set /p "choice=请输入选择 (1-5): "rem ---------- 选项判断 ----------

if "%choice%"=="1" (set "MODEL_PATH=jinx-gpt-oss-20b-Q8_0.gguf"goto launch

) else if "%choice%"=="2" (set "MODEL_PATH=gpt-oss-20b-F16.gguf"goto launch

) else if "%choice%"=="3" (set "MODEL_PATH=jinx-gpt-oss-20b-mxfp4.gguf"goto launch

) else if "%choice%"=="4" (set /p "MODEL_PATH=请输入模型文件完整路径: "if not exist "!MODEL_PATH!" (echo 错误:模型文件不存在!pausegoto menu)goto launch

) else if "%choice%"=="5" (goto :eof REM 只结束批处理,不关闭整个 CMD

) else (echo 无效选择,请重新输入!pausegoto menu

):launch

echo.

echo 正在启动模型:!MODEL_PATH!

echo 参数配置:--no-warmup -c 131072 -fa on --jinja

echo.rem 如果你想让服务器在后台运行,可以改成 start "" … 下面的方式会在当前窗口等待服务器结束

llama-server -m "c:\llama\!MODEL_PATH!" --no-warmup -c 131072 -fa on --jinjarem ---------- 错误处理 ----------

if errorlevel 1 (echo.echo llama-server 启动失败!echo 请检查:echo 1. 模型文件是否存在echo 2. 显存是否足够echo 3. 参数配置是否正确pause

) else (echo llama-server 已成功启动。pause

)endlocal