【AI论文】UniVideo:面向视频的统一理解、生成与编辑

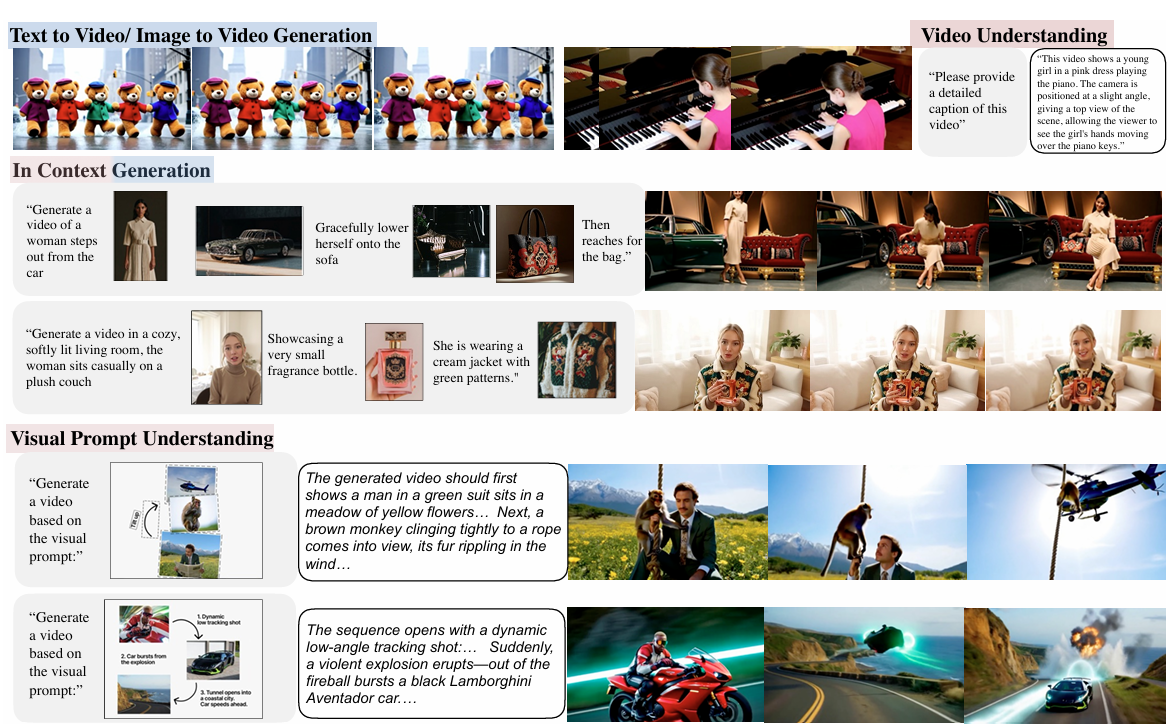

摘要:统一多模态模型在多模态内容生成与编辑方面已展现出令人瞩目的成果,但目前仍主要局限于图像领域。在本研究中,我们提出了UniVideo这一通用框架,将统一建模拓展至视频领域。UniVideo采用双流设计,结合了用于指令理解的多模态大语言模型(Multimodal Large Language Model, MLLM)与用于视频生成的多模态扩散变换器(Multimodal DiT, MMDiT)。这种设计能够准确解析复杂的多模态指令,同时保持视觉一致性。基于这一架构,UniVideo将多样化的视频生成与编辑任务统一在一个多模态指令范式下,并进行联合训练。大量实验表明,在文本/图像到视频的生成、情境视频生成及情境视频编辑任务中,UniVideo的表现达到或超越了当前最先进的特定任务基线模型。值得注意的是,UniVideo的统一设计实现了两种形式的泛化能力。首先,UniVideo支持任务组合,例如通过单条指令融合编辑与风格迁移等多种功能。其次,即使未针对自由形式视频编辑进行显式训练,UniVideo也能将其编辑能力从大规模图像编辑数据迁移至该场景,处理诸如视频人物绿幕抠像或更换视频内材质等未见过的指令。除这些核心能力外,UniVideo还支持基于视觉提示的视频生成,其中MLLM解析视觉提示并在合成过程中引导MMDiT。为推动未来研究,我们将公开模型与代码。Huggingface链接:Paper page,论文链接:2510.08377

研究背景和目的

研究背景:

随着人工智能技术的快速发展,多模态内容生成与编辑在图像、视频等领域展现出巨大的应用潜力。

然而,现有的统一多模态模型主要集中于图像领域,在视频领域的应用仍相对有限。视频数据不仅包含丰富的视觉信息,还涉及时间维度的动态变化,这为多模态模型的设计与训练带来了巨大挑战。传统方法通常针对单一任务设计,难以扩展至多样化的视频生成与编辑任务,且缺乏对复杂多模态指令的理解能力。此外,视频编辑任务通常需要任务特定的模块或流水线,难以跨任务扩展。因此,开发一个能够统一理解、生成和编辑视频的多模态模型成为当前研究的重要方向。

研究目的:

本研究旨在提出一个名为UniVideo的统一多模态视频生成与编辑框架,该框架能够:

- 统一多模态指令理解:通过结合多模态大语言模型(MLLM)和多模态扩散变换器(MMDiT),实现对复杂多模态指令的准确理解。

- 统一视频生成与编辑:在单一多模态指令范式下,统一多种视频生成与编辑任务,实现跨任务联合训练。

- 支持任务组合与泛化:支持编辑与风格迁移等任务的组合,并能将图像编辑能力迁移到视频编辑中,处理未见过的指令。

- 发布模型与代码:通过发布模型和代码,促进未来研究的发展,推动多模态视频生成与编辑技术的进步。

研究方法

1. 模型架构设计:

UniVideo采用双流设计,包括一个用于指令理解的多模态大语言模型(MLLM)和一个用于视频生成的多模态扩散变换器(MMDiT)。

MLLM负责处理文本、图像和视频输入,生成文本响应;MMDiT则结合MLLM的高级语义信息和VAE的细粒度重建信号,实现高质量的视频生成。具体实现中,采用qwen2.5VL-7B作为MLLM骨干网络,HunyuanVideo-T2V-13B作为MMDiT骨干网络,并通过MLP连接器对齐两者之间的特征维度。

2. 多任务统一训练:

UniVideo在广泛的视频生成与编辑任务上进行联合训练,包括文本到图像、文本到视频、图像到视频、上下文视频生成、上下文视频编辑和图像编辑等任务。

通过标准化多模态指令,为每个视觉输入分配ID标签,实现跨任务指令的统一处理。同时,采用3D位置嵌入保留帧间的空间索引,帮助MMDiT区分条件潜变量和噪声视频潜变量。

3. 分阶段训练策略:

UniVideo的训练分为三个阶段:

- 第一阶段:连接器对齐:仅训练MLP连接器,保持MLLM和MMDiT冻结,使用大规模预训练样本进行训练。

- 第二阶段:MMDiT微调:保持MLLM冻结,微调连接器和MMDiT,使用高质量样本提升性能。

- 第三阶段:多任务训练:扩展训练任务,包括上下文生成、上下文视频编辑、图像编辑和图像到视频等任务,进一步提升模型的泛化能力。

研究结果

1. 视觉理解与生成能力:

UniVideo在视觉理解任务上表现出色,在MMBench、MMMU和MM-Vet等基准测试上取得了竞争性的分数。同时,在视频生成任务上,UniVideo支持从文本和图像生成高质量视频,并在VBench基准测试上展示了强大的生成能力。

2. 上下文视频生成与编辑:

在上下文视频生成任务中,UniVideo在单ID和多ID设置下均展现了优越的性能,特别是在主体一致性和提示跟随方面表现突出。

在上下文视频编辑任务中,UniVideo无需掩码即可准确跟随指令,同时保持参考图像的身份一致性,性能优于或相当于最先进的任务特定模型。

3. 零样本泛化能力:

UniVideo展示了强大的零样本泛化能力,能够将图像编辑能力迁移到视频编辑中,处理未见过的指令,如绿幕人物替换或视频内材料更改等。

此外,UniVideo还能泛化到新颖的任务组合,如同时进行删除和替换操作,尽管在训练过程中并未明确训练此类组合。

4. 视觉提示理解:

UniVideo支持基于视觉提示的视频生成,能够理解用户绘制的参考图像和故事板,生成相应的视频内容。同时,UniVideo还能处理直接在输入图像上绘制的注释,将其视为图像到视频任务,展示了对复杂多模态指令的强大理解能力。

研究局限

1. 训练数据限制:

尽管UniVideo在多个任务上展示了出色的性能,但其训练数据并未包含一般自由形式的视频编辑任务。

因此,UniVideo在某些复杂视频编辑指令上的表现可能受到限制。未来研究需要探索如何收集和利用更多样化的视频编辑数据,以进一步提升模型的泛化能力。

2. 模型复杂度与效率:

尽管UniVideo通过双流设计和分阶段训练策略提升了模型的性能,但其复杂度仍然较高,特别是在处理长视频时。

未来研究需要探索如何进一步优化模型结构,降低计算复杂度,提升推理效率。

3. 多模态指令的复杂性:

尽管UniVideo能够处理复杂的多模态指令,但在某些极端复杂或模糊的指令下,模型的表现仍可能受限。未来研究需要探索如何提升模型对复杂指令的理解能力,例如通过引入更先进的自然语言处理技术或强化学习算法。

未来研究方向

1. 探索更广泛的多模态任务:

未来研究可以探索将UniVideo框架扩展至更多多模态任务,如音频生成、三维场景重建等,进一步提升模型的通用性和实用性。

2. 优化模型结构与训练策略:

针对模型复杂度和效率问题,未来研究可以探索更轻量级的模型结构和更高效的训练策略,如知识蒸馏、量化等,以降低模型的计算成本和推理延迟。

3. 增强多模态指令理解能力:

为了提升模型对复杂多模态指令的理解能力,未来研究可以探索引入更先进的自然语言处理技术,如预训练语言模型、知识图谱等,以增强模型对指令的解析和执行能力。

4. 推动实际应用与落地:

最终,未来研究需要关注如何将UniVideo框架应用于实际场景中,如虚拟现实、增强现实、智能设计等领域,通过实际应用验证技术的有效性和实用性,并收集用户反馈以进一步优化模型性能。