具身智能论文阅读:Nav-R1: Reasoning and Navigation in Embodied Scenes

摘要

具身导航要求智能体在复杂的三维环境中整合感知、推理和动作,以实现稳健的交互。现有方法通常存在推理痕迹不连贯且不稳定的问题,这限制了其在多样化环境中的泛化能力,同时也难以在实时导航中平衡长时域语义推理与低延迟控制。为了解决这些挑战,我们提出了 Nav-R1,一种统一具身环境推理的具身基础模型。我们首先构建了 Nav-CoT-110K,一个大规模具身任务逐步思维链(Chains-of-Thought, CoT)数据集,使结构化推理能够实现冷启动初始化。在此基础上,我们设计了一个基于 GRPO 的强化学习框架,包含三种互补奖励:格式奖励、理解奖励和导航奖励,以提升结构遵循性、语义落地性和路径保真度。此外,我们引入了 Fast-in-Slow 推理范式,将深思熟虑的语义推理与低延迟的反应控制解耦,实现高效而连贯的导航。在具身 AI 基准上的广泛评估表明,Nav-R1 在推理和导航性能上平均提升超过 8%,持续优于强基线。实际部署在移动机器人上的实验进一步验证了其在有限板载资源下的鲁棒性。

代码:https://github.com/AIGeeksGroup/Nav-R1

网站:https://aigeeksgroup.github.io/Nav-R1

I NTRODUCTION

具身场景理解是具身人工智能、机器人技术和智能体中的核心问题,要求智能体在复杂的三维环境中进行感知、推理和行动。对具身导航的稳健理解不仅支持目标导向的任务,如物体搜索、指令跟随和轨迹规划,还使得更高层次的具身交互成为可能,包括对话、推理和决策等。这些能力对于服务机器人、增强现实助手以及部署在现实环境中的智能具身系统至关重要。

近年来,大型视觉语言模型(LVLMs)的进展将二维感知的成功扩展到了三维具身领域,催生了将感知、语言和行动耦合的统一框架。如图1所示,这些进展为解决具身对话、具身推理、具身规划和具身导航等四个具身任务奠定了基础,这也是本文的核心关注点。

尽管取得了这些进展,仍然存在显著的挑战。首先,现有方法常常存在推理轨迹不连贯和不稳定的问题,导致无法与导航指令对齐,从而影响在多样化环境中的泛化能力,并产生语义不一致的输出。其次,具身导航需要平衡长时间跨度的语义推理与低延迟的反应控制,以实现实时执行,这一双重需求在当前方法中尚未得到充分解决。

鉴于这些限制,迫切需要具身基础模型,能够共同解决语义推理和具身行动的问题,而不是将其视为独立的问题。为此,本文旨在开发一个统一的框架,平衡长时间跨度的推理与实时响应控制,从而在多样的三维环境中实现稳健的泛化和可靠的执行。

为克服这些限制,本文提出了Nav-R1,一个将推理、规划、对话和导航整合为统一框架的具身基础模型。具体而言,我们构建了一个大规模数据集Nav-CoT-110K,通过提示强大的视觉语言模型(VLM)以自我中心的观察、指令和行动选项,并通过基于规则的过滤确保一致性,从而合成高质量的具身任务推理链(CoT)。该数据集用于冷启动阶段,为Nav-R1提供结构化的推理和指令对齐。

在此基础上,我们设计了一个基于GRPO的强化学习框架,结合三种互补的奖励机制:(i)格式奖励,确保结构一致性;(ii)理解奖励,捕捉语义正确性和视觉对齐;(iii)导航奖励,优化路径保真度和终点准确性。

为了进一步解决语义准确性与实时控制之间的矛盾,我们提出了一种受认知科学启发的“快进慢出”双重系统推理方案:一个慢模块从视觉历史中聚合长期语义,而一个快模块以低延迟执行短时间跨度的行动,两者异步协调,实现高效而连贯的导航。

以下是您提供的英文论文内容的中文翻译,已按照原文格式进行排版:

我们在具身基准测试上对 Nav-R1 进行了广泛评估。Nav-R1 始终优于先前的最先进方法,在导航成功率和推理准确性方面取得了改进。超越仿真,我们将 Nav-R1 部署在一台配备 Jetson Orin Nano、LiDAR 和 RGB-D 相机的 WHEELTEC R550 移动机器人上,通过设计基于云的推理,展示了在有限机载计算资源下的稳健现实世界性能。这些结果验证了 Nav-R1 在推理能力、语义对齐和具身实时控制方面实现了强大的平衡。

贡献总结

我们的贡献总结如下:

- 我们提出了 Nav-R1,一种具身基础模型,配备基于 GRPO 的强化学习框架,以增强 3D 环境中的推理和导航。具体而言,我们设计了三种互补的奖励函数:格式奖励、理解奖励和导航奖励,以提高结构一致性、语义对齐和路径保真度。此外,我们通过 CoT 数据引擎构建了大规模的 Nav-CoT-110K 数据集,提供高质量的逐步推理轨迹,通过冷启动初始化为模型提供结构化推理。

- 我们提出了一种新颖的“快进慢出”推理范式,将长时间跨度的语义推理与短时间跨度的反应控制解耦。这种双系统设计确保了规划的语义一致性,同时在动态环境中保持低延迟响应。

- 我们在具身 AI 基准测试和现实世界机器人部署上进行了全面评估。Nav-R1 在对话、推理、规划和导航任务上相较于强基线平均提高了 8%,并在配备有限机载资源的物理机器人上进一步展示了稳健的性能。

R ELATED W ORK

具身理解:具身理解旨在通过将多模态传感数据与语言指令紧密集成,使智能体具备在三维环境中感知、推理和行动的能力。早期的研究仅限于二维视觉抽象,缺乏进行复杂三维推理所需的空间表达能力。近期的进展通过使用大型语言模型(LLMs)作为感知、语义对齐和行动规划之间的连接纽带,弥补了这一空白。LEO 便是这一趋势的典型代表,它引入了一种具身通用智能体,分两阶段进行训练——三维视觉-语言对齐和随后的视觉-语言-行动指令微调,从而在无需任务特定子模块的情况下,实现了在图像描述、问答和具身推理等任务中的统一能力。与 LEO 相辅相成,GaussianVLM 采用了一种以场景为中心的范式,将语言特征直接嵌入三维高斯斑点中。其双重稀疏化机制将密集的场景表示精炼为任务感知的标记,避免了外部物体检测器的使用,并实现了在具身推理任务中的零样本泛化。这些研究共同强调了统一架构和语言对齐的三维表示对于稳健的场景理解和面向行动的认知的重要性。

具身导航:具身导航任务要求智能体将多模态指令转化为在非结构化三维场景中的平滑连续运动,主要包括物体目标导航(ObjectNav)和视觉语言导航(VLN)等任务。传统的处理流程依赖于离散的拓扑图,这限制了路径的灵活性。近期的研究则采用了由大型视觉语言模型驱动的端到端范式。VLN-R1 将强化学习微调与时间衰减奖励相结合,使用 GRPO 风格的训练和 VLN-Ego 数据集,缩小了指令与行动之间的差距。Uni-NaVid 进一步将导航子任务——物体搜索、指令跟随等——统一在一个视频条件下的视觉-语言-行动主干中,实现了实时推理轨迹。即将发布的通用智能体 OctoNav 引入了一种混合训练范式,将“行动前思考”的推理链与 GRPO 和在线强化学习相结合,使其能够忠实地执行自由形式的指令并进行连续控制。最近,MTU3D 通过将未探索区域视为统一视觉-语言-探索目标中的前沿查询,架起了视觉对齐与主动探索之间的桥梁;在一百万条轨迹上进行预训练,使其在 HM3D-OVON、GOAT-Bench、SG3D 和 A-EQA 上的成功率提高了 14% 至 23%,同时支持语言、类别和图像目标等多种输入。这些进展共同展示了大型视觉语言模型在融合感知、推理和行动方面日益增长的能力,为适应性具身导航奠定了基础。

DATASETS

我们在公共的 3D 视觉语言数据集和新构建的 Nav-CoT-110K 数据集的基础上构建了我们的框架。表 I 总结了本文所考虑的所有数据集的统计信息,包括场景覆盖范围、任务类型、指令模态和环境设置。

Public Datasets

我们借鉴了多个广泛使用的具身人工智能基准数据集,以确保多样性和可比性。R2R 和其连续扩展版本 R2R-CE 提供了 Matterport3D 场景中的自然语言导航指令。RxR-CE 将这一设置扩展到多语言环境,并具备密集的时间对齐。对于物体目标导航,SOON 引入了在室内环境中基于类别的搜索,而 HM3D-OVON 进一步支持在零样本设置下的开放词汇物体导航。这些基准数据集共同涵盖了离散和连续环境中的指令跟随和物体中心导航任务。

合成数据集

在这些资源的基础上,我们引入了 Nav-CoT-110K,这是一个由 11 万条逐步推理链(Chain-of-Thought,CoT)注释的轨迹组成的大规模数据集。与以往主要提供指令和目标位置的数据集不同,Nav-CoT-110K 明确包含与多模态观察对齐的结构化推理,从而桥接了感知、语言和行动。该数据集作为 Nav-R1 冷启动阶段的基础,使其在强化学习之前获得结构化的推理能力。

T HE P ROPOSED M ETHOD

A. Overview

所提出的 Nav-R1 框架被设计为一个具身基础模型,统一了多模态感知、结构化推理和具身控制。如图 2 所示,Nav-R1 采用“快进慢出”的推理范式,其中慢系统执行长时间跨度的语义推理,而快系统确保低延迟导航。该框架遵循两阶段训练流程:首先使用 CoT 数据引擎构建 Nav-CoT-110K 数据集,提供高质量的逐步推理轨迹。基于该数据集,在冷启动阶段初始化模型的推理能力,随后进行强化学习阶段,通过多维奖励优化语义对齐和导航保真度。

B. CoT Data Engine

我们提出了一个 CoT 数据引擎,旨在为具身导航与推理任务构建高质量的思维链(Chain of Thought, CoT)。该引擎利用视觉-语言模型(Vision-Language Models, VLMs)的推理能力,生成连贯的逐步推理过程,为复杂 3D 环境中的导航决策提供依据。

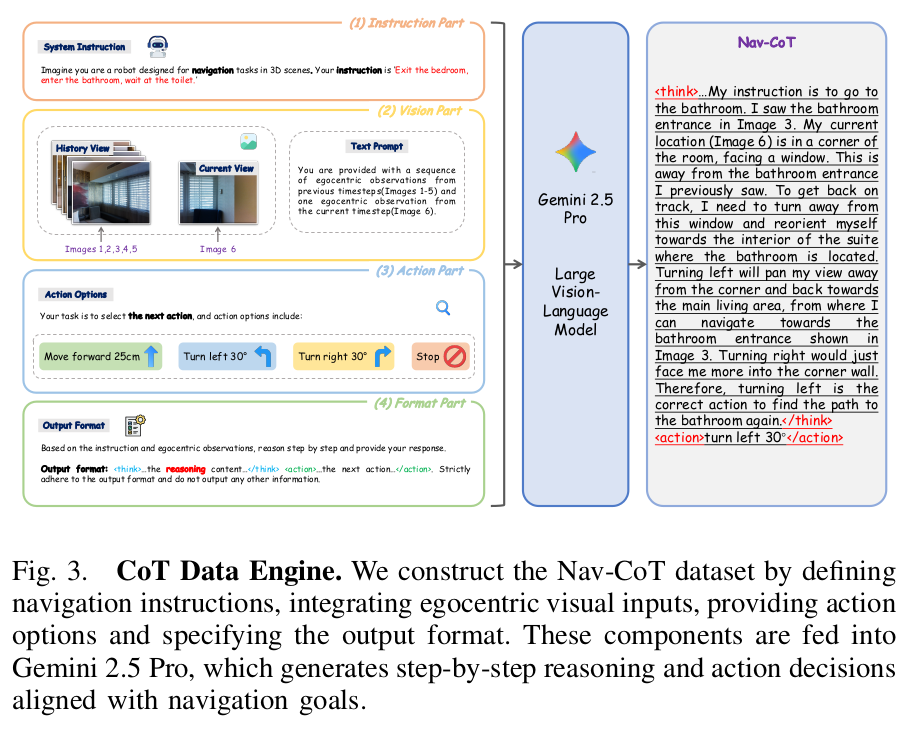

如图 3 所示,该过程从从 3D 场景中提取的自我中心视觉观察(egocentric visual observations)开始,为智能体的视角提供丰富的上下文信息。与此同时,我们结合了来源于标准具身 AI 基准的导航指令——VLN 任务依赖 R2R [4]、R2R-CE [29] 和 RxR-CE [30] 数据集,而 ObjectNav 任务使用来自 SOON [57] 和 OVON [52] 的指令。

为了指导推理,我们设计了一个包含四个关键组成部分的复合提示(composite prompt):(1) 导航指令,(2) 自我中心视觉输入,(3) 每一步可行动作集合,以及 (4) 明确的格式要求。该提示引导 Gemini 2.5 Pro [43] 对空间关系进行推理,环境约束、指令语义,并生成结构化的逐步 CoT 序列。输出遵循标准化格式,其中推理内容被包裹在 <think>...</think> 标签中,所选择的动作则被包裹在 <action>...</action> 标签中,从而确保观察、推理与决策之间的透明对齐。

在各种环境中运行该流水线可生成约 11.5 万个 CoT 示例,每个示例包含场景 ID、导航指令、视觉输入、结构化推理以及对应动作。这些原始输出随后通过两阶段筛选流程进行精炼:(i) 基于规则的检查,用于剔除不完整或逻辑不一致的响应;(ii) 通过将动作与可行导航路径交叉验证进行质量确认。经过精炼后,约 11 万个示例组成了 Nav-CoT-110K 数据集,作为 Nav-R1 的冷启动初始化语料,提供丰富的推理轨迹,紧密结合感知、指令遵循与导航决策。

图 3 CoT 数据引擎。我们通过定义导航指令、整合自我中心视觉输入、提供动作选项并指定输出格式来构建 Nav-CoT 数据集。这些组件被输入到 Gemini 2.5 Pro 中,该模型生成逐步的推理过程和动作决策,并与导航目标保持一致。

图中的流程可以分为四个部分:

- 指令部分(Instruction Part):提供任务背景和导航指令,例如“离开卧室,进入浴室,在厕所等待”。

- 视觉部分(Vision Part):输入历史视图(Images 1-5)与当前视图(Image 6),并配合文本提示(Text Prompt)描述每个时刻的自我中心观察。

- 动作部分(Action Part):提供可选择的动作选项,如“前进 25cm”、“左转 30°”、“右转 30°”和“停止”。

- 格式部分(Format Part):规范输出格式,推理内容使用

<think>...</think>标签包裹,动作使用<action>...</action>标签包裹,确保严格遵循指定格式,不输出其他信息。

通过该流程,Gemini 2.5 Pro 能够生成与导航目标对齐的逐步推理和动作决策示例。

回答中需要给出COT和选择的动作

Cold Start Stage

虽然强化学习在推理密集型模型(如 DeepSeek-R1 [12])中表现出了显著的效果,但直接将强化学习应用于大型三维视觉语言模型往往会导致优化不稳定。尤其是,策略容易生成语义上不连贯的 CoT 序列,或产生与导航指令不匹配的动作,使模型难以从零开始收敛。

为了解决这一问题,我们采用了基于监督微调的冷启动阶段。具体而言,我们使用由 CoT 数据引擎生成的 Nav-CoT-110K 数据集来初始化 Nav-R1。该监督训练步骤使策略具备生成结构化推理序列(格式为 <think>...</think><action>...</action>)的基本能力,并将其与对应的导航动作建立关联。

通过用连贯的推理和动作模式对模型进行引导,冷启动阶段稳定了后续的强化学习优化,并为顺利过渡到强化学习阶段奠定了基础。在强化学习阶段,多维度的奖励进一步提升了语义理解、路径准确性以及结构遵循性。

Reinforcement Learning

D. 强化学习

Group Relative Policy Optimization (GRPO) [40] 最近在推理密集型任务(如 DeepSeek R1 [12])中表现出了强大的效果。其核心原理是通过基于群组的反馈来优化策略:从当前策略中采样多个候选响应,由任务特定的奖励函数进行评分,并根据它们的相对优势进行更新。

如图 4 所示,将该框架扩展到具身 3D 视觉语言任务中,Nav-R1 引入了三种互补奖励,共同监督训练:Format Reward,用于确保输出的结构有效性;Understanding Reward,用于保证语义正确性并在 3D 场景推理中进行视觉落地;Navigation Reward,用于评估导航路径的忠实度和目标到达的准确性。这些奖励共同提供多维度反馈,平衡语言结构、语义理解和动作执行。

a) 策略采样:对于输入状态 ( x , q ) (x, q) (x,q),其中 x x x 表示多模态场景表示, q q q 表示指令或问题,Nav-R1 从策略 π θ \pi_\theta πθ 生成 N N N 个候选响应 o 1 , o 2 , … , o N {o_1, o_2, \dots, o_N} o1,o2,…,oN。每个候选响应对应场景理解的答案预测或导航的动作预测。然后使用以下奖励函数对这些响应进行评估。

b) 格式奖励:为了保证结构一致性,格式奖励 R Format R_{\text{Format}} RFormat 验证每个输出是否严格遵循推理-决策模板:

<think>...</think><answer>...</answer> 或 <think>...</think><action>...</action>。

形式化表示为:

R Format = { 1 , 如果输出符合格式 0 , 否则 ( 1 ) R_{\text{Format}} = \begin{cases} 1, & \text{如果输出符合格式} \ 0, & \text{否则} \end{cases} \quad (1) RFormat={ 1,如果输出符合格式 0,否则(1)

该约束不仅确保输出可被机器解析,还将推理过程与最终预测解耦。

c) 理解奖励:理解奖励 R understanding R_{\text{understanding}} Runderstanding 用于评估模型是否展示了对 3D 场景的真实理解。它包含两个组成部分:答案奖励和语义奖励。答案奖励用于衡量预测结果与真实答案的准确性:

R ans = { 1 , 如果预测答案等于真实答案 0 , 否则 ( 2 ) R_{\text{ans}} = \begin{cases} 1, & \text{如果预测答案等于真实答案} \ 0, & \text{否则} \end{cases} \quad (2) Rans={ 1,如果预测答案等于真实答案 0,否则(2)

语义奖励用于衡量生成答案 a ^ \hat{a} a^ 与对应 RGB-D 图像 I I I 的对齐程度:

R sem = CLIPScore ( I , a ^ ) ( 3 ) R_{\text{sem}} = \text{CLIPScore}(I, \hat{a}) \quad (3) Rsem=CLIPScore(I,a^)(3)

整体理解奖励定义为:

R understanding = R ans + R sem ( 4 ) R_{\text{understanding}} = R_{\text{ans}} + R_{\text{sem}} \quad (4) Runderstanding=