服务器搭建vllm框架并部署模型+cursor使用经验

在运用大模型的过程中,大家一般都会选择获取api码,通过云端连接大模型来使用。但是要想使用模型使用的顺畅,有条件的话,可以去阿里云等平台租借一个服务器,通过在服务器上下载模型,外设一个api接口去调用。

安装conda

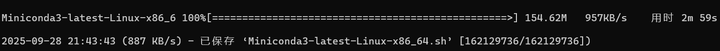

这里笔者选择用conda来安装vllm的环境,首先先在服务器上安装conda,输入命令下载conda:

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

下载好后,再执行安装脚本:

bash Miniconda3-latest-Linux-x86_64.sh

然后一路按enter ,直到看到

You can undo this by running `conda init --reverse $SHELL`? [yes|no]

这里的意思是是否每次连接都自动启动conda,一般不建议用yes,因为以后可能会用到其他的环境,只需要每次都用命令:conda activate 来进入conda环境即可。

接下来,输入source ~/.bashrc 在终端里输入conda --version,能看到版本号,比如:conda 25.7.0,就说明安装成功了,接下来输入退出命令到外面去把路径保存到环境里即可:

echo 'export PATH="$HOME/miniconda3/bin:$PATH"' >> ~/.bashrc

source ~/.bashrc

注意这里的HOME要换成自己的。

安装vllm

首先创建一个新的conda环境来安装vllm,避免以后用其他模型时会冲突:

conda create -n vllm_env python=3.10 -y

conda activate vllm_env

创建并激活好后,会自动进入这个新的环境里,此时下载vllm:

pip install vllm

如果下载的过程中频繁看到警告说重新下载或者installing显示了很久,可以切换清华源下载:

pip install vllm -i https://pypi.tuna.tsinghua.edu.cn/simple

接下来我们就可以输入运行大模型的命令了,注意要写成在后台运行:

nohup vllm serve Qwen/Qwen2.5-VL-7B-Instruct \--trust-remote-code \--tensor-parallel-size 1 \--port 2796 \> qwen_7B.log 2>&1 &

运行完成后,再运行命令:

ps aux | grep uvicorn | grep -v grep

只要不显示进程异常退出,那么就代表模型在服务器上部署成功了。

cursor使用经验

-

不管给agent梳理的逻辑思路有多么清晰,一定一定要亲自看完AI写的代码,难免会有一些隐藏的因为AI幻觉导致的逻辑问题

-

在使用前可以先设置一个全局的role,限定或提供一些思路,然后再根据项目的具体需求添加局部的role,可以让AI在思考时更贴近实际的需求,且不用每次都做特别说明

-

用cursor的agent进行代码开发时,最好能提供一些关键的上下文信息,包括前面做了什么,有什么效果等

-

提问时不要一次性抛出所有问题,建议先梳理好整套的逻辑架构,然后一个问题一个问题地抛给agent,这样既可以减少它写代码的错误率(一个个地解决问题,就相当于让agent隔一段时间就总结一下进度,还能起到利用上下文的作用)