Pixel-Perfect Depth with Semantics-Prompted Diffusion Transformers,nips 2025

这篇由华中科技大学、浙江大学和小米团队提出的Pixel-Perfect Depth模型,针对单目深度估计中常见的“飞点”(flying pixels)问题提出了创新性解决方案。

本文提出了一种基于像素空间扩散生成的单目深度估计模型Pixel-Perfect Depth,该模型从估计的深度图中恢复高质量、无飞行的点云。当前的生成深度估计模型微调了稳定的扩散,并取得了令人印象深刻的性能。然而,它们需要 VAE 将深度图压缩到潜在空间中,这不可避免地会在边缘和细节处引入飞行像素。我们的模型通过直接在像素空间中执行扩散生成来解决这一挑战,避免了 VAE 诱导的伪影。为了克服与像素空间生成相关的高复杂性,我们引入了两个新的设计:1)语义提示扩散变压器(DiT),它将视觉基础模型的语义表示合并到DiT中,以提示扩散过程,从而在增强细粒度视觉细节的同时保持全局语义一致性;2)级联DiT设计,逐步增加令牌的数量,进一步提高效率和准确性。我们的模型在五个基准测试中在所有已发布的生成模型中实现了最佳性能,并且在边缘感知点云评估中明显优于所有其他模型。

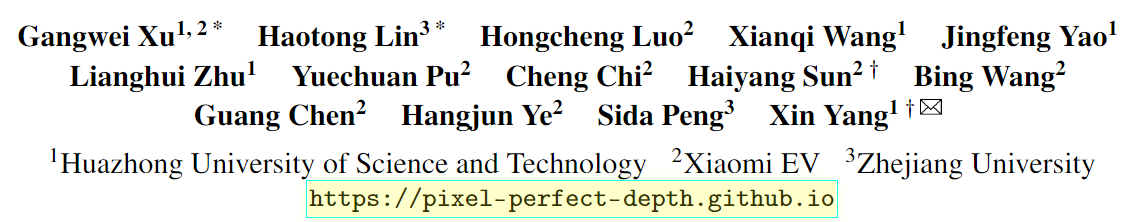

单目深度估计(MDE)是一项具有广泛下游应用的基本任务,如三维重建、新视图合成和机器人操作。由于其重要性,最近出现了大量深度估计模型[29,67,68,74]。这些模型在大多数零样本场景或区域都实现了高质量的结果,但在转换为点云时会出现对象边界周围的像素和精细细节的问题,如图 1 和图 4 所示,这限制了它们在自由视点广播、机器人操作和沉浸式内容创建等任务中的实际应用。

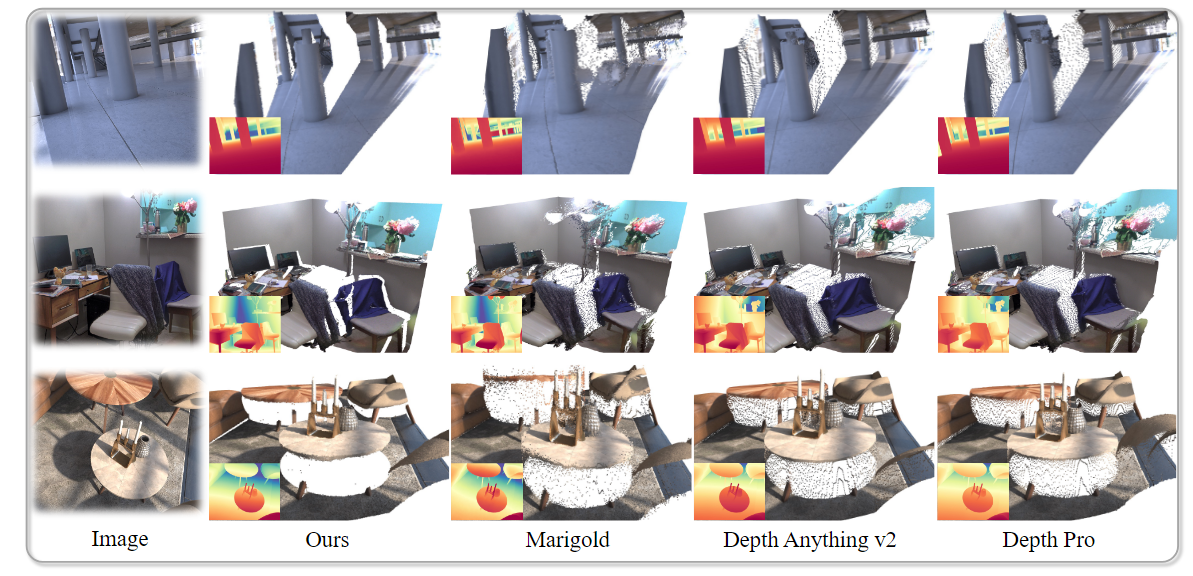

由于不同的原因,当前模型存在飞行像素问题。对于判别模型 [68]、4、74、25],飞行像素主要是由于它们倾向于在深度不连续边缘输出前景和背景之间的中间(平均)深度值,以最小化回归损失。相比之下,生成模型[29,14,18]通过对像素级深度分布建模绕过直接回归,使它们能够保持锐利的边缘,更忠实地恢复精细结构。然而,目前的生成深度模型通常微调稳定扩散[45]进行深度估计,这需要变分自动编码器(VAEs)将深度图压缩到潜在空间中。这种压缩不可避免地会导致边缘清晰度和结构保真度的损失,导致大量的飞行像素,如图2所示。

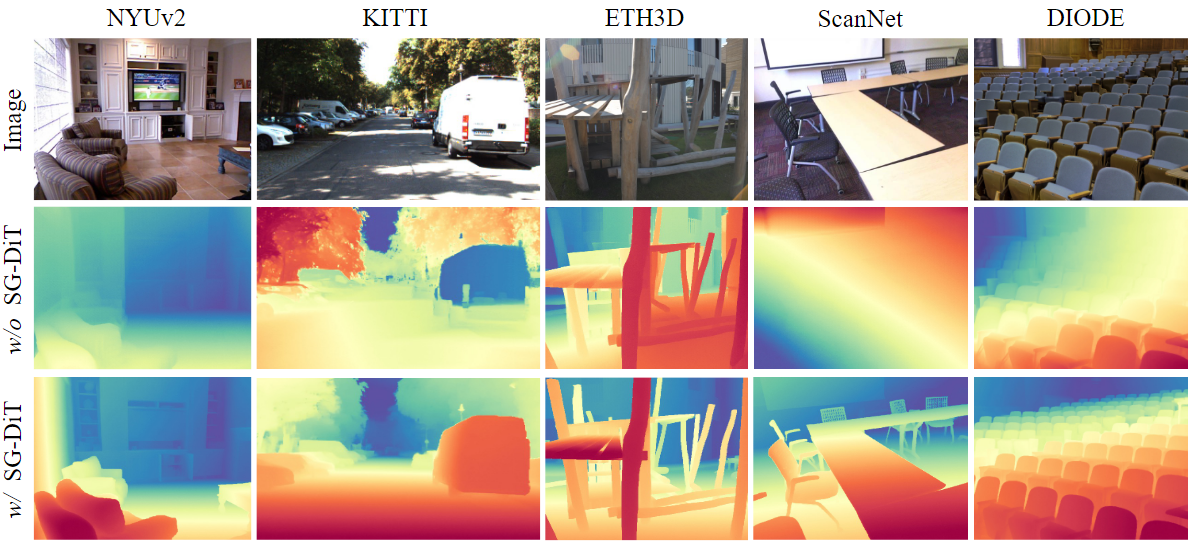

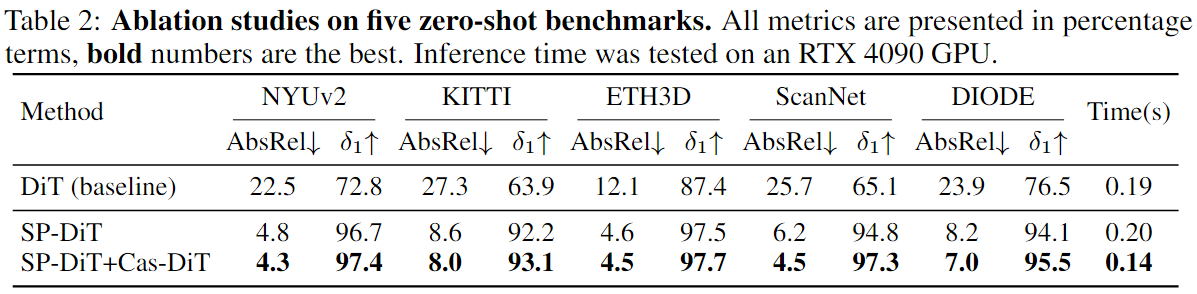

一个简单的解决方案是在像素空间中训练基于扩散的单目深度模型,绕过 VAE 的使用。然而,我们发现这是非常具有挑战性的,因为建模全局语义一致性和细粒度视觉细节的复杂性和不稳定性增加,导致深度预测质量极低(表2和图5)。为了进一步研究这一限制,我们研究了先前关于高分辨率图像生成的研究。一些工作[24,55,80]通过信噪比(SNR)分析,指出添加强度较高的噪声更有可能破坏高分辨率图像的全局结构或低频分量,从而提高生成。这表明高分辨率像素空间生成的主要困难在于有效地感知和建模全局图像结构。

在本文中,我们提出了Pixel-Perfect Depth,这是一个使用像素空间扩散变压器高质量和无飞行像素的单目深度估计框架。认识到高分辨率像素空间生成的主要困难在于感知和建模全局图像结构。为了应对这一挑战,我们提出了语义提示扩散变换器(SP-DiT),它将高级语义表示合并到扩散过程中,以增强模型保持全局结构和语义一致性的能力。配备 SP-DiT,我们的模型可以更有效地保持全局语义一致性,同时在高分辨率像素空间中生成细粒度的视觉细节。然而,从视觉基础模型[38,68,58,19]获得的语义表示往往不能很好地与DiT的内部表示对齐,导致训练不稳定和收敛问题。为了解决这个问题,我们引入了一种简单而有效的语义表示正则化技术,它确保稳定的训练并促进收敛到理想的解决方案。如表 2 和图 5 所示,所提出的 SP-DiT 显着提高了整体性能,在 NYUv2 [52] AbsRel 指标上实现了高达 78% 的改进。

此外,我们介绍了级联DiT设计(Cas-DiT),这是一种有效的扩散变压器体系结构。我们发现,在扩散变压器中,早期块主要负责用于捕获和生成全局或低频结构,而后面的块专注于生成高频细节。基于这一见解,Cas-DiT 采用渐进式补丁大小策略:早期的 DiT 块中使用更大的补丁大小来减少令牌的数量并促进全局图像结构建模;在后面的 DiT 块中,我们增加了令牌的数量,这相当于使用更小的补丁大小,允许模型专注于细粒度空间细节的生成。这种从粗到细的级联设计不仅显着降低了计算成本并提高了效率,而且还带来了显着的准确性增益。

我们在下面强调了本文的主要贡献:

• 我们提出了像素-完美深度,这是一种具有像素空间扩散生成的单目深度估计模型,能够从估计的深度图生成无飞行像素的点云。

• 我们引入了语义提示的 DiT,它将归一化的语义表示集成到 DiT 中,以有效地保持全局语义一致性,同时增强细粒度的视觉细节。这显着提高了整体性能。我们进一步提出了一种新颖的级联 DiT 设计来提高我们模型的效率和准确性。

• 我们的模型在所有已发布的生成深度估计模型中在五个基准测试中实现了最佳性能。

• 我们引入了一个边缘感知点云评估指标,它有效地评估边缘的飞行像素。我们的模型在本次评估中明显优于以前的模型

2相关工作

2.1单目深度估计

早期的单目深度估计方法主要依赖于人工设计的特征[46,23]。尽管初始方法[12,11]难以跨数据集泛化,但神经网络的出现彻底改变了该领域。为了解决这一限制,引入了尺度不变和相对损失[43],使多数据集[31,72,7,63,61,59,57,62,44]训练成为可能。最近的方法侧重于提高深度估计的泛化能力[68,4]、深度一致性[66]、6,26,28]和度量尺度[3,32,33,74,17,75,25,40,34]。这些方法收敛于使用基于变压器的架构[42]。并行工作 [60, 65] 探索点云表示以提高深度估计性能。最近的几种方法[27,9,49,47,48,79]尝试使用扩散模型进行度量深度估计。相比之下,我们的方法侧重于相对深度,并在广泛的现实世界场景中展示了改进的泛化和细粒度的细节。此外,我们的模型通过引入语义提示 DiT 与这些方法显着不同,它将预训练的高级语义表示合并到扩散过程中,大大提高了性能。

最近,[29]通过微调预训练的稳定扩散[45]进行深度估计,为该领域带来了新的见解,这在相对深度上展示了令人印象深刻的零镜头能力。以下作品 [18, 16 , 54, 78, 2] 试图提高其性能和推理速度。然而,它们都基于在潜在空间中训练的潜在扩散模型[45],并且需要VAE将深度图压缩到潜在空间中。我们专注于直接在像素空间中训练的像素空间扩散模型,而不需要任何 VAE。

2.2扩散生成模型扩散

生成模型[20,53,39,76,70,71]在图像和视频生成方面表现出了令人印象深刻的结果。早期的方法[20,22,21],如DDPM[20],直接在像素空间中操作,从而实现高保真的生成,但会产生显著的计算成本,特别是在高分辨率下。为了解决这个限制,潜在扩散模型在通过 VAE 获得的低维潜在空间中执行扩散过程,如稳定扩散 [45] 所普及的那样。这种设计显着提高了训练和推理效率,并已广泛应用于最近的工作 [13, 71, 76, 81, 30, 41, 69]。

单目深度估计的扩散模型通常遵循类似的趋势。例如,Marigold[29]及其后续[18,16]微调预训练的稳定扩散[45]模型的深度预测,受益于从大规模数据集中学习到的快速收敛和强先验。然而,VAE 的潜在压缩导致生成的点云中的飞行像素。相比之下,像素空间扩散避免了这种伪影,但在高分辨率下仍然存在计算密集型和缓慢的收敛。为了解决这个问题,我们提出了语义提示的 DiT 和 Cascade DiT 设计,它能够在没有潜在压缩的情况下进行有效的高分辨率深度估计。

3 Method

3.1 Pixel-Perfect Depth

给定一个输入图像,我们的目标是估计一个像素完美的深度图,该深度图在转换为点云时没有飞行像素。现有模型[29、14、18、68、4]由于其固有的建模范式而经常受到飞行像素的影响。由于判别模型的平均预测偏差,判别模型倾向于平滑物体边缘并模糊精细细节,从而导致重建点云中明显的飞行像素。理论上,生成模型可以更好地捕获对象边缘的多模态深度分布。然而,当前的生成模型通常依赖于其强大的图像先验来微调用于深度估计的稳定扩散 [45]。这需要通过VAE将深度图压缩到潜在空间中,不可避免地导致飞行像素。为了释放生成模型在深度估计方面的潜力,我们提出了Pixel-Perfect深度,它直接在像素空间中执行扩散,而不是潜在空间。它允许我们直接对深度的像素分布进行建模,例如对象边缘的不连续。然而,直接在高分辨率像素空间(例如 1024×768)中训练生成扩散模型在计算上要求很高,难以优化。为了克服这些挑战,我们引入了语义提示的 DiT 和级联 DiT 设计,详见以下部分。

3.2生成公式

我们采用流匹配[35,36,1]作为我们的深度估计框架的生成核心。流匹配通过一阶常微分方程 (ODE) 从高斯噪声到数据样本的连续变换。在我们的例子中,我们对从高斯噪声到深度样本的变换进行建模。具体来说,给定干净的深度样本 x0 ∼ D 和高斯噪声 x1 ∼ N (0, 1),我们将连续时间 t ∈ [0, 1] 处的插值样本定义为:

![]()

这定义了一个速度场:

![]()

它描述了从干净数据到噪声的方向。我们的模型 vθ (xt, t, c) 被训练以根据当前噪声样本 xt、时间步长 t 和输入图像 c 来预测速度场。训练目标是预测速度和真实速度之间的均方误差 (MSE):

在推理时,我们从噪声 x1 开始,通过将时间间隔 [0, 1] 离散化为步骤 ti 来解决 ODE,迭代更新样本如下:

![]()

其中 ti 从 1 减少到 0,逐渐将初始噪声 x1 转换为深度样本 x0。

3.3语义提示扩散变压器

我们的语义提示DiT建立在扩散变压器(DiT)[39]的基础上,因为它在生成建模中的简单性、可扩展性和强大的性能。与之前的深度估计模型(如Depth Annything v2[68]和Marigold[29])不同,我们的架构纯粹是基于transformer的,没有任何卷积层。通过整合高级语义表示,我们的模型在增强细粒度视觉细节的同时保留了全局语义一致性,而不牺牲DiT的简单性和可扩展性。

具体来说,给定插值噪声样本 xt 和对应的图像 c,我们首先将它们连接成一个输入:at = xt ⊕ c,其中图像 c 用作条件。然后,我们直接输入 DiT。DiT 的第一层是一个补丁操作,它将空间输入转换为 T 个标记的 1D 序列(补丁),每个序列维度为 D,通过从输入 at 线性嵌入大小为 p × p 的每个补丁。随后,输入标记由一系列 Transformer 块处理,称为 DiT 块。在最终的 DiT 块之后,每个令牌被线性投影到 p × p 张量中,然后将其重新整形回原始空间分辨率以获得预测的速度 v(即 x1−x0),通道维度为 1。

不幸的是,直接在像素空间中执行扩散会导致较差的收敛和高度不准确的深度预测。如图 5 所示,该模型难以对全局图像结构和细粒度细节进行建模。为了解决这个问题,我们使用视觉基础模型 f 从输入图像 c 中提取高级语义表示 e 作为指导,如下所示:

![]()

其中 T ' 和 D′ 分别是 f 的标记数和嵌入维度。然后将这些高级语义表示合并到我们的 DiT 模型中,使其能够更有效地保持全局语义一致性,同时增强细粒度的视觉细节。然而,我们发现获得的语义 e 的大小与我们的 DiT 模型中标记的大小显着不同,这会影响模型的训练的稳定性及其性能。为了解决这个问题,我们使用 L2 范数沿特征维度归一化语义表示 e,如下所示:

随后,通过多层感知器 (MLP) 网络 hφ 将归一化语义表示集成到我们的 DiT 模型的标记 z 中,

![]()

其中 B(·) 表示双线性插值算子,它将语义表示 ^e 的空间分辨率为与 DiT 标记的空间分辨率为对齐。生成的 z' 表示用语义增强的 DiT 标记。在融合后,语义提示后续的DiT块,在保持全局语义一致性的同时,增强高分辨率像素空间中的细粒度视觉细节。我们将这些后续的 DiT 块称为语义提示 DiT。

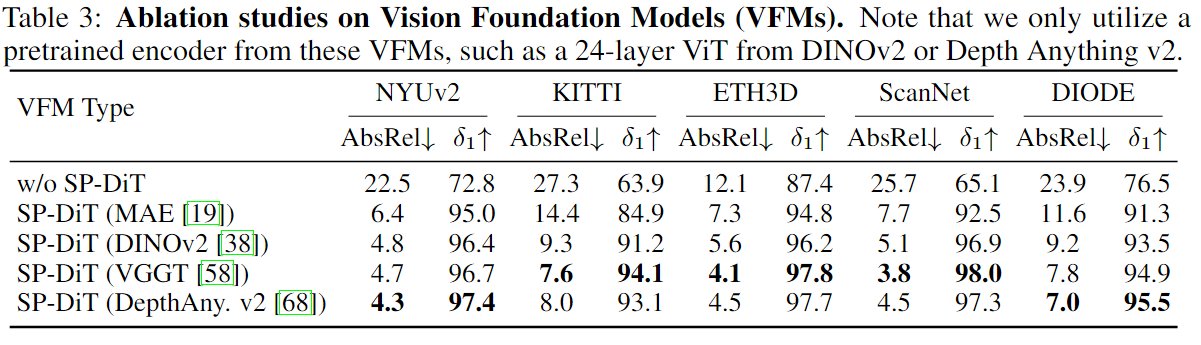

在这项工作中,我们尝试了各种预训练的视觉基础模型,包括 DINOv2 [38]、VGGT [58]、MAE [19] 和 Depth Anything v2 [68]。所有这些都显著提高了性能,促进了更稳定和有效的训练,如表3所示。注意,我们只使用每个视觉基础模型的编码器,例如DINOv2[38]和深度任何东西v2[68]的24层视觉转换器编码器(ViT-L/14)。

3.4级联DiT设计

虽然提出的语义提示DiT显著提高了精度性能,但直接在像素空间中执行扩散在计算上仍然很昂贵。为了解决这个问题,我们提出了一种新颖的级联 DiT 设计来减少模型的计算负担。我们观察到,在 DiT 架构中,早期块主要负责捕获全局图像结构和低频信息,而后面的块专注于对细粒度、高频细节进行建模。

为了优化这个过程的效率和有效性,我们在早期的 DiT 块中采用了较大的补丁大小。这种设计显着减少了需要处理的令牌数量,从而降低了计算成本。此外,它鼓励模型优先学习和建模全局图像结构和低频信息,这也与从输入图像中提取的高级语义表示更好地对齐。在后来的 DiT 块中,我们增加了令牌的数量,这相当于使用更小的补丁大小。这允许模型更好地关注细粒度的空间细节。生成的从粗到细的级联设计反映了视觉感知的层次性,提高了深度估计的效率和准确性。

具体来说,对于我们的总共有 N 个 DiT 块的扩散模型,前 N/2 个块构成补丁大小较大的粗阶段,而其余 N/2 个块(即 SP-DiT)使用更小的补丁大小形成精细阶段。

3.5实现细节

在本节中,我们提供了有关模型架构细节、深度归一化和训练细节的基本信息。

模型架构细节。在我们的实现中,我们总共使用了 N = 24 个 DiT 块,每个块以 D = 1024 的隐藏维度运行。前 12 个块是标准 DiT 块,补丁大小为 16,对应于 (H/16) × (W/16) 标记,用于大小为 H × W 的输入。剩下的 12 个块是我们提出的语义提示 DiT 块,它采用 8 的更精细的补丁大小,从而产生 (H/8) × (W/8) 标记。在第 12 块之后,我们使用 MLP 网络将隐藏维度增加 4 倍,然后重塑以获得更多的标记。

深度归一化。地面实况深度值被归一化以匹配扩散模型预期的比例。在归一化之前,我们将深度值转换为对数尺度,以确保室内和室外场景的容量分配更加平衡。具体来说,我们应用变换 ̃d = log(d + ε),其中 ̃d 表示变换后的深度,d 是原始深度值,ε 是一个小的正常数(例如,1)以确保数值稳定性。然后我们使用以下方法对对数尺度深度 ̃d 进行归一化:

其中 dmin 和 dmax 分别是每个地图的 2% 和 98% 的深度百分位数。

训练细节。我们在不同分辨率的扩散模型训练两种变体:一个在512 × 512,另一个在1024 × 768处。我们的训练图像最初分辨率为1024 × 768。为了训练512 × 512模型,我们将较短的边调整为512,然后应用随机裁剪得到正方形输入。我们使用 8 个 NVIDIA GPU 训练所有模型 800K 步,每个 GPU 的批量大小为 4。我们使用恒定学习率为1 × 10−4的AdamW优化器训练所有模型。我们在训练期间不使用任何数据增强。训练损失是预测速度和真实速度之间的 MSE 损失,如公式 3 所示。

4 实验

4.1 实验设置

训练数据集。我们的目标是估计像素完美的深度图,当转换为点云时,没有飞行像素和几何伪影。为了实现这一点,必须在具有高质量地面实况点云的数据集上进行训练。我们采用 Hypersim [44],这是一个逼真的合成数据集,可提供准确和干净的 3D 几何形状。具体来说,我们使用 Hypersim 的官方训练拆分,其中包含大约 54K 个样本作为我们的训练数据。数据集分辨率为 1024 × 768。

评估设置。继之前的大多数深度估计模型[29,14,18]之后,我们评估了五个真实数据集上的零镜头相对深度估计性能:NYUv2[52]、KITTI[15]、ETH3D[50]、ScanNet[8]和DIODE[56],涵盖室内和室外场景。为了评估深度估计的质量,我们采用了两个广泛使用的评估指标:绝对相对误差 (AbsRel) 和 δ1 准确度。为了证明我们的模型在没有飞行像素的情况下生成点云,我们将估计的深度图转换为 3D 点云,并使用所提出的边缘感知度量来评估它们。为简单起见,所有定量评估均使用 512 × 512 模型进行。我们对图 1 所示的定性结果使用 1024 × 768 模型。

4.2消融和分析

成分消融分析。我们采用 DiT [39] 模型作为我们的基线,并对我们提出的模块进行消融。定量结果如表2所示。由于大量的计算成本和优化困难,直接在高分辨率像素空间中进行扩散生成是非常具有挑战性的,导致性能显著下降。如图 5 所示,基线模型难以保留全局语义并生成细粒度的视觉细节。相比之下,所提出的语义提示 DiT (SP-DiT) 解决了这些挑战,实现了显着提高的准确性,例如,NYUv2 AbsRel 指标的增益为 78%。我们进一步引入了一种新的级联 DiT 设计 (Cas-DiT),它逐渐增加令牌的数量。这种从粗到细的设计不仅显着提高了效率,例如,在 RTX 4090 GPU 上将推理时间减少了 30%,而且可以更好地对全局上下文进行建模,从而显着提高了准确性。

视觉基础模型 (VFMs) 的消融。我们使用来自不同 VFM 的预训练视觉编码器来评估 SP-DiT 的性能,包括 MAE [19]、DINOv2 [38]、Depth Anything v2 [68] 和 VGGT [58],如表 3 所示。所有这些都显着提高了性能。

4.3零样本相对深度估计

为了评估我们模型的零样本泛化,我们在五个真实世界基准上将其与最近的深度估计模型 [68, 4 , 29 , 18 , 16 ] 进行了比较。如表 1 所示,我们的模型在所有评估指标上都优于所有其他生成深度估计模型。与以前的生成模型不同,我们不依赖来自预训练的稳定扩散 [45] 模型的图像先验。相反,我们的扩散模型是从头开始训练的,仍然实现了卓越的性能。我们的模型可以很好地推广到广泛的现实世界场景,即使仅在合成深度数据集上进行训练。此外,它优于在相似数量的训练数据上训练的判别模型。不同于以前的使用卷积架构的模型,例如,生成模型去噪 U-Net 和判别模型的 DPT,我们的模型纯粹是基于转换器的,没有卷积层。

4.4边缘感知点云评估

我们的目标是估计像素完美的深度图,在没有飞行像素的情况下产生干净的点云,由于这些区域的深度预测不准确,这些深度图经常出现在物体边缘。然而,现有的评估基准和指标往往难以反映物体边缘的飞行像素。例如,像NYUv2或KITTI这样的基准通常缺乏边缘注释,而AbsRel和δ1等指标以平坦区域为主,难以评估边缘的深度精度。

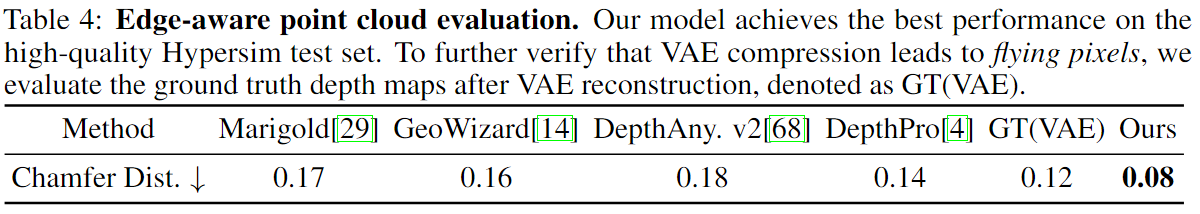

为了解决这些限制,我们评估了 Hypersim [44] 数据集的官方测试拆分,该数据集提供了高质量的真实点云,并且在训练期间没有使用。我们进一步提出了一个边缘感知点云度量,它量化了边缘的深度精度。具体来说,我们使用Canny算子从地面真实深度图中提取边缘掩码,并计算这些边缘附近预测点云和真实点云之间的倒角距离。

表 4 中的定量结果表明我们的方法实现了最佳性能。深度Pro[4]和深度任意v2[68]等判别模型倾向于平滑边缘,导致飞行像素。Marigold [29] 等生成模型依赖于 VAE 压缩,它模糊边缘和细节,导致重建点云中的伪影。为了说明这一点,我们使用 VAE (GT(VAE))) 对地面实况深度进行编码和解码,而无需任何生成过程。表 4 和图 2 显示 VAE 压缩引入了飞行像素,导致比我们的倒角距离更大。

5结论

我们提出了Pixel-Perfect Depth,这是一种单目深度估计模型,它利用像素空间扩散变压器来恢复高质量的、无飞行的点云。与之前依赖潜在空间扩散与 VAE 的生成深度模型不同,我们的模型直接在像素空间中执行扩散,避免了 VAE 压缩引起的飞行像素。为了解决像素空间扩散的复杂性和优化挑战,我们引入了语义提示的DiT和级联DiT设计,大大提高了性能。我们的模型在边缘感知点云评估中明显优于先前的模型。

局限性和未来的工作。这项工作有两个已知的限制。首先,与大多数基于图像的扩散模型一样,当应用于视频帧时,它缺乏时间一致性,导致跨帧的闪烁深度很小。其次,与Depth Anthing v2[68]等判别模型相比,它的多步扩散过程导致推理速度较慢。未来的工作可以通过探索视频深度估计方法[51,26,66,6,28]来提高时间一致性并采用DIT加速策略[37,82,5](如缓存来加速推理)来解决这些限制。

6更多的定性比较

我们提供了与并发工作MoGe[60]的定性比较,如图6所示。MoGe[60]作为一种判别模型,受到边缘和精细结构的飞行像素的影响,这是在其他判别模型中观察到的常见问题[68,4]。与 MoGe [60] 相比,我们的模型产生的飞行像素要少得多。

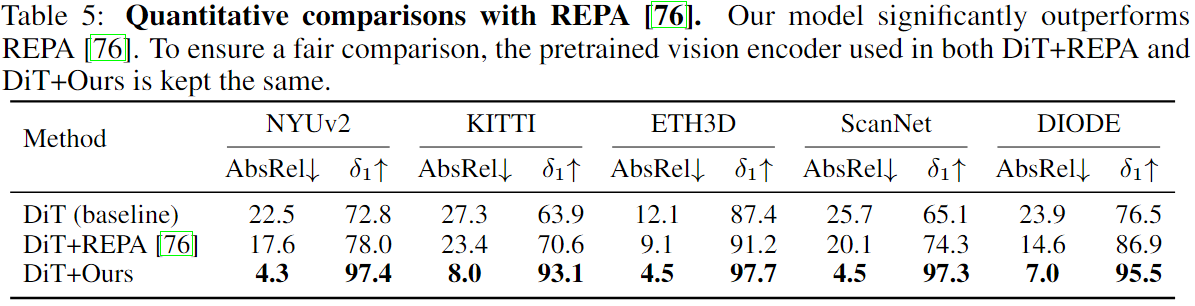

7 与 REPA 的其他讨论

我们对最近的图像生成方法 REPA [76] 进行了额外的讨论。REPA[76]将扩散模型中的中间标记与预先训练的视觉编码器对齐,显著提高了图像生成任务的训练效率和生成质量。我们将我们的方法与REPA[76]进行比较,定量评价结果如表5所示。DiT+REPA是指用REPA的表示对齐训练DiT模型,而DiT+Ours表示使用我们的语义提示DiT训练DiT模型。为了公平比较,DiT+REPA 和 DiT+Ours 中使用的预训练视觉编码器保持不变。实验结果表明,我们的语义提示 DiT 显着优于 REPA [76]。我们将我们的模型相对于 REPA 的优越性归因于两个因素。首先,在训练期间,REPA 使用预训练的视觉编码器对 DiT 标记的隐式对齐是次优的,这使得 DiT 很难有效地利用预训练视觉编码器的语义指导。相比之下,我们的语义提示 DiT 直接集成语义线索,从而产生更有效的指导。其次,在推理时,REPA 不能利用预训练的视觉编码器来提供语义指导,而我们的方法在推理过程中有效地将高级语义合并到语义提示的 DiT 中以指导扩散过程。

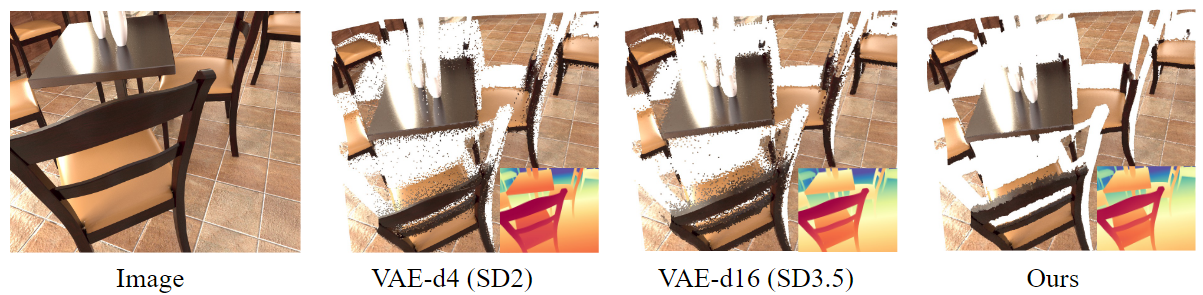

8 不同类型

VAE 中飞行像素的分析为了更好地理解基于 VAE 的重建中飞行像素的出现,我们通过使用它们重建地面实况深度图来分析具有不同潜在维度(即通道)的 VAE。图 7 显示,这两种 VAE 变体在对象边缘和细节上表现出飞行像素,揭示了 VAE 重建在保留精确几何结构方面的常见弱点。VAE-d4 (SD2) 表示使用来自稳定扩散 2 的 VAE 重建地面实况深度图,潜在维度为 4,也用于 Marigold [29]。VAE-d16 (SD3.5) 使用来自稳定扩散 3.5 的 VAE,其潜在维度为 16。

8 不同类型 VAE 中飞行像素的分析

为了更好地理解基于 VAE 的重建中飞行像素的出现,我们通过使用它们重建地面实况深度图来分析具有不同潜在维度(即通道)的 VAE。图 7 显示,这两种 VAE 变体在对象边缘和细节上表现出飞行像素,揭示了 VAE 重建在保留精确几何结构方面的常见弱点。VAE-d4 (SD2) 表示使用来自稳定扩散 2 的 VAE 重建地面实况深度图,潜在维度为 4,也用于 Marigold [29]。VAE-d16 (SD3.5) 使用来自稳定扩散 3.5 的 VAE,其潜在维度为 16。

核心贡献总结

- 像素空间扩散生成:

直接在像素空间进行扩散,避免了潜在空间(VAE)压缩导致的结构损失,从根本上减少了边缘区域的飞点问题。 - 语义提示的扩散变换器(SP-DiT):

- 利用视觉基础模型(如DINOv2、Depth Anything v2)提取语义特征,通过正则化处理后融入扩散过程,增强全局语义一致性。

- 结合高层语义信息,提升了模型对边缘和细节的建模能力。

- 级联DiT设计(Cas-DiT):

- 早期块采用大块处理全局结构,降低计算量;后期块细化小块生成细节,平衡效率与精度。

- 分阶段设计优化了高分辨率生成的计算复杂度。

- 边缘感知评估指标:

提出基于边缘区域的Chamfer距离指标,定量评估飞点在点云中的影响,验证了模型的有效性。

- 飞点的成因分析:

- Discriminative 模型: 倾向于输出前景和背景之间的平均深度值,以最小化回归损失,导致深度不连续边缘出现飞点。

- Generative 模型: 使用 VAE 压缩深度图到潜在空间,导致边缘锐度和结构保真度降低,从而产生飞点。

- 解决飞点问题的策略:

- 避免 VAE 压缩: 直接在像素空间进行扩散生成,避免 VAE 压缩带来的信息损失。

- 引入语义信息: 利用视觉基础模型提取的语义信息,指导深度估计过程,保持全局语义一致性,减少飞点。

- 优化模型架构: 通过级联设计等方式,提高模型的效率和准确性,从而改善深度估计的质量,减少飞点。

- 飞点评估方法:

- 边缘感知评估指标: 传统的评估指标可能无法准确反映边缘区域的深度估计质量,因此需要设计专门的边缘感知评估指标,以更准确地评估飞点问题。

对飞点研究的启发

- 避免潜在空间压缩:

VAE的量化误差和重建损失是飞点的重要来源。直接像素空间生成可能是解决飞点的有效路径,需探索如何在保证效率的同时实现高分辨率生成。 - 语义信息的融合:

- 引入预训练模型的语义特征(如场景理解、边缘检测)可增强模型对深度不连续区域的感知。

- 需关注特征归一化(如L2正则化)以解决跨模型特征尺度不一致问题。

- 层级化生成架构:

- 采用级联设计(全局→局部)可高效建模高分辨率深度图,减少计算负担。

- 类似思路可应用于其他生成模型,如GAN或NeRF,以优化边缘生成质量。

- 针对性评估指标:

传统指标(AbsRel、δ1)难以捕捉飞点问题。需设计边缘敏感指标(如局部Chamfer距离)或结合点云可视化分析,以更全面评估模型。 - 高质量训练数据:

使用Hypersim等高质量合成数据可提升模型对细节的建模能力。若受限于真实数据,可通过合成数据增强或域适应方法缓解数据偏差。 - 动态场景的扩展:

论文未解决视频深度的时间一致性问题。飞点可能在动态场景中更显著,需结合时序信息(如光流、运动估计)进一步优化。 - 模型加速与优化:

像素扩散的计算复杂度较高,可借鉴DiT加速策略(如缓存机制、蒸馏技术)提升推理速度,使其更适用于实时应用。