thumos14数据集学习

视频理解数据集学习

目录

1.任务定义

2. THUMOS数据集

2.1来源与种类

2.2 文件组成

2.4标注文件

2.4.1 txt标注文件

2.4.2 XGTF 标注文件

2.5其他文件

2.6与模型匹配

2.7 THUMOS14 定位任务的 20 个动作类别

4. ActivityNet数据集

4.1 来源与种类

4.2 文件组成

4.3 视频文件解析

4.4 JSON标注文件

4.5 其他文件

4.6 与模型匹配

视频理解是指通过深度学习技术,自动化地对视频中的内容进行识别和解析。视频理解中的三大研究方向分为:动作识别(Action Recognition)、时序动作定位(Temporal Action Localization)和视频Embedding。

动作识别是指在视频中识别并分类发生的动作,模型不仅要分析视频中每帧图像的静态内容,还需学习视频帧之间的时序关系。

时序动作定位是指在未剪辑长视频中,预测动作的类别以及动作发生的起止时间

视频 Embedding 是从视频中学习一个低维、稠密、浮点的特征向量,用以概括视频内容。视频Embedding之间的距离反映了视频之间的相似度。

时序动作定位最常用的数据集有两个。一个是THUMOS-14(Idrees etal.,2017),训练集是UCF-101,包含101类动作;通常在THUMOS-14的验证集上训练,在测试集上查看效果。另一个是ActivityNet-1.3(Heilbron et al.,2015),包含200类动作。

时序动作定位的特征提取模型包括Two-Stream 网络、C3D(Convolutional 3D Network)、I3D(Inflated 3D ConvNet)。时序动作定位的经典检测模型如 S-CNN、TURN、BSN、BMN。

下面是对时序动作定位数据集的分析。

2. THUMOS数据集

2.1来源与种类

THUMOS 数据集 由中佛罗里达大学(UCF)团队创建,该系列数据集经历了三个阶段的演进:

- THUMOS13:仅包含 UCF101 的裁剪短视频,用于动作分类(101 类)。

- THUMOS14:在保留 UCF101 作为训练集的基础上,加入标注动作类别与起止时间的验证集与测试集

- THUMOS15:在 2014 年版本的基础上进行了扩展。

| thumos14主页 | https://www.crcv.ucf.edu/THUMOS14/home.html |

| thumos15主页 | http://www.thumos.info/home.html |

2.2 文件组成

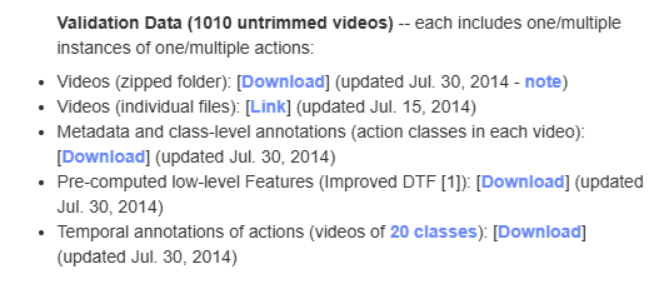

THUMOS14 数据集官方提供了完整的视频文件(.mp4)、动作标注文件(.txt 与 .xgtf)、元数据与视频级标签,以及预计算的 Improved Dense Trajectory Features (iDTF) 特征

2.3视频文件解析

· 格式:.mp4 文件

· 文件命名:video_validation_0000204.mp4

文件数量:验证集1010个

2.4标注文件

2.4.1 txt标注文件

里面有 20 个 .txt 文件,每个动作类别对应一个文件,每一行代表一个动作实例,格式为:

[video_name starting_time ending_time]

video_name:视频文件名,例如 video_validation_0000683

starting_time:动作开始时间(秒,保留 1 位小数)

ending_time:动作结束时间(秒,保留 1 位小数)

video_validation_0000160 155.2 160.6

video_validation_0000160 178.3 186.1

video_validation_0000160 187.0 196.7

2.4.2 XGTF 标注文件

官方提供了原始的 XGTF 标注文件(TH14_Temporal_annotations_validation_ViperXGTF),使用VIPER(Video Performance Evaluation Resource) 工具进行标注,文件格式是.xgtf,是xml文件,包含信息有:视频基本信息(帧数、帧率、尺寸等)、类别名称、起止帧号(framespan)。.xgtf需在VIPER工具中打开,配合原始MPEG视频看视频标注。

2.5其他文件

元数据与视频级标签(Metadata and class-level annotations):包含每个视频所涉及的动作类别,属于视频级标签。没有时间标注,主要用于分类。

预计算特征(Pre-computed low-level Features, Improved DTF):官方通过 Improved Dense Trajectory Features (iDTF) 提供了视频的预计算低层特征。

2.6与模型匹配

在 弱监督时序动作定位(Weakly Supervised Temporal Action Localization, WTAL) 任务中,THUMOS14 数据集通常按如下方式使用:

训练阶段:使用 .mp4 视频文件作为输入,通过 I3D 网络 提取 RGB 特征 与 光流特征,结合数据集中提供的视频级标签(包含视频名称及对应的动作类别)进行训练。

测试阶段:利用包含动作类别与具体起止时间的时序标注文件(temporal annotation)进行评估,验证模型在未剪辑视频上预测动作区间的准确性。

2.7 THUMOS14 定位任务的 20 个动作类别

THUMOS14 从 UCF101 的 101 个动作类别中挑选出 20 个,重新做了未裁剪长视频的收集与标注。

| 类别 ID | 类别名称 | 中文翻译(参考) |

| 7 | BaseballPitch | 棒球投球 |

| 9 | BasketballDunk | 篮球扣篮 |

| 12 | Billiards | 台球 |

| 21 | CleanAndJerk | 举重挺举 |

| 22 | CliffDiving | 悬崖跳水 |

| 23 | CricketBowling | 板球投球 |

| 24 | CricketShot | 板球击球 |

| 26 | Diving | 跳水 |

| 31 | FrisbeeCatch | 飞盘接力 |

| 33 | GolfSwing | 高尔夫挥杆 |

| 36 | HammerThrow | 链球 |

| 40 | HighJump | 跳高 |

| 45 | JavelinThrow | 标枪 |

| 51 | LongJump | 跳远 |

| 68 | PoleVault | 撑杆跳 |

| 79 | Shotput | 铅球 |

| 85 | SoccerPenalty | 足球点球 |

| 92 | TennisSwing | 网球挥拍 |

| 93 | ThrowDiscus | 掷铁饼 |

| 97 | VolleyballSpiking | 排球扣球 |

3.1 BaseballPitch(棒球投球,UCF101 类别 ID: 7)

- 动作简介:棒球投手从准备到完成投球的全过程。

- 动作特点:抬腿准备 → 挥臂 → 球出手

- 截图展示

3.2 BasketballDunk(篮球扣篮,UCF101 类别 ID: 9)

- 动作简介:篮球运动员在空中将球扣入篮筐的过程。

- 动作特点:包含起跳→ 空中持球 → 扣球,动作时间通常只有1-2秒

- 数据情况:,BasketballDunk 常见于比赛场景,容易与普通跑动、投篮背景混淆。动作较快。

- 截图展示:

3.3 Billiards(台球,UCF101 类别 ID: 12)

- 动作简介:台球选手用球杆击打母球的动作。

- 动作特点:瞄准准备 → 出杆击球。动作时间通常有5秒。

- 数据情况:在 THUMOS14 中,Billiards 多为室内场景,背景稳定,但击球瞬间动作幅度较小。

3.4 CleanAndJerk(举重挺举,UCF101 类别 ID: 21)

- 动作简介:举重运动员完成从抓起杠铃到将其举过头顶的动作。

- 动作特点:抓起 → 抬至肩部 → 挺举过头顶 → 稳定。动作时间通常有10-20秒。

- 数据情况:背景清晰,动作边界清晰

- 截图展示:

3.5(悬崖跳水,UCF101 类别 ID: 22)

- 动作简介:运动员从高处或悬崖跳入水中的动作。

- 动作特点:准备起跳 → 腾空 → 入水。动作时间通常有3-4秒。

- 数据情况:背景复杂(如海边、悬崖),动作变化大,但整体时序清晰,易于标注。

- 截图展示:

3.6 CricketBowling(板球投球,UCF101 类别 ID: 23)

- 动作简介:板球投手以奔跑助力并将球投向击球手的过程。

- 动作特点:助跑 → 手臂大幅度挥动 → 投球出手。动作时间通常1-2秒。

- 数据情况:动作幅度大,速度快,与 CricketShot(板球击球) 同场出现,助跑部分容易与普通跑动背景混淆。

- 截图展示:

3.7 CricketShot(板球击球,UCF101 类别 ID: 24)

- 动作简介:板球击球手挥动球棒击打来球的过程。

- 动作特点:准备站姿 → 挥棒击球。时间特别短,通常为1s

- 数据情况:在 THUMOS14 中,CricketShot 和 CricketBowling 经常在同一视频中连续出现,需要模型区分不同角色的动作。

3.8 Diving(跳水,UCF101 类别 ID: 26)

- 动作简介:运动员从跳台或跳板起跳,完成空中姿态变化并入水的动作。

- 动作特点:起跳 → 空中翻转/伸展 → 入水。时长1-2s

- 数据情况:在 THUMOS14 中,Diving 视频背景较为统一,多为泳池场景。和悬崖跳水有部分重复,大多场景是在泳池

- 截图展示:

3.9 FrisbeeCatch(飞盘接力,UCF101 类别 ID: 31)

- 动作简介:飞盘从一人手中抛出后,被另一人成功接住的过程。

- 动作特点:一个人扔飞盘 →另一个人(奔跑后)接飞盘 ,持续时间较短

- 数据情况:在 THUMOS14 中,FrisbeeCatch 多出现在户外场景,伴随多人运动。

- 截图展示:

3 ActivityNet数据集

目前最大的数据库,包含分类和检测两个任务。这个数据集仅提供视频的youtube链接,而不能直接下载视频,所以还需要用python中的youtube下载工具来自动下载。3.1 来源与种类

ActivityNet 数据集 由 Heilbron 等人于 2015 年在 CVPR 上提出,是一个用于大规模视频动作识别与时序动作定位的公开基准数据集。

ActivityNet v1.2:包含 100 类动作、13,000 多个视频,总时长约 800 小时。

ActivityNet v1.3:扩展至 200 类动作、约 20,000 个视频,总时长约 648 小时,是目前主流版本。

官网主页:https://activity-net.org

3.2 文件组成

ActivityNet 数据集官方提供:

- 视频文件(.mp4)

- 标注文件(.json)

- 元数据(类别层级结构、视频统计信息)

- 预计算特征(C3D、I3D 提取的 RGB 与光流特征)

支持分类(Action Recognition)和时序动作定位(TAL)两类任务。

3.3 视频文件解析

- 格式:.mp4 文件

- 文件命名:以视频 ID 命名

- 数量:v1.3 版本共约 20,000 个视频,总时长 648 小时。

- 划分:训练集(training)、验证集(validation)、测试集(testing)。

3.4 JSON标注文件

文件名:activity_net.v1-3.min.json

文件内容:"v_QOlSCBRmfWY": {

"duration_second": 82.73,

"duration_frame": 2067,

"annotations": [

{"segment": [6.195294851794072, 77.73085420904837], "label": "Ballet"}

],

"feature_frame": 2064

}

字段含义:

视频ID、视频时长、视频总帧数、动作发生的时间区间、动作类别、特征帧数

下载地址:https://github.com/wzmsltw/BSN-boundary-sensitive-network/tree/master/data

3.5 其他文件

4.5.1 预计算特征文件(Pre-computed Features)

官方提供基于 C3D 和 I3D 模型提取的 RGB 与光流特征

3.6 与模型匹配

在 时序动作定位(TAL) 与 弱监督时序动作定位(WTAL) 任务中,ActivityNet 常被用作模型验证的标准大规模基准:

- 训练阶段:

使用 .mp4 视频或预计算的 I3D/C3D 特征作为输入,结合 JSON 文件中的类别标签进行监督训练。对于弱监督任务,仅使用视频级标签训练模型以推断时间边界。 - 测试阶段:

使用提供的时间标注文件验证模型的预测边界精度,常以 t-IoU 与 mAP 作为评估指标。

4.评价指标

本研究采用 mean Average Precision (mAP) 作为主要评价指标。

在不同时间交并比 (t-IoU = 0.1~0.7) 下分别计算 mAP@tIoU,

并对全部阈值取平均得到 Average mAP,