「深度学习笔记1」深度学习全面解析:从基本概念到未来趋势

一文读懂深度学习的核心原理、发展历程与应用场景

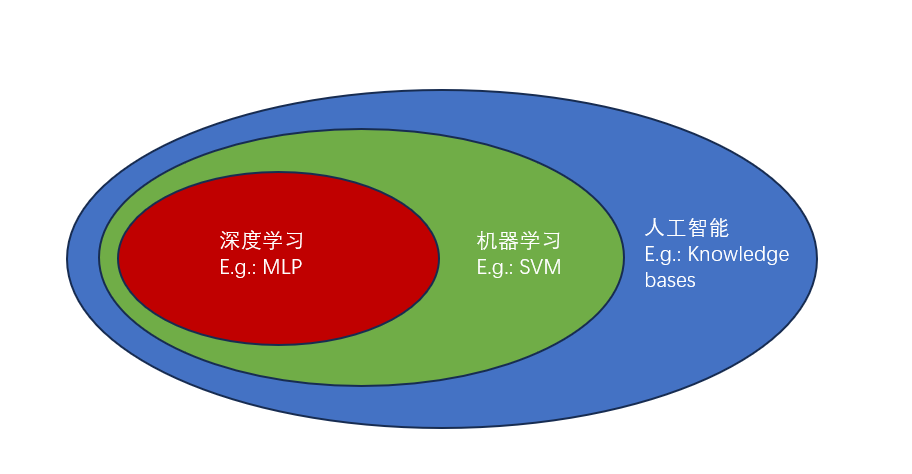

1. 人工智能、机器学习与深度学习的层次关系

让我们通过一个生活中的例子来理解这三者的关系。假设我们要教计算机识别猫的照片:

- 人工智能是最终目标:“让计算机能像人一样识别猫”

- 机器学习是实现方法:“给计算机看大量猫的照片,让它自己总结规律”

- 深度学习是具体技术:“使用多层神经网络自动从像素中学习猫的特征”

1.1 人工智能:智能科学的广阔天地

人工智能的概念最早在1956年达特茅斯会议上由约翰·麦卡锡正式提出,目标是让机器模拟人类智能行为。想象一下,如果人工智能是一个大学,那么它下面有多个不同的专业方向:

- 专家系统:像老中医一样,把经验规则编码成"如果-那么"规则

- 自然语言处理:让计算机理解、生成人类语言

- 计算机视觉:让机器"看懂"图像和视频

- 机器学习:让计算机通过数据自动学习规律

1.2 机器学习:实现AI的核心路径

传统编程是"输入数据+规则=输出结果",而机器学习是"输入数据+输出结果=学习规则"。这就好比教孩子认猫:不是告诉他"猫有尖耳朵、胡须",而是给他看各种猫的照片,让他自己发现规律。

机器学习的核心优势在于:

- 数据驱动:数据越多,性能越好

- 自动优化:能从错误中自动调整改进

- 泛化能力:学会后能识别没见过的猫品种

1.3 深度学习:机器学习的前沿阵地

深度学习的"深度"体现在多层网络结构上。就像我们认识猫的过程:先看出边缘和轮廓(底层特征),再组合成眼睛、鼻子(中层特征),最后形成完整的猫的概念(高层特征)。

表1:人工智能各分支领域比较

| 领域 | 核心方法 | 好比 | 应用场景 |

|---|---|---|---|

| 专家系统 | 规则库和推理机 | 老中医凭经验开药方 | 医疗诊断、故障分析 |

| 机器学习 | 统计学习算法 | 学生通过做题提高成绩 | 推荐系统、欺诈检测 |

| 深度学习 | 深层神经网络 | 婴儿通过观察学习认人 | 图像识别、语音识别 |

2. 深度学习的发展历程:三起两落的波澜壮阔

2.1 早期奠基(1940s-1960s):充满希望的起步

- 1943年:McCulloch和Pitts提出M-P神经元模型,开创了神经网络研究的先河

- 1958年:Frank Rosenblatt提出感知机模型,首次实现可通过学习改进的神经网络

- 1960年:Widrow和Hoff提出ADALINE模型和LMS算法,成为现代梯度下降的先驱

此时的神经网络就像刚发明的汽车,虽然概念先进,但性能和实用性还远远不够。

2.2 第一次AI寒冬(1970s):理想与现实的差距

1969年,Minsky和Papert出版了《Perceptrons》,指出单层神经网络连简单的"异或"问题都无法解决。这好比发现新发明的汽车居然不能转弯,导致研究资金大幅减少,神经网络进入第一个寒冬期。

2.3 复兴与发展(1980s-1990s):技术积累期

- 1980年代:反向传播算法重新激发研究热情

- 1986年:Rumelhart等人发表反向传播的里程碑论文

- 1990年代:支持向量机等传统机器学习方法占据主导

2.4 深度学习的爆发(2006年至今):一鸣惊人

- 2006年:Hinton等人提出深度信念网络,开启"深度学习革命"

- 2012年:AlexNet在ImageNet竞赛中一鸣惊人,将错误率从26%大幅降低到15%

- 2016年:AlphaGo击败李世石,让全世界看到深度学习的强大潜力

3. 深度学习的技术原理:揭开"黑箱"之谜

3.1 神经网络的基本结构:模仿大脑的工作原理

人脑由千亿个神经元相互连接而成,深度学习网络是对这一结构的简化模拟:

输入层 → [隐藏层1 → 隐藏层2 → ... → 隐藏层N] → 输出层

举个例子:识别手写数字"7"

- 输入层:接收28×28=784个像素值

- 隐藏层:第一层识别笔画边缘,第二层组合成角度和交叉点,第三层形成数字部件

- 输出层:判断是0-9中哪个数字的概率最大

3.2 关键算法突破:解决训练难题

反向传播算法是深度学习训练的引擎。好比教孩子认字:先让他猜这是什么字(前向传播),然后告诉他正确答案(计算误差),再从后往前调整每个笔画的权重(反向传播)。

ReLU激活函数解决了梯度消失问题,让深层网络训练成为可能。这就像给神经网络安装了"放大器",信号在多层传递后不会衰减消失。

3.3 深度学习vs传统机器学习:本质区别

| 特性 | 传统机器学习 | 深度学习 | 生活比喻 |

|---|---|---|---|

| 特征处理 | 需要人工设计特征 | 自动学习特征 | 手工做菜 vs 全自动厨房 |

| 数据需求 | 小规模数据 | 需要大规模数据 | 背单词表 vs 沉浸式外语环境 |

| 计算需求 | CPU即可 | 需要GPU等专用硬件 | 自行车 vs 高铁 |

| 可解释性 | 相对较好 | "黑箱"问题 | 说明书清晰的家电 vs 智能魔法盒 |

4. 深度学习的核心网络架构:四大金刚各显神通

4.1 卷积神经网络(CNN):图像识别的王者

CNN通过局部连接和权重共享大幅减少参数数量。想象一下认人脸时,我们不会一次看整张脸,而是先注意眼睛、鼻子等局部特征,再组合成完整印象。

经典CNN模型演进:

- LeNet-5(1998):成功应用于银行支票手写数字识别

- AlexNet(2012):在ImageNet竞赛中一战成名

- ResNet(2015):通过"短路连接"解决深层网络训练难题

4.2 循环神经网络(RNN):处理序列数据的专家

RNN专为序列数据设计,具有"记忆"能力。好比我们理解句子时,会记住前面的词汇,从而理解整个句子的含义。

LSTM是RNN的重要变体,解决了长期依赖问题,在机器翻译、语音识别中表现卓越。

4.3 生成对抗网络(GAN):最具创意的网络

GAN由生成器和判别器组成,通过"左右互搏"不断提升。这就像古董鉴定师(判别器)与仿造者(生成器)的博弈,最终仿造者能做出以假乱真的作品。

4.4 Transformer:自然语言处理的革命者

基于自注意力机制,Transformer彻底改变了自然语言处理领域,成为ChatGPT等大语言模型的基础。

5. 深度学习的实际应用:从实验室到日常生活

5.1 计算机视觉:效果最显著的领域

在ImageNet图像分类任务中,深度学习将错误率从2010年的28.2%降至2015年的3.57%,甚至超越人类水平(5.1%)。

实际应用案例:

- 医疗影像:腾讯AI Lab的系统可自动标记微小结节,阅片效率提升4倍

- 人脸识别:支付宝刷脸支付准确率超过99%

- 自动驾驶:特斯拉Autopilot能实时识别行人、车辆和交通标志

5.2 自然语言处理:让机器理解人类语言

- 智能客服:京东AI客服能理解消费者情绪,提供有温度的服务

- 机器翻译:百度翻译支持200多种语言,质量接近人工翻译

- 内容生成:AI写作助手能自动生成新闻稿、诗歌等内容

5.3 语音识别与合成:实现自然交互

深度学习将语音识别错误率从传统方法的30%以上降至6%以下,使Siri、小爱同学等智能助手成为可能。

6. 深度学习的挑战与风险:光明前景下的阴影

6.1 技术挑战:尚未解决的难题

对抗样本是深度学习的安全隐患。在熊猫图片上添加人眼难以察觉的噪声,就能让模型误认为是"鸵鸟"。这类似于人类视觉错觉,但对AI系统的影响更为严重。

其他技术挑战包括:

- 数据依赖:需要大量标注数据,在医疗等数据稀缺领域应用受限

- 可解释性:决策过程如"黑箱",影响在金融、司法等关键领域的应用

- 计算资源:训练大型模型能耗惊人,引发环境担忧

6.2 伦理与社会问题:技术向善的思考

- 隐私风险:人脸识别技术可能被用于大规模监控

- 算法偏见:训练数据中的偏见会导致歧视性决策

- 就业影响:自动化可能取代部分人工工作,需社会政策调整

7. 未来展望:深度学习将走向何方?

7.1 技术趋势:更智能、更高效、更可信

- 自监督学习:减少对人工标注数据的依赖,让模型从海量无标注数据中学习

- 神经架构搜索:自动化网络设计过程,发现更优的模型结构

- 可解释AI:提高模型透明度,建立用户信任,让AI决策过程"看得见、看得懂"

7.2 应用前景:赋能千行百业

- 科学发现:AlphaFold2破解蛋白质结构预测难题,加速新药研发

- AI原生应用:深度融合AI技术的新型产品和服务将不断涌现

- 人机协同:AI不是取代人类,而是增强人类能力,实现更高效的协作

总结

深度学习作为人工智能领域最具影响力的技术之一,已经深刻改变了多个行业的面貌。从早期的神经网络研究到如今的深度学习革命,这一领域经历了多次起伏,但始终保持着强大的发展动力。

对于技术从业者而言,理解深度学习的基本原理、发展历程和应用场景,是在智能时代保持竞争力的关键。正如深度学习通过多层网络从简单特征逐步构建复杂表示一样,我们的学习也需要从基础开始,循序渐进,最终掌握这一强大工具的精髓。

未来已来,深度学习将继续推动技术创新,为人类社会创造更大价值。让我们以开放的心态拥抱这一变革,同时保持理性的思考,确保技术发展始终服务于人类的福祉。