【ComfyUI】SDXL Revision 文本提示实现参考图像概念迁移生成

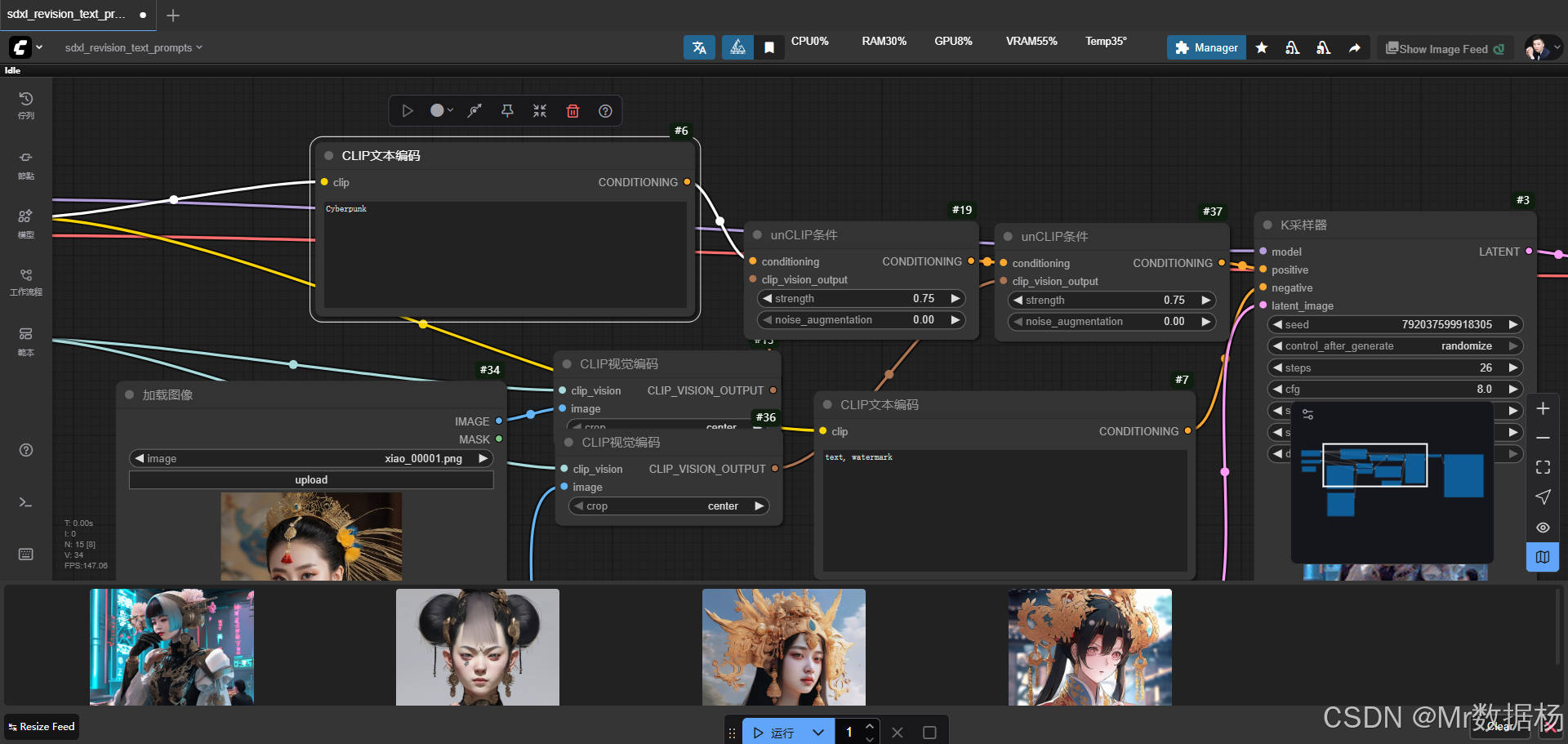

今天带来的是一个基于 ComfyUI 的工作流案例,它结合了图像输入与文本条件,通过 CLIP 编码器和 Stable Diffusion XL 的强大生成能力,将图像特征与文字描述进行融合,最终实现艺术化的场景合成。

整个过程的演示效果直观地展示了如何从多张输入图像和提示词中,生成具有一致风格和高度细节的图像结果。该工作流特别适用于需要多模态信息融合的创作场景,例如风景重绘、艺术风格再创造或文本引导下的视觉合成。

文章目录

- 工作流介绍

- 核心模型

- Node节点

- 工作流程

- 应用场景

- 开发与应用

工作流介绍

本工作流通过加载 Stable Diffusion XL 模型作为生成核心,结合 CLIP 文本和视觉编码器完成条件约束,并通过 unCLIPConditioning 与 KSampler 的配合实现潜在空间中的图像采样与合成。整个管线涵盖了从输入图像与文本提示的特征提取,到潜在图像生成,再到最终的解码与保存。整体流程在保证生成多样性的同时,也维持了视觉一致性。

核心模型

在模型配置中,Stable Diffusion XL 被用作主要的生成模型,负责在潜在空间中进行采样与合成;同时加载了 CLIP 模型来处理文本提示,使语义条件能直接参与到生成中;VAE 模型则负责对潜在向量与可视化图像进行编码与解码,保证生成结果的高保真度。此外,还引入了 CLIP Vision 模型,使得输入的参考图像可以被转化为视觉特征,并进一步与文本提示结合,用于指导生成。

| 模型名称 | 说明 |

|---|---|

| sd_xl_base_1.0.safetensors | 主要生成模型,负责在潜在空间中完成采样和图像合成 |

| CLIP | 文本编码模型,将提示词转化为可供采样器理解的语义向量 |

| VAE | 编码与解码潜在向量,保证生成图像与原始输入空间的映射 |

| clip_vision_g.safetensors | 图像编码模型,用于将输入参考图像转化为视觉特征向量 |

Node节点

工作流的节点覆盖了从输入数据到最终结果的完整链路。LoadImage 节点负责加载参考图像作为输入源,CLIPTextEncode 与 CLIPVisionEncode 节点分别处理文本提示与图像特征,并通过 unCLIPConditioning 节点将多模态信息融合。EmptyLatentImage 提供潜在空间的初始噪声,KSampler 在模型与条件的指导下生成潜在图像,随后由 VAEDecode 节点解码为最终图像,最后通过 SaveImage 节点完成保存。整个节点组合清晰地展现了 ComfyUI 工作流在多模态条件控制下的强大能力。

| 节点名称 | 说明 |

|---|---|

| LoadImage | 加载参考图像作为输入数据 |

| CLIPTextEncode | 将文本提示转化为语义向量 |

| CLIPVisionEncode | 将输入图像转化为视觉特征 |

| unCLIPConditioning | 融合文本与图像特征,形成生成条件 |

| EmptyLatentImage | 创建潜在空间的初始噪声图像 |

| KSampler | 在条件引导下采样生成潜在图像 |

| VAEDecode | 将潜在向量解码为实际图像 |

| SaveImage | 输出并保存生成图像 |

工作流程

该工作流的运行机制围绕潜在空间的生成与解码展开,流程从图像与文本的双输入开始,经由特征提取与条件融合,逐步进入潜在空间采样环节,最终解码并输出结果。在这一过程中,参考图像与提示词的结合,使得生成内容能够兼具语义控制与视觉风格传递。EmptyLatentImage 节点为采样器提供初始噪声图,unCLIPConditioning 则在不同阶段对文本和图像特征进行叠加,保证了采样的连贯性和细节丰富度。经过 KSampler 的迭代采样,潜在向量被送入 VAE 解码器生成真实图像,并由 SaveImage 节点完成存储与输出。整体流程形成了一条从输入到生成的高效链路,突出了 ComfyUI 在复杂生成场景中的可操作性与灵活性。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 数据输入 | 加载参考图像并准备文本提示条件 | LoadImage、CLIPTextEncode |

| 2 | 特征提取 | 将输入图像转化为视觉特征向量 | CLIPVisionEncode |

| 3 | 条件融合 | 融合文本与图像特征,生成多模态条件 | unCLIPConditioning |

| 4 | 潜在初始化 | 创建初始潜在空间作为采样起点 | EmptyLatentImage |

| 5 | 潜在采样 | 在条件约束下进行迭代采样生成潜在图像 | KSampler |

| 6 | 解码重建 | 将潜在向量还原为可视化图像 | VAEDecode |

| 7 | 结果输出 | 保存并导出最终生成图像 | SaveImage |

应用场景

该工作流的应用场景集中在需要多模态融合和视觉再创造的领域。通过结合文本提示与图像参考,既能保持原始画面的结构与风格,又能在细节上进行重新塑造,因此非常适合艺术风格转换、风景场景重绘、海报与插画创作等场景。在设计创作中,可以通过不同的文本描述引导生成出更符合主题需求的视觉作品;在数据增强中,可以利用该流程快速生成多样化的样本,用于训练视觉模型。对于创作者、设计师或研究人员而言,这样的流程不仅提升了创作效率,还拓展了视觉表达的自由度和实验性。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 艺术创作 | 在图像参考基础上加入风格化元素 | 插画师、设计师 | 风景、角色、艺术作品 | 保持场景结构同时增强艺术表现力 |

| 风格重绘 | 改造已有图像的风格与氛围 | 数字艺术创作者 | 自然风光、城市景观 | 快速完成不同风格的再创作 |

| 视觉合成 | 融合文本与图像生成新场景 | 研究人员、内容制作者 | 多模态实验图像 | 精细控制图像语义与视觉特征 |

| 数据增强 | 生成多样化训练数据 | AI 研究人员 | 样本扩展 | 提高模型鲁棒性与泛化能力 |

| 商业设计 | 结合广告需求定制图像 | 创意团队 | 宣传海报、广告素材 | 在限定风格下高效生成高质量内容 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

ComfyUI使用教程、开发指导、资源下载

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用