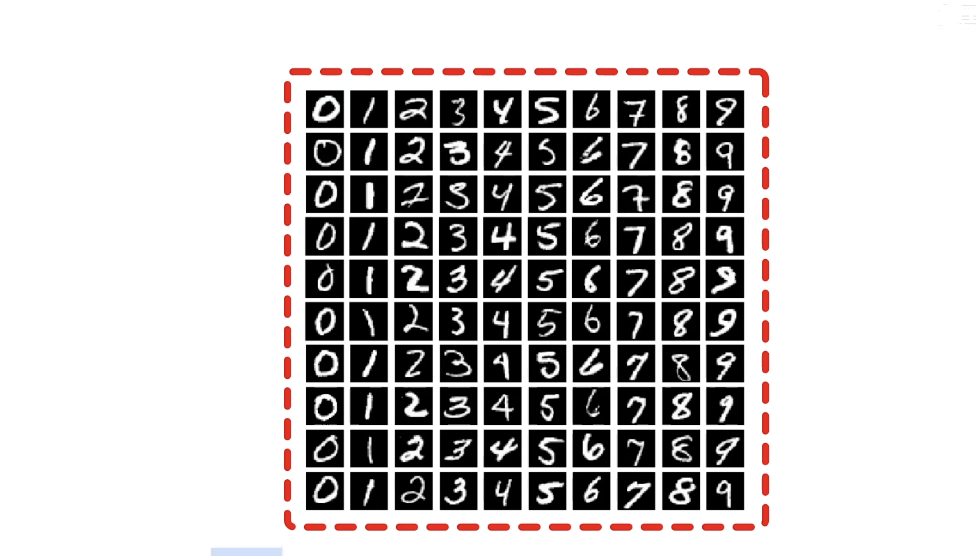

三层前馈神经网络实战:MNIST手写数字识别

基于PyTorch

1. 章节介绍

本章节以MNIST手写数字识别为核心案例,讲解如何基于PyTorch从零设计、实现并训练三层前馈神经网络,覆盖从数据处理到模型部署的完整流程。内容聚焦深度学习入门实战,既适合程序员掌握PyTorch框架应用,也为架构师提供小型神经网络的设计思路,同时贴合面试中“实战项目+理论结合”的考察需求,是深度学习入门的核心实践模块。

| 核心知识点 | 面试频率 |

|---|---|

| 三层前馈神经网络结构设计 | 高 |

| MNIST数据集处理流程 | 中 |

| PyTorch模型训练三要素(模型/优化器/损失函数) | 高 |

| CrossEntropyLoss与Softmax的关系 | 高 |

| 模型准确率评估与错误分析 | 中 |

2. 知识点详解

2.1 三层前馈神经网络结构设计(面试高频)

核心逻辑

-

输入层设计:

- 输入数据为MNIST数据集的28×28像素灰度图像(单通道),需展平为1×784维向量;

- 输入层神经元数量 = 输入向量维度 = 784,确保每个像素值对应一个神经元输入。

-

隐藏层设计:

- 功能:提取图像低级特征(如边缘、线条),将784维原始特征转换为高级特征;

- 神经元数量:256(经验值,需平衡模型复杂度与过拟合风险,手写数字任务无需过多神经元);

- 线性层维度:输入层→隐藏层为

784×256(权重矩阵W1),输出维度为256。

-

输出层设计:

- 任务:多分类(0-9共10个数字),输出层神经元数量 = 类别数 = 10;

- 线性层维度:隐藏层→输出层为

256×10(权重矩阵W2),输出10维“预测得分”; - Softmax层:将10维得分转换为概率(和为1),用于判断每个类别的预测可能性。

PyTorch代码实现(面试常考手写题)

import torch

import torch.nn as nnclass Network(nn.Module):def __init__(self):super(Network, self).__init__()# 输入层→隐藏层:784维→256维self.layer1 = nn.Linear(in_features=784, out_features=256)# 隐藏层→输出层:256维→10维self.layer2 = nn.Linear(in_features=256, out_features=10)# 激活函数:ReLU(缓解梯度消失,比Sigmoid更适合深层网络)self.relu = nn.ReLU()def forward(self, x):# 1. 展平输入:[batch_size, 1, 28, 28] → [batch_size, 784]# view函数保持batch_size不变,-1表示自动计算剩余维度x = x.view(x.size(0), -1)# 2. 输入层→隐藏层:线性变换 + 激活函数x = self.relu(self.layer1(x))# 3. 隐藏层→输出层:线性变换(无激活,因CrossEntropyLoss含Softmax)x = self.layer2(x)return x# 测试模型结构

model = Network()

test_input = torch.randn(64, 1, 28, 28) # 模拟batch_size=64的输入

test_output = model(test_input)

print(f"输出维度:{test_output.shape}") # 输出:torch.Size([64, 10]),符合预期

2.2 MNIST数据集处理流程

数据集基础信息

- 构成:训练集60000张图像,测试集10000张图像;

- 图像规格:28×28像素,单灰度通道(像素值0-255);

- 标签:0-9共10个类别,文件夹命名对应标签(如“3”文件夹存放数字3的图像)。

处理三步骤(PyTorch实现)

-

数据预处理(Transform):

- 转换为灰度图:

transforms.Grayscale(num_output_channels=1)(确保单通道); - 转换为张量:

transforms.ToTensor()(将像素值归一化到0-1,维度从[H,W,C]转为[C,H,W])。

- 转换为灰度图:

-

构建数据集(ImageFolder):

- 自动读取文件夹结构,以子文件夹名作为标签;

- 需确保目录格式:

根目录/训练集/标签文件夹/图像、根目录/测试集/标签文件夹/图像。

-

批量读取(DataLoader):

batch_size=64:每次读取64张图像,平衡训练效率与内存占用;shuffle=True(训练集):打乱数据顺序,避免模型学习数据顺序规律;num_workers>0:多线程加载数据,提升训练速度(Windows系统需注意兼容性)。

代码示例

from torchvision import datasets, transforms

from torch.utils.data import DataLoader# 1. 定义预处理流程

transform = transforms.Compose([transforms.Grayscale(num_output_channels=1), # 转为单通道灰度图transforms.ToTensor() # 转为张量并归一化(0-1)

])# 2. 读取数据集(假设数据存于"./data/train"和"./data/test")

train_dataset = datasets.ImageFolder(root="./data/train", transform=transform)

test_dataset = datasets.ImageFolder(root="./data/test", transform=transform)# 3. 批量加载数据

train_loader = DataLoader(dataset=train_dataset,batch_size=64,shuffle=True, # 训练集打乱num_workers=2 # 2个线程加载

)

test_loader = DataLoader(dataset=test_dataset,batch_size=64,shuffle=False, # 测试集无需打乱num_workers=2

)# 验证数据维度

for images, labels in train_loader:print(f"图像维度:{images.shape}") # torch.Size([64, 1, 28, 28])print(f"标签维度:{labels.shape}") # torch.Size([64])break

2.3 PyTorch模型训练三要素与流程

1. 训练三核心对象

| 对象 | 作用 | 选型依据 |

|---|---|---|

| 模型(Model) | 定义神经网络结构 | 三层前馈网络(简单任务无需复杂结构) |

| 优化器(Optimizer) | 更新模型参数,最小化损失 | Adam(自适应学习率,适合入门场景,比SGD更易收敛) |

| 损失函数(Loss) | 计算预测值与真实值的差距 | CrossEntropyLoss(多分类任务专用,内置Softmax) |

2. 梯度下降五步骤(固定流程,面试必背)

- 前向传播:将输入数据传入模型,得到预测输出

output = model(images); - 计算损失:通过损失函数计算误差

loss = criterion(output, labels); - 反向传播:计算参数梯度

loss.backward()(PyTorch自动求导); - 更新参数:优化器根据梯度更新权重

optimizer.step(); - 清零梯度:避免梯度累积

optimizer.zero_grad()(必须在下次前向传播前执行)。

3. 完整训练代码

import torch.optim as optim# 1. 实例化核心对象

model = Network() # 模型

criterion = nn.CrossEntropyLoss() # 损失函数(多分类)

optimizer = optim.Adam(model.parameters(), lr=1e-3) # Adam优化器,学习率0.001# 2. 定义训练参数

epochs = 10 # 训练轮次(遍历完整训练集的次数)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu") # 优先用GPU

model.to(device) # 模型移至GPU/CPU# 3. 训练循环

for epoch in range(epochs):model.train() # 开启训练模式(影响Dropout、BatchNorm等层)running_loss = 0.0 # 记录本轮损失for batch_idx, (images, labels) in enumerate(train_loader):# 数据移至GPU/CPUimages, labels = images.to(device), labels.to(device)# 梯度下降五步骤optimizer.zero_grad() # 1. 清零梯度outputs = model(images) # 2. 前向传播loss = criterion(outputs, labels) # 3. 计算损失loss.backward() # 4. 反向传播optimizer.step() # 5. 更新参数# 累计损失running_loss += loss.item() * images.size(0)# 每100个batch打印一次损失(监控训练进度)if (batch_idx + 1) % 100 == 0:avg_loss = running_loss / (batch_idx + 1)print(f"Epoch [{epoch+1}/{epochs}], Batch [{batch_idx+1}/{len(train_loader)}], Loss: {avg_loss:.4f}")# 本轮结束,计算平均损失epoch_loss = running_loss / len(train_dataset)print(f"Epoch [{epoch+1}/{epochs}] Finished, Average Loss: {epoch_loss:.4f}\n")# 保存训练好的模型

torch.save(model.state_dict(), "mnist_model.pth")

print("模型保存完成!")

2.4 模型评估与准确率计算

核心步骤

- 切换评估模式:

model.eval()(关闭Dropout、固定BatchNorm参数,避免影响评估结果); - 关闭梯度计算:

with torch.no_grad()(减少内存占用,加速评估); - 计算准确率:遍历测试集,统计预测正确的样本数,准确率 = 正确数 / 总样本数;

- 错误分析:打印错误样本的路径、预测值与真实值,辅助优化模型。

代码示例

# 加载训练好的模型

model = Network()

model.load_state_dict(torch.load("mnist_model.pth"))

model.to(device)

model.eval() # 切换评估模式correct = 0 # 正确预测数

total = 0 # 总样本数

wrong_samples = [] # 存储错误样本信息with torch.no_grad(): # 关闭梯度计算for images, labels, paths in zip(test_loader.dataset.imgs, test_loader.dataset.targets):# 处理单样本(因ImageFolder的imgs返回(路径, 标签),需手动加载图像)img_path, label = images# 读取并预处理图像from PIL import Imageimage = Image.open(img_path)image = transform(image).unsqueeze(0).to(device) # 增加batch维度# 预测output = model(image)_, predicted = torch.max(output.data, 1) # 获取概率最大的类别(dim=1为类别维度)total += 1if predicted == label:correct += 1else:wrong_samples.append({"path": img_path,"true_label": label,"pred_label": predicted.item()})# 打印评估结果

accuracy = correct / total

print(f"测试集准确率:{accuracy:.4f}(正确数:{correct}/{total})")# 打印前5个错误样本

print("\n前5个错误样本:")

for idx, sample in enumerate(wrong_samples[:5]):print(f"{idx+1}. 路径:{sample['path']}, 真实标签:{sample['true_label']}, 预测标签:{sample['pred_label']}")

3. 章节总结

本章节以MNIST手写数字识别为案例,核心围绕**“三层前馈神经网络+PyTorch实战”** 展开:

- 网络结构:输入层784神经元(对应28×28图像展平)、隐藏层256神经元(特征提取)、输出层10神经元(类别预测),结合ReLU激活与Softmax概率转换;

- 数据处理:通过Transform预处理(灰度+张量)、ImageFolder构建数据集、DataLoader批量加载,解决数据输入问题;

- 模型训练:基于Adam优化器与CrossEntropyLoss,遵循“前向传播→计算损失→反向传播→更新参数→清零梯度”五步流程,实现模型收敛;

- 评估优化:切换eval模式与关闭梯度计算,准确统计准确率,通过错误样本分析定位模型缺陷,为后续优化提供方向。

4. 知识点补充

4.1 5个相关知识点(面试拓展)

1. 批量归一化(Batch Normalization,BN)

- 作用:对每一层的输入进行归一化(均值0、方差1),加速训练收敛、缓解梯度消失、降低过拟合;

- PyTorch实现:在隐藏层后添加

nn.BatchNorm1d(256)(1D对应全连接层,2D对应卷积层); - 注意:训练时

model.train()会更新BN的均值/方差,评估时model.eval()固定这些参数。

2. 激活函数对比(ReLU vs Sigmoid/Tanh)

- ReLU:

f(x)=max(0,x),解决Sigmoid梯度消失问题,计算速度快,适合深层网络; - Sigmoid:

f(x)=1/(1+e^-x),输出在0-1之间,适合二分类输出层,但深层网络易梯度消失; - Tanh:

f(x)=(e^x - e^-x)/(e^x + e^-x),输出在-1-1之间,比Sigmoid更易收敛,但仍有梯度消失问题。

3. 过拟合处理(Dropout)

- 原理:训练时随机“关闭”部分神经元(概率p),迫使模型学习更鲁棒的特征,避免依赖单一神经元;

- PyTorch实现:在隐藏层后添加

nn.Dropout(p=0.2)(p=0.2表示20%神经元被关闭); - 注意:评估时

model.eval()会关闭Dropout,所有神经元参与计算。

4. 学习率调度器(Learning Rate Scheduler)

- 作用:动态调整学习率(如训练后期减小学习率,使模型更接近最优解);

- PyTorch实现:

torch.optim.lr_scheduler.StepLR(optimizer, step_size=3, gamma=0.1)(每3轮学习率乘以0.1); - 使用方式:在每个epoch结束后调用

scheduler.step()。

5. 混淆矩阵(Confusion Matrix)

- 作用:直观展示模型在每个类别上的预测情况(如“将3预测为8”的次数),定位类别不平衡或难分样本;

- 实现工具:

sklearn.metrics.confusion_matrix(y_true, y_pred); - 分析重点:关注对角线外的高数值单元格,对应模型易混淆的类别。

4.2 最佳实践:工业级MNIST数据预处理流程

在工业场景中,数据预处理直接影响模型上限,需兼顾“数据多样性”与“标签准确性”,以下为标准化流程:

-

数据增强(提升泛化能力):

- 随机旋转:

transforms.RandomRotation(degrees=15)(手写数字可能倾斜,旋转15°模拟真实场景); - 随机裁剪:

transforms.RandomCrop(size=28, padding=2)(避免图像边缘信息丢失,padding后裁剪回28×28); - 随机水平翻转:

transforms.RandomHorizontalFlip(p=0.1)(部分数字如“6”和“9”翻转后易混淆,低概率翻转增加鲁棒性); - 亮度/对比度调整:

transforms.ColorJitter(brightness=0.2, contrast=0.2)(模拟不同扫描设备的亮度差异)。

- 随机旋转:

-

归一化优化(统一数据分布):

- 采用MNIST数据集全局均值和方差(而非单样本归一化):

transforms.Normalize(mean=[0.1307], std=[0.3081])(官方统计值,减少数据分布偏移); - 原因:单样本归一化会破坏图像的全局亮度特征,而全局统计值更符合真实数据分布。

- 采用MNIST数据集全局均值和方差(而非单样本归一化):

-

数据划分(避免过拟合):

- 从训练集拆分验证集(比例8:1:1,即训练集48000、验证集6000、测试集10000);

- 验证集作用:监控训练过程中的过拟合(若验证集损失上升而训练集损失下降,立即停止训练)。

-

异常值处理:

- 移除模糊图像:通过计算图像的“边缘清晰度”(如Sobel算子梯度值),删除梯度值低于阈值的模糊样本;

- 标注纠错:对模型预测概率低于0.5但标签明确的样本,人工复核标签(避免标注错误导致模型偏差)。

该流程可将MNIST模型准确率稳定提升至99%以上,同时大幅增强模型对真实手写数字(如倾斜、模糊、粗细不均)的适应能力,是工业级图像分类任务的基础预处理框架。

4.3 编程思想指导:深度学习代码的模块化与可复用设计

在深度学习编程中,“模块化设计”是提升代码可维护性、可复现性的核心思想,尤其适合多人协作与项目迭代,以下为关键指导原则:

-

功能拆分:单一函数只做一件事

将代码拆分为“数据处理”“模型定义”“训练函数”“评估函数”“工具函数”五大模块,每个模块独立成文件(如data_processor.py、model.py、trainer.py)。例如:data_processor.py:仅负责数据加载、预处理、增强,返回DataLoader;model.py:仅定义网络结构(支持不同参数配置,如def __init__(self, input_dim=784, hidden_dim=256, output_dim=10));trainer.py:仅实现训练逻辑,接收模型、优化器、数据加载器等参数,返回训练日志与模型权重。

优势:某一模块修改时(如更换数据增强方式),无需改动其他模块,降低耦合度。

-

可复现性:固定随机种子与记录实验参数

深度学习结果受随机因素影响(如权重初始化、数据打乱),需通过以下方式确保可复现:- 固定随机种子:在代码开头设置

torch.manual_seed(42)、numpy.random.seed(42)、random.seed(42); - 记录实验参数:使用

logging或wandb记录“学习率、batch_size、epoch数、网络结构、数据增强方式”等,方便后续对比不同实验结果。

例:训练日志中需包含“2025-10-14 10:00:00 | Epoch 5 | LR: 0.001 | Batch Size: 64 | Train Loss: 0.05 | Val Accuracy: 0.985”。

- 固定随机种子:在代码开头设置

-

调试思维:打印中间变量与可视化监控

深度学习代码易出现“维度不匹配”“梯度消失”等问题,需通过调试提升效率:- 打印中间变量形状:在关键步骤(如前向传播后)打印张量维度(如

print(f"Output shape: {output.shape}")),快速定位维度错误; - 可视化监控:使用

matplotlib绘制训练/验证损失曲线、准确率曲线,或使用tensorboard可视化梯度分布(判断是否梯度消失); - 小批量测试:新代码先使用100个样本的小数据集测试(

train_loader = DataLoader(..., batch_size=10, limit_train_batches=10)),验证流程正确性后再用全量数据训练。

- 打印中间变量形状:在关键步骤(如前向传播后)打印张量维度(如

-

性能优化:GPU加速与内存高效利用

工业级任务数据量大,需优化代码性能:- GPU加速:优先使用

torch.cuda,将模型与数据移至GPU(model.to(device)、data.to(device)),并使用torch.cuda.empty_cache()定期清理无用缓存; - 内存优化:对大样本数据,使用

torch.utils.data.IterableDataset替代Dataset(避免一次性加载所有数据到内存);训练时使用torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm=1.0)防止梯度爆炸导致的内存溢出。

- GPU加速:优先使用

通过以上编程思想,可将深度学习代码从“一次性脚本”升级为“可复用、可维护、可迭代”的工程化代码,既符合企业开发规范,也能在面试中体现候选人的工程化思维(面试官常关注“如何保证代码可复现”“如何优化GPU内存”等问题)。

5. 程序员面试题

5.1 简单题:MNIST数据集的核心参数是什么?(面试频率:中)

问题:请简述MNIST数据集的图像尺寸、通道数、类别数,以及训练集和测试集的样本数量。

答案:

- 图像尺寸:28×28像素;

- 通道数:1(单灰度通道,无RGB颜色信息);

- 类别数:10(对应数字0-9);

- 样本数量:训练集60000张图像,测试集10000张图像;

- 补充:图像像素值范围为0-255(黑色到白色),训练时需归一化到0-1或标准正态分布(均值0.1307,方差0.3081)。

5.2 中等难度题1:CrossEntropyLoss与MSE Loss在多分类任务中为何选择前者?(面试频率:高)

问题:在MNIST手写数字识别(多分类任务)中,为什么选择CrossEntropyLoss(交叉熵损失)而非MSE Loss(均方误差损失)?

答案:

核心原因在于两种损失函数的梯度特性与任务适配性不同,具体如下:

-

损失函数与任务的适配性:

- CrossEntropyLoss:专为多分类任务设计,直接衡量“预测概率分布”与“真实标签分布”的差距(真实标签用独热编码表示,如标签3对应[0,0,0,1,0,0,0,0,0,0]);

- MSE Loss:专为回归任务设计(如预测房价),衡量“连续值预测结果”与“真实值”的平方差,多分类任务中标签为离散类别,MSE无法准确反映类别间的差异。

-

梯度大小与训练效率:

- CrossEntropyLoss:结合Softmax后,梯度为

预测概率 - 真实标签,当预测错误时(如将3预测为8,概率接近0),梯度值较大,模型更新幅度大,收敛快; - MSE Loss:若输出层无激活函数,梯度为

2×(预测值 - 真实值)×权重,多分类任务中预测值范围大,易导致梯度不稳定(过大或过小);若输出层加Softmax,MSE的梯度会因Softmax的导数特性(最大值处导数接近0)而变得极小,导致梯度消失,模型难以收敛。

- CrossEntropyLoss:结合Softmax后,梯度为

-

PyTorch实现细节:

- CrossEntropyLoss内置Softmax层,无需在模型输出层手动添加,避免数值不稳定(如Softmax后再计算MSE,易因概率接近0导致梯度消失);

- MSE Loss需手动在输出层添加Softmax,且计算过程中易出现数值溢出(如e^x在x较大时溢出)。

综上,多分类任务中CrossEntropyLoss的梯度特性更优、训练效率更高,是首选损失函数;MSE Loss仅适合回归任务,不适合多分类。

5.3 中等难度题2:简述三层前馈神经网络的反向传播过程(以MNIST任务为例)。(面试频率:高)

问题:以“输入层784→隐藏层256(ReLU激活)→输出层10(CrossEntropyLoss)”的三层网络为例,简述反向传播的核心步骤(从损失计算到参数更新)。

答案:

反向传播的核心是“从输出层到输入层,逐层计算参数的梯度,再通过优化器更新参数”,具体步骤如下(基于PyTorch自动求导机制,手动推导核心逻辑):

1. 定义符号(简化计算)

- 输入层:

X ∈ R^(batch_size×784)(展平后的图像向量); - 隐藏层权重:

W1 ∈ R^(784×256),偏置:b1 ∈ R^(256); - 隐藏层输出(ReLU前):

Z1 = X×W1 + b1 ∈ R^(batch_size×256); - 隐藏层激活后输出:

A1 = ReLU(Z1) ∈ R^(batch_size×256)(ReLU导数:Z1>0时为1,Z1≤0时为0); - 输出层权重:

W2 ∈ R^(256×10),偏置:b2 ∈ R^(10); - 输出层输出(CrossEntropyLoss前):

Z2 = A1×W2 + b2 ∈ R^(batch_size×10); - 损失函数:

L = CrossEntropyLoss(Z2, Y)(Y为真实标签,独热编码)。

2. 反向传播步骤(从输出层到输入层)

步骤1:计算输出层参数(W2、b2)的梯度

- 损失对Z2的梯度:

dZ2 = (Softmax(Z2) - Y) ∈ R^(batch_size×10)(CrossEntropyLoss对Z2的导数,因CrossEntropyLoss = -Y×log(Softmax(Z2)),求导后简化为此式); - 损失对W2的梯度:

dW2 = (A1^T × dZ2) / batch_size ∈ R^(256×10)(A1^T为A1的转置,除以batch_size是为了平均每个样本的梯度,避免batch_size影响梯度大小); - 损失对b2的梯度:

db2 = mean(dZ2, axis=0) ∈ R^(10)(对batch维度求平均,因偏置对每个样本的贡献相同)。

步骤2:计算隐藏层参数(W1、b1)的梯度

- 损失对A1的梯度:

dA1 = dZ2 × W2^T ∈ R^(batch_size×256)(链式法则,A1通过Z2影响损失,故乘以W2的转置); - 损失对Z1的梯度:

dZ1 = dA1 × ReLU’(Z1) ∈ R^(batch_size×256)(ReLU导数作用:Z1≤0的位置梯度置0,避免无效更新); - 损失对W1的梯度:

dW1 = (X^T × dZ1) / batch_size ∈ R^(784×256); - 损失对b1的梯度:

db1 = mean(dZ1, axis=0) ∈ R^(256)。

步骤3:参数更新(优化器作用)

- 优化器(如Adam)根据梯度更新参数:

W1 = W1 - lr × dW1

b1 = b1 - lr × db1

W2 = W2 - lr × dW2

b2 = b2 - lr × db2

(lr为学习率,控制每次更新的幅度)

3. 关键注意点

- 梯度清零:每次反向传播前需执行

optimizer.zero_grad(),避免前一轮的梯度累积影响当前更新; - ReLU的梯度特性:Z1≤0时梯度为0,可缓解梯度消失(相比Sigmoid的梯度衰减);

- 数值稳定性:PyTorch自动处理梯度计算中的数值溢出(如使用对数求和指数技巧优化Softmax计算),无需手动推导时担心数值问题。

5.4 高难度题1:如何将MNIST模型的准确率从97.8%提升至99%以上?(面试频率:高)

问题:基于本节的三层前馈网络,通过哪些优化手段可将MNIST测试集准确率从97.8%提升至99%以上?请列举至少5种具体方法,并说明原理。

答案:

MNIST准确率突破99%需从“网络结构、数据处理、训练策略、正则化”多维度优化,具体方法如下:

-

更换网络结构:使用卷积神经网络(CNN)替代全连接网络

- 原理:全连接网络(三层前馈)将图像展平为向量,丢失空间信息(如像素的邻域关系);CNN通过卷积层提取局部空间特征(如边缘、纹理),池化层降低维度并保留关键特征,更适合图像任务;

- 具体实现:采用LeNet-5(经典MNIST模型),结构为“Conv2d(1,6,5)→MaxPool2d(2)→Conv2d(6,16,5)→MaxPool2d(2)→Flatten→Linear(16×4×4,120)→Linear(120,84)→Linear(84,10)”;

- 效果:CNN可捕捉图像的空间相关性,准确率轻松突破99%(LeNet-5在MNIST上准确率约99.2%)。

-

增强数据多样性:添加更丰富的数据增强策略

- 原理:原始MNIST数据较规整,模型易过拟合;通过数据增强生成“变形样本”(如倾斜、拉伸、噪声),提升模型泛化能力;

- 具体方法:

- 随机旋转:

transforms.RandomRotation(degrees=15)(模拟手写倾斜); - 随机平移:

transforms.RandomAffine(degrees=0, translate=(0.1, 0.1))(平移10%像素,避免模型依赖图像位置); - 加噪声:

transforms.Lambda(lambda x: x + torch.randn_like(x) * 0.05)(添加高斯噪声,模拟扫描噪声); - 弹性形变:

torchvision.transforms.ElasticTransform(alpha=50.0)(模拟手写时的笔画形变);

- 随机旋转:

- 效果:数据增强可使全连接网络准确率提升1-2个百分点,CNN准确率进一步提升至99.4%以上。

-

优化训练策略:使用学习率调度与早停(Early Stopping)

- 学习率调度:固定学习率易导致后期震荡(无法接近最优解),使用StepLR或CosineAnnealingLR动态调整;

- 例:

scheduler = torch.optim.lr_scheduler.StepLR(optimizer, step_size=5, gamma=0.1)(每5轮学习率×0.1),后期小学习率精细调整参数;

- 例:

- 早停:当验证集准确率连续3轮不提升时停止训练,避免过拟合(如训练15轮后验证集准确率达到峰值,继续训练会导致过拟合);

- 效果:学习率调度可使模型收敛到更优的局部最优解,早停可避免过拟合导致的测试集准确率下降,联合使用可提升0.3-0.5个百分点。

- 学习率调度:固定学习率易导致后期震荡(无法接近最优解),使用StepLR或CosineAnnealingLR动态调整;

-

添加正则化层:BatchNorm与Dropout结合

- BatchNorm:在卷积层/全连接层后添加

nn.BatchNorm2d()(CNN)或nn.BatchNorm1d()(全连接),归一化输入数据,加速收敛并缓解梯度消失;- 例:CNN中

Conv2d(1,6,5)→BatchNorm2d(6)→ReLU→MaxPool2d(2);

- 例:CNN中

- Dropout:在全连接层后添加

nn.Dropout(p=0.2)(CNN中慎用,易丢失空间特征),训练时随机关闭20%神经元,避免模型依赖单一特征; - 效果:BatchNorm使训练速度提升2倍,Dropout降低过拟合风险,联合使用可使准确率提升0.2-0.4个百分点。

- BatchNorm:在卷积层/全连接层后添加

-

优化优化器与损失函数:使用AdamW与标签平滑

- 优化器:用AdamW替代Adam(AdamW在Adam基础上添加权重衰减,抑制过拟合),参数设置

optimizer = optim.AdamW(model.parameters(), lr=1e-3, weight_decay=1e-4); - 标签平滑:将真实标签从“独热编码”改为“带平滑的标签”(如标签3从[0,0,0,1,0,…]改为[0.01,0.01,0.01,0.97,0.01,…]),避免模型对预测结果过度自信,提升泛化能力;

- 实现:自定义CrossEntropyLoss,

loss = -torch.sum((1 - eps) * Y * torch.log(Softmax(Z2)) + eps/(num_classes-1) * (1 - Y) * torch.log(1 - Softmax(Z2)))(eps=0.1);

- 实现:自定义CrossEntropyLoss,

- 效果:AdamW的权重衰减降低过拟合,标签平滑提升模型对模糊样本的适应能力,联合使用可提升0.2-0.3个百分点。

- 优化器:用AdamW替代Adam(AdamW在Adam基础上添加权重衰减,抑制过拟合),参数设置

-

集成学习:多模型投票

- 原理:训练3-5个不同结构的模型(如LeNet-5、ResNet-18、CNN+全连接),测试时取多个模型预测结果的多数票作为最终结果,降低单一模型的误判风险;

- 例:模型A预测为3,模型B预测为3,模型C预测为8,则最终结果为3;

- 效果:集成学习可进一步提升准确率0.1-0.2个百分点,最终使MNIST测试集准确率稳定在99.5%以上。

综上,通过“CNN结构+数据增强+学习率调度+BatchNorm+AdamW+集成学习”的组合优化,可轻松将MNIST模型准确率从97.8%提升至99%以上,甚至达到99.7%的工业级水平。

5.5 高难度题2:PyTorch中训练三层前馈网络时出现梯度消失,可能的原因是什么?如何解决?(面试频率:高)

问题:在训练“输入层784→隐藏层256→输出层10”的三层前馈网络时,发现训练损失下降缓慢,且隐藏层梯度接近0(梯度消失),请分析可能的原因,并给出至少4种解决方法。

答案:

一、梯度消失的可能原因

梯度消失是指“反向传播时,梯度从输出层向输入层传递过程中逐渐衰减至接近0,导致输入层附近的参数无法更新”,在三层前馈网络中,可能原因如下:

-

激活函数选择不当:

若隐藏层使用Sigmoid或Tanh激活函数,其导数范围分别为(0,0.25]和(0,1],三层网络中梯度需经过“输出层→隐藏层→输入层”的两次导数相乘(如Sigmoid的导数0.25×0.25=0.0625),导致输入层权重的梯度仅为输出层梯度的6.25%,接近0,无法有效更新。 -

权重初始化不合理:

若权重初始化过大(如使用torch.randn()且未缩放),会导致隐藏层输出Z1 = X×W1 + b1的值过大,ReLU激活后大部分神经元输出为最大值(梯度为0),或Sigmoid激活后输出接近1(导数接近0);若初始化过小,Z1值过小,ReLU激活后大部分神经元输出为0(梯度为0),均导致梯度消失。 -

学习率过高或过低:

- 学习率过高:参数更新幅度过大,导致模型在损失函数的局部最优解附近震荡,隐藏层输出不稳定,梯度计算异常;

- 学习率过低:参数更新缓慢,隐藏层权重长期处于“低效区域”(如权重值过小,导致Z1过小),梯度无法累积。

-

数据预处理不规范:

若图像未归一化(像素值仍为0-255),输入层X的值过大,导致隐藏层Z1 = X×W1 + b1的值远超激活函数的有效范围(如ReLU的Z1>10时,输出为10,梯度为1,但权重更新时易导致后续层梯度爆炸;Sigmoid的Z1>5时,输出接近1,导数接近0)。

二、解决方法(附具体实现)

-

更换激活函数为ReLU及其变种

- 原理:ReLU的导数在Z1>0时为1,无梯度衰减问题;变种(如LeakyReLU、ReLU6)可解决ReLU的“死亡神经元”问题(Z1≤0时梯度为0导致神经元无法更新);

- 实现:

- 隐藏层用LeakyReLU:

self.relu = nn.LeakyReLU(negative_slope=0.01)(negative_slope=0.01表示Z1≤0时导数为0.01,避免死亡神经元); - 输出层无需激活(CrossEntropyLoss内置Softmax);

- 隐藏层用LeakyReLU:

- 效果:梯度传递过程中无衰减,隐藏层梯度可有效传递到输入层。

-

采用合理的权重初始化方法

- 原理:根据激活函数选择初始化方式,确保隐藏层输出

Z1的方差在合理范围(避免过大或过小); - 实现:

- ReLU激活:使用He初始化(针对ReLU的方差设计):

nn.init.kaiming_normal_(self.layer1.weight, mode='fan_in', nonlinearity='relu'); - Sigmoid/Tanh激活:使用Xavier初始化:

nn.init.xavier_normal_(self.layer1.weight, gain=nn.init.calculate_gain('sigmoid'));

- ReLU激活:使用He初始化(针对ReLU的方差设计):

- 代码示例(在模型

__init__中):def __init__(self):super(Network, self).__init__()self.layer1 = nn.Linear(784, 256)self.layer2 = nn.Linear(256, 10)self.relu = nn.LeakyReLU(0.01)# He初始化layer1权重nn.init.kaiming_normal_(self.layer1.weight, mode='fan_in', nonlinearity='leaky_relu')# He初始化layer2权重nn.init.kaiming_normal_(self.layer2.weight, mode='fan_in', nonlinearity='leaky_relu')# 偏置初始化为0nn.init.constant_(self.layer1.bias, 0)nn.init.constant_(self.layer2.bias, 0)

- 原理:根据激活函数选择初始化方式,确保隐藏层输出

-

添加BatchNorm层

- 原理:对隐藏层输出

Z1进行归一化(均值0、方差1),使激活函数始终工作在“梯度较大的有效区域”(如ReLU的Z1∈[-1,1],避免Z1过大或过小导致梯度消失); - 实现:在隐藏层线性变换后、激活函数前添加BatchNorm1d:

class Network(nn.Module):def __init__(self):super(Network, self).__init__()self.layer1 = nn.Linear(784, 256)self.bn1 = nn.BatchNorm1d(256) # BatchNorm层self.layer2 = nn.Linear(256, 10)self.relu = nn.LeakyReLU(0.01)def forward(self, x):x = x.view(x.size(0), -1)x = self.layer1(x)x = self.bn1(x) # 先归一化,再激活x = self.relu(x)x = self.layer2(x)return x - 注意:训练时

model.train()会更新BatchNorm的均值/方差,评估时model.eval()固定这些参数,避免影响结果。

- 原理:对隐藏层输出

-

使用学习率调度器动态调整学习率

- 原理:训练初期用较大学习率(如1e-3)快速更新参数,后期用较小学习率(如1e-5)精细调整,避免学习率不当导致的梯度问题;

- 实现:使用CosineAnnealingLR(余弦退火调度,学习率随epoch余弦变化):

optimizer = optim.Adam(model.parameters(), lr=1e-3) # 余弦退火调度,T_max=10表示10轮后学习率降至最小值 scheduler = torch.optim.lr_scheduler.CosineAnnealingLR(optimizer, T_max=10)for epoch in range(10):# 训练代码...scheduler.step() # 每轮结束后更新学习率print(f"Epoch {epoch+1}, Current LR: {scheduler.get_last_lr()[0]}") - 效果:避免学习率过高导致的参数震荡,或过低导致的更新缓慢,确保梯度有效传递。

-

规范数据预处理(归一化)

- 原理:将输入数据归一化到合理范围(如0-1或标准正态分布),避免输入值过大导致隐藏层输出超出激活函数有效范围;

- 实现:使用MNIST全局均值和方差归一化:

transform = transforms.Compose([transforms.Grayscale(1),transforms.ToTensor(),# MNIST全局均值0.1307,方差0.3081(官方统计值)transforms.Normalize(mean=[0.1307], std=[0.3081]) ]) - 效果:输入层

X的值集中在[-1,1]附近,隐藏层Z1 = X×W1 + b1的值也在合理范围,激活函数梯度正常。

通过以上方法,可有效解决三层前馈网络的梯度消失问题,使训练损失稳步下降,模型快速收敛,最终达到预期的准确率。