阿德莱德学习推理与导航!PEAP-LLM:基于大语言模型的参数高效动作规划

- 作者:Bahram Mohammadi1^{1}1, Ehsan Abbasnejad1^{1}1, Yuankai Qi2^{2}2, Qi Wu1^{1}1, Anton Van Den Hengel1^{1}1, Javen Qinfeng Shi1^{1}1

- 单位:1^{1}1澳大利亚阿德莱德大学机器学习研究所,2^{2}2澳大利亚麦考瑞大学应用人工智能中心

- 论文标题:Learning to Reason and Navigate: Parameter Efficient Action Planning with Large Language Models

- 论文链接:https://arxiv.org/pdf/2505.07500

主要贡献

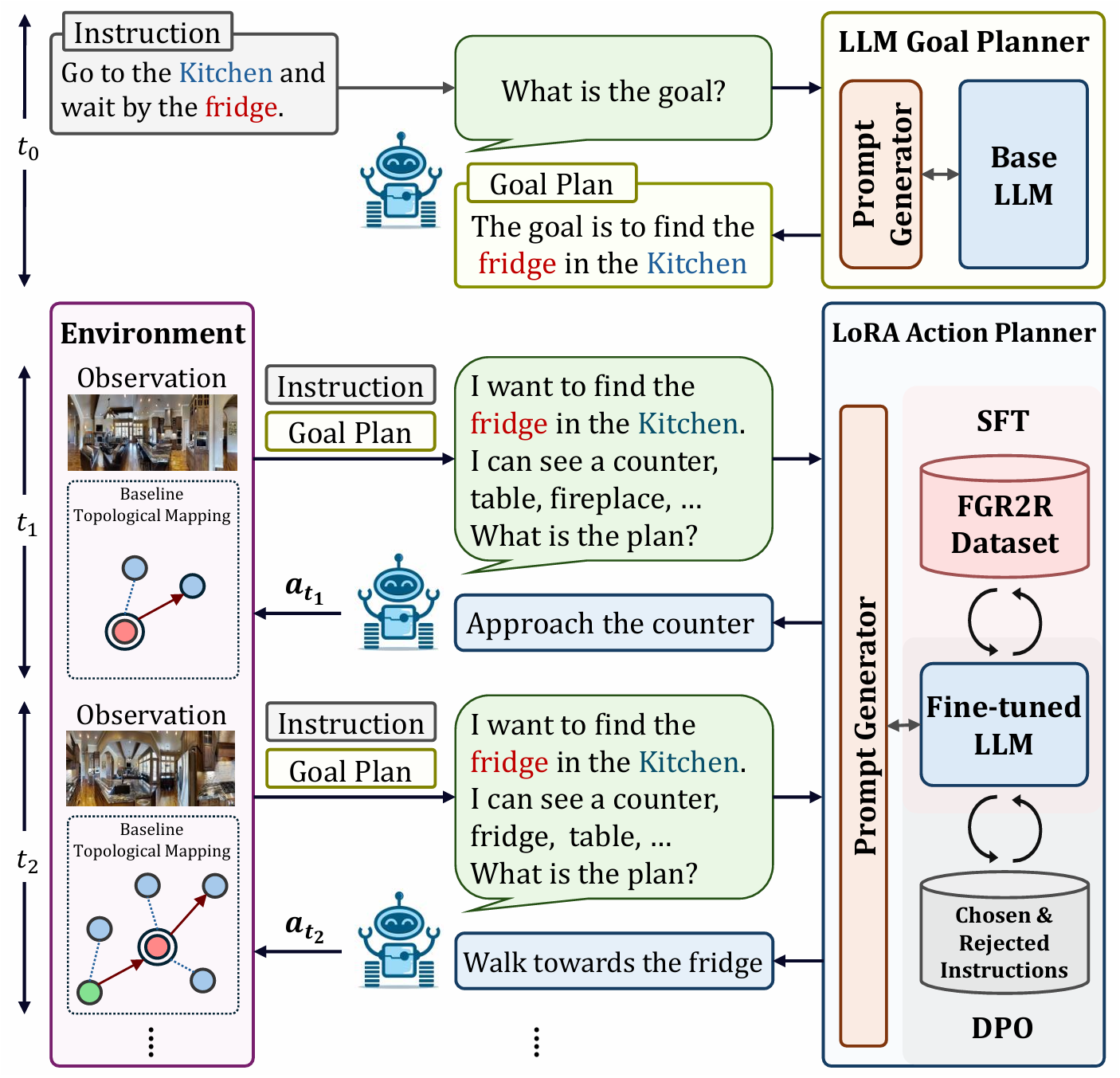

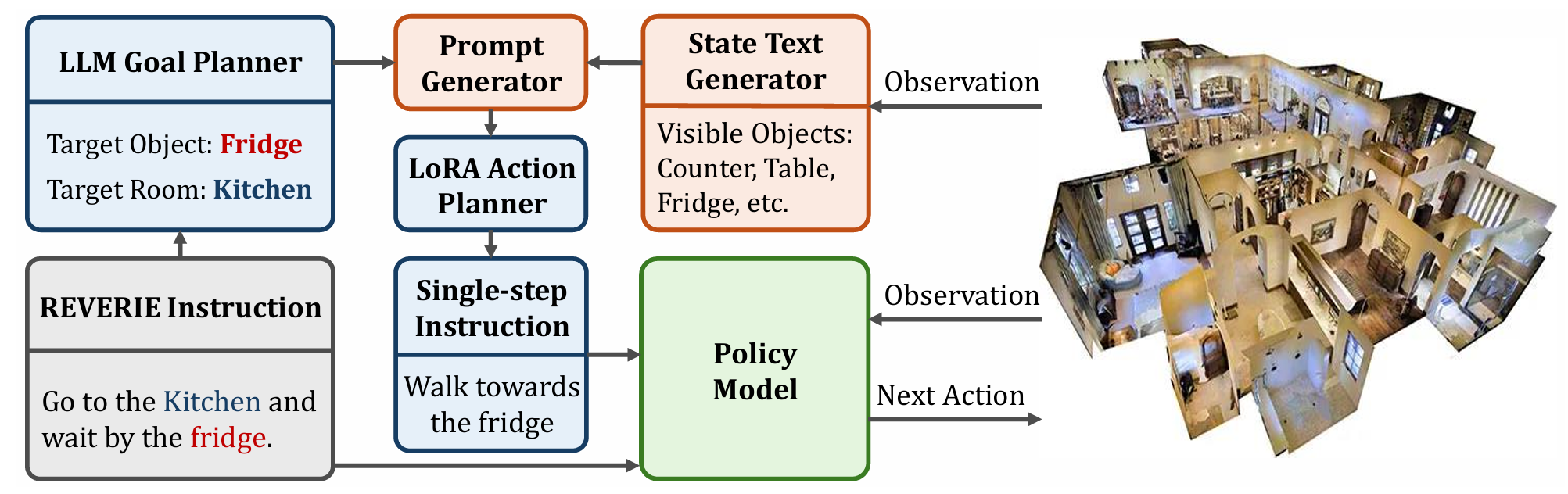

- 提出了参数高效的动作规划器PEAP-LLM,使智能体能够在每个位置与LLM交互以获得单步指令,从而提高导航效率。

- 设计了LGP和LAP两个模块,LLM目标规划器(LGP)用于从REVERIE指令中提取目标对象和房间;LoRA动作规划器(LAP)用于生成单步动作计划。

- 提出了两阶段方法来对LLM进行微调,包括监督微调(SFT)和直接偏好优化(DPO),以提高生成指令的质量并防止LLM产生幻觉和偏见信息。

- 在REVERIE基准测试中的实验结果表明,该方法优于以往的SOTA方法,验证了其有效性和泛化能力。

研究背景

- 视觉语言导航(VLN)任务涉及计算机视觉、自然语言处理和导航等多个领域,近年来受到广泛关注。在众多VLN任务中,REVERIE任务要求智能体在没有预先探索的情况下,根据高级指令(如“给我拿一把勺子”)在复杂室内环境中导航并定位远程目标对象,因此高效的导航计划至关重要。

- 大语言模型(LLMs)在行动规划方面展现出巨大潜力,但在包含复杂环境和多样化对象的REVERIE任务中,LLMs的应用尚未得到充分探索。以往的研究中,直接应用LLMs难以取得良好性能,而基于硬提示的方法在复杂场景中容易出错且需要人工干预。

方法提出

基线智能体

论文以HM3D-DUET作为主要的基线模型。该模型基于DUET架构,通过构建拓扑地图来实现有效的长期规划,使智能体能够在图中的所有可导航节点之间进行规划,而不仅仅是相邻节点。模型包含两个组件:拓扑映射和全局动作规划。

- 拓扑映射:负责添加新访问的位置并更新节点表示。

- 全局动作规划:包含两个编码器:细粒度编码器和粗粒度编码器。

- 细粒度编码器:关注拓扑图中每个节点的局部观察,输入包括上下文词表示和当前节点的视觉表示(图像和目标特征的编码嵌入)。通过多层跨模态Transformer来建模视觉和语言之间的关系,并获得视觉标记的嵌入。需要在局部动作空间中指定两个导航分数以及REVERIE任务中的目标分数。

- 粗粒度编码器:对每个节点的视觉表示添加两种编码:位置编码(当前节点相对于当前节点的距离和方向)和导航步编码(已访问和未访问节点的编码不同)。使用图感知自注意力(GASA)来建模环境布局和节点与指令之间的关系。

- 动作推理:通过动态融合细粒度和粗粒度编码器的预测分数来获得最终的导航分数。将局部动作分数转换到全局动作空间,并通过Sigmoid函数预测融合权重。

- 优化:基线模型在行为克隆任务(包括单步动作预测SAP和目标定位OG)以及两个辅助代理任务(掩码语言建模MLM和掩码视图分类MVC)上进行预训练。优化过程中采用伪交互式演示器提供的监督,类似于DAgger算法。

LLM目标规划器

- 目标:从REVERIE指令中提取目标对象和目标房间,以改善生成的单步指令。

- 方法:利用基础LLM进行目标导向计划的提取。将整个过程分解为三个连续阶段:

- 提取高级指令的主要目标。

- 根据目标识别目标对象。

- 根据高级指令和目标对象的常见位置确定目标房间。

- 房间列表:为了帮助LLM更准确地确定目标房间,使用了REVERIE数据集中的房间列表。从列表中选择目标房间可以识别不常见的房间类型,并且即使指令中没有明确提到目标房间,也能够确定目标房间。

LoRA动作规划器

- 目标:在每个时间步生成单步指令,以增强视觉和文本数据之间的对应关系,并提高智能体通过完成指令的可追溯性。

- 对象检索:使用ODISE提取可见对象,并通过CLIP模型根据与环境的相关性选择最相关的5个对象。计算对象与平均编码视角图像之间的余弦相似度得分,以确定对象的相关性。

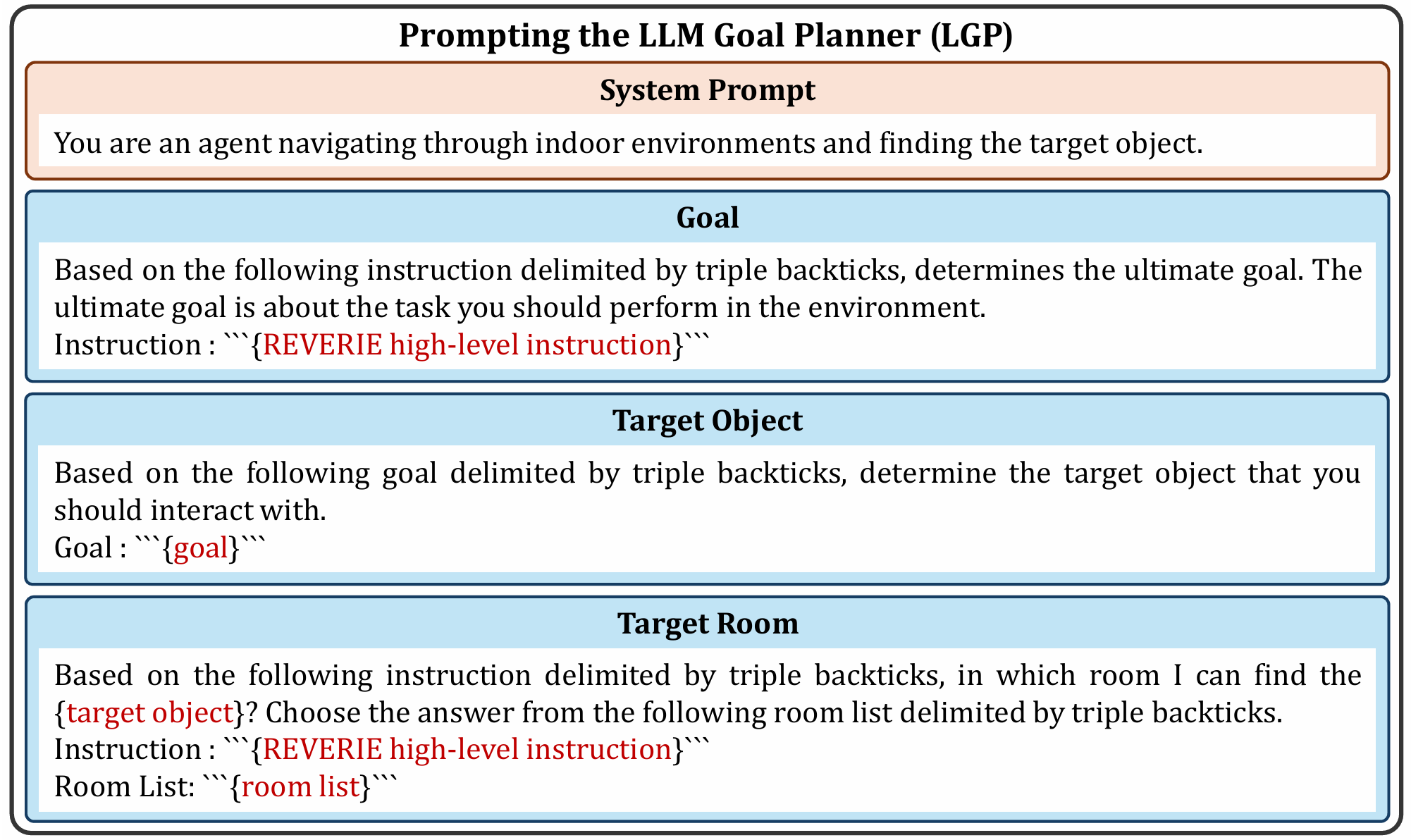

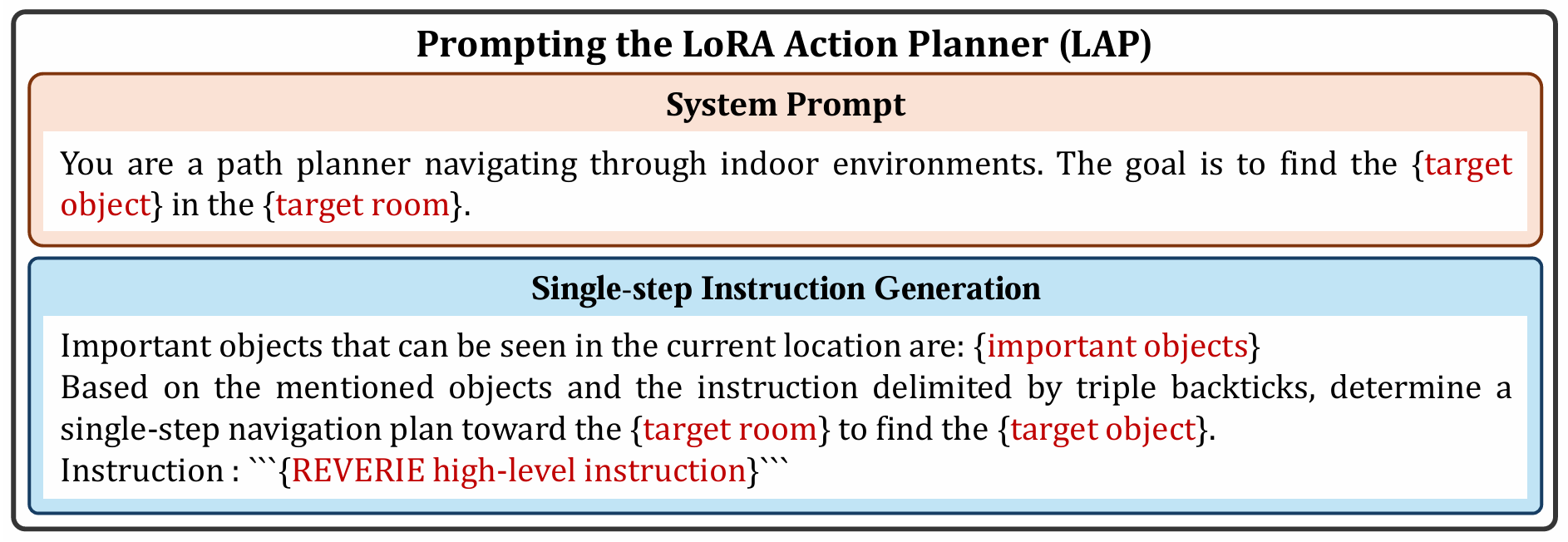

- 提示模板:为LGP和LAP提供了详细的提示模板,以指导LLM生成准确的目标对象和房间信息,以及单步导航计划。

提示模板

- LGP提示:首先定义系统提示,告知模型关于任务的一般信息。然后通过三个连续步骤进行对象识别和对象定位:提取REVERIE高级指令的主要目标、根据目标检索目标对象、根据目标对象的常见位置和REVERIE指令找到目标房间。

- LAP提示:同样首先定义系统提示,描述智能体的任务,即在目标房间中找到目标对象。然后以目标导向计划、REVERIE高级指令和可见对象作为输入,生成单步导航计划。

- Llama 2模型提示:介绍了使用Llama 2模型时的提示模板,包括单消息实例和多消息实例的格式。

LLM微调

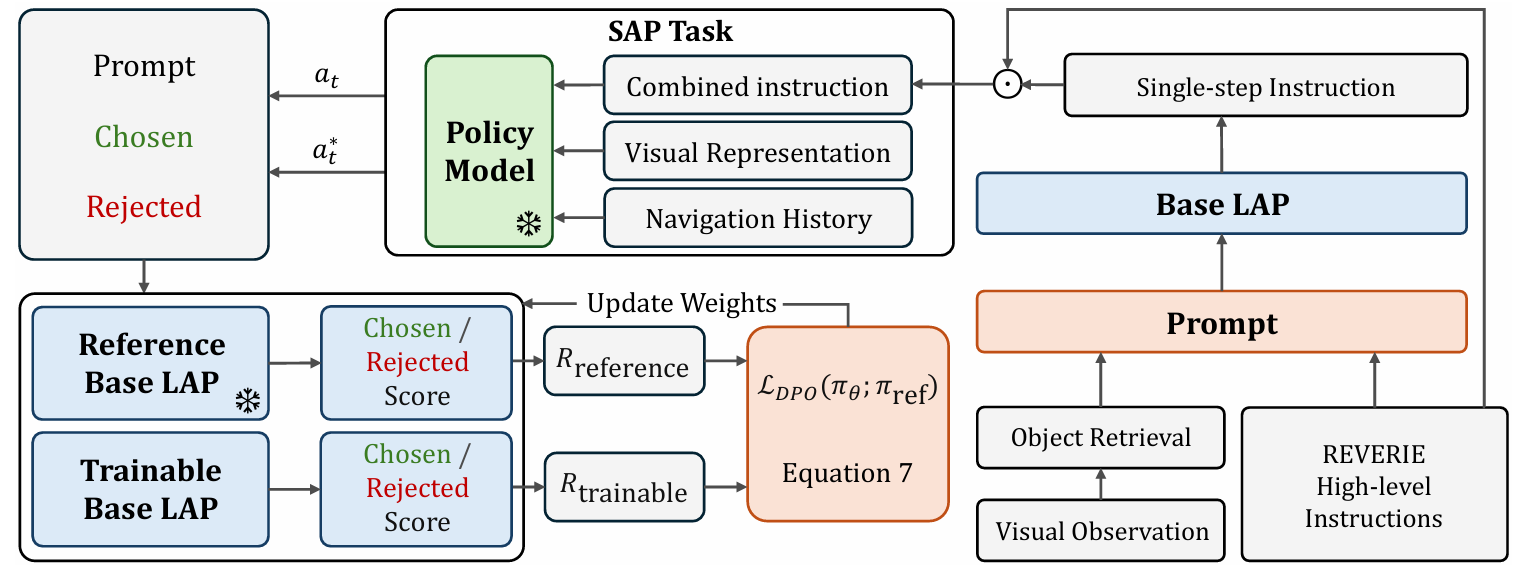

采用两阶段方法对LLM进行微调,减少LLM生成幻觉、偏见信息以及减少人工干预设计准确提示的需求。

- 监督微调(SFT):需要构建一个包含每个视角的地面真实指令和对应提示的数据集。利用FGR2R数据集中的分解步骤指令来构建数据集。采用参数高效微调技术,如前缀调整和低秩适应(LoRA)。在本工作中,由于LoRA具有训练速度快、适应性强以及对小型硬件可行等优点,因此选择了LoRA。

- 直接偏好优化(DPO):DPO跳过了奖励建模,直接在偏好注释数据上优化策略。主要目标是将环境反馈和策略模型的动作预测过程中的反馈纳入微调过程。通过以下步骤实现:

- 使用策略模型区分偏好和不偏好的单步指令。

- 根据预测动作构建数据集。

- 使用DPO训练器对从上一阶段输出的基础LAP进行微调。

- 使用SAP任务收集正确和错误的单步指令。SAP任务将模型预测的下一个动作与专家演示的最短路径上的真实动作进行比较,以确定生成的单步指令是否导致正确的动作预测。

- 构建DPO训练器所需的数据集,包括提示、选择的(偏好)和拒绝的(不偏好)响应。根据SAP任务的结果,将生成的单步指令标记为选择的或拒绝的。

- DPO训练器的策略公式化为最大化偏好响应的概率,同时最小化非偏好响应的概率。参考模型的权重在训练过程中保持冻结,以防止与基础LAP模型偏差过大。

实验

实验设置

- 基线模型:使用HM3D-DUET作为基线模型,该模型通过构建拓扑地图并利用全局动作规划来实现导航。在实验中,作者没有对基线模型的实现进行任何修改,只是在其基础上添加了生成的单步动作计划。

- 数据集:主要在REVERIE数据集上进行实验,该数据集包含简短的高级指令,要求智能体高效探索环境并定位远程目标对象。

- 训练细节:使用AdamW优化器进行训练,学习率为10^-5。视角图像和目标边界框通过预训练的ViT-B/16模型进行编码。使用CLIP模型选择与环境最相关的5个目标对象。LLM使用公开的LLaMA 2-CHAT模型,参数量为70亿。

- 硬件配置:实验在单个NVIDIA 3090 GPU上进行,微调了20k次迭代。

数据集

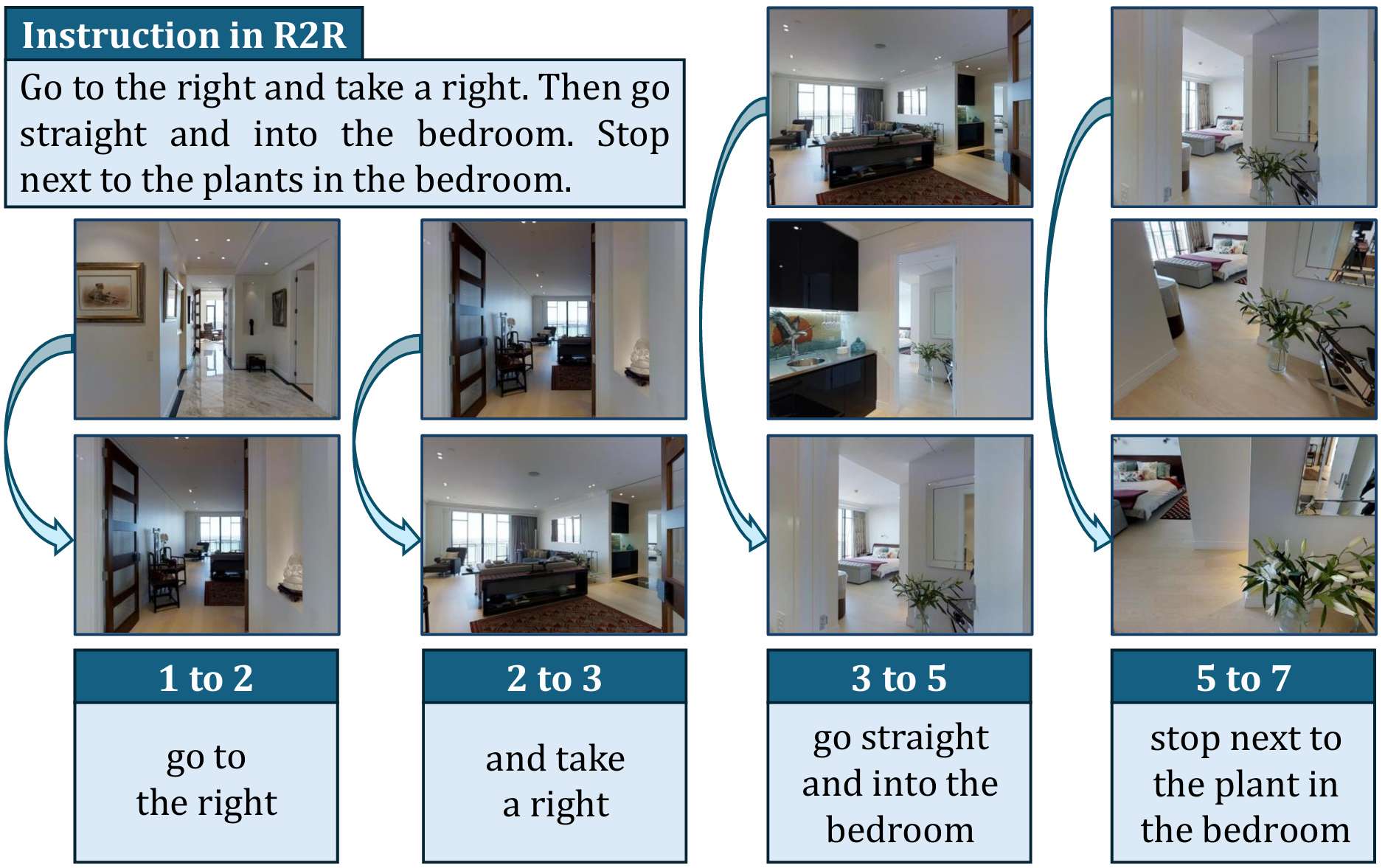

- REVERIE数据集是一个目标导向的任务,结合了R2R导航和指代表达任务。智能体需要在环境中导航以识别在初始视图中不可见的目标对象。

- 该数据集包含4000多个目标对象,分布在489个类别中,专家路径长度从4到7不等,平均指令长度为18个单词。

评估指标

- 成功率(SR):成功完成任务的比例,即智能体停止点到目标位置的距离小于3米。

- 路径长度加权的成功率(SPL):综合考虑成功率和轨迹长度,表示导航效率。

- 远程定位成功率(RGS):在停止点正确识别目标对象的比例。

- 路径长度加权的远程定位成功率(RGSPL):RGS指标被轨迹长度加权,表示目标定位能力。

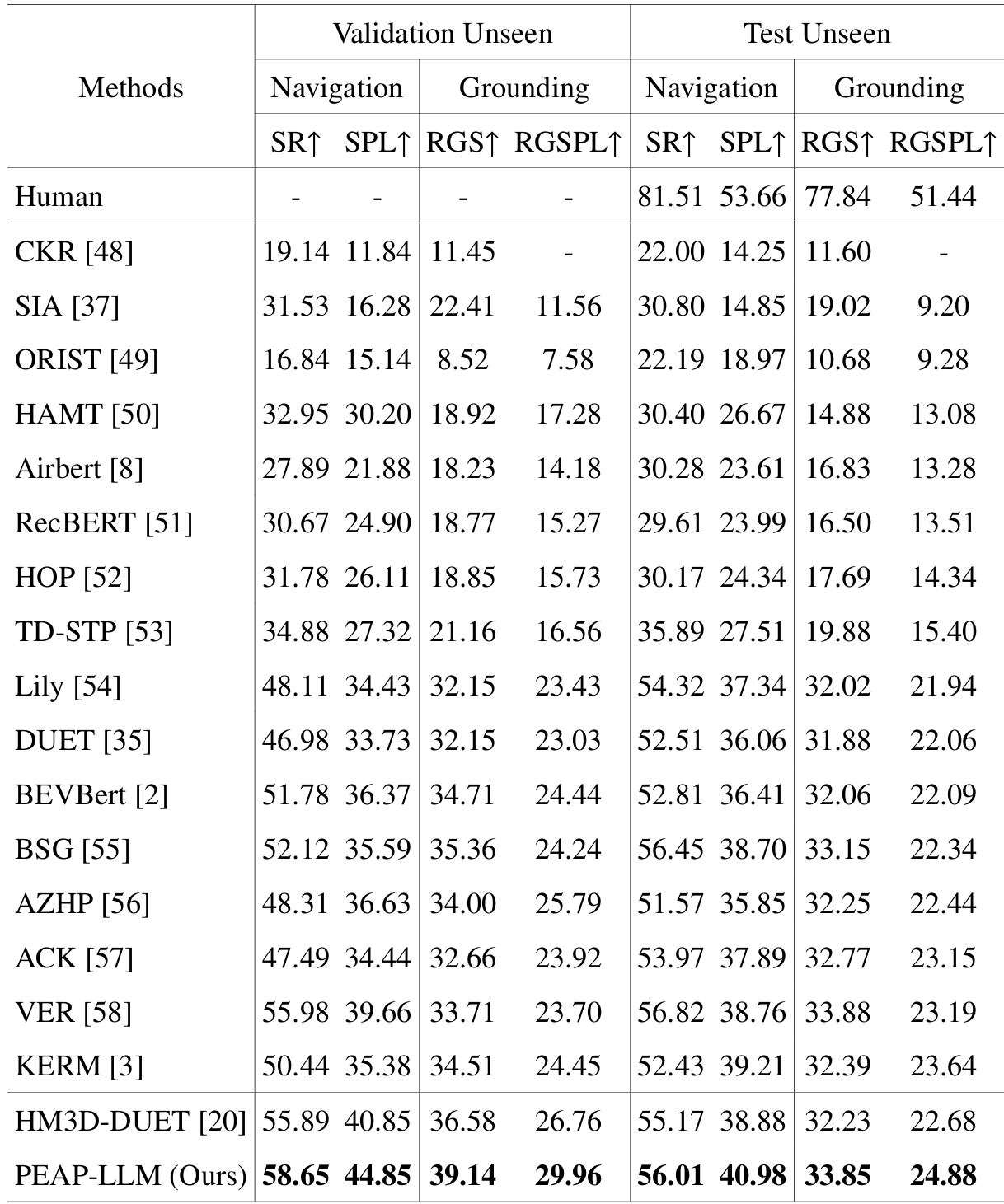

与SOTA方法的比较

- PEAP-LLM在REVERIE的验证未见集和测试未见集上均优于以往的SOTA方法。具体来说:

- 在验证未见集上,PEAP-LLM的SPL比HM3D-DUET提高了4.00%,RGSPL提高了3.20%。

- 在测试未见集上,PEAP-LLM的SPL比HM3D-DUET提高了2.10%,RGSPL提高了2.20%。

- 与多种SOTA方法(如CKR、SIA、ORIST、HAMT、Airbert、RecBERT、HOP、TD-STP、Lily、DUET、BEVBert、BSG、AZHP、ACK、VER、KERM)进行了比较,PEAP-LLM在所有指标上均取得了最佳性能。

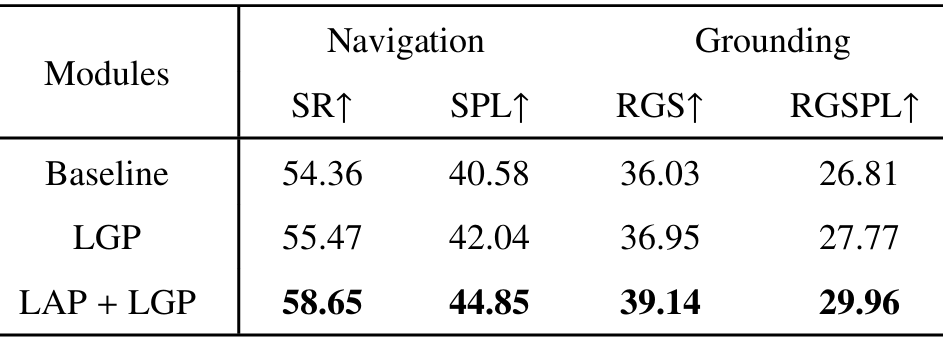

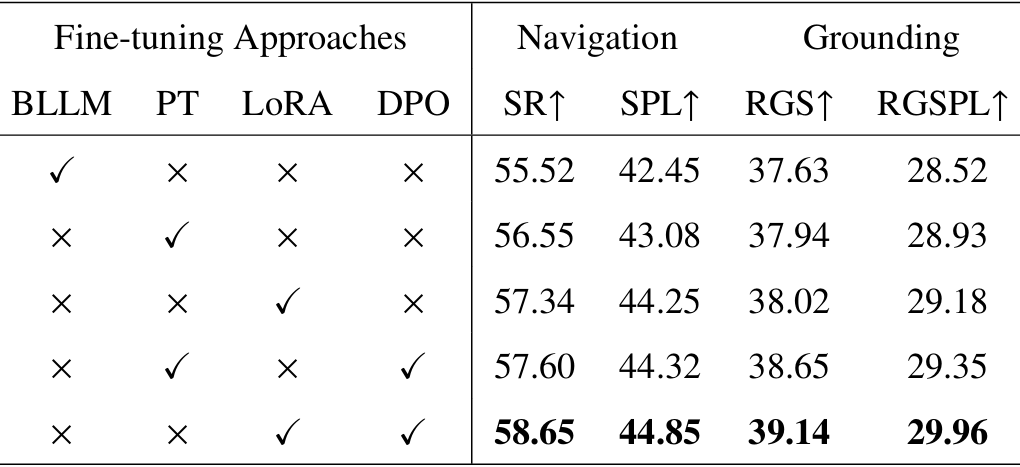

消融研究

- 模块贡献:

- LGP模块:仅使用LGP时,性能已经比基线有所提升,表明LGP在提取目标对象和房间方面的有效性。

- LAP模块:将LGP和LAP结合使用时,性能进一步显著提升,表明LAP在生成单步指令方面的有效性。

- 微调方法:

- 基础LLM:仅使用基础LLM时,性能较差。

- 前缀调整(PT):使用前缀调整进行微调,性能有所提升。

- 低秩适应(LoRA):使用LoRA进行微调,性能进一步提升。

- 直接偏好优化(DPO):在LoRA微调的基础上使用DPO,性能达到最佳。

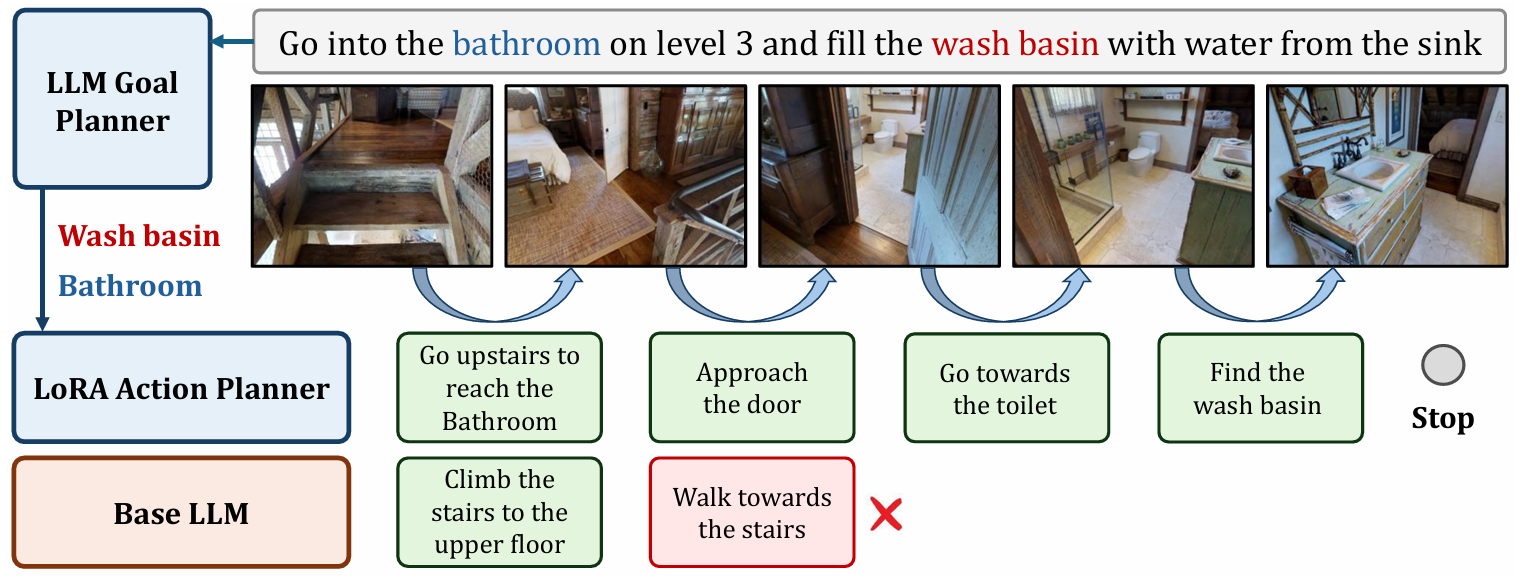

定性分析

通过一个具体的例子展示了PEAP-LLM在导航过程中的表现。基线智能体在没有PEAP-LLM的情况下无法到达目标位置并定位目标对象,而使用PEAP-LLM后,智能体能够通过与LAP实时交互获得单步指令,从而选择正确的导航方向并成功到达目标位置。

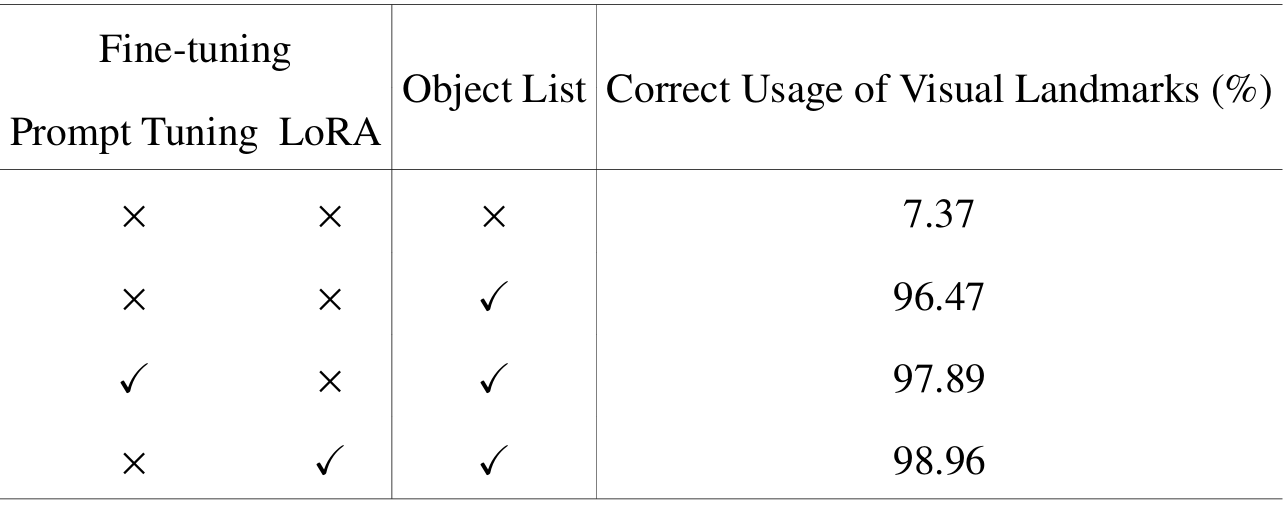

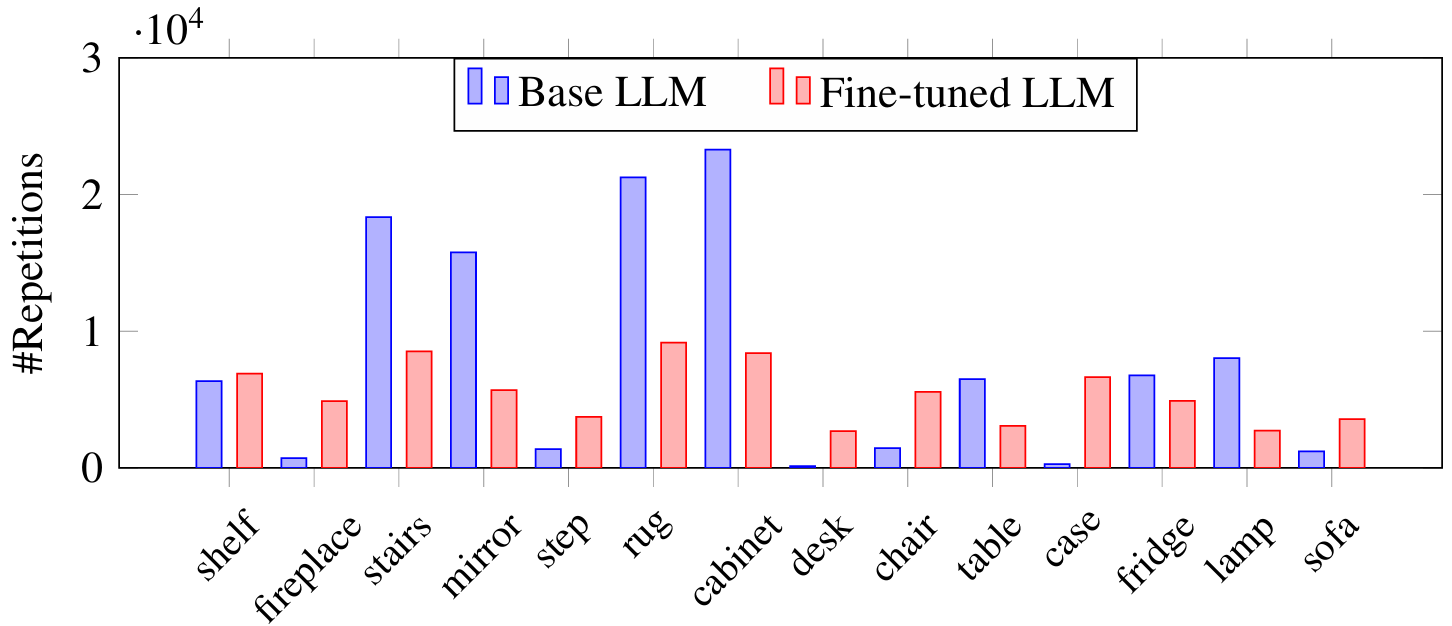

定量分析

- 视觉地标使用:通过实验表明,定义适当的目标对象列表可以显著提高生成的单步指令中视觉地标的准确性。此外,LLM微调可以进一步提高视觉地标的使用准确性。

- 对象使用频率:通过统计生成的单步指令中常见对象的使用频率,发现LLM微调可以减少对某些特定对象的偏见,使生成的指令更加平衡。

结论与未来工作

- 结论:

- PEAP-LLM通过结合LGP和LAP模块以及采用两阶段LLM微调方法,在REVERIE任务中显著提升了智能体的导航和目标定位性能,证明了其有效性和泛化能力。

- 未来工作:

- 虽然PEAP-LLM取得了良好的效果,但在每个位置生成单步指令可能会增加计算开销。

- 因此,未来可以考虑定义一个量化智能体信心水平的指标,以便智能体仅在检测到不确定性时才向LAP请求动作计划,从而减少计算开销。

- 此外,还可以将额外的上下文信息(如可见目标相对于智能体角度和高度的相对方向)纳入提示中,以生成更准确的单步导航指令。