【完整源码+数据集+部署教程】 落叶植物叶片分类系统源码和数据集:改进yolo11-LVMB

背景意义

研究背景与意义

随着全球生态环境的变化,植物的多样性及其在生态系统中的重要性日益受到关注。植物叶片的分类不仅是植物学研究的基础,也是生态监测、农业管理和生物多样性保护的重要环节。传统的植物分类方法依赖于人工观察和专家知识,既耗时又容易受到主观因素的影响。近年来,计算机视觉技术的快速发展为植物叶片的自动分类提供了新的解决方案,尤其是基于深度学习的目标检测算法如YOLO(You Only Look Once)系列,因其高效性和准确性而备受青睐。

本研究旨在基于改进的YOLOv11算法,构建一个高效的落叶植物叶片分类系统。我们选择了包含四种不同植物叶片的图像数据集,包括葡萄叶、印度李叶、橙子叶和常春藤叶,数据集共包含4800张经过精心标注的图像。这些图像经过多种预处理和增强技术的处理,确保了模型在不同环境和条件下的鲁棒性。通过对这些叶片进行分类,不仅可以帮助研究人员更好地理解植物的生态特征,还能为农业生产提供科学依据,推动可持续发展。

此外,叶片分类系统的成功应用将为其他植物分类任务提供借鉴,推动计算机视觉技术在生态学和生物多样性研究中的广泛应用。随着数据集的不断扩展和模型的持续优化,该系统有望实现更高的分类精度和更广泛的适用性,从而为生态监测、植物保护和资源管理等领域提供有力支持。总之,本研究不仅具有重要的学术价值,还有助于促进生态环境的保护与可持续发展。

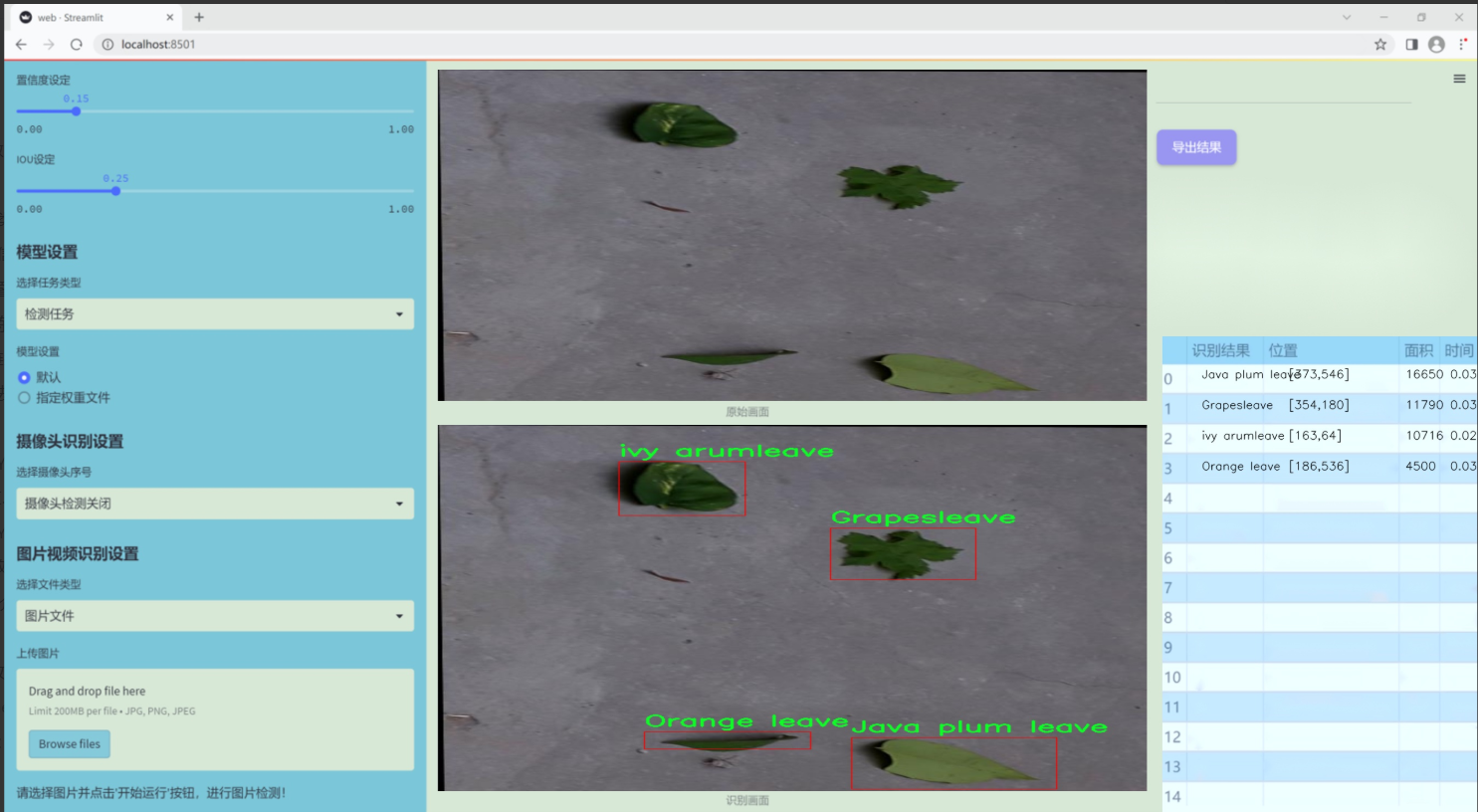

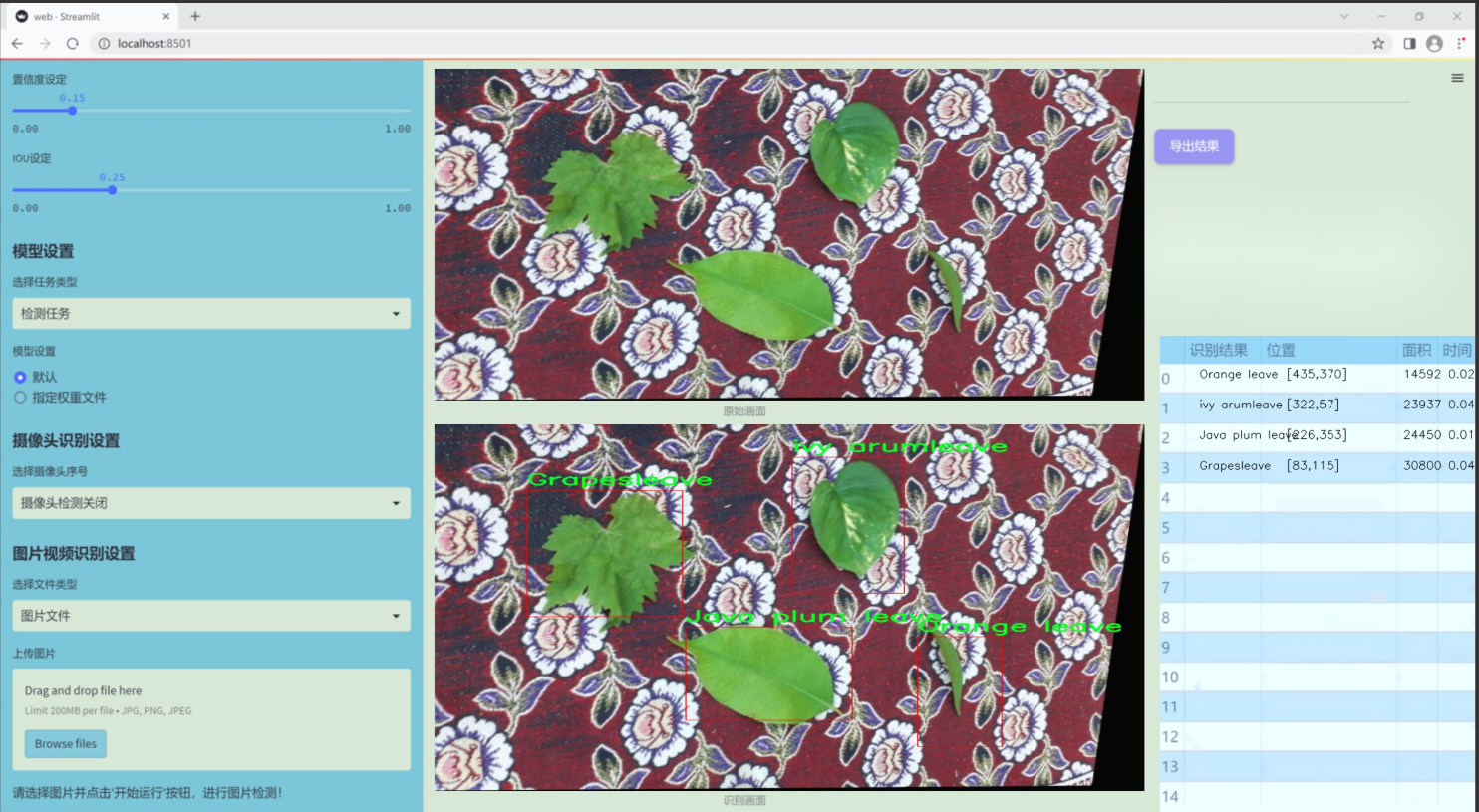

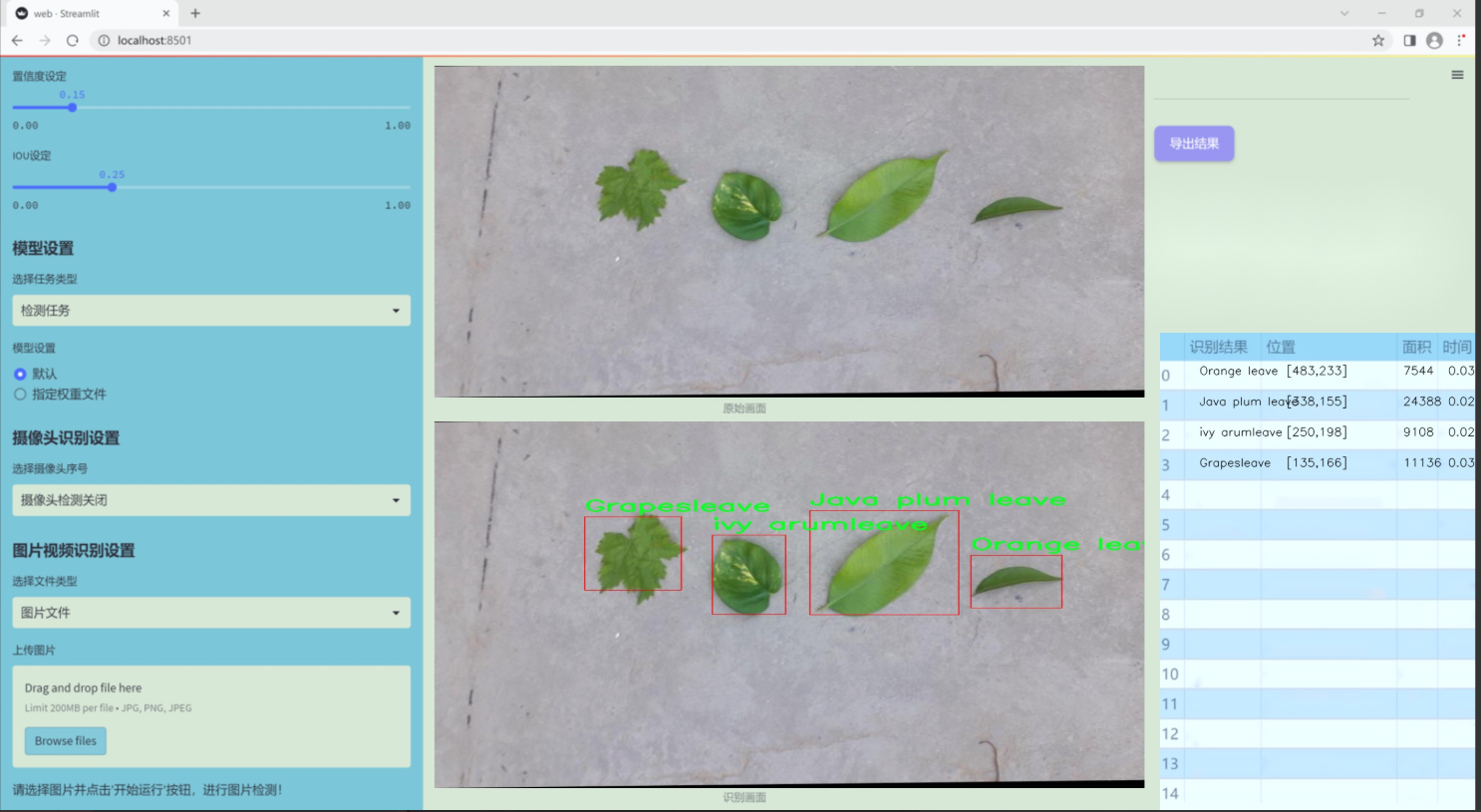

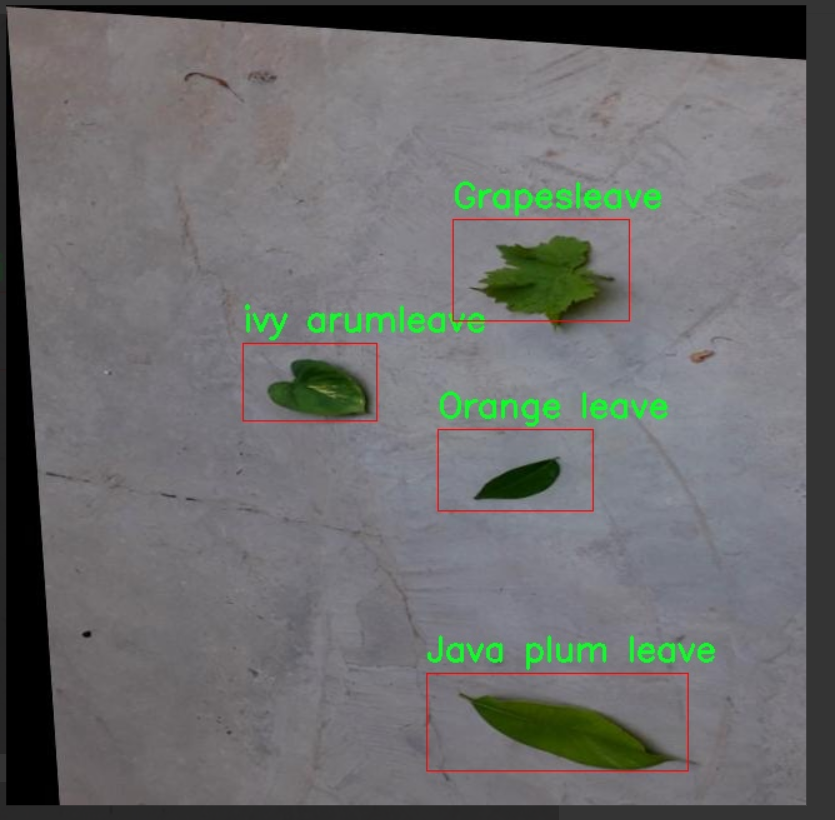

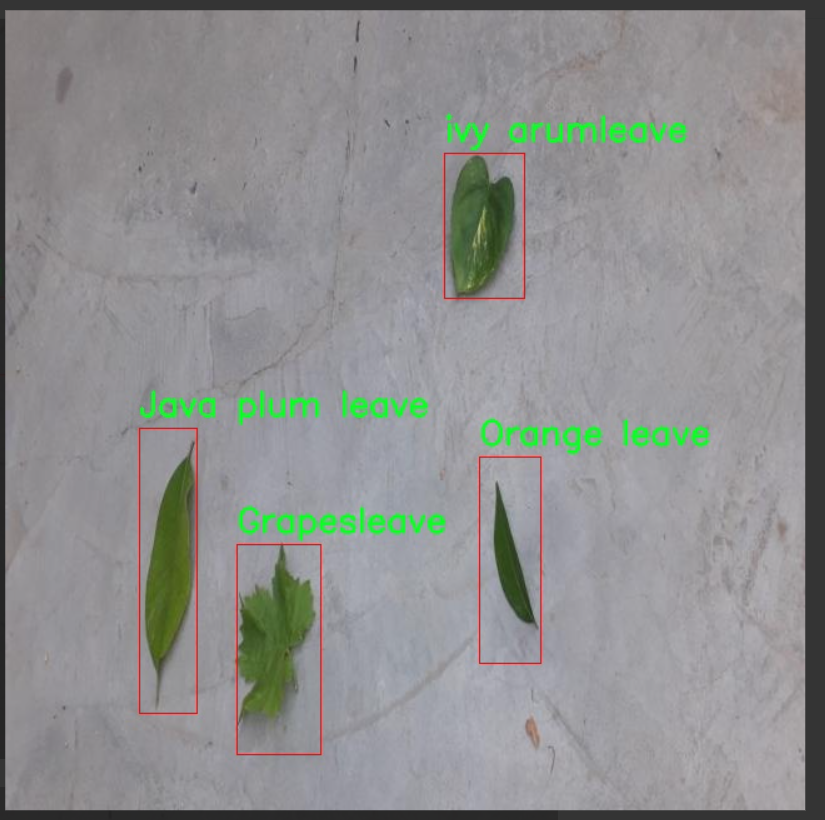

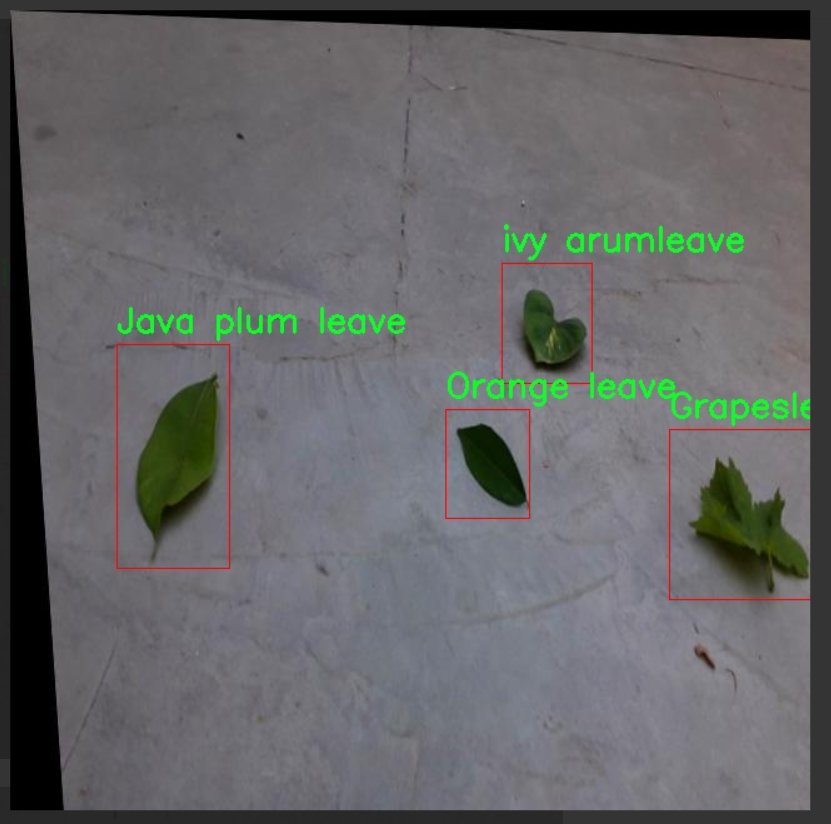

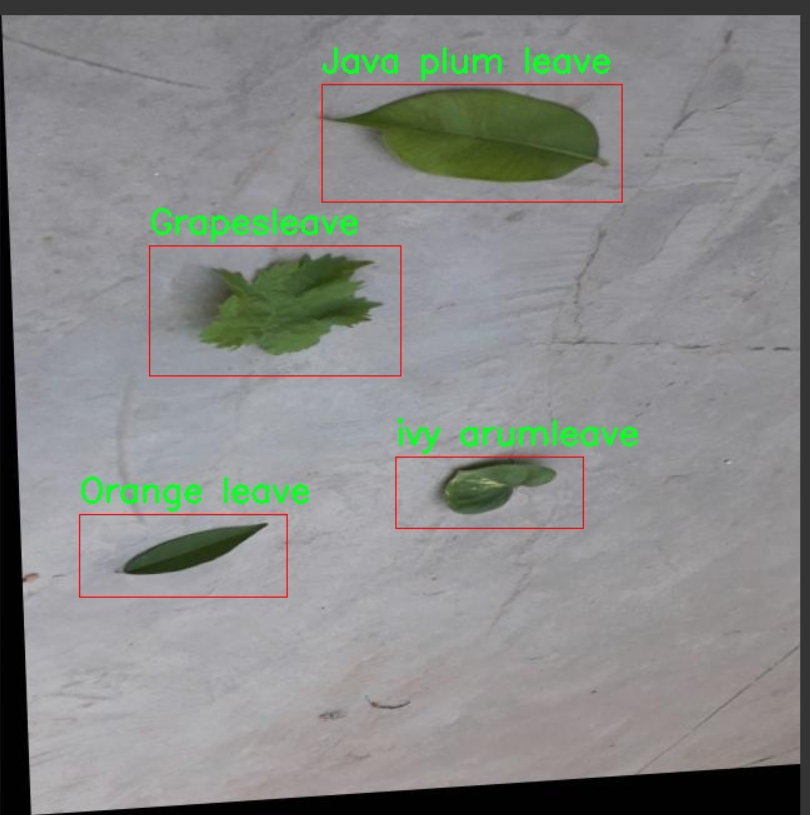

图片效果

数据集信息

本项目数据集信息介绍

本项目旨在改进YOLOv11的落叶植物叶片分类系统,因此我们构建了一个专门用于叶片检测的高质量数据集。该数据集包含四个主要类别,分别是“Grapesleave”(葡萄叶)、“Java plum leave”(番石榴叶)、“Orange leave”(橙子叶)和“ivy arumleave”(常春藤叶)。这些类别的选择不仅考虑了植物的多样性,还兼顾了它们在生态系统中的重要性和经济价值。

数据集的构建过程涉及对不同植物叶片的采集与拍摄,确保每个类别的样本具有代表性和多样性。我们在不同的光照条件和背景下拍摄了大量的叶片图像,以提高模型的鲁棒性和准确性。每个类别的样本数量经过精心设计,以确保模型在训练过程中能够充分学习到各类叶片的特征和差异。

在数据集的标注过程中,我们采用了精确的边界框标注方法,以确保每个叶片的特征能够被准确捕捉。这种细致的标注不仅为模型提供了丰富的训练数据,也为后续的验证和测试提供了可靠的基础。通过对数据集的深入分析,我们还发现不同类别之间在形态、颜色和纹理上的差异,这为改进YOLOv11模型提供了重要的参考。

总之,本项目的数据集不仅为叶片检测提供了丰富的样本和准确的标注,还为改进YOLOv11的分类性能奠定了坚实的基础。通过利用这一数据集,我们期望能够显著提升落叶植物叶片的分类精度,为植物识别和生态研究提供有力支持。

核心代码

以下是对给定代码的核心部分进行分析和详细注释的结果。我们将保留主要的类和函数,并为其添加中文注释,以便更好地理解其功能和实现。

import torch

import torch.nn as nn

import torch.nn.functional as F

定义一个函数,用于确保某个值是可被指定的除数整除的

def _make_divisible(v, divisor, min_value=None):

if min_value is None:

min_value = divisor

new_v = max(min_value, int(v + divisor / 2) // divisor * divisor)

# 确保向下取整不会超过原值的90%

if new_v < 0.9 * v:

new_v += divisor

return new_v

Swish激活函数

class swish(nn.Module):

def forward(self, x):

return x * torch.sigmoid(x)

h_swish激活函数

class h_swish(nn.Module):

def init(self, inplace=False):

super(h_swish, self).init()

self.inplace = inplace

def forward(self, x):return x * F.relu6(x + 3.0, inplace=self.inplace) / 6.0

h_sigmoid激活函数

class h_sigmoid(nn.Module):

def init(self, inplace=True, h_max=1):

super(h_sigmoid, self).init()

self.relu = nn.ReLU6(inplace=inplace)

self.h_max = h_max

def forward(self, x):return self.relu(x + 3) * self.h_max / 6

动态ReLU激活函数

class DyReLU(nn.Module):

def init(self, inp, reduction=4, lambda_a=1.0, K2=True, use_bias=True, use_spatial=False,

init_a=[1.0, 0.0], init_b=[0.0, 0.0]):

super(DyReLU, self).init()

self.oup = inp # 输出通道数

self.lambda_a = lambda_a * 2 # 动态调整参数

self.K2 = K2 # 是否使用K2

self.avg_pool = nn.AdaptiveAvgPool2d(1) # 自适应平均池化

self.use_bias = use_biasself.exp = 4 if use_bias else 2 if K2 else 2 if use_bias else 1 # 确定扩展因子squeeze = _make_divisible(inp // reduction, 4) # 确定压缩因子# 定义全连接层self.fc = nn.Sequential(nn.Linear(inp, squeeze),nn.ReLU(inplace=True),nn.Linear(squeeze, self.oup * self.exp),h_sigmoid())self.spa = nn.Sequential(nn.Conv2d(inp, 1, kernel_size=1),nn.BatchNorm2d(1),) if use_spatial else None # 可选的空间注意力def forward(self, x):# 输入处理x_in = x[0] if isinstance(x, list) else xx_out = x[1] if isinstance(x, list) else xb, c, h, w = x_in.size() # 获取输入的尺寸y = self.avg_pool(x_in).view(b, c) # 自适应平均池化y = self.fc(y).view(b, self.oup * self.exp, 1, 1) # 全连接层输出# 根据扩展因子计算输出if self.exp == 4:a1, b1, a2, b2 = torch.split(y, self.oup, dim=1)a1 = (a1 - 0.5) * self.lambda_a + self.init_a[0]a2 = (a2 - 0.5) * self.lambda_a + self.init_a[1]b1 = b1 - 0.5 + self.init_b[0]b2 = b2 - 0.5 + self.init_b[1]out = torch.max(x_out * a1 + b1, x_out * a2 + b2)elif self.exp == 2:a1, b1 = torch.split(y, self.oup, dim=1)a1 = (a1 - 0.5) * self.lambda_a + self.init_a[0]b1 = b1 - 0.5 + self.init_b[0]out = x_out * a1 + b1elif self.exp == 1:a1 = ya1 = (a1 - 0.5) * self.lambda_a + self.init_a[0]out = x_out * a1# 如果使用空间注意力,则进行处理if self.spa:ys = self.spa(x_in).view(b, -1)ys = F.softmax(ys, dim=1).view(b, 1, h, w) * h * wys = F.hardtanh(ys, 0, 3, inplace=True) / 3out = out * ysreturn out

动态可变形卷积模块

class DyDCNv2(nn.Module):

def init(self, in_channels, out_channels, stride=1, norm_cfg=dict(type=‘GN’, num_groups=16, requires_grad=True)):

super().init()

self.with_norm = norm_cfg is not None

bias = not self.with_norm

self.conv = ModulatedDeformConv2d(

in_channels, out_channels, 3, stride=stride, padding=1, bias=bias)

if self.with_norm:

self.norm = build_norm_layer(norm_cfg, out_channels)[1]

def forward(self, x, offset, mask):"""前向传播函数"""x = self.conv(x.contiguous(), offset, mask) # 进行可变形卷积if self.with_norm:x = self.norm(x) # 进行归一化return x

DyHead模块

class DyHeadBlock_Prune(nn.Module):

def init(self, in_channels, norm_type=‘GN’, zero_init_offset=True, act_cfg=dict(type=‘HSigmoid’, bias=3.0, divisor=6.0)):

super().init()

self.zero_init_offset = zero_init_offset

self.offset_and_mask_dim = 3 * 3 * 3 # 偏移和掩码的维度

self.offset_dim = 2 * 3 * 3 # 偏移的维度

# 根据规范类型选择归一化配置norm_dict = dict(type='GN', num_groups=16, requires_grad=True) if norm_type == 'GN' else dict(type='BN', requires_grad=True)# 定义空间卷积层self.spatial_conv_high = DyDCNv2(in_channels, in_channels, norm_cfg=norm_dict)self.spatial_conv_mid = DyDCNv2(in_channels, in_channels)self.spatial_conv_low = DyDCNv2(in_channels, in_channels, stride=2)self.spatial_conv_offset = nn.Conv2d(in_channels, self.offset_and_mask_dim, 3, padding=1) # 偏移卷积层# 定义尺度注意力模块self.scale_attn_module = nn.Sequential(nn.AdaptiveAvgPool2d(1), nn.Conv2d(in_channels, 1, 1),nn.ReLU(inplace=True), build_activation_layer(act_cfg))# 定义任务注意力模块self.task_attn_module = DyReLU(in_channels)self._init_weights() # 初始化权重def _init_weights(self):for m in self.modules():if isinstance(m, nn.Conv2d):normal_init(m, 0, 0.01) # 正态初始化卷积层if self.zero_init_offset:constant_init(self.spatial_conv_offset, 0) # 偏移卷积层初始化为0def forward(self, x, level):"""前向传播函数"""# 计算偏移和掩码offset_and_mask = self.spatial_conv_offset(x[level])offset = offset_and_mask[:, :self.offset_dim, :, :]mask = offset_and_mask[:, self.offset_dim:, :, :].sigmoid()mid_feat = self.spatial_conv_mid(x[level], offset, mask) # 中间特征sum_feat = mid_feat * self.scale_attn_module(mid_feat) # 加权特征summed_levels = 1# 处理低层特征if level > 0:low_feat = self.spatial_conv_low(x[level - 1], offset, mask)sum_feat += low_feat * self.scale_attn_module(low_feat)summed_levels += 1# 处理高层特征if level < len(x) - 1:high_feat = F.interpolate(self.spatial_conv_high(x[level + 1], offset, mask),size=x[level].shape[-2:],mode='bilinear',align_corners=True)sum_feat += high_feat * self.scale_attn_module(high_feat)summed_levels += 1return self.task_attn_module(sum_feat / summed_levels) # 返回任务注意力模块的输出

代码核心部分总结:

激活函数:定义了多种激活函数(Swish, h_swish, h_sigmoid, DyReLU),用于提高模型的非线性表达能力。

动态可变形卷积:DyDCNv2类实现了可变形卷积,并可选择性地应用归一化。

DyHead模块:DyHeadBlock_Prune类实现了具有多种注意力机制的模块,能够根据输入特征动态调整卷积的偏移和掩码。

这些核心部分共同构成了一个灵活且强大的深度学习模块,适用于各种计算机视觉任务。

该文件dyhead_prune.py实现了一些深度学习模型中的模块,主要用于动态头(Dynamic Head)结构,通常应用于目标检测等任务。文件中使用了PyTorch框架,并引入了一些额外的库用于构建激活层和归一化层。

首先,文件定义了一个辅助函数_make_divisible,该函数用于确保输入的值能够被指定的除数整除,并且不会小于给定的最小值。这个函数常用于网络结构设计中,以确保通道数等参数的合理性。

接下来,文件定义了几个激活函数类,包括swish、h_swish和h_sigmoid。这些类都继承自nn.Module,并实现了forward方法,具体实现了相应的激活函数。swish函数是一种新型激活函数,h_swish和h_sigmoid则是基于ReLU6的变体,适用于特定的深度学习模型。

然后,文件定义了DyReLU类,这是一个动态ReLU模块。它的构造函数接受多个参数,包括输入通道数、缩减比例、初始化参数等。DyReLU的前向传播方法根据输入的特征图计算输出,使用了自适应平均池化和全连接层。该模块还支持空间注意力机制,通过卷积和批归一化来实现。

接着,定义了DyDCNv2类,这是一个带有归一化层的可调变形卷积模块。它使用了ModulatedDeformConv2d,并在前向传播中计算偏移量和掩码,支持多种归一化方式(如分组归一化和批归一化)。

最后,文件定义了DyHeadBlock_Prune类,这是一个包含三种注意力机制的动态头块。构造函数中初始化了多个卷积层和注意力模块。forward方法计算输入特征图的偏移量和掩码,并通过不同的卷积层进行特征提取和融合,最终输出经过任务注意力模块处理的特征图。

总体来说,该文件实现了动态头结构中的多个关键组件,利用了可调变形卷积和动态激活函数,以提高模型在目标检测等任务中的性能。

10.2 activation.py

import torch

import torch.nn as nn

class AGLU(nn.Module):

“”“AGLU激活函数模块,来源于https://github.com/kostas1515/AGLU。”“”

def __init__(self, device=None, dtype=None) -> None:"""初始化AGLU激活函数模块。"""super().__init__()# 使用Softplus作为基础激活函数,beta设为-1.0self.act = nn.Softplus(beta=-1.0)# 初始化lambda参数,并将其定义为可学习的参数self.lambd = nn.Parameter(nn.init.uniform_(torch.empty(1, device=device, dtype=dtype))) # lambda参数# 初始化kappa参数,并将其定义为可学习的参数self.kappa = nn.Parameter(nn.init.uniform_(torch.empty(1, device=device, dtype=dtype))) # kappa参数def forward(self, x: torch.Tensor) -> torch.Tensor:"""计算AGLU激活函数的前向传播。"""# 将lambda参数限制在最小值0.0001,避免数值不稳定lam = torch.clamp(self.lambd, min=0.0001)# 计算AGLU激活函数的输出return torch.exp((1 / lam) * self.act((self.kappa * x) - torch.log(lam)))

代码注释说明:

导入必要的库:引入PyTorch库及其神经网络模块。

AGLU类:定义了一个名为AGLU的类,继承自nn.Module,表示一个自定义的激活函数模块。

初始化方法:

super().init():调用父类的初始化方法。

self.act:使用Softplus作为基础激活函数,beta参数设置为-1.0。

self.lambd和self.kappa:这两个参数是可学习的,分别用于控制激活函数的形状和输出,初始化为均匀分布的随机值。

前向传播方法:

torch.clamp:将lambd参数限制在最小值0.0001,以避免在计算中出现数值不稳定。

返回值:计算并返回AGLU激活函数的输出,使用了指数函数和Softplus的组合。

这个程序文件 activation.py 定义了一个名为 AGLU 的激活函数模块,属于 Ultralytics YOLO 项目的一部分,遵循 AGPL-3.0 许可证。该模块使用 PyTorch 框架实现,主要用于深度学习模型中的激活函数。

在文件的开头,首先导入了必要的库,包括 torch 和 torch.nn。接着定义了 AGLU 类,该类继承自 nn.Module,表示一个神经网络模块。

在 AGLU 类的构造函数 init 中,初始化了激活函数的相关参数。首先调用 super().init() 来初始化父类。然后,使用 nn.Softplus 激活函数,并将其赋值给 self.act。Softplus 是一种平滑的激活函数,具有类似于 ReLU 的特性。接下来,定义了两个可学习的参数 lambd 和 kappa,它们是通过均匀分布初始化的,并使用 nn.Parameter 包装,以便在训练过程中能够更新这两个参数。

forward 方法实现了前向传播的计算逻辑。它接收一个输入张量 x,并首先对 lambd 参数进行裁剪,确保其值不小于 0.0001,以避免数值不稳定。然后,计算激活函数的输出,使用公式 torch.exp((1 / lam) * self.act((self.kappa * x) - torch.log(lam))),其中 self.act 是之前定义的 Softplus 激活函数。

总的来说,这个模块实现了一种统一的激活函数,结合了可学习的参数,以增强模型的表达能力,适用于深度学习任务中的非线性变换。

10.3 transformer.py

以下是保留的核心代码部分,并添加了详细的中文注释:

import torch

import torch.nn as nn

from functools import partial

引入自定义的归一化模块

from .prepbn import RepBN, LinearNorm

from …modules.transformer import TransformerEncoderLayer

定义一个线性归一化的部分函数

ln = nn.LayerNorm

linearnorm = partial(LinearNorm, norm1=ln, norm2=RepBN, step=60000)

class TransformerEncoderLayer_RepBN(TransformerEncoderLayer):

def init(self, c1, cm=2048, num_heads=8, dropout=0, act=…, normalize_before=False):

# 初始化父类TransformerEncoderLayer

super().init(c1, cm, num_heads, dropout, act, normalize_before)

# 使用自定义的线性归一化self.norm1 = linearnorm(c1)self.norm2 = linearnorm(c1)

class AIFI_RepBN(TransformerEncoderLayer_RepBN):

“”“定义AIFI变换器层。”“”

def __init__(self, c1, cm=2048, num_heads=8, dropout=0, act=nn.GELU(), normalize_before=False):"""使用指定参数初始化AIFI实例。"""super().__init__(c1, cm, num_heads, dropout, act, normalize_before)def forward(self, x):"""AIFI变换器层的前向传播。"""c, h, w = x.shape[1:] # 获取输入张量的通道数、高度和宽度pos_embed = self.build_2d_sincos_position_embedding(w, h, c) # 构建2D正弦余弦位置嵌入# 将输入张量从形状[B, C, H, W]展平为[B, HxW, C]x = super().forward(x.flatten(2).permute(0, 2, 1), pos=pos_embed.to(device=x.device, dtype=x.dtype))# 将输出张量的形状转换回[B, C, H, W]return x.permute(0, 2, 1).view([-1, c, h, w]).contiguous()@staticmethod

def build_2d_sincos_position_embedding(w, h, embed_dim=256, temperature=10000.0):"""构建2D正弦余弦位置嵌入。"""assert embed_dim % 4 == 0, "嵌入维度必须是4的倍数,以便进行2D正弦余弦位置嵌入"grid_w = torch.arange(w, dtype=torch.float32) # 创建宽度的网格grid_h = torch.arange(h, dtype=torch.float32) # 创建高度的网格grid_w, grid_h = torch.meshgrid(grid_w, grid_h, indexing="ij") # 生成网格坐标pos_dim = embed_dim // 4 # 计算位置嵌入的维度omega = torch.arange(pos_dim, dtype=torch.float32) / pos_dim # 计算频率omega = 1.0 / (temperature**omega) # 根据温度调整频率# 计算宽度和高度的正弦余弦值out_w = grid_w.flatten()[..., None] @ omega[None]out_h = grid_h.flatten()[..., None] @ omega[None]# 返回拼接后的正弦余弦位置嵌入return torch.cat([torch.sin(out_w), torch.cos(out_w), torch.sin(out_h), torch.cos(out_h)], 1)[None]

代码核心部分解释:

类定义:

TransformerEncoderLayer_RepBN 继承自 TransformerEncoderLayer,并在构造函数中初始化了两个归一化层。

AIFI_RepBN 继承自 TransformerEncoderLayer_RepBN,实现了前向传播和位置嵌入的构建。

前向传播:

在 forward 方法中,输入张量 x 的形状被转换为适合变换器的格式,并计算出位置嵌入。

位置嵌入构建:

build_2d_sincos_position_embedding 方法生成了2D正弦余弦位置嵌入,用于增强模型对位置信息的理解。

重要性:

这段代码实现了一个自定义的变换器层,结合了特殊的归一化方法和位置嵌入方式,适用于处理图像等二维数据,能够提高模型的表现。

这个程序文件 transformer.py 定义了一个基于 Transformer 的编码层,主要用于处理图像或其他二维数据。它使用了改进的归一化方法(RepBN)和线性归一化(LinearNorm),并实现了一个特定的 Transformer 层(AIFI_RepBN)。

首先,文件导入了必要的 PyTorch 库,包括神经网络模块和功能模块。接着,使用 functools.partial 创建了一个 linearnorm 函数,该函数结合了 LayerNorm 和 RepBN,并设置了一个步数参数(step=60000),这在训练过程中可能用于调整归一化的行为。

接下来,定义了一个名为 TransformerEncoderLayer_RepBN 的类,它继承自 TransformerEncoderLayer。在初始化方法中,调用了父类的构造函数,并为该层定义了两个归一化层 norm1 和 norm2,这两个层都使用了之前定义的 linearnorm。

然后,定义了 AIFI_RepBN 类,继承自 TransformerEncoderLayer_RepBN,并在其构造函数中设置了一些默认参数,如 cm、num_heads、dropout 和激活函数(默认为 GELU)。这个类代表了一个特定的 Transformer 层,名为 AIFI。

在 AIFI_RepBN 类中,重写了 forward 方法,该方法负责前向传播。首先,它获取输入张量 x 的形状,并调用 build_2d_sincos_position_embedding 方法生成二维的正弦-余弦位置嵌入。然后,将输入张量从形状 [B, C, H, W] 展平为 [B, HxW, C],并传递给父类的 forward 方法进行处理。最后,将输出张量的形状恢复为 [B, C, H, W]。

build_2d_sincos_position_embedding 是一个静态方法,用于生成二维的正弦-余弦位置嵌入。该方法首先检查嵌入维度是否可以被4整除,这是生成位置嵌入的要求。然后,创建两个网格(grid_w 和 grid_h),分别表示宽度和高度的坐标。接着,计算嵌入的频率(omega),并使用这些频率生成正弦和余弦的嵌入。最终,返回一个包含正弦和余弦值的张量。

总的来说,这个文件实现了一个基于 Transformer 的编码层,结合了先进的归一化技术和位置嵌入方法,适用于处理具有空间结构的数据。

10.4 test_selective_scan_speed.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn.functional as F

def build_selective_scan_fn(selective_scan_cuda: object = None, mode=“mamba_ssm”, tag=None):

“”"

构建选择性扫描函数的工厂函数,返回一个可用于前向和反向传播的自定义函数。

参数:

selective_scan_cuda: 自定义CUDA实现的选择性扫描函数

mode: 选择性扫描的模式

tag: 标签,用于标识不同的选择性扫描实现

"""class SelectiveScanFn(torch.autograd.Function):@staticmethoddef forward(ctx, u, delta, A, B, C, D=None, z=None, delta_bias=None, delta_softplus=False, return_last_state=False, nrows=1, backnrows=-1):"""前向传播函数,计算选择性扫描的输出。参数:ctx: 上下文对象,用于保存信息以供反向传播使用u: 输入张量delta: 增量张量A, B, C: 相关参数张量D: 可选的张量z: 可选的张量delta_bias: 可选的增量偏置delta_softplus: 是否使用softplus激活return_last_state: 是否返回最后的状态nrows: 行数backnrows: 反向行数返回:输出张量或输出和最后状态的元组"""# 确保输入张量是连续的if u.stride(-1) != 1:u = u.contiguous()if delta.stride(-1) != 1:delta = delta.contiguous()if D is not None:D = D.contiguous()if B.stride(-1) != 1:B = B.contiguous()if C.stride(-1) != 1:C = C.contiguous()if z is not None and z.stride(-1) != 1:z = z.contiguous()# 处理输入的维度和形状if B.dim() == 3:B = rearrange(B, "b dstate l -> b 1 dstate l")ctx.squeeze_B = Trueif C.dim() == 3:C = rearrange(C, "b dstate l -> b 1 dstate l")ctx.squeeze_C = True# 确保数据类型为floatif D is not None and (D.dtype != torch.float):ctx._d_dtype = D.dtypeD = D.float()if delta_bias is not None and (delta_bias.dtype != torch.float):ctx._delta_bias_dtype = delta_bias.dtypedelta_bias = delta_bias.float()# 进行选择性扫描的计算if mode == "mamba_ssm":out, x, *rest = selective_scan_cuda.fwd(u, delta, A, B, C, D, z, delta_bias, delta_softplus)else:raise NotImplementedError("未实现的模式")# 保存需要用于反向传播的张量ctx.save_for_backward(u, delta, A, B, C, D, delta_bias, x)last_state = x[:, :, -1, 1::2] # 获取最后的状态return out if not return_last_state else (out, last_state)@staticmethoddef backward(ctx, dout):"""反向传播函数,计算梯度。参数:ctx: 上下文对象,包含前向传播时保存的信息dout: 上游梯度返回:输入张量的梯度"""u, delta, A, B, C, D, delta_bias, x = ctx.saved_tensors# 计算反向传播的梯度du, ddelta, dA, dB, dC, dD, ddelta_bias, *rest = selective_scan_cuda.bwd(u, delta, A, B, C, D, delta_bias, dout, x, None, False)return (du, ddelta, dA, dB, dC, dD if D is not None else None, ddelta_bias if delta_bias is not None else None)def selective_scan_fn(u, delta, A, B, C, D=None, z=None, delta_bias=None, delta_softplus=False, return_last_state=False, nrows=1, backnrows=-1):"""封装选择性扫描函数的调用,方便使用。"""return SelectiveScanFn.apply(u, delta, A, B, C, D, z, delta_bias, delta_softplus, return_last_state, nrows, backnrows)return selective_scan_fn

代码说明:

build_selective_scan_fn: 这是一个工厂函数,用于创建选择性扫描的自定义函数。它接受CUDA实现、模式和标签作为参数。

SelectiveScanFn: 这是一个继承自torch.autograd.Function的类,定义了前向和反向传播的逻辑。

forward方法: 计算选择性扫描的输出。它处理输入的形状和数据类型,并调用CUDA实现的前向函数。

backward方法: 计算反向传播的梯度,使用CUDA实现的反向函数。

selective_scan_fn: 封装SelectiveScanFn的调用,简化使用。

通过这些核心部分,用户可以方便地进行选择性扫描的前向和反向传播计算。

这个程序文件 test_selective_scan_speed.py 是一个用于测试选择性扫描(Selective Scan)算法性能的脚本,主要使用 PyTorch 框架实现。程序的核心部分是定义了一些函数和类,用于实现选择性扫描的前向和反向传播操作,并通过不同的模式和参数进行性能测试。

首先,文件导入了必要的库,包括 PyTorch、数学运算库、时间库和其他一些工具库。接着,定义了一个构建选择性扫描函数的工厂函数 build_selective_scan_fn,该函数接受一个 CUDA 实现的选择性扫描函数和一些配置参数,返回一个自定义的选择性扫描函数 selective_scan_fn。

在 SelectiveScanFn 类中,定义了前向传播 forward 和反向传播 backward 方法。前向传播方法处理输入数据的维度和连续性,确保输入张量是连续的。然后,根据不同的模式调用相应的 CUDA 实现,计算输出和中间状态,并保存必要的张量以供反向传播使用。反向传播方法则根据保存的上下文计算梯度,支持多种输入情况和数据类型。

此外,文件中还定义了多个选择性扫描的参考实现函数,例如 selective_scan_ref、selective_scan_easy 和 selective_scan_easy_v2,这些函数实现了选择性扫描的基本逻辑,处理输入数据并返回计算结果。

在 test_speed 函数中,设置了一些测试参数,包括数据类型、序列长度、批量大小和状态维度等。然后生成随机输入数据,调用不同的选择性扫描实现进行性能测试。通过记录每个实现的执行时间,比较它们的速度和效率。

最后,脚本通过 test_speed 函数执行所有的性能测试,并打印出每个测试的执行时间。这个程序的设计目的是为了评估不同选择性扫描实现的性能,帮助开发者选择最合适的实现方式。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式