【完整源码+数据集+部署教程】 盲道图像分割损坏检测系统源码和数据集:改进yolo11-GhostHGNetV2

背景意义

研究背景与意义

随着城市化进程的加快,城市基础设施的建设与维护显得尤为重要。盲道作为城市公共设施的重要组成部分,不仅为视障人士提供了安全的出行通道,也在提升城市人性化设计方面发挥着重要作用。然而,随着时间的推移,盲道在使用过程中容易出现损坏,影响其功能的发挥,甚至可能对使用者造成安全隐患。因此,及时、准确地检测盲道的损坏情况,成为了城市管理者亟需解决的问题。

传统的盲道损坏检测方法多依赖人工巡查,效率低下且容易受到主观因素的影响。近年来,计算机视觉技术的快速发展为盲道损坏检测提供了新的解决方案。基于深度学习的图像分割技术,尤其是YOLO(You Only Look Once)系列模型,因其在目标检测和分割任务中的优越性能,逐渐成为研究的热点。YOLOv11作为该系列的最新版本,具备更高的检测精度和实时性,能够有效地处理复杂场景下的图像数据。

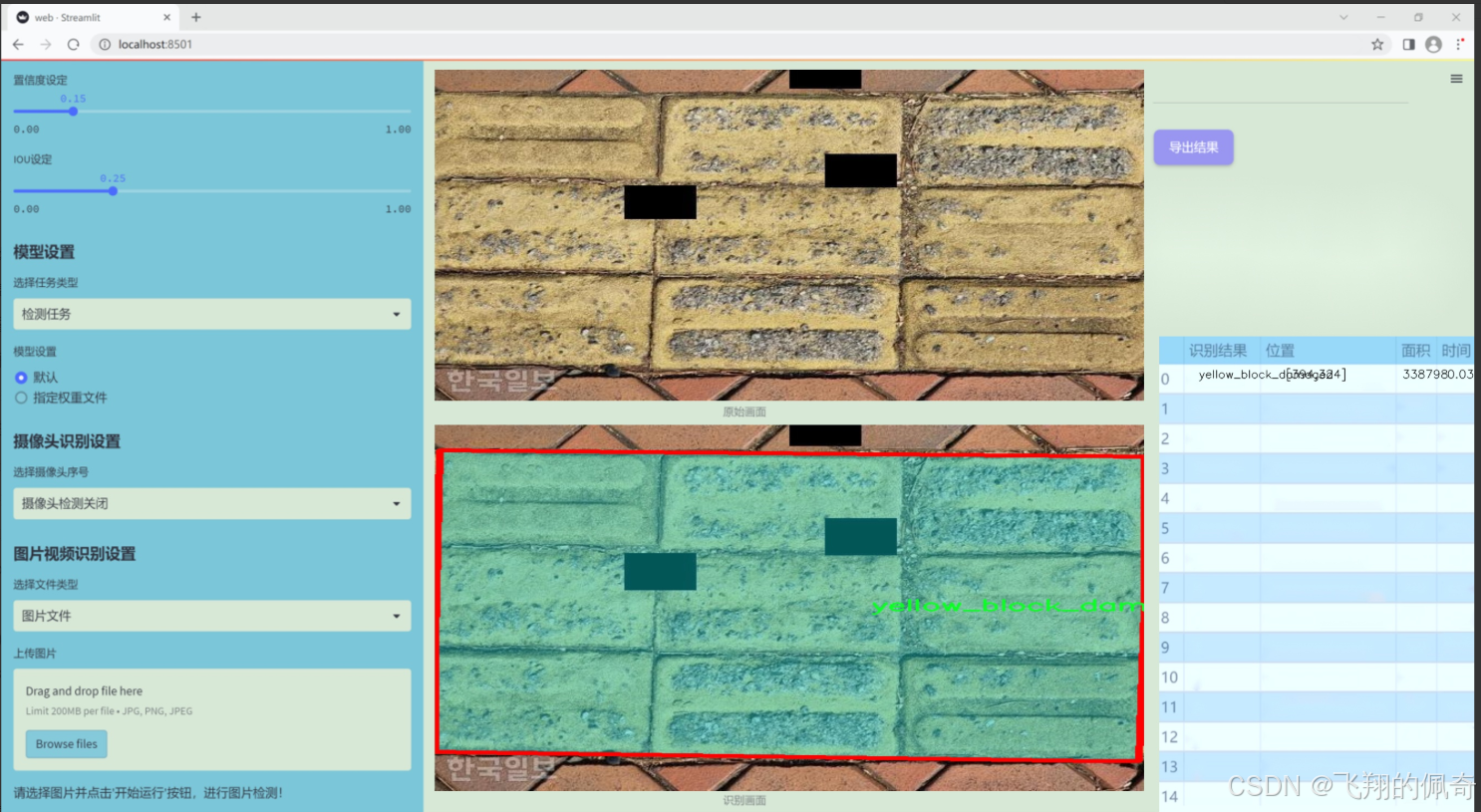

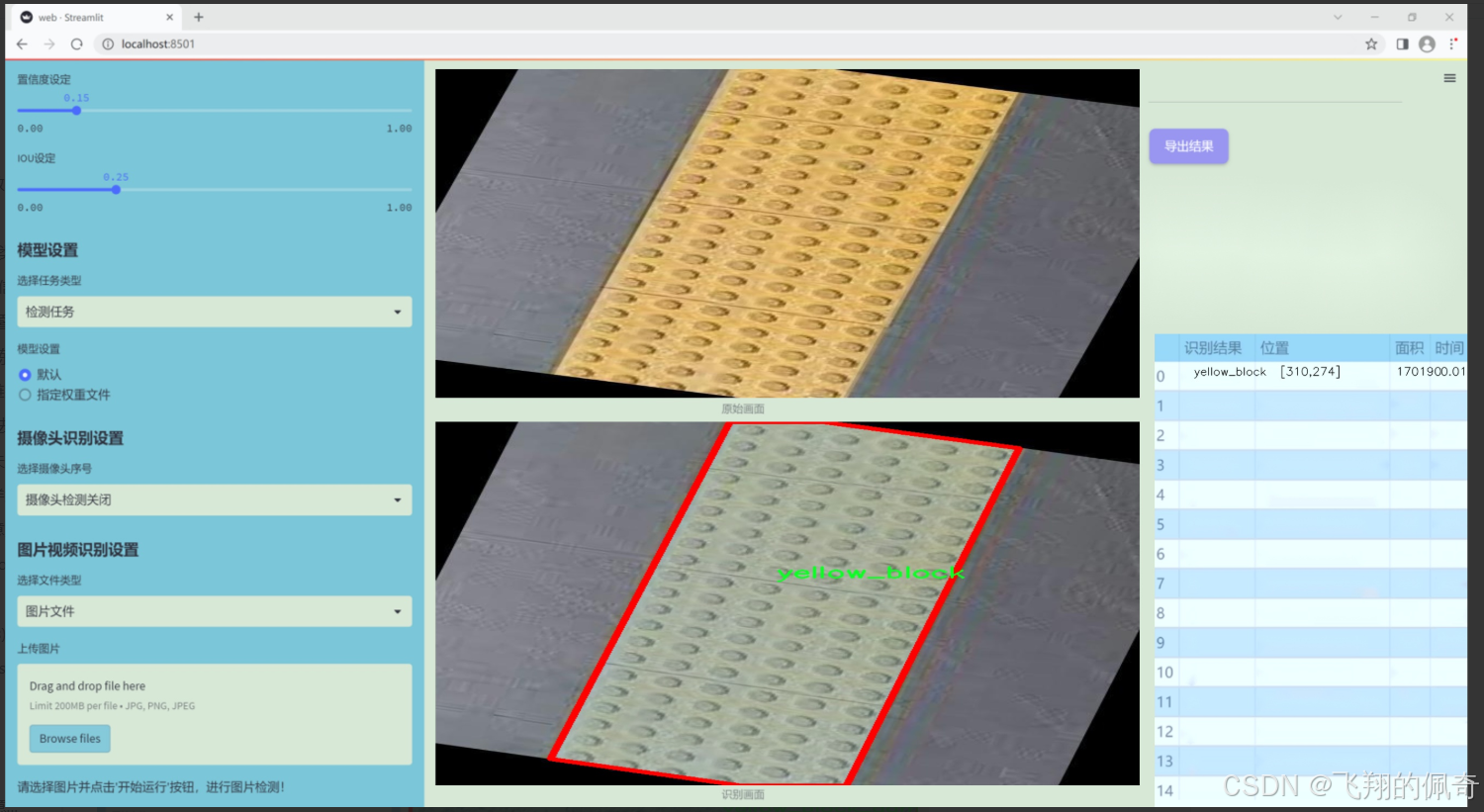

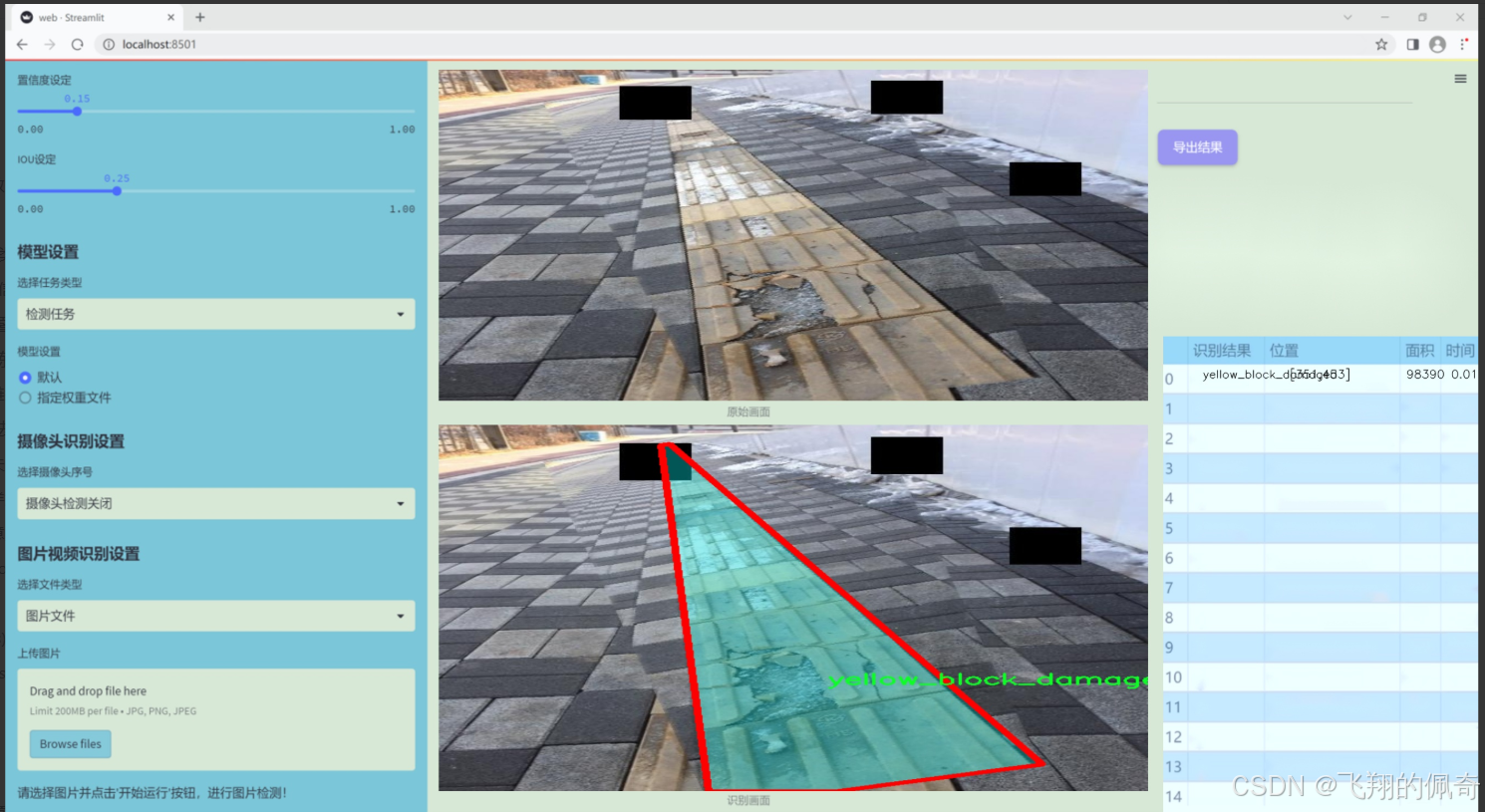

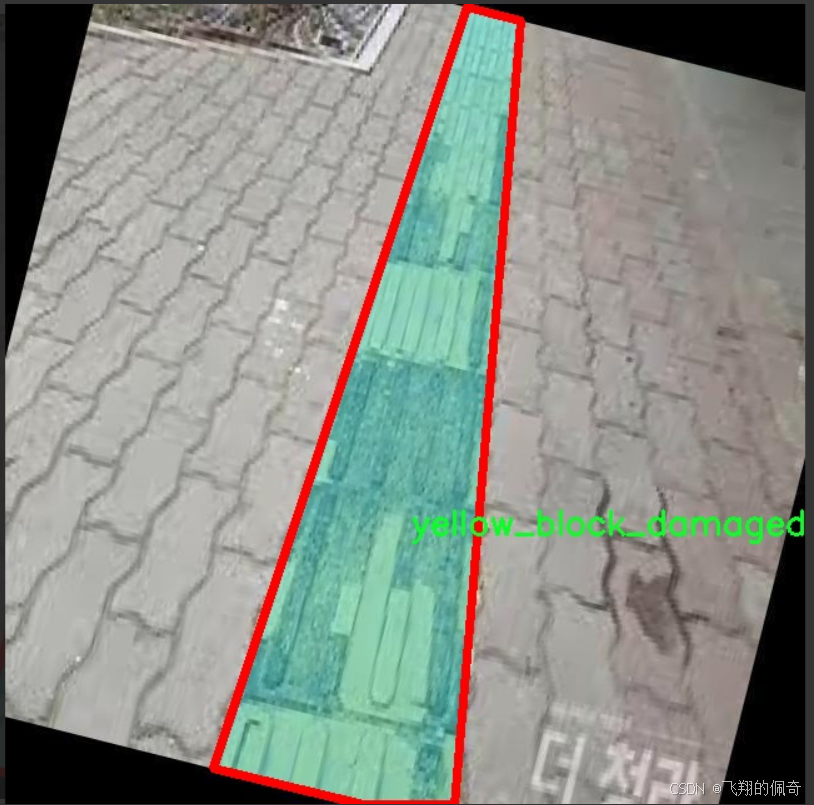

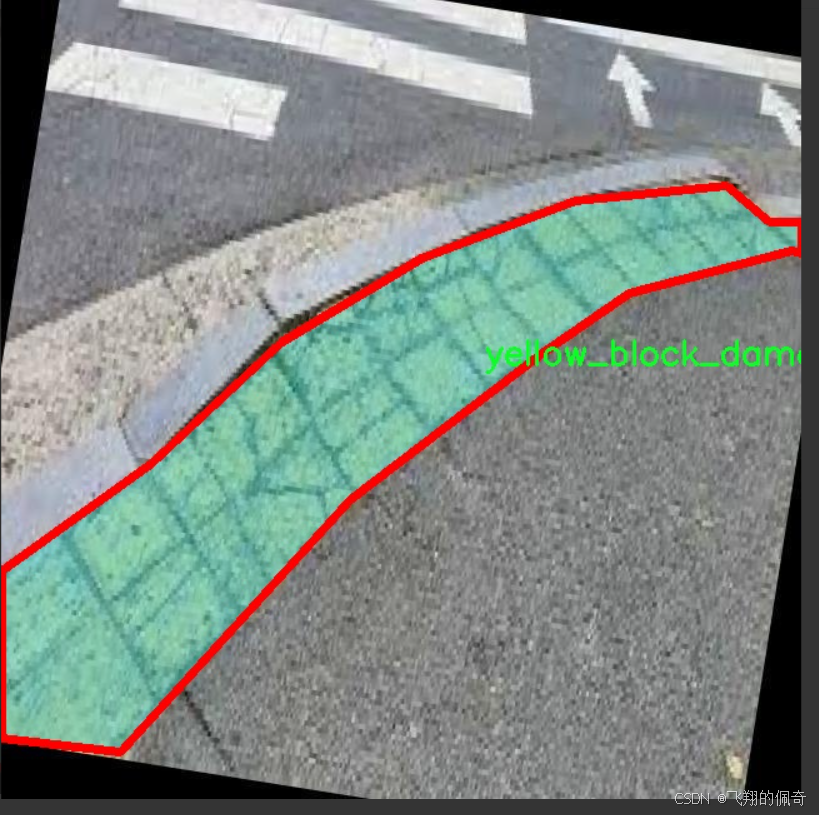

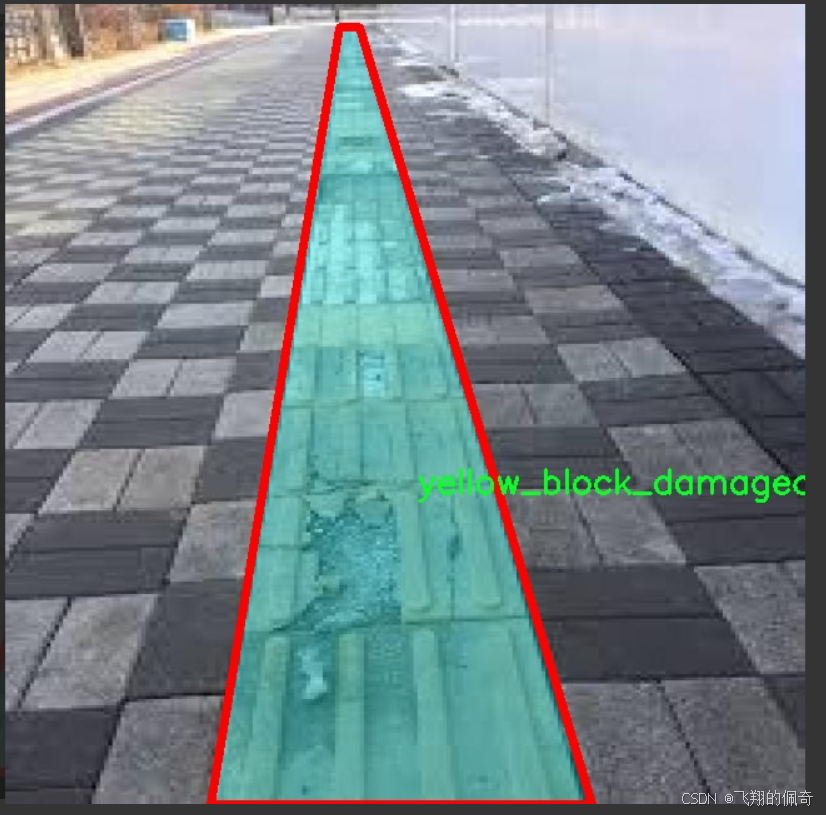

本研究旨在基于改进的YOLOv11模型,构建一个高效的盲道图像分割损坏检测系统。通过利用包含1402张图像的数据集,该数据集包含两类标注:正常的“yellow_block”和损坏的“yellow_block_damaged”。该系统不仅能够自动识别和分割盲道的损坏区域,还能为后续的城市基础设施维护提供数据支持和决策依据。通过引入先进的图像处理技术,我们希望能够提高盲道损坏检测的准确性和效率,进而推动城市公共设施的智能化管理,提升视障人士的出行安全与便利性。这一研究不仅具有重要的学术价值,也为实际应用提供了切实可行的解决方案。

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集专注于“YellowBlock”主题,旨在为改进YOLOv11的盲道图像分割损坏检测系统提供高质量的训练数据。该数据集包含两类主要对象,分别为“yellow_block”和“yellow_block_damaged”。通过对这两类对象的细致标注和分类,我们能够有效地训练模型,以便其在实际应用中能够准确识别和区分完好与损坏的盲道标识。

在数据集的构建过程中,我们特别注重数据的多样性和代表性,以确保模型能够在不同环境和条件下表现出色。数据集中的“yellow_block”类别代表了标准的盲道标识,通常用于指引行人安全通行。而“yellow_block_damaged”类别则涵盖了各种损坏情况,例如磨损、破裂或颜色褪色等。这种分类不仅帮助模型学习到正常状态与损坏状态之间的差异,还能提高其在实际应用中的鲁棒性和准确性。

为了确保数据集的质量,我们在数据收集阶段采用了多种拍摄角度和光照条件,以增强模型的泛化能力。此外,数据集中的图像经过严格的预处理和标注,确保每一张图像都能为模型的训练提供有效的信息。通过这种精心设计的数据集,我们期望能够显著提升YOLOv11在盲道图像分割损坏检测任务中的性能,使其在实际应用中能够快速、准确地识别和定位盲道的损坏情况,从而为城市基础设施的维护和管理提供有力支持。

核心代码

以下是经过简化并添加详细中文注释的核心代码部分:

import torch

import torch.nn as nn

import numpy as np

class Mlp(nn.Module):

“”“多层感知机(MLP)模块”“”

def init(self, in_features, hidden_features=None, out_features=None, act_layer=nn.GELU, drop=0.):

super().init()

out_features = out_features or in_features # 输出特征数

hidden_features = hidden_features or in_features # 隐藏层特征数

self.fc1 = nn.Linear(in_features, hidden_features) # 第一层线性变换

self.act = act_layer() # 激活函数

self.fc2 = nn.Linear(hidden_features, out_features) # 第二层线性变换

self.drop = nn.Dropout(drop) # Dropout层

def forward(self, x):"""前向传播"""x = self.fc1(x) # 线性变换x = self.act(x) # 激活x = self.drop(x) # Dropoutx = self.fc2(x) # 线性变换x = self.drop(x) # Dropoutreturn x

class CSWinBlock(nn.Module):

“”“CSWin Transformer中的一个块”“”

def init(self, dim, num_heads, mlp_ratio=4., drop=0., attn_drop=0., norm_layer=nn.LayerNorm):

super().init()

self.dim = dim # 输入特征维度

self.num_heads = num_heads # 注意力头数

self.mlp_ratio = mlp_ratio # MLP的扩展比例

self.norm1 = norm_layer(dim) # 第一层归一化

self.qkv = nn.Linear(dim, dim * 3) # 线性变换生成Q、K、V

# 注意力层self.attn = LePEAttention(dim, num_heads=num_heads, attn_drop=attn_drop)# MLP层mlp_hidden_dim = int(dim * mlp_ratio) # 隐藏层维度self.mlp = Mlp(in_features=dim, hidden_features=mlp_hidden_dim, out_features=dim)self.norm2 = norm_layer(dim) # 第二层归一化def forward(self, x):"""前向传播"""x = self.norm1(x) # 归一化qkv = self.qkv(x).reshape(x.shape[0], -1, 3, self.dim).permute(2, 0, 1, 3) # 生成Q、K、Vx = self.attn(qkv) # 注意力计算x = x + self.drop_path(x) # 残差连接x = x + self.drop_path(self.mlp(self.norm2(x))) # MLP和残差连接return x

class CSWinTransformer(nn.Module):

“”“CSWin Transformer模型”“”

def init(self, img_size=640, in_chans=3, num_classes=1000, embed_dim=96, depth=[2,2,6,2], num_heads=12):

super().init()

self.num_classes = num_classes

self.embed_dim = embed_dim # 嵌入维度

# 初始卷积嵌入层self.stage1_conv_embed = nn.Sequential(nn.Conv2d(in_chans, embed_dim, kernel_size=7, stride=4, padding=2),nn.LayerNorm(embed_dim))# CSWinBlock的多个阶段self.stage1 = nn.ModuleList([CSWinBlock(dim=embed_dim, num_heads=num_heads) for _ in range(depth[0])])# 继续添加其他阶段...def forward(self, x):"""前向传播"""x = self.stage1_conv_embed(x) # 初始卷积嵌入for blk in self.stage1:x = blk(x) # 通过每个CSWinBlockreturn x

其他函数和模型注册代码省略…

代码说明:

Mlp类:实现了一个多层感知机,包含两个线性层和一个激活函数,支持Dropout。

CSWinBlock类:实现了CSWin Transformer中的一个基本块,包含注意力机制和MLP结构,使用残差连接。

CSWinTransformer类:定义了整个CSWin Transformer模型,包括初始的卷积嵌入层和多个CSWinBlock的堆叠。

这段代码展示了CSWin Transformer的基本结构和工作流程,核心部分主要集中在模型的块和前向传播的实现上。

这个程序文件实现了一个名为CSWin Transformer的深度学习模型,主要用于计算机视觉任务。代码中包含了多个类和函数,具体功能如下:

首先,导入了必要的库,包括PyTorch及其模块、一些辅助函数和工具,如timm库中的功能和einops库中的重排层。这些库为模型的构建和训练提供了基础。

接下来,定义了一个名为Mlp的类,这是一个多层感知机(MLP),它包含两个线性层和一个激活函数(默认为GELU),并在每个线性层后添加了Dropout以防止过拟合。该类的forward方法实现了数据的前向传播。

然后,定义了LePEAttention类,它实现了一种新的注意力机制。该类的构造函数中定义了输入维度、分辨率、头数等参数,并初始化了卷积层和Dropout层。该类的forward方法实现了对输入的查询、键、值的处理,并计算注意力分数,最后返回经过注意力机制处理后的结果。

CSWinBlock类是模型的基本构建块,它结合了MLP和LePEAttention。构造函数中定义了多个参数,包括输入维度、头数、分辨率等,并初始化了相关层。在forward方法中,首先对输入进行归一化,然后计算查询、键、值,并通过注意力机制处理,最后将结果与输入相加并经过MLP处理。

接下来,定义了img2windows和windows2img两个辅助函数,用于将图像数据转换为窗口格式以及将窗口格式的数据转换回图像格式。这些函数在处理图像时非常重要,因为它们帮助模型有效地处理局部信息。

Merge_Block类用于在不同阶段之间合并特征图,它通过卷积层和归一化层实现了特征的下采样。

CSWinTransformer类是整个模型的核心,负责构建整个网络结构。构造函数中定义了输入图像的大小、补丁大小、输入通道数、类别数、嵌入维度、深度等参数,并依次构建了多个阶段的网络。每个阶段由多个CSWinBlock组成,并通过Merge_Block进行特征合并。模型的forward_features方法实现了特征的前向传播,并在每个阶段提取特征。

最后,定义了一些辅助函数,如_conv_filter和update_weight,用于处理模型权重的更新和转换。此外,还定义了CSWin_tiny、CSWin_small、CSWin_base和CSWin_large等函数,分别构建不同规模的CSWin Transformer模型,并支持加载预训练权重。

在主程序中,创建了随机输入数据,并实例化了不同规模的模型,进行前向传播并打印输出特征的尺寸。这部分代码用于测试模型的构建和功能是否正常。

总体来说,这个程序实现了一个高效的视觉Transformer模型,结合了多种先进的技术,适用于各种计算机视觉任务。

10.3 hcfnet.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

class SpatialAttentionModule(nn.Module):

def init(self):

super(SpatialAttentionModule, self).init()

# 定义一个卷积层,用于生成空间注意力图

self.conv2d = nn.Conv2d(in_channels=2, out_channels=1, kernel_size=7, stride=1, padding=3)

self.sigmoid = nn.Sigmoid() # 使用Sigmoid激活函数将输出限制在0到1之间

def forward(self, x):# 计算输入特征图的平均值和最大值avgout = torch.mean(x, dim=1, keepdim=True) # 在通道维度上求平均maxout, _ = torch.max(x, dim=1, keepdim=True) # 在通道维度上求最大值# 将平均值和最大值拼接在一起out = torch.cat([avgout, maxout], dim=1)# 通过卷积层和Sigmoid激活函数生成空间注意力图out = self.sigmoid(self.conv2d(out))# 将输入特征图与空间注意力图相乘,增强重要特征return out * x

class PPA(nn.Module):

def init(self, in_features, filters) -> None:

super().init()

# 定义多个卷积层和注意力模块

self.skip = nn.Conv2d(in_features, filters, kernel_size=1, bias=False) # 跳跃连接

self.c1 = nn.Conv2d(filters, filters, kernel_size=3, padding=1)

self.c2 = nn.Conv2d(filters, filters, kernel_size=3, padding=1)

self.c3 = nn.Conv2d(filters, filters, kernel_size=3, padding=1)

self.sa = SpatialAttentionModule() # 空间注意力模块

self.drop = nn.Dropout2d(0.1) # Dropout层,防止过拟合

self.bn1 = nn.BatchNorm2d(filters) # 批归一化

self.silu = nn.SiLU() # SiLU激活函数

def forward(self, x):# 通过卷积层和跳跃连接处理输入x_skip = self.skip(x)x1 = self.c1(x)x2 = self.c2(x1)x3 = self.c3(x2)# 将多个特征图相加x = x1 + x2 + x3 + x_skipx = self.sa(x) # 应用空间注意力模块x = self.drop(x) # 应用Dropoutx = self.bn1(x) # 应用批归一化x = self.silu(x) # 应用SiLU激活函数return x

class DASI(nn.Module):

def init(self, in_features, out_features) -> None:

super().init()

# 定义多个卷积层和Bag模块

self.bag = Bag() # Bag模块

self.tail_conv = nn.Conv2d(out_features, out_features, kernel_size=1)

self.conv = nn.Conv2d(out_features // 2, out_features // 4, kernel_size=1)

self.bns = nn.BatchNorm2d(out_features)

# 定义跳跃连接的卷积层self.skips = nn.Conv2d(in_features[1], out_features, kernel_size=1)self.skips_2 = nn.Conv2d(in_features[0], out_features, kernel_size=1)self.skips_3 = nn.Conv2d(in_features[2], out_features, kernel_size=3, stride=2, dilation=2, padding=2)self.silu = nn.SiLU() # SiLU激活函数def forward(self, x_list):# 解包输入特征图x_low, x, x_high = x_listx_high = self.skips_3(x_high) if x_high is not None else Nonex_low = self.skips_2(x_low) if x_low is not None else Nonex = self.skips(x) # 处理主特征图x_skip = x # 保存跳跃连接的特征图x = torch.chunk(x, 4, dim=1) # 将特征图分成4个部分# 根据高低特征图的存在情况进行不同的处理if x_high is None:x0 = self.conv(torch.cat((x[0], x_low[0]), dim=1)) if x_low is not None else self.conv(x[0])x1 = self.conv(torch.cat((x[1], x_low[1]), dim=1)) if x_low is not None else self.conv(x[1])x2 = self.conv(torch.cat((x[2], x_low[2]), dim=1)) if x_low is not None else self.conv(x[2])x3 = self.conv(torch.cat((x[3], x_low[3]), dim=1)) if x_low is not None else self.conv(x[3])else:x0 = self.bag(x_low[0], x_high[0], x[0])x1 = self.bag(x_low[1], x_high[1], x[1])x2 = self.bag(x_low[2], x_high[2], x[2])x3 = self.bag(x_low[3], x_high[3], x[3])# 将处理后的特征图拼接x = torch.cat((x0, x1, x2, x3), dim=1)x = self.tail_conv(x) # 通过尾部卷积层x += x_skip # 加上跳跃连接x = self.bns(x) # 应用批归一化x = self.silu(x) # 应用SiLU激活函数return x

代码核心部分说明:

SpatialAttentionModule:实现了空间注意力机制,通过计算输入特征图的平均值和最大值,生成注意力图并加权输入特征图,增强重要特征。

PPA:主网络结构,包含多个卷积层和空间注意力模块,通过跳跃连接和多层特征融合来提高特征表达能力。

DASI:通过Bag模块融合不同层次的特征图,使用卷积层和激活函数进行处理,最终输出融合后的特征图。

这个程序文件 hcfnet.py 实现了一个深度学习模型的几个组件,主要用于图像处理任务。文件中定义了多个类,每个类代表一个特定的模块,主要包括空间注意力模块、局部全局注意力模块、ECA(Efficient Channel Attention)、PPA(Parallel Processing Attention)和DASI(Dual Attention Spatial Interaction)。

首先,SpatialAttentionModule 类实现了一个空间注意力机制。该模块通过计算输入特征图的平均值和最大值来生成注意力图,然后通过卷积层和Sigmoid激活函数处理这些特征,最终将注意力图与输入特征图相乘,从而突出重要的空间信息。

接下来,LocalGlobalAttention 类实现了局部和全局注意力机制。该模块首先将输入特征图分割成小块(patches),然后通过多层感知机(MLP)处理这些小块以提取特征。接着,计算这些特征的注意力权重,并通过余弦相似度与一个可学习的提示向量进行结合,最终输出增强后的特征图。

ECA 类实现了一种高效的通道注意力机制。它通过自适应平均池化来生成通道特征,并使用一维卷积来计算通道之间的关系,最后通过Sigmoid激活函数生成通道注意力权重并与输入特征图相乘。

PPA 类是一个综合模块,结合了多个卷积层、空间注意力模块、ECA和局部全局注意力模块。它通过跳跃连接(skip connection)将不同层的特征结合在一起,增强特征的表达能力,并在最后应用批归一化和激活函数(SiLU)来提高模型的非线性表达能力。

Bag 类实现了一个简单的加权融合机制,通过计算边缘注意力来对输入特征进行加权组合。

最后,DASI 类是一个更复杂的模块,负责处理多个输入特征图。它通过跳跃连接和融合机制将不同分辨率的特征结合在一起,使用卷积层进行特征变换,并在最后应用批归一化和激活函数。这个模块能够有效地整合来自不同层次的信息,增强模型的表现。

整体来看,这个文件实现了一种结合了多种注意力机制和特征融合策略的深度学习模型,旨在提高图像处理任务中的特征提取和表示能力。

10.4 attention.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

from torch import nn

class EMA(nn.Module):

“”"

Exponential Moving Average (EMA) 模块

“”"

def init(self, channels, factor=8):

super(EMA, self).init()

self.groups = factor # 将通道分为若干组

assert channels // self.groups > 0 # 确保每组至少有一个通道

self.softmax = nn.Softmax(-1) # 用于计算权重的softmax

self.agp = nn.AdaptiveAvgPool2d((1, 1)) # 自适应平均池化

self.pool_h = nn.AdaptiveAvgPool2d((None, 1)) # 针对高度的池化

self.pool_w = nn.AdaptiveAvgPool2d((1, None)) # 针对宽度的池化

self.gn = nn.GroupNorm(channels // self.groups, channels // self.groups) # 组归一化

self.conv1x1 = nn.Conv2d(channels // self.groups, channels // self.groups, kernel_size=1) # 1x1卷积

self.conv3x3 = nn.Conv2d(channels // self.groups, channels // self.groups, kernel_size=3, padding=1) # 3x3卷积

def forward(self, x):b, c, h, w = x.size() # 获取输入的尺寸group_x = x.reshape(b * self.groups, -1, h, w) # 将输入重塑为分组形式x_h = self.pool_h(group_x) # 对高度进行池化x_w = self.pool_w(group_x).permute(0, 1, 3, 2) # 对宽度进行池化并调整维度hw = self.conv1x1(torch.cat([x_h, x_w], dim=2)) # 1x1卷积处理x_h, x_w = torch.split(hw, [h, w], dim=2) # 分割回高度和宽度x1 = self.gn(group_x * x_h.sigmoid() * x_w.permute(0, 1, 3, 2).sigmoid()) # 组归一化x2 = self.conv3x3(group_x) # 3x3卷积处理x11 = self.softmax(self.agp(x1).reshape(b * self.groups, -1, 1).permute(0, 2, 1)) # 计算权重x12 = x2.reshape(b * self.groups, c // self.groups, -1) # 重塑x2x21 = self.softmax(self.agp(x2).reshape(b * self.groups, -1, 1).permute(0, 2, 1)) # 计算权重x22 = x1.reshape(b * self.groups, c // self.groups, -1) # 重塑x1weights = (torch.matmul(x11, x12) + torch.matmul(x21, x22)).reshape(b * self.groups, 1, h, w) # 计算最终权重return (group_x * weights.sigmoid()).reshape(b, c, h, w) # 返回加权后的输出

class SimAM(nn.Module):

“”"

SimAM 模块

“”"

def init(self, e_lambda=1e-4):

super(SimAM, self).init()

self.activaton = nn.Sigmoid() # Sigmoid激活函数

self.e_lambda = e_lambda # 正则化参数

def forward(self, x):b, c, h, w = x.size() # 获取输入的尺寸n = w * h - 1 # 计算样本数# 计算均值平方差x_minus_mu_square = (x - x.mean(dim=[2, 3], keepdim=True)).pow(2)# 计算yy = x_minus_mu_square / (4 * (x_minus_mu_square.sum(dim=[2, 3], keepdim=True) / n + self.e_lambda)) + 0.5return x * self.activaton(y) # 返回加权后的输出

class SpatialGroupEnhance(nn.Module):

“”"

空间组增强模块

“”"

def init(self, groups=8):

super().init()

self.groups = groups # 组数

self.avg_pool = nn.AdaptiveAvgPool2d(1) # 自适应平均池化

self.weight = nn.Parameter(torch.zeros(1, groups, 1, 1)) # 权重参数

self.bias = nn.Parameter(torch.zeros(1, groups, 1, 1)) # 偏置参数

self.sig = nn.Sigmoid() # Sigmoid激活函数

self.init_weights() # 初始化权重

def init_weights(self):for m in self.modules():if isinstance(m, nn.Conv2d):nn.init.kaiming_normal_(m.weight, mode='fan_out') # Kaiming初始化if m.bias is not None:nn.init.constant_(m.bias, 0) # 偏置初始化为0elif isinstance(m, nn.BatchNorm2d):nn.init.constant_(m.weight, 1) # BN权重初始化为1nn.init.constant_(m.bias, 0) # BN偏置初始化为0elif isinstance(m, nn.Linear):nn.init.normal_(m.weight, std=0.001) # 线性层权重初始化if m.bias is not None:nn.init.constant_(m.bias, 0) # 偏置初始化为0def forward(self, x):b, c, h, w = x.shape # 获取输入的尺寸x = x.view(b * self.groups, -1, h, w) # 重塑输入xn = x * self.avg_pool(x) # 计算平均池化xn = xn.sum(dim=1, keepdim=True) # 对组求和t = xn.view(b * self.groups, -1) # 重塑t = t - t.mean(dim=1, keepdim=True) # 去均值std = t.std(dim=1, keepdim=True) + 1e-5 # 计算标准差t = t / std # 归一化t = t.view(b, self.groups, h, w) # 重塑t = t * self.weight + self.bias # 加权和偏置t = t.view(b * self.groups, 1, h, w) # 重塑x = x * self.sig(t) # 加权输入x = x.view(b, c, h, w) # 恢复原始形状return x

代码说明:

EMA: 实现了指数移动平均,主要用于平滑特征图的输出,增强模型的稳定性。

SimAM: 通过计算均值的平方差来增强特征图,结合Sigmoid激活函数,提供了一种自适应的特征增强方式。

SpatialGroupEnhance: 通过自适应平均池化和Sigmoid激活函数对输入进行空间增强,能够有效地提升特征图的表达能力。

以上是代码的核心部分及其详细注释,帮助理解每个模块的功能和实现方式。

这个程序文件 attention.py 实现了一系列与注意力机制相关的模块,主要用于深度学习中的图像处理和计算机视觉任务。文件中使用了 PyTorch 框架,定义了多个类和函数来实现不同类型的注意力机制。

首先,文件导入了必要的库,包括 torch、torch.nn、torchvision 和其他一些用于高效计算和模型构建的工具。接着,定义了一些常用的注意力模块,例如 EMA(Exponential Moving Average)、SimAM(Similarity Attention Module)、SpatialGroupEnhance 等。

EMA 类实现了一种基于通道的注意力机制,通过对输入特征图进行分组和池化,计算出加权系数,从而增强特征表示。SimAM 类则实现了一种基于相似度的注意力机制,利用 Sigmoid 激活函数对特征进行加权。

SpatialGroupEnhance 类实现了一种空间组增强机制,通过对输入特征图进行分组和池化,计算出每个组的权重,从而提升特征的表达能力。

文件中还实现了 TopkRouting、KVGather 和 QKVLinear 等类,这些类共同构成了一个复杂的注意力机制,能够在不同的空间位置之间进行信息传递和加权。

BiLevelRoutingAttention 类实现了一种双层路由注意力机制,结合了局部和全局的特征信息,能够在不同的尺度上进行特征提取。该类支持多种参数配置,例如注意力头的数量、窗口大小等。

此外,文件中还实现了一些其他的注意力模块,如 CoordAtt、TripletAttention、BAMBlock、EfficientAttention 等。这些模块各自有不同的设计目标和应用场景,例如 CoordAtt 通过坐标信息来增强特征表示,TripletAttention 则结合了通道、行和列的注意力机制。

文件的最后部分定义了一些辅助类和函数,如 img2windows 和 windows2img,用于在图像和窗口之间进行转换,以便在注意力计算中使用。

总的来说,这个文件实现了多种先进的注意力机制,旨在提高深度学习模型在图像处理任务中的性能。每个模块都可以根据具体的任务需求进行组合和调整,以实现最佳的效果。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式