【完整源码+数据集+部署教程】 航拍水体检测图像分割系统源码和数据集:改进yolo11-DLKA

背景意义

研究背景与意义

随着城市化进程的加快和人类活动的增加,水体污染和水资源管理问题日益凸显。水体作为生态系统的重要组成部分,不仅为生物提供栖息地,还在调节气候、提供饮用水和支持农业等方面发挥着重要作用。因此,及时、准确地监测水体的变化对于环境保护和资源管理至关重要。传统的水体检测方法往往依赖于人工巡查,效率低下且容易受到人为因素的影响。近年来,随着遥感技术和计算机视觉的迅速发展,基于图像处理的水体检测方法逐渐成为研究热点。

本研究旨在基于改进的YOLOv11模型,构建一个高效的航拍水体检测图像分割系统。YOLO(You Only Look Once)系列模型以其快速的检测速度和较高的准确率而闻名,适合实时监测应用。通过对YOLOv11进行改进,我们希望在保证检测精度的同时,提升其在复杂环境下的鲁棒性和适应性。此外,针对特定的水体检测任务,我们将使用包含1673幅图像的数据集,数据集中仅包含一个类别“Water”,这为模型的训练和评估提供了清晰的目标。

在数据集的处理过程中,我们对图像进行了自动方向调整和统一尺寸处理,以确保模型输入的一致性。这种预处理方式能够有效提高模型的训练效率和检测精度。通过构建该系统,我们期望能够实现对水体的自动化监测,及时发现水体污染和变化,为环境保护和水资源管理提供科学依据。

综上所述,本研究不仅具有重要的理论意义,还将为实际应用提供有效的技术支持,推动水体监测技术的发展,助力可持续发展目标的实现。

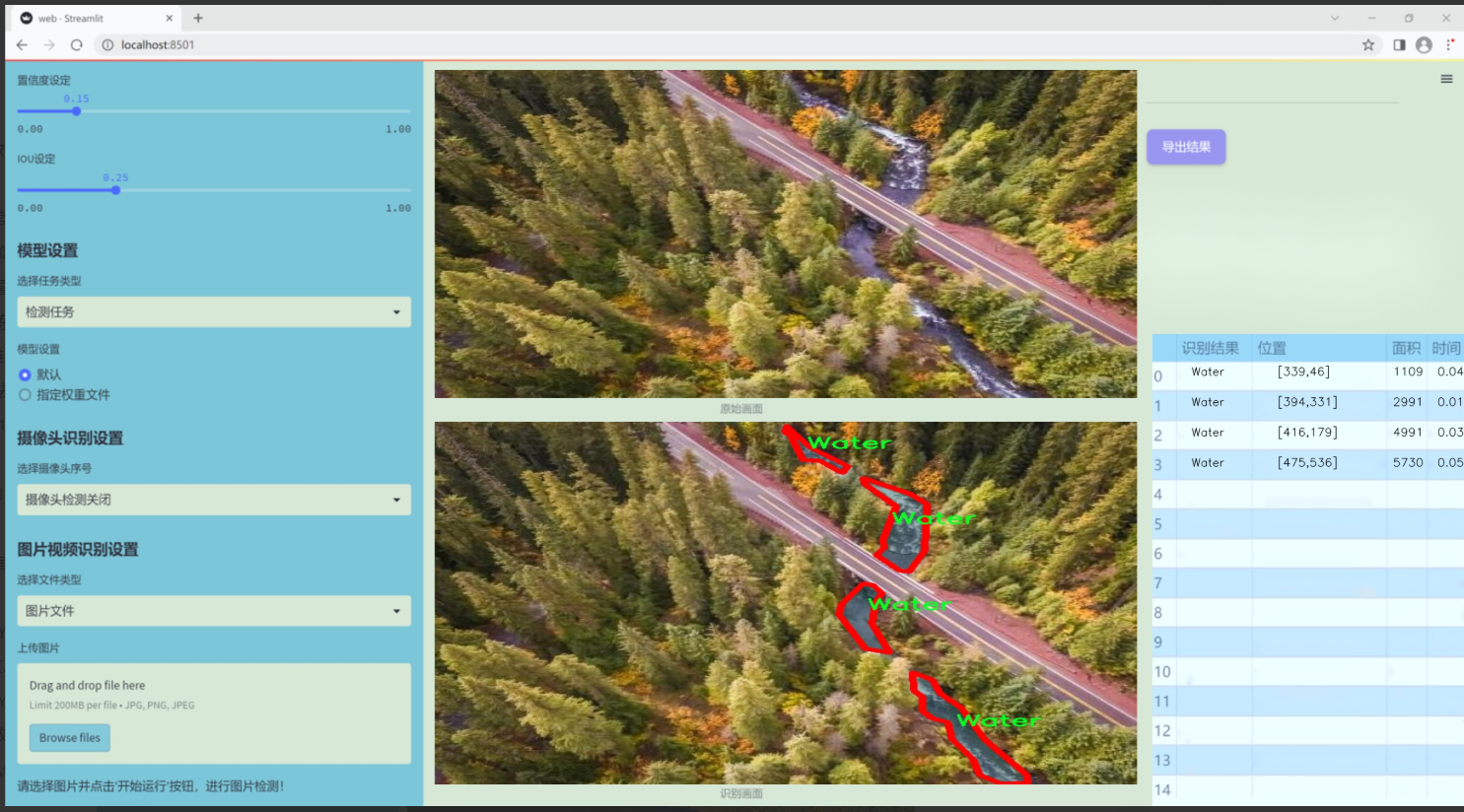

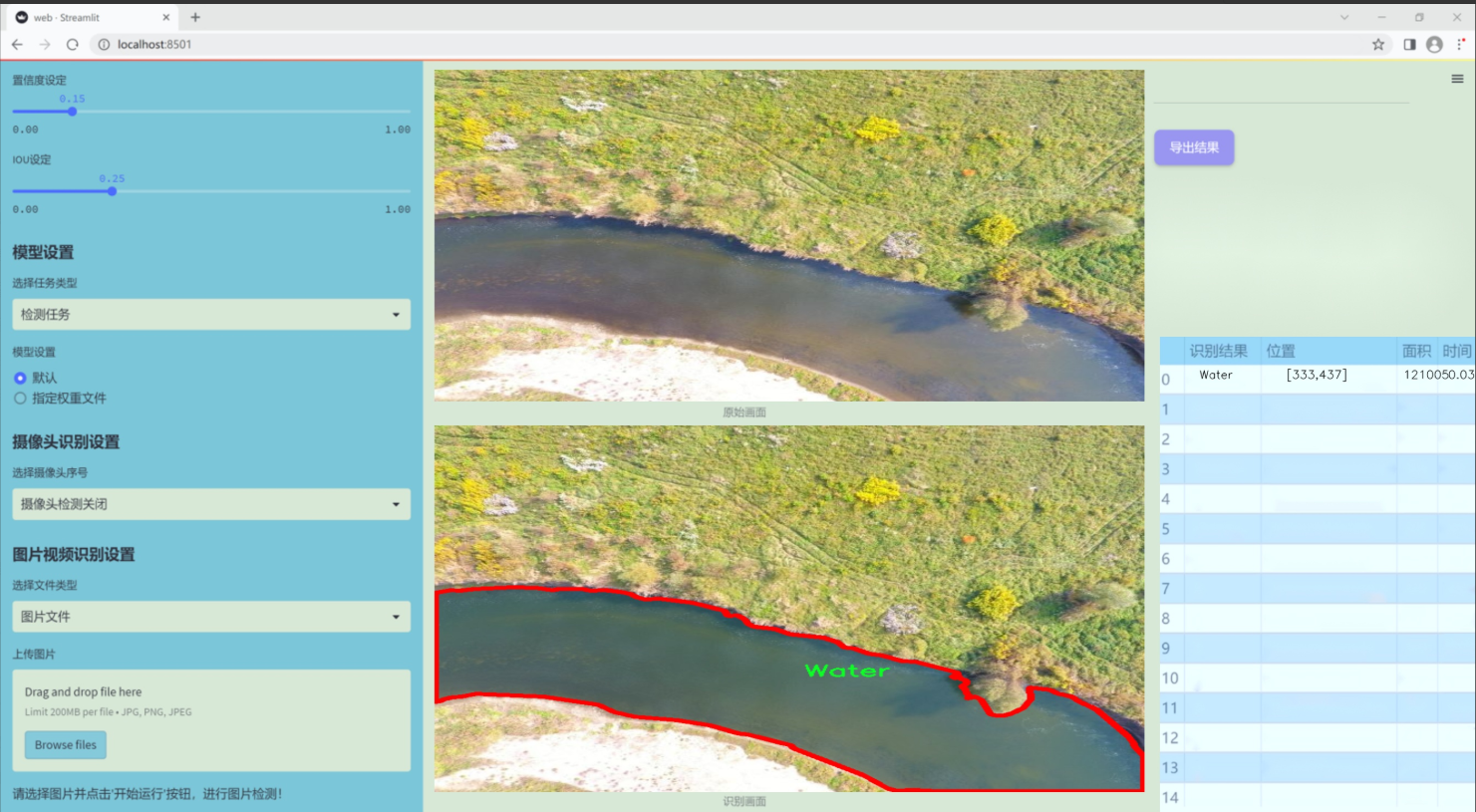

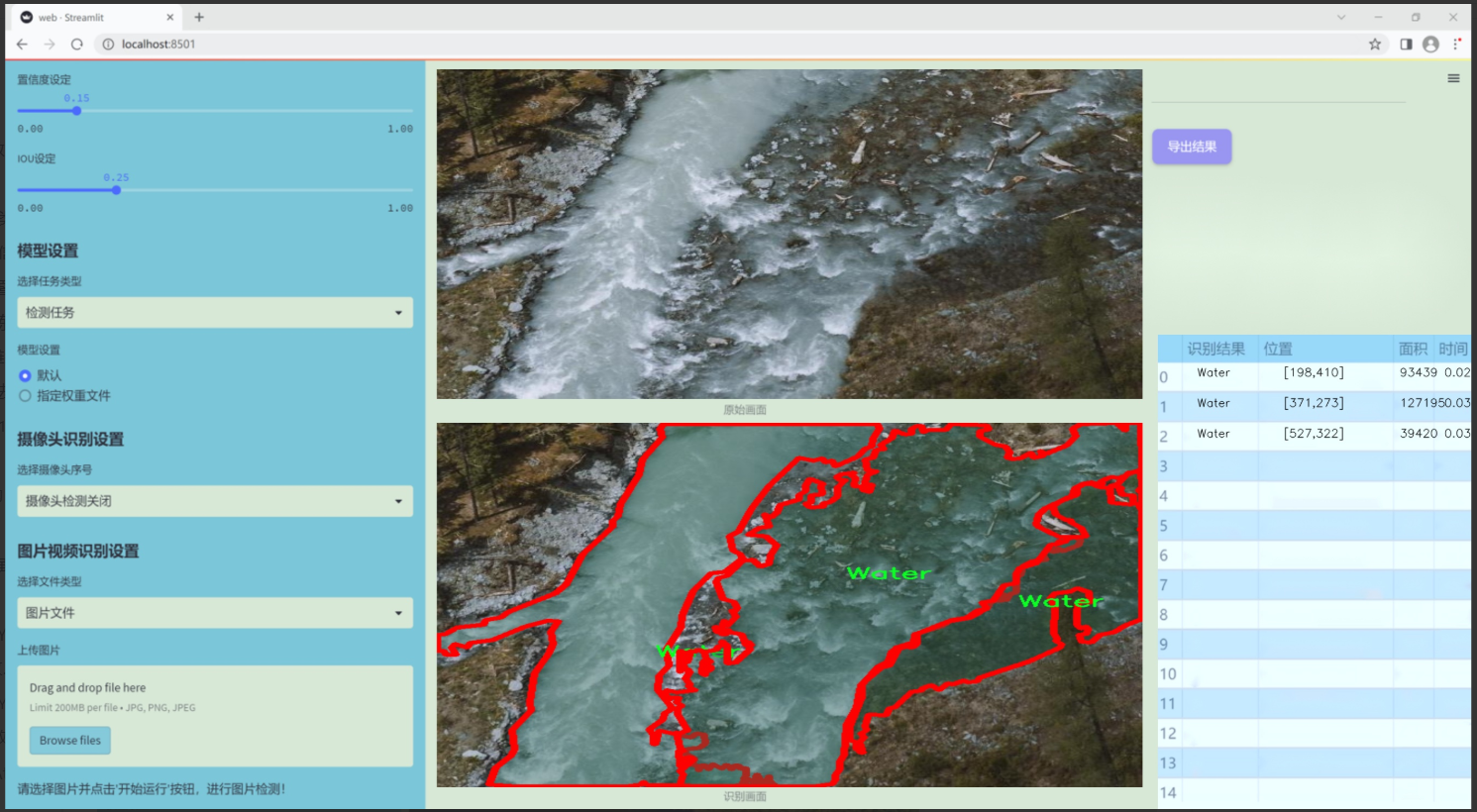

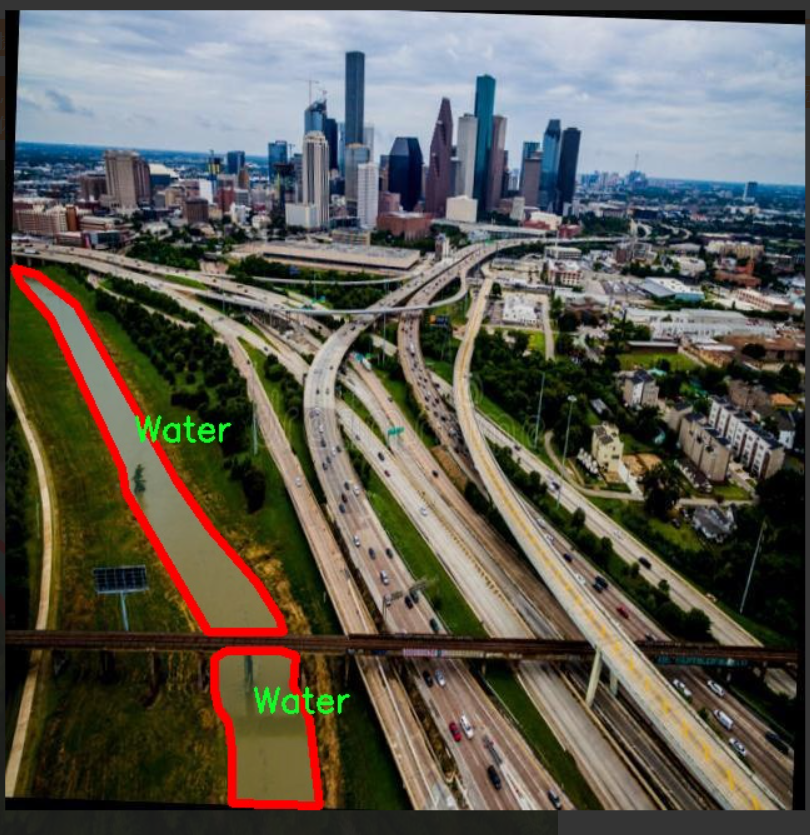

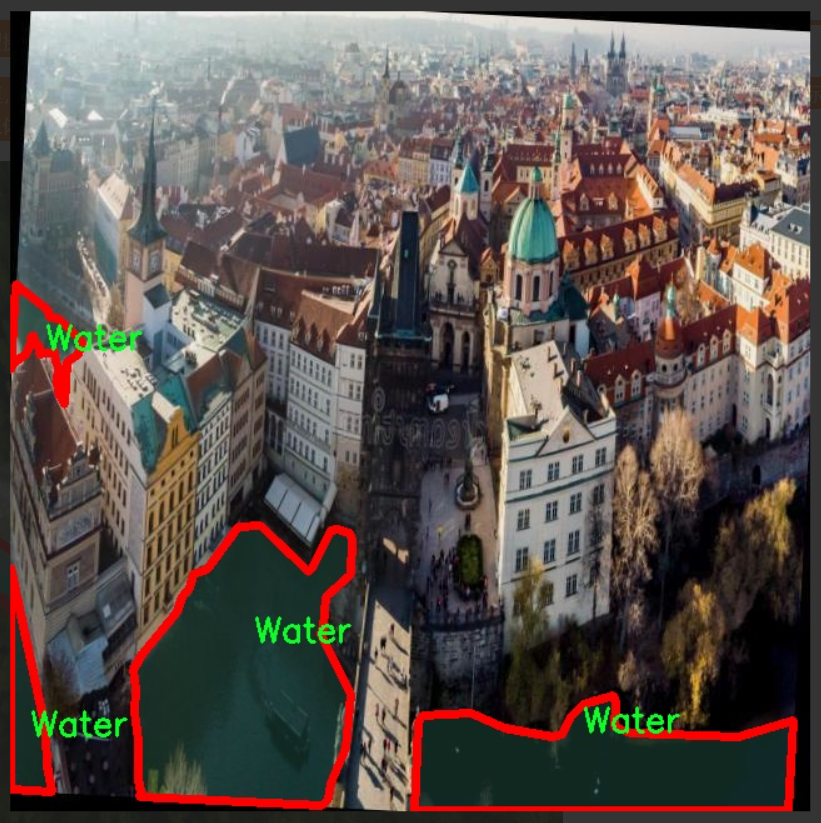

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集专注于航拍水体的检测与图像分割,旨在为改进YOLOv11模型提供高质量的训练素材。数据集的主题为“Water_Bodies”,主要涵盖了水体的多样性及其在不同环境条件下的表现。该数据集包含一个类别,即“Water”,这意味着所有的标注图像均围绕水体的特征展开,旨在提高模型对水体的识别精度和分割能力。

在数据集的构建过程中,我们精心挑选了来自不同地理位置和气候条件的航拍图像,以确保数据的多样性和代表性。这些图像不仅包括静态水体,如湖泊、河流和水库,还涵盖了动态水体的变化,如潮汐影响下的海洋区域。每张图像都经过严格的标注,确保水体区域的准确性,以便为YOLOv11模型的训练提供可靠的输入。

此外,数据集还考虑了不同的光照条件和季节变化,确保模型在各种环境下的鲁棒性。例如,数据集中包含了晴天、阴天、黄昏等不同光照条件下的水体图像,增强了模型对光照变化的适应能力。同时,季节性变化也被纳入考虑,春夏秋冬不同季节的水体表现为模型提供了丰富的训练样本。

通过这种精心设计的数据集,我们期望能够显著提升YOLOv11在航拍水体检测与图像分割任务中的表现,使其能够在实际应用中更好地识别和分割水体区域,从而为环境监测、水资源管理及相关领域提供强有力的技术支持。

核心代码

以下是经过简化和注释的核心代码部分:

import torch

from torch import nn

class EMA(nn.Module):

“”"

指数移动平均 (Exponential Moving Average) 模块

用于增强特征的表示能力。

“”"

def init(self, channels, factor=8):

super(EMA, self).init()

self.groups = factor # 将通道分成若干组

assert channels // self.groups > 0 # 确保每组至少有一个通道

self.softmax = nn.Softmax(-1) # Softmax层

self.agp = nn.AdaptiveAvgPool2d((1, 1)) # 自适应平均池化

self.pool_h = nn.AdaptiveAvgPool2d((None, 1)) # 对高度进行池化

self.pool_w = nn.AdaptiveAvgPool2d((1, None)) # 对宽度进行池化

self.gn = nn.GroupNorm(channels // self.groups, channels // self.groups) # 组归一化

self.conv1x1 = nn.Conv2d(channels // self.groups, channels // self.groups, kernel_size=1) # 1x1卷积

self.conv3x3 = nn.Conv2d(channels // self.groups, channels // self.groups, kernel_size=3, padding=1) # 3x3卷积

def forward(self, x):b, c, h, w = x.size() # 获取输入的尺寸group_x = x.reshape(b * self.groups, -1, h, w) # 将输入重塑为分组形式x_h = self.pool_h(group_x) # 对高度进行池化x_w = self.pool_w(group_x).permute(0, 1, 3, 2) # 对宽度进行池化并转置hw = self.conv1x1(torch.cat([x_h, x_w], dim=2)) # 1x1卷积x_h, x_w = torch.split(hw, [h, w], dim=2) # 分割结果x1 = self.gn(group_x * x_h.sigmoid() * x_w.permute(0, 1, 3, 2).sigmoid()) # 归一化x2 = self.conv3x3(group_x) # 3x3卷积x11 = self.softmax(self.agp(x1).reshape(b * self.groups, -1, 1).permute(0, 2, 1)) # 计算权重x12 = x2.reshape(b * self.groups, c // self.groups, -1) # 重塑x21 = self.softmax(self.agp(x2).reshape(b * self.groups, -1, 1).permute(0, 2, 1)) # 计算权重x22 = x1.reshape(b * self.groups, c // self.groups, -1) # 重塑weights = (torch.matmul(x11, x12) + torch.matmul(x21, x22)).reshape(b * self.groups, 1, h, w) # 计算最终权重return (group_x * weights.sigmoid()).reshape(b, c, h, w) # 返回加权后的结果

class SimAM(nn.Module):

“”"

SimAM 模块,用于自适应特征增强。

“”"

def init(self, e_lambda=1e-4):

super(SimAM, self).init()

self.activaton = nn.Sigmoid() # Sigmoid激活函数

self.e_lambda = e_lambda # 正则化参数

def forward(self, x):b, c, h, w = x.size() # 获取输入的尺寸n = w * h - 1 # 计算总的像素点数x_minus_mu_square = (x - x.mean(dim=[2, 3], keepdim=True)).pow(2) # 计算均值平方差y = x_minus_mu_square / (4 * (x_minus_mu_square.sum(dim=[2, 3], keepdim=True) / n + self.e_lambda)) + 0.5 # 计算yreturn x * self.activaton(y) # 返回加权后的结果

class SpatialGroupEnhance(nn.Module):

“”"

空间组增强模块,用于增强特征的空间表示。

“”"

def init(self, groups=8):

super().init()

self.groups = groups # 组数

self.avg_pool = nn.AdaptiveAvgPool2d(1) # 自适应平均池化

self.weight = nn.Parameter(torch.zeros(1, groups, 1, 1)) # 权重参数

self.bias = nn.Parameter(torch.zeros(1, groups, 1, 1)) # 偏置参数

self.sig = nn.Sigmoid() # Sigmoid激活函数

self.init_weights() # 初始化权重

def init_weights(self):""" 初始化权重 """for m in self.modules():if isinstance(m, nn.Conv2d):nn.init.kaiming_normal_(m.weight, mode='fan_out') # Kaiming初始化if m.bias is not None:nn.init.constant_(m.bias, 0) # 偏置初始化为0elif isinstance(m, nn.BatchNorm2d):nn.init.constant_(m.weight, 1) # 批归一化权重初始化为1nn.init.constant_(m.bias, 0) # 偏置初始化为0elif isinstance(m, nn.Linear):nn.init.normal_(m.weight, std=0.001) # 线性层权重初始化if m.bias is not None:nn.init.constant_(m.bias, 0) # 偏置初始化为0def forward(self, x):b, c, h, w = x.shape # 获取输入的尺寸x = x.view(b * self.groups, -1, h, w) # 重塑输入xn = x * self.avg_pool(x) # 计算平均池化xn = xn.sum(dim=1, keepdim=True) # 求和t = xn.view(b * self.groups, -1) # 重塑t = t - t.mean(dim=1, keepdim=True) # 减去均值std = t.std(dim=1, keepdim=True) + 1e-5 # 计算标准差t = t / std # 归一化t = t.view(b, self.groups, h, w) # 重塑t = t * self.weight + self.bias # 加权t = t.view(b * self.groups, 1, h, w) # 重塑x = x * self.sig(t) # 返回加权后的结果return x.view(b, c, h, w) # 返回最终结果

代码说明:

EMA (Exponential Moving Average): 该模块用于增强特征表示,通过对输入特征进行加权和归一化,提升模型的表现。

SimAM (Similarity Adaptive Module): 该模块通过计算输入特征的均值和方差,动态调整特征的权重,增强模型的自适应能力。

SpatialGroupEnhance: 该模块通过对输入特征进行空间增强,提升特征的空间表示能力,使用自适应平均池化和Sigmoid激活函数来实现。

这个程序文件 attention.py 定义了一系列用于深度学习中注意力机制的模块,主要基于 PyTorch 框架。文件中包含了多个类,每个类实现了不同类型的注意力机制或相关功能,以下是对文件内容的详细说明。

首先,文件导入了必要的库,包括 PyTorch 的核心模块和一些其他工具,如 torchvision 和 einops。这些库提供了张量操作、神经网络层、初始化方法等功能。

接下来,文件定义了一系列注意力模块,包括:

EMA (Exponential Moving Average):该模块通过对输入进行分组处理,计算每个组的加权平均,并使用 sigmoid 函数生成权重,从而增强特征的表达能力。

SimAM (Similarity Attention Module):这是一个基于相似度的注意力模块,通过计算输入特征的均值和方差来生成注意力权重,强调特征的相似性。

SpatialGroupEnhance:该模块通过对输入特征进行空间增强,利用自适应平均池化和 sigmoid 激活函数来生成空间注意力权重。

TopkRouting:实现了可微分的 Top-k 路由机制,选择最相关的特征进行后续处理。

KVGather:用于根据路由索引和权重选择键值对,支持不同的加权方式(如软加权和硬加权)。

QKVLinear:用于将输入特征映射到查询、键和值的线性变换。

BiLevelRoutingAttention:实现了双层路由注意力机制,结合了局部和全局注意力的优势。

LocalWindowAttention:局部窗口注意力模块,适用于图像处理,利用局部窗口的特征进行注意力计算。

CoordAtt、TripletAttention、BAMBlock、EfficientAttention 等模块:这些模块实现了不同的注意力机制,增强了模型的特征提取能力。

其他模块:如 DeformConv、EffectiveSEModule、MLCA 等,提供了不同的卷积和注意力机制,进一步丰富了模型的功能。

文件中还包含了一些辅助函数,如 img2windows 和 windows2img,用于将图像划分为窗口和将窗口重组为图像。这些函数在处理图像时非常有用,尤其是在实现局部注意力机制时。

总的来说,这个文件实现了多种注意力机制,适用于不同的深度学习任务,尤其是在计算机视觉领域。通过组合这些模块,可以构建出更强大的神经网络模型,以提高特征提取和表示能力。

10.4 lsknet.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

from functools import partial

class Mlp(nn.Module):

“”“多层感知机(MLP)模块”“”

def init(self, in_features, hidden_features=None, out_features=None, act_layer=nn.GELU, drop=0.):

super().init()

out_features = out_features or in_features # 输出特征数,如果未指定则与输入特征数相同

hidden_features = hidden_features or in_features # 隐藏层特征数,如果未指定则与输入特征数相同

self.fc1 = nn.Conv2d(in_features, hidden_features, 1) # 第一个卷积层

self.dwconv = DWConv(hidden_features) # 深度卷积层

self.act = act_layer() # 激活函数

self.fc2 = nn.Conv2d(hidden_features, out_features, 1) # 第二个卷积层

self.drop = nn.Dropout(drop) # Dropout层

def forward(self, x):"""前向传播"""x = self.fc1(x) # 通过第一个卷积层x = self.dwconv(x) # 通过深度卷积层x = self.act(x) # 激活x = self.drop(x) # Dropoutx = self.fc2(x) # 通过第二个卷积层x = self.drop(x) # Dropoutreturn x

class Attention(nn.Module):

“”“注意力模块”“”

def init(self, d_model):

super().init()

self.proj_1 = nn.Conv2d(d_model, d_model, 1) # 投影层1

self.activation = nn.GELU() # 激活函数

self.spatial_gating_unit = LSKblock(d_model) # 空间门控单元

self.proj_2 = nn.Conv2d(d_model, d_model, 1) # 投影层2

def forward(self, x):"""前向传播"""shortcut = x.clone() # 保存输入以进行残差连接x = self.proj_1(x) # 通过投影层1x = self.activation(x) # 激活x = self.spatial_gating_unit(x) # 通过空间门控单元x = self.proj_2(x) # 通过投影层2x = x + shortcut # 残差连接return x

class Block(nn.Module):

“”“基本块,包括注意力和MLP”“”

def init(self, dim, mlp_ratio=4., drop=0., drop_path=0., act_layer=nn.GELU):

super().init()

self.norm1 = nn.BatchNorm2d(dim) # 第一层归一化

self.norm2 = nn.BatchNorm2d(dim) # 第二层归一化

self.attn = Attention(dim) # 注意力模块

self.drop_path = DropPath(drop_path) if drop_path > 0. else nn.Identity() # 随机深度

mlp_hidden_dim = int(dim * mlp_ratio) # MLP隐藏层维度

self.mlp = Mlp(in_features=dim, hidden_features=mlp_hidden_dim, act_layer=act_layer, drop=drop) # MLP模块

def forward(self, x):"""前向传播"""x = x + self.drop_path(self.attn(self.norm1(x))) # 通过注意力模块并添加残差x = x + self.drop_path(self.mlp(self.norm2(x))) # 通过MLP模块并添加残差return x

class LSKNet(nn.Module):

“”“LSKNet模型”“”

def init(self, img_size=224, in_chans=3, embed_dims=[64, 128, 256, 512], depths=[3, 4, 6, 3]):

super().init()

self.num_stages = len(depths) # 网络阶段数

for i in range(self.num_stages):

# 初始化每个阶段的嵌入层和块

patch_embed = OverlapPatchEmbed(img_size=img_size // (2 ** i), in_chans=in_chans if i == 0 else embed_dims[i - 1], embed_dim=embed_dims[i])

block = nn.ModuleList([Block(dim=embed_dims[i]) for _ in range(depths[i])]) # 生成块

norm = nn.LayerNorm(embed_dims[i]) # 归一化层

setattr(self, f"patch_embed{i + 1}“, patch_embed) # 将嵌入层添加到模型中

setattr(self, f"block{i + 1}”, block) # 将块添加到模型中

setattr(self, f"norm{i + 1}", norm) # 将归一化层添加到模型中

def forward(self, x):"""前向传播"""outs = []for i in range(self.num_stages):patch_embed = getattr(self, f"patch_embed{i + 1}") # 获取嵌入层block = getattr(self, f"block{i + 1}") # 获取块norm = getattr(self, f"norm{i + 1}") # 获取归一化层x, H, W = patch_embed(x) # 嵌入for blk in block:x = blk(x) # 通过每个块x = norm(x) # 归一化outs.append(x) # 保存输出return outs

class DWConv(nn.Module):

“”“深度卷积模块”“”

def init(self, dim=768):

super(DWConv, self).init()

self.dwconv = nn.Conv2d(dim, dim, 3, padding=1, groups=dim) # 深度卷积层

def forward(self, x):"""前向传播"""return self.dwconv(x) # 通过深度卷积层

生成模型的函数

def lsknet_t(weights=‘’):

model = LSKNet(embed_dims=[32, 64, 160, 256], depths=[3, 3, 5, 2]) # 创建LSKNet模型

if weights:

model.load_state_dict(torch.load(weights)[‘state_dict’]) # 加载权重

return model

主程序

if name == ‘main’:

model = lsknet_t(‘lsk_t_backbone-2ef8a593.pth’) # 创建模型并加载权重

inputs = torch.randn((1, 3, 640, 640)) # 随机输入

for i in model(inputs):

print(i.size()) # 输出每个阶段的输出尺寸

代码核心部分说明:

Mlp:实现了一个多层感知机,包含两个卷积层和一个深度卷积层,使用GELU激活函数和Dropout。

Attention:实现了一个注意力机制,包含两个投影层和一个空间门控单元。

Block:将注意力模块和MLP结合在一起,形成一个基本的网络块。

LSKNet:构建整个网络结构,包含多个阶段,每个阶段由嵌入层、多个块和归一化层组成。

DWConv:实现了深度卷积,用于特征提取。

lsknet_t:用于创建LSKNet模型并加载预训练权重的函数。

这个程序文件 lsknet.py 实现了一个名为 LSKNet 的深度学习模型,主要用于图像处理任务。该模型的结构包括多个模块和层,具体实现了卷积、注意力机制和多层感知机等功能。以下是对代码的详细讲解。

首先,程序导入了必要的库,包括 PyTorch 及其神经网络模块、函数式工具和 NumPy。接着,定义了一个 Mlp 类,这个类实现了一个多层感知机,包含两个卷积层和一个深度卷积层(DWConv),并使用 GELU 激活函数和 Dropout 层来增加模型的非线性和防止过拟合。

接下来是 LSKblock 类,它实现了一个特定的注意力机制。该类使用了多个卷积层,包括深度卷积和空间卷积,通过对输入特征图进行处理,生成注意力权重,并对输入进行加权,增强了模型对重要特征的关注。

Attention 类则封装了 LSKblock,并在其前后添加了线性变换和激活函数。Block 类是模型的基本构建块,结合了归一化、注意力机制和多层感知机,形成了一个完整的处理单元。它还使用了层级缩放参数来增强模型的表达能力。

OverlapPatchEmbed 类负责将输入图像划分为重叠的补丁,并将这些补丁嵌入到一个高维空间中。它使用卷积层来实现这一功能,并在输出后进行归一化处理。

LSKNet 类是整个模型的核心,构造了多个阶段,每个阶段包含了补丁嵌入、多个 Block 和归一化层。模型的深度和宽度可以通过参数进行调整。该类还实现了前向传播方法,处理输入数据并返回每个阶段的输出。

DWConv 类实现了深度卷积操作,进一步增强了模型的特征提取能力。程序中还定义了一个 update_weight 函数,用于更新模型的权重。

最后,提供了两个函数 lsknet_t 和 lsknet_s,用于创建不同配置的 LSKNet 模型,并可选择加载预训练权重。主程序部分创建了一个 LSKNet 模型实例,并对随机生成的输入进行前向传播,输出每个阶段的特征图尺寸。

整体来看,这个程序文件实现了一个灵活且强大的图像处理模型,适用于各种计算机视觉任务。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式