每天五分钟深度学习:两个角度解释正则化解决网络过拟合的原理

本文重点

前面我们学习了当神经网络模型出现过拟合问题的时候,我们可以使用正则化技术来解决这个问题,并且我们通过梯度下降的公式可以看到,当使用正则化技术的时候,更新参数的时候,很明显的一点是参数比不使用正则化技术变小了。那么为什么变小了就可以解决过拟合问题呢?本文我们将来从两个角度来解释这个问题。

角度一

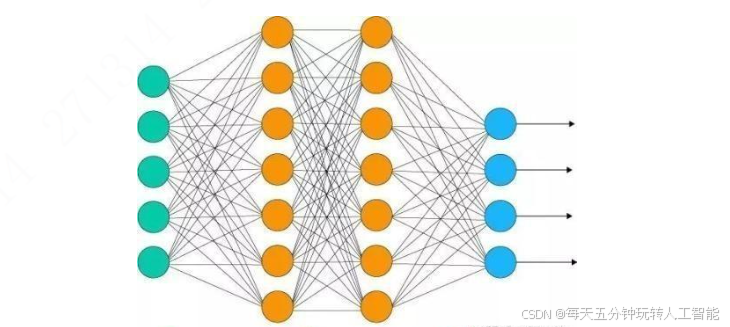

我们知道神经网络之所以过拟合就是神经网络模型太大了,所以导致了过拟合问题的发生,那么我们就需要降低神经网络模型的复杂程度,我们知道神经网络的每一个神经元实质就是一个参数w,当神经网络中w参数变小了,那么就相当于模型神经元的效果失效了,如图所示,当没有使用正则化的时候,此时神经网络为:

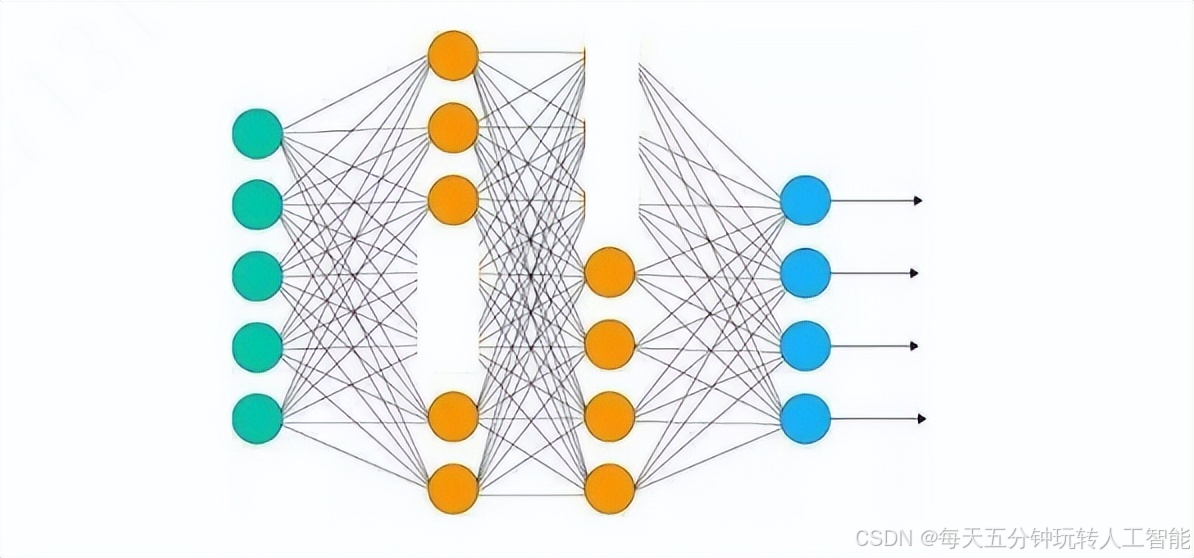

当使用正则化的时候,此时模型的部分参数会变小,变小的那部分神经元的效果就不好了,或者说失效了,此时的神经网络看起来就像是这样的:

(有的神经元被删掉了,被删掉的神经元就表示失效了,或者效果变弱了),我们可以看到时使用正则化的神经网络中部分神经元失效了,那么神经元数量减少了,也就是说神经网络模型结构变得不复杂了,刚才我们说过了之所以过拟合就是因为神经网络模型结构复杂,那么模型结构不复杂了,那么也就相当于解决过拟合了。