卷积神经网络CNN(五): 标准CNN神经网络

卷积神经网络(CNN)是深度学习在计算机视觉领域取得突破性进展的关键。它是一种特殊设计的前馈神经网络,旨在高效、有效地处理具有网格状拓扑结构的数据,尤其是图像。CNN模仿了生物视觉皮层的工作机制,通过分层结构自动学习特征的表示,成功解决了传统神经网络在处理高维图像数据时面临的“维度灾难”和空间结构信息丢失的问题。

核心概念与结构优势

局部连接与权值共享(Local Connectivity and Parameter Sharing)

传统全连接网络(MLP)中的每个神经元都连接到前一层的所有神经元。对于一张1000×1000的图像,如果第一隐藏层有100万个神经元,则参数数量将是天文数字。

CNN通过两个关键概念解决了这个问题:

- 局部感受野(Local Receptive Fields): CNN中的神经元只与输入数据的一个局部区域相连(例如3×3或5×5的像素块)。这大大减少了每层神经元的连接数量,符合视觉系统“局部感知”的原理。

- 权值共享(Parameter Sharing): 在一个卷积层内,同一个“滤波器”(或称“核”)会以相同的权重在整个输入数据上滑动。这意味着网络一旦学会了识别某一特征(如一条水平边缘)在图中的一个位置,就能在任何其他位置识别它。这不仅极大地减少了模型需要学习的参数总量,而且赋予了CNN至关重要的平移不变性(Translational Invariance)。

标准CNN的层次结构

一个标准的、用于图像分类的CNN模型通常由以下三种主要类型的层交替堆叠而成:

- 输入层(Input Layer): 接收原始数据,对于彩色图像,通常是H×W×C的三维矩阵,其中H和W是高和宽,C是通道数(如RGB图像 C=3)。

- 隐藏层(Hidden Layers): 由一系列交替的卷积、激活、池化层构成,负责特征的提取和抽象。

- 分类层/输出层(Classification/Output Layer): 通常由一个或多个全连接层和最终的Softmax层组成,将提取出的特征映射到最终的类别概率分布上。

三大核心操作层

卷积层(Convolutional Layer, Conv)

卷积层是CNN的核心,负责从输入数据中提取空间特征。

操作原理: 卷积操作通过一个可学习的**滤波器(Filter/Kernel)**在输入数据上进行滑动,并进行逐元素的乘积累加运算。每次运算的结果成为输出特征图上的一个像素点。

关键超参数:

- 滤波器尺寸(Kernel Size): 决定局部感受野的大小,如3×3。

- 步长(Stride): 滤波器在输入数据上移动的距离。较大的步长(如2)可以实现快速降采样。

- 填充(Padding): 在输入数据的边缘添加零值(Zero-Padding),以控制输出特征图的空间尺寸。常用的“Same” Padding可以保证输出尺寸与输入尺寸相同。

- 滤波器数量/深度(Number of Filters): 决定了输出特征图的深度。每个滤波器学习提取一种特定的特征,如边缘、颜色或纹理。

输出: 卷积操作的输出被称为特征图(Feature Map)。深度为K的卷积层将产生K个特征图,每个特征图代表输入数据中特定特征的激活强度分布。

激活层(Activation Layer)

激活层通常紧跟在卷积层之后,用于引入非线性。

目的: 如果没有非线性激活函数,无论网络堆叠多少层,模型始终等同于一个线性模型,无法解决复杂的非线性分类问题。

最常用的激活函数:修正线性单元(ReLU, Rectified Linear Unit)

ReLU(x)=max(0,x)

ReLU的优势在于计算简单、导数恒定(对于正值),这有助于缓解梯度消失问题,加速网络的训练和收敛。

池化层(Poling Layer)

池化层(也称降采样层)是用来减小特征图的空间维度,从而降低计算量和参数数量,并增强网络对局部平移的鲁棒性。

操作原理: 池化操作将输入特征图划分为不重叠的区域,并对每个区域应用一个统计函数来输出一个单一的值,实现降维。

常见类型:

- 最大池化(Max Pooling): 取区域内的最大值作为输出。这是最常用的池化方式,因为它能够有效地捕捉特征中最强的激活信号,保留最显著的特征信息。

- 平均池化(Average Pooling): 计算区域内的平均值作为输出。常用于网络的最后一层(全局平均池化),用于替代全连接层。

优势:

- 维度缩减: 降低后续层的计算复杂度。

- 平移不变性: 即使特征在输入中发生微小的位移,只要它仍落在池化窗口内,池化层的输出变化会很小,提高了模型对输入扰动的鲁棒性。

全连接层与输出

经过多层卷积、激活和池化操作后,图像的原始像素信息已经被抽象成高度语义化的特征表示。这一阶段的输出通常是一个具有深度的三维特征图。

展平(Flatten)

在将特征传递给传统的全连接层之前,需要将三维的特征图展平(Flatten)为一个长向量。这个向量包含了从图像中提取的所有高级特征。

全连接层(Fully Connected Layer, FC)

展平后的特征向量被输入到一个或多个全连接层。这些层负责将抽象特征组合起来,进行最终的分类或回归决策。

输出层(Output Layer)

输出层通常是一个FC层,其神经元数量等于分类任务的类别数量K。

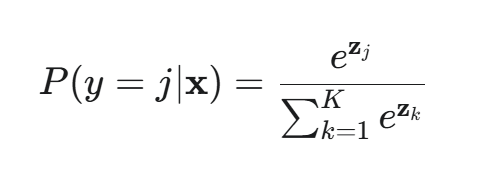

- Softmax 激活: 对于分类任务,输出层使用Softmax函数将原始得分(logits)转换成概率分布,即每个类别的概率总和为1。

CNN的训练与正则化

标准的CNN模型通过**反向传播(Backpropagation)**算法进行训练,并通过梯度下降(Gradient Descent)及其变种(如Adam、SGD with Momentum)来优化网络权重,最小化损失函数(Loss Function),如交叉熵损失(Cross-Entropy Loss)。

关键正则化技术:

- Dropout: 在训练过程中,随机地关闭(置零)一部分神经元的输出。这可以防止神经元之间的复杂共适应性,强制网络学习更鲁棒的特征表示,有效防止过拟合。

- 批标准化(Batch Normalization, BN): 在激活函数之前,对每一层的输入进行标准化处理(调整为均值为0,方差为1)。BN可以加速训练,允许使用更大的学习率,并起到正则化作用。

总结

卷积神经网络的成功是由于其结构上的归纳偏置(Inductive Bias)——即对局部性(通过局部感受野)和空间不变性(通过权值共享和池化)的假设。一个标准的CNN架构,从输入层开始,通过Conv-ReLU-Pooling的结构不断堆叠,逐步实现:

- 从低级特征(边缘、角点) 到 高级特征(对象部件、整体对象) 的抽象分层学习。

- 从高维度(像素空间) 到 低维度(特征向量) 的信息压缩与精炼。