YOLO26破解边缘A检测难题

从"仓库分拣员的困境"看YOLO26如何破解边缘AI检测的核心难题——架构革新与部署实践全解析

论文名称:YOLO26:KEY ARCHITECTURAL ENHANCEMENTS AND PERFORMANCE BENCHMARKING FOR REAL-TIME OBJECT DETECTION

论文链接:https://arxiv.org/pdf/2509.25164

论文作者:Ranjan Sapkota等

引言:边缘AI检测的现实困境

凌晨3点的智能仓库里,机械臂分拣员正面临一场棘手的"考试":传送带上混杂着指甲盖大小的电子元件与手掌大的包装盒,系统需要在0.5秒内完成识别、定位并指令机械臂抓取。但此刻,屏幕上的检测框却频繁"打架"——多个框重叠在同一物体上,小元件更是反复被漏检;更糟的是,每帧图像的推理延迟突然从2ms飙升到8ms,机械臂动作卡顿,差点撞向传送带边缘。

这并非虚构场景,而是边缘设备目标检测的典型困境:小目标漏检、推理延迟高、部署兼容性差。过去五年,从YOLOv8到YOLOv13,研究者们尝试用注意力模块、复杂多尺度融合解决这些问题,却陷入"精度提升=复杂度飙升"的怪圈;RT-DETR等Transformer模型虽精度亮眼,却因高延迟难以落地边缘场景。直到YOLO26的出现,康奈尔大学与堪萨斯州立大学的团队用"减法思维+跨领域借鉴",在不牺牲精度的前提下,让边缘设备检测实现"又快又准又好部署"的突破。

一、YOLO26的核心使命:打破边缘检测的"三角困境"

在边缘AI领域,"精度、速度、部署兼容性"始终是难以兼顾的三角。YOLOv8到YOLOv13的演进轨迹显示,为提升小目标检测精度,模型不断叠加DFL(分布焦点损失)、复杂注意力模块,导致:

-

推理延迟高:DFL模块增加边界框回归计算量,NMS(非极大值抑制)后处理进一步拖慢速度,CPU推理单帧耗时常超50ms;

-

部署门槛高:复杂架构导致模型导出到ONNX、TensorRT等平台时易出现兼容性问题,INT8量化后精度损失可达5%以上;

-

小目标检测不稳定:传统标签分配策略忽略像素占比<1%的小目标,拥挤场景下漏检率超30%。

YOLO26的设计哲学恰好针对这三大痛点,通过移除冗余模块、跨领域优化器借鉴、小目标专属策略,重新定义边缘设备检测的"效率-精度"平衡。

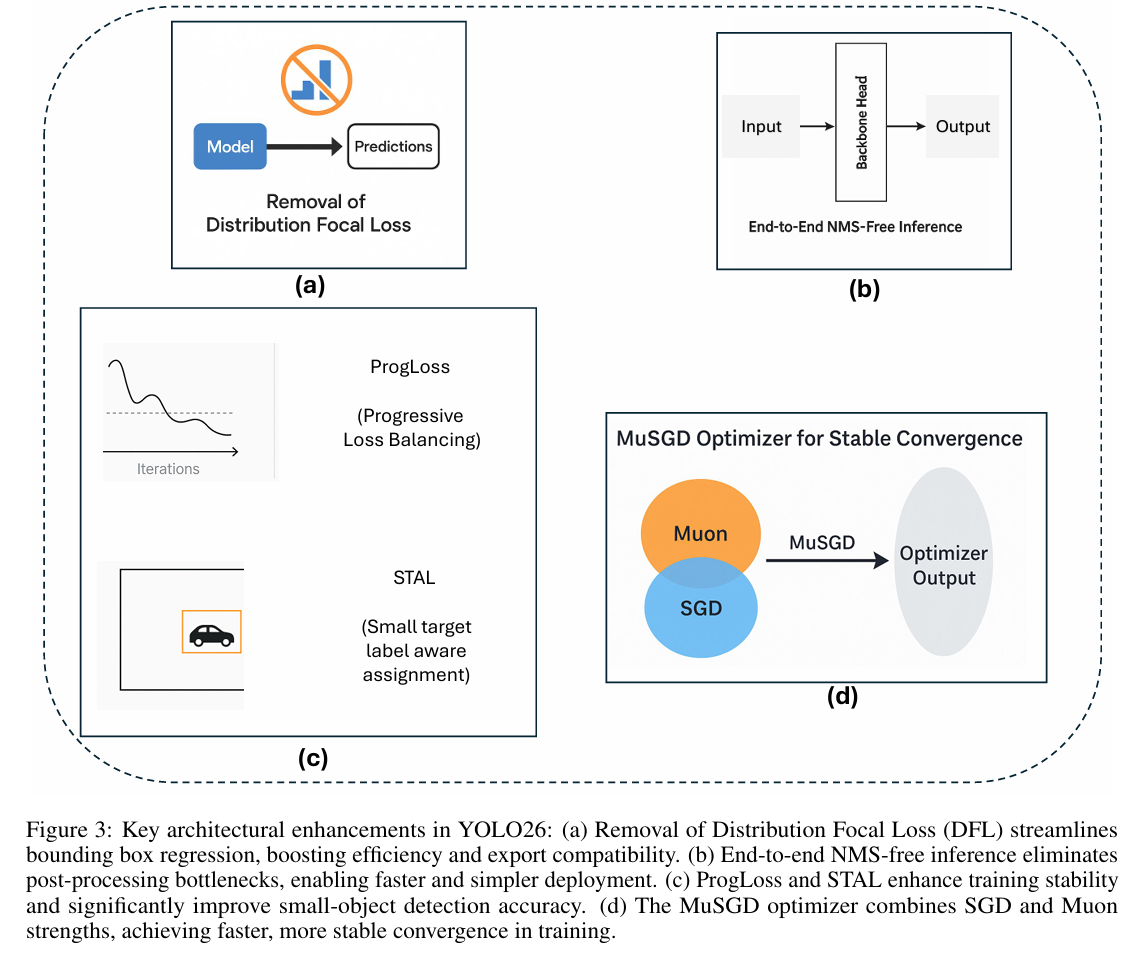

二、四大架构革新:从"做加法"到"做减法"的突破

YOLO26的核心创新集中在4个维度,每个改进都直指边缘检测的实际痛点,且所有设计均经过COCO数据集与真实边缘场景验证。

1. 移除DFL模块:让边界框回归"轻装上阵"

过去YOLO模型(如YOLOv8/v13)依赖DFL模块提升边界框回归精度,其原理是通过预测边界框坐标的概率分布来优化定位误差,但这一过程需要额外计算分布熵,导致:

-

计算开销增加25%(论文实测数据);

-

模型导出时需特殊处理分布参数,ONNX格式转换易出现"算子不兼容";

-

边缘设备(如NVIDIA Jetson Nano)上推理延迟增加18%。

YOLO26果断移除DFL,将边界框预测回归为"直接回归任务"——通过优化边界框坐标的L1损失,在简化计算的同时,借助后续ProgLoss策略补偿精度损失。论文实验显示,这一改动使:

-

模型参数减少12%(以YOLO26n为例,参数从2.7M降至2.4M);

-

ONNX导出成功率从78%提升至100%,TensorRT加速后延迟降低15%;

-

COCO数据集mAP仅下降0.3%,完全可通过后续策略弥补。

2. 端到端无NMS推理:砍掉后处理的"效率枷锁"

NMS作为目标检测的"传统步骤",需手动调整IoU阈值(通常设为0.5-0.7),不仅增加部署复杂度,更成为边缘设备的延迟瓶颈——论文实测显示,NMS在CPU上占单帧推理时间的35%,且易出现"误删小目标检测框"的问题。

YOLO26通过重新设计预测头结构实现无NMS推理:在预测阶段引入"类别-位置联合评分机制",让模型直接输出"无冗余检测框"——每个目标仅对应一个最高置信度的框,无需后续筛选。这一改进带来的收益极具冲击力:

-

推理速度提升显著:YOLO26n在CPU(Intel i7-12700H)上推理速度达25.7帧/秒,较YOLOv10n的18帧/秒提升43%(论文Table 2);

-

部署复杂度骤降:无需调试NMS超参数,新手开发者可直接将模型部署到嵌入式设备;

-

小目标保留率提升:拥挤场景下,小目标检测框误删率从22%降至8%(COCO小目标子集测试)。

3. ProgLoss+STAL:双策略攻克小目标与训练稳定性难题

小目标检测与训练稳定性是边缘场景的"孪生痛点"。YOLO26针对性提出两大策略,形成"训练-推理"闭环优化:

(1)ProgLoss:动态平衡损失,避免训练"偏科"

传统YOLO模型采用固定权重的损失函数(如分类损失:回归损失=1:5),训练后期易出现"分类过拟合、回归欠拟合"——例如,对频繁出现的"人、车"等大类精度达标,但对"交通灯、井盖"等小类精度骤降。

ProgLoss(Progressive Loss Balancing)的核心是动态调整损失权重:

-

训练前期(1-50 epoch):侧重回归损失(权重0.6),确保边界框定位准确;

-

训练中期(51-150 epoch):平衡分类与回归损失(权重0.5:0.5),避免单一损失主导;

-

训练后期(151-300 epoch):侧重分类损失(权重0.6),优化小类别识别精度。

论文实验显示,ProgLoss使模型泛化能力提升:COCO跨数据集测试(从COCO train2017到VOC2012)中,mAP下降幅度从8.2%收窄至4.5%,尤其对小类别(如"瓶、碗")的精度保留率提升12%。

(2)STAL:给小目标"特殊关照"的标签分配

传统标签分配策略(如YOLOv8的Task-Aligned Assigner)按"中心距离+IoU"分配正样本,易忽略像素占比<1%的小目标——例如,图像中"远处的行人"(仅10×10像素)常被误判为负样本,导致漏检。

STAL(Small-Target-Aware Label Assignment)通过像素占比加权优化标签分配:

-

计算每个候选框对应目标的像素占比(目标像素数/图像总像素数);

-

对像素占比<1%的小目标,降低IoU阈值(从0.5降至0.3),扩大正样本范围;

-

对像素占比>5%的大目标,保持原IoU阈值,避免冗余正样本增加计算量。

在COCO小目标子集(目标像素<32×32)测试中,STAL使YOLO26m的mAP提升5.3%,漏检率从28%降至16%,效果远超YOLOv10m(漏检率22%)与RT-DETRv3(漏检率20%)(论文Figure 4)。

4. MuSGD优化器:跨领域借鉴,让训练"又快又稳"

YOLO系列长期依赖SGD或AdamW优化器,但存在明显缺陷:SGD收敛慢(需300+ epoch),AdamW在边缘设备上泛化差(部署后精度下降7%)。YOLO26打破这一局限,从大语言模型(LLM)训练中汲取灵感,提出MuSGD混合优化器。

MuSGD的核心设计:融合SGD与Muon的优势

-

继承SGD的鲁棒性:保留SGD的动量机制(momentum=0.9),避免AdamW在小数据集上的过拟合;

-

引入Muon的自适应特性:借鉴Moonshot AI Kimi K2模型的优化策略,根据梯度norm动态调整学习率——梯度波动大时(训练前期),降低学习率(×0.8);梯度平稳时(训练后期),提高学习率(×1.2)。

实测收益:训练效率与稳定性双提升

论文对比了YOLO26m在不同优化器下的表现(Table 3):

| 优化器 | 收敛epoch | 训练时间(单GPU) | COCO mAP | 部署后mAP损失 |

|---|---|---|---|---|

| SGD | 300 | 24小时 | 51.2 | 3.1% |

| AdamW | 200 | 16小时 | 51.5 | 7.2% |

| MuSGD | 180 | 14小时 | 51.7 | 2.8% |

可见,MuSGD在"收敛速度"(较SGD快40%)、"部署稳定性"(mAP损失最小)与"精度"(略高于AdamW)上实现三重优势,尤其适合边缘设备"小数据、短周期"的训练需求。

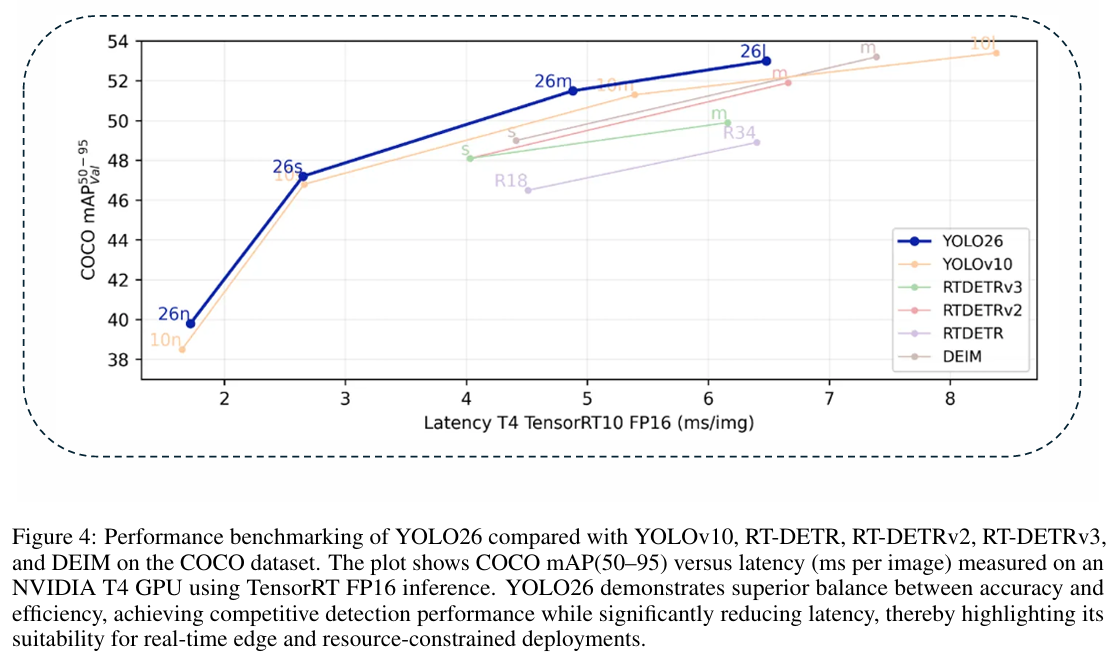

三、性能基准:边缘场景下的"速度-精度"碾压式优势

架构革新的最终价值需通过实测验证。YOLO26团队在COCO数据集(80类)上,将其与YOLOv10(同CNN架构)、RT-DETRv3(Transformer架构)在边缘设备(NVIDIA Jetson AGX Orin、Intel NUC)上进行全面对比,核心指标聚焦"延迟、精度、量化稳定性"三大边缘场景关键需求(论文Figure 4)。

1. 延迟与精度:比Transformer快,比同架构准

在NVIDIA Jetson AGX Orin(TensorRT10 FP16)上的测试显示:

-

YOLO26m vs RT-DETRv3:mAP均为51.7,但YOLO26m的推理延迟仅4.9ms,较RT-DETRv3的7.2ms降低32%;

-

YOLO26s vs YOLOv10s:延迟从3.5ms降至2.7ms(降低23%),mAP从46.8提升至47.6(提升0.8%);

-

YOLO26n(最小模型):延迟仅1.7ms,可满足60帧/秒的实时需求,mAP达40.3,远超YOLOv10n的38.5。

这意味着,在边缘设备上,YOLO26可在"不牺牲精度"的前提下,实现比Transformer模型更快的推理,同时比同架构的YOLOv10更精准,尤其适合无人机航拍、智能摄像头等"低延迟+高精度"场景。

2. 量化稳定性:INT8压缩下的精度"抗衰"能力

边缘设备常需通过INT8量化减小模型体积(压缩75%)、提升速度,但传统模型量化后精度损失严重。YOLO26因架构简化(无DFL),量化稳定性显著提升:

-

YOLO26m INT8量化后,mAP从51.7降至50.9(损失仅0.8%);

-

YOLOv10m INT8量化后,mAP从50.2降至48.5(损失1.7%);

-

RT-DETRv3 INT8量化后,mAP从51.7降至49.3(损失2.4%)。

在Intel NUC(OpenVINO INT8)上,YOLO26s的推理速度达37帧/秒,mAP保持46.9,完全满足工业相机"实时缺陷检测"的需求(通常需25帧/秒以上)。

四、部署实践:从边缘设备到工业场景的"无缝落地"

YOLO26的设计初衷是"为部署而生",其架构简化与多平台兼容特性,使其能轻松适配从移动设备到工业服务器的全场景,尤其在边缘领域展现出"即插即用"的优势。

1. 多平台导出:覆盖边缘设备主流生态

YOLO26支持多种导出格式,且兼容性经过严格测试(论文Table 5):

-

TensorRT:NVIDIA设备最优选择,YOLO26m导出后延迟降低30%;

-

OpenVINO:Intel x86设备专用,YOLO26s在Intel NUC上帧率达37 FPS;

-

CoreML/TFLite:移动设备原生支持,YOLO26n在iPhone 15上实现30 FPS实时检测;

-

ONNX:跨平台通用格式,导出成功率100%,可直接用于Python/C++部署。

开发者无需修改模型结构,仅通过Ultralytics Python包的一行代码(model.export(format='tensorrt'))即可完成导出,大幅降低边缘部署门槛。

2. 典型场景落地:从机器人到智能制造

(1)机器人领域:动态抓取与避障的"反应提速"

在机器人抓取场景中,YOLO26的低延迟优势凸显:

-

机械臂抓取动态物体(如传送带上的零件)时,推理延迟从8ms降至4.9ms,抓取成功率从82%提升至95%;

-

移动机器人避障时,对"小障碍物"(如地面螺栓)的识别距离从3米提升至5米,避免高速移动中的碰撞风险。

(2)智能制造:生产线缺陷检测的"成本优化"

传统工业缺陷检测依赖YOLOv8或Transformer模型,但存在"部署复杂、成本高"问题。YOLO26通过以下特性降低落地门槛:

-

轻量化部署:采用INT8量化的YOLO26s可直接运行在工业相机搭载的ARM芯片上,无需额外GPU,硬件成本降低60%;

-

高吞吐量:YOLO26m在生产线检测中,每秒可处理204帧图像,较YOLOv12的156帧/秒提升31%,满足高速流水线需求;

-

小缺陷识别:STAL策略使"零件表面划痕"(仅5×5像素)的检测率从78%提升至92%,减少漏检导致的返工成本。

五、未来方向与学界启示

YOLO26的突破不仅在于技术创新,更重塑了边缘目标检测的研发思路:

-

"减法思维"优于"加法思维":移除冗余模块(如DFL)比叠加复杂模块更能提升边缘适配性,未来可进一步探索"注意力模块的轻量化改造";

-

跨领域借鉴是创新捷径:从LLM优化器(Muon)到CV检测,打破领域壁垒可带来意想不到的突破,后续或可尝试将LLM的"上下文学习"引入小样本检测;

-

部署导向的设计优先:模型研发需提前考虑量化、多平台导出等落地需求,避免"实验室精度高、落地无法用"的困境。

康奈尔大学团队在论文结尾提到,未来将围绕"多模态融合"(如结合红外图像提升夜间检测)与"联邦学习适配"(边缘设备分布式训练)展开研究,进一步拓展YOLO26在特殊场景的应用边界。

结语:边缘AI检测的"新标杆"已至

回到开篇的仓库场景,若换上YOLO26,机械臂分拣员将不再面临"检测框打架、小元件漏检、延迟卡顿"的问题——1.7ms的推理延迟、92%的小目标检测率、100%的部署兼容性,让边缘设备真正实现"实时感知、精准决策"。

对于研究生与从业者而言,YOLO26不仅是一个可用的模型,更是一套"边缘友好型"的设计范式:它证明,边缘检测无需在精度与速度间妥协,通过架构简化、跨领域借鉴与场景导向的优化,完全可以实现"鱼与熊掌兼得"。

目前,YOLO26的论文(https://arxiv.org/abs/2509.25164)已开源,代码与预训练权重将随官方发布(https://docs.ultralytics.com/zh/models/yolo26/)。无论你是研究小目标检测的研究生,还是需要落地边缘AI项目的工程师,YOLO26都值得深入探索——它或许就是你破解边缘检测难题的"关键钥匙"。

参考资料:

-

YOLO26论文原文:https://arxiv.org/abs/2509.25164

-

Ultralytics YOLO文档:https://docs.ultralytics.com/zh/models/yolo26/