架构师论文《论大数据平台的数据质量保障测试体系》

核心内容: 针对某公司构建的用户数据平台(CDP)项目,探讨如何为大数据系统设计全面的数据质量保障方案。论述范围包括数据源的准确性验证、ETL过程中的数据转换逻辑测试、数据仓库中数据的一致性和完整性校验,以及如何利用自动化脚本和监控工具实现数据质量的持续监控。

摘要:

2023年12月,我司为实现数据驱动的精细化运营,决定整合散落在各个业务系统的用户数据,构建一个统一的客户数据平台(CDP)。该平台旨在为市场营销、产品推荐和风险控制等业务提供360度全景用户画像。在此项目中,我担任数据架构师,首要职责便是确保进入、处理及流出平台的数据的质量。我深知,数据质量是整个数据平台的生命线,“垃圾进,垃圾出”的原则将使平台的价值荡然无存。传统的软件测试方法主要关注功能逻辑的正确性,而对海量数据的准确性、一致性、完整性等方面则显得力不从心。为此,我设计并领导构建了一套贯穿数据全生命周期的数据质量保障测试体系。本文将结合该CDP平台的建设实践,首先阐述数据质量的多维度定义及其对业务的决定性影响。接着,详细论述该测试体系在数据采集、ETL处理、数据存储及数据服务等关键环节的具体实践,包括如何制定数据质量规则(DQR)、如何通过自动化脚本进行数据剖析与验证、以及如何建立数据质量的监控与告警机制。最后,本文将分享通过该体系发现的典型数据质量问题,如数据源格式突变、ETL逻辑错误导致的数据倾斜、跨系统ID关联不一致等,并阐述相应的解决方案及其成效。该体系的实施,有效保障了CDP平台产出数据的可信度,为上层数据应用的成功奠定了坚实基础。

正文:

在数字化浪潮的推动下,数据已成为企业的核心资产。我所在的公司为打破业务系统间的数据孤岛,最大化地发掘用户数据价值,于2023年底正式启动了客户数据平台(CDP)的建设项目。该项目旨在汇集来自CRM、App后端、交易系统等多个渠道的用户行为、属性和交易数据,经过清洗、整合、加工后,形成统一的用户画像标签体系,并通过数据API或BI报表等形式,赋能公司的各大业务线。我被任命为该项目的数据架构师,从项目伊始,我就清醒地认识到,这个平台成功的基石并非是采用了多么先进的大数据技术栈(如Spark、Flink、ClickHouse等),而在于我们能否保障平台中每一个数据点的质量。如果平台提供给业务方的数据是错误的、不完整的或是相互矛盾的,那么基于这些数据做出的任何决策,轻则导致营销资源浪费,重则可能引发错误的风险评估,对公司造成不可估量的损失。因此,构建一个全面的数据质量保障体系,便成为了我工作的重中之重。

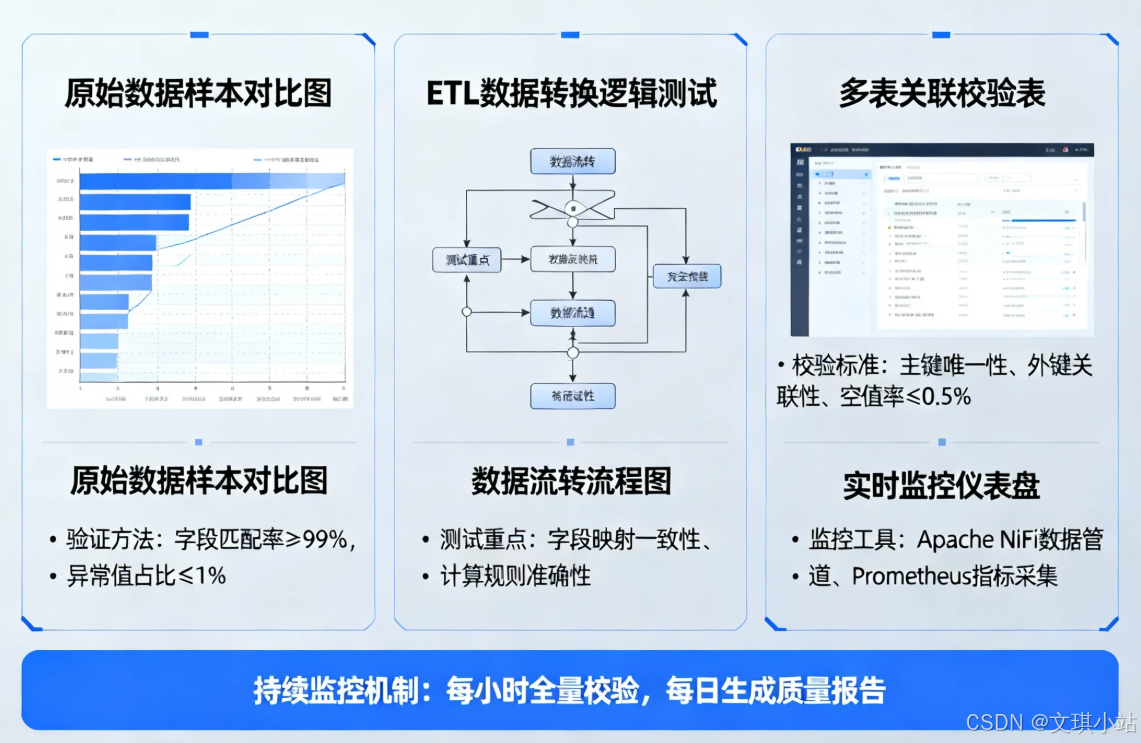

与传统的应用软件测试不同,大数据平台的测试核心不再仅仅是程序的功能是否符合需求,而是数据本身。我设计的这套数据质量保障测试体系,其理念是“预防为主,监控为辅”,将质量保障的活动嵌入到数据从产生到消费的整个生命周期中。这个体系并非一套孤立的测试工具或流程,而是结合了自动化脚本、流程规范和监控告警的一整套解决方案,覆盖了数据流转的四大关键阶段。第一阶段是数据采集与接入。这是保障数据质量的第一道关口。我们面临的数据源多种多样,有来自业务数据库的结构化数据,也有来自App前端的半结构化埋点日志。我们首先与各个数据源的负责人共同制定了详细的数据契据(Data Contract),明确了每个字段的类型、格式、枚举值范围以及业务含义。然后,我们开发了一套数据接入前的自动化预检脚本,该脚本会在数据正式进入数据湖之前,对数据进行剖析,检查其是否符合契据约定,例如,用户的年龄字段是否为正整数,订单金额是否为正数,是否存在大量的空值等。任何违反规则的数据批次都将被隔离,并触发告警通知给数据源的负责人,从而将问题扼杀在摇篮里。

第二阶段是ETL(Extract-Transform-Load)过程的测试。这是数据加工和价值提炼的核心环节,也是数据质量问题最容易滋生的温床。在这个阶段,数据会被清洗、转换、关联和聚合。复杂的ETL逻辑,尤其是涉及多表关联和窗口计算的Spark或Flink作业,极易引入错误。为了测试这些ETL作业的正确性,我们借鉴了软件开发中单元测试和集成测试的思想。对于每一个独立的转换逻辑(Transform),我们都要求开发工程师编写单元测试,使用小规模的、精心构造的输入数据集,来验证其输出是否完全符合预期。这确保了单个处理逻辑的正确性。更进一步,对于一条完整的ETL流水线,我们则进行端到端的集成测试。我们构建了一个与生产环境隔离的、小规模的测试数据集市。在这个环境中,我们运行完整的ETL流程,然后编写自动化的数据比对脚本。这些脚本不仅会比对输入和输出的数据量是否一致(Record Count Reconciliation),还会对关键指标进行抽样核对,例如,计算处理前后所有用户的总消费金额是否保持不变,验证用户ID的主键唯一性是否被破坏等。

第三阶段是数据仓库与数据集市的存储层质量校验。数据经过ETL处理后,会被加载到数据仓库(如Hive、ClickHouse)的不同层次(ODS, DWD, DWS)中。在这一层,我们关注的重点是数据的完整性、一致性和准确性。我们建立了一套数据质量监控系统,该系统会周期性地(通常是每日ETL任务执行完毕后)对仓库中的核心表执行一系列预定义的“数据质量规则(Data Quality Rules, DQR)”。这些规则是通过SQL查询来实现的,例如,“检查用户事实表中是否存在关联不到用户维度表的悬挂外键”、“检查每日新增用户数是否在正常的波动阈值范围内(Anomalies Detection)”、“检查用户的账户余额是否出现负数”等。我们为此构建了一个数据质量规则引擎,业务人员和数据分析师可以通过简单的配置界面来定义和管理这些规则。一旦某个规则校验失败,系统会自动创建告警工单,并指派给相应的数据治理负责人进行跟进处理。

第四阶段是数据服务层的质量保障。这是数据价值输出的最后一公里,通常以API或BI报表的形式提供给下游业务系统或数据分析师。在这一层,我们除了要保证数据的正确性之外,还需要关注数据的新鲜度(Timeliness)和服务的稳定性。我们为核心的数据API编写了功能自动化测试,模拟业务方的调用,验证返回的数据结构和内容是否正确。同时,我们通过监控系统密切关注数据的延迟情况,即从数据产生到最终可在API中查询到的时间间隔,并设定了SLA(服务等级协议)。任何超过SLA阈值的情况都会触发告警。对于BI报表,我们则与数据分析团队合作,建立了一套交叉验证机制,定期将报表中的关键指标与原始业务系统的数据进行核对,以确保报表数据的可信度。

通过实施这套贯穿始终的数据质量保障体系,我们在CDP平台的建设过程中,提前发现了大量潜在的数据质量问题。例如,我们曾发现由于前端埋点SDK的一个版本bug,导致部分用户的设备ID上传为空,通过接入前的预检脚本及时拦截了这批“脏”数据;我们也曾通过ETL集成测试,定位到一个复杂的窗口函数使用错误,该错误导致了用户活跃度标签计算的严重偏差。可以说,没有这套体系的保驾护航,我们的CDP平台很可能就是一个外表光鲜亮丽,内部却充满错误数据的“数据沼泽”。最终,该平台成功上线,并以其高质量、高可信度的数据赢得了业务部门的广泛信赖,为公司实现数据驱动决策的战略目标提供了坚实的数据地基。

更多文章,请移步WX,搜索同名:文琪小站

202505系分论文示例2《论模型驱动分析方法及应用》

202505系分论文2《论软件系统测试方法及应用》

系统分析师考试大纲新旧版本深度分析与备考策略报告