LLM 论文精读(九)A Survey of Reinforcement Learning for Large Reasoning Models

这是一篇近期 (2025年09月18日)发布有关 RL 和 LLM 方向的综述,总体来说篇幅较长且非常全面,原文共计 117 页,出去参考文献还剩 64 页,读起来还是有点吃力的但里面的公式并不多,重点在于灌输一个宏观的概念,所以你可以只选和自己相关的章节阅读。

为了方便阅读我对其排版进行了大幅度调整,在原文基础上添加了很多文档内和外部链接,但图片和表格上的链接无法添加,这两部分是直接截图的。

写在最前面

为了方便你的阅读,以下几点的注意事项请务必了解:

- 该系列文章每个字都是我理解后自行翻译并写上去的,可能会存在笔误与理解错误,如果发现了希望读者能够在评论区指正,我会在第一时间修正错误。

- 阅读这个系列需要你有基本的 LLM, RL 相关基础知识,有时候我会直接使用英文名词,因为这些词汇实在不容易找到符合语境的翻译。

- 原文可能因为版面限制存在图像表格与段落不同步的问题,为了更方便阅读,我会在博文中重新对图像表格进行排版,并做到引用图表的文字下方就能看到被引用的图表。因此可能会出现一张图片在博客中多处位置重复出现的情况。

- 对于原文中的图像,我会在必要时对图像描述进行翻译并附上我自己的理解,但如果图像描述不值得翻译我也不会强行写上去。

Basic Information

- 论文标题:A Survey of Reinforcement Learning for Large Reasoning Models

- 原文链接: https://arxiv.org/abs/2509.08827

- 发表时间:2025年09月18日

- 发表平台:arxiv

- 预印版本号:[v2] Thu, 18 Sep 2025 15:28:02 UTC (2,092 KB)

- 作者团队:Kaiyan Zhang, Yuxin Zuo, Bingxiang He, Youbang Sun, Runze Liu, Che Jiang, Yuchen Fan, Kai Tian, Guoli Jia, Pengfei Li, Yu Fu, Xingtai Lv, Yuchen Zhang, Sihang Zeng, Shang Qu, Haozhan Li, Shijie Wang, Yuru Wang, Xinwei Long, Fangfu Liu, Xiang Xu, Jiaze Ma, Xuekai Zhu, Ermo Hua, Yihao Liu, Zonglin Li, Huayu Chen, Xiaoye Qu, Yafu Li, Weize Chen, Zhenzhao Yuan, Junqi Gao, Dong Li, Zhiyuan Ma, Ganqu Cui, Zhiyuan Liu, Biqing Qi, Ning Ding, Bowen Zhou

- 院校机构:

- Tsinghua University;

- Shanghai AI Laboratory;

- Shanghai Jiao Tong University;

- Peking University;

- University of Science and Technology of China;

- Harbin Institute of Technology;

- University of Washington;

- Huazhong University of Science and Technology;

- University College London;

- 项目链接: 【暂无】

- GitHub仓库: https://github.com/TsinghuaC3I/Awesome-RL-for-LRMs

Abstract

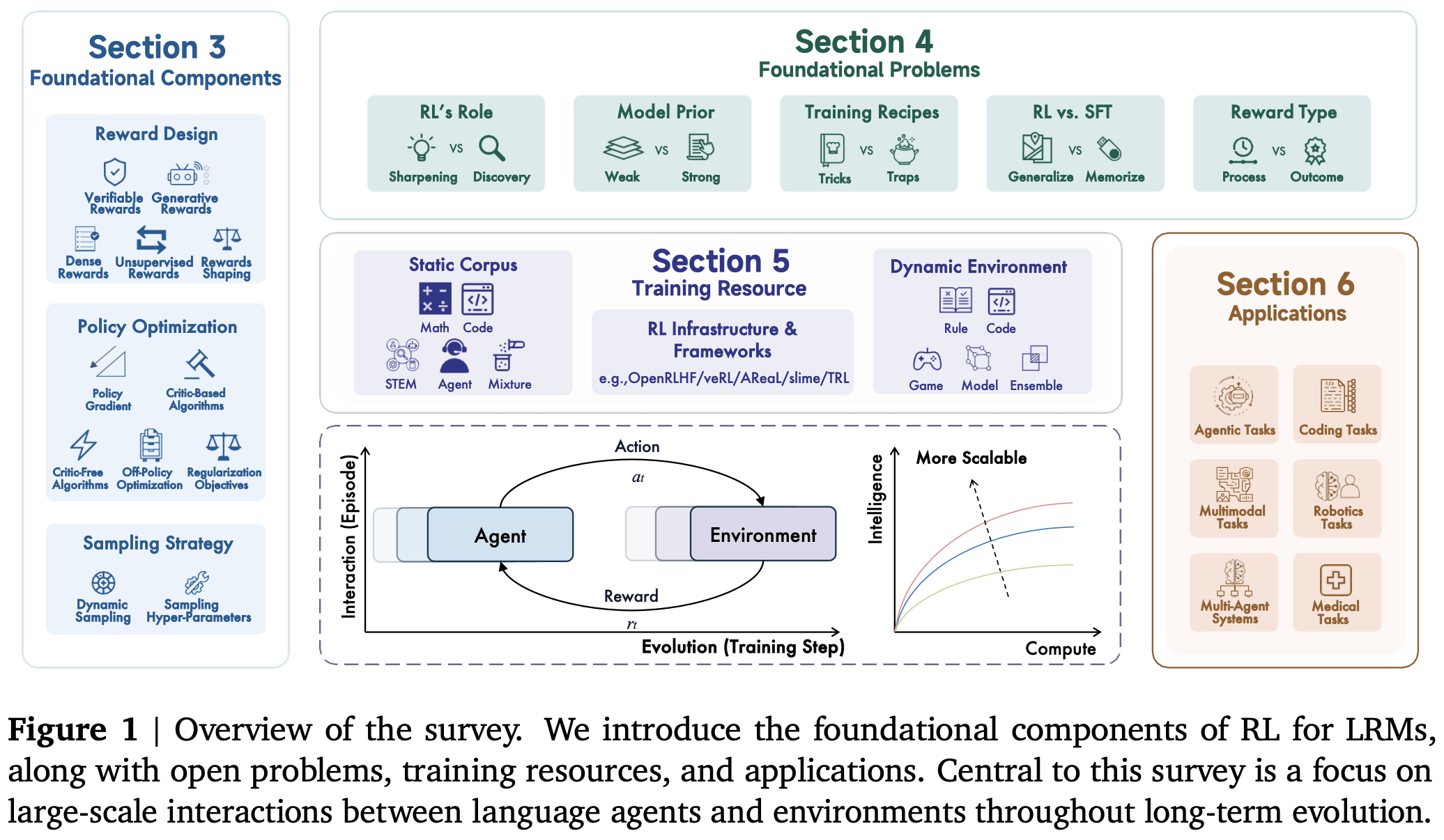

本文概述了强化学习 (RL) 在大型语言模型 (LLM) 推理方面的最新进展。RL 在拓展 LLM 能力方面取得了显著成功,尤其是在处理数学和编程等复杂逻辑任务方面。因此,RL 已成为将 LLM 转换为 LRM 的基础方法。随着该领域的快速发展,进一步扩展 LRM 的强化学习现在不仅面临着 计算资源 方面的挑战,还面临着 算法设计、训练数据 和 基础设施 方面的挑战。为此,有必要重新审视该领域的发展,重新评估其发展轨迹,并探索增强 RL 向超级人工智能 (ASI) 扩展性的策略。作者考察了将强化学习应用于 LLM 和 LRM 以提高推理能力的研究,尤其是自 DeepSeek-R1 发布以来的研究,包括 基础组件、核心问题、训练资源 和 下游应用,以期望发现这一快速发展领域的未来机遇和方向。作者希望这篇综述能够促进未来强化学习在更广泛的推理模型方面的研究。

1. Introduction

强化学习 (RL) 已反复证明,特定且明确的奖励信号能够驱动人工智能体在复杂任务上超越人类。诸如 AlphaGo 和 AlphaZero 等里程碑式的系统,通过自我对弈和奖励反馈进行学习,超越了围棋、国际象棋、将棋和 Stratego 等世界冠军,从而确立了 RL 作为一种实用且前景广阔的高级问题解决技术的地位。在大型语言模型 (LLM) 时代,强化学习最初作为一种用于人类校准的训练后策略而受到广泛关注。诸如强化学习人类反馈 (Reinforcement Learning from Human Feedback, RLHF) 和直接偏好优化 (Direct Preference Optimization, DPO) 等广泛采用的方法,可以对预训练模型进行微调,使其遵循指令并反映人类偏好,从而显著提高了 帮助性 helpfulness、诚实性 honesty 和 无害性 harmlessness (3H)。

最近出现了一种新趋势:强化学习用于大型推理模型 (RL for Large Reasoning Models, LRM) ,其目标 不仅在于协调行为,更在于激励推理本身。两个近期的里程碑式成果(即 OpenAI o1 和 DeepSeek-R1)表明,使用带有可验证奖励 (reinforcement learning with verifiable rewards, RLVR) 的强化学习(例如数学答案正确率或代码单元测试通过率)训练 LLM,可以使模型执行长篇推理,包括规划、反思和自我修正。 OpenAI 报告称,o1 的性能随着强化学习(增加训练时间计算)和推理 “thinking” 时间(测试时间计算)的增加而平稳提升,这揭示了除预训练之外的新的扩展轴。DeepSeek-R1 对数学任务采用明确的、基于规则的准确率奖励,对编码任务采用基于编译器或测试的奖励。这种方法表明,大规模强化学习,特别是群体相对策略优化 ( Group Relative Policy Optimization, GRPO),甚至可以在后期阶段对齐在前期基础模型中诱导复杂的推理行为。

这种转变将推理重新定义为一种可以明确训练和扩展的能力:LRM 分配大量测试时间计算来生成、评估和修改中间思路,并且其性能会随着计算预算的增加而提升。这种动态引入了一条能力提升的互补路径,与预训练期间的数据和参数缩放正交,同时利用奖励最大化目标,并在存在可靠验证者的情况下自动检查奖励(例如,竞赛数学、竞技编程 以及某些科学领域)。此外,强化学习可以通过启用自生成训练数据来克服数据限制。因此,强化学习越来越被视为一种很有前景的技术,通过不断扩展,它能够在更广泛的任务上实现人工智能超级智能 ( Artificial SuperIntelligence, ASI)。

与此同时,强化学习在 LRM 中的进一步扩展带来了新的约束,不仅在计算资源方面,还在算法设计、训练数据和基础设施方面也面临新的挑战。如何以及在何处扩展 LRM 的强化学习以实现高级智能并产生现实世界的价值,仍然是尚未解决的问题。因此,作者认为现在是时候重新审视该领域的发展,并探索增强强化学习向超级人工智能扩展性的策略。总而言之,本综述回顾了LRM强化学习的最新研究,内容如下:

- 介绍在 LRM 背景下强化学习建模的初步定义 § 2.1,并概述了自 OpenAI o1 发布以来前沿推理模型的发展 § 2.2;

- 回顾关于 LRM 强化学习基础组件的最新文献,包括奖励设计(§ 3.1)、策略优化(§ 3.2)和采样策略(§ 3.3),并比较了每个组件的不同研究方向和技术方法;

- 讨论强化学习中用于 LRM 的一些基础且仍存在争议的问题 (§ 4),例如强化学习的作用 (§ 4.1)、强化学习与 SFT (§ 4.2)、模型先验 (§ 4.3)、训练方案 (§ 4.4) 以及奖励定义 (§ 4.5)。作者认为这些问题值得进一步探索,以便强化学习能够持续扩展;

- 研究了强化学习的训练资源(§5),包括静态语料库(§5.1)、动态环境(§5.2)和训练基础设施(§5.3)。虽然这些资源在研究和生产中均可重复使用,但仍需进一步标准化和开发;

- 回顾了强化学习在各种任务中的应用(§6),例如编码任务(§6.1)、代理任务(§6.2)、多模态任务(§6.3)、多智能体系统(§6.4)、机器人任务(§6.5)和 医疗应用(§6.6);

- 最后讨论强化学习语言模型的未来方向(§7),涵盖新算法、机制、特性和其他研究途径;

2. Preliminaries

2.1 Background

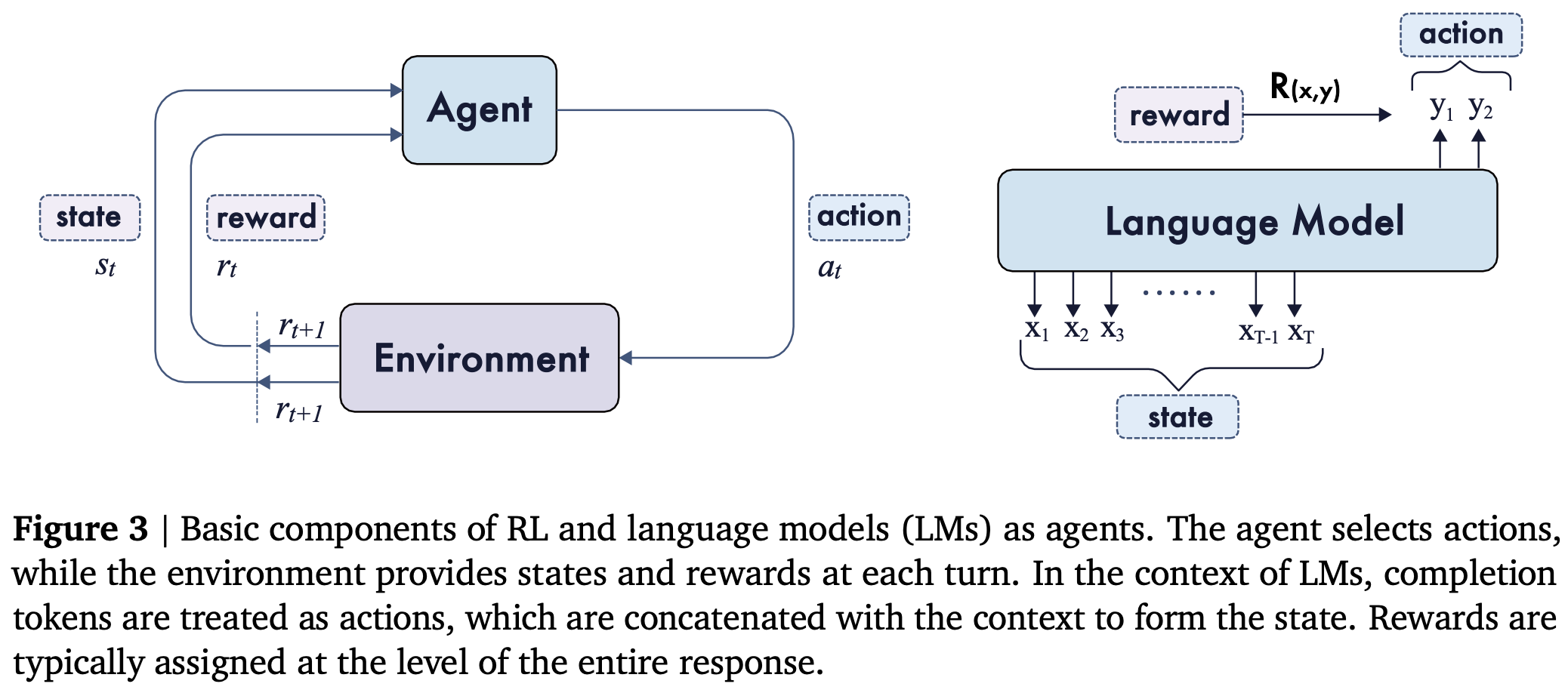

在本节中,将介绍强化学习的基本组成部分,并描述如何在强化学习框架中将语言模型配置为 agents。如 Fig.3 所示,强化学习提供了一个用于序列决策的通用框架,其中 agent 通过采取行动与环境交互,以最大化累积奖励。

在经典强化学习中,该问题通常表述为马尔可夫决策过程 (Markov Decision Process, MDP),由一个元组 (S,A,P,R,γ){(\mathcal{S,A,P},R,\gamma)}(S,A,P,R,γ) 定义。其主要组成部分包括 状态空间 S\mathcal{S}S、动作空间 A\mathcal{A}A、转移方程 P:S×A↦S\mathcal{P:S\times A \mapsto S}P:S×A↦S、奖励函数 R:S×A↦RR:\mathcal{S\times A }\mapsto \mathbb{R}R:S×A↦R 和 折扣因子 γ∈[0,1]\gamma\in [0,1]γ∈[0,1]。在每个步骤中,agent 会观察到一个状态 sts_{t}st 根据其由 θ\thetaθ 参数化的策略 πθ\pi_{\theta}πθ 选择一个动作 ata_{t}at,获得奖励 rtr_{t}rt,然后过渡到下一个状态 st+1s_{t+1}st+1,当将强化学习应用于语言模型时,这些概念可以自然地映射到语言领域,且几乎无需任何调整。映射总结如下:

- Prompt/Task (xxx):对应于初始状态或环境上下文,从数据分布中提取并对应于数据集 D\mathcal{D}D;

- Policy (πθ\pi_{\theta}πθ):表示语言模型,根据提示词生成长度为 TTT 的序列 y=(y1,…yT)y=(y_{1},\dots y_{T})y=(y1,…yT);

- State (sts_{t}st):定义为提示生成的 tokens,即 st=(x,a1:t−1)s_{t}=(x,a_{1:t-1})st=(x,a1:t−1);

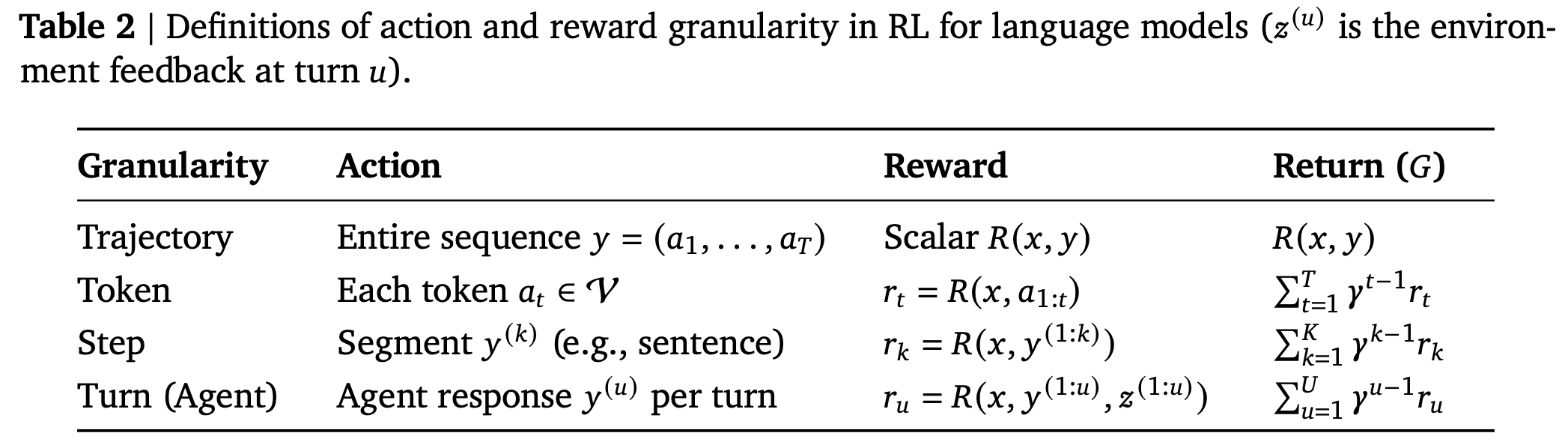

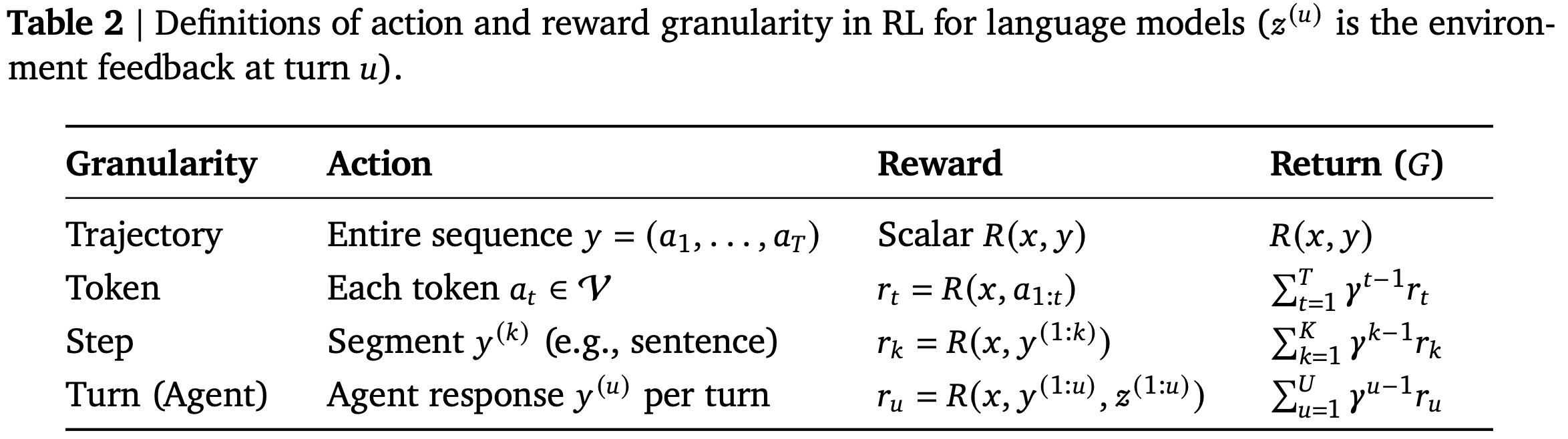

- Action (ata_{t}at):从动作空间 A\mathcal{A}A 中选择的第 ttt 步的动作,根据粒度不同,动作可以被表示为一整个序列 yyy (sequence-level)、一个 token at∈Va_{t}\in\mathcal{V}at∈V (token-level)、一个片段 y(k)=(y1(k),…,yTk(k))y^{(k)}=(y_{1}^{(k)},\dots,y_{T_{k}}^{(k)})y(k)=(y1(k),…,yTk(k)),详细的区别可查看

Table.2; - Transition Dynamics (P\mathcal{P}P):在 LLM 的上下文中,状态转换通常是确定性的,因为 st+1=[st,at]s_{t+1}=[s_{t}, a_{t}]st+1=[st,at],其中 [⋅,⋅][·, ·][⋅,⋅] 表示字符串连接。当状态包含 EOS token 时,策略将转换到终止状态;

- Reward (R(x,y)or rtR(x,y) \text{or } r_{t}R(x,y)or rt):根据动作粒度不同,例如,序列级 sequence-level R(x,y)R(x,y)R(x,y)、token-level rt=R(x,a1:t)r_{t}=R(x,a_{1:t})rt=R(x,a1:t)、step-level rk=R(x,y(1:k))r_{k}=R(x,y^{(1:k)})rk=R(x,y(1:k))。

- Return (GGG):提示 xxx的整个累积奖励 yyy (通常在有限时间范围 γ=1\gamma=1γ=1 内)。可以简化为单个标量 R(x,y)R(x,y)R(x,y),其中包含 sequence-level、token、step 奖励,如

Table.2所示;

在这种情况下,学习目标是最大化数据分布 D\mathcal{D}D 上的预期累积奖励:

maxθJ(θ):=Ex∼D,y∼πθ(x)[G]\max_{\theta}\mathcal{J}(\theta) := \mathbb{E}_{x\sim \mathcal{D}, y\sim \pi_{\theta}(x)}[G] θmaxJ(θ):=Ex∼D,y∼πθ(x)[G]

在实际使用中,通常会将学习到的策略正则化为参考策略 πref\pi_{ref}πref,将其应用 KL-divergence 约束,以稳定训练并保持语言质量。在以下章节中将介绍基于此基本公式的各种算法。

2.2 Frontier Models

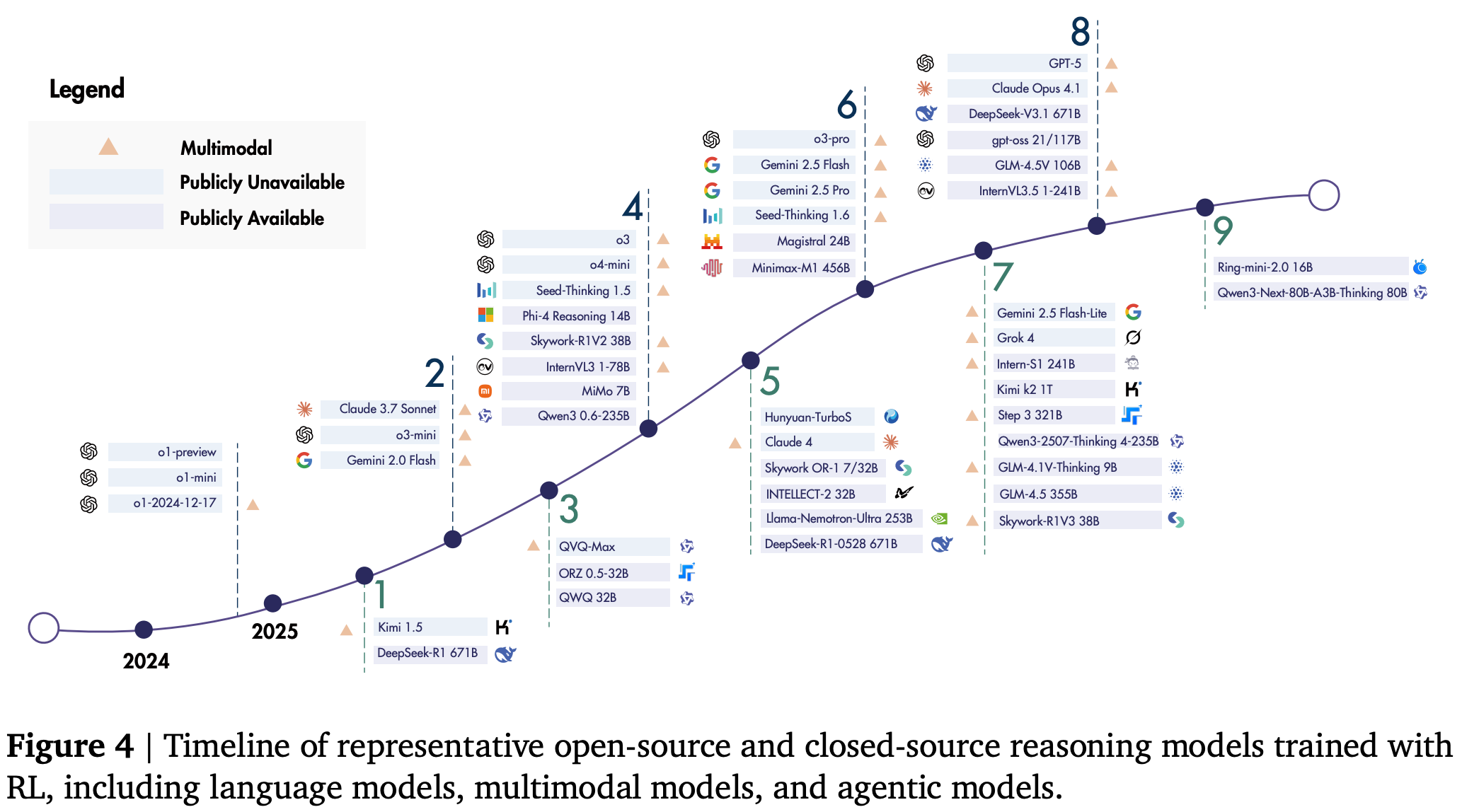

在本小节中,将概述使用类似强化学习的方法训练的最先进的大型推理模型,这些模型大致按时间顺序排列在三个主要方向:LRM、agent LRM 和多模态 LRM。

在过去的一年里,RL 逐步拓展了推理模型及其应用的前沿领域。首批大型推理模型,如 OpenAI 的 o1 (2024) 系列,确立了将训练时强化学习和测试时计算扩展至更强大推理能力的有效性,并在数学、编程和科学基准测试中取得了领先的成果;DeepSeek 的旗舰模型 R1 (2025) 紧随其后,成为首个在各个基准测试中性能匹敌 o1 的开源模型,它采用多阶段训练流程来确保全面的模型能力,并探索了无监督微调的纯强化学习(即零强化学习)的发展路径;其他专有模型也迅速发布:Claude-3.7-Sonnet (2025) 以 混合推理 为特色;Gemini 2.0/2.5 (2025) 引入了更长的上下文长度;Seed-Thinking 1.5 (2025) 以 跨领域泛化 为特色; o3 (2025) 系列则展示了日益先进的推理能力。最近,OpenAI 推出了其首个开源推理模型 gpt-oss-120b (2025),随后又推出了迄今为止功能最强大的人工智能系统 GPT5 (2025),它可以在高效模型和更深层次的推理模型 GPT-5 思维之间灵活切换。并行的开源工作持续拓展着人工智能的版图。在 Qwen 系列中,QwQ-32B (2025) 的性能与 R1 相当,紧随其后的是 Qwen3 (2025)系列,其中代表模型 Qwen3-235B 进一步提升了基准分数;Skywork-OR1 (2025) 模型套件基于 R1 提炼的模型,通过有效的数据混合和算法创新实现了可扩展的强化学习训练;Minimax-M1 (2025) 是第一个引入 混合注意力机制来有效扩展强化学习的模型。其他研究包括 Llama-Nemotron-Ultra (2025),旨在平衡准确率和效率;Magistral 24B (2025),它通过强化学习从头开始训练,没有从先前的模型中进行提炼;和 Seed-OSS (2025),强调长上下文推理能力。

模型推理的改进反过来又扩展了它们在编码和代理场景中的用例。Claude 系列以其在 coding 和 agentic 任务上的领先性能而闻名,Claude-4.1-Opus (2025) 就是一个例证,它进一步推进了 SWE-bench 上的最新成果;Kimi K2 (2025) 是一个近期具有代表性的代理模型,它专门针对 agentic 任务进行了优化,构建了大规模 agentic 训练数据合成和可适应不可验证奖励的通用强化学习程序;GLM4.5 (2025) 和 DeepSeek-V3.1 版本都强调了工具使用和代理任务,并在相关基准测试中取得了显著的改进。

多模态是推理模型得以广泛应用的关键因素。大多数前沿专有模型,包括 GPT-5、o3、Claude 和 Gemini 系列都原生具备多模态特性。Gemini-2.5 (2025) 尤其强调了其在文本、图像、视频和音频方面的出色表现。在开源方面,Kimi 1.5 (2025) 代表了多模态推理的早期成果,重点突出了长上下文扩展以及文本和视觉领域的联合推理。QVQ (2025) 在视觉推理和分析性思维方面表现出色,而 SkyworkR1V2 (2025) 则通过混合强化学习(同时使用 MPO 和 GRPO)来平衡推理能力和通用能力。作为 InternVL 系列的显著补充,InternVL3 (2025) 采用了统一的原生多模态预训练阶段,而后来的 InternVL3.5 (2025) 则采用了两阶段级联强化学习框架,从而提升了效率和通用性。近期,Intern-S1 (2025) 模型专注于跨领域的多模态科学推理,得益于在线强化学习中的混合奖励设计,该设计能够同时在各种任务上进行训练。其他近期模型包括 Step3 (2025),旨在实现高效训练并最大限度地降低解码成本;以及 GLM-4.5V (2025),它在大多数视觉多模态基准测试中均取得了最佳性能。

除了上述模型之外,在 Fig.4 中提供了推理模型的完整列表,并在 Table.1中提供了有关开源模型的详细信息。

2.3 Related Surveys

在本小节中,将比较近期与强化学习和 LLM 相关的综述。一些综述主要关注强化学习本身,涵盖了经典强化学习及其最新的扩展。

【Note】:这里我将paper名和链接附上,你可以直接点击文章名进行跳转,同时进行了分段,原文中并没有相关部分

- Ghasemi(2024):提出了一项涵盖算法和现实世界挑战的通用强化学习综述 《A Comprehensive Survey of Reinforcement Learning: From Algorithms to Practical Challenges》 ;

- Huh 和 Mohapatra(2023):专注于多智能体强化学习 《Multi-agent Reinforcement Learning: A Comprehensive Survey》;

- Zhang(2024):回顾了自我博弈技术《A Survey on Self-play Methods in Reinforcement Learning》;

- Wu 等人则对计算机视觉任务中的强化学习进行了综述 《Reinforcement Learning in Vision: A Survey》。

虽然这些研究为强化学习提供了广阔的视角,但它们并未明确阐述其在 LLM 中的应用。相比之下,其他研究则集中于 LLM 及其新兴能力,例如 长链思维推理 和 自适应行为,其中强化学习通常被引入作为支持这些进步的关键方法。

- Zhao(2023):对 LLM 架构和应用进行了广泛的概述,而最近的研究则专注于推理能力 《A Survey of Large Language Models》;

- Zhang(2025):调查了 ·DeepSeek-R1· 之后对推理 LLM 的复制研究 《100 Days After DeepSeek-R1: A Survey on Replication Studies and More Directions for Reasoning Language Models》;

- Chen(2025):研究了长链思维推理;Li 等人分析了从 System 1 到 System 2 推理的转变 《Towards Reasoning Era: A Survey of Long Chain-of-Thought for Reasoning Large Language Models》;

这些研究强调 基于强化学习的方法(例如 RLHF 和 RLVR)是有用的 工具,但仅将它们视为众多推理策略中的一个元素。

- Sun(2025):通过基础模型对推理进行了更广泛、更结构化的探讨,重点介绍了专门为推理而提出或改编的关键基础模型,以及各种推理任务、方法和基准测试的最新进展 《A Survey of Reasoning with Foundation Models》;

- Zhang(2025):研究了强化学习如何赋予 LLM 自主决策和自适应代理能力 《The Landscape of Agentic Reinforcement Learning for LLMs: A Survey》;

- Xu(2025):通过讨论 LLM 的强化推理,更贴近我们的关注点,强调了试错优化如何改进复杂推理 《Towards Large Reasoning Models: A Survey of Reinforced Reasoning with Large Language Models》;

- Wu(2025):通过调查奖励模型和从反馈中学习的策略来补充这一观点 《Sailing by the Stars: A Survey on Reward Models and Learning Strategies for Learning from Rewards》;

然而,这些研究仍然侧重于推理性能或奖励设计,而不是对 LLM 的强化学习方法进行系统性处理。

- Srivastava 和 Aggarwal(2025):代表了近期尝试连接这两个领域的尝试,他们回顾了用于 LLM 对齐和增强的强化学习算法,主要采用了

RLHF、RLAIF和DPO等方法。他们的研究仍然主要关注对齐能力,而非推理能力。

与以往涵盖通用强化学习或 LLM 推理的综述不同,作者将强化学习置于核心地位,并系统地总结其在整个 LLM 训练生命周期中的作用,包括奖励设计、策略优化和采样策略。目标是 探索将 LRM 中的强化学习扩展至 ASI 的新方向,并重点关注长期交互和演化。

3. Foundational Components

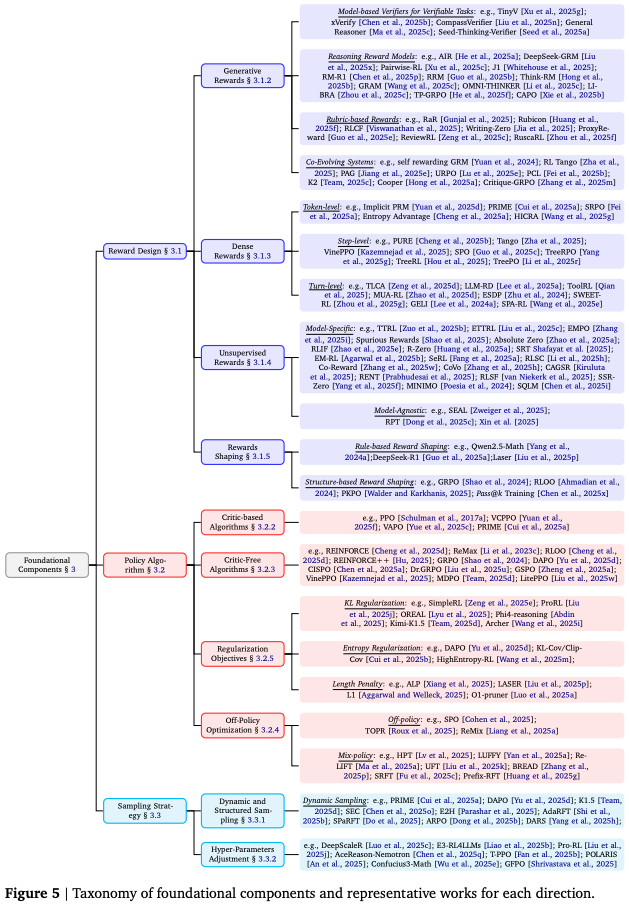

在本节中,将回顾 LRM 的 RL 基础组件,包括奖励设计(§3.1)、策略优化算法(§3.2)和采样策略(§3.3)。基础组件的分类如 Fig.5 所示。

3.1 Reward Design

在本小节中,将全面探讨强化学习中用于 LRM 的奖励设计。从 § 3.1.1 开始,可验证奖励 是一个自然的起点。在这方面已经取得了实质性的进展,例如 DeepSeek-R1 的成功,它通过可验证的奖励机制证明了强化学习的可扩展性;§ 3.1.2 探讨了 生成性奖励,其中模型用于验证或直接生成奖励信号;然而,可验证奖励和生成性奖励通常都表示为稀疏的数值反馈。一个重要的补充维度是奖励信号的密度;§ 3.1.3 探讨了 密集奖励 的方法。另一个分类维度涉及奖励是根据外部基本事实计算得出的,还是由模型直接估计得出的。这种区别在 § 3.1.4 中讨论 无监督奖励。基于这四个类别,在 § 3.1.5 中转向 奖励塑造,分析组合或转换不同奖励信号以促进学习的策略。

3.1.1 Verifiable Rewards

Rule-based Rewards

奖励作为强化学习的训练信号,决定了优化方向。近年来,基于规则的可验证奖励机制在大规模强化学习中主要用于训练 LRMs。此类奖励机制通过鼓励更长且更具反思性的思维链,能够可靠地提升数学和编码推理能力。该范式在 Tülu 3 中被形式化为 RLVR,它用程序化的验证器(例如,答案检查器或单元测试)取代了学习到的奖励模型。此类验证器在具有客观可验证结果的领域提供二进制的可验证信号。类似的基于规则的可验证奖励设计方法随后被集成到 DeepSeek 的训练流程中。例如,DeepSeek-V3 (2024) 明确引入了 针对确定性任务定制的基于规则的奖励系统,而 DeepSeek-R1 则进一步采用了 基于准确度和基于格式的奖励。基于规则的奖励与基于结果或基于过程的奖励模型 (process-based Reward Models, RMs) 形成鲜明对比,例如基于人类偏好排名训练的奖励模型使用标准 RLHF 和基于步骤级注释训练的过程奖励模型 (Process Reward Models, PRM)。 DeepSeek-V3 和 DeepSeek R1 证明,RM 在大规模强化学习环境中可能会遭受 reward hacking,但通过尽可能利用基于规则的奖励,可以增强系统抵御 manipulation 和 exploitation 的能力,从而确保更高的可靠性。实践中,两种基于规则的可验证奖励被广泛使用:

- Accuracy rewards:对于结果确定性的任务(例如数学),策略必须在规定的分隔符(通常为

\boxed{...})内生成最终解决方案。然后,自动检查器会将此输出与基本事实进行比较。对于 coding 任务,单元测试或编译器会提供通过/失败信号; - Format rewards:这些规则施加了一个结构约束,要求模型将其思维链置于

<think>和</think>之间,并将最终答案输出到单独的字段中(例如,<answer>...</answer>)。这提高了大规模强化学习中解析和验证的可靠性;

Rule-based Verifier

基于规则的奖励通常源自基于规则的验证器。这些验证器依赖于大量手动编写的等价规则来确定预测答案是否与基本事实相符。目前,广泛使用的数学验证器主要基于 Python 库 Math-Verify1 和 SymPy2 构建。此外,一些研究也提供了开源且成熟的验证器,例如 DAPO 和 DeepScaleR。最近,Huang (2025) 强调了基于规则和基于模型的验证器各自存在的局限性,以期为更可靠的奖励系统的设计提供参考 《From Accuracy to Robustness: A Study of Rule- and Model-based Verifiers in Mathematical Reasoning》。

在实践中,数学问题求解和代码生成等任务难以解决但相对容易验证,从而能够满足高效 RL 优化的主要标准:存在清晰的基本事实、可快速自动验证、可评估许多候选解决方案、以及与正确性紧密相关的奖励信号。相比之下,缺乏快速或客观验证的任务(例如开放式问答或自由形式写作)对于基于结果的 RL 来说仍然具有挑战性,因为它们 依赖于嘈杂的学习奖励模型或主观的人为反馈。验证者定律认为,训练人工智能系统执行任务的难易程度与任务的可验证程度成正比,一旦一项任务能够配备强大的自动反馈,它就可以通过 RL 快速改进。第6节中讨论的成功应用证实了这一原则,因为其核心挑战在于 设计可靠的可验证反馈。相反,第7节中强调的许多未解决的问题恰恰源于 缺乏可靠的自动化奖励。

3.1.2 Generative Rewards

虽然基于规则的奖励为可验证任务提供了可靠的信号(如前所述,§3.1.1)但其适用性有限。许多复杂的推理任务,尤其是在开放式或创造性领域,缺乏客观的 ground truth,这使得结构简单的验证器难以应对。为了弥补这一差距,GenRM 应运而生并成为一个强大的替代方案。GenRM 并非输出简单的标量分数,而是 利用 LRM 的生成能力来生成结构化的评论、理由和偏好,从而提供更易于解释和更细致的奖励信号。这种方法解决了两个关键挑战:首先,提高了难以解析的可验证任务的验证的鲁棒性;其次,使得强化学习能够应用于主观的、不可验证的领域。

Model-based Verifiers for Verifiable Tasks

基于规则的系统面临的主要挑战在于其脆弱性,当模型以意想不到的格式生成正确答案时,它们经常会产生假阴性。为了缓解这个问题,一项研究使用基于规则的 GenRM 作为灵活的基于模型的验证器。这些模型经过训练能够 在语义上评估模型自由格式输出与参考答案之间的等价性。这种方法已被用于开发增强现有基于规则系统的轻量级验证器,以及能够处理多种数据类型和推理任务的更全面的多领域验证器。通过用学习到的语义判断替换或补充严格的字符串匹配,这些验证器为可验证领域的强化学习提供了更准确的奖励信号。

Generative Rewards for Non-Verifiable Tasks

GenRM 的另一个核心应用是基于评估的 GenRM,它使强化学习能够胜任验证规则不成立的任务。这种范式已经从使用 LLM 作为零样本评估器发展成为复杂的协同进化系统。可以根据这些方法的核心设计原则对其进行分类:

- Reasoning Reward Models (Learning to Think):超越简单偏好预测的一项重大进步是 训练 RM 在做出判断之前进行明确的推理。这种方法是 LLM-as-a-Judge 概念的基础,它涉及提示 RM 生成 CoT 批评或理由。例如,

CLoud RMs首先生成自然语言评论,然后使用它来预测标量奖励。将奖励建模转化为推理任务的原则,如今已成为最先进的 RM 的核心。这些 RM 经过训练,能够在赋予分数或偏好之前提供详细的理由。为了进一步提升判断能力,这些推理 RM 通常自己用强化学习进行训练,使用基于最终判决正确性的简单、可验证的元奖励。这项工作还探索了不同的奖励形式,例如从 tokens 概率中获取软奖励以及权衡逐点和成对评分方案之间的权衡; - Rubric-based Rewards (Structuring Subjectivity):为了将主观任务的评估锚定在更一致的标准上,许多框架采用了结构化的评估准则。与依赖硬编码逻辑来执行客观、可验证任务的基于规则的方法不同,基于评估准则的方法 利用自然语言描述来捕捉主观、不可验证领域的细致评估标准,而传统的二元规则在这些领域是不够的。这需要使用 LLM 生成或遵循一系列原则来指导其评估。

RaR、QA-LIGN、Rubicon和RLCF等框架使用此类评估准则来生成细粒度、多方面的奖励。这一概念可以延伸到将高级任务分解为一组可验证的代理问题,或生成特定领域的原则,例如创意写作或科学评论。此外,评分标准可以发挥双重作用,既可以作为指导策略探索的教学框架,也可以作为最终奖励的标准; - Co-Evolving Systems (Unifying Policy and Reward):最先进的范式超越了静态的策略-奖励关系,转向了生成器和验证器共同改进的动态系统。这可以通过以下方式实现:

- Self-Rewarding:单个模型生成自己的训练信号。这在自我奖励语言模型中得到了证明,并且已在以下框架中实现操作:模型在策略和验证者角色之间交替;根据自身的批评进行自我修正;通过完成后学习将奖励函数内化;

- Co-Optimization:策略和单独的奖励模型同时训练。例如,

RL Tango使用共享的结果级奖励联合训练生成器和过程级GenRM;Cooper协同优化了这两个模型,以增强鲁棒性并减少 reward hacking。其他研究则将策略(“player”)和奖励(“refere”)函数统一到一个通过统一 RL 循环训练的模型中;

这种从静态判断系统向动态协同进化系统的演变,通常由结合规则信号和生成信号的混合奖励方案。此外,GenRM 正在被改进以提供更细粒度的流程级反馈,以解决复杂推理链中的信用分配问题。本质上,生成性奖励对于将强化学习扩展到通用 LRM 所针对的全部任务范围至关重要。

3.1.3 Dense Rewards

在经典强化学习(例如游戏和机器人操控任务)中,密集奖励几乎会在每个决策步骤提供频繁的反馈,这缩短了信用分配范围,通常可以提高样本效率和优化稳定性,但如果信号设计不当,也存在错误指定和 reward hacking 的风险。对于 LLM 推理,密集奖励通常是基于过程的信号,用于监督中间步骤而非仅仅监督结果,并且已被证明是有效的,通常优于基于结果的奖励。基于§2.1中的定义,根据动作和奖励粒度,在LLM RL的背景下进一步形式化稀疏/结果和密集奖励,如 Table.2所示。

Token-Level Rewards

DPO 及其后续工作表明,token 级别的奖励可以通过策略与参考模型之间的对数似然比来计算;隐式 PRM 进一步表明,可以通过训练 ORM 并使用 Rafailov 参数化来获得 token 级别的奖励;PRIME 将 ORM 学习融入到强化学习训练中,并使用隐式 token 级别的奖励来训练策略;SRPO 删除了 PRIME 中的 ORM,并改进了优势估计;另一系列研究集中于使用内部反馈作为 token 级奖励,例如 token entropy 和 strategic grams。

Step-Level Rewards

阶梯式奖励的方法分为两类:基于模型的方法 和 基于采样的方法。早期的研究依赖于人类专家来注释阶梯式密集奖励,这种方法成本高昂且难以扩展。

- Model-based:为了降低注释成本,

Math-Shepherd使用蒙特卡洛估计来获取步骤级标签,并证明了使用训练好的 PRM 进行流程验证在强化学习中是有效的;PAV通过优势建模进一步改进了流程奖励。为了减轻基于模型的步骤级奖励带来的 reward hacking,PURE采用最小形式的信用分配而非求和形式,而Tango和AIRL-S则联合训练策略和 PRM。凭借生成式 PRM(详见§3.1.2)的强大验证能力,ReasonFlux-PRM、TP-GRPO和CAPO等模型利用这些能力,为强化学习训练提供阶梯式奖励。然而,基于模型的密集奖励机制容易受到奖励黑客攻击,而且在线训练 PRM 的成本高昂; - Sampling-based:另一系列研究使用蒙特卡洛采样进行在线过程奖励估计。

VinePPO通过蒙特卡洛估计改进了PPO;为了改进步骤分割,SPO和FR3E使用低概率或高熵标记作为划分点。为了提高样本效率和优势估计,SPO、TreeRPO、TreeRL和TreePO探索了基于树的结构,用于细粒度的过程奖励计算;MRT、S-GRPO、VSRM和SSPO强制 LLM 在中间位置终止思考过程,以有效地估计步骤级奖励;PROF利用结果奖励和过程奖励之间的一致性来过滤强化学习训练中的噪声数据。

Turn-Level Rewards

回合级奖励评估每次完整的 agent 与环境交互,例如工具调用及其结果,并在多回合任务中以单回合为粒度提供反馈。回合级奖励的研究大致可分为两条路线:直接每回合监督 和 从结果级奖励中获取回合级信号。

- 直接每轮监督:一些研究在每轮提供显式反馈,例如,情绪敏感对话策略学习利用用户情绪作为每轮奖励来指导策略优化,展示了轮级反馈如何提升对话代理的交互质量;

ToolRL设计了基于格式和正确性的结构化奖励,并在工具调用的每个步骤提供,为学习提供密集的轮级信号;Zeng 等人进一步利用可验证信号和显式轮级优势估计来改进强化学习过程中的多轮工具使用;SWEET-RL学习了一个 step/turn-level 评价器,可提供每轮奖励和信用分配,从而提供显式的轮级监督;MUA-RL将模拟用户交互融入 RL 循环,其中每次多轮交换都会产生每轮反馈,使 agent 能够在真实的用户-代理动态下迭代地改进其策略;G-RA通过引入门控奖励聚合扩展了这一工作思路,其中密集的轮次级奖励(例如,动作格式、工具调用有效性、工具选择)仅在满足更高优先级的结果级条件时才会累积; - 结果级奖励中获取回合级信号:其思路是 将基于结果的监督分解或重新分配到更细粒度的单元中。将对话 agent 与全局反馈对齐将会话级分数转换为回合级伪奖励,而

GELI利用韵律和面部表情等多模态线索,将会话级反馈细化为局部回合级信号;SPA-RL通过进度归因将基于结果的奖励重新分配到每步或每回合的贡献中;ARPO将 step/turn-level 优势归因于轨迹级结果(例如,使用工具后),从而有效地将全局回报转换为局部信号;

总体而言,回合级奖励,无论是在每次交互时直接分配,还是从结果分解中得出,都是 基于过程和结果监督之间的桥梁,并在稳定和改进多回合 agent 强化学习的优化方面发挥着核心作用,更多详细信息请参见§6.2。

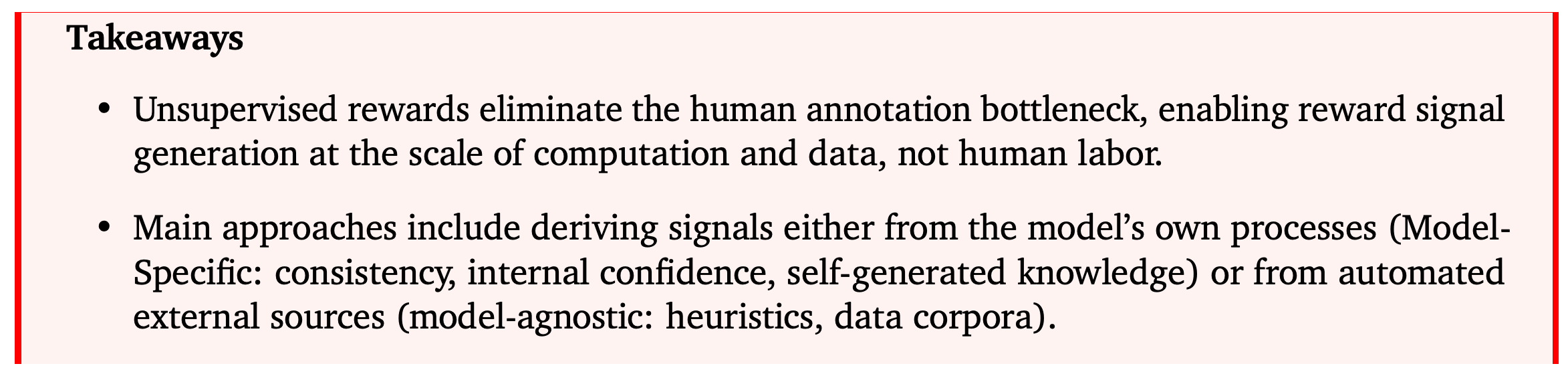

3.1.4 Unsupervised Rewards

前沿语言模型在众多任务中表现出色,包括许多极具挑战性的任务。然而,这些模型发展的一个关键限制在于 其对强化学习中人为生成的奖励信号的依赖 (§ 3.1.1–3.1.3)。对于需要较高人类专业知识的任务,人工反馈通常速度慢、成本高且不切实际。为了解决这个问题,一种很有前景的方法是无监督强化学习,它 使用自动生成的可验证奖励信号来代替真实标签。这种方法对于实现 LLM 可扩展 RL 至关重要。本节概述了这些无监督奖励机制,并根据其来源将其分为两类:源自模型本身的奖励机制(特定于模型)和 来自外部非人类来源的奖励机制(与模型无关)。

Model-Specific Rewards

这种范式 LLM 的内部知识作为唯一的监督来源。它假设高性能模型能够生成一致、可信或评价合理的输出。这种方法具有高度可扩展性,只需要模型和计算资源即可生成几乎无限量的 “labeled” 数据。然而,其闭环特性存在 reward hacking 和 model collapse 的风险。

- Rewards from Output Consistency:该方法 假设正确答案将在多个生成的输出中形成一个密集且一致的聚类。基础研究如

EMPO和测试时强化学习 ( Test-Time Reinforcement Learning, TTRL) 分别通过聚类和多数投票实现了这一目标。后续方法旨在通过提高效率ETTRL、融入推理轨迹CoVo或使用对比一致性来对抗 reward hacking 的Co-Reward来改进这一方法; - Rewards from Internal Confidence:另一种方法是 直接从模型的内部状态获取奖励,并使用置信度作为正确性的 agent。信号可以基于交叉注意力

CAGSR、负熵EM-RL、RENT或生成概率Intuitor、RLSC、RLSF。这些方法的成功通常取决于基础模型的初始能力,并且可能很脆弱,因为它们 依赖于正确路径和错误路径之间的低密度分离等先验; - Rewards from Self-Generated Knowledge:该范式 利用模型的知识来创建学习信号,既可以充当评判者(self-rewarding),也可以充当问题提出者(self-instruction)。在自我奖励中,模型评估自身的输出以产生奖励。该奖励是由 Yuan 等人和 Wu 等人提出的概念,并应用于

SSR-Zero和MINIMO等工作中;在自我指导中,提出者模型为求解者生成课程,提出者通常会因创建最佳难度的任务而获得奖励,而求解者的奖励可以与模型无关(例如,来自 AZR 中的代码执行器)或特定于模型(例如,通过SQLM和SeRL中的多数投票)。

Model-Agnostic Rewards

与模型特定方法不同,该范式 从外部自动化来源获取奖励。这种方法将学习过程建立在外部信息的基础上,无需人工标记。其核心原理是这些外部信号易于获取且无需人工干预。然而,由于通常无法获得精确的反馈,agent 奖励的质量至关重要,并且 reward hacking 的风险仍然存在。

- Heuristic Rewards:这种方法构成了另一种基于规则的奖励机制,它采用 基于输出属性(例如长度或格式)的简单预定义规则作为质量的 agent,在 §3.1.1中讨论的一个具体案例是该方法的典型。

DeepSeek-R1率先采用了这种方法,后来通过动态奖励缩放等技术进行了改进。虽然这些启发式方法可扩展,但它们可能会被模型利用,导致模型在不提升真实性能的情况下获得表面的改进; - Data-Centric Rewards:这种方法从 大型、未标记语料库的结构中获取奖励信号。类似于大规模预训练的下一个词预测,

RPT将下一个词条预测重新定义为强化学习任务,将网络规模的数据集转化为数百万个训练样本;在元层面,SEAL允许模型生成自己的训练数据和超参数,并使用下游性能作为奖励;

总而言之,无监督奖励设计对于创建可扩展的 LLM 强化学习系统至关重要。模型特定范式通过利用模型的内部知识来促进自我改进,而模型无关范式则将学习建立在外部的自动反馈之上。虽然这两种方法都能有效地绕过人工标注瓶颈,但仍然容易受到 reward hacking。可扩展强化学习的未来很可能涉及策略性地结合这些方法的混合系统,例如,使用以数据为中心的奖励进行预训练,使用模型特定的自我奖励进行复杂推理的微调,并尽量减少人工监督以确保安全性和一致性。

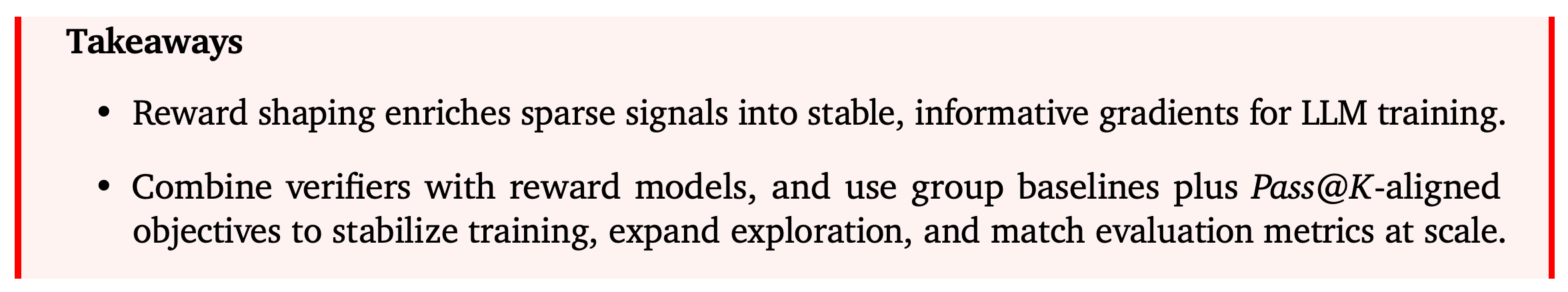

3.1.5 Rewards Shaping

如上所述,强化学习中 agent 的主要学习目标是最大化累积奖励,因此奖励函数的设计尤为关键。在前几节中介绍了各种奖励函数,例如可验证奖励(§ 3.1.1)、生成奖励(§ 3.1.2)、密集奖励(§ 3.1.3)以及无监督奖励(§ 3.1.4)。除了奖励工程之外,同样重要的是考虑 如何修改或增强奖励函数,以鼓励那些推动向理想解决方案前进的行为。这个过程被称为奖励塑造 reward shaping,可以分为 基于规则的奖励塑造 和 基于结构化的奖励塑造。

Rule-based Reward Shaping

在基于 LLM 的强化学习中,最简单且最常用的奖励塑造方法是 将基于规则的验证器和奖励模型的奖励结合起来,以生成整体奖励信号,如 Qwen2.5 Math 中所示。通常使用一个常数系数来平衡奖励模型和基于规则的组件的贡献。这种方法并非为所有正确答案分配相同的奖励,而是允许根据奖励模型的得分对答案进行进一步排序。这种方法对于更具挑战性的样本尤其有用,并且有助于避免所有奖励值都为 0 或 1 的情况,否则会导致无效的学习梯度。这种启发式组合策略广泛应用于开放领域任务,其中将基于规则的奖励和奖励模型相结合,可以为 LLM 的强化学习提供更具信息量和有效性的奖励信号。

另一种方法是 结合基于规则的奖励,例如结果级奖励和格式奖励,正如 DeepSeek-R1 中实现的那样,这使得 LLM 能够学习长链思维推理。这些奖励包括 基于格式的奖励 和 基于长度的奖励,以解决 LLM 输出中的各种异常;与使用固定奖励权重或启发式规则进行奖励插值不同,Lu 等人提出了 动态奖励加权,同时采用了超体积引导的权重自适应和基于梯度的权重优化,该方法在多目标对齐任务中取得了优异的性能;近期的研究还探索了 多角色强化学习训练,并使用不同的奖励函数为不同角色(例如求解器和评论家)分配不同的奖励,通常这些奖励会使用手动设置的常量进行组合;最近的研究还探索了多角色 RL 训练,为不同的角色分配不同的奖励函数,以鼓励不同的行为和目标,如求解器和评论家。

Structure-based Reward Shaping

与仅依赖个体样本的基于规则的奖励塑造相比,</font color=blue>基于结构的奖励塑造利用列表或集合级别的基线来计算一组候选者的奖励。一种颇具影响力的方法是 GRPO,它使用对同一问题 G 的回答的组平均值作为基线(或诸如留一法或排序之类的变体),并据此为 PPO 式更新构建优势。最近的研究进一步修改了优化目标或信用分配策略,以促进更强的探索并与评估指标更加一致,例如 Pass@K,Walder 和 Karkhanis 对最终奖励进行联合变换,使优化直接等同于集合级别的目标,并提供低方差、无偏的梯度估计;Chen 等人直接针对 Pass@K 推导和分析其优势和有效近似值,将集合级目标分解回单个样本的信用分配。该方向的奖励塑造方法旨在稳定训练并鼓励策略进行更广泛的探索,从而降低过早收敛到次优局部解的风险。

3.2 Policy Optimization

在本小节中,首先对策略梯度目标的数学公式进行技术概述(§ 3.2.1);然后,根据梯度计算过程中奖励的生成方式,将强化学习中的在线策略优化算法分为两类:基于评价器的(§ 3.2.2)和 无评价器的(§ 3.2.3);最后,讨论了近期将在线策略强化学习与离线数据集相结合进行更复杂的训练后(即离策略)优化的研究(§ 3.2.4),以及各种正则化技术,例如熵和知识图谱(§ 3.2.5)。

3.2.1 Policy Gradient Objective

如第 2.1 节所述,强化学习中,LLM 的上下文被视为环境,下一级预测的概率分布被视为策略。对于强化学习系统,系统的目标是找到一个最优策略,使系统产生的预期累积奖励最大化。由于 LLM 中参数数量众多,因此 LLM 的强化学习策略优化算法大多是基于一阶梯度的算法。一般而言,强化学习算法会优化网络参数,使预期奖励最大化。下文将给出强化学习算法中 LLM 梯度计算的通用公式。

- Notations:虽然已经在§2.1中介绍了相关符号,但为了清晰起见这里重新讨论这些定义。令 x∼Dx\sim \mathcal{D}x∼D 为提示词(初始状态 s1=ss_{1}=ss1=s);随机策略 πθ\pi_{\theta}πθ 生成一额序列 y=(a1,…,aT)y=(a_{1},\dots,a_{T})y=(a1,…,aT),将序列长度 yyy 计作 ∣y∣|y|∣y∣,状态定义为 st+1=(x,s≤t)s_{t+1}=(x,s_{\leq t})st+1=(x,s≤t);假设一个序列级的奖励 R(x,y)R(x,y)R(x,y) 可以选择性被分解成 token-level 级奖励 rtr_{t}rt;获取 G≥1G\geq1G≥1 时行为策略 πb\pi_{b}πb 根据提示词得到的响应,或者使用参考策略 πref\pi_{ref}πref(例如,基础、微调或指示模型)进行正则化。

重新审视 § 2.1 中定义的 MDP。在 MDP 中,将当前状态 sss 下的预期累积奖励表示为 V(值)函数:

V(s)=Eat∼πθ(st),st+1∼P(s,a)[∑t=0Tγtr(st,at)∣s0=s]V(s)=\mathbb{E}_{a_{t}\sim\pi_{\theta}(s_{t}),s_{t+1}\sim\mathcal{P}(s,a)}[\sum^{T}_{t=0}\gamma^{t}r(s_{t},a_{t})|s_{0}=s] V(s)=Eat∼πθ(st),st+1∼P(s,a)[t=0∑Tγtr(st,at)∣s0=s]

当前 state-action 对的预期累积奖励表示为 Q(质量)函数:

Q(s,a)=Eat∼πθ(st),st+1∼P(s,a)[∑t=0Tγtr(st,at)∣s0=s,a0=a]Q(s,a)=\mathbb{E}_{a_{t}\sim\pi_{\theta}(s_{t}),s_{t+1}\sim\mathcal{P}(s,a)}[\sum^{T}_{t=0}\gamma^{t}r(s_{t},a_{t})|s_{0}=s,a_{0}=a] Q(s,a)=Eat∼πθ(st),st+1∼P(s,a)[t=0∑Tγtr(st,at)∣s0=s,a0=a]

然后,强化学习的目标可以表述为期望累积奖励的最大化问题。为了优化目标函数,通常使用策略梯度算法进行梯度估计:

∇θJ(θ)=Ex∼D,y∼πθ[∑t=1T∇θπθ(yt∣y<t)Qt]\nabla_{\theta}\mathcal{J}(\theta)=\mathbb{E}_{x\sim\mathcal{D},y\sim\pi_{\theta}}\left[\sum^{T}_{t=1}\nabla_{\theta}\pi_{\theta}(y_{t}|y_{<t})Q_{t}\right] ∇θJ(θ)=Ex∼D,y∼πθ[t=1∑T∇θπθ(yt∣y<t)Qt]

策略梯度的合理性可以通过以下直觉得到证明:遵循策略梯度的算法应该最大化优于平均动作的概率,并最小化低于平均动作的概率。这一概念导致了 AAA(advantage)函数 A(s,a)=Q(s,a)−V(s)A(s,a)=Q(s,a)-V(s)A(s,a)=Q(s,a)−V(s)。优势衡量当前动作相对于现有策略在预期总奖励方面的提升程度。优势可以通过多种方式估算。如果只有完整轨迹的奖励,那么 vanilla REINFORCE 算法直接定义 At=R(x,y)A_{t}=R(x,y)At=R(x,y)。

对于训练 LLM 的情况,普通的策略梯度算法经常会遇到稳定性问题。因此,训练通常使用 PPO 算法。对于包含 NNN 个样本的算法,定义一个具有 PPO 式更新的通用目标函数,如下所示:

J(θ)=Edata[1z∑i=1N∑t=1Timin(wi,t(θ)A^i,t,clip(wi,t(θ),1−ϵlow,1+ϵhigh)A^i,t)]\mathcal{J}(\theta)=\mathbb{E}_{data} \left[ \frac{1}{z} \sum^{N}_{i=1} \sum^{T_{i}}_{t=1} \min \left( w_{i,t}(\theta)\hat{A}_{i,t},\text{clip}(w_{i,t}(\theta),1-\epsilon_{low},1+\epsilon_{high})\hat{A}_{i,t} \right) \right] J(θ)=Edata[z1i=1∑Nt=1∑Timin(wi,t(θ)A^i,t,clip(wi,t(θ),1−ϵlow,1+ϵhigh)A^i,t)]

其中:

- wi,t(θ)w_{i,t}(\theta)wi,t(θ):为重要性比率;

- A^i,t\hat{A}_{i,t}A^i,t:优势(无论是 token-level 还是 sequence-level);

- TiT_{i}Ti:每个样本的 tokens 数或响应数;

- NNN:给定 prompt 下的样本总数;

- ZZZ:标准化因子(例如,total tokens、group size 等);

PPO 算法最初是作为 TRPO 算法的计算高效近似而提出的。当 vanilla 策略梯度方法面临数据效率低下和鲁棒性问题时,PPO 表现出色。与 TRPO 相比 PPO 被证明更易于实现、更具通用性,并且具有更好的样本复杂度。

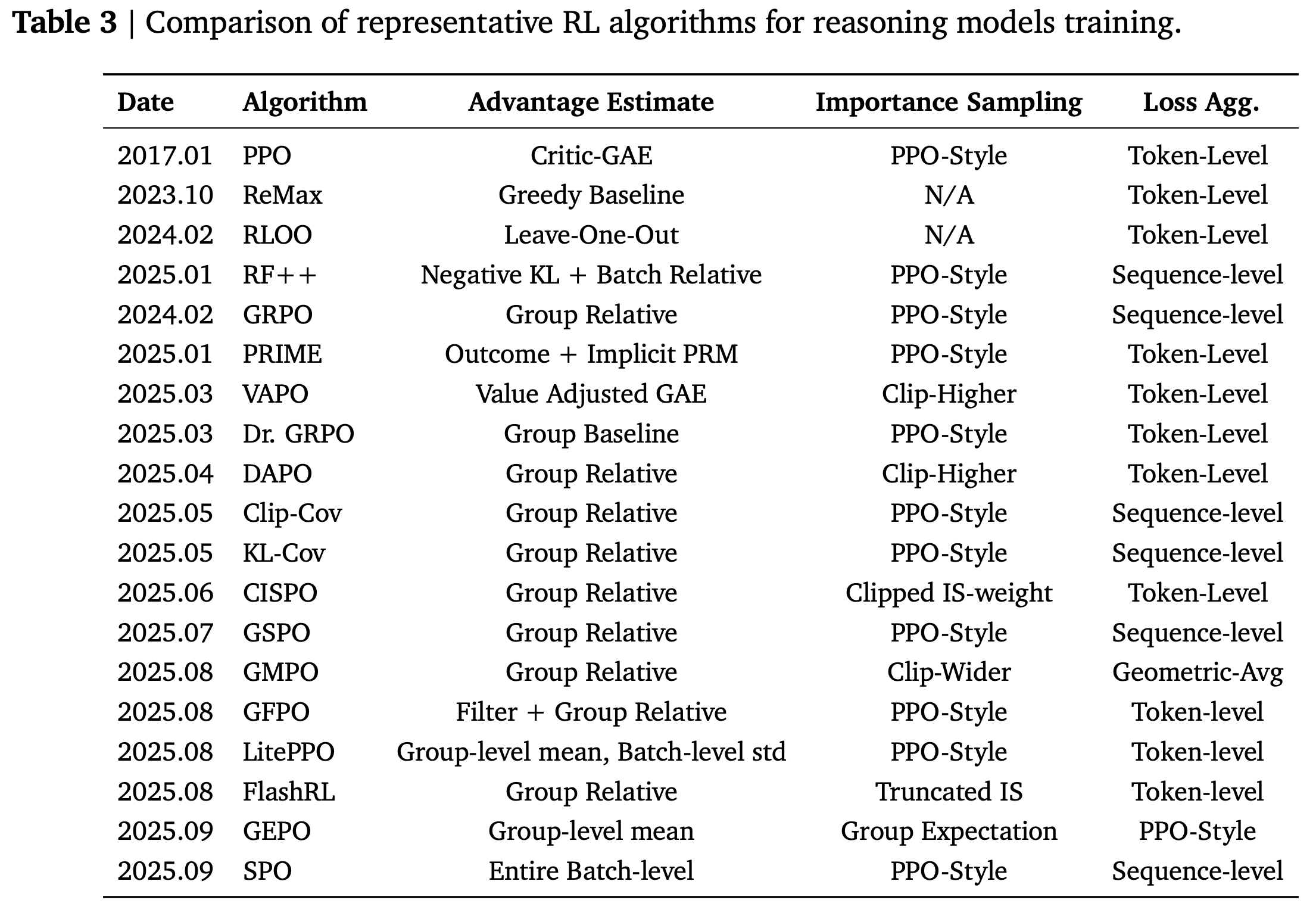

然而,由于 LLM 的复杂和较长的 CoT 特性,精确的目标函数、梯度估计和更新技术可以采用多种不同的形式,如 Table.3 所示。

3.2.2 Critic-based Algorithms

强化学习中首批与 LLM 相关的研究重点是如何有效地将 LLM 策略与外部监督对齐,从而使 LLM 拥有更好的指令遵循能力,同时确保模型有用、诚实且无害。最常见的 LLM 对齐方法是 RLHF。该技术利用人类作为学习算法的评判者,具体步骤如下:首先,由 LLM 生成一系列模型输出,并由人类进行标记以创建数据集;然后,该数据集用于训练奖励模型,以预测人类会更喜欢哪种响应。最后,使用奖励模型和价值函数来训练 LLM,价值函数充当系统中的评判者。训练通常使用 PPO 算法完成。 PPO 算法以以下形式制定目标:

JPPO(θ)=Ex∼D,y∼πθold(⋅∣x)[1∣y∣∑t=1∣y∣min(wt(θ)A^t,clip(wt(θ),1−ϵ,1+ϵ)A^t)]\mathcal{J}_{\text{PPO}}(\theta)=\mathbb{E_{x\sim\mathcal{D}},y\sim\pi_{\theta_{old}}(\cdot|x)} \left[ \frac{1}{|y|} \sum^{|y|}_{t=1} \min \left( w_{t}(\theta)\hat{A}_{t},\text{clip}(w_{t}(\theta),1-\epsilon,1+\epsilon)\hat{A}_{t} \right) \right] JPPO(θ)=Ex∼D,y∼πθold(⋅∣x)∣y∣1t=1∑∣y∣min(wt(θ)A^t,clip(wt(θ),1−ϵ,1+ϵ)A^t)

其中 A^t\hat{A}_{t}A^t 是基于价值模型的优并且满足:

wt(θ)=πθ(yt∣x,y<t)πθold(yt∣x,y<t)w_{t}(\theta)=\frac{\pi_{\theta}(y_{t}|x,y_{<t})}{\pi_{\theta_{old}}(y_{t}|x,y_{<t})} wt(θ)=πθold(yt∣x,y<t)πθ(yt∣x,y<t)

PPO 被提出作为 TRPO 的裁剪替代目标,保留了 TRPO 的保守策略迭代同时不受约束,并且计算复杂度接近传统的策略梯度方法。由于当前策略与采样分布之间的差异,TRPO 中的优势乘以公式 6 中的重要性采样因子 wtw_{t}wt。PPO 优化与 TRPO 目标相同,但消除了信赖域约束。此外,PPO 增加了裁剪机制和 KL 正则化因子,以确保当前策略不会与 rollout 策略 πθold\pi_{\theta_{old}}πθold 偏离太远。

在基于评论家的方法中,强化学习的可扩展性是通过引入评论家模型来实现的。奖励模型在手动标记的生成数据小子集上进行充分训练后,即可将其用于构建评论家模型,从而为绝大多数未标记的生成数据生成更大规模的标记级价值信号供强化学习使用。然而,这些工作需要评论家模型沿着目标 LLM 运行和优化,并产生显著的计算开销。

在 PPO 中,评判模型采用了强化学习文献中的广义优势估计器 GAE。GAE 通常由时间差分误差构成:

δt=rt+γV(yt+1)−V(yt)\delta_{t}=r_{t}+\gamma V(y_{t+1})-V(y_{t}) δt=rt+γV(yt+1)−V(yt)

然后跨时间步进行累积:

A^GAE,t=∑l=tT(γλ)lθt+l\hat{A}_{GAE,t}=\sum^{T}_{l=t}(\gamma\lambda)^{l}\theta_{t+l} A^GAE,t=l=t∑T(γλ)lθt+l

其中 γ\gammaγ 是 MDP 的折扣因子,λ\lambdaλ 是控制偏差-方差权衡的参数。

最近的研究认为,衰减因子对于需要较长 CoT 的复杂推理任务不利,并提出了价值校准的 PPO 和 VAPO,VRPO 提出了在嘈杂的奖励信号下增强批评者模型稳健性的新机制。

此外,基于评价器的算法也已证明,基于规则奖励的蒙特卡罗估计具有稳定的可扩展性。类似的方法已通过PRM的实现应用于固定的外部模型。

引入批评模型的另一种方法是引入隐式 PRM。这种方法也能够为可扩展的强化学习训练提供 token 级别的监督。与 GAE 方法不同,隐式 PRM 和 PRIME 等方法采用了特定的奖励模型公式来直接生成 token 级别的奖励。

3.2.3 Critic-Free Algorithms

除了基于批评家的模型(为模型训练提供 token-level 反馈信号)之外,许多近期研究都表明,response-level 奖励对于使用强化学习的可扩展推理任务而言已经足够。这些无评论家算法对响应中所有使用相同基于规则或模型生成的响应级奖励,证明了它们在各种任务中的有效性。与基于评论家的算法相比,无评论家方法不需要单独的评论家模型,从而显著降低了计算需求并简化了训练。此外,在基于规则的环境中训练 LLM 时,如果任何响应的奖励都可以明确定义,无评论家算法可以避免因评论家模型训练不良而可能出现的 reward hacking 问题。这一特性使得无评论家算法在这种环境下比基于评论家的方法更具可扩展性。

经典的 REINFORCE 算法是最早为强化学习开发的算法之一,具体公式如下:

JREINFORCE(θ)=Ex∼D,{y}∼πold(⋅∣x)[R(x,y)∇θlog(πθ(y∣x))]\mathcal{J}_{\text{REINFORCE}}(\theta)=\mathbb{E}_{x\sim\mathcal{D},\{y\}\sim\pi_{old}(\cdot|x)}[R(x,y)\nabla_{\theta}log(\pi_{\theta}(y|x))] JREINFORCE(θ)=Ex∼D,{y}∼πold(⋅∣x)[R(x,y)∇θlog(πθ(y∣x))]

其中,对于 RLVR 任务,R(x,y)R(x,y)R(x,y) 通常取 ±1 的形式。这种简单的公式 将整个序列视为单个动作,并将响应任务视为老虎机游戏。然而,由于方差较大,原始算法通常存在严重的不稳定性问题。ReMax 为 REINFORCE 引入了一种方差降低机制,并采用了贪婪的基线估计。Ahmadian 等人还引入了 RLOO,这进一步提供了一个无偏基线和更稳定的结果。REINFORCE++ 借鉴了 PPO 和 GRPO 类算法中的裁剪和全局优势归一化等技术,以提供更准确的优势和梯度估计。

强化学习中最流行的无评判方法之一是 GRPO。GRPO 的目标公式如下:

JGRPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)[1G∑i=1G1∣yi∣∑t=1∣yi∣min(wi,t(θ)A^i,t,clip(wi,t(θ),1−ϵ,1+ϵ)A^i,t)]wi,t(θ)=πθ(yi,t∣x,yi,<t)πθold(yi,t∣x,yi,<t),A^i,t=A^t=R(x,yi)−mean({R(x,yi)}i=1G)std({R(x,yi)}i=1G)\begin{aligned} \mathcal{J}_{\text{GRPO}}(\theta) &=\mathbb{E}_{x\sim\mathcal{D},\{y_{i}\}^{G}_{i=1}\sim\pi_{\theta_{old}}(\cdot|x)} \left[ \frac{1}{G}\sum^{G}_{i=1}\frac{1}{|y_{i}|}\sum^{|y_{i}|}_{t=1}\min(w_{i,t}(\theta)\hat{A}_{i,t},\text{clip}(w_{i,t}(\theta),1-\epsilon,1+\epsilon)\hat{A}_{i,t}) \right] \\ & w_{i,t}(\theta)=\frac{\pi_{\theta}(y_{i,t}|x,y_{i,<t})}{\pi_{\theta_{old}}(y_{i,t}|x,y_{i,<t})}, \hat{A}_{i,t}=\hat{A}_{t}=\frac{R(x,y_{i})-\text{mean}(\{R(x,y_{i})\}^{G}_{i=1})}{\text{std}(\{R(x,y_i)\}^{G}_{i=1})} \end{aligned} JGRPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)G1i=1∑G∣yi∣1t=1∑∣yi∣min(wi,t(θ)A^i,t,clip(wi,t(θ),1−ϵ,1+ϵ)A^i,t)wi,t(θ)=πθold(yi,t∣x,yi,<t)πθ(yi,t∣x,yi,<t),A^i,t=A^t=std({R(x,yi)}i=1G)R(x,yi)−mean({R(x,yi)}i=1G)

其中 yiy_{i}yi 中的所有 tokens 都与 A^t\hat{A}_{t}A^t 具有相同的优势。

GRPO 是 PPO 的无批评者修改版,其中整个序列使用相同的优势估计,而不是由批评者提供的 GAE,该估计通过组相对正则化计算得出,比基于二元规则的奖励更优。与 PPO 和 REINFORCE 类方法相比,GRPO 基于组优势计算有效地降低了训练信号的方差,并已被证明可以加快训练过程。其他近期方法,包括 DAPO、CISPO、Dr. GRPO 和 LitePPO,对 GRPO 进行了进一步修改,通过仔细调整采样策略、限幅阈值和损失正则化,进一步增强了强化学习训练过程的稳定性;另一种最近的方法,GSPO,用序列级剪辑取代了逐个 tokens 剪辑的重要性采样率。

除了 REINFORCE 和 GRPO 相关算法外,还有其他无评判方法。VinePPO 通过将学习到的评判方法替换为蒙特卡洛优势估计,对 PPO 进行了修改;CPGD 提出了一种新的策略梯度目标,并结合了漂移正则化机制;K1.5 在基础模型的训练中运用了改进的镜像下降强化学习,成功增强了 LLM 的长上下文推理能力;Lv 等人最近引入了一种统一的策略梯度估计器和混合后训练算法,为 LLM 中强化学习的策略梯度估计提供了统一的框架;SPO 引入了一种无组、单流策略优化,用持久的 KL 自适应值跟踪器和全局优势正则化取代了每组基线,从而实现了比 GRPO 更平滑的收敛和更高的准确率,同时在长期和工具集成的环境中能够高效扩展;HeteroRL 将 rollout 采样与参数学习分离,以实现去中心化的异步训练,并通过 GEPO 降低了延迟引起的 KL 漂移(理论上呈指数级)下的重要性权重方差,即使在严重延迟(例如,1800 秒内性能下降 ❤️%)下也能保持稳定性。

Importance Sampling for Policy Optimization:由于强化学习的 rollout-reward-training 循环,确保部署数据完全遵循当前模型的策略分布在计算上通常非常困难。因此,引入了重要性采样来减少训练中的偏差。强化学习中重要性采样的第一个版本是在 TRPO 中引入的,其中将逐个 token 的重要性比率 wi,tw_{i,t}wi,t 引入到目标函数中。这种方法在最近的工作中被广泛采用,例如 GRPO。由于实际分布比率无法在 CoT 的长上下文中有效计算,因此该方法仅限于逐个 token 的重要性比率。然而,token 级别的重要性采样会给强化学习算法引入另一种偏差,因为给定策略的实际采样分布是根据状态-动作对定义的,而 token 级别的方法仅考虑当前动作。GMPO 通过引入几何平均来寻求缓解,以提高具有极端重要性采样比率的 token 的训练鲁棒性;GSPO 计算了一个序列级重要性采样因子,GSPO添加了一个独特的归一化因子,以确保能够计算出概率比,但这种方法也对实际重要性采样因子进行了有偏估计。一个有希望的新方向是超越标准在线策略梯度方法的理论框架,直接从监督学习理论中推导出本质上是离策略的算法,下一节详细介绍离策略优化。

3.2.4 Off-policy Optimization

在强化学习中,off-policy 方法处理的是学习的策略(目标策略)与生成数据的策略(行为策略)不同的情况。这种核心区别使得 agent 能够学习最佳行动方案,而无需在数据收集过程中遵循该方案。这种灵活性是一个关键优势,通常可以带来比在策略算法更高的采样效率,因为 在策略算法每次更新时都需要直接从当前策略采样新数据。这些方法的核心挑战是 如何校正行为策略和目标策略之间的分布偏移,通常使用带有加权目标函数的重要性采样来解决:

Lpolicy(θ)=−Ex∼D,y∼πb(y∣x)[πθ(y∣x)πb(y∣x)⋅r(x,y)]\mathcal{L}_{\text{policy}}(\theta)= -\mathbb{E}_{x\sim\mathcal{D},y\sim\pi_{b}(y|x)} \left[ \frac{\pi_{\theta}(y|x)}{\pi_{b}(y|x)}\cdot r(x,y) \right] Lpolicy(θ)=−Ex∼D,y∼πb(y∣x)[πb(y∣x)πθ(y∣x)⋅r(x,y)]

其中分数 πθ(y∣x)πb(y∣x)\frac{\pi_{\theta}(y|x)}{\pi_{b}(y|x)}πb(y∣x)πθ(y∣x) 表示目标策略 πθ\pi_{\theta}πθ 和行为策略 πb\pi_{b}πb 之间的重要性权重。

在实际的大规模模型训练中,离线策略学习通常以不同的形式表现出来。近期的研究大致可以分为三个方面:

- 训练-推理精度差异,即模型训练精度较高,但部署精度较低,导致目标策略和行为策略之间存在差距;

- 异步经验回放机制,通过在学习过程中重用过去的轨迹来提高效率和稳定性;

- 更广泛的离线策略优化方法,包括优化器级改进、数据级离线学习以及将监督微调与强化学习相结合的混合方法;

Training-Inference Precision Discrepancy

一种值得注意的离线策略场景源于训练模型和推理模型之间参数精度的差异,采用不同的训练和推理框架(例如,vLLM 与 FSDP),或使用模型量化来加速推理,这些都是 LLM 推理中不确定性的表现。通常的做法是使用高精度参数训练模型,然后部署具有低精度参数的量化版本。这就造成了一种差异:部署的低精度模型充当行为策略,生成真实世界的交互数据,而高精度模型仍然是训练期间更新的目标策略。虽然这种不匹配会导致离线策略学习问题,但研究表明, 量化导致的策略发散通常很小。因此,这种差异可以通过简单的校正技术(例如截断重要性采样 truncated importance sampling, TIS)有效地管理,从而实现稳定的训练,同时保留加速推理的优势。

Asynchronous Off-Policy Training

对于LLM,异步训练与离线策略强化学习自然契合。许多参与者同时生成轨迹并将其附加到共享的重放缓冲区,而集中式学习器则从该缓冲区中采样小批量数据以更新目标策略。基于此观点,一些近期方法有意重用过去的轨迹,以提高效率和稳定性。其中一个例子是回顾性重放 Retrospective Replay ,它通过选择性地重放早期的推理轨迹来指导当前的策略更新,从而增强了LLM推理的探索能力;EFRame 采用 exploration-filter-replay 机制,将过滤后的响应与新的部署交织在一起,以促进更深入的推理;在 coding 领域,可能性和通过率优先的经验重放 (PPER) 对此进行了更进一步的改进,它通过优先考虑缓冲区中高价值的代码样本,从而实现更稳定的优化;扩展到多模态交互,ARPO 将重放应用于 GUI 代理,其中成功的轨迹被重用,以在稀疏奖励下提供可靠的学习信号;RLEP 使用经验缓冲区来锚定探索,该缓冲区包含先前运行中已验证的成功轨迹,并与新的 rollout 相结合,以平衡可靠性和发现。总而言之,这些方法说明了重放缓冲区如何成为基于 LLM 的代理的现代异步离策略训练的基石。

Off-Policy Optimization

微调 LLM 的最新进展探索了超越传统在线策略强化学习 (on-policy RL) 的复杂优化策略。这些方法大致分为 离线策略优化 和 混合策略优化,旨在通过创造性地利用来自不同来源的数据来提高样本效率、训练稳定性和整体性能。下文将介绍这一主题:

- Optimizer-Level Off-Policy Methods:这些方法专注于改进优化过程本身,强调策略更新的稳定性和效率。例如,

SPO引入了一种软策略优化方法,可实现稳定的在线离策略强化学习;而TOPR提出了一种渐进式离策略强化学习 (REINFORCE) 算法,以提高稳定性和效率;ReMix进一步强调了这一点,它专注于有效利用离策略数据,最大限度地提高可用信息的效用; - Data-Level Off-Policy Methods:一类离线策略算法 完全基于大规模外部离线数据进行学习。例如, Dynamic Fine-Tuning (

DFT) 框架将 SFT 损失推广到强化学习公式,并引入了停止梯度机制,从而能够像 SFT 一样在离线数据上进行训练,同时提升性能; Intuitive Fine-Tuning (IFT) 同样基于离线数据,它添加了一个时间残差连接,融合了 SFT 和 RLHF 目标,并显式地建模和优化当前 token 对所有后代的影响;另一种相关方法是 Direct Preference Optimization (DPO),它直接根据偏好数据优化策略。这些方法共同代表了强化学习向更加以数据为中心的方向发展,使得能够从海量多样化的离线数据源开发复杂的策略; - Mix-Policy Methods:除了更高效地重用历史数据之外,混合策略优化代表着另一个重要趋势,它结合了 SFT 和 RL 的优势。这种混合方法利用了 SFT 在专家数据上的稳定性,同时使用 RL 来优化特定的奖励函数,并通过两种主要方式整合监督数据。一种策略是在损失函数层面,将 SFT 和 RL 目标直接结合在损失函数中,如

UFT、SRFT、LUFFY、RED和ReLIFT等方法都通过创建统一或单阶段训练流程来体现这一点,这些流程可以同时从专家演示和强化学习反馈中学习;第二种策略在数据层面运作,使用专家数据来构建生成过程本身,高质量数据充当前缀或锚点来指导模型的探索,如BREAD从专家锚点生成分支 rollout,Prefix-RFT通过前缀采样融合了不同的训练方案。通过在损失或数据层面混合策略,这些方法可以防止 reward hacking 并确保模型保留来自 SFT 的知识,从而产生更强大、更强大的复杂推理模型;

3.2.5 Regularization Objetives

如前文所述,确保稳定性并防止灾难性的策略漂移至关重要。尤其对于长视域训练,KL 正则化和熵正则化等技术被广泛应用。

KL Regularization

KL 散度正则化的作用是该领域一个备受争议的话题。在大多数研究中,KL 正则化应用于:

- 当前策略 πθ\pi_{\theta}πθ 和参考策略 πref\pi_{ref}πref;

- 当前策略 πref\pi_{ref}πref 和旧策略 πold\pi_{old}πold;

LKL=β∑t=1∣y∣KL(πθ(⋅∣yt)∣∣πref/old(⋅∣yt))\mathcal{L}_{KL}=\beta\sum^{|y|}_{t=1}KL(\pi_{\theta}(\cdot|y_{t})||\pi_{ref/old}(\cdot|y_{t})) LKL=βt=1∑∣y∣KL(πθ(⋅∣yt)∣∣πref/old(⋅∣yt))

- 对于前者,这是 RLHF 中常用的技术,最初是为了防止模型被破坏性地更新而引入的。先前的研究认为,加入 KL 惩罚对于维持稳定性和避免在数千个训练步骤中出现熵崩溃至关重要。为了降低 KL 项过度限制进度的风险,Liu 等人将此方法与定期参考策略重置相结合,其中参考模型会更新为训练策略的最新快照;为了同时保持知识并增强推理能力,Wang 等人对低熵 tokens 应用更强的 KL 正则化,对高熵 tokens 应用较弱的正则化。然而,在使用 LLM 进行推理的 RL 背景下,这比标准 RLHF 更具挑战性,需要重新考虑这种 KL 正则化的必要性。最近,许多研究表明,该策略有望在训练期间自由探索,因此可能会与其初始化产生很大分歧以发现新的 CoT 结构,从而使 KL 约束成为不必要的限制。所以,大多数其他近期研究主张完全取消 KL 惩罚,以简化实现、降低内存成本并实现更具可扩展性的 GRPO;

- 对于后一种情况,它可以替代策略损失的裁剪形式。Zhang 等人讨论了正向 KL、反向 KL、正则化 KL 和正则化形式之间的区别。Cui 等人、Lyu 等人和 Team 也采用了这种方法,展示了其在不同强化学习训练规模中的潜力。然而,其更深层次的机制及其对可扩展强化学习的意义仍在探索中;

Entropy Regularization

在强化学习文献中,保留策略熵被广泛认为是许多算法的关键方面。为此,策略熵可以通过正则化技术进行主动控制。

Lent=α∑t=1∣y∣H[πθ(⋅∣yt)]=α∑t=1∣y∣∑v=1∣V∣πθ(ytv∣yt)logπθ(ytv∣yt)\mathcal{L}_{ent}=\alpha\sum^{|y|}_{t=1}H[\pi_{\theta}(\cdot|y_{t})]=\alpha \sum^{|y|}_{t=1} \sum^{|V|}_{v=1} \pi_{\theta}(y^{v}_{t}|y_{t})log\pi_{\theta}(y^{v}_{t}|y_{t}) Lent=αt=1∑∣y∣H[πθ(⋅∣yt)]=αt=1∑∣y∣v=1∑∣V∣πθ(ytv∣yt)logπθ(ytv∣yt)

然而,在强化学习中,LLM 直接应用熵正则化既不常见,也不太有效。在损失函数中使用显式熵正则化项仍然是一个争论点。一些人认为使用标准系数或有针对性的损失函数是有益的,但另一些人则反对这样做,认为这会导致不稳定甚至训练崩溃,尤其是在奖励稀疏的情况下。许多研究表明,在不进行干预的情况下会出现熵崩溃现象,这会阻碍训练过程中有效的策略探索。为了解决这个问题,He 等人动态调整熵损失的系数;Yu 等人采用 clip-higher 技术将更多低概率 token 纳入策略更新;Wang 等人直接在 20% 的高熵 token 上进行训练;Cheng 等人和 Chen 等人通过将熵纳入优势计算来强调熵;除了这些明确最大化熵的技术之外,Cui 等人对熵动力学的潜在机制提供了理论解释,将动作的输出概率与其优势之间的协方差确定为熵的 “driver”。基于这一见解,提出了 Clip-Cov 和 KL-Cov,通过选择性地约束一小部分表现出极高协方差的 token 来调节熵。

Length Penalty

LRMs 在复杂任务上取得的最新成功验证了长 CoT 推理的有效性。然而,较长的推理轨迹会导致更高的推理成本。为了平衡推理预算和性能,许多工作试图在保持模型性能的同时降低推理成本。例如,Aggarwal 和 Welleck 通过 确保遵守用户指定的长度约束来控制推理长度;Yuan 和 Luo 为优化目标设计了相对长度正则化和精度保持约束;Xiang 和 Liu 等人建议 根据问题难度应用自适应长度惩罚来保持模型能力。

3.3 Sampling Strategy

与静态数据集不同,强化学习依赖于主动策划的部署,其中关于 采样内容和采样方式的决策直接影响学习效率、稳定性以及习得推理行为的质量。有效的采样策略不仅能确保训练信号的多样性和信息量,还能使学习过程与预期的奖励结构和策略目标保持一致。在本小节中,将概述动态和结构化采样(§3.3.1)方面的最新进展,以及进一步优化采样和策略改进的超参数调整技术(§3.3.2)。

3.3.1 Dynamic and Structured Sampling

采样已成为推理 LLM 的 RL 微调中的一流杠杆,它是一种高效且自适应的机制,可以最大限度地提高数据利用率,减少浪费的计算,并提高训练效果,或者作为 LLM 以结构化格式进行采样的控制和指导。

Dynamic Sampling

动态采样会根据在线学习信号(例如成功率、优势、不确定性或估计难度)调整要推出的提示的选择以及分配给每个提示的计算预算。其主要目标是将计算集中在信息丰富的示例上,同时避免饱和或无效的示例。现有方法通常分为两类:

- Efficiency-oriented Sampling:一些研究 使用在线过滤技术将训练集中在中等难度的问题上,以确保训练的有效性和效率。一个代表性的设计是

PRIME,它应用在线过滤器来丢弃过易或过难的问题;另一个例子是DAPO,它对 rollout 饱和(全部正确)或退化(全部错误)的提示进行过度采样和过滤,然后重复采样,直到每个小批量都包含具有非零优势的提示,并专注于中等难度的情况以保持信息梯度。在此基础上,优先方案通过与失败率成比例的采样,将 rollout 预算分配给掌握不足的项目,如 p(i)∝(1−si)p(i)\propto(1-s_{i})p(i)∝(1−si) 规则。课程学习方法在多个尺度上运作:类别级选择使用非平稳 bandits;E2H遵循从易到难的调度,并保证小模型的收敛性。高效方法包括预推出选择以跳过无用提示,以及基于难度的在线选择和推出重放;POLARIS通过离线难度估计、按模型尺度构建 “mirror-J” 分布、持续移除已掌握的条目以及应用批量信息替换来形式化地实现这一点。为了进一步提升效率,近期的研究进展包括使用轻量级控制器进行自适应采样,无需修改算法;同时,采用随机重组的经验回放通过均衡利用率来减少方差;增强的优先级方法则根据经验池特征动态调整优先级权重。此外,通过使用专家数据构建生成过程,也可以提高采样效率:使用高质量的演示作为前缀锚点,使探索偏向搜索空间中具有潜力的区域。该领域已从均匀采样转向模型感知策略,该策略结合了项目、类别和难度级别的选择,以便在每次部署中获得更强大的学习信号; - Exploration-oriented Sampling:还有其他一些研究旨在 使用动态rollout进行探索。

ARPO提出实现熵引导的rollout,以确保较高的不确定性,从而使模型能够调用外部工具,从而提高多样性;DARS提出了一种 rollout 机制,可以为不同难度的问题动态分配样本数量;Zhou 提出了RuscaRL,通过在rollout过程中为策略提供不同的规则来增强探索能力;G2RPO-A不会丢弃所有错误的问题,而是在思考过程中添加指导,以便为难题生成正确的样本;Li 等人利用最新的 kkk 个检查点来生成 kkk 个响应,以防止训练期间的遗忘;

Structured Sampling

结构化采样不仅控制采样内容,还控制推理轨迹的拓扑结构,使生成、信用分配和计算重用与问题求解的底层结构保持一致。通过将部署组织为树状结构或通过共享和分段前缀,这些方法能够实现节点级奖励,提高部分计算(例如键值缓存)的重用,并在内存和预算受限的情况下提高采样效率,此处重点介绍两种代表性方法:

- Search-driven Tree Rollouts:其他研究利用蒙特卡洛树搜索 (MCTS) 生成树形响应,其经典阶段包括初始化、选择、扩展和反向传播,将单个推理视为一棵树而非一条链,并在节点级别分配奖励,从而可以生成更密集/细粒度的过程信号;Hou 等人提出了

TreeRL,这是一种基于策略的树形搜索框架,其性能优于传统的思维链式强化学习 (ChainRL),同时通过更高效的搜索策略大幅降低了计算开销;ToTRL在合成谜题环境中引入了一种思维树引导的训练范式,使其能够泛化到数学推理等分布外的任务;Yang 等人将 MCTS 集成到训练流程中,以生成基于规则的细粒度过程奖励,从而提高策略优化中奖励信号的粒度和保真度; - Shared-prefix or Segment-wise Schemes:虽然这些树搜索方法丰富了探索并提供了细粒度的奖励,但它们的采样效率仍然是一个限制。一些工作设计了分段/共享前缀采样来提高生成效率。

SPO、TreeRPO、TreeRL、FR3E和ARPO从先前生成的前缀开始进行额外采样;TreePO实现了一种分段树采样算法,该算法减轻了键值缓存的负担,减少了GPU的训练时间,并提高了采样效率;

3.3.2 Sampling Hyper-parameters

本小节总结了近期研究中采样的超参数调整策略。有效的强化学习训练需要在几个相互竞争的目标之间取得微妙的平衡,近期文献主要关注两个主要方面的技术:

- 管理探索与利用之间的权衡,以确保模型发现并改进有效的推理路径;

- 有效地管理序列长度,以平衡推理深度和计算成本;

Exploration and Exploitation Dynamics

一个核心挑战是如何平衡探索(发现新颖的推理策略)和利用(改进高回报解决方案)。实现这一目标的 主要杠杆是温度、熵正则化和 PPO 的裁剪机制。对于温度,策略差异很大。一些研究提出了一种动态方法,例如分阶段增加温度(例如,对于 4B 模型温度从 1.40 → 1.45 → 1.50;7B 模型温度从 0.7 → 1.0 → 1.1 升至 1.0),以随着训练的进展逐渐扩大轨迹多样性,或者使用调度程序动态调整温度以维持稳定的熵水平。一种更具规范性的方法建议调整训练温度,使扩展后的熵保持在 0.3 左右,这被发现可以达到最佳平衡。其他研究则只是简单地主张使用较高的固定温度(例如 1.0 或 1.2)来鼓励初始探索,同时指出仅靠这个温度不足以防止长期熵下降。

Length Budgeting and Sequence Management

几乎所有研究都在努力控制生成响应的长度,以平衡性能和成本。最流行的策略是分阶段延长上下文。这涉及从短上下文窗口(例如 8 毫秒)开始强化学习,然后在后续阶段逐渐将其增加到 16 k、24 k 或 32 k。初始短上下文阶段被认为至关重要,因为它迫使模型学习更简洁、更高效的标记推理模式。除了在非常长的上下文上进行训练之外,还有一种替代方案,即在推理时应用推理时间长度外推技术(例如 Yarn),使在较短序列上训练的模型能够推广到较长的序列。对于超出长度预算的响应的处理,目前尚无共识。一些研究会在响应接近最大长度时应用一个软线性惩罚,或者直接在奖励函数中应用一个可调惩罚 α\alphaα。一种更细致、与阶段相关的策略是,当长度预算较短(8k - 16k)时过滤(mask the loss of)过长的样本,而当预算较长(32 k)时对其进行惩罚,因为过滤在非常长的上下文中可能会变得有害。

在这些研究中,有效的超参数调整体现在探索(温度、熵目标、裁剪)、效率(分阶段长度课程)和序列管理(超长过滤器、惩罚或推理时间外推)的联合调整。这些方法可直接应用于大多数 GRPO/PPO 风格的 LLM 强化学习流程。

4. Foundational Problems

回顾了 LLM 强化学习流程的关键组成部分后,现在将转向讨论该领域中几个核心且通常尚未解决的基础问题。在本节中,将阐明核心问题,提出对比观点,并总结每个未解决问题的最新进展。具体将讨论一些挑战,例如 §4.1 中强化学习的基本作用(sharpening vs. discovery)、§4.2 中强化学习与 SFT 之间的界限(generalization vs. memorization)、§4.3 中模型先验的选择(weak models vs. strong models)、§4.4 中训练算法的有效性(tricks vs. traps)以及 §4.5 中奖励信号的粒度(process vs. outcome)。通过重点介绍这些未解决的问题,旨在理清当前的研究形势,并推动对 LRM 强化学习基础理论的进一步研究。

4.1 RL’s Role: Sharpening or Discovery

首先总结一下关于强化学习作用的两种主流观点:锐化(Sharpening)和 探索(Discovery)。这两种观点似乎截然相反。锐化观点认为,强化学习不会创造真正新颖的模式,而是对基础模型中已有的正确响应进行改进和重新加权。相比之下,探索观点则认为,强化学习能够发现基础模型在预训练过程中无法获得、也无法通过重复采样生成的新模式。

可以通过多种理论视角来理解 Shapening 和 Discovery 视角之间的差异。首先,从 KL 散度优化的角度来看,SFT 通常优化正向 KL 散度 DKL(pdata∣∣pmodel)D_{KL}(p_{data}||p_{model})DKL(pdata∣∣pmodel),表现出模式覆盖行为:模型试图覆盖数据分布中的所有模式;相比之下,强化学习方法优化反向 KL 散度 DKL(pdata∣∣pmodel)D_{KL}(p_{data}||p_{model})DKL(pdata∣∣pmodel),表现出模式搜寻行为:将概率质量集中在高奖励区域。最近的理论进展进一步丰富了这一理解。

Xiao 等人证明,RLHF 可以被视为对偏好数据的隐式模仿学习,从而在基于强化学习的对齐和行为克隆之间建立了深层联系;Sun 将 SFT 本身定义为逆向强化学习的一种形式,揭示即使是监督方法也隐含地涉及奖励建模。这些观点表明,关于Sharpening 与 Discovery 的争论可能探讨的是统一学习过程的不同方面:强化学习的模式搜索特性提供了一种锐化机制,而隐含的奖励学习和组合能力则可以通过扩展训练来实现发现。

- 最初,

DeepSeek-R1通过 RLVR 展示了颇具前景的 “Aha” 行为,启发了TinyZero等轻量级复刻模型,它们通过简化的训练方案和最少的代码报告了类似的现象。随后,特定领域的改编也随之而来,包括Logic-RL,它展示了基于规则的强化学习,能够培养反思和验证能力,并迁移到数学推理; - 然而,

Limit-of-RLVR提出了一种以锐化为导向的反驳:Pass@K评估表明,RL 增强了Pass@1的性能,但在广泛采样时往往表现不佳large-k Pass@K。这表明 RL 主要缩小了搜索空间,而不是发现根本上新颖的解决方案轨迹。同时的争论质疑观察到的 “Aha” 行为是否真正由 RL 引起,还是仅仅是预训练期间已经嵌入的潜在能力。机制分析进一步认为,RL 收益通常来自熵塑造或奖励 agent。例如,high-entropy “forking” tokens 似乎主导了性能提升;最大化模型置信度 (RENT) 和 TTRL 可以在不依赖外部奖励的情况下增强推理能力;甚至虚假或随机的奖励信号也能改变 Qwen 模型,这意味着强化学习通常会展现预先训练好的推理特征,而不是学习全新的特征。一项平行的研究将测试时搜索和计算框架化为元强化学习问题,提出 MRT 来增强进度信号,并比仅关注结果的强化学习更好地扩展 “thinking time” 。数据效率研究也表明,即使是像单样本强化学习 (RLVR) 这样的极端情况也能显著提升数学推理能力,这再次与激发潜在能力的锐化观点相一致。作为对这些观点的补充,一项关于强化学习虚拟现实(RLVR)探索的系统研究将Pass@K形式化为探索边界的度量,并揭示了在训练、实例和token级别之间微妙的熵-性能权衡,从而将锐化视角置于统一的分析框架中。最近,Shenfeld 等人提出了“强化学习剃刀”原理,证明在线强化学习比监督微调更能更好地保留先验知识。他们表明,强化学习的优势源于其在适应新任务的同时保持现有能力的能力,而非发现全新的行为; - 然而,最近有几项研究重新开启了这一领域的探索。

ProRL报告称,足够长时间且稳定的强化学习可以扩展基础模型的推理边界,从而提升 Pass@1 和 Pass@K 的性能。ProRL v2提供了持续扩展的证据,它融合了工程学的进步,并展现出更强大的结果。同时,对Pass@K指标的批评导致了CoT-Pass@k等替代方案的出现,其理论论据支持这一观点:RLVR 隐性地激励正确的推理路径,而不仅仅是奖励幸运的终点。一些互补方法可以通过运用自我对弈问题合成来保持熵值并增强Pass@K,或通过新的策略目标直接优化Pass@K,从而维持 RLVR 的优势。Yuan 等人进一步为发现论提供了令人信服的证据,他们证明了 LLM 可以通过组合现有能力来学习强化学习中的新技能,这表明强化学习能够催生超越现有模式简单细化的行为。

近期的理论进展揭示了不同对齐范式之间更深层次的联系,或许可以调和“ Sharpening 和 Discovery 之间明显的二分法。Xiao 等人的研究表明,RLHF 隐式地执行了模仿学习;Sun 则表明 SFT 可以理解为逆 RL。这些见解表明,监督学习和 RL 方法都在分布匹配和奖励优化的共同理论框架内运行,关键区别不在于这些方法能否发现新的能力,而在于它们如何在探索和利用之间进行权衡。强化学习中逆向知识学习的模式搜索特性提供了一种高效收敛到高性能区域的机制(Sharpening),而隐式奖励学习和顺序决策方面则能够在充足的训练时间和适当的正则化条件下将现有能力组合成新的行为(Discovery)。这种统一的观点表明,争论应该从“Sharpening or Discoveryt” 转向理解每种现象占主导地位的条件。

4.2. RL vs. SFT: Generalize or Memorize

在本小节中,将讨论强化学习和监督微调的作用,重点关注泛化和记忆之间的相互作用。后训练 LLM 主要有两种方法:SFT 和 RL。当前的争论主要集中在两个问题上:

- 哪种方法更能实现分布外的泛化?

- 通过 SFT 进行行为克隆是否会对泛化能力设定上限?

近年来,大量研究关注这一主题。值得注意的是,Chu 等人在文本和视觉环境中给出了直接结论,指出 “SFT memorizes,RL generalizes”。

最近的两项研究进一步强化了这种对比。Huan 等人发现,强化学习在数学任务上 (RL on-math) 往往会保持甚至提高非数学任务和指令遵循方面的表现,而监督微调在数学方面 (SFT-on-math) 往往会导致负迁移和灾难性遗忘。他们基于潜在空间主成分分析 (PCA) 和标记分布 (KL) 测量的诊断分析,以及 Mukherjee 等人的研究,都表明 SFT 会导致表征和输出漂移(memorization),而强化学习则能更好地保留基域结构(generalization)。Zhou 等人也进行了补充性研究,剖析了五种数学问题解决的训练路径,并观察到:

- 在数学文本上进行持续预训练仅能提供适度的迁移;

- 传统的短 CoT SFT 经常损害泛化能力;

- 长 CoT SFT 和基于规则的强化学习(带有格式/正确性奖励)扩展了推理深度和自我反思能力,从而提升了更广泛的推理能力;

此外,强化学习之前的 SFT 预热可以稳定策略并进一步促进跨领域迁移。这些结果表明,基于策略的目标函数和更长的自我反思轨迹能够促进可迁移模式的生成,这些模式在分布变化的情况下仍能保持稳健;而短 CoT SFT 往往会过拟合到表面模式,这反映了经典的强化学习与 SFT 在泛化和记忆性之间的分歧。关于这个主题主要有三个研究方向:

- RL demonstrates superior generalization:Chu 等人表明,强化学习在分布外 (OOD) 性能方面优于 SFT,而 SFT 倾向于记忆 GeneralPoints 和 V-IRL 任务中的数据。先前的研究也表明,RLHF,尤其是在分布偏移较大的情况下,能够比 SFT 更有效地泛化,尽管这可能会以降低输出多样性为代价。此外,

DeepSeek-R1证明,纯强化学习训练可以自发地产生高级推理行为,例如反思和验证; - RL is not a panacea:强化学习的泛化能力在很大程度上受初始数据分布和验证奖励设计的影响。Jin 等人发现,强化学习可以部分缓解过拟合;然而,在严重过拟合或分布突变的情况下,它仍然无效,正如在 OOD “24 points” 和频域分析任务中观察到的那样。强化学习的主要价值在于它能够促进 “proper leanring” 。当应用适当的重新加权、信赖域约束或动态重新缩放时,SFT 可以显著提高泛化能力,并且通常可以为后续的强化学习更好地准备模型。在实践中,SFT 可以作为稀疏奖励强化学习的下限。

- Unified or alternating paradigms of SFT and RL:Yan 等人提出了一个框架,通过整合离策略推理轨迹来增强 RLVR;Liu 等人将 SFT 和 RL 集成到一个单阶段目标中,从理论上克服了长视域样本复杂度的瓶颈,并通过经验证明了其优于单独使用任何一种方法;Fu 等人提出了一种使用熵感知权重的示范模仿 (SFT) 和策略改进 (RL) 的联合单阶段集成方法;Zhang 等人提供了理论证据表明,在涉及小模型、高难度或稀疏成功轨迹的场景中,传统的从 SFT 到 RL 的两阶段方法可能完全失败。他们通过采用从专家锚点开始的分支展开机制来解决这个问题,从而有效地连接两个阶段。Ma 等人发现 RL 擅长巩固和增强现有能力,而 SFT 更擅长引入新知识或新模型能力;

然而,仍有几个挑战尚未解决。一个主要问题是 区分真正的问题解决能力和仅仅记住答案,同时避免数据污染。目前仍然缺乏标准化、可重复的分布外基准。此外,强化学习训练对初始数据分布高度敏感;当 SFT 引起显著的表征漂移时,强化学习的恢复和泛化能力有限。为了应对这些挑战,需要推广诸如 UFT、SRFT 和 Interleaved 等框架,这些框架将 SFT 与强化学习的整合机械化,从而将新知识融入其中,增强扩展性和鲁棒性。Lv 等人还探索了自动调度策略,以确定何时在 SFT 和 RL 之间切换以及如何有效地分配它们的比例。

总而言之,强化学习在可验证任务和分布显著变化的情况下往往能够实现 “真正的泛化”,但它并非万能药。改进的SFT可以帮助弥补泛化方面剩余的差距。因此,最佳实践正在向统一或交替的混合范式靠拢,以结合两种方法的优势。

4.3 Model Prior: Weak and Strong

最近的研究表明,强化学习如今能够在广泛的任务中表现出色,只要结合足够强大的模型先验和可验证的奖励信号,从而将主要瓶颈从规模化转移到环境和评估协议的设计上。从这个角度来看,强化学习的主要作用是重新磨练预训练期间已经编码的潜在能力,而不是从头开始生成新的能力。

在本小节中,将研究这种依赖关系的三个关键维度:将 RL 应用于基础模型与指令调整模型的比较优势、不同模型系列(特别是在 Qwen 和 Llama 架构之间)之间 RL 响应能力的巨大差异,以及 可以增强弱先验和强先验模型的 RL 结果的新兴策略,包括中期训练和设计。

Base vs. Instruct Models

DeepSeek-R1 首先引入了关于将强化学习应用于基础模型或指令调优模型的讨论,并引入了两种可行的后训练范式:

R1-Zero:将大规模基于规则的强化学习直接应用于基础模型,从而产生涌现的长视域推理;R1:包含一个简短的冷启动 SFT 阶段,用于在强化学习之前稳定输出格式和可读性;

Open-Reasoner-Zero 独立证明了应用基础 Qwen 模型的极简训练方案足以同时扩展响应长度和基准准确率,这与 R1-Zero 的训练动态相似。这些发现表明,基础模型先验比指令模型更适合强化学习,通常产生的改进轨迹比从高度一致的指令模型开始时观察到的轨迹更平滑,因为在指令模型中,根深蒂固的格式和服从先验可能会干扰奖励塑造。

Model Family Difference

近期研究强调,基础模型的选择对强化学习结果至关重要。例如,One-shot RLVR 表明,引入一个精心挑选的数学示例可以使 Qwen2.5-Math-1.5B 的 MATH500 准确率提高一倍以上,并在多个基准测试中实现显著的平均提升。然而,Spurious Rewards 揭示了一个截然相反的模式:即使在随机或虚假的奖励信号下,Qwen 系列模型也能获得显著的提升,而 Llama 和 OLMo 模型通常不会如此。这种差异凸显了模型先验的影响,并强调了在不同先验模型之间验证强化学习声明的重要性。观察到的不对称性表明,在训练前接触推理模式(例如,数学或代码 CoT)存在差异。 Qwen 模型已广泛接触此类分布,往往更加“RL-friendly”,而同类的 Llama 模型在接受相同的 RLVR 程序时往往会表现出脆弱性。

Mid-training Solutions

在实践中,研究人员发现,这种性能差距可以通过中期训练或退火训练策略来解决。在最近的 LLM 研究中,退火表示后期预训练阶段,在此期间学习率会衰减,同时重新加权数据分布以强调较小的高质量来源,例如代码、数学和精选的 QA 语料库。Llama 3 明确将此阶段命名为退火数据,描述了数据混合的转变和线性 LR 衰减到零。他们进一步报告说,在此阶段注入少量高质量数学和代码可显着改善面向推理的基准;MiniCPM 阐明了一个类似的两阶段课程,称为稳定-衰减。在衰减(annealing)阶段,他们将 SFT 风格的高质量知识和技能数据与标准预训练语料库交织在一起,观察到比仅在预训练后应用相同 SFT 更大的改进;OLMo 2 公开了一种现代的中期训练方法:预训练被分成一个漫长的、以网络为主的阶段,接着是一个较短的中期训练阶段,该阶段对高质量和特定领域的来源尤其是数学进行上采样,同时将 LR 线性衰减到零。更一般地说,当代的中期训练策略将学习率计划和数据分发开关的联合设计作为首要关注点。例如,Parmar 等人表明,最佳持续预训练需要:

- 一个双分布计划,在后期阶段强调目标能力;

- 一个退火的、非重新预热的 LR 计划,其中分布切换的时机由 LR 分数而不是固定的 token 数量决定;

最近的一项系统研究扩展了这项工作,表明一个稳定然后衰减的中期训练计划,注入高质量的数学和思路链式问答语料库,使 Llama 模型在基于 RL 的微调下具有更高的可扩展性,从而有效缩小了与 Qwen 模型的性能差距。总之,这些发现为弱先验模型族提供了一个实用的方案:在训练中期强化推理先验,然后应用 RLVR。

Strong Model Improvements

虽然许多重复实验都支持基础模型,但越来越多的证据表明,如果课程、验证和长度控制经过精心设计,强化学习可以进一步改进强大的蒸馏/指导模型。例如,AceReason-Nemotron 报告称,在蒸馏的 Qwen 模型上,先进行数学运算再进行纯代码强化学习取得了持续的收益,分析显示 Pass@1 和 Pass@K 方案均有所改进。这些发现对过于简单的 “base-only” 叙述进行了细微的调整:在适当的约束条件下,指导/蒸馏模型也能从中受益,但优化难度较低。一条平行线评估推理模型的可控性。MathIF 强调了一种系统性矛盾:扩展推理能力通常会损害指令遵循性能,尤其是在长篇输出的情况下。补充证据表明,明确的CoT提示可能会降低指令遵循的准确性,并提出了选择性推理。这些研究共同促进了强化学习中多目标训练(格式、简洁性、服从性)以及正确性/可验证性的提升。

可以从三个角度总结模型先验如何从根本上塑造 LLM 训练中的 RL 结果:

- 作为 RL 起点,基础模型始终优于指令调整模型,其中 DeepSeek-R1 和 Open-Reasoner-Zero 展示了从最少配方中产生的推理;

- 模型家族表现出不对称的 RL 响应能力:Qwen 模型即使在虚假奖励下也能显示出收益,而 Llama/OLMo 模型需要通过退火学习率和高质量数学/代码数据注入进行仔细的中期训练;

- 强大的蒸馏模型可以从 RL 中受益,但需要更复杂的课程设计和多目标优化;

由于强化学习越来越多地用于重新磨练潜在的预训练能力,而不是创造新的能力,因此重点转向整体优化从预训练到强化学习的流程,而不是独立处理这些阶段。

4.4 Training Recipes: Tricks or Traps

大型模型的强化学习训练主要从 PPO 系列发展而来,通过各种工程技术(例如修剪、基线校正、归一化和 KL 正则化)来保持稳定性。在 LLM 推理的强化学习领域,DeepSeek-Math 和 DeepSeek-R1 引入了无批评的 GRPO,通过降低复杂度简化了训练过程。尽管取得了这些进展,但与训练稳定性和效率相关的挑战依然存在,这促使人们提出了一系列新方法,包括动态采样、各种重要性采样率和多层归一化。

一种更广泛采用的促进探索的技术是使用解耦的 PPO 裁剪(“Clip 35 Higher”),其中裁剪上限设置得高于下限(例如,ϵlow=0.2\epsilon_{low}=0.2ϵlow=0.2,ϵhigh=0.28\epsilon_{high} = 0.28ϵhigh=0.28),以允许不太可能但可能有用的标记的概率更自由地增加。Archer针对具有不同熵水平的标记提出了一种双裁剪机制,而 Archer2.0 进一步对具有相反优势值的 tokens 使用非对称双裁剪。

- Minimalism in Data and Sampling:Xiong 等人对 GRPO 进行了分解,发现 最大的性能提升来自于丢弃所有不正确的样本,而不是依赖复杂的奖励正则化技术。他们提出,像

RAFT或Reinforce-Rej这样的方法,能够使用更简单的机制,实现与 GRPO/PPO 相当的稳定性和 KL 效率;DAPO将“动态采样 + 解耦剪枝”系统化为一种可复现的大规模方法,并结合了解耦 PPO 裁剪(“Clip-Higher”),其中裁剪上限设置得高于下限(例如,ϵlow=0.2\epsilon_{low}=0.2ϵlow=0.2,ϵhigh=0.28\epsilon_{high} = 0.28ϵhigh=0.28),从而允许不太可能但可能有用的 tokens 的概率更自由地增加,在 AIME24 基准的强基线上展示了最佳结果;GRESO表明,预过滤可以将推出时间加快 2.4 倍,将整体训练速度提高 2.0 倍,同时性能损失最小; - Structural Modification of the Objective Function:

GSPO将比例和裁剪操作转移到序列级别,从而比 GRPO 具有更高的稳定性和效率,尤其适用于混合专家 (MoE) 模型的稳定强化学习训练;S-GRPO进一步减少了冗余推理,缓解了推理链过长和不必要的趋势,并在多个基准测试中将序列长度缩短了 35% 至 61%,同时准确率略有提升; - The Struggle Between De-biasing and Normalization:

Dr. GRPO指出了 GRPO 的一个关键偏差,即 “犯错时间越长,错误就越多”,并引入了一些细微的算法修改来提高 tokens 效率。与此同时,其他研究(例如BNPO)从自适应分配的角度重新审视了奖励规范化的重要性,并提出了新的规范化方案。这两个阵营的证据相互矛盾,表明将规范化视为通用解决方案可能具有误导性;

将各种方法整合到一个开源框架中,以实现独立且可重复的实验。这项工作提供了一个路线图,概述了哪些技术在哪些设置下有效,并证明了一种极简的方法组合可以在多种配置中胜过 GRPO 和 DAPO。至关重要的是,它凸显了该领域最紧迫的挑战:不一致的实验设置、不完整的报告以及相互矛盾的结论。这构成了当前强化学习在研究界应用的根本限制。总而言之,虽然实用的“技巧”对于稳定强化学习训练很有价值,但“科学训练”的本质在于验证和可扩展性。该领域的进步需要统一的实验方案、可验证的奖励结构和明确的 scalability–performance–cost 曲线,以证明一种方法在扩展时仍然有效,而不仅仅是在特定的数据或模型上有效。

4.5 Reward Type: Process or Outcome

在标准强化学习中,策略的目标是最大化预期累积奖励。“奖励足够”假设进一步认为,设计合理的奖励就足够了,并且最大化回报原则上可以产生各种智能。在 LLM 的强化学习中,核心挑战在于如何提供有意义的奖励,例如训练奖励模型或验证器来对输出进行评分,并将这些分数用于强化学习或搜索。常见的方法包括 结果奖励(仅评估最终结果,例如正确性或通过单个测试)和 过程奖励(通过对中间步骤进行密集反馈来提供逐步评分)。

- 如 §3.1.1所示,当任务答案可验证时,结果奖励对于具有挑战性的数学和编码任务而言是最简单且最具可扩展性的。然而,仅注重结果的方法可能会默许不真实的思维链,例如 “先回答,后产生幻觉”和奖励推测。最近的研究表明,最先进的模型在现实世界场景中也表现出不真实的推理和事后合理化。其他研究也强调,基于规则的强化学习容易受到奖励黑客攻击和推理错觉的形成;

PRM天然地促进了长链信用分配。Lightman 等人清晰地比较了两种奖励方法:对于数学推理,经过过程监督训练的 PRM 更加稳定可靠,显著优于仅由结果监督的 PRM。然而,逐步标注的成本极高,而且质量在不同领域之间往往会下降。相关研究表明,启发式或基于蒙特卡洛的综合方法往往泛化能力较差,并会引入偏差;

总体而言,结果奖励提供“可扩展的目标一致性与自动验证”,而过程奖励提供“可解释的密集指导”。将两者结合起来,例如通过隐式过程建模或生成验证器,可能代表着奖励设计未来一个有前景的方向。

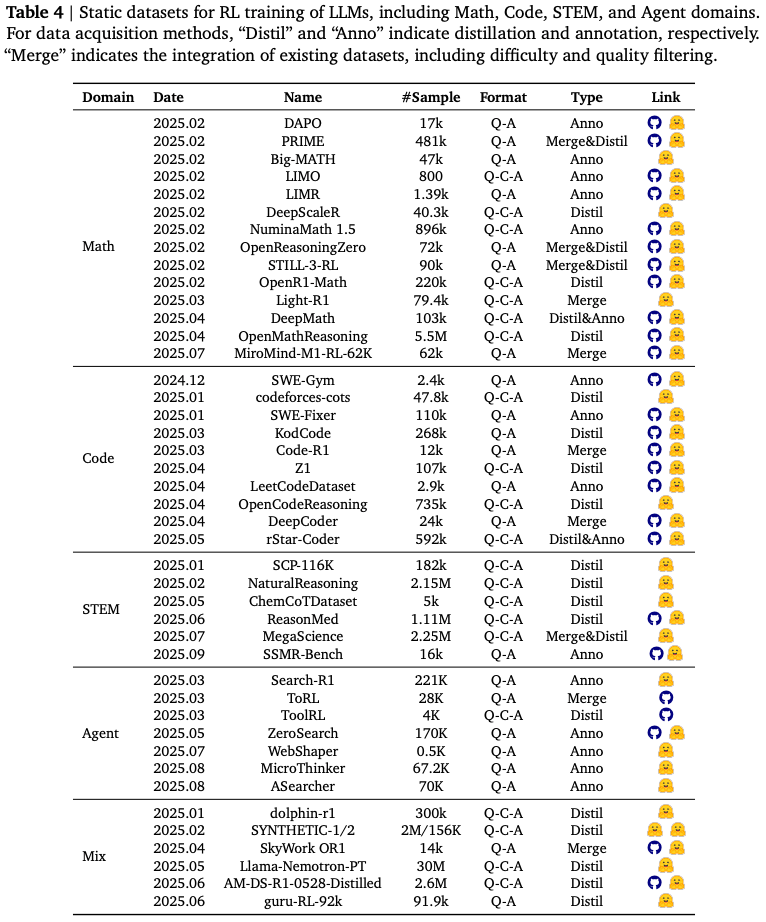

5. Training Resources

LLM 的有效强化学习不仅取决于算法和目标设计,还取决于底层训练资源的质量和结构。从静态语料库到动态环境以及专门的强化学习基础设施,资源的选择深刻影响着大规模训练的稳定性和可扩展性。在本节中,将概述当前实践中利用的主要训练资源类别。首先探讨静态语料库作为强化学习基础的作用和局限性(§5.1);然后讨论提供更丰富的学习信号和更真实的任务分布的动态交互式环境日益增长的重要性(§5.2);最后,回顾为 LLM 提供可扩展且高效训练流程的强化学习基础设施(§5.3)。

5.1 Static Corpus

本节概述了基于 LLM 的强化学习静态语料库。数据构建正从 “scale-first” 转向 “quality- and verifiability-first”,明确地是为了支持可验证的奖励(参见 3.1.1 节)。如 Table.4 所示,数据集覆盖四大领域:数学、编码、STEM 和 agent 任务(例如搜索和工具使用)。所有语料库均与 RLVR 直接兼容,从而支持过程感知评估。这些数据集支持强化学习流程的关键组件,包括策略预训练、奖励建模和难度感知采样。

以数学为中心的强化学习数据集围绕三个构建流程进行整合,包括 注释/验证、提炼 和 多源合并,同时广泛地公开中间推理轨迹,规模从数百到数百万个示例不等,紧凑且精心策划的数据集

LIMO和LIMR:强调具有明确过程反馈的高质量问题;DAPO、Big-MATH和DeepMath:带注释/验证的资源,提供了适用于奖励建模和价值校准的可靠解决方案轨迹;NuminaMath 1.5:在更大规模上扩展了过程丰富的样本;DeepScaleR、OpenR1-Math和OpenMathReasoning:以蒸馏为中心的语料库,继承了强教师或“R1 式”长链推理,支持策略预训练和 RL 阶段选择;PRIME、OpenReasoningZero和STILL-3-RL:合并和蒸馏集合,将开放问题与自生成候选问题相结合,提供难度分层和高质量过滤信号;Light-R1和MiroMind-M1-RL-62K:社区维护数据,封装了轻量级、强化学习就绪的格式,以便在计算受限的情况下进行快速迭代。

总的来说,这些资源涵盖了从基础计算到竞赛级问题的各种问题,并提供最终答案和可衡量的中间步骤,从而支持可扩展的策略学习、奖励建模和基于过程的强化学习。

面向代码的强化学习数据集主要分为三类:程序修复/编辑、算法竞赛问题 以及 带推理的通用代码生成。这些数据集通常提供可执行的单元测试和中间执行轨迹,以促进奖励塑造和流程级评估。

SWE-Gym:交互式测试驱动资源旨在实现细粒度的编辑策略;SWE-Fixer和LeetCodeDataset:人工验证的修复对则支持价值对齐和奖励建模;codeforces-cots、Z1和OpenCodeReasoning:属于竞赛风格和算法推理,强调长链轨迹和难度分层;KodCode和rStar-Coder:在用于通用代码生成的大规模“R1 式”代码提炼中,提供了丰富的流程样本,有助于策略预训练和强化学习阶段选择;Code-R1和DeepCoder:轻量级、以合并为中心的版本,便于在计算受限的情况下进行快速迭代;

总的来说,这些语料库涵盖了从单功能修复到竞赛级问题求解的整个过程,提供了可自动检查的最终成果和逐步的计划/编辑,从而为代码代理提供了可扩展的策略学习、奖励建模和基于流程的强化学习。

面向 STEM 的强化学习数据集通常集中在三个主题上:教科书或课程提取、跨学科大规模推理,以及 具有合并与提炼流程的领域专用语料库(例如化学和医学)。这些数据集通常会发布思路链式的理论基础和与证据一致的信号,从而实现流程级的奖励。

SCP-116K:面向本科到博士阶段的科学研究,提供自动提取的问题-解决方案对以及模型生成的推理;NaturalReasoning:提供从热门基准中净化的多学科问题,并提取参考答案;ChemCoTDataset:提供了化学领域特定的思路链式范例,涵盖分子编辑/优化和反应预测;ReasonMed:提供基于多智能体精炼的医疗问答系统,其中包含多步骤的理论基础(CoT)和简明摘要;SSMR-Bench:程序以文本(ABC 符号)和视觉格式自动合成基于音乐理论的乐谱推理问题,每个模态发布 16000 个训练对,并通过可验证的奖励支持评估和强化学习;MegaScience:通过基于消融的选择聚合公共科学语料库,并为大多数组成集标注分步解决方案,从而为强化学习构建一个庞大的科学推理训练池;

混合域强化学习数据集通过 “distillation-first” 和 “merge-centric” 的流程统一了 数学、代码 和 科学推理,同时广泛发布了思路链轨迹、验证者信号和多轨迹候选集,从而实现过程奖励和难度感知选择。在 R1 风格的混合数据集中。

dolphin-r1:融合了DeepSeek-R1、Gemini思维和精选聊天数据,用于通用推理;SYNTHETIC:套件将大规模 SFT 风格轨迹与可用于强化学习的多轨迹样本相结合;SYNTHETIC-1将DeepSeek-R1推理与多样化的验证者聚合在一起;SYNTHETIC-2-RL:则为偏好/奖励学习提供了具有多种轨迹的多域任务;SkyWork OR1-RL-Data:强调可验证的数学和代码问题,并带有难度标签,可作为轻量级的强化学习池;Llama Nemotron Post-Training:编译涵盖数学、代码、STEM、通用推理和工具使用的指令/R1 风格数据,用于后训练;AM-DeepSeek-R1-0528-Distilled:提供跨领域的精炼追踪数据,并带有质量过滤记录;guru-RL 92k:通过针对强化学习格式优化的五阶段流水线,整理六个高强度推理领域。

总的来说,这些语料库提供了跨领域的可验证端点和逐步推理原理,支持可扩展的策略学习、奖励建模和基于过程的强化学习。

以 agent 为中心的强化学习数据集专注于两种互补的功能:搜索即行动 和 工具使用,同时发布可验证的过程信号,例如搜索/浏览轨迹、证据 URL 和工具执行日志,从而实现过程奖励和离线评估。

Search-R1:基于NQ/HotpotQA构建,用于训练交错推理-搜索行为;ToRL:从基础模型扩展了工具集成的强化学习,以学习何时以及如何调用计算工具;ToolRL:研究用于学习工具选择和应用的细粒度奖励设计;ZeroSearch:制定了离线信息搜索任务,无需真实的网络调用即可激励搜索;WebShaper:通过“扩展器代理” (Expander Agent) 合成信息搜索数据,涵盖各种任务形式和推理结构,并提供 URL 证据;MicroThinker:为多步骤代理提供完整的部署轨迹和丰富的工具使用日志;ASearcher:发布了基于 Apache 2.0 许可的训练集,用于长期搜索代理,并包含问答字段和源注释。

总的来说,这些语料库涵盖了规划、检索、工具编排、证据验证和答案生成等功能,支持面向网络/搜索和工具使用代理的可扩展策略学习、奖励建模和基于过程的强化学习。

5.2 Dynamic Environment

现有的静态强化学习语料库,无论是手动标注、半自动标记还是从网络上抓取,对于需要更高级、更泛化的推理能力的训练模型来说,都越来越显得力不从心。如今,越来越多的研究利用 “Dynamic Environments” 来共同确保可扩展性和可验证性,这两项特性是有效模型训练的关键。

与传统推理语料库不同,这些动态环境代表着一种范式转变。它们既可以实现数据的自动化和无限合成,也可以对模型的整个推理过程提供逐级、多轮的反馈。如 Table.5 所示,根据用于合成和交互的方法,这些环境可以进行分类,作为强化学习过程的交互对象。鉴于专注于训练资源,本小节的数据集和环境组织将不包括仅用于评估的基准。

Rule-based Environment

仅仅依赖 “Exact Match” 之类的反馈可能会导致模型走记忆的捷径,而不是真正的推理。为了解决这个问题,一些环境提供了复杂多样的任务,这些任务需要基于确定性规则的操作作为验证器。

AutoLogi:通过构建代码来检查基于固定模型输出格式的逻辑约束的正确性,从而生成难度可控的开放式逻辑谜题;Logic-RL:使用可扩展的骑士与仆从谜题来创建基于规则的强化学习环境,将 7B 模型的推理能力推广到数学领域;SynLogic、Reasoning Gym和Enigmata:等项目进一步扩展了任务的多样性。它们识别出控制每个任务难度的关键参数,从而允许在各种逻辑相关的推理挑战中无限地生成数据;ProtoReasoning:则基于这样的假设:模型的泛化能力来自共享的抽象推理原型。它将不同类型的任务规范化为一致的格式,例如 Prolog 问题或 PDDL 任务,然后使用解释器自动验证模型的输出;

Code-based Environment

LLM 推理的一个重要应用领域是软件工程和代码开发。这些环境的一个关键特征是模型在训练期间必须与可编译的代码环境交互。因此,如何可扩展地构建基于代码的任务环境仍然是一个重要的研究方向,为了教会智能体使用工具。

ReCall:利用先进的 LLM 构建了一个基于 Python 的工具交互环境,并自主合成其自身的 SynTool 数据用于强化学习训练;MLGym:在 AutoML 领域,是首批支持交互式环境进行迭代实验和训练的模型之一,使用 Docker 容器隔离每个任务的执行环境,虽然其任务基本固定,但可扩展性较差;MLE-Dojo:则具有更高的可扩展性,因为它更容易让用户集成新任务;MedAgentGym:是一个高效且可扩展的医疗领域交互式训练环境;R2E-Gym:在软件工程领域,通过直接从 GitHub 提交历史记录以编程方式生成环境,并与 OpenHands 集成以实现交互式功能,从而减少了对手动编写的 GitHub 问题和测试用例的依赖;SWE-rebench通过提出一种可扩展的软件工程任务构建流程,扩展了原始的静态SWE-bench。该流程包含模拟真实软件开发场景的复杂交互式任务,确保数据的新鲜度并避免数据污染;AgentCPM-GUI:在计算机使用领域,在 RFT 阶段构建交互式 GUI 环境,以提供有关模型操作的反馈;AppWorld使用包含各种移动应用程序 API 的环境;ZeroGUI则更进一步,利用现有的高级 VLM 为 Ubuntu 和 Android 构建任务。在训练过程中,GUI 代理与环境交互,然后将反馈提供给 VLM 以提供奖励,所有这些都无需手动数据管理;

Game-based Environment

游戏环境的特点是其状态空间清晰而复杂,其中人工智能的行为与环境状态紧密耦合。与前面提到的环境相比,这导致了更多步骤、更连续的交互过程,并且此类环境自然支持 §3.1.3 中的密集奖励,使强化学习训练更加高效和稳定。早期用于训练代理的交互式环境的研究:

ALFWorld和ScienceWorld:在 agent规划领域仍然具有影响力;Code2Logic:利用游戏代码和问答模板自动生成多模态推理数据,从而产生了GameQA数据集。该数据集不仅可扩展,还可以以渐进的难度测试模型的多模态推理能力;lmgame-Bench:采用了不同的方法,直接选择经典游戏并通过统一的API与LLM进行交互。游戏环境会根据 LLM 的操作更新其状态并提供奖励,LLM 随后会根据奖励调整其策略;Play to Generalize:使用简单、可扩展的强化学习游戏环境来训练一个 7B 参数的 MLLM。研究发现,该模型获得的推理技能可以推广到未见过的游戏和多学科推理任务;G1:引入了 VLM-Gym,这是一个支持并行执行多个游戏状态的强化学习环境,有助于大规模训练;KORGym:进一步扩展了支持的简单游戏数量,提供了交互式且难度可配置的强化学习环境;PuzzleJAX:采用了不同的方法,使用 JAX 加速由 PuzzleScript 语言生成的游戏。这不仅加快了游戏环境的速度以支持基于强化学习的训练,还提供了一个拥有无限游戏资源的游戏开发者社区。为了学习通用的合作技能,跨环境合作利用游戏 Overcooked,并在自对弈框架内最大化环境多样性;

*Optimus系列: 对于像 Minecraft 这样更复杂、自由度更高的游戏,利用知识图谱与游戏环境交互,构建数据来评估模型的长期规划能力;

Model-based Environment

这种范式有助于通过模型间交互或自我对弈创建高度灵活多样的强化学习环境。

SwS:利用模型失败的训练案例来抽象关键概念并生成新问题,从而有针对性地增强其推理能力;SPIRAL:使用三个零和博弈进行自我对弈,以防止过度拟合静态策略;Sweet-RL:对于模型间交互,使用类似证明器-验证器的训练框架,其中 agent 与基于 LLM 的人类模拟器交互并协作,以解决前端设计和后端编程任务;TextArena:提出将对抗性文本游戏与排名系统相结合,通过允许模型直接交互来相对衡量其能力,从而克服了人类评分的瓶颈;Absolute Zero:完全摆脱了人类定义的评估任务,利用三种推理模式让模型自主生成任务,并通过自我进化提升推理能力;Genie 3:在视觉领域生成了近乎真实且可交互的 3D 虚拟环境,为未来多模态环境交互强化学习奠定了基础。

虽然一些现有的世界模型已经支持基于强化学习的模型训练,并且在上面列出了使用基于模型的环境训练 LRM 的研究,但仍然没有足够可扩展的解决方案来支持基于世界模型的 LRM 的强化学习训练。我们认为,这种动态环境的最终形式将是一个能够模拟完整、自足世界的预言世界模型。

Ensemble-based Environment

还有一些工作需要大量的工程投入,将各种任务和数据集整合起来,形成用于强化学习的交互式环境和训练数据。

InternBootcamp:是一个大规模、可扩展的环境库,旨在训练逻辑推理模型 (LRM)。它通过提供难度可控的生成器和基于规则的验证器,支持八个领域的 1000 多个通用推理任务。其一项关键贡献是其对“任务扩展”的实证演示,表明增加训练任务的数量可以显著提升推理性能和训练效率;Synthetic-2:通过提供一个包含 400 万条经过验证的推理轨迹的海量开放数据集,为这种方法做出了贡献。这些轨迹是通过“行星级、流水线并行、去中心化推理运行”协作生成的,展示了一种用于为复杂强化学习任务创建经过验证的训练数据的高度可扩展方法;

5.3 RL Infrastructure

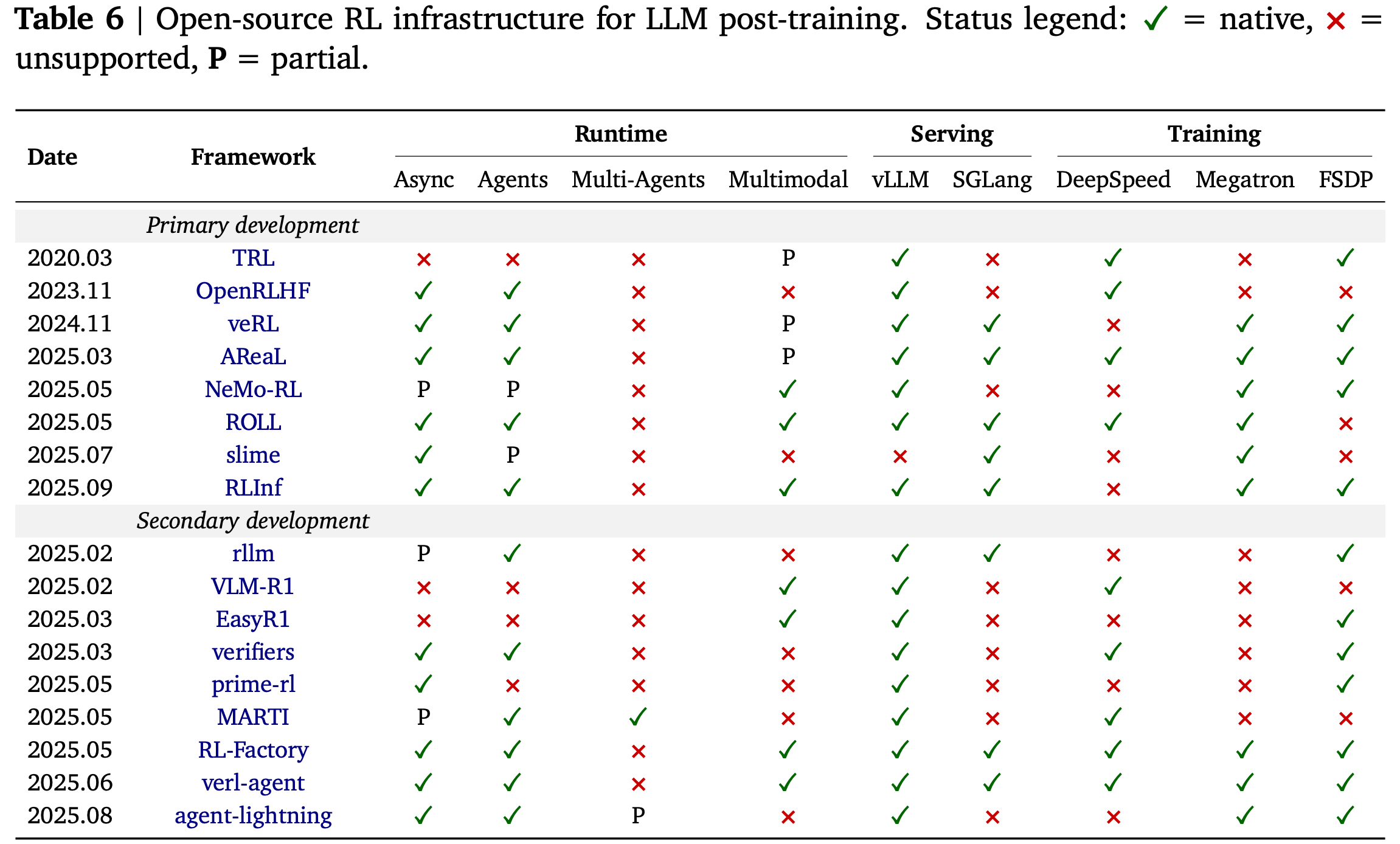

在本小节中,将介绍开源强化学习基础设施,这些基础设施不仅推动了算法研究的发展,也促进了下游应用的发展。首先介绍主要的 开发框架,这些框架主要提供对LLM训练和推理框架的基本包装;接下来,将介绍基于这些主要框架构建的二次开发框架,这些框架进一步适用于各种下游应用,包括代理强化学习、编码强化学习、多智能体强化学习、多模态强化学习、分布式强化学习等。在 Table.6中比较了这些开源强化学习框架,并在下文中介绍了主要框架。

Primary Development

当前的强化学习基础设施严重依赖于为 LLM 设计的成熟训练框架和推理引擎。DeepSpeed、Megatron 和 Fully Sharded Data Parallel (FSDP) 等框架针对 LLM 的预训练和后训练进行了优化。在推理方面,vLLM 和 SGLang5 针对高效推理进行了定制,并结合了高级调度程序和 Flash Attention 机制。与在 PyTorch 模型上直接进行前向计算相比,这些优化显著提高了推理速度。许多开源强化学习框架都建立在即插即用的训练和推理框架之上,其中大多数框架是在 Ray6 等分布式计算引擎上实现的。本文,我们回顾一下直接基于上述骨干网络训练和推理框架开发的强化学习框架。

- TRL:专注于以训练器为中心的后训练,使用 SFT、PPO/GRPO、 DPO 和专用的

RewardTrainer(以及最新的在线版本),而非定制的分布式运行时。它集成了用于在线方法(服务器或共置模式)的 vLLM,但并非原生支持 SGLang 或 TensorRT-LLM。扩展功能委托给 Accelerate,它原生支持 DDP、DeepSpeed ZeRO 和 FSDP;Megatron 并非后端。奖励建模通过 RewardTrainer 提供开箱即用的支持,并且该库提供了用于 GRPO/DPO/在线部署的清晰 API; - OpenRLHF:提供 PPO、GRPO、REINFORCE++(及其基线变体)和 RLOO 的分布式实现,同时还包含 DPO/IPO/cDPO 和 KTO 等偏好学习基线。其运行时支持异步流水线 RLHF 和异步代理强化学习模式,并公开了基于类的代理 API 用于多轮设置。在服务方面,OpenRLHF 与 vLLM 紧密集成,以实现高吞吐量部署。训练围绕具有自动张量并行 (AutoTP) 的 DeepSpeed ZeRO-3 进行组织,无需 Megatron 或 FSDP。该框架提供了用于 RM 和 PRM 训练的方案,并将 PRM 信号集成到部署中;

- Verl:提供最广泛的算法菜单之一(PPO、GRPO、GSPO、ReMax、REINFORCE++、RLOO、PRIME、DAPO/DrGRPO 等),以及多轮训练和工具使用。其运行时以

HybridFlow控制器为中心,并添加了代理强化学习 (Agentic RL) 部署和用于分解式异步训练的原型(公共路线图上标有“异步和离线策略架构”)。Verl 支持 vLLM 和 SGLang 服务,并提供 FSDP 和 Megatron-LM 训练后端。奖励选项包括基于模型的奖励和函数/可验证奖励(例如数学/编码),并支持多 GPU LoRA-RL; - AReaL:旨在为大型推理模型提供高吞吐量强化学习,其完全异步设计通过可中断的 rollout 工作器、重放缓冲区和并行奖励服务(例如,基于单元测试的代码奖励)将生成与训练分离,并由可感知陈旧性的 PPO 目标函数实现稳定性。根据经验,该系统在数学/代码基准测试中报告的训练加速比高达 2.77 倍,最终准确率达到或超过同等水平,并且可近乎线性地扩展到 512 块 GPU。该开源堆栈强调基于 SGLang 的 rollout 服务和 Ray 启动器,适用于单节点到约 1K GPU 的集群,并以 PyTorch FSDP 作为主要训练后端(Megatron 也可用);较新的 “AReaL-lite” 添加了算法优先的 API,其中包含 GRPO 示例,并支持多轮代理强化学习/RLVR 工作流;

- NeMo-RL:NVIDIA 的 NeMo 堆栈现已开放专用的 “NeMo RL” 库和用于对齐的早期 NeMo-Aligner 工具包。在算法方面,NeMo 涵盖 SFT 和偏好训练(DPO/RPO/IPO/REINFORCE),以及包含 PPO 和 GRPO 的完整 RLHF,包括多轮变体。运行时强调可扩展、面向生产的编排和广泛的并行性;训练基于 Megatron Core(张量/数据/流水线/专家并行),适用于 100B 规模的模型和多节点集群。在服务方面,NeMo 框架记录了使用 TensorRT-LLM 和 vLLM 的部署。在 RLHF 教程中,奖励模型训练是一流的,拥有从 RM 拟合到 PPO 的端到端流水线;

- ROLL:ROLL 的目标是通过 GRPO/PPO/REINFORCE++ 以及其他方案(例如 TOPR/RAFT++/GSPO)实现大规模 LLM 强化学习,并明确支持异步训练和代理强化学习流水线。运行时遵循基于 Ray 的多角色设计,并集成了 SGLang 和 vLLM 用于部署服务。训练主要围绕 Megatron Core 构建,FSDP2 已列入公共路线图;DeepSpeed 被确认为依赖项。奖励处理通过奖励工作器(例如,验证器、沙盒工具、LLM-as-judge)和可插拔环境实现模块化。技术报告详细介绍了系统和扩展方面的考虑;

- slime:定位为一个基于

SGLang的强化学习扩展后训练框架,将部署端的 SGLang 与训练端的 Megatron 连接起来。它更注重基础设施而非算法广度,但提供了密集模型和多轮模型的示例,并包含多轮 + 工具调用(“Search-R1 lite”)。运行时支持异步训练和代理工作流;通过 SGLang 提供一流的服务。训练使用 Megatron-LM 和 Ray 进行集群启动;奖励建模本身并非主要关注点,尽管可以在部署端生成验证者/“奖励”信号; - RLinf:一个体现智能的框架,强调模块化和适应性。受“大脑”和“小脑”范式共存以及该领域不断发展的轨迹的启发,RLinf 采用“宏到微流”(M2Flow)范式,将宏观逻辑工作流与微观物理执行分离,从而实现可编程组合和高效调度。在运行时,RLinf 允许将强化学习组件(例如 Actor、Critic、Reward、Simulator)灵活地放置在任意 GPU 上,并配置共置、分解或混合执行模式——从共享所有布局到细粒度流水线。一个典型案例是将生成器和基于 GPU 的模拟器解耦为一个流水线,而推理和训练器共享执行。在服务方面,RLinf 支持 vLLM/SGLang,在训练方面,集成了 Megatron/FSDP;

Secondary Development

在本部分中,将介绍几个基于主要开发框架构建的代表性框架,并扩展其功能以支持更广泛的下游应用。主要关注 agent 强化学习、多模态强化学习和多智能体强化学习的框架。尽管一些主要框架已经为这些领域提供了部分支持,但我们重点介绍为特定领域研究设计的专用框架。

- Agentic RL:该领域专注于训练LLM在各种场景中使用外部工具,例如搜索引擎、Python解释器、Web浏览器等。主要框架,例如

veRL和AReaL,已经更新或专门设计以支持这些功能。Agentic RL的核心特性是异步生成和训练,这显著减少了LLM与外部环境长期交互时的计算时间。次要框架大多基于veRL构建,以集成其他工具和环境,其新功能逐渐融入veRL。更多关于Agentic RL的细节将在§6.1和§6.2中讨论; - Multimodal RL:虽然主要的开发框架最初是为训练语言模型而设计的,但它们通常基于Transformer,后者支持视觉语言模型的推理和训练。该领域的主要挑战在于数据处理和损失函数设计。一些著名的框架,例如

VLM-R1和EasyR1,已经开发用于训练基于veRL的视觉语言模型。对于多模态生成,一些专门用于基于扩散模型的RL训练的框架已经开发,例如DanceGRPO。然而,这些方法超出了本文的讨论范围,读者可以参考近期以视觉模型为重点的RL综述文章以了解更多细节。关于多模态RL的更多细节将在§6.3中讨论; - Multi-Agent RL:主要侧重于实现异步部署和训练的动态工作流。虽然大多数此类框架仍然局限于单智能体应用,但基于 LLM 的多智能体强化学习 (MARL) 仍是一个正在积极探索的领域。Zhang 等人提出了第一个基于 LLM 的多智能体强化学习 (MARL) 高性能开源框架,用于实现集中式交互和分布式策略训练。此外,近期的框架(例如

Agent-Lightning)实现了训练和推理的分离,从而更易于支持多智能体训练。更多关于多智能体强化学习的细节将在 6.4 节中讨论;

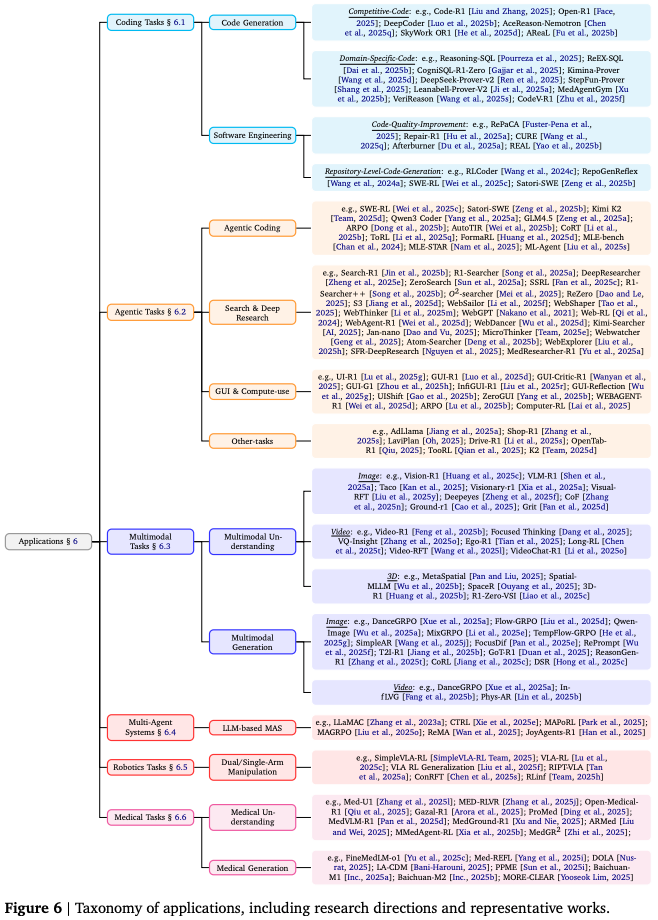

6. Applications

理解强化学习在 LLM 领域的进步,最好通过其在各个领域的实际影响来理解。在本节中,将回顾强化学习训练的语言模型应用于实际任务的最新进展和挑战。重点介绍强化学习驱动的方法如何提升 编码任务的能力(§6.1)、如何 实现更具自主性和适应性的 agent行为(§6.2),以及如何 将 LLM 扩展到文本、视觉及其他领域的多模态推理(§6.3)。此外,还讨论了其在多智能体系统(§6.4)、机器人技术(§6.5)和医学(§6.6)中的应用,阐述了每个领域的广阔潜力和独特需求 Fig.6 中提供了应用的总体分类及其相应的相关工作。

6.1. Coding Tasks

近年来,大量研究表明 强化学习在可验证任务中具有显著优势。鉴于编码任务固有的可验证性和实际重要性,强化学习已成为提升代码推理能力的核心方法,并持续受到广泛关注。为了系统地回顾该领域,我们根据任务复杂性和发展趋势,将现有研究分为三个方向:代码生成 Code Generation、软件工程辅助 software engineering assistance 和 agent编码 agentic coding,从简单的可验证任务到更复杂、自主的代理编码。

Code Generation

该方向的主要目标是生成正确且可执行的代码。研究重点是利用强化学习调整 LLM 的生成分布,以满足不同编码任务的需求。继 DeepSeek-R1 证明了强化学习在复杂推理方面的潜力后,越来越多的研究将强化学习应用于代码生成。

- Competitive Programming:竞技编程是最早的基准测试之一,它启发了包括

Code-R1、Open-R1、DeepCoder、AceReason-Nemotron、SkyWork-OR1和AReaL在内的多项研究,这些研究在编程任务中复制了DeepSeek-R1的结果;为了解决强化学习训练的 不稳定性以及推理速度慢 的问题,DeepCoder和SkyWork OR1采用了分阶段的强化学习训练,逐步增加上下文长度以稳定学习过程;DeepCoder和AReaL进一步采用异步部署,将训练与推理分离,加速学习;为了解决代码生成中 缺乏明确的抽象推理能力的问题,AR2框架(用于抽象推理的对抗性强化学习)通过 RLVR 迭代训练教师和学生模型;除了尝试使用自回归模型进行代码生成外,Dream-Coder还将 RLVR 训练范式融入扩散模型,从而实现了更快的生成速度;在 跨任务泛化 方面,AceReason Nemotron观察到了从数学推理任务到竞技编程的正迁移效应; - Domain-Specific Code:由于不同领域对代码要求的差异,强化学习越来越多地应用于特定任务。在数据检索领域,

Reasoning-SQL、ReEX-SQL和CogniSQL-R1-Zero将 GRPO 算法应用于 Text-to-SQL 任务,并在相应的基准测试中取得了显著的性能;在形式化证明方面,Kimina-Prover和DeepSeek-Prover-v2通过将自然语言与 Lean 相结合,统一了非形式化证明;StepFun-Prover构建了端到端的工具集成训练流程;Leanabell-Prover-V2通过多轮验证者反馈直接优化推理轨迹,进一步提升了强化学习在该领域的能力;在其他领域,MedAgentGym提供了大规模轨迹生成的可执行编码环境,以改进基于 LLM 的医学推理;VeriReason、Proof2Silicon和CodeV-R1将 RLVR 扩展到电子设计自动化 (EDA) 领域,加速了 LLM 驱动的硬件设计。此外,图表到代码的生成使智能体能够处理结构化或视觉输入,并将其转换为可执行代码,体现了跨模态领域特定代码生成的特性;

Software Engineering

尽管在竞技编程和特定领域任务方面取得了进展,但这些研究往往与现实世界的软件开发环境存在差距。因此,强化学习研究也侧重于现实世界的软件工程,包括代码修复、质量优化和存储库级生成。

- Code Quality Improvement:自动代码修复和质量改进可在保留功能性的同时提升软件可靠性。强化学习显著提升了修复效率和泛化能力,使模型能够处理未见缺陷。

RePaCA通过使用思路链推理和基于 GRPO 的微调来指导 LLM,从而缓解 APR 补丁过拟合问题;Repair-R1则联合优化了测试用例的生成和修复,减少了对事后验证的依赖。除了修复错误之外,强化学习还能提升代码效率、可维护性、可读性和安全性;CURE和UTRL通过编码器-测试器交互来改进代码和单元测试,而无需真值监督;Afterburner利用执行反馈,将 Pass@1 率从 47% 提升至 62%,超越了人类的效率水平;REAL将程序分析和单元测试作为混合奖励进行集成,以提高可扩展性和质量,从而实现无需人工干预的高质量代码生成; - Repository-Level Code Generation:除了函数和代码片段级别的任务之外,最近的研究还探索了代码库级别的代码生成和维护,强调跨文件和跨模块复杂依赖关系的一致性和可维护性。

RLCoder将检索增强生成 (RAG) 与强化学习相结合,以训练检索器并提高代码补全的准确率;RepoGenReflex进一步引入了一种反射机制来评估生成结果并提供反馈,从而持续优化生成策略并提升泛化能力。通过将强化学习与自动化测试和持续集成相结合,该方法将 LLM 优化与实际开发流程相结合,从而推动软件工程自动化的发展;

6.2 Agentic Tasks

工具使用被认为是语言模型的一项基本能力。近期的研究利用强化学习帮助 LLM 掌握工具并完成更复杂的问题。作者在这里将它们分为编码代理 Coding Agent、简单搜索代理 Simple Search Agent、浏览器使用代理 Browser-use Agent、深度研究代理 DeepResearch、图形用户界面 (GUI) 和计算机使用代理 GUI & Computer-use Agent 以及其他任务 Other Tasks。

Coding Agent

强化学习与智能体范式的融合,将代码生成从单步输出推进到多轮交互和自主迭代,赋予 LLM 闭环优化的执行和验证能力。

- Code Agents:一种常见的做法是将 强化学习集成到具备执行和验证功能的代码代理中,并在

SWE-Bench等实际基准测试上进行评估。SWE-RL将 GRPO 应用于代码块 generation–execution–correction 循环,从而实现持续策略优化,并提升数学推理、通用代码生成和跨领域任务的性能;EvoScale (Satori-SWE)允许代理自主提升代码块质量,而无需外部验证器;Kimi K2、Qwen3-Coder和GLM-4.5等强化学习增强模型展现出更强大的代理行为,从而提升了自主性和可扩展性;Sinha 等人研究了 LLM 中的长视界执行,并证明由于误差累积,单步准确率的提升并不一定能转化为多步任务的成功性能。这些发展表明,强化学习与代理编码的结合正在推动从 “single-step generation” 向 “autonomous iteration” 的转变; - Tool-Integrated Reasoning:强化学习的另一个新兴应用是 工具集成推理 (TIR),它通过将自然语言推理与外部工具执行环境紧密耦合来增强 LLM 的代码推理能力。这种方法使模型能够生成、执行和验证中间代码或程序输出,从而减少错误并提高可验证性。

ARPO、AutoTIR、CoRT和ToRL等代表性工作采用了类似的策略:使用 SFT 或强化学习(主要是 GRPO 或其变体)对模型进行后训练,并将输出结构化(例如<code>...</code>)以触发工具执行,并将结果反馈到推理循环中;Li、Paprunia、Xue 等人的研究也采用了类似的策略,通过提升小型 LLM 的工具使用能力、稳定多轮推理以及奖励独立于最终答案的工具使用序列,扩展了基于强化学习的工具集成推理。这种紧密集成提供了明确的强化学习奖励信号,引导模型生成逻辑一致的输出,并通过可验证的计算迭代地完善它们。此外,诸如FormaRL之类的自动形式化方法通过将基于编译器的语法检查和 LLM 一致性评估与最少的标记数据相结合,将 TIR 扩展为基于精益的形式化证明生成,从而进一步提高了可靠性和正确性; - Automated ML Programming:强化学习在自动化机器学习 (AutoML) 领域展现出广阔前景,它将代码代理扩展为 能够自主处理数据、构建模型和优化的机器学习工程代理(MLE 代理)。

MLE-bench评估了机器学习代理的能力;MLE-STAR提出了一种基于搜索和优化的机器学习工程代理;ML-Agent展示了强化学习驱动的自主机器学习工程。Yang 等人的研究表明,由经过强化学习训练的相对较小的模型驱动的代理,其性能优于使用更大但静态的模型的代理,尤其是在持续训练的情况下;

Simple Search Agent

通过结构化提示、多轮生成以及与在线搜索引擎(例如谷歌)或静态本地语料库(例如维基百科)的集成,可以将 LLM 训练为搜索代理。然而,使用在线搜索引擎进行训练通常会产生大量的 API 成本,使得这种方法成本过高。为了应对这一挑战,Sun 等人提出在训练具有搜索功能的 LLM 时模拟搜索引擎,从而显著降低成本,同时保持甚至提高性能。其他一些工作,例如 R1-Search++ 和 SEM 则利用 LLM 的内部知识来减少训练预算,同时获得更好的性能。SSRL提出了在完全模拟的环境中训练模型,这些模型可以通过 Sim2Real 泛化无缝地适应真实场景,同时可以针对特定应用开发多样化的奖励信号;Dao、Le、Mei 等人采用多样性奖励来鼓励全面而准确的信息收集;Wang利用阶梯式奖励进一步提升搜索代理的性能;S3 利用超越 RAG 的增益,以更少的数据实现更好的性能。为了增强 LLM 处理更具挑战性的查询(例如 GAIA 和 BrowseComp等基准测试中的查询)的能力,WebSailor 从知识图谱构建训练数据,使模型能够搜索和浏览开放的网络环境,从而解决难以理解的问题。WebShaper 引入了一个形式化的数据构建框架,旨在提升通用人工智能助手的解决问题能力。

Browser-use Agent

除了使用搜索引擎,其他浏览器用户代理也利用网页浏览功能。WebGPT 使用文本网页描述来训练模型,使其具备浏览网站的能力;Web-RL 采用课程策略和对象关系映射 (ORM) 将 LLM 转换为网页代理;DeepResearcher 利用另一个 LLM 在浏览时充当摘要器,以辅助搜索过程;Vattikonda 使用各种超参数引导训练学生模型,以实现稳定的训练和更佳的性能;WebAgent-R1 提出了一种多轮异步 GRPO 来训练端到端网页浏览代理,并取得了优异的性能;WebDancer 运用 SFT 和 RL,通过网页搜索和浏览实现深度信息检索和多步推理。此外,其他任务也需要网页代理,例如 Academic Browse。

DeepResearch Agent

DeepResearch 旨在从各种在线来源收集信息,帮助解决实际问题,例如报告生成;WebThinker 经过迭代深度优化算法 (DPO) 训练,利用 LRM 的长连接能力,结合深度网络浏览器和 LLM 编写器完成具有挑战性的任务;Kimi-Searcher 识别了多智能体面临的困境,并自动构建密集的工具使用数据,对单智能体模型进行端到端训练,在 HLE 上取得了优异的性能;Jan-nano 通过采用多阶段强化学习虚拟环境 (RLVR) 消除了对冷启动或快速响应时间 (SFT) 的需求,分别专注于工具调用、回答质量和延长响应长度;MicroThinker 使用 SFT 和 DPO 训练 Qwen3,提升了其在实际应用中的性能;WebWatcher 被提出,这是一个多模态深度研究模型,能够利用外部工具和视觉信息来解决极其复杂的问题;Atom Searhcer 利用 LRM 作为 PRM,在训练过程中提供细粒度的奖励信号,从而获得更佳性能;ASearcher 将交互轮次扩展到 10 轮以上,以激发深度研究代理的推理能力;WebExplorer 采用基于模型的数据合成方法来构建高质量数据,从而获得更佳性能; SFR-DeepResearch 以最少的工具使用次数赋能单个智能体,并在更长的轨迹下获得相当的性能。除了一般的 QA 任务外,MedResearcher-R1 也被提出用于解决临床问题。

GUI & Computer-use Agent

UI-R1 是首个将基于规则的强化学习应用于图形用户界面 (GUI) 任务的成果。它引入了一种新颖的基于规则的动作奖励机制,并使用一个小型的、人工策划的训练集进行了优化;在此基础上,GUI-R1、GUI-Critic-R1 等精心设计了细粒度的基于规则的奖励机制,以满足 GUI 任务的特定目标,例如动作准确性、论证正确性和步骤级状态;GUI-G1 对先前的方法进行了实证分析,发现了诸如长度偏差、难度偏差和奖励黑客攻击敏感性等问题,并重新制定了奖励规范化方案以缓解这些问题。

此外,最近的研究试图从在线GUI环境中获取反馈,以更好地模拟现实世界的操作条件。GUI Reflection 和 UIShift 根据UI元素的变化得出二元奖励,以指示操作成功或失败。Liu 等人提出了一种两阶段训练范式,明确增强了规划和反思推理能力;ZeroGUI 引入了一种用于生成具有挑战性的任务的自动化流程,并仅根据在线环境反馈来估算奖励,从而无需人工注释。与上述分步方法不同,应用端到端异步强化学习框架来训练移动端和计算机端的智能体正日益成为一种趋势,这些框架仅使用基于规则的任务级完成奖励来优化模型,而无需分步奖励信号。UI-TARS通过迭代训练和反射调优,从错误中学习并适应不可预见的情况。更进一步的是,UI-TARS 2增强了 GUI、游戏、代码和工具使用方面的功能,并采用了端到端强化学习。

Other Tasks

除了搜索和图形用户界面 (GUI) 代理之外,强化学习 (RL) 也已成功应用于各种其他代理任务。例如,Jiang 等人利用历史绩效指标(例如点击率)作为奖励信号来指导基于强化学习的优化,从而改进了广告文案生成;在电子商务领域,Shop-R1 引入了一种复合奖励函数,该函数将内部模型逻辑与外部分层反馈相结合,以更好地模拟购物环境中的类人决策;对于自动驾驶,LaviPlan 将感知视觉能力与情境感知决策相结合,从而在动态条件下实现更稳健的导航;Drive-R1 旨在平衡复杂驾驶场景下的推理和规划能力,从而改善战略行为和被动反应行为;在结构化数据交互方面,OpenTab-R1 采用两阶段训练框架来提升 LLM 在基于表格的问答方面的熟练程度。此外,诸如 Qian 等人和团队等提出的通用代理模型,展现了掌握多种常用工具(例如计算器、API 和数据库)以解决各种现实世界任务的能力,展现了强化学习在构建多功能、工具增强型代理方面的可扩展性。

6.3. Multimodal Tasks

强化学习的成功不仅体现在语言模型上,也体现在它在多模态任务中取得了显著进展。一些特定的优化方法已被开发出来,以增 强诸如空间感知 和 跨模态可控性 等能力。下文将从理解和生成两个角度探讨强化学习在多模态任务中的应用。

Multimodal Understanding

与语言场景相比,多模态理解需要强大的空间感知和跨模态语义对齐能力。近年来,大量研究利用强化学习来 增强跨图像、视频 和 三维空间的推理能力,并显著提升了理解能力。

- RL in Image Understanding:

Vision-R1、VLM-R1、Visual-RFT首次尝试将DeepSeek-R1风格的 RFT 从数学和代码领域扩展到多模态感知任务。这些方法标志着训练范式的转变:从 SFT 中的数据扩展转向针对特定任务目标定制可验证奖励函数的策略设计。它们在多个检测和基础基准测试中取得了优异的表现,证明了强化微调 (RFT) 即使在训练数据有限的情况下也具有卓越的泛化能力。随后,一些视觉推理模型采用了类似的思考-回答模式,尝试通过反复试验进行学习。这些方法通过结果-奖励驱动的优化来增强推理能力,从而无需昂贵的逐步监督或 CoT 训练数据。近年来,Deepeyes、CoF以及其他等方法已从纯基于文本的认知推理 (CoT) 扩展到显式多模态交错推理链。这些方法尝试使用现成的工具或图像生成模型迭代地识别图像中的感兴趣区域,从而实现更具可解释性的推理过程。其他方法通过在推理阶段复制和路由视觉标记来实现隐式多模态交错认知推理 (COT),从而减轻了基于长文本的认知推理 (CoT) 中的幻觉。尽管取得了显著的成功,但仍有几个挑战亟待解决:1. 推理和回答不一致:模型产生的思维无法映射到最终答案;2. 长链探索崩溃:随着响应长度的增加,模型变得脆弱,容易产生幻觉;3. 数据质量敏感性:强化学习样本选择至关重要,因为低质量的训练数据可能导致性能不理想,甚至出现负面优化; - RL in Video Understanding:扩展视频理解能力以解释和推理动态视觉内容对于多模态理解至关重要。

Video-R1引入了一个用于视频多模态大型语言模型 (MLLM) 的系统性强化学习框架,并使用时间感知的 GPRO 算法 (T-GRPO) 来改进时空推理;ReAd-R提出了一个通过基于规则的强化学习优化的框架,以模拟人类启发式思维来理解广告视频;Focused Thinking采用代币加权奖励方案,精简冗长、通用的思路链,并使用分级(部分积分)奖励来增强视频推理;VQ-Insight设计了分级奖励机制,并针对长视频设计了通用的、针对特定任务的时间学习定制的问答流程;为了从第一人称视角理解人类的日常生活,Ego-R1通过强化学习训练了一个工具思维链代理,通过动态调用检索和视觉工具进行逐步推理,从而处理超长以自我为中心的视频(长达数天或数周);LongVILA的Long-RL框架构建了一个大型LongVideo-Reason数据集以及一个专门的两阶段 CoT-SFT 和强化学习流水线,并采用序列并行机制,使 MLLM 能够处理超长视频;为了自动化更多视频 CoT 数据的创建,VideoRFT使用 LLM 从丰富的视频描述符中生成初始推理,并对其进行 VLM 细化,并引入语义一致性奖励,以使文本推理与视觉证据保持一致;VideoChat-R1证明,有针对性的多任务强化学习微调可以显著提升特定的时空技能,而不会降低一般聊天性能。总而言之,这些研究为通过强化学习开发稳健且可泛化的视频推理铺平了道路; - RL in 3D Understanding:虽然 MLLM 通过强化学习在二维视觉理解方面取得了显著进展,但将其能力扩展到三维空间的视觉空间理解仍然是一个充满挑战的前沿领域。

MetaSpatial采用了一种基于多轮强化学习的优化机制,该机制集成了物理感知约束,以增强MLLM的空间推理能力;在GRP 的基础上,Spatial-MLLM和SpaceR证明,即使是小规模的模型,也可以通过类似R1-Zero的训练缩小与更大规模模型的性能差距;RoboRefer将基于 RL 的空间推理扩展到具体环境,以在现实世界动态中进行推理;

Multimodal Generation

强化学习在 LLM 中的探索也已扩展到多模态生成。测试 时间扩展 和 推理预测优化 方面的开创性研究,推动了图像和视频生成在美学和文本保真度方面的显著进步。近年来,人们越来越关注增强图像和视频生成中的推理能力。

- RL in Image Generation:扩散模型显著推进了视觉生成,越来越多的研究将强化学习融入其中,通过将去噪步骤视为CoT轨迹来隐式地执行推理。然而,GRPO 在扩散模型中表现出常微分方程 (ODE) 采样之间的内在冲突。具体而言,GRPO 依赖随机采样来估计优势,而 ODE 采样遵循确定性的去噪轨迹,这限制了 rollout 样本的多样性。为了解决这个问题,人们采用了从常微分方程 (ODE) 到随机微分方程 (SDE) 的转换,以在采样过程中引入随机项。考虑到随机微分方程 (SDE) 的低效性,

MixGRPO通过集成 SDE 和常微分方程 (ODE) 设计了混合采样策略;TempFlow-GRPO明确利用了基于流的模型中的时间结构,从而实现了更精确的信用分配和策略优化;GPT-4o展示了强大的文本保真度和编辑一致性,引发了人们对自回归模型可控性的兴趣;SimpleAR基于大规模图文训练数据,直接将 GRPO 应用于后训练,并在高分辨率图像生成方面取得了显著的性能;为了增强对空间关系和数值一致性等细粒度属性的遵循,FocusDiff构建了仅在细微属性变化上存在差异的配对数据集,并利用它们来训练生成模型;RePrompt在图像生成框架中整合了一个额外的多模态理解模型,并使用 GRPO 对其进行训练以优化提示;T2I-R1、GoT-R1和ReasonGen-R1将提示优化和图像生成统一在一个模型中,利用 GRPO 进行联合优化; - RL in Video Generation:与图像生成相比,将强化学习扩展到视频生成在时间连贯性和物理真实感方面面临更大的挑战。

DanceGRPO在HunyuanVideo上进行后训练,并使用VideoAlign提供基于视频美观度、运动质量和文本-视频一致性的奖励;Inf LVG使用 GRPO 根据上下文相关性指导 token 选择,从而实现语义一致且时间连贯的长视频生成;Phys-AR引入速度和质量作为球运动场景的可验证奖励,显著增强了视频生成的物理真实感;

目前,一些超长学习模型 (ULM) 采用统一的框架来同时优化多模态理解和生成。为此,提出了 从文本到图像以及从图像到文本的双向和双重奖励机制,以增强生成和理解能力。在多模态理解方面,Deepeyes 和 CoF 尝试使用生成模型或外部工具来实现多模态语义理解 (CoT)。对于多模态生成,使用精炼文本作为语义理解 (CoT) 也依赖于多模态理解能力。因此,探索统一的多模态理解和生成后训练方法是未来研究的紧迫任务。从特定领域的角度来看,代码生成可以作为文本生成和图像生成之间的桥梁。强化学习 (RL) 的应用有助于模型推理复杂图表并为特定领域的图像生成生成结构化代码,这是一个很有前景的应用。

6.4 Multi-Agent Systems

目前,基于 LLM 推理的强化学习研究主要集中在单一模型上,而将 RL 应用于多智能体系统 (MAS) 已成为一个突出的前沿研究方向。本节首先概述传统 RL 和多智能体 RL (MARL) 的基本概念,并重点介绍它们面临的主要挑战。此外,本节还讨论了 LLM 在 MARL 中的创新应用,强调了其在信息共享和信用分配方面的优势。最后,本文将探讨 RL 与 LLM 集成的 MAS 的最新进展,重点探讨如何利用 RL 来增强智能体之间的协作和策略优化,从而促进多智能体推理能力的发展。

Traditional MARL

近年来,多智能体系统(MAS)作为一种复杂的分布式智能系统,在强化学习(RL)领域引起了广泛关注。传统的多智能体系统(MARL)主要关注共享环境中多个智能体的交互和联合学习,以实现全局目标。传统MARL的主要挑战包括信用分配的复杂性、环境的非平稳性以及智能体之间沟通与协作的效率。为了解决这些问题,研究人员提出了一种集中训练与分散执行(CTDE)范式,其中智能体在训练阶段共享全局信息以进行策略优化,而在执行阶段的决策仅依赖于局部观察。基于 CTDE 范式,研究者引入了基于价值的方法(例如 VDN 和 QMIX)、基于策略梯度的方法(例如 MADDPG)以及 Actor-Critic 方法(例如 COMA)。此外,由于 PPO 被认为是传统强化学习中的 SOTA,MAPPO 在一些简单的协作任务中也被证明具有令人惊喜的效果。然而,随着智能体数量的增加和任务复杂度的上升,传统的 MARL 方法在样本效率和可扩展性方面面临着巨大的挑战。为了解决这个问题,学者们考虑在与所有智能体的交互中用邻近智能体替换当前智能体(例如 MF-MARL),这有效地缓解了 MARL 中由于智能体数量增加而导致的维数灾难。然而,它仍然无法有效地应用于需要多个智能体同时协作的复杂任务场景。

LLM for MARL

LLM 的快速发展在解决 MARL 中的挑战方面展现出巨大的潜力。凭借其强大的自然语言理解和生成能力,LLM 可以为 MAS 提供有效的信息共享机制。例如,在 MARL 的信用分配问题中,研究人员利用 LLM 设计直观的奖励分配机制,从而提高信用分配的准确性和可解释性。Zhang 等通过 使 LLM 能够实时推断每个智能体的意图并生成下一个合作计划,显著提升了稀疏奖励场景下多智能体协作的效率;Ding 等 利用 LLM 将自然语言任务描述解析为可执行的实体级子目标,从而实现奖励塑造和策略共享,有效缓解了 MARL 中的信用分配问题;Li 利用 LLM 的 “theory of mind”能力,使智能体能够生成关于队友潜在策略的语言信念,从而实现更精准的多智能体协调决策。

RL for LLM-based MAS

在强化学习与LLM融合的背景下,基于LLM的MAS研究逐渐成为热点。相关研究主要关注如何充分利用LLM的语言理解和生成能力,同时利用强化学习实现多智能体之间的高效协作和策略优化。LLaMAC 和 CTRL 等框架将 LLM 与 actor-critic 架构相结合。LLaMAC 采用集中式 LLM-Critic 为多个 LLM-Actor 提供基于自然语言的价值反馈,从而促进多智能体之间的协作学习;CTRL 利用合成数据训练LLM进行“自我批评”,并通过强化学习(例如GRPO)迭代地改进模型输出,从而在无需人工标注的情况下提升测试时性能。

在大规模多智能体协作场景中,MAPoRL通过联合训练多个 LLM 并引入推理感知奖励,促进了多轮任务中高效且可迁移的协作;MAGRPO 将 LLM 协作建模为一个合作型多智能体强化学习问题,提出了一种群体级别的相对策略优化机制,显著提升了写作和代码生成等任务中多轮联合输出的质量;ReMA 引入了高级智能体和低级智能体的双 LLM 结构,通过交替冻结和更新策略,实现了元思维和推理能力的协同增强;JoyAgents-R1 设计了一种联合进化训练流程,通过交替进行全局经验回放和个体 PPO 更新,促进异构 LLM 团队在开放域问答任务中的多样性和一致性;AlphaEvolve 设计了一种进化优化机制来协调多 LLM 协作;通过直接修改代码并持续接收评估反馈,MAS 增强了处理复杂编码任务的能力;AutoAgents 通过动态生成根据任务需求定制的专用代理,并引入观察者角色进行反思和改进,显著增强了 MAS 在复杂任务中的适应性和问题解决能力。

6.5 Robotics Tasks

RL in Robotics Tasks

强化学习 (RL) 在机器人技术领域得到了广泛的应用,主要集中在三个领域:机器人控制、视觉与语言导航 (VLN) 以及 机器人操控任务。传统的强化学习在机器人控制领域的研究已经成熟,并获得了广泛的应用,例如类人机器人的动作生成、稳健的四足动物运动执行以及灵巧的手部操控。同样,VLN 任务也取得了显著进展。然而,这些领域在模型架构、规模、任务类型、奖励函数设计、优化目标和算法方法方面与基于 LLM 的强化学习存在显著差异,因此不在本综述的讨论范围之内。

机器人操控任务使机器人能够解决现实世界环境中的各种操控问题,这是具身智能最具挑战性和最基础的方面。这些任务不仅需要对视觉和文本信息的全面理解以及细粒度的运动控制,还需要物理推理、长期规划和逻辑推理能力。利用 LLM 和 VLM 卓越的文本和视觉处理能力,一些研究探索将这些模型作为核心组件,与动作模块相结合,用于操控任务,例如 RobotBrain 和 RT-2。

Vision-Language-Action Models

近年来,视觉-语言-动作 (VLA) 模型通过统一的端到端训练将 VLM 主干模型与动作模块集成在一起,已成为最具前景的解决方案,并成为机器人操控的主流方法。当前的 VLA 模型遵循两阶段范式:先使用多模态数据(例如 Open X-Embodiment)进行预训练,然后对遥控机器人轨迹进行监督微调。然而,这种模仿学习范式存在严重的局限性:其性能严重依赖于高质量的轨迹数据,而这些数据的收集成本高昂且效率低下,并且生成的模型对未知场景的泛化能力较差。鉴于 VLA 和 LLM 在架构、规模和方法上的相似性,将 LLM 风格的 RL 方法应用于 VLA 训练,为解决数据稀缺和泛化挑战提供了一个有希望的方向。

将 DeepSeek-R1 的强化学习方法应用于 VLA 需要解决几个挑战:

- 与单轮完成任务的 LLM 不同,VLA 需要多轮环境交互才能生成完整的轨迹;

- VLA 在连续的动作空间中运行;

- 传统的强化学习方法依赖于手工设定的过程奖励,限制了可扩展性;

近期的一些研究,包括 SimpleVLA RL、VLA-RL、VLA RL Generalization、RIPT-VLA 和 ConRFT,开创性地将 DeepSeek-R1 的方法应用于 VLA 训练。

SimpleVLA-RL 使 VLA 模型能够与环境交互以推出多样化的完整轨迹,采用二元成功/失败奖励作为监督信号,并使用 GRPO 算法训练 OpenVLA-OFT。仅凭一条演示轨迹,这种 RL 方法在 LIBERO 和 RobotWin2.0 基准测试中就超越了最先进的 VLA 模型,例如 π0\pi_{0}π0,实现了 SOTA 性能,并在真实机器人实验中优于先进的 RDT 模型;作为 π0\pi_{0}π0 的升级版,π0.5\pi_{0.5}π0.5 使用来自不同场景和来源的多模态机器人数据进行异构训练,使 VLA 成为可泛化现实世界机器人操作任务的新里程碑。与 DeepSeek-R1 的 “aha moments” 类似,经过强化学习训练的 VLA 也能发现新颖的行为模式;VLA RL Generalization 研究了强化学习对 VLA 泛化能力的影响,证明了其在未见过的环境、物体和纹理方面比 SFT 有显著提升,同时比较了 GRPO 和 PPO 的有效性;RIPT-VLA 采用 RLOO进行 VLA RL 训练;RLinf 为 VLA RL 设计了一个灵活、可扩展的强化学习框架,该框架将渲染、推理和训练统一起来,从而提升了 VLA 的训练效率和性能;ConRFT 通过交替进行强化学习和 SFT 循环来迭代训练 VLA,并通过多次迭代逐步提升性能。

强化学习的数据效率、更高的泛化能力以及极低的监督要求有效解决了 VLA 目前面临的数据稀缺和泛化能力差的挑战。通过允许 VLA 自主探索并从反复试验中学习,仅需结果监督,这种方法与复杂且昂贵的远程操作数据收集相比,显著降低了实施成本。此外,强化学习的数据效率消除了对大规模昂贵轨迹数据集的需求,从而实现了可扩展的 VLA 后训练能力。

然而,目前 VLA 强化学习 (VLA RL) 的研究主要基于 仿真环境。虽然 SimpleVLA RL 通过 Sim2Real 迁移实现了在现实世界的部署,但很少有研究部署实体机器人来收集用于强化学习的真实世界轨迹。此外,VLA 强化学习的研究也受到强化学习在机器人技术领域发展的限制,包括但不限于采样效率、奖励稀疏性和 Sim2Real 迁移。关键挑战包括在实体机器人上进行自主采样(需要多个设备来提高效率)、持续的手动重置和注释。

6.6 Medical Tasks

医学 LLM 中的强化学习 (RL) 优化通常旨在增强推理和泛化能力,通常采用先进行简单推理 (SFT) 再进行强化学习 (RL) 的两阶段流程。现有研究大致可分为 基于规则的奖励的可验证问题 verifiable problems with rule-based rewards,以及 基于生成式或基于规则的奖励的不可验证问题 non-verifiable problems with generative or rubric-based rewards。

Medical Understanding

这些任务,例如多项选择问答、结构化预测、临床编码或视觉基础,允许使用确定性奖励,使其成为医学 LLM 中强化学习 (RL) 最成熟的领域。典型的范例是先进行可验证推理 (SFT),然后进行强化学习 (RL) 的两阶段流程,其中诸如 GRPO 之类的算法直接针对基于正确性的信号来优化模型。例如,HuatuoGPT-o1 通过使用医学验证器合成可靠的推理轨迹数据,并使用 SFT 和强化学习 (RL) 训练模型来增强推理能力;Med-U1 采用混合二进制正确性奖励和长度惩罚,以确保准确性和格式合规性;MED-RLVR 将可验证奖励应用于多目标问答 (MCQA),从而提升了面向对象 (OOD) 的泛化能力;Open-Medical-R1 证明,仔细的数据过滤可以提高强化学习的效率;Gazal-R1 设计了一个多组件奖励系统,通过 GRPO 来改进准确性、格式遵循度和推理质量,从而增强医学推理能力;ProMed将医学 LLM 从被动模式转变为主动模式,LLM 可以在决策之前提出具有临床价值的问题,并在 MCTS 引导的轨迹探索和强化学习过程中使用 Shapley 信息增益奖励;MedGR2 引入了一个生成式奖励学习框架,该框架创建了一个自我改进的良性循环,共同开发了一个数据生成器和奖励模型,以便为 SFT 和强化学习训练自动创建高质量的多模态医学数据。

除了文本问答之外,近期模型将基于规则的奖励机制扩展到视觉和多模态任务。MedVLM-R1采用强化学习框架,通过格式和准确度奖励机制,激励模型在不使用任何推理参考的情况下发现人类可解释的推理路径;MedGround-R1 为医学影像基础任务引入了空间语义奖励机制,该机制结合了空间准确度奖励和语义一致性奖励;ARMed 通过自适应语义奖励机制解决了开放式医学视觉问答 (VQA) 中的奖励崩溃问题,该机制根据历史奖励分布在训练过程中动态调整语义奖励;Liu and Li 利用基于规则的格式和匹配奖励机制,仅使用 100 个带注释的样本,即可指导结构化 JSON 生成,从而实现医学视觉信息提取;MMedAgent-RL 是一个基于强化学习的多智能体框架,可实现医疗智能体之间的动态优化协作;MedGemma 已使用强化学习进行后训练,并在 MedXpertQA 上进行了进一步评估,MedXpertQA 是一个专家级医学多选题基准,其中包含一个用于评估推理模型的子集。

对于其他临床应用,DRG-Sapphire 将基于规则的奖励机制(GRPO)应用于诊断相关分组。EHRMIND 将 SFT 预热和 RL VR 相结合,使用电子健康记录 (EHR) 数据执行复杂的临床推理任务,包括医疗计算、患者试验匹配和疾病诊断;ChestX-Reasoner 结合临床报告中的过程奖励来训练模型,使其能够模拟放射科医生的逐步推理;CX-Mind 采用 SFT 和 RL,结合格式、结果和过程奖励,来训练胸部 X 光诊断的交错推理。为了实现基于代码的医学推理的基准测试,MedAgentGym提出了医疗代理代码生成的基准,并证明了强化学习可以提高这种推理能力。

Medical Generation

这些任务包括 放射学报告生成、多轮临床对话、治疗计划 和 诊断叙述,这些任务缺乏唯一的真实答案。因此,基于规则的奖励并不直接适用。虽然 DPO 已被用于改进偏好对齐生成任务的医学 LLM,但针对不可验证任务的大规模强化学习正在兴起,但仍然相对缺乏探索。例如,DOLA 将 LLM 代理与商业治疗计划系统相结合,并加入一个奖励函数,用于指导在目标覆盖率和危及器官保留之间进行权衡,以优化治疗计划的生成;LA-CDM 提出了一种通过混合训练范式训练的双智能体结构,该范式将监督微调与强化学习相结合,以平衡诊断准确性、不确定性校准和决策效率;在诊断对话方面,PPME 使用大规模电子病历 (EMR) 和混合训练开发了一个即插即用框架,通过专门的查询和诊断模型增强 LLM 的交互式诊断能;在临床决策支持方面,MORE-CLEAR 将多模态离线强化学习应用于脓毒症治疗策略,从而改善了 MIMIC-III/IV 中的生存预测决策。对于放射学报告生成,BoxMed-RL 在预训练阶段利用强化学习,使用格式奖励和交并比 (IoU) 奖励来确保生成的报告与像素级解剖证据相对应;Baichuan-M1 采用三阶段强化学习方法:ELO(探索性对数似然优化)用于增强思路链推理的多样性,TDPO(标记级直接偏好优化)用于解决长度相关的约束,最后是 PPO 结合奖励模型反馈进行策略优化;Baichuan-M2 引入了一种新颖的动态验证框架,超越了静态答案验证器,建立了一个大规模、高保真交互式强化学习系统,该系统包含一个病人模拟器和临床评分标准生成器,适用于真实的临床环境。

总体而言,医学 LLM 中的强化学习 (RL) 对于可验证问题已非常成熟,其中确定性正确性允许基于规则的奖励和稳定的 GRPO 训练。相比之下,面向生成的任务仍然具有挑战性:当前的解决方案采用基于规则的奖励、课程迁移或离线强化学习来近似质量信号。非可验证任务中可扩展强化学习的匮乏,凸显了构建可信、具有推理能力的医学基础模型的关键未来方向。

7. Future Directions

虽然 LLM 的强化学习取得了显著进展,但未来仍面临许多根本性的挑战和机遇。本节概述了几个有望引领该领域下一波发展的新方向。强调了 持续强化学习对于适应不断变化的数据和任务的重要性(§7.1),基于记忆和基于模型的强化学习对于增强推理能力的重要性(§7.2 和 §7.3),以及 教授LLM高效推理和潜在空间推理的新兴方法(§7.4 和 §7.5)。还讨论了在预训练过程中利用强化学习的前沿领域(§7.6),将强化学习应用于基于扩散的架构(§7.7),以及推动科学发现(§7.8)。最后,探讨了架构与算法协同设计以满足日益庞大和高效智能模型需求的挑战和前景(§7.9)。通过调查这些方向,旨在为 LLM 未来的 RL 研究提供路线图和灵感。

7.1. Continual RL for LLMs

为了提升 LLM 在基于强化学习的后训练阶段的多领域性能,主流方法是混合不同任务的数据,并以统一的方式进行训练。在合成数据上,多阶段强化学习已被证明不如使用混合数据进行训练,甚至在强化学习中,难度递增的课程学习 (Curriculum Learning) 也可能没有必要。然而,Chen 认为,跨不同任务的多阶段强化学习在推广到困难或未知问题方面具有优势。尽管关于多阶段强化学习有效性的争论仍在继续,但随着该领域朝着构建必须适应动态环境中不断变化的数据和任务的人工智能系统的方向发展,探索用于 LLM 的持续强化学习 (CRL) 变得十分必要。

与传统的连续强化学习 (CRL) 类似,LLM 也面临着在多阶段强化学习 (RL) 训练中平衡稳定性和可塑性的根本挑战。可塑性对于 LLM 来说可能尤其令人担忧,因为广泛使用的深度学习技术可能导致大型模型在持续学习环境中的表现并不比浅层网络更好。LLM 的连续强化学习 (CRL) 的另一个挑战在于 LLM 中知识和推理的纠缠性质,这与传统的强化学习 (RL) 设置不同,在传统的强化学习 (RL) 中,任务可以离散定义,策略可以模块化组织,例如在类似游戏的环境或具身场景中。

传统认知学习 (CRL) 研究的现有方法框架为满足 LLM 的特定需求提供了良好的基础。传统认知学习 (CRL) 研究的核心方法论见解包括 经验回放、策略重用 和 奖励塑造。对于开发针对学习资源管理 (LRM) 的认知学习 (CRL) 框架,这仍然是一个有价值的研究方向。开发专门针对 LLM 或 LRM 的认知学习 (CRL) 技术,对于创建更具适应性、更高效的人工智能系统至关重要,这些系统能够终身学习并在动态多变的环境中运行。

7.2. Memory-based RL for LLMs

尽管 agent 强化学习领域已有诸多研究探索了记忆机制,涵盖从外部长期存储和插入到内部记忆处理和工作记忆控制,但大多数设计仍然局限于当前任务,其泛化能力有限。正如 Silver 和 Sutton 所强调的,下一代智能体将主要从经验中学习,通过持续的交互获得技能。一个关键方向是将智能体记忆从特定任务的缓冲区转化为结构化、可重用且可在不同任务之间迁移的经验存储库,从而使记忆发展成为更广泛的适应性和终身学习的基础。这种以体验为中心的观点也与强化学习自然契合,因为智能体与其环境交互产生的数据提供了丰富的经验痕迹,可以得到有效利用。此外,尽管近期已有研究探索如何维护一个共享的经验池,以便从过去的历史中检索相关策略,并将其他智能体的经验应用于新的任务场景,但这一方向仍未得到充分探索。这里的核心挑战是如何通过强化学习,使智能体能够自动学习如何操作和管理记忆,并在不同任务之间构建和泛化经验知识。应对这一挑战对于迈向 “experience era”至关重要,届时集体交互痕迹将成为更广泛的智能体智能的基础。

7.3. Model-based RL for LLMs

强化学习的核心挑战在于如何从环境中获取可扩展且稳健的奖励信号以及有意义的状态表征。先前的研究已经探讨了构建世界模型,以便为强化学习智能体提供信息丰富的状态。最近,LLM 已被应用于各种强化学习场景。对于使用 LLM 的强化学习,尤其是对于语言智能体而言,构建能够准确捕捉环境状态并生成可靠奖励的世界模型至关重要。最近的进展表明,生成式世界模型(包括通过视频预训练增强的世界模型)既实用又有效。然而,对于基于 LLM 的智能体来说,如何将世界模型与强化学习 (RL) 无缝集成仍然是一个悬而未决的研究课题。因此,基于模型的强化学习与 LLM 的结合正成为未来研究的一个极具前景且可扩展的方向。

7.4. Teaching LRMs Efficient Reasoning

推理时间扩展提高了 LRM 在困难任务上的准确性,但也引入了系统性的过度思考(对简单实例进行不必要的长推理链),并且在激进截断的情况下,会导致思考不足(过早停止和依赖脆弱的捷径)。RL-for-LLM 的一个核心挑战是开发计算分配策略,使推理的深度和停止适应实例难度和认知不确定性。目前的研究已经探索了提示中的硬编码推理级别、基于长度的自适应奖励塑造,以及在损失函数中使用长度惩罚。

然而,将这些方法推广到原则性的成本效益权衡中仍然是一个悬而未决的问题。教会语言推理模型 (LRM) 具有资源理性,仅在边际效用允许的情况下进行更长时间的推理,仍然是强化学习在语言推理领域的核心且尚未解决的问题。

7.5. Teaching LLMs Latent Space Reasoning

认知推理(CoT)通过促使模型清晰地表达中间步骤来鼓励逐步推理,从而提高可解释性和准确性。近期研究将认知推理与强化学习相结合,以进一步提升推理质量,即在回答问题之前对长篇思维进行采样,以进行建模训练。然而,当前的实现通常依赖于离散标量空间中的 tokens 级采样,这可能会成为瓶颈,因为连续空间中有意义的语义信息会丢失。最近提出的一种名为潜在空间推理 (LSR) 的方法可能更利于强化学习的优化。LSR 在 LLM 的连续潜在空间中进行推理,从而实现更细致、更流畅的语义推理。这一特性有助于提升学习动态,并使其与强化学习技术更好地融合。强化学习与 LSR 的结合,在未来开发更强大、适应性更强的推理模型方面具有巨大的潜力。然而,评估连续潜在思维的质量比评估基于 tokens 的思维更具挑战性。这将使提供准确的监督信号(例如奖励和优势)变得更加复杂,这将成为 LSR 与强化学习结合面临的挑战。

7.6. RL for LLMs Pre-training

传统的预训练依赖于大型文本语料库和下一个 token 预测,而扩展这一范式已被证明是开发基础模型的关键。如今,新兴研究正在探索将强化学习迁移到流程的早期阶段,不仅将其应用于训练后阶段,还将其应用于预训练本身。例如,强化学习预训练将下一个 token 预测重新定义为一个强化学习问题,并从语料库中获得可验证的奖励,并报告了随着可用计算能力的增加而持续增加的收益,从而将强化学习定位为一种有前景的预训练扩展策略。

与此同时,诸如 avataRL 之类的开源项目展示了如何纯粹利用强化学习 (RL) 从随机初始化开始训练语言模型,引导令牌级奖励并采用迭代 “referee” 评分,从而阐明了一条通往从零开始进行强化学习 (RL-from-scratch) 训练的具体路径。这与复兴的强化学习 (RL) 范式相一致,在该范式中,利用先前获得的计算知识(预训练的批评家),而不是从头开始训练。这些发展提出了一个实际问题:如何使强化学习 (RL) 式预训练在规模上具有成本效益?应对这一挑战可能需要同时降低验证者的负担和奖励工程相关的成本,而这似乎对于扩展基于强化学习的预训练至关重要。此外,这方面的研究与第 3.1.4 节中引入的无监督奖励设计密切相关,这提出了关于如何获得既可扩展又可靠的奖励的重要问题。

7.7. RL for Diffusion-based LLMs

扩散大型语言模型 (DLLM) 代表了语言生成领域的一种新兴范式。与自回归 (AR) 模型相比,DLLM 的优势包括更高的解码效率,以及通过多轮扩散实现自我修正的更大潜力。目前,人们已开始探索 DLLM 的强化学习,但仍有几个关键问题尚未解决。

将强化学习应用于 DLLM 的核心挑战在于准确高效地估计采样响应的对数概率。这是由于自回归模型和扩散语言模型在对样本似然性进行建模的方式上存在根本差异。自回归模型通过预测下一个标记生成序列,并通过链式法则分解联合概率,从而实现简单的从左到右采样。然而,DLLM 通过最大化证据下界 (ELBO) 来近似似然优化。ELBO 涉及对扩散时间步长和掩码数据的双重期望,并且通常需要大量采样才能获得准确的估计;否则,它会在偏好优化过程中引入高方差。尽管已经提出了诸如中的一步估计器和中的采样分配策略等方法来减轻方差,但高效准确的 ELBO 估计仍然是在线策略学习的一个悬而未决的问题。

此外,DLLM 中存在多种可行的解码轨迹,这引入了一个额外的研究维度:利用强化学习引导模型找到最优采样轨迹。这需要为中间去噪步骤设计有效的奖励函数。例如,He 将去噪表述为一个多步骤决策问题,并将奖励模型应用于中间状态;Wang 提出了一种基于扩散的价值模型,该模型计算前缀条件的、基于标记的优势,以实现轨迹级奖励;Song 等人利用基于编辑距离的奖励来最大化解码效率。未来的研究也可能从为计算机视觉中的连续扩散模型开发的强化学习技术中汲取灵感,从而有可能为统一的多模态框架铺平道路。

7.8. RL for LLMs in Scientific Discovery

最近的研究表明,强化学习可以提升 LLM 在推理繁重的科学任务上的表现,在某些情况下甚至超越专门的方法。在生物和化学等领域,强化学习的核心挑战在于大规模地进行结果验证,而这一过程通常依赖于湿实验室实验。现有的一些方法侧重于替代或补充实验验证:Pro-1 使用 Rosetta 能量函数作为奖励函数来优化蛋白质稳定性,而 rbio1 使用生物模型和外部知识源来验证基因扰动的结果预测。

在奖励制定和改进预言机模型本身方面,仍有许多探索空间。与此相关的是构建合适的强化学习环境以支持快速实验-反馈循环的更广泛问题。诸如 Coscientist 和 Robin 之类的代理系统已通过实验室在环验证获得成功,但此类稀疏、延迟且成本高昂的反馈信号对于直接训练底层的 LLM 而言并不切实际。实验环境的计算机模拟,例如细胞水平的扰动响应预测,代表了一条潜在的发展方向。然而,由于应用范围有限且严重缺乏准确性和通用性,许多此类系统远不足以取代真实的实验室环境。其他研究方向则探索将特定领域模型融入 LLM 训练中,以处理科学数据,并开发能够执行一系列明确定义任务的通用模型。这些方向,加上通用强化学习方法论的进步,将继续拓展 LLM 的用例,从狭义任务扩展到具有开放式目标的复杂交互,使其能够更有效地促进新发现。

7.9. RL for Architecture-Algorithm Co-Design

目前,大多数用于 LLM 的强化学习流程都假设采用密集的 Transformer或混合专家 (MoE)作为主干网络,用于优化几乎完全与任务准确率相关的奖励。因此,架构自由度及其对硬件的影响被排除在学习循环之外。与此同时,新一轮硬件架构协同设计浪潮应运而生(例如,DeepSeek 的 NSA中与硬件对齐的稀疏注意力机制,以及步骤 3 中的模型-系统协同设计),这表明,通过将模型结构与计算基础对齐,可以实现更高的效率和性能。

作者认为,将架构打造为强化学习中的一流行动空间,对下一代 LLM 来说是一项开放且影响深远的挑战。例如,强化学习的 MoE 方法可以使模型在强化学习过程中学习路由策略、专家激活、容量分配或稀疏模式,不仅针对任务奖励进行优化,还能针对延迟、内存流量、能耗和激活预算等硬件感知目标进行优化。在此框架下,强化学习的任务不仅是学习对 token 进行 “reason”,还要学习跨参数和模块进行推理,从而根据每个问题的难度和实时计算约束动态调整模型拓扑。这种视角超越了经典的基于强化学习的神经架构搜索 (NAS),后者通常针对给定任务或数据集找到固定的架构。相比之下,增强型多目标学习 (MoE) 侧重于优化推理过程中每个输入的路由和模块自适应,从而可能同时提高效率和灵活性。关键的待解决问题包括:**设计稳健的多目标奖励函数以避免出现琐碎的解(例如,全专家稀疏性);在架构操作修改网络拓扑时实现稳定的信用分配;以及 在提示、任务和部署规模之间摊销架构策略学习。应对这些挑战对于在未来的 LLM 中实现真正集成的架构-算法协同优化至关重要。

8. Conclusion

本文综述了强化学习在 LRM 领域的最新进展,尤其侧重于推理能力,从而有效地将 LLM 转化为 LRM。与 RLHF 或 DPO 等主要用于人类对齐的先前方法相比,重点是针对 LLM 的强化学习虚拟学习 (RLVR)。RLVR 通过提供直接的结果级奖励来增强 LLM 的推理能力。首先,介绍 RLVR 的核心组件,包括奖励设计、策略优化和采样策略,总结了每个部分的多个研究方向和现有工作;然后,讨论了 LLM 强化学习训练中几个最受争议的问题;此外,还介绍了 LLM 强化学习的训练资源,涵盖静态数据集、动态环境和强化学习基础设施;最后,回顾了强化学习在 LLM 中在不同场景下的下游应用,并重点介绍了几个旨在通过基于强化学习的 LLM 实现超级智能的有前景的研究方向。