视频重新照明新突破!北大中科大浙大等提出重照明方法Lumen:一句话让视频秒变电影级光影。

由北京大学、Kunbyte AI、中国科学院大学、浙江大学、杭州师范大学等联合提出的重照明方法Lumen,是基于大规模视频生成模型的端到端视频重新照明框架,可接收文本描述指导照明和背景控制。鉴于高质量配对视频稀缺,构建了混合真实与合成视频的大规模数据集,合成领域利用 3D 渲染引擎,现实领域采用 HDR 光照模拟。基于此设计联合训练课程,注入领域感知适配器,还构建基准测试与现有方法对比。Lumen 能生成电影级重新光照视频。

相关链接

论文: http://arxiv.org/pdf/2508.12945v1

项目: https://lumen-relight.github.io

模型:https://huggingface.co/Kunbyte/Lumen

试用:https://huggingface.co/spaces/Kunbyte/Lumen

论文阅读

视频重新照明是一项具有挑战性但很有价值的任务,旨在替换视频中的背景,同时相应地调整前景的照明并与背景和谐融合。在转换过程中,必须保留前景的原始属性(例如反照率),并在时间帧之间传播一致的重新照明。虽然以前的研究主要依赖于 3D 模拟,但最近的研究利用扩散生成模型的泛化能力来实现可学习的图像重新照明。

论文提出的Lumen是一个基于大规模视频生成模型开发的端到端视频重新照明框架,它接收灵活的文本描述以指导对照明和背景的控制。考虑到在各种光照条件下具有相同前景的高质量配对视频的稀缺性,构建了一个混合了真实视频和合成视频的大规模数据集。对于合成领域,受益于社区中丰富的 3D 资源,利用先进的 3D 渲染引擎来策划不同环境下的视频对。对于现实领域采用基于 HDR 的光照模拟来弥补自然场景视频配对的不足。

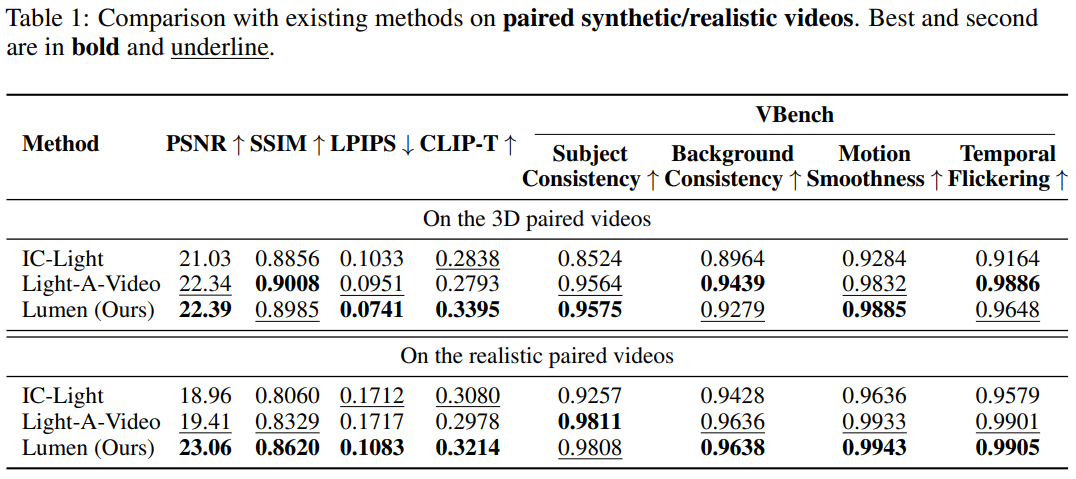

基于上述数据集,作者设计了一个联合训练课程,以有效发挥每个领域的优势,即合成视频的物理一致性和现实视频的广义领域分布。为了实现这一点,我们在模型中注入了一个领域感知适配器,以解耦重新光照和领域外观分布的学习。我们构建了一个全面的基准测试,从前景保留和视频一致性评估的角度,将 Lumen 与现有方法进行评估。实验结果表明,Lumen 能够有效地将输入编辑成具有一致光照和严格前景保留的电影级重新光照视频。

数据准备

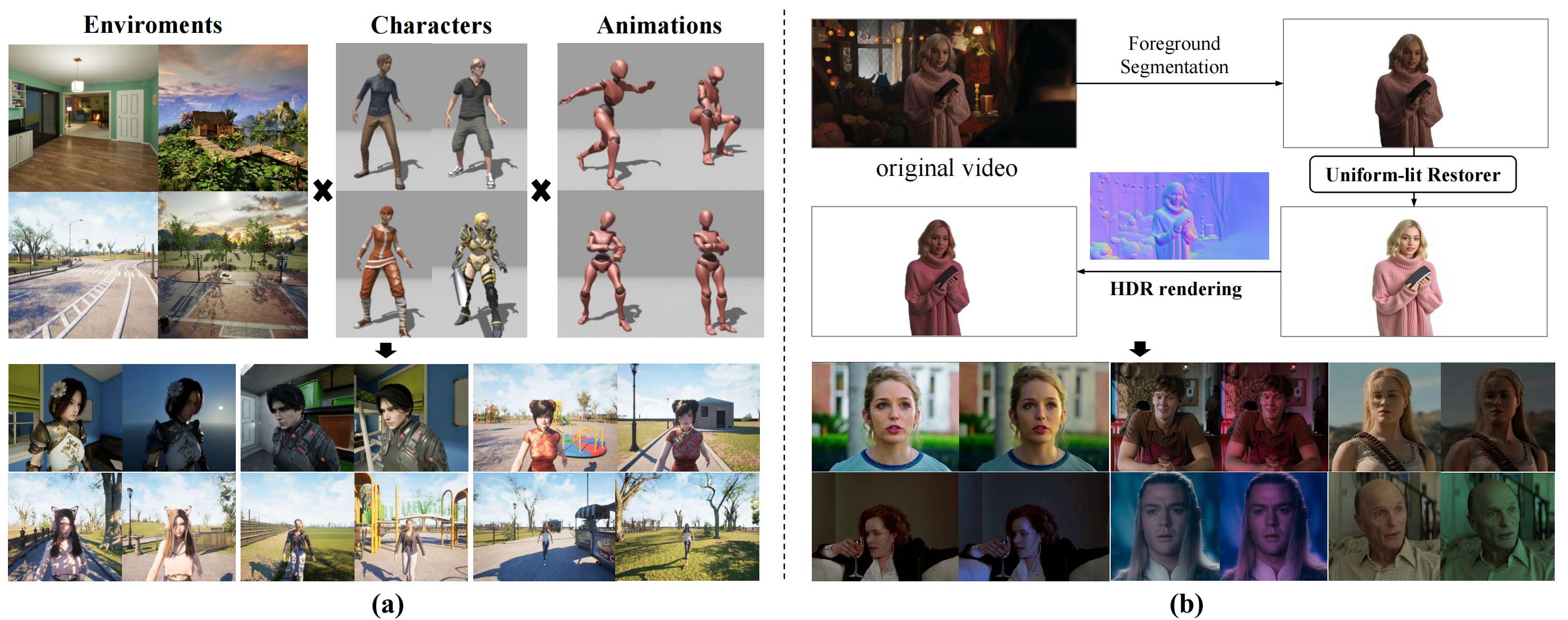

两个领域的数据准备和示例。(a)3D 渲染数据结合各种环境、角色和动画,形成具有对齐前景的配对视频。(b)逼真的视频被转换为均匀照明的外观,并使用基于 HDR 的重新照明进行渲染。

方法概述

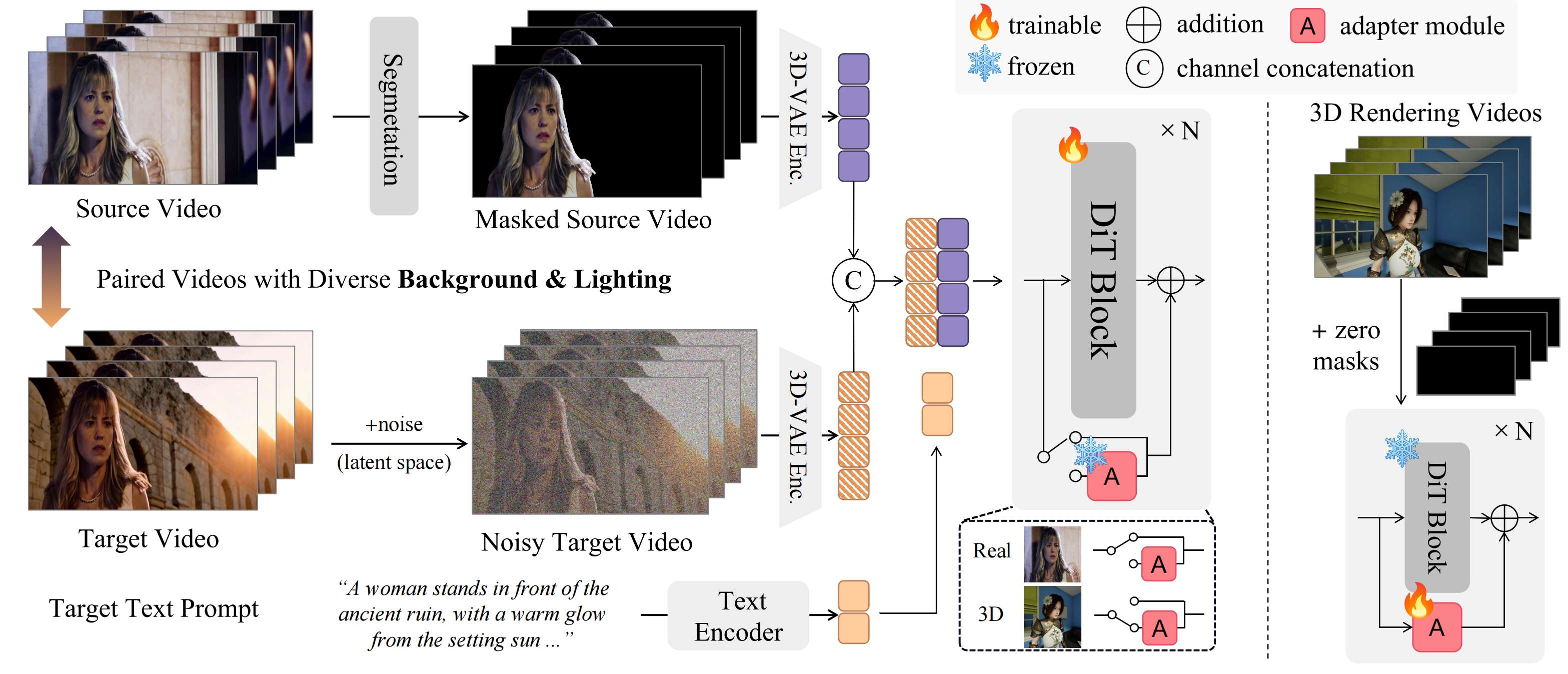

Lumen 的框架基于 DiT 架构的视频生成模型开发。该模型使用带噪声的 token 和带掩码的输入视频的串联。在主干网络中注入了一个适配器模块,用于解耦 3D 配对视频中的风格分布。

实验结果

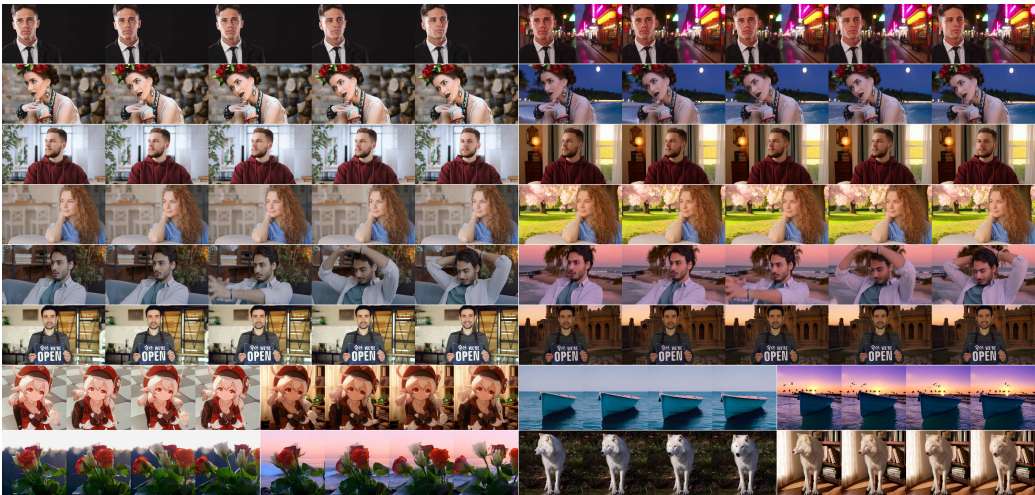

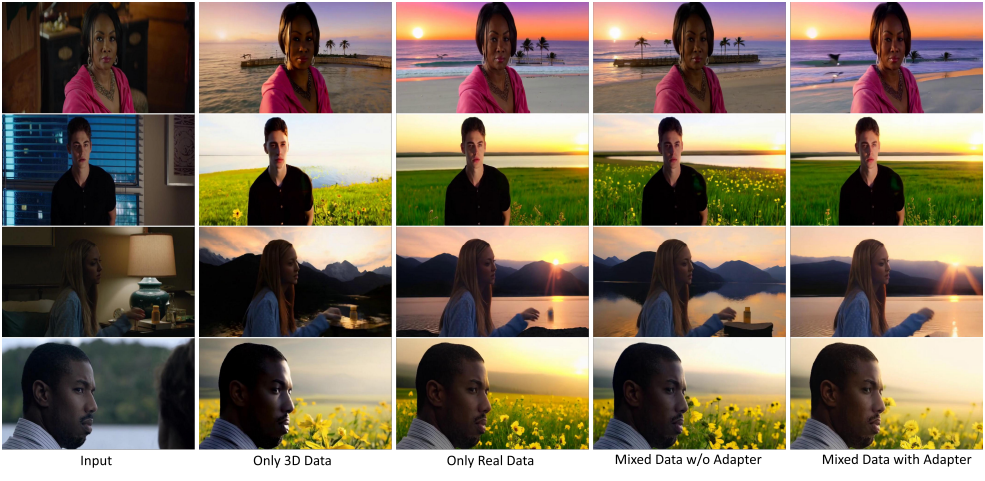

定性比较:在构建的基准上对 Lumen 与现有方法进行定性比较。四个案例的文本提示从上到下依次为:(1) 一名男子身处昏暗的房间,房间内有蓝色灯光和霓虹灯;(2) 一名男子在房间里,自然光,王家卫风格;(3) 一名男子在房间里,自然光;(4) 一名女子拍手,自然光,温暖的氛围。

定性消融研究:纯三维数据的结果光照效果较好,但前景保留效果较差。纯真实数据的结果光照一致性可能不理想。Lumen(带适配器的混合数据)在前景保留和光照协调方面均取得最佳效果。

结论

论文提出了基于大规模视频生成模型的视频光照重现模型 Lumen,该模型支持基于文本的光照和背景替换指导。为了解决缺乏成对光照重现视频的问题,我们构建了一个包含 3D 渲染和增强现实视频的多领域数据集。我们通过将输入视频的前景扩展至预训练视频生成模型的输入来调整模型。为了充分利用构建的数据集,设计了一个领域混合训练课程,其中注入了一个风格适配器模块,以帮助解耦渲染数据的领域分布。此外,我们还提供了一个全面的基准测试,在合成/现实领域中使用成对/非成对视频,并提出了新的指标来检验前景保留的效果。定性和定量比较均证明了 Lumen 与现有方法相比的有效性,Lumen 能够生成具有一致前景保留和时间光照重现效果的电影级视频。