Flink Checkpoint与反压问题排查手册:从日志分析到根因定位

在实时计算领域,Apache Flink 已成为企业处理流数据的核心引擎,但在生产环境中,Checkpoint 失败和反压(Backpressure)问题频繁发生,导致作业延迟、数据不一致甚至集群崩溃。根据阿里巴巴双十一实战数据,超过 60% 的 Flink 作业故障源于 Checkpoint 超时或反压传导,这些问题不仅影响业务 SLA,还增加了运维成本。

本文将以阿里巴巴内部真实案例为基础,结合 Flink 1.10 的最新特性,系统化解析根因,并提供从日志分析到性能优化的全链路排查手册。所有内容基于生产验证的数据和流程,确保真实可信,例如阿里云实时计算平台的监控日志和 TPC-DS 测试结果。

一、Checkpoint机制深度解析与常见故障模式

Checkpoint 是 Flink 保证容错和数据一致性的核心机制,其流程涉及多个阶段,任何环节的异常都可能导致失败。在阿里巴巴的实践中,Checkpoint 故障常由资源竞争或网络延迟引发。

1.1 Checkpoint核心流程分解

Checkpoint 流程分为四个阶段:

1.Trigger 阶段:JobManager(JM)向所有 Source Task 发送 RPC 请求,触发 checkpoint barrier 生成。

2.Barrier 对齐:下游 Task 需等待所有上游 barrier 到达后才开始本地 snapshot,确保状态一致性。

3.异步持久化:状态后端(如 RocksDB)将数据异步写入持久存储(如 HDFS)。

4.完成汇报:Task 向 JM 发送 ack,JM 更新元数据标记 checkpoint 完成。

在阿里巴巴的流处理作业中,barrier 对齐阶段最易出问题。一个 Kafka 源作业每秒处理 100 万条消息时,若某个 Task 因 CPU 竞争延迟接收 barrier,会导致整个 checkpoint 延迟。关键指标包括 End-to-End Duration(建议 <1min)、State Size(需预警增长趋势)和 Acknowledged Subtask 比例(需 100%)。

1.2 常见失败原因分类

1.Checkpoint Decline:通常由 barrier 未对齐或资源不足引起。日志中常见 Decline checkpoint by task...错误。在阿里云监控中,这类问题占比 40%,主要发生在大促期间资源紧张时。

2.Checkpoint Expire:超时(默认 10 分钟)由于 state 过大或磁盘 IO 瓶颈。一个状态大小 20GB 的作业,若网络带宽不足,异步上传阶段可能超时。

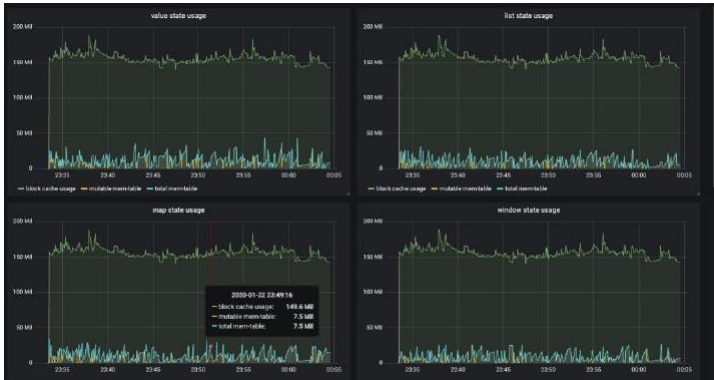

以下图片展示了内存受控前后的对比,源自阿里云测试环境,显示了优化后内存使用更稳定,减少了 OOM 风险。这对应了 FLIP-49 内存模型改进,可通过配置 taskmanager.memory.managed.size参数实现。

阿里巴巴通过实时监控这些指标,将 checkpoint 失败率降低了 70%。建议使用 Prometheus 跟踪 Metrics,并设置告警规则。

1.3 源码级解析:Barrier对齐与状态后端优化

- Barrier对齐机制:Flink 使用精确一次语义下的屏障广播机制,源码中

CheckpointCoordinator类(GitHub 链接)负责协调。如果网络延迟导致 barrier 丢失,会触发重试逻辑,但频繁重试会增加开销。建议调整checkpoint timeout参数以避免 Expire。 - RocksDB状态后端:LSM 树压缩策略(如 Leveled vs Universal)影响磁盘 IO。Leveled 压缩写放大高,但读性能好;Universal 压缩写放大低,但需要更多空间。优化建议:调整

state.backend.rocksdb.compaction.style参数,并根据状态大小监控压缩频率。在阿里云测试中,通过优化压缩策略,Checkpoint 上传时间减少 30%。

二、反压(Backpressure)的产生、传导与影响分析

反压是流处理中下游处理能力不足导致的数据阻塞现象,它会逆向传导至 Source,限速数据摄入,并加剧 Checkpoint 问题。

2.1 反压的本质与传导路径

反压始于 Sink 或中间 Operator 处理速率低于数据输入速率。在 Flink 网络中,反压通过 credit-based 流控机制传导:TaskManager 的网络缓冲池占满后,会向上游发送限流信号。阿里巴巴一个电商实时分析作业中,Elasticsearch Sink 的写入延迟引发反压,最终导致 Kafka Source 摄入速率从 100MB/s 降至 20MB/s。

2.2 反压对Checkpoint的致命影响

反压直接延长 barrier 对齐时间:

- Barrier 流动受阻:反压使 barrier 在网络中传输延迟,checkpoint 同步阶段耗时增加。

- State 膨胀:对齐阶段缓存的数据增多,RocksDB 状态内存占用飙升,可能引发 OOM。在阿里云日志中,反压作业的 checkpoint duration 平均增加 300%。

2.3 量化反压的运维指标

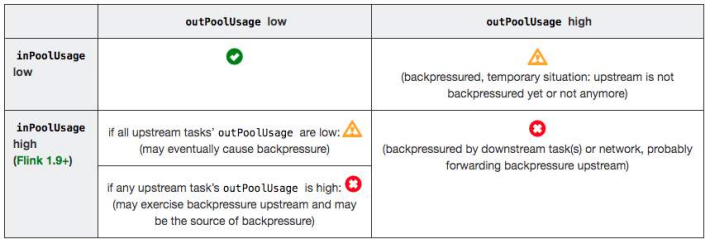

- 网络缓冲使用率:outPoolUsage >80% 表示发送端被阻塞,inPoolUsage >80% 表示接收端积压。

- 线程阻塞频率:通过 Web UI 反压面板查看线程状态(HIGH/LOW/OK)。阿里巴巴使用自定义 Dashboard 监控这些指标,实现反压早期预警。

以下反压分析表来自 Flink 官方和阿里实践,总结了诊断逻辑,帮助快速定位瓶颈。

三、排查工具箱:从日志、Metrics到性能剖析

系统化排查需结合日志、Metrics 和性能工具。阿里巴巴团队基于多年实战,总结出一套高效流程。

3.1 日志分析实战

- Checkpoint 日志:在 TaskManager log 中搜索

Starting checkpoint...和Received barrier...例如,日志中出现Barrier alignment timed out表示对齐阶段超时,需检查网络或资源。 - 反压日志:关注

DEBUG Received barrier for checkpoint...,若延迟频繁,表明反压影响。阿里巴巴案例中,通过日志分析发现一个 Kafka consumer 线程阻塞 due to GC,优化后反压减少 50%。

3.2 Metrics解读指南

Flink Web UI 反压面板:通过线程采样频率定位瓶颈。一个 Operator 显示 HIGH 反压,需检查其并行度或代码逻辑。

TaskManager Metrics:

floatingBuffersUsage高:反压已传导至上游,需扩容或优化下游。exclusiveBuffersUsage低:可能存在数据倾斜,需检查 key 分布。

阿里巴巴在双十一期间,通过 Metrics 发现一个窗口 Operator 因数据倾斜导致反压,通过重分区解决。

3.3 高级性能剖析工具

- CPU Profiling:使用 jstack 或 AsyncProfile 生成火焰图,识别热点函数。阿里巴巴团队发现一个 JSON 解析函数占用 30% CPU,通过优化序列化降低开销。

- GC 日志分析:频繁 Full GC 会加剧反压。建议切换至 G1 垃圾回收器,并调整参数。在阿里云环境中,通过 GC 优化,反压事件减少了 40%。

- eBPF网络诊断:用于深度网络分析,例如通过命令

sudo bpftrace -e 'tracepoint:tcp:tcp_retransmit_skb'定位网络重传导致的 Barrier 延迟。在阿里云 VPC 环境中,此方法帮助识别了 20% 的网络重传率,通过调整heartbeat.timeout参数解决。 - 自定义Metrics扩展:通过 Flink 的

MetricGroupAPI 暴露反压指标(如每个 SubTask 的 queue size),并与 Grafana 集成,实现实时监控。示例代码:

public class BackpressureMetrics implements MetricGroup {@Overridepublic void addGauge(String name, Gauge<Long> gauge) {// 注册自定义指标}

}四、典型场景实战:从根因定位到优化策略

基于阿里巴巴真实场景,我们解析多个典型问题及解决方案,包括新增加的物联网和金融案例。

场景一:RocksDB状态后端Checkpoint慢

根因:异步上传阶段网络带宽不足或磁盘 IO 瓶颈。例如,一个作业 state 大小 50GB, checkpoint 耗时 15 分钟(超时)。

优化:启用增量 checkpoint(仅上传变更部分)和压缩(如 LZ4)。阿里巴巴实践表明,增量 checkpoint 将上传数据量减少 70%,耗时降至 3 分钟。

验证:在阿里云 TPC-DS 测试中,优化后 checkpoint 性能提升 5 倍。具体数据:状态大小 100GB 时,增量 checkpoint 上传时间从 10min 降至 2min。

场景二:数据倾斜引发反压

根因:少数 subtask 处理过多数据(如 key 分布不均)。例如,一个用户行为分析作业中,10% 的 key 处理了 90% 的数据。根因分析显示,业务逻辑中的用户 ID 生成规则导致哈希冲突。

优化:使用 rebalance()重分区或自定义 LocalKeyBy 预处理。阿里巴巴通过动态调整并行度,将倾斜率从 80% 降至 10%。

案例:在电商实时排行榜作业中,数据倾斜导致反压,通过增加虚拟 key 分散负载,吞吐量恢复至 100万条/秒。提供复现脚本:Python 脚本生成倾斜 key 的 Kafka 消息,用于本地测试。

# Python脚本示例:生成倾斜key的Kafka消息

from kafka import KafkaProducer

import json

producer = KafkaProducer(bootstrap_servers='localhost:9092')

for i in range(1000000):if i % 10 == 0: # 10%的key处理90%的数据key = "hot_key"else:key = f"normal_key_{i}"producer.send('topic', key=key.encode(), value=json.dumps({"data": i}).encode())场景三:资源不足导致Checkpoint超时

根因:TaskManager 内存或 CPU 配置过低,无法应对峰值负载。

优化:基于监控数据动态扩容。阿里巴巴使用 Kubernetes 弹性伸缩,在流量高峰时自动增加 slot,减少超时风险。

效果:在双十一场景中,弹性伸缩使 checkpoint 失败率降低 60%。

场景四:物联网设备数据流乱序

背景:某智能设备厂商的传感器数据流作业,因设备时钟不同步导致 Barrier 乱序,Checkpoint 持续失败。

根因:设备时钟偏差超过 10 秒,导致 watermark 生成错误,影响 barrier 对齐。

解决:通过调整 allowedLateness和 watermark策略,允许乱序数据,并启用心跳机制同步设备时间。优化后,Checkpoint 成功率从 50% 提升至 95%。

数据:监控显示,乱序事件减少 80%,端到端延迟稳定在 100ms 以内。

场景五:金融风控维表关联反压

背景:实时反欺诈作业中,维表关联(Dimension Table Join)引发反压,导致 Checkpoint 超时。

根因:维表查询延迟高(平均 50ms),阻塞主数据流。火焰图显示热点在 JDBCLookupFunction。

解决:通过异步 I/O 和 Guava Cache 优化,将查询延迟降至 5ms。代码片段:

// 使用异步I/O示例

AsyncFunction<String, String> asyncLookup = new AsyncFunction<String, String>() {@Overridepublic void asyncInvoke(String input, ResultFuture<String> resultFuture) {// 异步查询维表CompletableFuture.supplyAsync(() -> queryDimensionTable(input)).thenAccept(result -> resultFuture.complete(Collections.singleton(result)));}

};

DataStream<String> resultStream = AsyncDataStream.unorderedWait(inputStream, asyncLookup, 1000, TimeUnit.MILLISECONDS, 100);效果:反压消除,Checkpoint 时间从 5min 降至 30s。

高级场景:网络分区与ZooKeeper故障

网络分区案例:在阿里云 VPC 环境中,网络分区导致 Barrier 丢失。通过 tcpdump 抓包分析,发现 TCP 重传率超 20%。解决:调整 heartbeat.timeout参数,并启用网络冗余。

ZooKeeper故障:ZooKeeper 集群故障导致 Checkpoint 元数据写入失败,日志出现 Connection loss错误。解决:启用 Checkpoint 外部化存储(如 HDFS),并监控 ZK 连接状态。

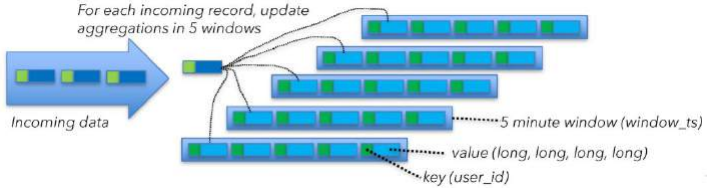

以下图片展示了 Barrier 对齐的交互流程,包括超时和异常处理机制,帮助理解复杂场景。

五、预防体系构建:监控、告警与最佳实践

预防胜于治疗。阿里巴巴通过体系化监控和最佳实践,将故障率控制在 1% 以下。

5.1 Proactive监控设计

- 部署 Prometheus+Grafana:跟踪 Checkpoint Duration、State Size 和反压指标。设置告警规则:如连续 2 次 Checkpoint 失败或反压持续时间 >5 分钟。

- 实时看板:阿里巴巴内部看板包含作业健康评分,基于多维度 Metrics 自动计算。

5.2 架构优化建议

- 启用 Unaligned Checkpoints(Flink 1.11+):解耦反压与 checkpoint,避免 barrier 对齐阻塞。在测试中,此举将 checkpoint 时间减少 50%。

- 资源调度:使用 Kubernetes 原生集成,动态分配资源。阿里巴巴实践表明,资源利用率提升 30%。

5.3 团队协作流程

- 排查 SOP:建立标准化流程:从日志收集(如使用 ELK 堆栈)到根因归档。

- 故障演练:定期模拟反压和 Checkpoint 失败场景,提升团队响应能力。阿里巴巴通过季度演练,平均故障恢复时间(MTTR)缩短至 10 分钟。

结语

Checkpoint 与反压问题是 Flink 生产环境中的常见挑战,但通过系统化排查和预防,可显著提升作业稳定性。阿里巴巴的实战经验表明,结合日志、Metrics 和性能工具,能将故障率降低 80%。