深入MySQL底层2-SQL优化与数据库运维管理

1.SQL优化

1.1 插入数据优化

1.1.1 insert语句优化:

如果我们需要一次性往数据库表中插入多条记录,可以从以下三个方面进行优化:

1). 优化方案一

批量插入数据

Insert into tb_test values(1,'Tom'),(2,'Cat'),(3,'Jerry');2). 优化方案二

手动控制事务

start transaction;

insert into tb_test values(1,'Tom'),(2,'Cat'),(3,'Jerry');

insert into tb_test values(4,'Tom'),(5,'Cat'),(6,'Jerry');

insert into tb_test values(7,'Tom'),(8,'Cat'),(9,'Jerry');

commit;3). 优化方案三

主键顺序插入,性能要高于乱序插入

主键乱序插入 : 8 1 9 21 88 2 4 15 89 5 7 3

主键顺序插入 : 1 2 3 4 5 7 8 9 15 21 88 891.1.2 插入大批量数据:

如果一次性需要插入大批量数据(比如: 几百万的记录),使用insert语句插入性能较低,此时可以使

用MySQL数据库提供的load指令进行插入。

可以执行如下指令,将数据脚本文件中的数据加载到表结构中:

-- 客户端连接服务端时,加上参数 -–local-infile

mysql –-local-infile -u root -p

-- 设置全局参数local_infile为1,开启从本地加载文件导入数据的开关

set global local_infile = 1;

-- 执行load指令将准备好的数据,加载到表结构中

load data local infile '/root/sql1.log' into table tb_user fields

terminated by ',' lines terminated by '\n' ;主键顺序插入性能高于乱序插入

示例演示:

A. 创建表结构

CREATE TABLE `tb_user` (

`id` INT(11) NOT NULL AUTO_INCREMENT,

`username` VARCHAR(50) NOT NULL,

`password` VARCHAR(50) NOT NULL,

`name` VARCHAR(20) NOT NULL,

`birthday` DATE DEFAULT NULL,

`sex` CHAR(1) DEFAULT NULL,

PRIMARY KEY (`id`),

UNIQUE KEY `unique_user_username` (`username`)

) ENGINE=INNODB DEFAULT CHARSET=utf8 ;B. 设置参数

-- 客户端连接服务端时,加上参数 -–local-infile

mysql –-local-infile -u root -p

-- 设置全局参数local_infile为1,开启从本地加载文件导入数据的开关

set global local_infile = 1;C. load加载数据

load data local infile '/root/load_user_100w_sort.sql' into table tb_user

fields terminated by ',' lines terminated by '\n' ;在load时,主键顺序插入性能高于乱序插入

1.2 主键优化

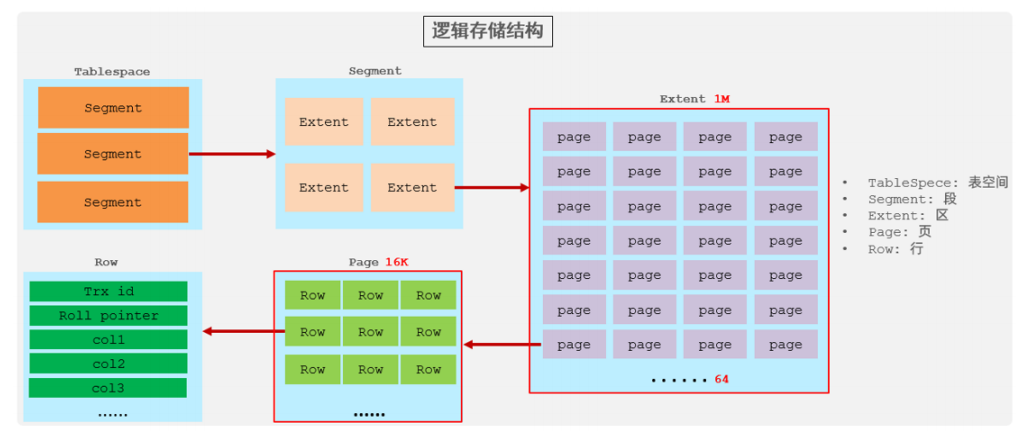

1). 数据组织方式

在InnoDB存储引擎中,表数据都是根据主键顺序组织存放的,这种存储方式的表称为索引组织表

(index organized table IOT)。

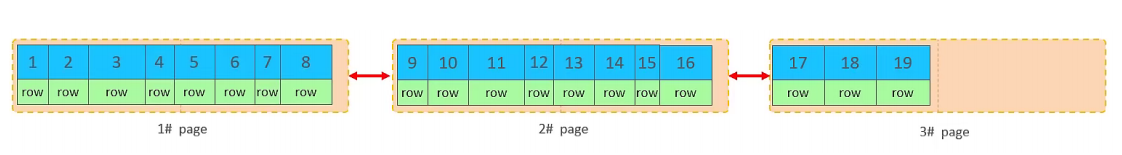

行数据,都是存储在聚集索引的叶子节点上的。而我们之前也讲解过InnoDB的逻辑结构图:

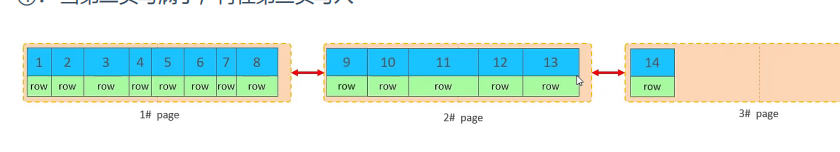

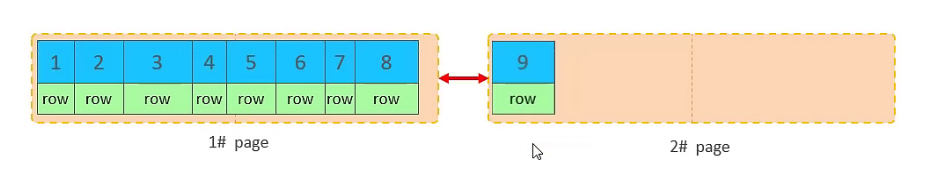

在InnoDB引擎中,数据行是记录在逻辑结构 page 页中的,而每一个页的大小是固定的,默认16K。 那也就意味着, 一个页中所存储的行也是有限的,如果插入的数据行row在该页存储不小,将会存储到下一个页中,页与页之间会通过指针连接。

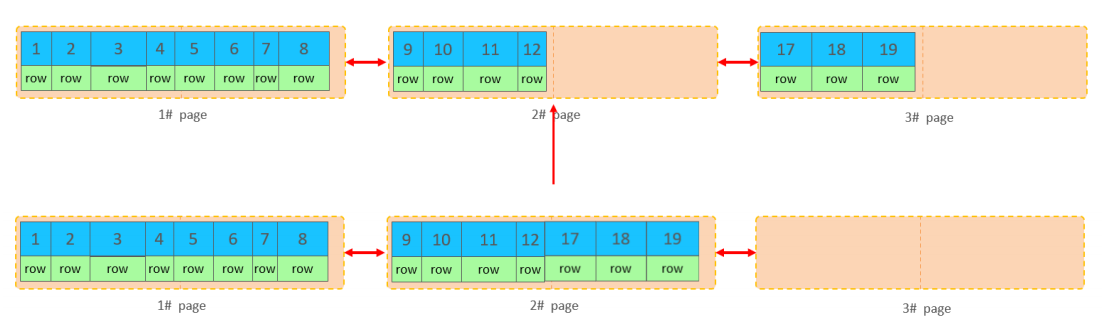

2). 页分裂

页可以为空,也可以填充一半,也可以填充100%。每个页包含了2-N行数据(如果一行数据过大,会行溢出),根据主键排列。

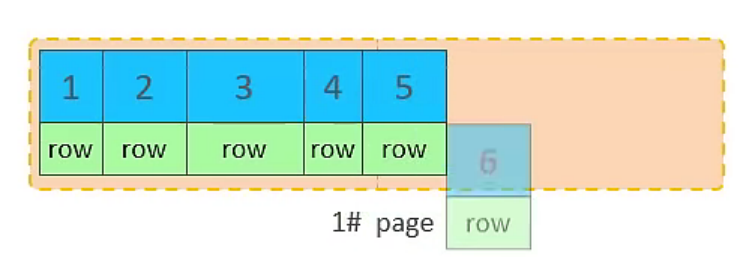

A. 主键顺序插入效果

①. 从磁盘中申请页, 主键顺序插入

②. 第一个页没有满,继续往第一页插入

③. 当第一个也写满之后,再写入第二个页,页与页之间会通过指针连接

④. 当第二页写满了,再往第三页写入

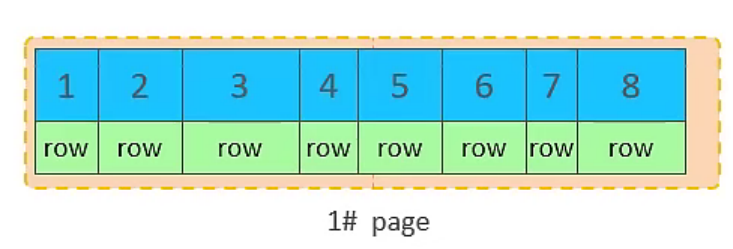

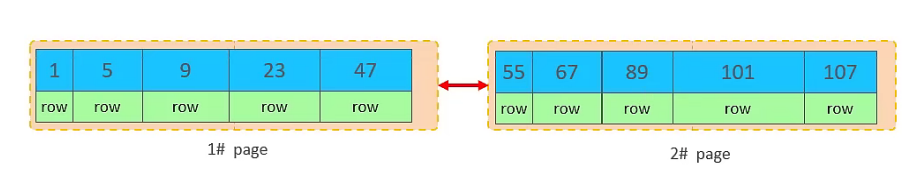

B. 主键乱序插入效果

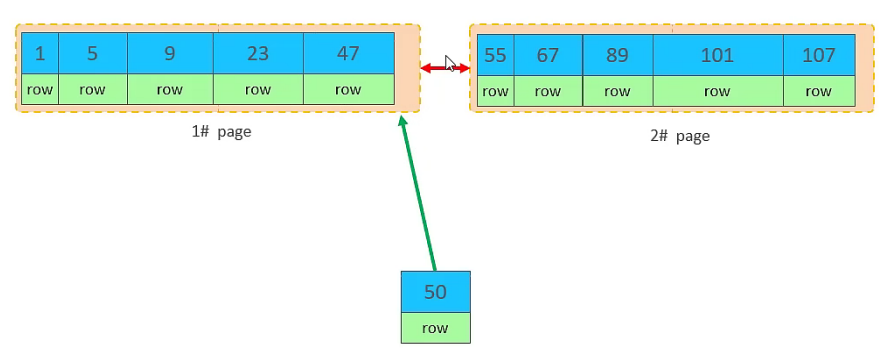

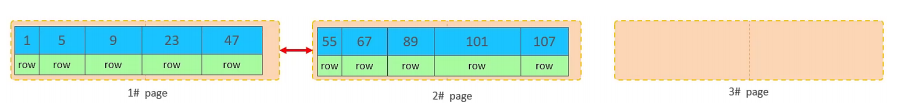

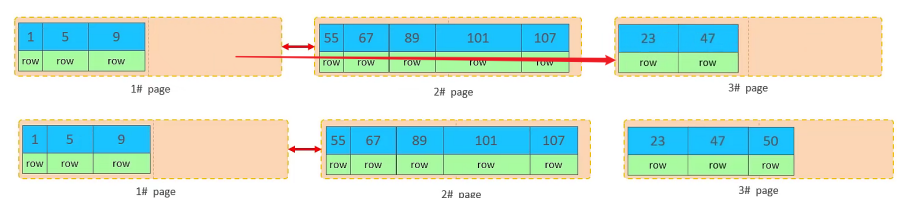

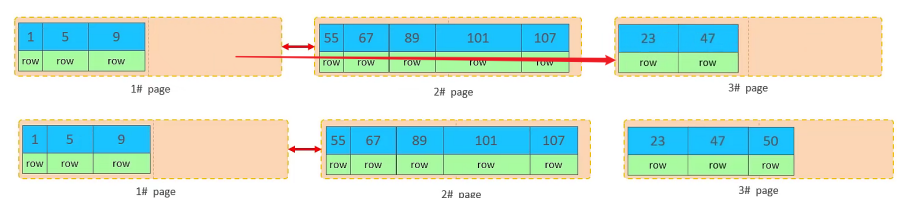

①. 加入1#,2#页都已经写满了,存放了如图所示的数据

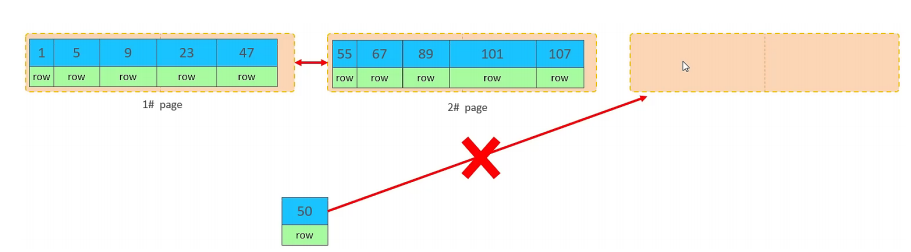

②. 此时再插入id为50的记录,我们来看看会发生什么现象会再次开启一个页,写入新的页中吗?

不会。因为,索引结构的叶子节点是有顺序的。按照顺序,应该存储在47之后。

但是47所在的1#页,已经写满了,存储不了50对应的数据了。 那么此时会开辟一个新的页 3#。

但是并不会直接将50存入3#页,而是会将1#页后一半的数据,移动到3#页,然后在3#页,插入50。

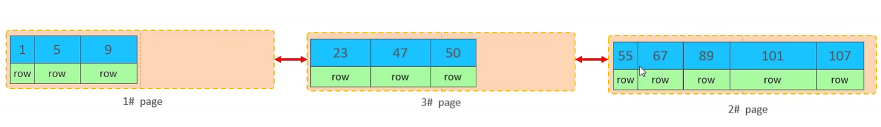

移动数据,并插入id为50的数据之后,那么此时,这三个页之间的数据顺序是有问题的。 1#的下一个页,应该是3#, 3#的下一个页是2#。 所以,此时,需要重新设置链表指针。

上述的这种现象,称之为 "页分裂",是比较耗费性能的操作。

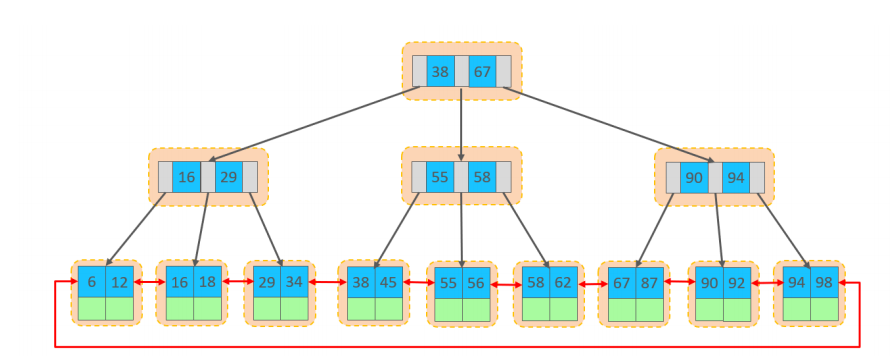

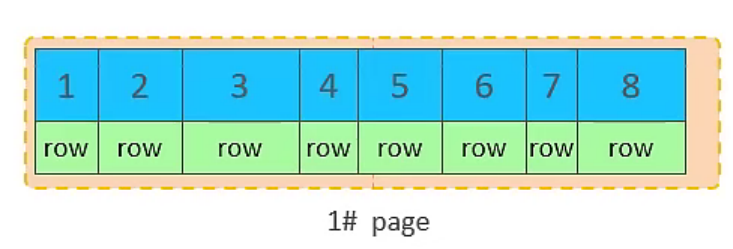

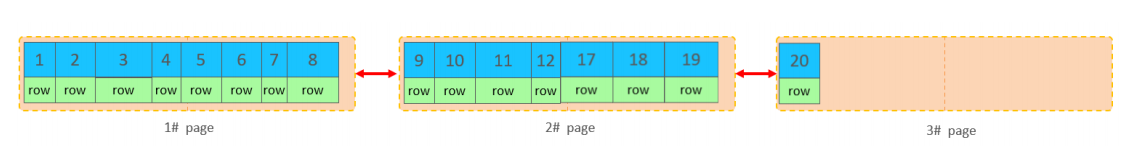

3). 页合并

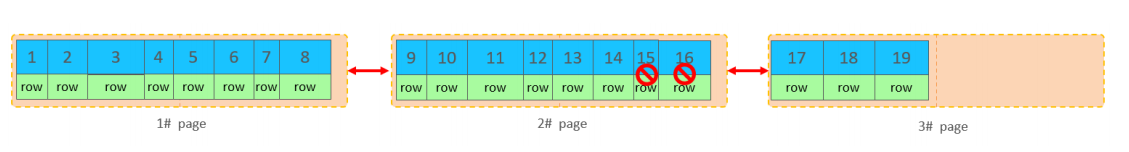

目前表中已有数据的索引结构(叶子节点)如下:

当我们对已有数据进行删除时,具体的效果如下:

当删除一行记录时,实际上记录并没有被物理删除,只是记录被标记(flaged)为删除并且它的空间变得允许被其他记录声明使用。

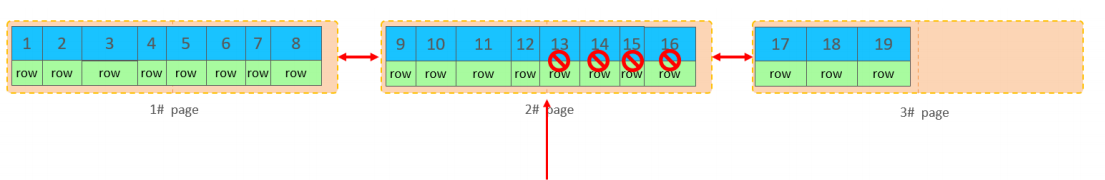

当我们继续删除2#的数据记录

当页中删除的记录达到 MERGE_THRESHOLD(默认为页的50%),InnoDB会开始寻找最靠近的页(前或后)看看是否可以将两个页合并以优化空间使用

删除数据,并将页合并之后,再次插入新的数据21,则直接插入3#页

这个里面所发生的合并页的这个现象,就称之为 "页合并"。

MERGE_THRESHOLD:合并页的阈值,可以自己设置,在创建表或者创建索引时指定。

4). 索引设计原则

满足业务需求的情况下,尽量降低主键的长度。

插入数据时,尽量选择顺序插入,选择使用AUTO_INCREMENT自增主键。

尽量不要使用UUID做主键或者是其他自然主键,如身份证号。

业务操作时,避免对主键的修改。

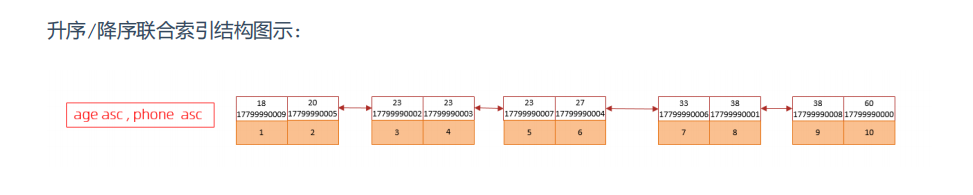

1.3 order by优化

MySQL的排序,有两种方式:

Using filesort : 通过表的索引或全表扫描,读取满足条件的数据行,然后在排序缓冲区sort

buffer中完成排序操作,所有不是通过索引直接返回排序结果的排序都叫 FileSort 排序。

Using index : 通过有序索引顺序扫描直接返回有序数据,这种情况即为 using index,不需要

额外排序,操作效率高。

对于以上的两种排序方式,Using index的性能高,而Using filesort的性能低,我们在优化排序

操作时,尽量要优化为 Using index。

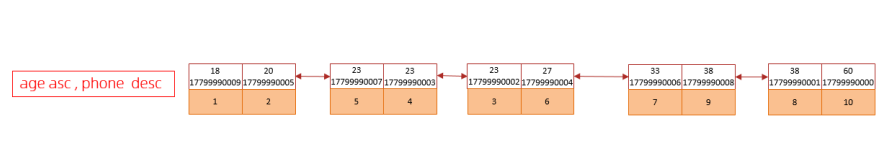

order by优化原则:

A. 根据排序字段建立合适的索引,多字段排序时,也遵循最左前缀法则。

B. 尽量使用覆盖索引。

C. 多字段排序, 一个升序一个降序,此时需要注意联合索引在创建时的规则(ASC/DESC)。

D. 如果不可避免的出现filesort,大数据量排序时,可以适当增大排序缓冲区大小

sort_buffer_size(默认256k)。

1.4 group by优化

在分组操作中,我们需要通过以下两点进行优化,以提升性能:

A. 在分组操作时,可以通过索引来提高效率。

B. 分组操作时,索引的使用也是满足最左前缀法则的

1.5 limit优化

在数据量比较大时,如果进行limit分页查询,在查询时,越往后,分页查询效率越低。

当在进行分页查询时,如果执行 limit 2000000,10 ,此时需要MySQL排序前2000010 记

录,仅仅返回 2000000 - 2000010 的记录,其他记录丢弃,查询排序的代价非常大 。

优化思路: 一般分页查询时,通过创建覆盖索引能够比较好地提高性能,可以通过覆盖索引加子查

询形式进行优化。

explain select * from tb_sku t , (select id from tb_sku order by id

limit 2000000,10) a where t.id = a.id;1.6 count优化

如果数据量很大,在执行count操作时,是非常耗时的。

MyISAM 引擎把一个表的总行数存在了磁盘上,因此执行 count(*) 的时候会直接返回这个数,效率很高; 但是如果是带条件的count,MyISAM也慢。

InnoDB 引擎就麻烦了,它执行 count(*) 的时候,需要把数据一行一行地从引擎里面读出来,然后累积计数。

如果说要大幅度提升InnoDB表的count效率,主要的优化思路:自己计数(可以借助于redis这样的数据库进行,但是如果是带条件的count又比较麻烦了)。

count用法:

count() 是一个聚合函数,对于返回的结果集,一行行地判断,如果 count 函数的参数不是NULL,累计值就加 1,否则不加,最后返回累计值。

用法:count(*)、count(主键)、count(字段)、count(数字)

按照效率排序的话,count(字段) < count(主键 id) < count(1) ≈ count(*),所以尽量使用 count(*)。

1.7 update优化

我们主要需要注意一下update语句执行时的注意事项。

update course set name = 'javaEE' where id = 1 ;当我们在执行删除的SQL语句时,会锁定id为1这一行的数据,然后事务提交之后,行锁释放。

但是当我们在执行如下SQL时:

update course set name = 'SpringBoot' where name = 'PHP' ;当我们开启多个事务,在执行上述的SQL时,我们发现行锁升级为了表锁。 导致该update语句的性能大大降低

InnoDB的行锁是针对索引加的锁,不是针对记录加的锁 ,并且该索引不能失效,否则会从行锁升级为表锁 。

2.日志

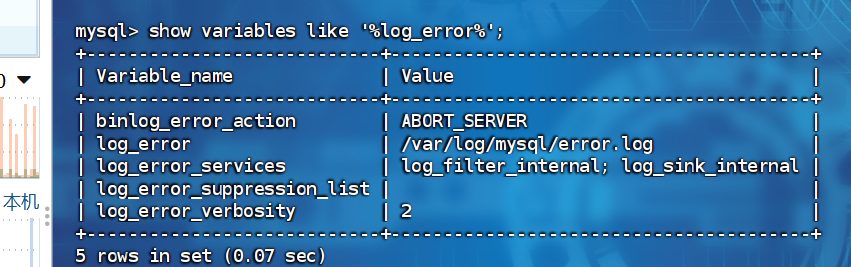

2.1 错误日志

错误日志是 MySQL 中最重要的日志之一,它记录了当 mysqld 启动和停止时,以及服务器在运行过程中发生任何严重错误时的相关信息。当数据库出现任何故障导致无法正常使用时,建议首先查看此日志。

该日志是默认开启的,默认存放目录 /var/log/,默认的日志文件名为 mysqld.log 。查看日志位置:

show variables like '%log_error%';

2.2 二进制日志

二进制日志(BINLOG)记录了所有的 DDL(数据定义语言)语句和 DML(数据操纵语言)语句,但不包括数据查询(SELECT、SHOW)语句。

作用:①. 灾难时的数据恢复;②. MySQL的主从复制。在MySQL8版本中,默认二进制日志是开启着的,涉及到的参数如下:

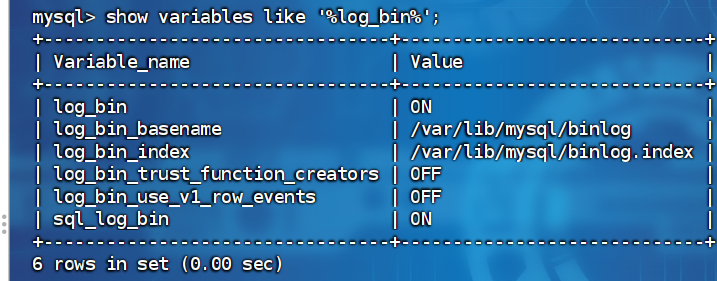

show variables like '%log_bin%';

参数说明:

log_bin_basename:当前数据库服务器的binlog日志的基础名称(前缀),具体的binlog文件名需要再该basename的基础上加上编号(编号从000001开始)。

log_bin_index:binlog的索引文件,里面记录了当前服务器关联的binlog文件有哪些。

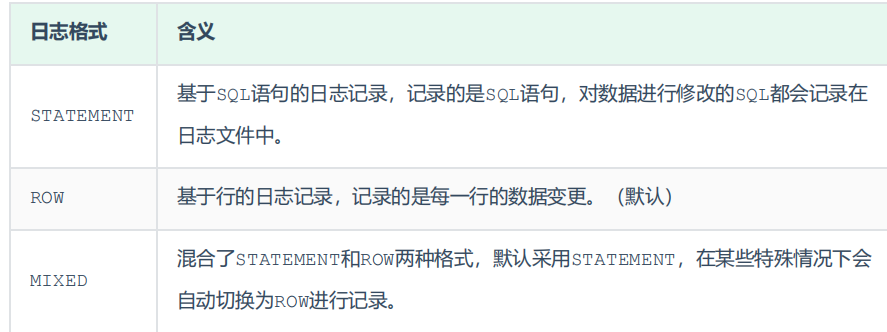

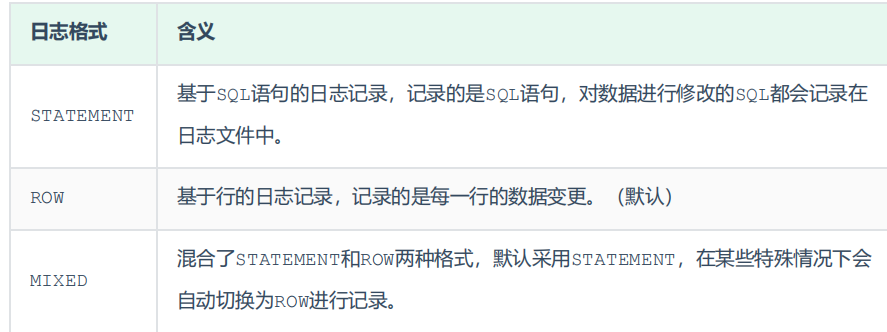

MySQL服务器中提供了多种格式来记录二进制日志,具体格式及特点如下:

show variables like '%binlog_format%'如果我们需要配置二进制日志的格式,只需要在 /etc/my.cnf 中配置 binlog_format 参数即可

查看:

由于日志是以二进制方式存储的,不能直接读取,需要通过二进制日志查询工具 mysqlbinlog 来查

看,具体语法:

mysqlbinlog [ 参数选项 ] logfilename

参数选项:

-d 指定数据库名称,只列出指定的数据库相关操作。

-o 忽略掉日志中的前n行命令。

-v 将行事件(数据变更)重构为SQL语句

-vv 将行事件(数据变更)重构为SQL语句,并输出注释信息删除:

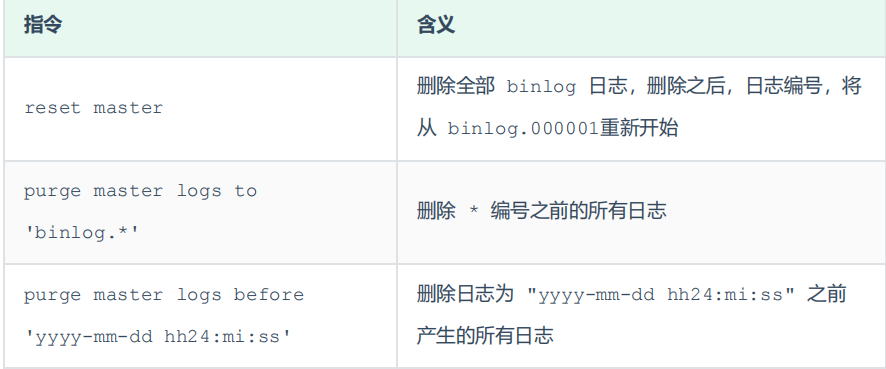

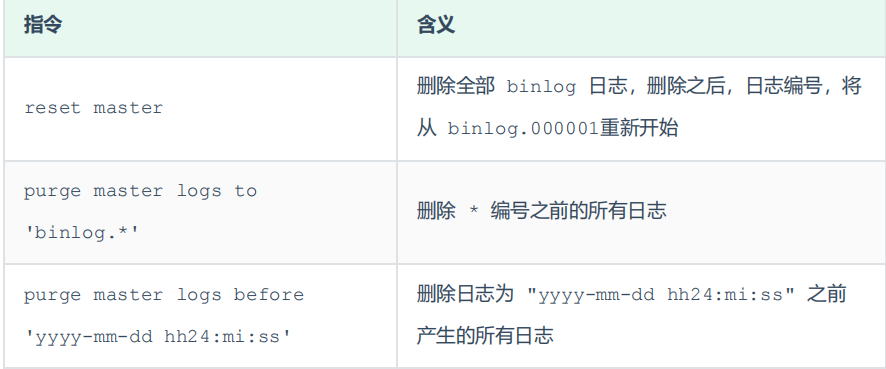

对于比较繁忙的业务系统,每天生成的binlog数据巨大,如果长时间不清除,将会占用大量磁盘空

间。可以通过以下几种方式清理日志:

也可以在mysql的配置文件中配置二进制日志的过期时间,设置了之后,二进制日志过期会自动删除

show variables like '%binlog_expire_logs_seconds%';2.3 查询日志

查询日志中记录了客户端的所有操作语句,而二进制日志不包含查询数据的SQL语句。默认情况下, 查询日志是未开启的。

如果需要开启查询日志,可以修改MySQL的配置文件 /etc/my.cnf 文件,添加如下内容:

#该选项用来开启查询日志 , 可选值 : 0 或者 1 ; 0 代表关闭, 1 代表开启

general_log=1

#设置日志的文件名 , 如果没有指定, 默认的文件名为 host_name.log

general_log_file=mysql_query.log开启了查询日志之后,在MySQL的数据存放目录,也就是 /var/lib/mysql/ 目录下就会出现

mysql_query.log 文件。之后所有的客户端的增删改查操作都会记录在该日志文件之中,长时间运

行后,该日志文件将会非常大。

2.4 慢查询日志

慢查询日志记录了所有执行时间超过参数 long_query_time 设置值并且扫描记录数不小于

min_examined_row_limit 的所有的SQL语句的日志,默认未开启。long_query_time 默认为

10 秒,最小为 0, 精度可以到微秒。

如果需要开启慢查询日志,需要在MySQL的配置文件 /etc/my.cnf 中配置如下参数:

#慢查询日志

slow_query_log=1

#执行时间参数

long_query_time=2默认情况下,不会记录管理语句,也不会记录不使用索引进行查找的查询。可以使用 log_slow_admin_statements和 更改此行为 log_queries_not_using_indexes,如下所述。

#记录执行较慢的管理语句

log_slow_admin_statements =1

#记录执行较慢的未使用索引的语句

log_queries_not_using_indexes = 1上述所有的参数配置完成之后,都需要重新启动MySQL服务器才可以生效。

3.主从复制

3.1 概述

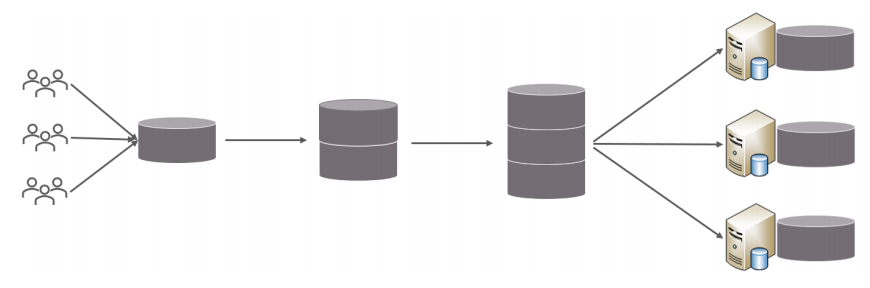

主从复制是指将主数据库的 DDL 和 DML 操作通过二进制日志传到从库服务器中,然后对这

些日志重新执行(也叫重做),从而使得从库和主库的数据保持同步。

MySQL支持一台主库同时向多台从库进行复制, 从库同时也可以作为其他从服务器的主库,实现链状复制。

MySQL 复制的优点主要包含以下三个方面:

主库出现问题,可以快速切换到从库提供服务。

实现读写分离,降低主库的访问压力。

可以在从库中执行备份,以避免备份期间影响主库服务。

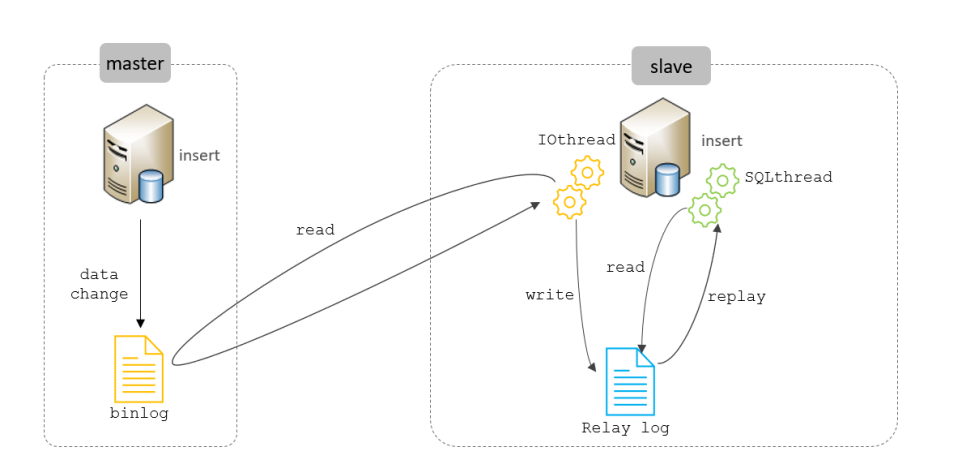

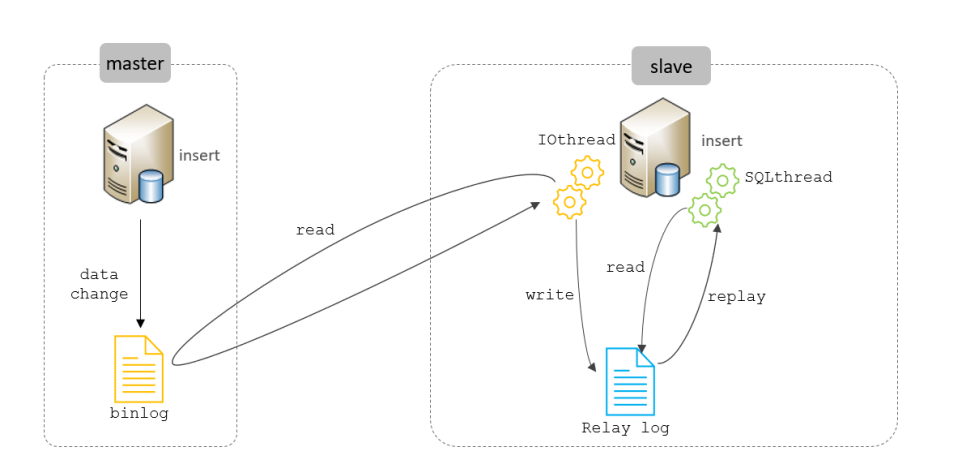

3.2 原理

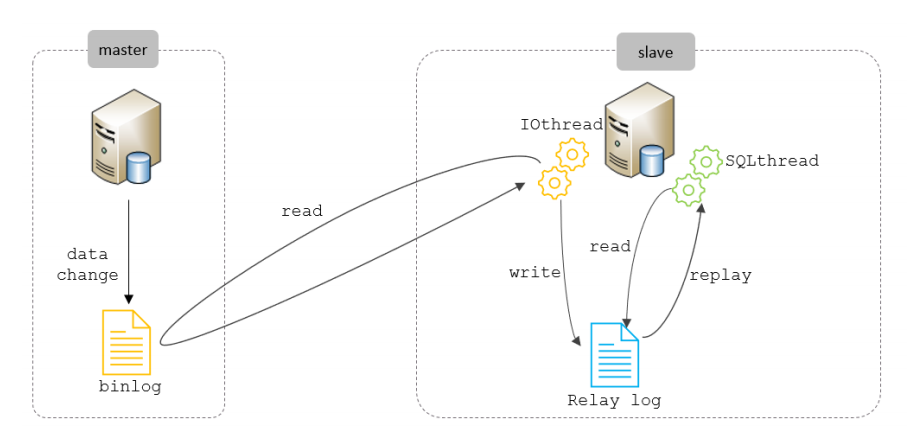

MySQL主从复制的核心就是 二进制日志,具体的过程如下:

从上图来看,复制分成三步:

1. Master 主库在事务提交时,会把数据变更记录在二进制日志文件 Binlog 中。

2. 从库读取主库的二进制日志文件 Binlog ,写入到从库的中继日志 Relay Log 。

3. slave重做中继日志中的事件,将改变反映它自己的数据。

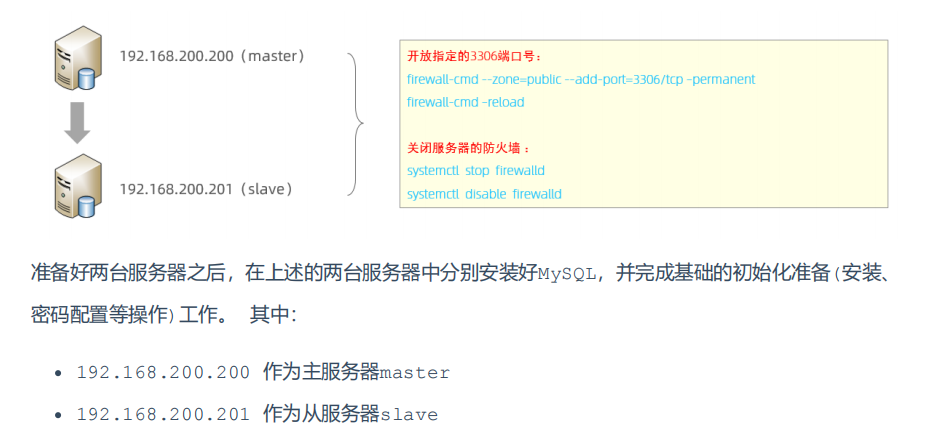

3.3 搭建

主库配置:

1. 修改配置文件 /etc/my.cnf

#mysql 服务ID,保证整个集群环境中唯一,取值范围:1 – 232-1,默认为1

server-id=1

#是否只读,1 代表只读, 0 代表读写

read-only=0

#忽略的数据, 指不需要同步的数据库

#binlog-ignore-db=mysql

#指定同步的数据库

#binlog-do-db=db012. 重启MySQL服务器

systemctl restart mysqld3. 登录mysql,创建远程连接的账号,并授予主从复制权限

#创建itcast用户,并设置密码,该用户可在任意主机连接该MySQL服务

CREATE USER 'itcast'@'%' IDENTIFIED WITH mysql_native_password BY 'Root@123456';

#为 'itcast'@'%' 用户分配主从复制权限

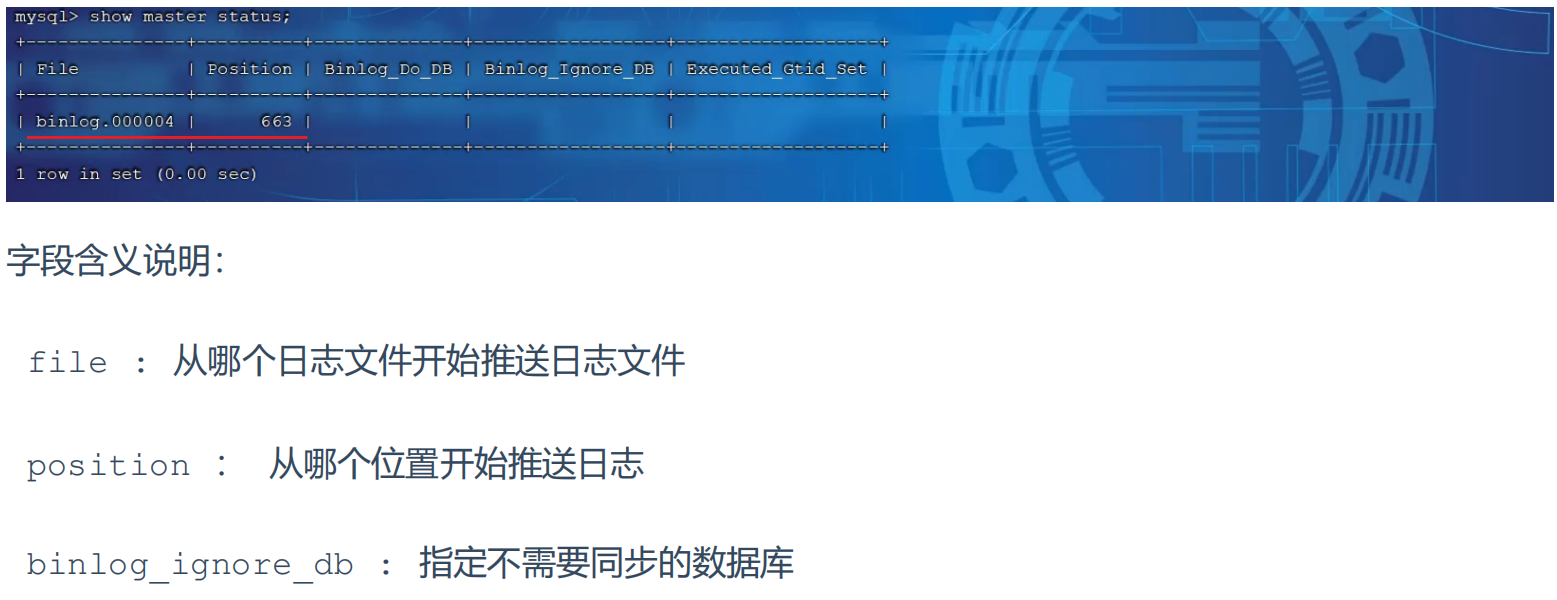

GRANT REPLICATION SLAVE ON *.* TO 'itcast'@'%';4. 通过指令,查看二进制日志坐标

show master status ;

从库配置:

1. 修改配置文件 /etc/my.cnf

#mysql 服务ID,保证整个集群环境中唯一,取值范围:1 – 2^32-1,和主库不一样即可

server-id=2

#是否只读,1 代表只读, 0 代表读写

read-only=12. 重新启动MySQL服务

systemctl restart mysqld3. 登录mysql,设置主库配置

CHANGE REPLICATION SOURCE TO SOURCE_HOST='192.168.200.200', SOURCE_USER='itcast',

SOURCE_PASSWORD='Root@123456', SOURCE_LOG_FILE='binlog.000004',

SOURCE_LOG_POS=663;上述是8.0.23中的语法。如果mysql是 8.0.23 之前的版本,执行如下SQL:

CHANGE MASTER TO MASTER_HOST='192.168.200.200', MASTER_USER='itcast',

MASTER_PASSWORD='Root@123456', MASTER_LOG_FILE='binlog.000004',

MASTER_LOG_POS=663;

4. 开启同步操作

start replica ; #8.0.22之后

start slave ; #8.0.22之前5. 查看主从同步状态

show replica status ; #8.0.22之后

show slave status ; #8.0.22之前4.分库分表

4.1 简介

随着互联网及移动互联网的发展,应用系统的数据量也是成指数式增长,若采用单数据库进行数据存储,存在以下性能瓶颈:

1. IO瓶颈:热点数据太多,数据库缓存不足,产生大量磁盘IO,效率较低。 请求数据太多,带宽

不够,网络IO瓶颈。

2. CPU瓶颈:排序、分组、连接查询、聚合统计等SQL会耗费大量的CPU资源,请求数太多,CPU出现瓶颈。

为了解决上述问题,我们需要对数据库进行分库分表处理

分库分表的中心思想都是将数据分散存储,使得单一数据库/表的数据量变小来缓解单一数据库的性能问题,从而达到提升数据库性能的目的。

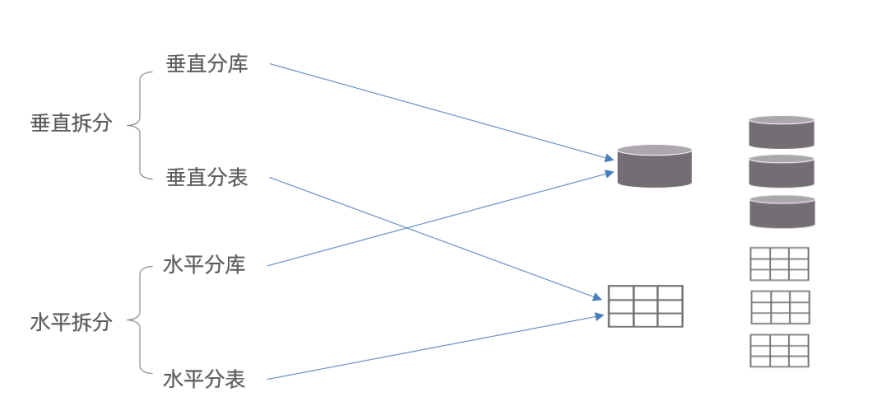

4.2 拆分策略

分库分表的形式,主要是两种:垂直拆分和水平拆分。而拆分的粒度,一般又分为分库和分表,所以组成的拆分策略最终如下:

4.2.1 垂直拆分

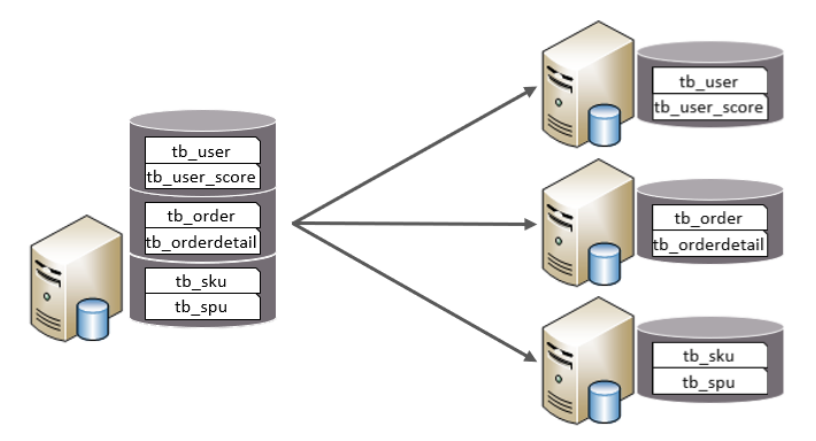

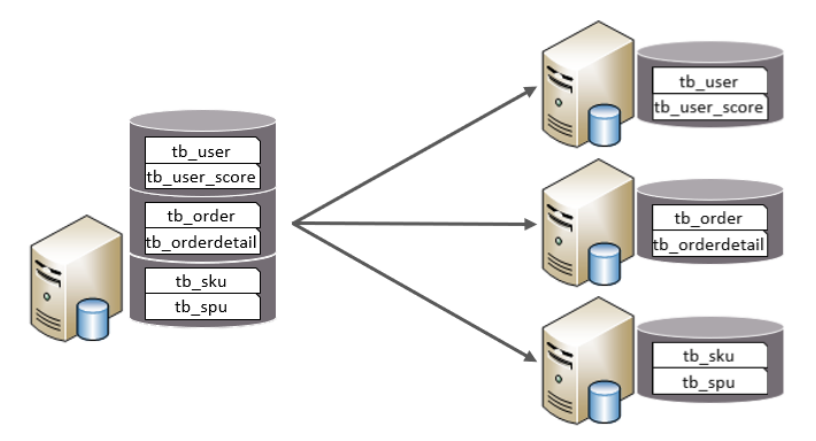

1. 垂直分库

垂直分库:以表为依据,根据业务将不同表拆分到不同库中。

特点:

每个库的表结构都不一样。

每个库的数据也不一样。

所有库的并集是全量数据

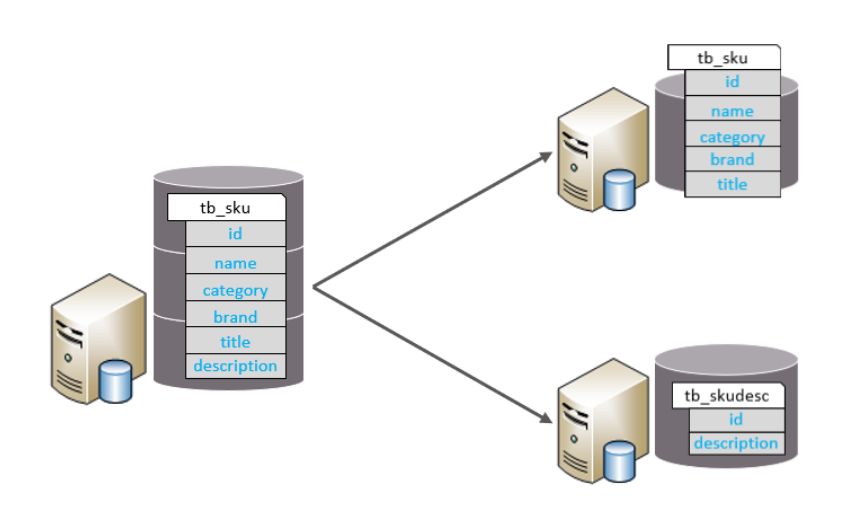

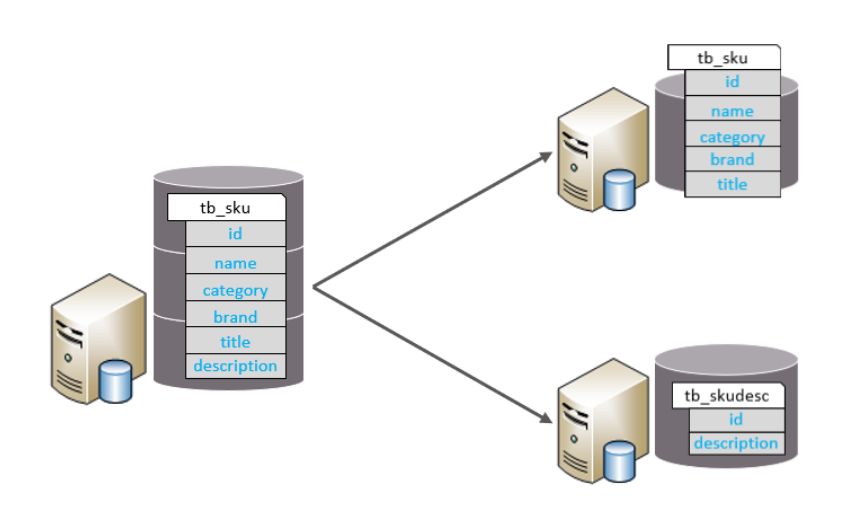

2. 垂直分表

垂直分表:以字段为依据,根据字段属性将不同字段拆分到不同表中。

特点:

每个表的结构都不一样。

每个表的数据也不一样,一般通过一列(主键/外键)关联。

所有表的并集是全量数据。

4.2.2 水平拆分

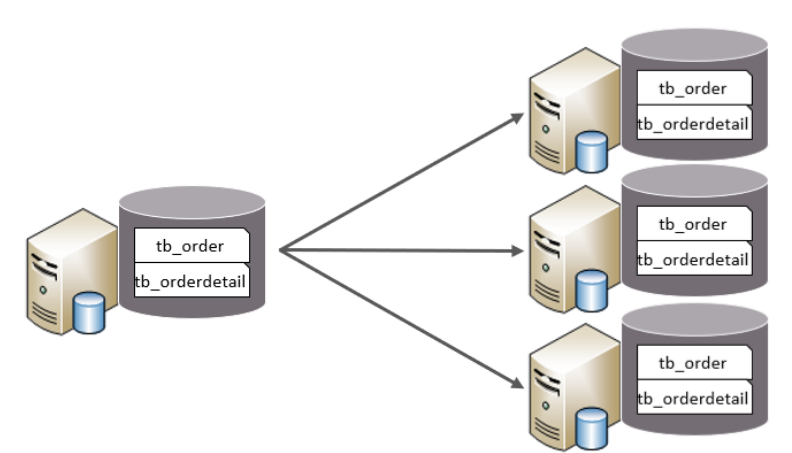

1. 水平分库

水平分库:以字段为依据,按照一定策略,将一个库的数据拆分到多个库中。

特点:

每个库的表结构都一样。

每个库的数据都不一样。

所有库的并集是全量数据。

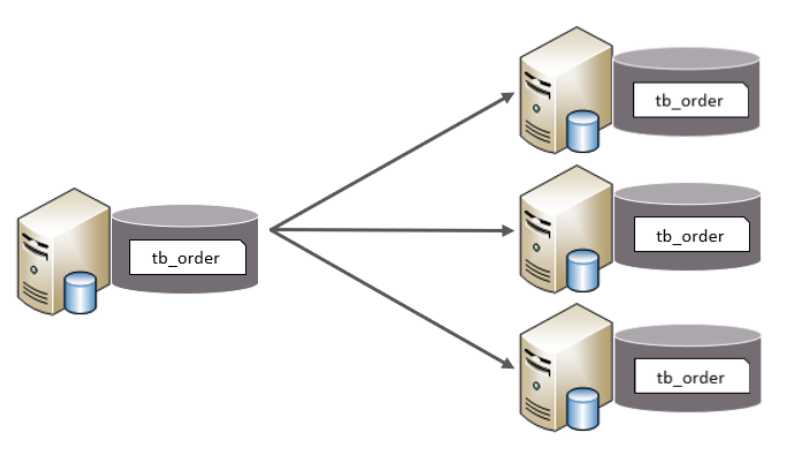

2. 水平分表

水平分表:以字段为依据,按照一定策略,将一个表的数据拆分到多个表中。

特点:

每个表的表结构都一样。

每个表的数据都不一样。

所有表的并集是全量数据。

在业务系统中,为了缓解磁盘IO及CPU的性能瓶颈,到底是垂直拆分,还是水平拆分;具体是分

库,还是分表,都需要根据具体的业务需求具体分析。

4.3 实现技术

shardingJDBC:

基于AOP原理,在应用程序中对本地执行的SQL进行拦截,解析、改写、路由处理。需要自行编码配置实现,只支持java语言,性能较高。

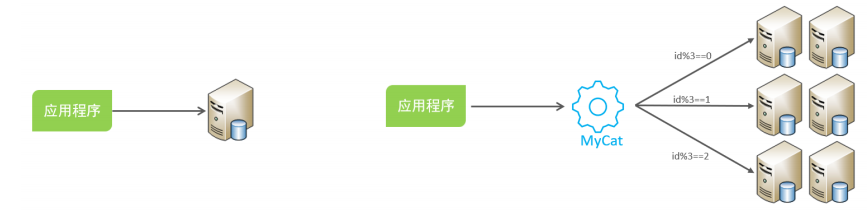

MyCat:

数据库分库分表中间件,不用调整代码即可实现分库分表,支持多种语言,性能不及前者。

4.3.1 MyCat介绍

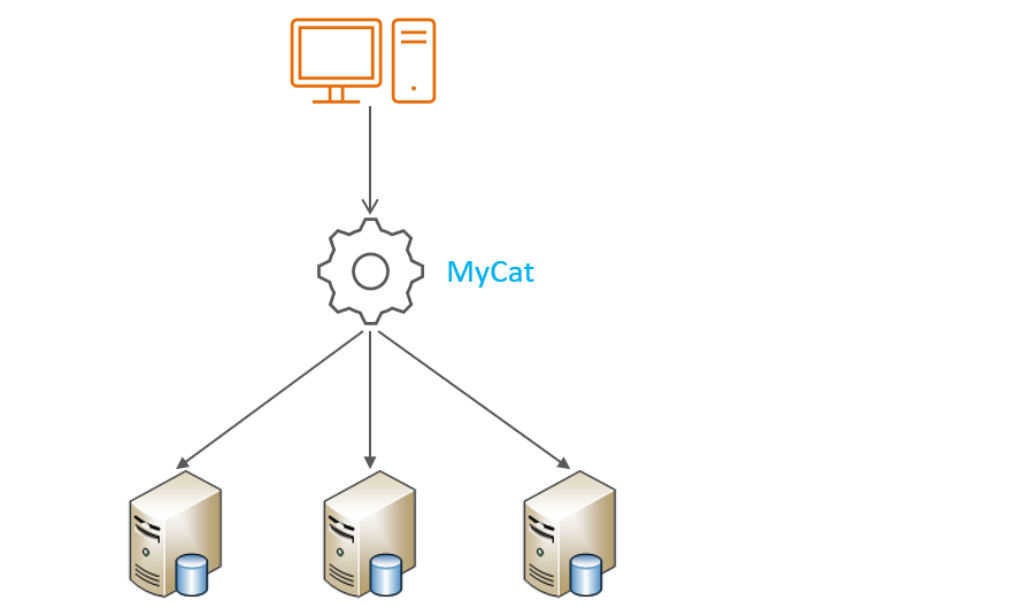

Mycat是开源的、活跃的、基于Java语言编写的MySQL数据库中间件。可以像使用mysql一样来使用mycat,对于开发人员来说根本感觉不到mycat的存在。

开发人员只需要连接MyCat即可,而具体底层用到几台数据库,每一台数据库服务器里面存储了什么数据,都无需关心。 具体的分库分表的策略,只需要在MyCat中配置即可。

优势: 性能可靠稳定 ,强大的技术团队 ,体系完善 ,社区活跃

下载地址:http://dl.mycat.org.cn

安装:

Mycat是采用java语言开发的开源的数据库中间件,支持Windows和Linux运行环境,下面介绍

MyCat的Linux中的环境搭建。我们需要在准备好的服务器中安装如下软件:MySQL ,JDK ,Mycat

目录介绍:

bin : 存放可执行文件,用于启动停止mycat

conf:存放mycat的配置文件

lib:存放mycat的项目依赖包(jar)

logs:存放mycat的日志文件

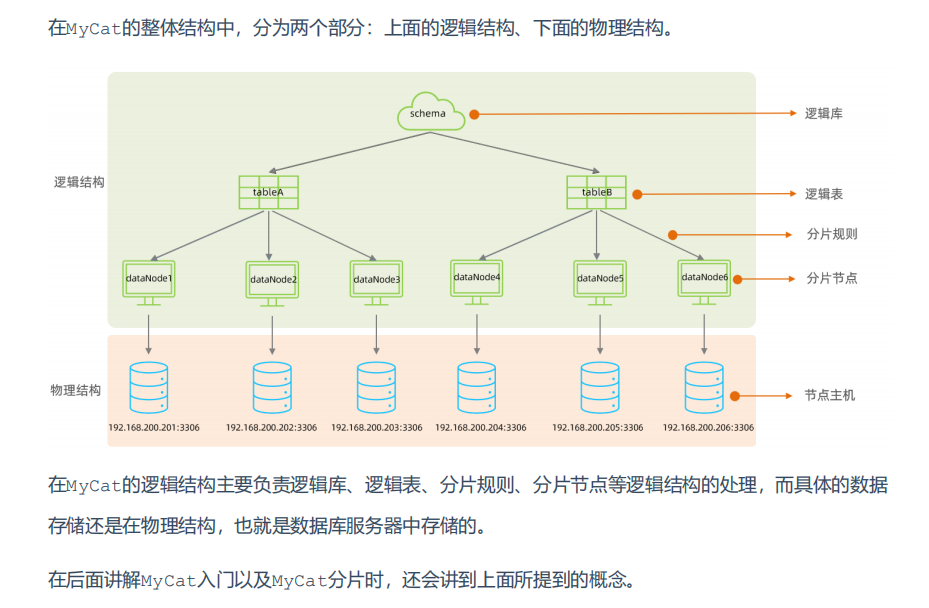

概念介绍:

4.3.2 分片规则

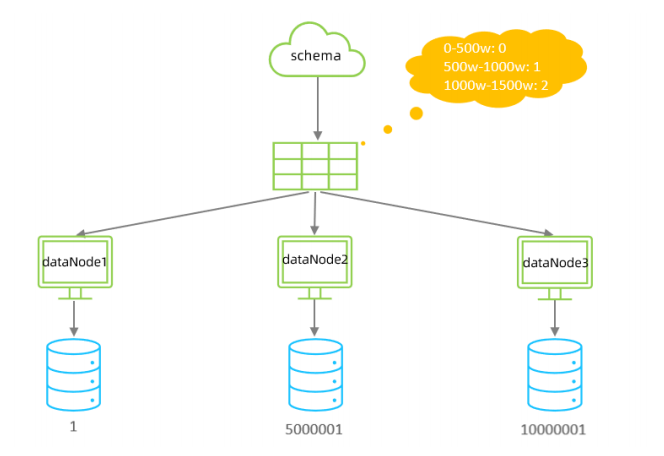

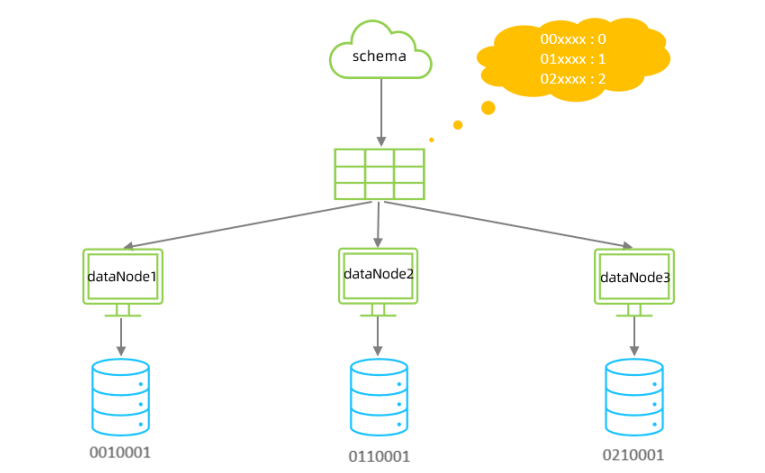

范围分片:

根据指定的字段及其配置的范围与数据节点的对应情况, 来决定该数据属于哪一个分片。

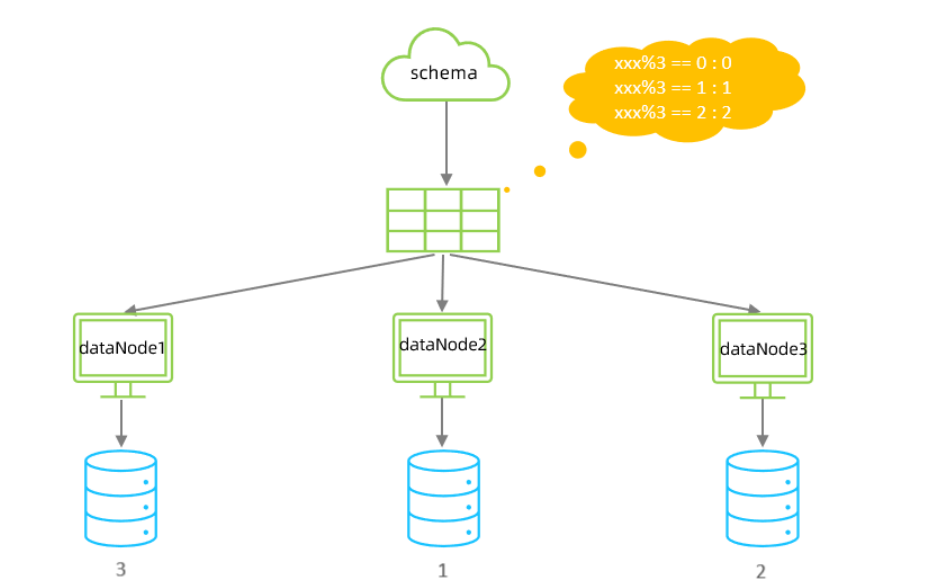

取模分片:

根据指定的字段值与节点数量进行求模运算,根据运算结果, 来决定该数据属于哪一个分片。

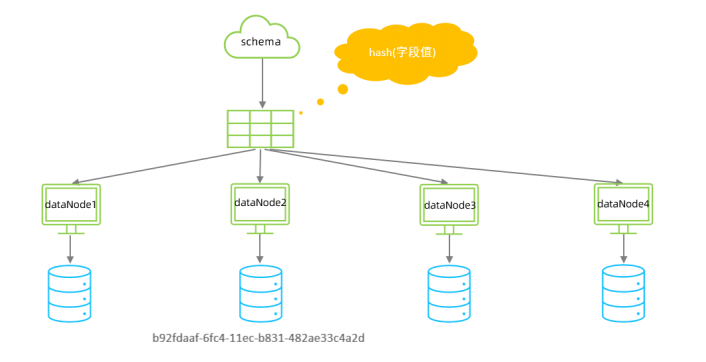

一致性哈希分片:

所谓一致性哈希,相同的哈希因子计算值总是被划分到相同的分区表中,不会因为分区节点的增加而改变原来数据的分区位置,有效的解决了分布式数据的拓容问题。

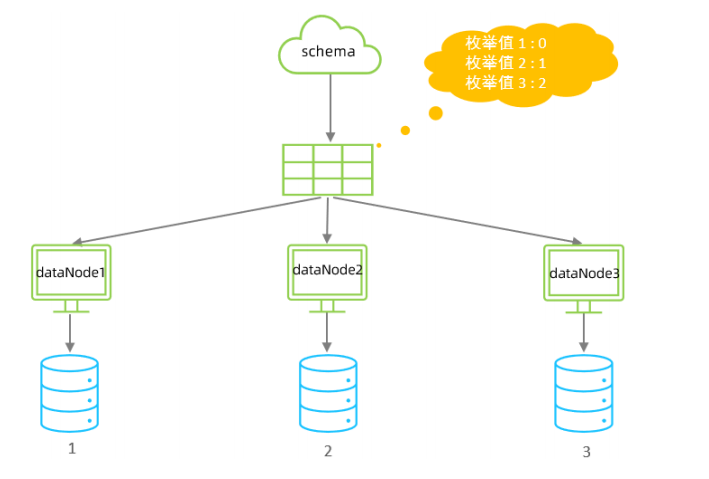

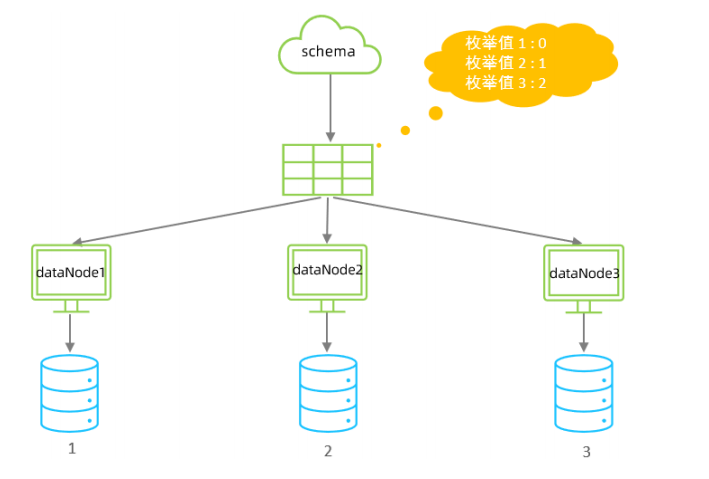

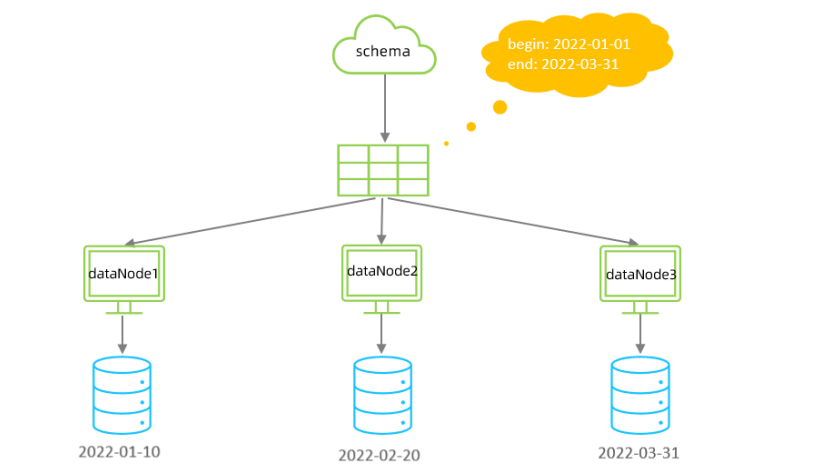

枚举分片:

通过在配置文件中配置可能的枚举值, 指定数据分布到不同数据节点上, 本规则适用于按照省份、性

别、状态拆分数据等业务 。

应用指定算法:

运行阶段由应用自主决定路由到那个分片 , 直接根据字符子串(必须是数字)计算分片号。

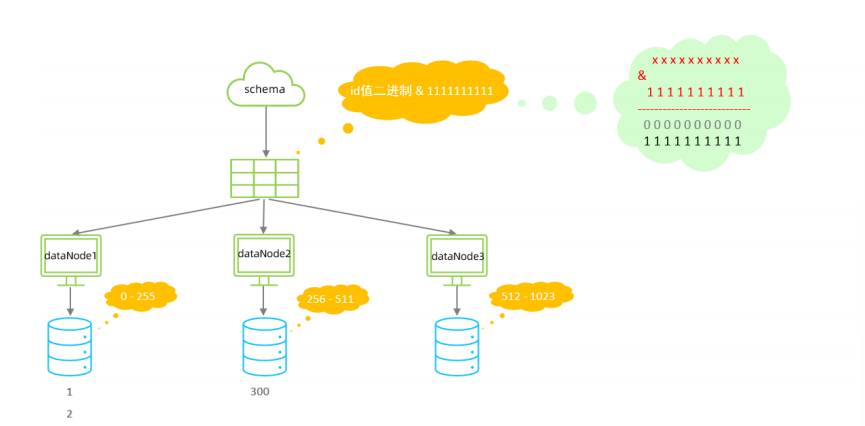

固定哈希分片算法:

该算法类似于十进制的求模运算,但是为二进制的操作,例如,取 id 的二进制低 10 位 与

1111111111 进行位 & 运算,位与运算最小值为 0000000000,最大值为1111111111,转换为十

进制,也就是位于0-1023之间。

特点:

如果是求模,连续的值,分别分配到各个不同的分片;但是此算法会将连续的值可能分配到相同的

分片,降低事务处理的难度。

可以均匀分配,也可以非均匀分配。

分片字段必须为数字类型。

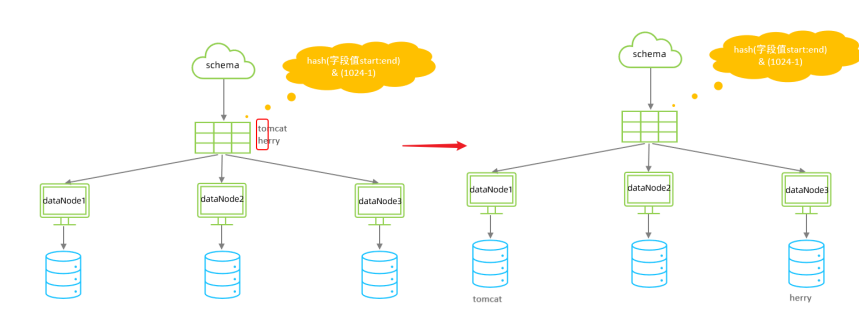

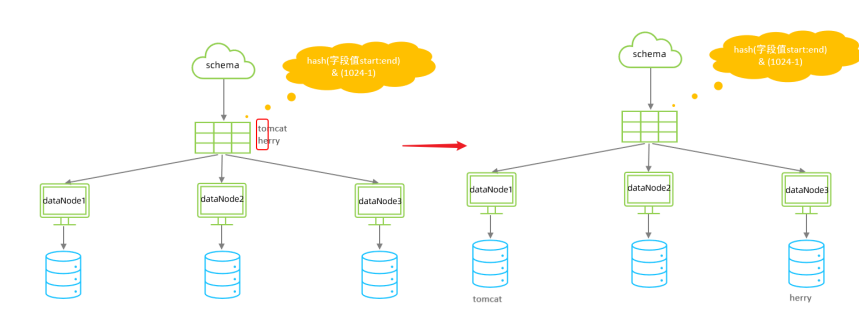

字符串哈希解析算法:

截取字符串中的指定位置的子字符串, 进行hash算法, 算出分片

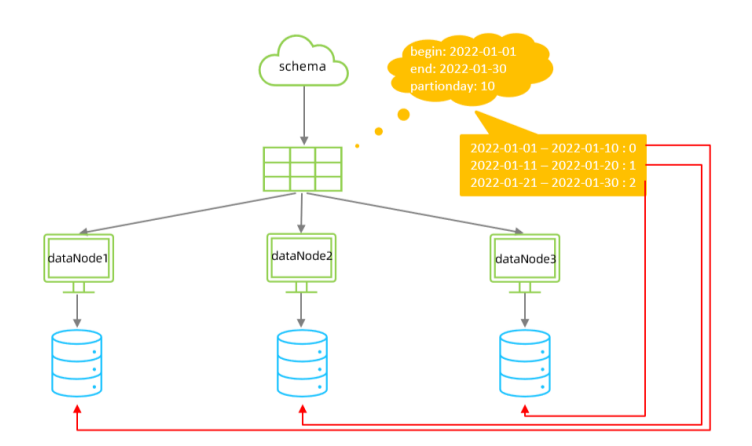

按天分片算法:

按照日期及对应的时间周期来分片。

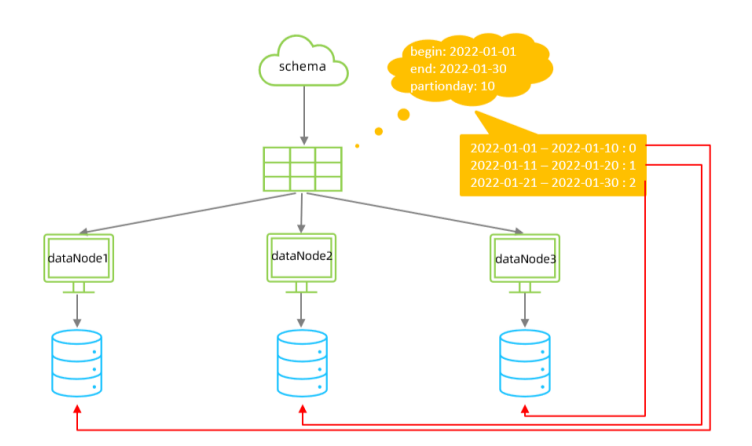

自然月分片:

使用场景为按照月份来分片, 每个自然月为一个分片

4.3.3 MyCat监控与管理

MyCat原理:

在MyCat中,当执行一条SQL语句时,MyCat需要进行SQL解析、分片分析、路由分析、读写分离分析等操作,最终经过一系列的分析决定将当前的SQL语句到底路由到那几个(或哪一个)节点数据库,数据库将数据执行完毕后,如果有返回的结果,则将结果返回给MyCat,最终还需要在MyCat中进行结果合并、聚合处理、排序处理、分页处理等操作,最终再将结果返回给客户端。

而在MyCat的使用过程中,MyCat官方也提供了一个管理监控平台MyCat-Web(MyCat-eye)。

Mycat-web 是 Mycat 可视化运维的管理和监控平台,弥补了 Mycat 在监控上的空白。帮 Mycat

分担统计任务和配置管理任务。Mycat-web 引入了 ZooKeeper 作为配置中心,可以管理多个节

点。Mycat-web 主要管理和监控 Mycat 的流量、连接、活动线程和内存等,具备 IP 白名单、邮

件告警等模块,还可以统计 SQL 并分析慢 SQL 和高频 SQL 等。为优化 SQL 提供依据。

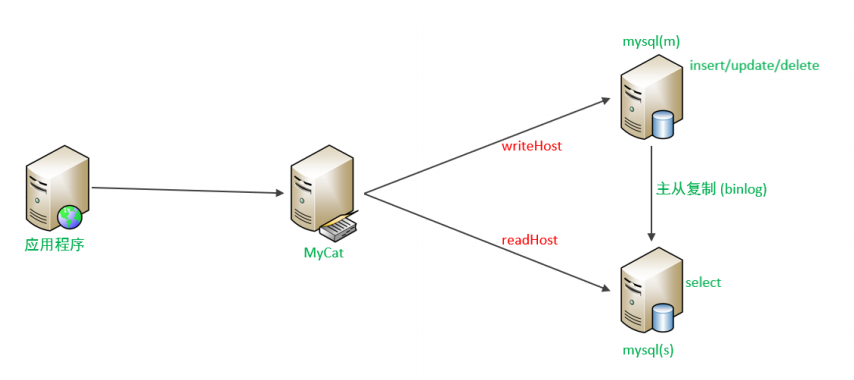

5.读写分离

读写分离,简单地说是把对数据库的读和写操作分开,以对应不同的数据库服务器。主数据库提供写操作,从数据库提供读操作,这样能有效地减轻单台数据库的压力。

通过MyCat即可轻易实现上述功能,不仅可以支持MySQL,也可以支持Oracle和SQL Server。

一主一从读写分离:

MySQL的主从复制,是基于二进制日志(binlog)实现的。

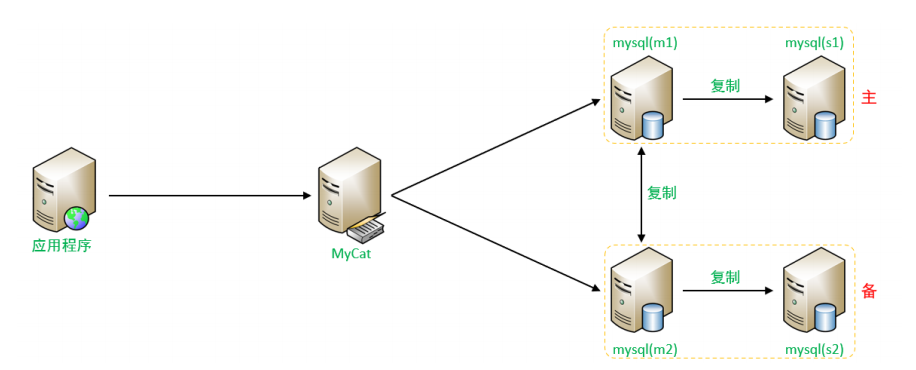

双主双从:

一个主机 Master1 用于处理所有写请求,它的从机 Slave1 和另一台主机 Master2 还有它的从

机 Slave2 负责所有读请求。当 Master1 主机宕机后,Master2 主机负责写请求,Master1 、

Master2 互为备机。架构图如下:

6.MySQL运维常用技巧

6.1 系统数据库

Mysql数据库安装完成后,自带了一下四个数据库,具体作用如下:

6.2 常用工具

6.2.1 mysql

该mysql不是指mysql服务,而是指mysql的客户端工具。

语法 :

mysql [options] [database]

选项 :

-u, --user=name #指定用户名

-p, --password[=name] #指定密码

-h, --host=name #指定服务器IP或域名

-P, --port=port #指定连接端口

-e, --execute=name #执行SQL语句并退出-e选项可以在Mysql客户端执行SQL语句,而不用连接到MySQL数据库再执行,对于一些批处理脚本,这种方式尤其方便。

示例:

mysql -uroot –p123456 db01 -e "select * from stu";6.2.2 mysqladmin

mysqladmin 是一个执行管理操作的客户端程序。可以用它来检查服务器的配置和当前状态、创建并删除数据库等。

通过帮助文档查看选项:

mysqladmin --help语法:

mysqladmin [options] command ...

选项:

-u, --user=name #指定用户名

-p, --password[=name] #指定密码

-h, --host=name #指定服务器IP或域名

-P, --port=port #指定连接端口示例:

mysqladmin -uroot –p1234 drop 'test01';

mysqladmin -uroot –p1234 version;6.2.3 mysqlbinlog

由于服务器生成的二进制日志文件以二进制格式保存,所以如果想要检查这些文本的文本格式,就会使用到mysqlbinlog 日志管理工具。

语法 :

mysqlbinlog [options] log-files1 log-files2 ...

选项 :

-d, --database=name 指定数据库名称,只列出指定的数据库相关操作。

-o, --offset=# 忽略掉日志中的前n行命令。

-r,--result-file=name 将输出的文本格式日志输出到指定文件。

-s, --short-form 显示简单格式, 省略掉一些信息。

--start-datatime=date1 --stop-datetime=date2 指定日期间隔内的所有日志。

--start-position=pos1 --stop-position=pos2 指定位置间隔内的所有日志。6.2.4 mysqlshow

mysqlshow 客户端对象查找工具,用来很快地查找存在哪些数据库、数据库中的表、表中的列或者索引。

语法 :

mysqlshow [options] [db_name [table_name [col_name]]]

选项 :

--count 显示数据库及表的统计信息(数据库,表 均可以不指定)

-i 显示指定数据库或者指定表的状态信息

示例:

#查询test库中每个表中的字段书,及行数

mysqlshow -uroot -p2143 test --count

#查询test库中book表的详细情况

mysqlshow -uroot -p2143 test book --count6.2.5 mysqldump

mysqldump 客户端工具用来备份数据库或在不同数据库之间进行数据迁移。备份内容包含创建表,及插入表的SQL语句。

语法 :

mysqldump [options] db_name [tables]

mysqldump [options] --database/-B db1 [db2 db3...]

mysqldump [options] --all-databases/-A

连接选项 :

-u, --user=name 指定用户名

-p, --password[=name] 指定密码

-h, --host=name 指定服务器ip或域名

-P, --port=# 指定连接端口

输出选项:

--add-drop-database 在每个数据库创建语句前加上 drop database 语句

--add-drop-table 在每个表创建语句前加上 drop table 语句 , 默认开启 ; 不

开启 (--skip-add-drop-table)

-n, --no-create-db 不包含数据库的创建语句

-t, --no-create-info 不包含数据表的创建语句

-d --no-data 不包含数据

-T, --tab=name 自动生成两个文件:一个.sql文件,创建表结构的语句;一

个.txt文件,数据文件示例:

A. 备份db01数据库

mysqldump -uroot -p1234 db01 > db01.sql备份出来的数据包含:

删除表的语句

创建表的语句

数据插入语句

如果我们在数据备份时,不需要创建表,或者不需要备份数据,只需要备份表结构,都可以通过对应的参数来实现。

B. 备份db01数据库中的表数据,不备份表结构(-t)

mysqldump -uroot -p1234 -t db01 > db01.sqlC. 将db01数据库的表的表结构与数据分开备份(-T)

mysqldump -uroot -p1234 -T /root db01 score6.2.6 mysqlimport/source

1). mysqlimport

mysqlimport 是客户端数据导入工具,用来导入mysqldump 加 -T 参数后导出的文本文件。

语法 :

mysqlimport [options] db_name textfile1 [textfile2...]

示例 :

mysqlimport -uroot -p2143 test /tmp/city.txt2). source

如果需要导入sql文件,可以使用mysql中的source 指令 :

语法 :

source /root/xxxxx.sql