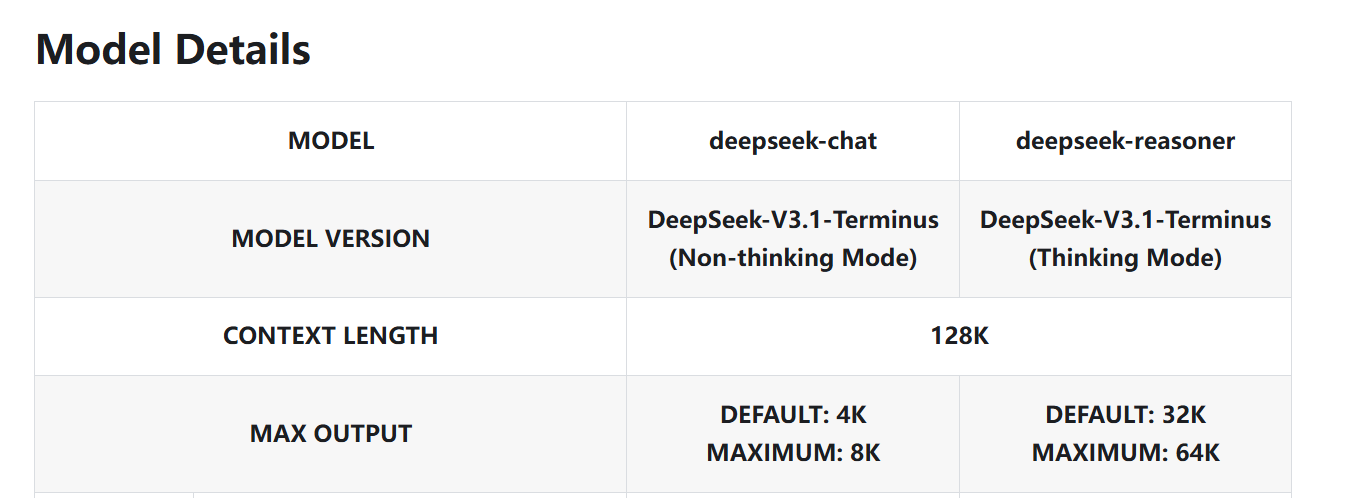

使用大模型进行chat的时候,这里的max output和context length分别是什么意思?所有的模型的上下文长度排名

1. CONTEXT LENGTH (上下文长度)

-

含义:这是模型一次可以“记住”和处理的最大输入长度(用户输入 + 模型历史对话 + 模型输出的内容)。

-

128K 表示模型最多能处理 128,000 tokens 的上下文。

-

作用:上下文长度越大,模型能记住的历史信息越多,可以处理长文档或多轮对话而不丢失前面的内容。

2. MAX OUTPUT (最大输出长度)

-

含义:这是模型一次能生成的 最大 token 数量。

api默认的是default token,如果你要更大的,需要手动指明token为max

所有的模型的上下文长度排名:

https://openrouter.ai/models?arch=DeepSeek&fmt=cards&order=context-high-to-low