Coze Stdio模型配置

Ollama下载与安装

Ollama 是一个开源的大型语言模型(LLM)平台,Ollama 提供了简洁易用的命令行界面和服务器,使用户能够轻松下载、运行和管理各种开源 LLM,通过 Ollama,用户可以方便地加载和使用各种预训练的语言模型,支持文本生成、翻译、代码编写、问答等多种自然语言处理任务。

ollama官网:https://ollama.com

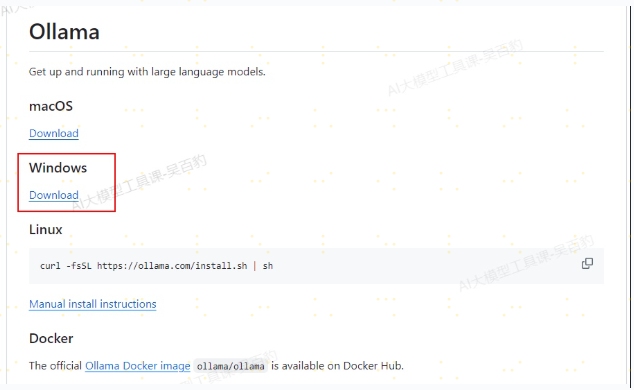

Ollama下载地址:https://github.com/ollama/ollama,这里以window中下载为例:

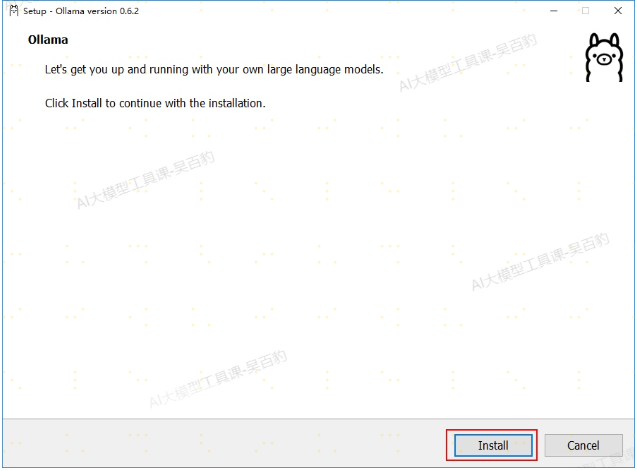

下载完成后双击“OllamaSetup.exe”进行安装,默认安装在“C\users\{user}\AppData\Local\Programs”目录下,建议C盘至少要有10G 剩余的磁盘空间,因为后续Ollama中还要下载其他模型到相应目录中。

安装完成后,电脑右下角自动有“Ollama”图标并开机启动。可以在cmd中运行模型进行会话

#命令 ollama run +模型 deepseek-r1:1.5b

ollama run deepseek-r1:1.5b

>>> 你是谁?

<think>

</think>

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。如您有任何任何问题,我会尽我所能为您提供帮助。

>>>

注意:使用run命令第一次运行模型,如果模型不存在会自动下载,然后进入模型交互窗口。后续使用会自动进入到交互窗口。

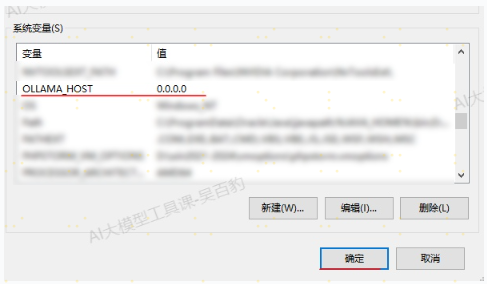

在浏览器中输入“localhost:11434”可以访问ollama,输出“Ollama is running”。默认情况下,Ollama 服务仅监听本地回环地址(127.0.0.1),这意味着只有在本地计算机上运行的应用程序才能访问该服务,如果想要使用“window ip:11434”访问ollama需要在环境变量中加入“OLLAMA_HOST”为“0.0.0.0”,这样就将 Ollama 的监听地址设置为 0.0.0.0,使其监听所有网络接口,包括本机 IP 地址。

注意:以上环境变量设置完成后,需要重启ollama。

Ollama聊天模型配置

Coze Studio 是基于大语言模型的 AI 应用开发平台,首次部署运行 Coze Studio 开源版之前,你需要先克隆到本地的项目中,配置所需要的模型。项目正常运行过程中,也可以随时按需添加新的模型服务、删除不需要的模型服务。

Coze Studio 支持的模型服务如下:

火山方舟 | Byteplus ModelArk

OpenAI

DeepSeek

Claude

Ollama

Qwen

Gemini

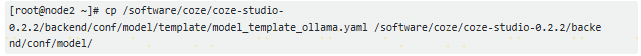

在 Coze Studio 开源版中,模型配置统一放在backend/conf/model 目录中,目录下存在多个 yaml 文件,每个文件对应一个可访问的模型。 为方便开发者快速配置,Coze Studio 在 backend/conf/model/template 目录下提供了一些模板文件,覆盖了常见的模型类型,例如火山方舟、OpenAI 等。开发者可以找到对应厂商的模型模板,复制到backend/conf/model 目录,根据模板注释设置各个参数。

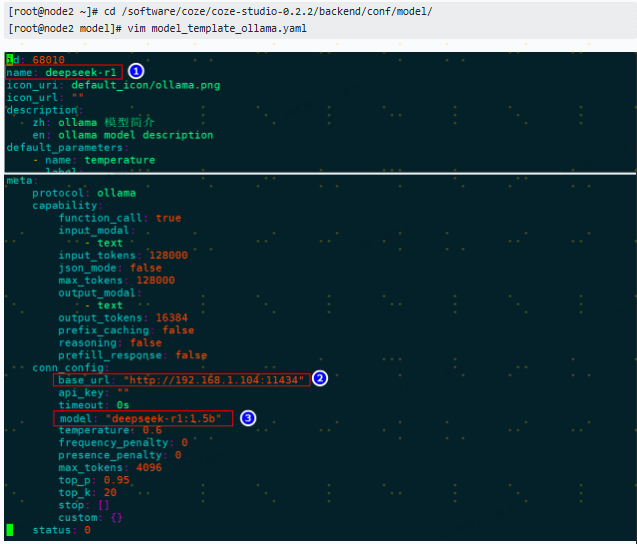

以上各种模型的配置可以参考:https://github.com/coze-dev/coze-studio/wiki/3.-%E6%A8%A1%E5%9E%8B%E9%85%8D%E7%BD%AE ,如下演示在Coze Stdio中配置Ollama 的“deepseek-r1:1.5b”模型,步骤如下:

1) 复制模板文件

2) 修改模型配置

name为展示在Coze Stdio中模型的名字;meta.conn_config.base_url为ollama地址;meta.conn_config.model为使用的Ollama中的模型名称。

3) 重启Coze Stdio 服务

#停止Coze Stdio服务

[root@node2 docker]# docker compose down#启动Coze Stdio服务

[root@node2 docker]# docker compose up -d

Ollama向量化模型配置

Coze Studio 开源版支持自定义设置知识库向量化依赖的 Embedding 模型,使知识库的向量化环节效果更符合指定场景的业务需求。

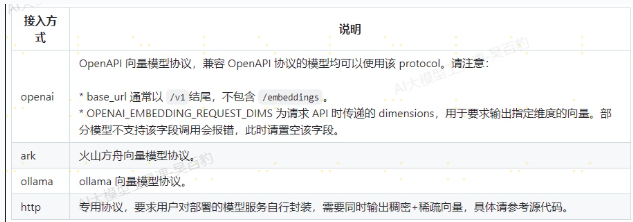

Coze Studio 支持四种方式接入向量化模型:

如下我们使用Ollama中“nomic-embed-text:latest”模型作为向量Embedding模型,配置方式如下:

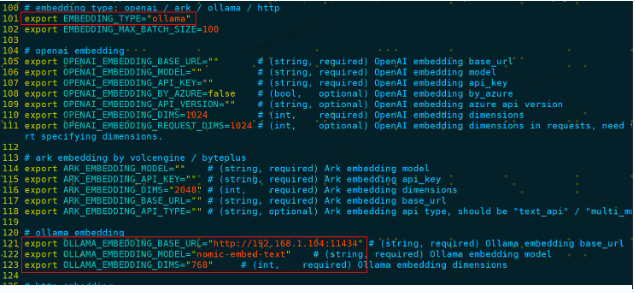

**1) 配置.env**

进入$COZE\_STIDIO\_HOME/docker/.env 文件,找到Embedding配置模块,配置如下:

```

export EMBEDDING_TYPE="ollama"

export OLLAMA_EMBEDDING_BASE_URL="http://192.168.1.104:11434"

export OLLAMA_EMBEDDING_MODEL="nomic-embed-text"

export OLLAMA_EMBEDDING_DIMS="768"

```

配置文成后保存.evn文件。

注意:EMBEDDING_TYPE 默认值为ark(火山方舟向量模型),这里使用Ollama中“nomic-embed-text”向量模型,所以改为ollama;“nomic-embed-text”模型需要在Ollama中提前下载,该模型向量化后的维度为768。

2) 重启Coze Stdio服务

#停止Coze Stdio服务

[root@node2 docker]# docker compose down#启动Coze Stdio服务

[root@node2 docker]# docker compose up -d