Class62 优化算法

Class62 优化算法

优化算法

在给定的目标函数下,寻找一组参数,使目标函数的值达到最优(最大化或最小化)

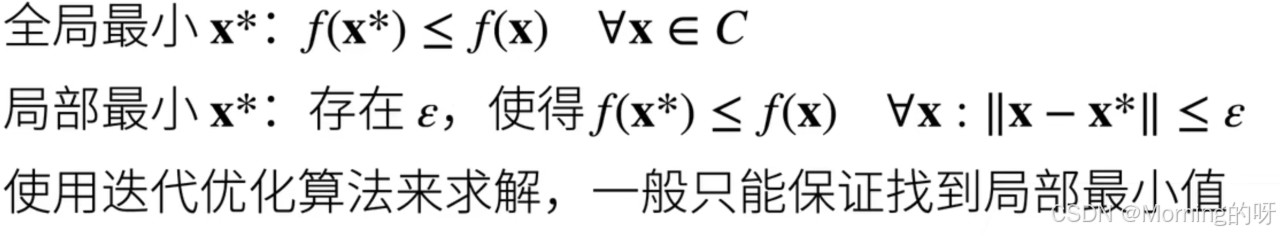

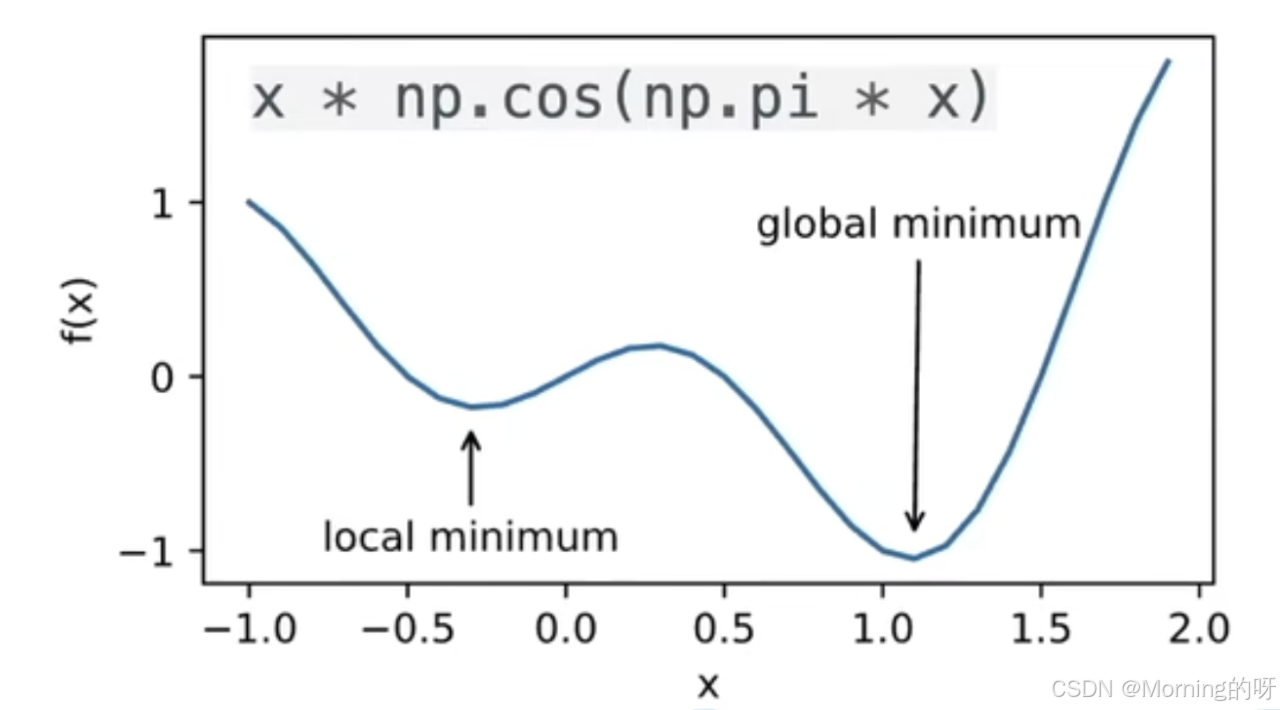

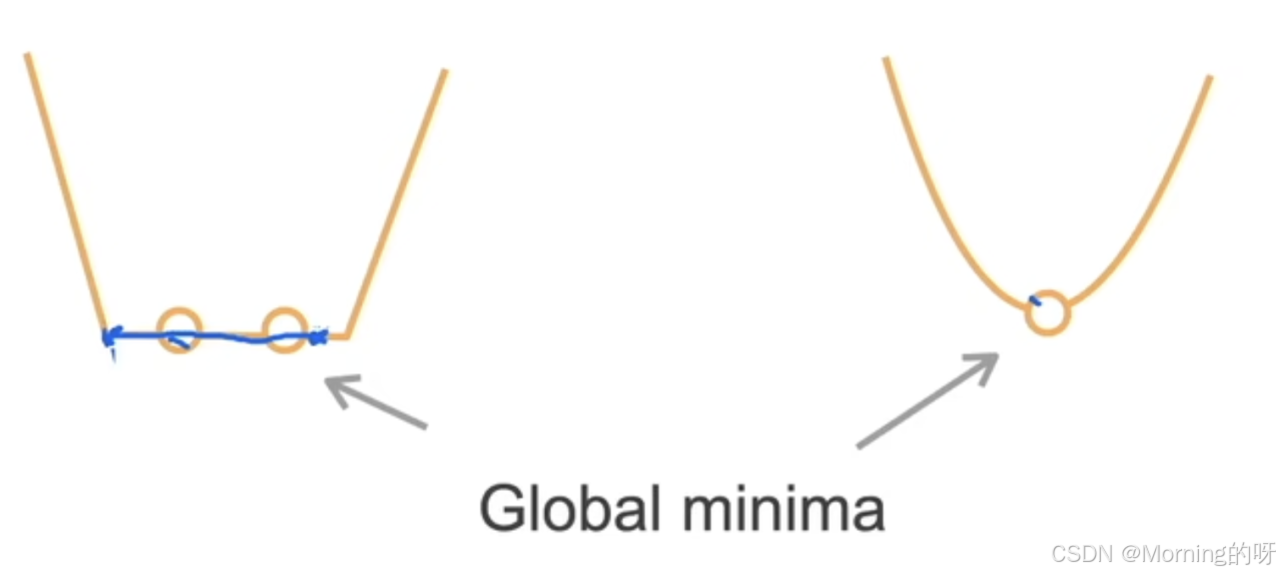

局部最小vs全局最小

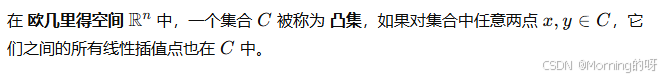

突集

也就是说,取集合中的两点𝑥和 𝑦,连成一条线段,这条线段的每一点都在集合𝐶内。

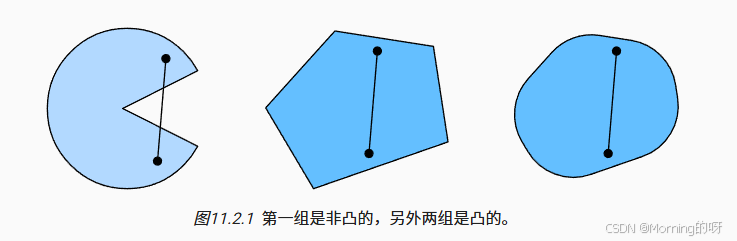

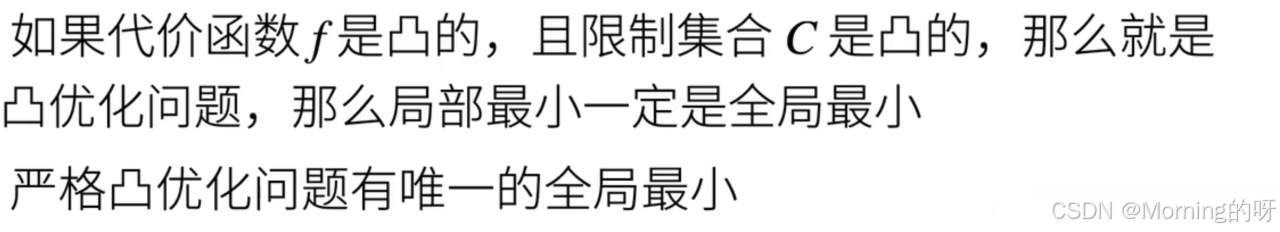

凸函数优化

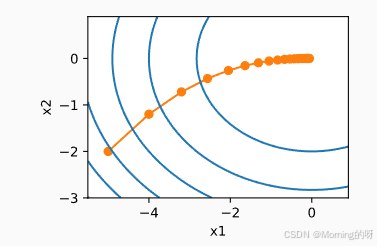

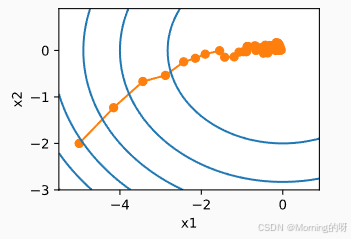

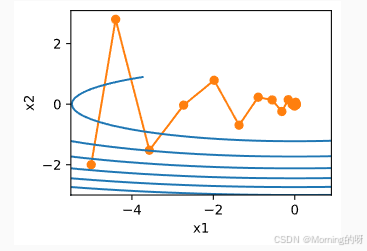

梯度下降

找到能 最小化目标函数(损失函数) 的参数

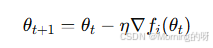

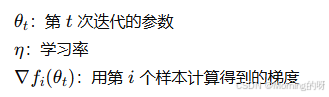

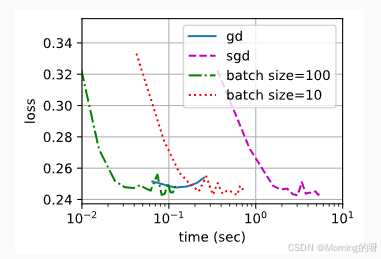

随机梯度下降

每次更新参数,只用一个样本来计算梯度

小批量随机梯度下降

小批量随机梯度下降是介于批量梯度下降(Batch GD)和 随机梯度下降(SGD)之间的一种折中方法

每次更新用全部数据计算梯度,每次更新只用一个样本

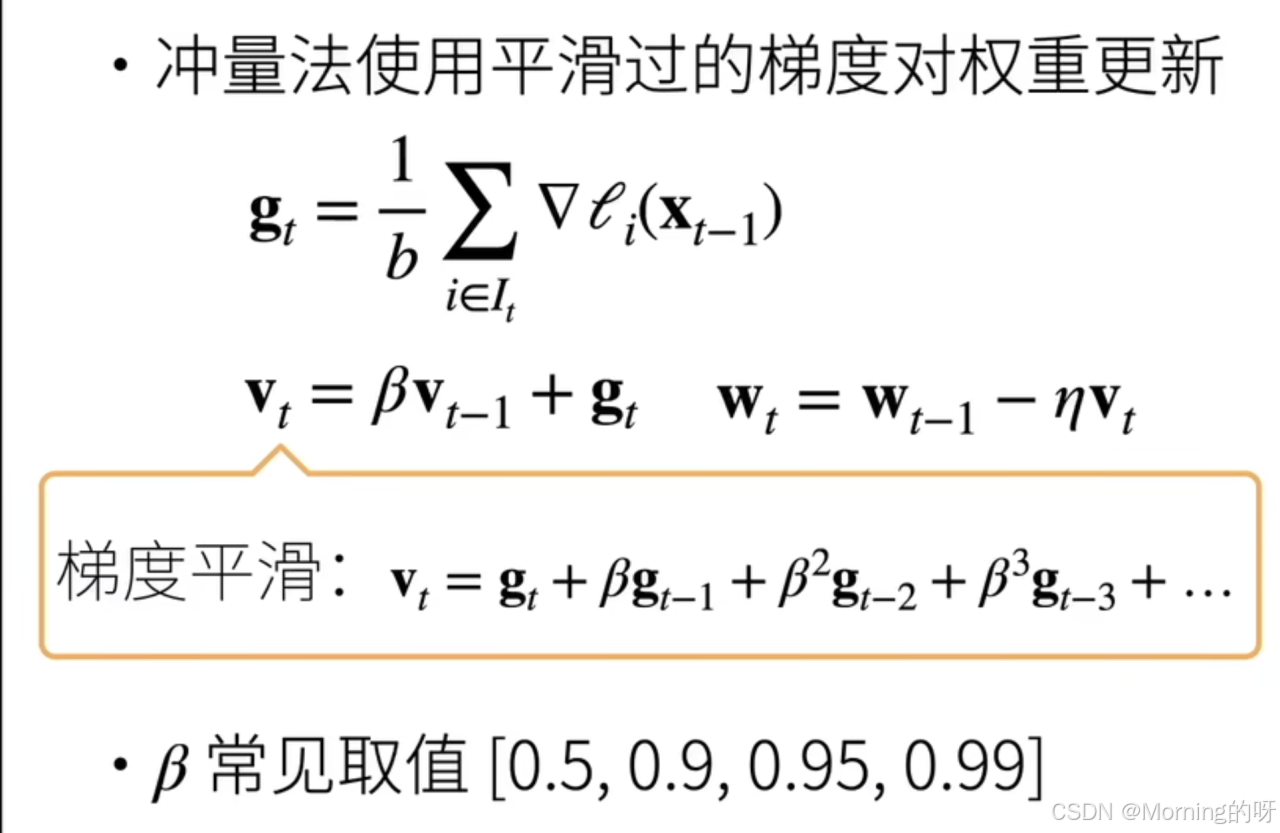

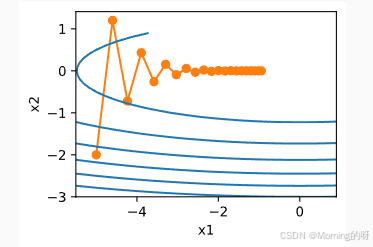

冲量法

不仅仅看当前的梯度,还要“记住”之前的更新方向,给参数增加“惯性”,像物体运动中的冲量一样,继续往前冲一段。

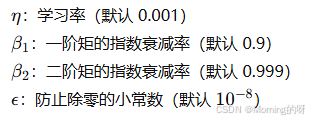

Adam法

Adam就是结合了Momentum和RMSProp的优点:

1.动量:累积一阶梯度,平滑更新方向。

2.自适应学习率:根据梯度平方调整每个参数的步长

Adam 的核心思想

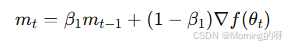

1.一阶矩(均值,momentum 部分)

类似动量法,对梯度做指数加权平均

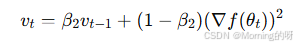

2.二阶矩(平方的均值,RMSProp 部分)

对梯度平方做指数加权平均,估计方差

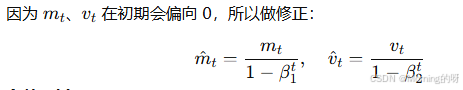

3.偏差修正

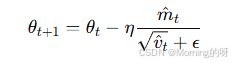

4.参数更新