中农农业机器人具身导航最新突破!T-araVLN:农业机器人视觉语言导航的指令翻译器

-

作者:Xiaobei Zhao, Xingqi Lyu, Xiang Li

-

单位:中国农业大学

-

论文标题:T-araVLN: Translator for Agricultural Robotic Agents on Vision-and-Language Navigation

-

论文链接:https://arxiv.org/pdf/2509.06644v3

主要贡献

-

提出了指令翻译模块,能够将含噪声和错误的自然语言指令转化为精炼且精确的指令,从而提高农业机器人对指令的理解能力。

-

提出了T-araVLN方法,通过整合指令翻译模块,显著提升了农业机器人在视觉语言导航任务中的成功率和导航精度。

-

通过消融实验和对比实验验证了指令翻译模块的有效性,并证明了T-araVLN在农业视觉语言导航领域达到了最佳性能。

研究背景

-

农业机器人在多种农业任务中扮演着重要角色,但它们的移动大多依赖人工操作或固定的轨道,这限制了它们的灵活性和效率。

-

视觉语言导航(VLN)技术允许机器人根据自然语言指令导航到目标位置,并在多个领域取得了良好的效果。受此启发,研究者将VLN技术引入农业领域,提出了AgriVLN方法和A2A基准测试中农具身导航赋能智慧农业!AgriVLN:农业机器人的视觉语言导航。

-

然而,AgriVLN在理解简单指令时表现良好,但在处理复杂指令时常常出现误解。为了解决这一问题,研究者提出了T-araVLN方法。

方法

任务定义

-

在农业视觉语言导航(Agricultural Vision-and-Language Navigation)任务中,模型需要根据自然语言指令导航到目标位置。

-

具体来说,模型在每个时间步接收自然语言指令 和前向RGB图像 ,目标是理解语言指令和视觉输入,选择最佳的低级动作 (从动作空间 {FORWARD, LEFT ROTATE, RIGHT ROTATE, STOP} 中选择),从而引导机器人从起点导航到终点。

T-araVLN

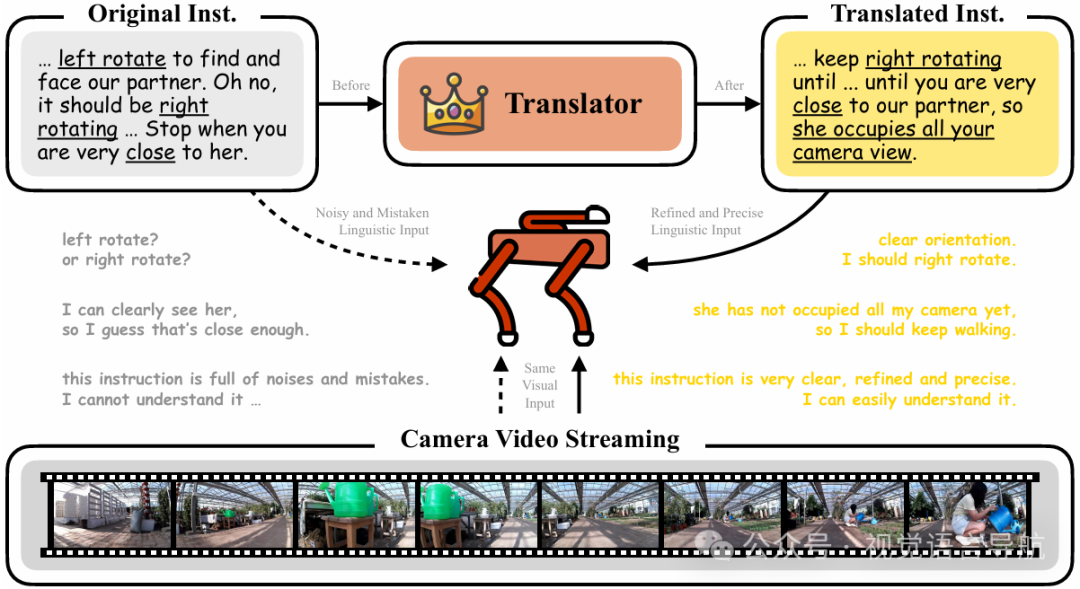

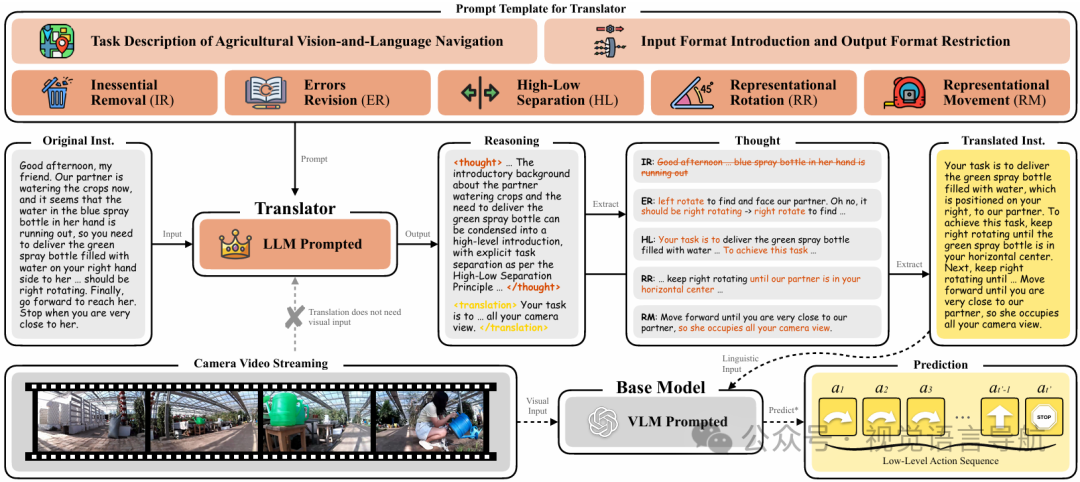

T-araVLN 是一种改进的农业视觉语言导航方法,其核心在于引入了一个指令翻译模块,该模块能够将原始的、可能包含噪声和错误的自然语言指令转化为更加精炼和精确的指令,从而提高下游模型对指令的理解能力。

指令翻译

该模块利用大型语言模型(LLM)构建,其目标是将原始的口语风格指令 转化为正式的书面语风格指令 ,同时去除不必要的语义信息,保留关键的语义内容。

-

翻译过程:翻译过程遵循一个明确的公式:

其中, 表示明确的推理过程, 表示连接操作, 是为翻译任务设计的提示模板。

-

提示模板:提示模板 的结构如下:

其中, 是对任务的描述, 是对输入和输出格式的限制, 表示五种翻译原则,每种原则都有一个示例 来指导翻译过程:

-

去除不必要内容(Inessential Removal)

-

修正错误(Errors Revision)

-

分离高低层次信息(High-Low Separation)

-

旋转表征(Representational Rotation)

-

移动表征(Representational Movement)。

-

-

翻译效果:经过翻译后的指令 比原始指令 更容易被下游的VLN决策模型理解。

基础模型

T-araVLN 的基础模型采用了 AgriVLN 的架构,记作 ,其中将指令翻译模块集成在指令输入层和子任务列表模块之间。

在每个时间步 ,基础模型尝试理解翻译后的指令 和相机图像 ,以决定最佳的低级动作 用于导航。这一过程可以表示为:

其中, 表示结束时间步,当满足以下任一条件时,导航过程结束:

-

预测的动作 ;

-

预测的动作序列与标签序列的偏差超过阈值 ;

-

时间步 达到上限。

评估指标

-

为了评估 T-araVLN 的性能,研究者采用了两个标准的 VLN 评估指标:成功率(Success Rate, SR)和导航误差(Navigation Error, NE)。

-

此外,还引入了 BERTScore F1 来计算原始指令和翻译后指令之间的语义相似度。BERTScore F1 的得分越低,表示翻译的修改程度越大,即翻译策略越激进;得分越高,则表示修改程度越小,翻译策略越保守。

实验

实验设置

-

实验平台:所有实验均在A2A基准测试上进行,这是一个专为农业视觉语言导航(VLN)设计的基准测试,包含多种复杂度的导航任务。

-

模型接口:通过API访问所有大型语言模型(LLMs),以确保实验的可重复性和公平性。

定性实验

-

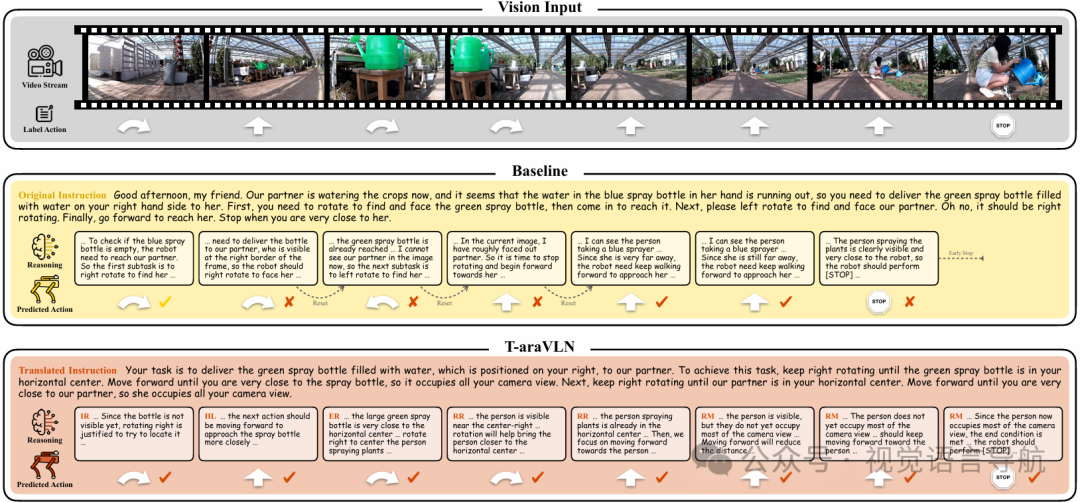

实验目的:通过具体案例展示T-araVLN如何将含噪声和错误的原始指令转化为精炼且精确的指令,从而提高导航性能。

-

实验结果:如图所示,原始指令包含多种噪声和错误,导致语言和视觉输入之间的对齐困难。T-araVLN通过其Instruction Translator模块,将原始指令转化为更易于理解的形式,从而显著提高了导航的准确性和效率。

-

具体案例分析:

-

原始指令:包含多余背景信息、语法错误和模糊表述。

-

翻译后指令:去除多余信息,修正错误,明确任务目标和动作序列。

-

导航结果:T-araVLN能够根据翻译后的指令准确导航至目标位置,而基线模型则因指令理解错误而偏离正确路径。

-

对比实验

-

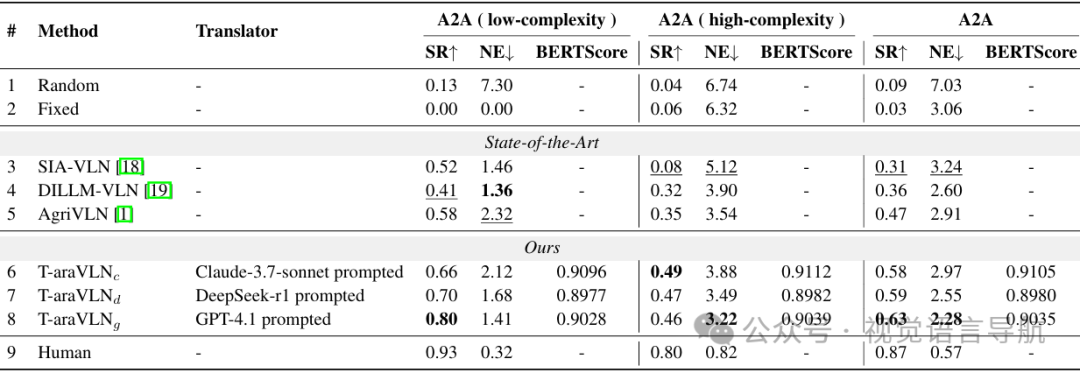

实验目的:将T-araVLN与现有的三种最先进模型(SIA-VLN、DILLM-VLN和AgriVLN)进行性能对比,验证T-araVLN在农业VLN领域的优势。

-

实验设置:

-

对比模型:SIA-VLN、DILLM-VLN、AgriVLN。

-

基线模型:随机(Random)、固定(Fixed)和人类(Human)模型,分别作为性能的下界和上界。

-

评估指标:成功率(SR)、导航误差(NE)和BERTScore F1。

-

-

实验结果:

-

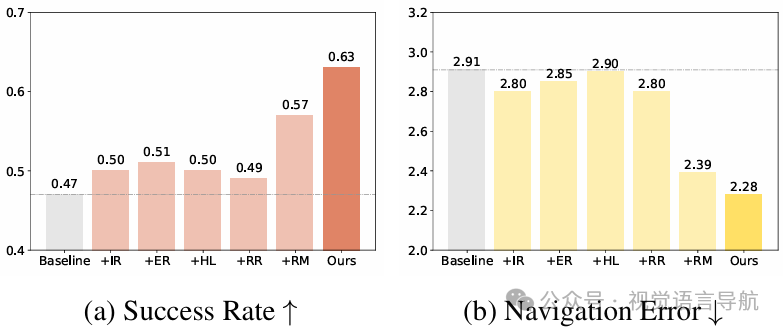

整体性能:T-araVLN在A2A基准测试的整体性能上,成功率(SR)从0.47提升至0.63,导航误差(NE)从2.91米降低至2.28米,显著优于所有基线模型。

-

低复杂度部分:在低复杂度任务(子任务数=2)中,T-araVLN的成功率提升至0.80,接近人类水平(0.93),导航误差降低至1.41米。

-

高复杂度部分:在高复杂度任务(子任务数≥3)中,T-araVLN的成功率为0.46,导航误差为3.22米,虽然不如低复杂度部分,但仍然优于其他基线模型。

-

BERTScore F1:T-araVLN的BERTScore F1为0.9035,表明翻译后的指令与原始指令在语义上保持了较高的相似度,同时去除了不必要的噪声。

-

消融实验

大型语言模型

-

实验目的:测试不同大型语言模型(LLMs)对T-araVLN性能的影响,选择最适合的LLM作为Instruction Translator模块的驱动。

-

实验设置:使用Claude-3.7-sonnet、DeepSeek-r1和GPT-4.1三种LLMs分别驱动Instruction Translator模块。

-

实验结果:

-

Claude-3.7-sonnet:BERTScore为0.9105,成功率(SR)为0.58,导航误差(NE)为2.97米。该模型的翻译策略较为保守,保留了较多噪声。

-

DeepSeek-r1:BERTScore为0.8980,成功率(SR)为0.59,导航误差(NE)为2.55米。该模型的翻译策略较为激进,删除了一些关键语义。

-

GPT-4.1:BERTScore为0.9035,成功率(SR)为0.63,导航误差(NE)为2.28米。该模型在保守和激进之间取得了最佳平衡。

-

-

结论:GPT-4.1在翻译策略上达到了最佳平衡,因此被选为T-araVLN中Instruction Translator模块的LLM。

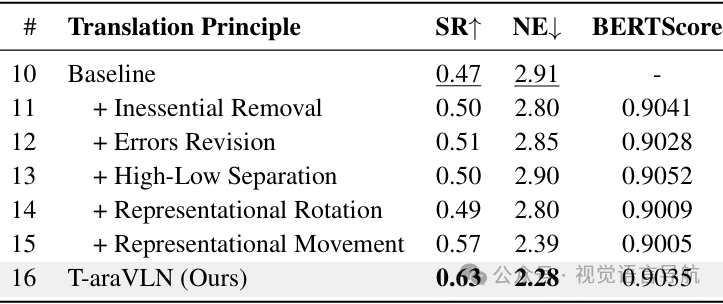

翻译原则

-

实验目的:验证Instruction Translator模块中五个翻译原则的有效性,并分析它们对性能的贡献。

-

实验设置:逐一应用五个翻译原则(去除不必要内容、修正错误、分离高低层次信息、旋转表征、移动表征),并测试它们的组合效果。

-

实验结果:

-

去除不必要内容(Inessential Removal):成功率(SR)提升至0.50,导航误差(NE)降低至2.80米。

-

修正错误(Errors Revision):成功率(SR)提升至0.51,导航误差(NE)降低至2.85米。

-

分离高低层次信息(High-Low Separation):成功率(SR)提升至0.50,导航误差(NE)为2.90米。

-

旋转表征(Representational Rotation):成功率(SR)为0.49,导航误差(NE)降低至2.80米。

-

移动表征(Representational Movement):成功率(SR)提升至0.57,导航误差(NE)降低至2.39米。

-

所有原则组合(T-araVLN):成功率(SR)提升至0.63,导航误差(NE)降低至2.28米。

-

-

结论:每个翻译原则都能在不同程度上提升性能,且所有原则组合时效果最佳,表明这些原则在翻译过程中相互协作,共同提升了指令的质量。

结论与未来工作

-

结论:

-

T-araVLN通过Instruction Translator模块将原始指令转化为更精炼和精确的形式,在A2A基准测试上取得了最佳性能,有效提高了成功率并降低了导航误差。

-

-

未来工作:

-

进一步优化Instruction Translator模块,探索更高效的LLM或改进翻译原则,以进一步提高农业机器人的导航性能。

-

此外,还可能将该方法扩展到其他农业任务或更复杂的农业环境中进行测试和应用。

-