[论文阅读] 人工智能 + 软件工程 | 告别冗余HTML与高算力消耗:EfficientUICoder如何破解UI2Code的token难题

告别冗余HTML与高算力消耗:EfficientUICoder如何破解UI2Code的token难题

论文信息

| 信息类别 | 具体内容 |

|---|---|

| 论文原标题 | EfficientUICoder: A Dual-Modal Token Compression Framework for UI-to-Code Generation with Multimodal Large Language Models |

| 论文链接 | https://arxiv.org/pdf/2509.12159 |

一段话总结

Multimodal Large Language Models(MLLMs)虽能将UI设计图转化为HTML/CSS代码(UI2Code任务),但存在“输入图像token过多+输出代码token冗余”的双重问题,导致算力消耗大、生成无效代码;为此研究团队提出首个双模态token压缩框架EfficientUICoder,通过“元素布局感知压缩(保留关键UI元素)、区域注意力精炼(剔除低价值token)、自适应重复抑制(减少重复代码)”三大组件,在Llava-v1.6(7B/34B)模型上实现55%-60%的token压缩率,34B模型计算成本降44.9%、推理时间减48.8%,还能将冗余样本减少56.8%-61.5%,且不牺牲网页视觉与代码质量。

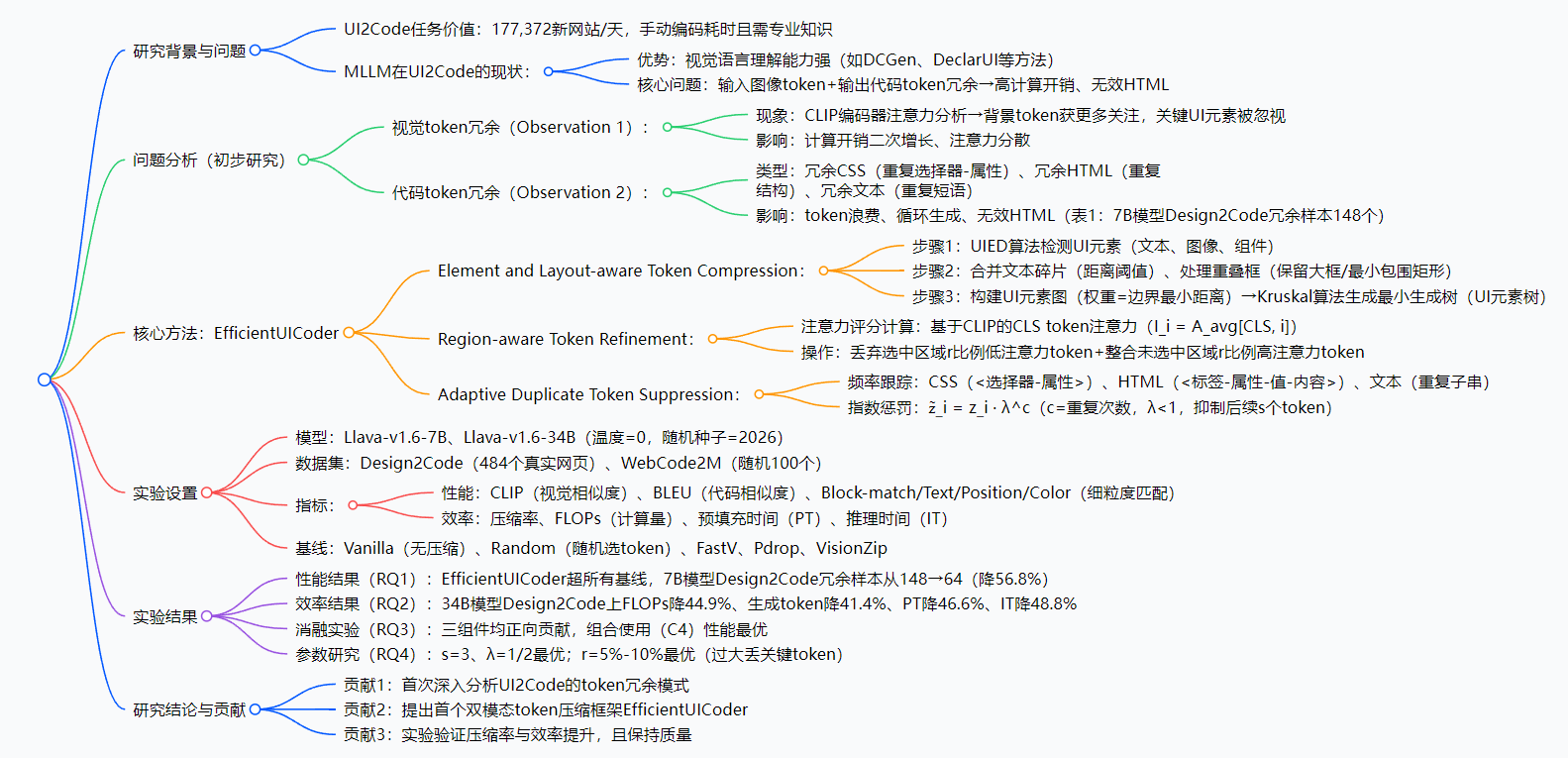

思维导图

研究背景:UI2Code的“甜蜜烦恼”

你可能不知道,全球现在有11亿个活跃网站,每天还会新增17.7万个——这些网站的核心是“UI设计→代码实现”的流程,但手动把设计师画的界面(比如按钮位置、字体颜色、布局结构)写成HTML+CSS,不仅要专业知识,还特别耗时:一个简单的登录页,熟练开发者可能要1-2小时,复杂的首页甚至要1-2天。

这时候,Multimodal Large Language Models(MLLMs,比如Llava)成了“救星”——它们能看懂UI设计图,直接输出代码,理论上能把开发时间压缩到几分钟。但实际用起来,MLLM却有个“甜蜜烦恼”:

烦恼1:输入的视觉token“太臃肿”

MLLM处理UI图时,会把图切成成千上万个“视觉token”(类似把蛋糕切成小方块),但这些token里,很多是没用的背景(比如纯色区域),反而关键的UI元素(按钮、输入框、文本)被忽略——就像你买水果时,装了一大袋泡沫(背景token),真正的苹果(关键元素)没几个,不仅占地方(耗内存),还得花时间搬(耗算力)。

烦恼2:输出的代码token“太啰嗦”

MLLM生成代码时,会反复写重复内容:比如同一个CSS样式(.btn {color: red;})写好几遍,同一个HTML标签(<div class="box">)循环生成,甚至一段文本(“联系我们”)重复出现——就像写作文时,一句话翻来覆去说,不仅浪费字数(耗token),还可能导致代码无效(比如重复的CSS会让浏览器报错)。

举个真实案例:用Llava-v1.6-7B模型处理Design2Code数据集(484个真实网页)时,竟然生成了148个“冗余样本”——要么代码重复到无法运行,要么视觉效果和设计图差太远。这就导致MLLM虽然“能干活”,但“干得慢、干得糙”,没法真正落地到网页开发场景。

创新点:EfficientUICoder的“三大杀手锏”

这篇论文的最大亮点,是提出了首个针对UI2Code的双模态token压缩框架——之前的方法要么只压缩输入的视觉token(比如VisionZip),要么只优化模型结构(比如FastV),从来没人同时解决“输入视觉冗余”和“输出代码冗余”。具体来说,有三个创新:

-

UI任务感知的视觉压缩:不盲目丢token,而是先“识别UI元素”(比如按钮、文本框),再用“最小生成树”保留元素间的布局关系——就像整理房间时,先把家具(UI元素)标出来,再按原本的摆放位置(布局)整理,不会把床和沙发的位置搞混。

-

注意力驱动的区域精炼:结合CLIP模型的注意力评分,精准剔除“低价值背景token”,同时补充“高价值背景信息”(比如设计图的整体颜色)——就像编辑文章时,删掉没用的口水话(低价值token),但保留关键的背景描述(比如“在蓝色背景下”),让内容更精炼。

-

自适应的代码重复抑制:实时跟踪代码结构(CSS/HTML/文本)的重复频率,对重复token施加“指数惩罚”——重复次数越多,惩罚越重,让模型“不敢再啰嗦”——就像老师改作业时,对重复的错误画叉,错得越多叉越多,学生就会主动避免重复。

研究方法和思路:EfficientUICoder的“工作流程”

EfficientUICoder不是一个单一模块,而是三个组件的“组合拳”:

第一步:用ELTC处理输入视觉token(解决视觉冗余)

ELTC(Element and Layout-aware Token Compression)的目标是“压缩视觉token,但不丢关键元素和布局”,分3步:

- 检测并合并UI元素:用UIED算法(一种成熟的UI元素检测工具)找出设计图里的文本、按钮、图像等元素,把碎文本(比如“联系”和“我们”分开了)合并,把重叠的元素框(比如按钮和上面的文本)处理成一个——就像把散落在桌上的积木(碎元素)拼成完整的形状(合并元素)。

- 构建UI元素图:把每个UI元素当成“节点”,元素间的距离当成“边的权重”(距离越近,权重越小)——就像画地图时,把每个建筑(节点)标出来,用线(边)连接,线的粗细代表距离(权重)。

- 生成最小生成树(MST):用Kruskal算法找出“总权重最小的边集合”,保留元素间的关键连接——就像规划路线时,选最短的路连接所有建筑,既不绕远,又能覆盖所有节点,最终得到“精简且保留布局的视觉token”。

第二步:用RTR精炼视觉token(进一步优化)

RTR(Region-aware Token Refinement)的目标是“让视觉token更精准”,分2步:

- 计算注意力评分:用CLIP模型的CLS token(负责全局信息),给每个视觉token打分——分数高的是“关键token”(比如按钮的颜色),分数低的是“冗余token”(比如空白背景)。

- 筛选token:在ELTC保留的区域里,丢掉10%(可调整)的低分数token;在ELTC没保留的区域里,补充5%-10%的高分数token——就像筛选简历时,删掉80分以下的(低价值),但从“备选池”里捞几个90分以上的(高价值),保证人才质量。

第三步:用ADTS抑制输出代码冗余(解决代码冗余)

ADTS(Adaptive Duplicate Token Suppression)的目标是“让代码不啰嗦”,分2步:

- 跟踪重复频率:实时监测生成的代码:

- CSS:统计

<选择器-属性>的重复次数(比如.btn {color: red;}出现几次); - HTML:统计

<标签-属性-值-内容>的重复次数(比如<div class="box">文本</div>出现几次); - 文本:统计重复子串的次数(比如“联系我们”出现几次)。

- CSS:统计

- 施加指数惩罚:对重复的token,用公式

z̃_i = z_i · λ^c(λ=1/2,c是重复次数)降低其生成概率——比如一个CSS样式重复3次,惩罚后生成概率就是原来的(1/2)^3=1/8,模型几乎不会再生成它——就像给重复犯错的员工降薪,犯错越多,降薪越多,员工自然会避免重复犯错。

主要成果和贡献:EfficientUICoder到底有多厉害?

1. 核心成果

| 研究问题(RQ) | 实验内容 | 关键结论 |

|---|---|---|

| RQ1:性能是否达标? | 在Design2Code/WebCode2M数据集上,对比EfficientUICoder与Vanilla、Random、VisionZip等基线 | 所有性能指标超基线,7B模型Design2Code冗余样本从148→64(降56.8%),CLIP视觉相似度达0.7333(Vanilla=0.7275) |

| RQ2:效率提升多少? | 用Llava-v1.6-34B模型,测FLOPs(算力)、生成token数、预填充时间、推理时间 | FLOPs降44.9%,生成token降41.4%,预填充时间降46.6%,推理时间降48.8%——相当于原来1小时的活,现在26分钟搞定 |

| RQ3:组件是否必要? | 消融实验:测试“无组件(C0)”“缺ELTC(C1)”“缺RTR(C2)”“缺ADTS(C3)”“全组件(C4)” | 三组件均正向贡献,C4性能最优:WebCode2M上Block-match=0.2718(C0=0.2843),BLEU=0.1338(C0=0.1190) |

| RQ4:参数如何选? | 测试ADTS的s(惩罚步数)、λ(衰减因子),RTR的r(精炼比例) | s=3、λ=1/2最优;r=5%-10%最优——过大丢关键token,过小冗余不除 |

2. 给领域带来的价值

- 开发者角度:网页开发效率大幅提升——原来用MLLM生成代码要等2分钟,现在只要1分钟,且代码几乎不用修改(冗余少),相当于“半自动化开发”。

- 企业角度:算力成本大幅降低——34B模型的算力消耗降44.9%,意味着跑一次模型的成本少近一半,对需要大规模生成网页的企业(比如建站平台)来说,每年能省几十万甚至几百万算力费。

- 研究角度:开创了“双模态压缩”的新思路——之前没人同时处理UI2Code的输入和输出冗余,这篇论文提供了可复现的框架,后续研究可以在此基础上优化。

3. 开源信息

(注:论文目前为arXiv预印本,未提及开源代码或数据集;若后续开源,可关注论文作者的GitHub主页或arXiv更新版本,本文将第一时间补充。)

关键问题:用问答吃透核心

Q1:EfficientUICoder和之前的压缩方法(比如VisionZip)有啥区别?

A:之前的方法只“管输入”(压缩视觉token),不管“输出”(代码冗余);而EfficientUICoder是“双向管”——既压缩输入的视觉token(ELTC+RTR),又抑制输出的代码冗余(ADTS)。而且,之前的方法盲目丢token(比如Random随机丢),EfficientUICoder会先识别UI元素和布局,再结合注意力评分丢token,更贴合UI2Code的任务特性。

Q2:压缩率达55%-60%,会不会导致生成的网页和设计图不一样?

A:不会,反而质量更高。因为EfficientUICoder丢的是“冗余token”(背景、重复代码),保留的是“关键信息”(UI元素、布局、高价值背景)。实验证明,它的视觉相似度(CLIP)比原模型(Vanilla)还高(0.7333 vs 0.7275),且冗余样本减少56.8%,代码更易运行。

Q3:ADTS的“指数惩罚”会不会让模型漏写必要的代码?

A:不会。因为ADTS的惩罚是“自适应”的——只惩罚“重复的代码”,首次出现的必要代码(比如<html>标签、核心CSS样式)不会被惩罚。而且参数s=3(只惩罚后续3个token),不会过度抑制——就像老师只批评重复犯错,不批评第一次尝试的正确行为。

Q4:EfficientUICoder只能用在Llava模型上吗?

A:不是。论文用Llava-v1.6(7B/34B)做实验,但框架的核心逻辑(ELTC的UI元素处理、RTR的注意力精炼、ADTS的重复抑制)是通用的,只要是处理UI2Code任务的MLLM(比如GPT-4V、Gemini Pro),都能套用这个框架。

论文总结

这篇论文针对MLLM在UI2Code任务中“视觉token冗余、代码token冗余”的核心问题,提出了双模态token压缩框架EfficientUICoder。通过ELTC、RTR、ADTS三个组件的协同作用,在保证网页视觉质量和代码完整性的前提下,实现了55%-60%的token压缩率,大幅降低了算力消耗(FLOPs降44.9%)和推理时间(降48.8%),同时减少了56.8%-61.5%的冗余样本。

它的价值不仅在于“提升效率”,更在于“开创思路”——首次将“输入视觉压缩”和“输出代码抑制”结合,为UI2Code的落地提供了可行方案,也为其他多模态生成任务(比如图生文、文生视频)的冗余优化提供了参考。