ActiveMQ RocketMQ RabbitMQ Kafka选型及应用场景

许多时候我们都将Kafka拿来跟常用的几个消息队列作比较,将 Kafka 加入对比使得选型更加全面和实际。但请注意Kafka并非完全适用消息中间件的所有场景。这四款消息中间件定位不同,选择取决于你的具体场景。

消息队列选型

核心定位一句话总结

RabbitMQ:成熟稳健的企业级消息代理。擅长于复杂的路由、低延迟消息传递和微服务异步通信。

ActiveMQ:Java 生态中的老牌多协议代理。遵循 JMS 规范,适合传统的、需要多种协议(如 OpenWire, STOMP, MQTT)集成的场景。

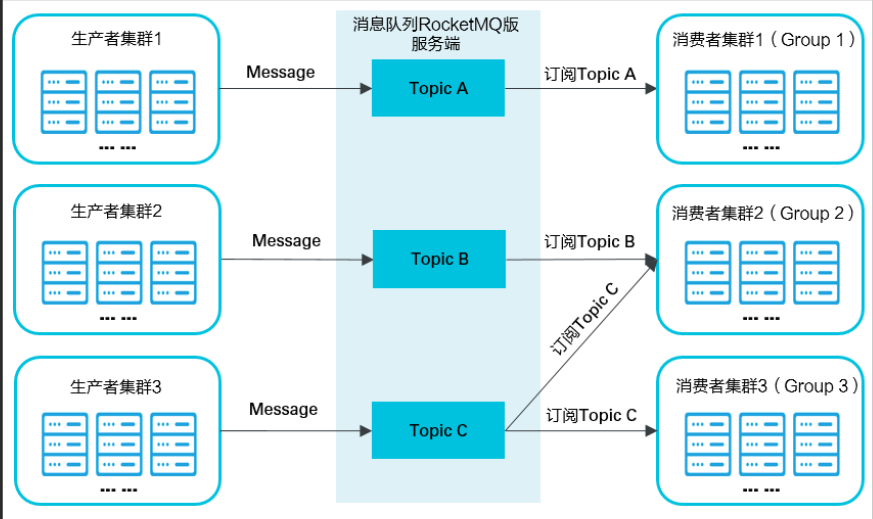

RocketMQ:金融级可靠、海量吞吐的队列。为分布式场景设计,尤其擅长顺序消息、大规模延迟消息、事务消息等核心业务场景。

Kafka:高吞吐、高扩展的分布式流处理平台。专为处理海量实时数据流(如日志、点击流、指标)构建,用于大数据管道和流式分析。

四者详细选型对比表

| 特性维度 | RabbitMQ | ActiveMQ | RocketMQ | Kafka |

|---|---|---|---|---|

| 核心定位 | 企业级消息代理 | 多协议消息代理 | 金融级/互联网级队列 | 分布式流处理平台 |

| 协议 | AMQP 为主 | 多协议(OpenWire, STOMP, MQTT, AMQP...) | 自定义协议(TCP/JMS) | 自定义协议(TCP) |

| 吞吐量 | 万级到十万级 QPS | 万级 QPS | 十万级到百万级 QPS | 百万级 QPS+(吞吐量之王) |

| 延迟 | 微秒级到毫秒级(最低) | 毫秒级 | 毫秒级 | 毫秒级到秒级(高吞吐牺牲了低延迟) |

| 可靠性 | 高(主从镜像队列) | 高(LevelDB/KahaDB 持久化) | 非常高(多副本、刷盘策略) | 极高(多副本、ISR 机制) |

| 顺序消息 | 无法保证(单个队列可保证) | 无法保证 | 严格保证(分区有序) | 严格保证(分区有序) |

| 事务消息 | 支持(性能差) | 支持(JMS XA) | 支持(高性能) | 支持(但语义不同,主要用于 Exactly-Once) |

| 延迟/定时消息 | 通过 DLX+TTL 模拟,不灵活 | 原生支持(功能强大) | 原生支持(性能极佳) | 不支持(可通过流处理模拟,非常复杂) |

| 消息回溯 | 不支持 | 不支持 | 支持(按时间偏移量) | 支持(核心功能) |

| 生态与集成 | 极广(多种语言客户端,Spring 集成好) | 广(主要 Java/JMS) | 广(主要 Java/阿里生态) | 极广(大数据生态事实标准) |

| 管理界面 | 优秀(管理界面非常友好) | 良好(有 Web Console) | 良好(有 Web Console) | 一般(第三方工具如 Kafka Tool, AKHQ) |

| 开发语言 | Erlang | Java | Java | Scala/Java |

| 学习成本 | 低(概念清晰) | 中 | 中 | 高(概念众多:Topic/Partition/Offset/ISR...) |

| 最佳应用场景 | 企业集成、微服务异步解耦、任务队列 | 传统企业应用、多协议接入(如 MQTT for IoT) | 电商、金融、互联网核心业务(订单、交易、短信) | 日志采集、流数据处理、实时数仓、事件溯源 |

Kafka 是否可以作为延迟队列的可选项?

结论:通常不作为延迟队列的首选,甚至可以说是一个“糟糕”的选择。

原因如下:

缺乏原生支持:Kafka 本身没有提供延迟或定时投递消息的机制。它的设计哲学是“尽快交付”,所有消息在可用后立即被消费者拉取。

实现极其复杂:你只能通过应用层“模拟”实现,常见方案有:

方案A:外部轮询:将需要延迟的消息先存入一个“待处理”Topic。消费者消费该 Topic 的所有消息,检查每条消息的“期望投递时间”。如果时间未到,就重新将其发回 Kafka 或存入数据库,稍后重试。这会产生大量无效的网络和存储开销。

方案B:使用流处理(Kafka Streams / Flink):创建一个流处理任务,将消息按照延迟时间进行窗口聚合,时间窗口到了之后再发送到目标 Topic。这同样非常重,且资源消耗大。

精度和性能差:无论哪种方案,都无法做到精确的、大规模的延迟投递,并且会严重浪费 Kafka 的吞吐量和存储资源,与 Kafka 的设计初衷背道而驰。

唯一可能考虑 Kafka 的场景:

你的系统已经重度依赖 Kafka,并且延迟消息的量不大,延迟精度要求不高(例如,允许分钟级的误差),并且你的团队愿意维护这样一套复杂的、基于应用层的逻辑。否则,应坚决选择 RocketMQ 或 ActiveMQ。

选型建议

1. 微服务异步通信和解耦

推荐:RabbitMQ

理由:路由功能强大(Exchange/Queue/Binding 模型),管理界面优秀,社区成熟,客户端支持语言多,非常适合微服务间的消息传递。如果延迟需求固定且简单,可以用 DLX 勉强应付。

2. 大数据、日志采集、流式处理

推荐:Kafka

理由:毋庸置疑的王者。吞吐量无敌,可靠性极高,生态繁荣(Connect, Streams),与 Flink、Spark、Elasticsearch 等数据组件无缝集成。

3. 电商、金融等核心业务(订单、交易、短信)

推荐:RocketMQ

理由:在吞吐量、延迟、可靠性上做到了最佳平衡。原生支持的顺序消息、事务消息、延迟消息正是这类业务的核心需求。它是阿里双十一场景锤炼出来的产品,久经考验。

4. 传统企业应用或需要多协议支持(如 MQTT for IoT)

推荐:ActiveMQ / ActiveMQ Artemis

理由:遵循 JMS 规范,对 Spring JMS 等传统 JavaEE 应用集成友好。ActiveMQ Artemis 是下一代 broker,性能更强。如果需要同时支持 MQTT 设备接入和内部应用通信,它是一个不错的中心化枢纽。

5. 需要高精度、大规模延迟/定时消息

强烈推荐:RocketMQ

备选:ActiveMQ

避免使用:Kafka, RabbitMQ 也非上选(除非场景极其简单)。

各消息队列对延迟队列的支持对比

延迟队列:处理类似订单超时取消、退款等一类业务,或者定时调用之类的处理。

ActiveMQ、RocketMQ 和 RabbitMQ 在实现延迟队列的方式上有着显著的区别,这也直接影响了它们的适用场景。

下面我将从实现原理、使用方法、优缺点和典型场景四个方面对它们进行详细的对比。

总览对比表

| 特性 | RabbitMQ | RocketMQ | ActiveMQ |

|---|---|---|---|

| 实现原理 | 通过 死信交换机(DLX) 和 TTL 模拟 | 原生支持,内部定时机制 | 原生支持(AMQ Scheduler),内部定时机制 |

| 延迟精度 | 较低(秒级),受队列扫描间隔影响 | 高(毫秒级/秒级),可自定义延迟级别 | 较高(毫秒级) |

| 灵活性 | 差。消息延迟时间不可变,需预先设置队列TTL | 高。可消息级别设置任意延迟时间(新版本) | 高。可消息级别设置任意延迟时间 |

| 可靠性 | 高(与其他消息一样持久化) | 非常高(与其他消息一样持久化) | 高(与其他消息一样持久化) |

| 易用性 | 中等,需要配置死信交换机和绑定,概念较多 | 简单,API 直接支持 | 简单,API 直接支持 |

| 性能 | 较好,但大量延迟消息可能占用普通队列资源 | 极佳,专为海量延迟消息设计,内部优化 | 较好,但大量定时消息可能对性能有影响 |

详细分析

1. RabbitMQ

RabbitMQ 本身并不直接提供延迟队列的功能,而是通过消息生存时间(TTL) 和 死信交换机(Dead-Letter-Exchange, DLX) 两个特性组合来模拟实现。

实现原理:

创建一个普通队列

A,为其设置两个属性:x-message-ttl: 消息在该队列中的存活时间(即延迟时间,如 60000ms)。x-dead-letter-exchange: 指定一个死信交换机DLX。(可选)

x-dead-letter-routing-key: 指定消息变成死信后的路由键。

创建一个消费者来监听死信队列

B(绑定在死信交换机DLX上),这里的消息就是延迟处理的消息。生产者将消息发送到队列

A。消息在队列

A中等待,直到超过设置的 TTL 时间也未消费,从而变成“死信”。死信会被 RabbitMQ 自动路由到配置的死信交换机

DLX,并最终被投递到死信队列B。消费者从队列

B中消费消息,从而实现延迟效果。

优点:

利用现有功能实现,无需插件。

可靠性高,消息会持久化。

缺点:

灵活性极差:延迟时间在队列级别定义。如果一个队列设置了 10s TTL,所有发送到这个队列的消息都延迟 10s。要实现不同延迟时间,需要为每个延迟时间创建单独的队列,非常繁琐和浪费资源。

精度不高:RabbitMQ 通过轮询检查过期消息,默认间隔是 5000ms,这意味着延迟误差可能在 5s 以内。

资源占用:在消息延迟期间,它仍然占用原队列的资源。

适用场景:

延迟时间固定的简单场景,且延迟类型不多(例如:只有 10分钟超时 和 30分钟超时 两种)。

系统已经在使用 RabbitMQ,并且不希望引入新的消息中间件。

2. RocketMQ

RocketMQ 原生支持延迟消息,是其核心功能之一,设计得非常优雅和强大。

实现原理:

RocketMQ 内部预设了 18 个固定的延迟级别(

1s, 5s, 10s, 30s, 1m, 2m, ... 2h)。生产者发送消息时,通过设置

message.setDelayTimeLevel(3)属性来指定消息的延迟级别(例如 3 对应 10s)。Broker 接收到延迟消息后,会将其转换并存储到特定的内部主题

SCHEDULE_TOPIC_XXXX中。RocketMQ 有专门的定时任务,每个延迟级别对应一个定时队列,时间到了之后才会将消息投递到真实的目标 Topic,从而被消费者消费。

从 4.x/5.x 版本开始,支持任意时间的延迟(基于定时消息):

使用

message.setDelayTimeMs(45000)即可设置任意的延迟毫秒数(如 45秒),突破了固定级别的限制,灵活性大大增强。

优点:

原生支持,API 简单易用。

可靠性极高,与普通消息一样持久化、高可用。

性能卓越,专为海量延迟消息设计,内部机制高效。

新版本灵活性高,支持任意延迟时间。

缺点:

旧版本只能使用固定的延迟级别(但通常也够用)。

适用场景:

几乎所有需要高可靠、高性能延迟队列的场景,尤其是电商、金融等核心业务。

典型例子:订单系统(30分钟未支付自动关闭)、定时推送通知、任务调度等。

3. ActiveMQ

ActiveMQ 通过其 AMQ Message Scheduler 功能原生支持延迟消息(以及周期性消息)。

实现原理:

需要在 ActiveMQ 的配置文件中启用调度支持(通常默认已启用)。

生产者在发送消息时,通过设置消息属性来指定延迟参数:

AMQ_SCHEDULED_DELAY: 延迟投递的时间(毫秒)。AMQ_SCHEDULED_PERIOD: 重复投递的间隔时间。AMQ_SCHEDULED_REPEAT: 重复投递的次数。

Broker 接收到消息后,会将其持久化到内部的

scheduler store中。内部的调度器会按计划时间将消息投递到目标队列,然后被消费者消费。

优点:

原生支持,API 简单灵活,可以精确到毫秒。

功能强大,不仅支持延迟,还支持定时和循环投递(Cron-like)。

消息可靠持久化。

缺点:

大量使用延迟/定时消息时,会对 Broker 性能产生一定压力,因为需要单独维护和调度。

在社区和生态方面,相比 RocketMQ 和 RabbitMQ,ActiveMQ 的活跃度稍低。

适用场景:

需要复杂调度策略的场景(如每隔 5分钟执行一次)。

已经在使用 ActiveMQ 作为主要消息中间件的系统。

对延迟精度要求高,且消息量不是极端巨大的场景。

总结与建议

首选推荐(尤其新项目):RocketMQ。

理由:它是为这类场景而生的。延迟消息是其一等公民,无论在可靠性、性能、易用性还是灵活性(新版本)上都表现得最为出色,是处理核心业务延迟任务的首选。

如果技术栈绑定或场景简单:RabbitMQ。

理由:如果你的团队对 RabbitMQ 非常熟悉,且延迟需求非常固定和简单(只有一两种延迟时间),可以用 DLX+TTL 的方案。但一旦需求变得复杂,它会成为维护的噩梦。

如果需要高级调度功能:ActiveMQ。

理由:如果你需要不仅仅是“一次性延迟”,而是复杂的、周期性的定时任务(比如“每天上午10点执行”),ActiveMQ 的 Scheduler 功能会非常合适。

简单来说,延迟队列是 RocketMQ 的“王牌功能”之一,而对于 RabbitMQ 来说则是“曲线救国”的实现方式。在选择时,应优先考虑 RocketMQ。