affordance数据集列表

-

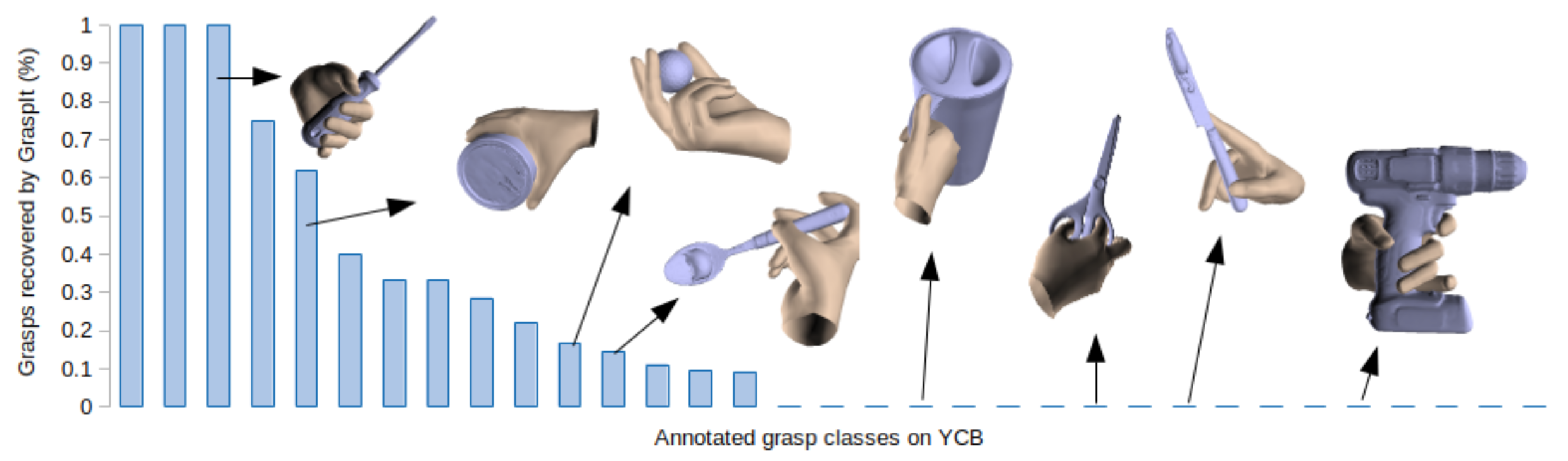

YCB-Affordance Dataset

我们发布了一个大规模数据集,其中包含针对 YCB 基准集 58 个物体的手动注释抓握动作。其中包含如下图所示的抓握动作,这些动作无法被 Graspit Simulator 或任何其他自动化流程识别。对于每个抓握动作,我们根据 Feix 等人的抓握分类法注释其手部位置、手势和抓握类型。我们将这些抓握动作迁移到 YCB 视频数据集中的 92 个视频序列中,并移除了由于与其他物体或桌子相互穿插而无法执行的抓握动作。该数据集包含 133.936 帧,其中真实抓握动作超过 2800 万。 -

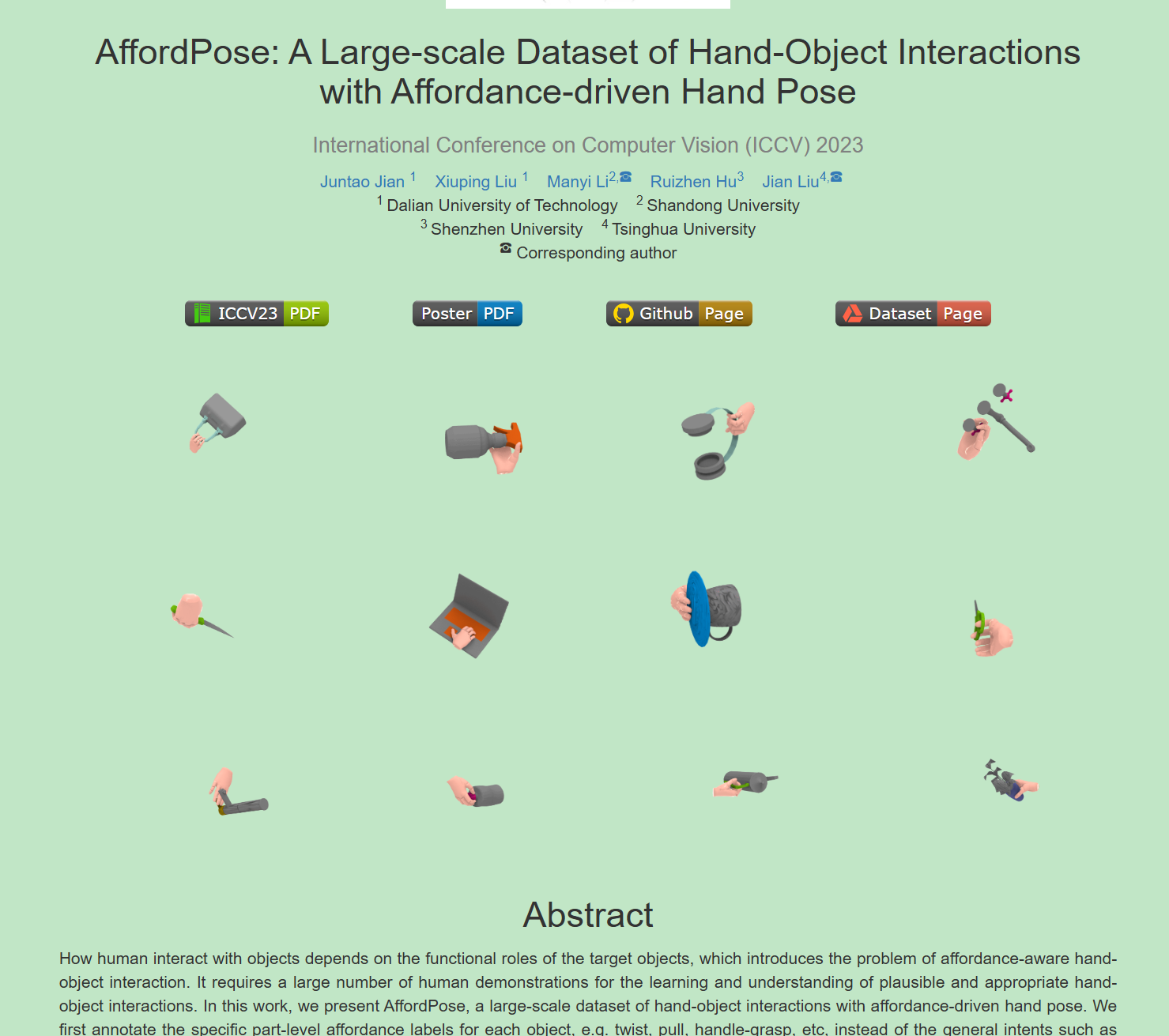

AffordPose: A Large-scale Dataset of Hand-Object Interactions with Affordance-driven Hand Pose

AffordPose 数据集共收集了约 26.7K 个可供性驱动的手部与物体交互数据,涉及 13 个不同类别的 641 个 3D 物体和 8 种可供性类型。

此外,我们还为每个交互数据渲染了 36 张 224*224 像素的图像。

- DexGraspNet: A Large-Scale Robotic Dexterous Grasp Dataset for General Objects Based on Simulation

人类与物体的交互方式取决于目标物体的功能角色,这引出了可供性感知的手物交互问题。这需要大量的人类演示才能学习和理解合理且恰当的手物交互。在本研究中,我们提出了AffordPose,一个包含可供性驱动手势的大规模手物交互数据集。我们首先为每个物体标注具体的部件级可供性标签,例如扭转、拉动、握持等,而不是使用或移交等通用意图,以指示手物交互的目的并指导其定位。细粒度的手物交互揭示了以手为中心的可供性对手势细节排列的影响,同时也展现出一定的多样性。我们收集了总共26.7K个手物交互数据,每个数据都包含物体的3D形状、部件级可供性标签以及手动调整的手势。全面的数据分析通过参数统计和接触计算揭示了不同可供性下手物交互的共性及多样性。我们还在手物可供性理解和面向可供性的手物交互生成任务上进行了实验,以验证数据集在学习细粒度手物交互方面的有效性。