CVPR 2025最佳论文解读|VGGT:Visual Geometry Grounded Transformer

本文介绍了CVPR 2025最佳论文《VGGT: Visual Geometry Grounded Transformer》。该论文提出了一种前馈神经网络,能够从一个、几个、甚至数百个图像场景中直接推断出场景所有的3D属性。VGGT是首个能在单次前馈中端到端预测完整3D场景信息的大型Transformer,其性能超越多项现有几何或深度学习方法,具有广泛的应用潜力。实验表明,该网络在多3D任务中均取得了最先进的结果,包括相机参数估计、多视图深度估计、密集点云重建和3D点跟踪。此外,将预训练的VGGT作为特征骨干网络,可显著提升下游任务的性能。

本文作者邓镝,审校韩煦。

论文链接:https://arxiv.org/abs/2503.11651

项目链接:https://github.com/facebookresearch/vggt

一、研究背景

传统3D重建方法主要采用视觉几何方法实现,例如光束平差法(Bundle Adjustment, BA)和运动恢复结构(Structure-from-Motion, SfM)。这些方法普遍存在两大缺点:

(1)复杂性和计算成本高

(2)一些结合了机器学习的方法仍然依赖视觉几何方法作为后处理步骤,限制了整体计算效率

研究者提出一个根本的问题:能否由神经网络直接解决3D任务,而不依赖后处理步骤。此前的一些模型例如DUSt3R、MASt3R等表现出良好的前景,但这些网络一次仅能处理两张图像,且仍需要通过后处理优化融合重建结果。针对以上问题,该论文提出端到端重建的神经网络VGGT,其主要创新点如下:

1.VGGT作为前馈式神经网络,仅需一次前向传播即可在数秒内直接从输入的少量或者数百张图像中,预测场景的全套3D属性,包括相机参数、点云图、深度图和3D点轨迹。

2.VGGT具有简洁的网络架构,其基于一个标准的Transformer模型,未引入特定的3D或其他归纳偏置。其性能提升主要来源于在大量公开的3D标注数据集上的训练。

3.VGGT使用一个骨干网络来预测所有相关的3D属性。这些3D属性相互关联,存在潜在冗余,但可以增强模型对几何的整体理解,从而提高预测准确性。

4.实验表明,VGGT的实验结果可以直接使用,且性能通常优于那些需要通过后处理的最先进方法。即使与后处理结合,VGGT仍然能获得最先进的结果。

二、研究方法

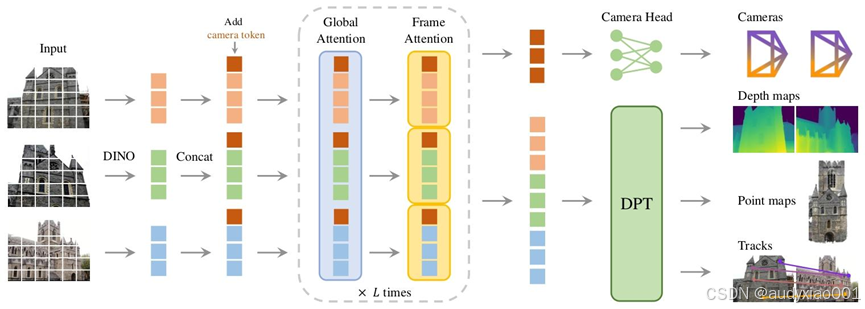

图1 架构总览。模型首先将输入图像分割为token。随后,模型在帧内自注意力层与全局自注意力层之间交替切换。其中,相机头、DPT(用于密集预测的视觉Transformer)头则负责预测所有输出。

如图1所示,VGGT是一种大型的Transformer模型,输入为观测同一3D场景的多张RGB图像序列。VGGT的Transformer可将该图像序列映射为对应的3D标注集(每帧对应一组标注),标注包含:相机参数、深度图、点图、用于点跟踪任务的特征网络。输入图像的序列顺序可任意指定,但需要将第一张图像作为参考帧。

具体而言,模型首先通过DINO(自监督视觉Transformer模型)将输入图像分割为token,并附加用于相机预测的相机token(可学习参数),相机token的作用是在模型处理过程中不断地汇总和学习与该图像对应的相机位姿信息。模型中对第一帧使用的可学习token与其他帧的可学习token不同,这使得模型可区分出第一帧,从而在第一帧相机的坐标系中表示3D预测结果。

随后,模型在帧内自注意力层与全局自注意力层之间交替切换。研究者对标准Transformer进行微调,引入交替注意力机制,使Transformer在“聚焦单帧内部”和“聚焦全局所有帧”之间交替切换。帧内自注意力指仅关注单帧内的token,全局自注意力指联合关注所有帧的token。从全局注意力到帧内注意力的过程会被交替重复L次,使得模型既能进行宏观的、跨视角的场景理解,又能进行微观的、单一视角的细节分析,从而有效地整合多视图信息。

最后,相机头以之前添加的相机token作为输入,通过四层额外的自注意力层和线性层,负责最终预测相机的外参和内参。而DPT(用于密集预测的视觉Transformer)头以图像token作为输入,负责预测所有密集输出(如深度图、点图等)。此外DPT头还输出密集特征,作为跟踪头的输入。而跟踪头作为一个独立的模块,基于CoTracker2架构实现,对于给定的查询点,可以预测所有图像中与查询点对应的同一3D点的2D点集。

三、实验

3.1 相机姿态估计

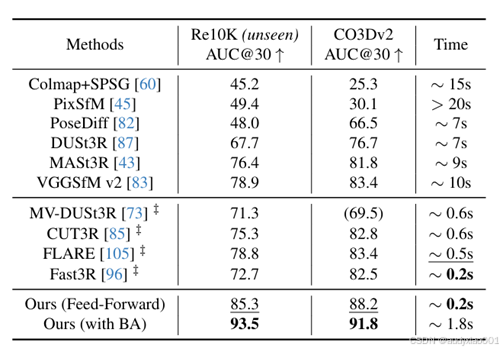

首先在CO3Dv2和RealEstate10K数据集上评估相机姿态估计性能,结果如表1所示。

表1 在RealEstate10K和CO3Dv2数据集上的相机姿态估计结果(随机选取10帧)。所有指标均越高越好;运行时间基于单张H100 GPU测量;所有方法均未在RealEstate10K数据集上训练;括号内数值表示未在CO3D数据集上训练的结果;标有‡的方法为同期研究。

实验结果表明,论文提出的模型在两个数据集的所有指标上均持续优于对比方法,包括采用计算成本高昂的后处理优化步骤的方法。相比之下,VGGT仅通过前馈方式即可实现更优性能,在相同硬件上仅需0.2秒。与同期研究(标有‡)相比,该方法的性能优势显著,且速度与最快的变体Fast3R相当。此外,在所有方法均未训练过的RealEstate10K数据集上,模型的性能优势更为明显,这验证了VGGT出色的泛化能力。

实验结果还表明,将VGGT与光束平差法等视觉几何优化方法结合,可进一步提升性能。需注意的是,论文方法可直接预测精度接近真值的点图/深度图,这些结果可作为光束平差法的良好初始值,从而省去了光束平差法所需的三角化和迭代优化步骤,使方法速度显著提升(即便结合光束平差法,总耗时也仅约2秒)。因此,尽管VGGT的前馈模式已优于所有现有方法,但后处理优化仍能带来性能提升,证明模型仍有改进空间。

3.2 多视图深度估计

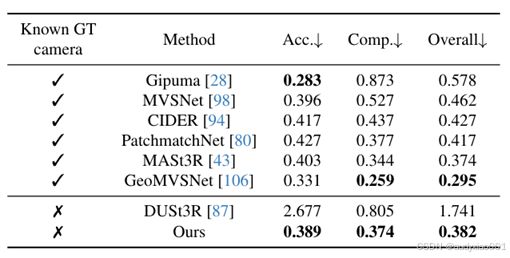

文中参考MASt3R的实验设置,在DTU数据集上进一步评估多视图深度估计性能。采用的指标包含:精度(Accuracy)、完整性(Completeness)、总体误差(Overall)。实验结果如表2所示。

实验结果表明,仅有DUSt3R和VGGT无需已知真值相机参数即可运行;MASt3R需利用真值相机参数对匹配结果进行三角化,以推导深度图;而GeoMVSNet等深度多视图立体匹配方法则需利用真值相机参数构建代价体(cost volume)。

论文方法的性能大幅超越DUSt3R,将总体误差从1.741降至0.382。其性能也已接近测试时已知真值相机参数的方法。性能的显著提升可能源于多图像训练方案,该方案使模型能够原生学习多视图三角化推理,而非依赖DUSt3R中“对多个成对相机三角化结果取平均”这类临时对齐流程。

表2 在DTU数据集上的密集多视图立体匹配估计结果(表上半部分为已知真值相机参数的方法,下半部分为未知真值相机参数的方法)

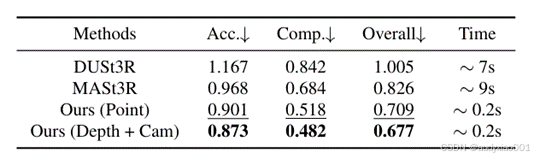

3.3 点图估计

在ETH3D数据集上,将预测的点云精度与DUSt3R、MASt3R进行对比。每个场景随机选取10帧,采用Umeyama算法将预测点云与真值对齐,并使用官方掩码过滤无效点后报告结果。点图估计的评估指标包括精度(Accuracy)、完整性(Completeness)、总体误差(Overall)。实验结果如表3所示。

表3 在ETH3D数据集上的点图估计结果(“(Point)”表示直接使用点图头的结果,“(Depth+Cam)”表示结合深度图头和相机头的结果(即利用预测的相机参数将预测的深度图投影为3D点云))

实验结果表明,尽管DUSt3R和MASt3R需进行复杂的优化(全局对齐,每个场景约需10秒),但论文的方法仅通过简单的前馈模式(每次重建仅需0.2秒),仍能显著超越它们的性能。同时发现,与直接使用估计的点图相比,结合深度头和相机头的预测结果精度更高。这一现象可归因于“将复杂任务(点图估计)分解为更简单的子任务(深度图预测和相机预测)”的优势,即使相机参数、深度图和点图在训练阶段是联合监督的。

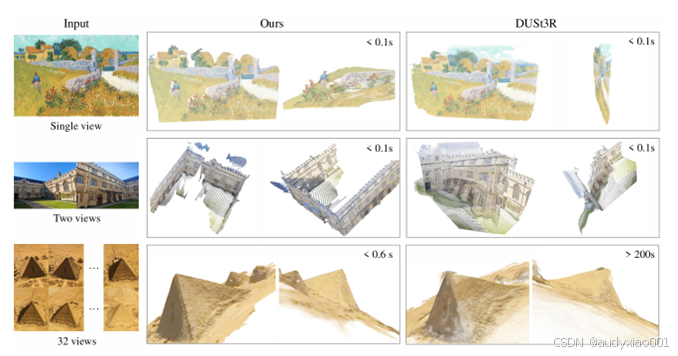

如图2展示了论文的方法与DUSt3R在真实场景中的定性对比。VGGT的预测结果质量高、泛化能力强,在油画、非重叠帧、沙漠等具有重复或均匀纹理的挑战性域外场景中均表现出色。

图2 论文方法与DUSt3R在真实场景中的预测3D点对比

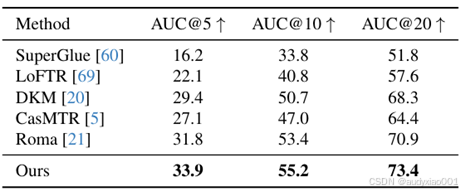

3.4 图像匹配

参考ScanNet数据集上的标准实验流程,结果如表4所示。尽管未针对双视图匹配进行显式训练,VGGT 的精度仍在所有基线方法中排名第一。

表4 在ScanNet-1500数据集上的双视图匹配对比

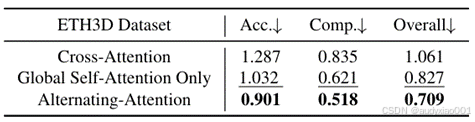

3.5 消融实验

为验证所提交替注意力设计的有效性,将其与两种替代注意力架构进行对比:仅全局自注意力、交叉注意力。所有模型变体的参数数量保持一致,均使用2L层注意力层。隐藏维度、注意力头数量等超参数均保持一致。消融实验选择点图估计精度作为评估指标,因其能反映模型对场景几何和相机参数的联合理解能力。

实验结果如表5所示,论文的交替注意力架构在精度上显著优于两种基线变体。

表5 在ETH3D数据集上的Transformer骨干网络消融实验

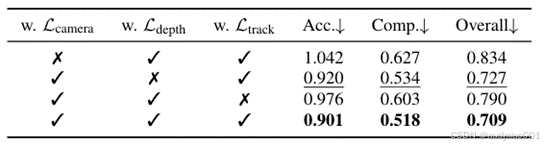

表6验证了“训练单一网络同时学习多个3D量”的优势,即使输出可能存在重叠。结果表明,在ETH3D数据集上,同时训练相机、深度和跟踪估计任务,可使点图估计精度达到最高。当训练中移除相机、深度或跟踪估计任务时,点图估计精度会明显下降。值得注意的是,加入相机参数估计对提升点图精度的效果显著,而深度估计的贡献则相对较小。

表6 多任务学习消融实验

3.6 下游任务微调

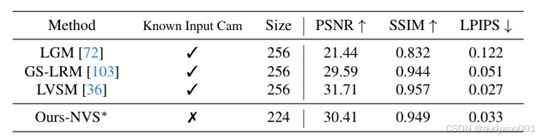

文中验证了预训练的VGGT在下游任务中的复用价值。前馈新视图合成实验严格遵循LVSM的训练和评估流程,并对VGGT进行修改,使其无需已知输入帧的相机参数即可直接输出目标图像。文中使用一个规模约为Objaverse数据集的20%的内部数据集。实验结果如表7所示,尽管无需输入相机参数且训练数据量少于LVSM,但文中的模型在GSO数据集上仍取得了具有竞争力的结果。

表7 在GSO数据集上的新视图合成定量对比

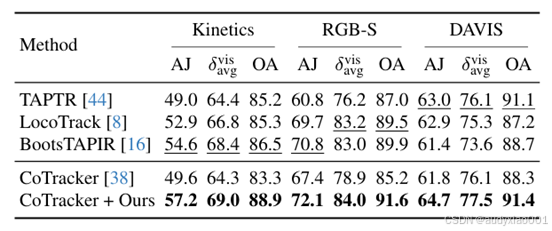

动态点跟踪实验采用标准指标评估:遮挡精度、(在特定像素阈值内准确跟踪的可见点平均比例)、平均交并比。对CoTracker2模型进行适配,将其骨干网络替换为预训练的VGGT网络。骨干网络预测的跟踪特征替代原特征提取器的输出,输入CoTracker2架构的后续模块,最终预测轨迹。在Kubric数据集上对修改后的跟踪器进行全微调。实验结果如表8所示,融入预训练VGGT显著提升了CoTracker在TAP-Vid基准上的性能。

表8 在TAP-Vid基准上的动态点跟踪结果

四、结果

该论文提出视觉几何基础Transformer(VGGT)。作为一种前馈神经网络,可直接从数百个输入视图中估计场景的所有关键3D属性。该模型在多项3D任务中均取得最先进结果,包括相机参数估计、多视图深度估计、密集点云重建和3D点跟踪。其简洁性和高效性使其非常适合实时应用。