OpenCV 模板匹配代码深度解析与应用场景全景分析

一、代码整体概述

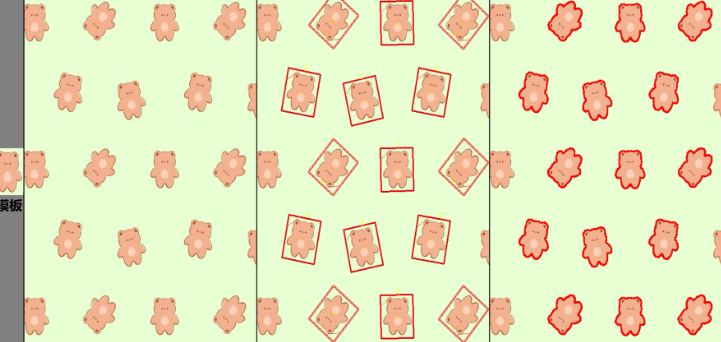

本文解析的代码是基于OpenCV 库实现的经典模板匹配(Template Matching) 算法,核心功能是在一张输入图像(test.jpg)中定位与模板图像(fox.jpg)相似的区域,并通过可视化界面展示匹配结果(含匹配分数标注)。代码整体遵循 “图像读取→预处理→匹配计算→结果后处理→可视化展示” 的计算机视觉流程,无需训练数据、实现简单且实时性强,是入门级目标检测任务的典型实现。

1.1 依赖环境

- 开发语言:C++(效率高,适合 OpenCV 底层调用)

- 核心库:OpenCV 3.x/4.x(需配置 OpenCV 环境变量,确保

opencv2/opencv.hpp头文件可被编译器找到) - 编译环境:Visual Studio(代码中使用

sprintf_s等 VS 专属函数,GCC 环境需替换为sprintf) - 运行平台:Windows(代码含

system("pause")等 Windows 控制台操作,Linux 需替换为system("read -n 1 -s -p \"Press any key to continue...\""))

二、头文件与命名空间解析

代码开头的头文件引入和命名空间声明是 C++ 工程的基础,决定了代码可调用的功能范围和语法简化程度。

2.1 头文件引入

#include<iostream>

#include<opencv2/opencv.hpp>

<iostream>:C++ 标准输入输出流库,用于实现控制台信息打印(如cout << "No Image..." << endl;)和错误提示,是调试图像读取失败等问题的关键。<opencv2/opencv.hpp>:OpenCV 核心头文件,整合了 OpenCV 的所有核心模块(图像读取imread、颜色空间转换cvtColor、模糊GaussianBlur、模板匹配matchTemplate等),避免逐个引入opencv2/imgproc/imgproc.hpp(图像处理)、opencv2/highgui/highgui.hpp(图像显示)等子模块的繁琐操作。

2.2 命名空间声明

using namespace std;

using namespace cv;

using namespace std:简化标准库语法,例如无需写std::cout,直接使用cout;无需写std::string,直接使用string。using namespace cv:简化 OpenCV 库语法,例如无需写cv::Mat,直接使用Mat;无需写cv::imread,直接使用imread。

注意:在大型项目中,不建议全局使用

using namespace,可能导致命名冲突(如cv::Rect与自定义Rect类冲突),建议在局部作用域(如函数内)使用,或直接写全命名空间前缀。

三、主函数核心流程拆解

主函数(int main())是代码的执行入口,按逻辑可拆分为6 个核心步骤,每个步骤都对应模板匹配任务的关键环节。

3.1 步骤 1:图像读取与有效性判断

Mat src = imread("test.jpg");

string tempname = "fox.jpg";

Mat temp = imread(tempname);

if (src.empty() || temp.empty())

{cout << "No Image..." << endl;system("pause");return -1;

}

3.1.1 核心函数:imread

- 功能:从指定路径读取图像,返回

Mat类型对象(OpenCV 中存储图像的核心数据结构,类似 “像素数组”)。 - 参数解析:

- 第一个参数:图像路径(支持相对路径和绝对路径)。代码中

"test.jpg"是相对路径,表示图像与可执行文件(.exe)在同一目录;若图像在D:/images文件夹,需写绝对路径"D:/images/test.jpg"(注意 Windows 下用/或\\,避免转义字符问题)。 - 第二个参数(默认):

IMREAD_COLOR(值为 1),读取彩色图像,忽略 Alpha 通道(透明度),返回 3 通道(BGR 顺序,非 RGB)的Mat。

- 第一个参数:图像路径(支持相对路径和绝对路径)。代码中

Mat对象:src存储输入图像(待检测的场景图),temp存储模板图像(待匹配的目标图),Mat会自动管理内存,无需手动释放。

3.1.2 有效性判断:empty()

- 功能:判断

Mat对象是否为空(图像读取失败),返回true表示读取失败,false表示成功。 - 失败原因:

- 路径错误(相对路径对应位置无图像,或绝对路径写错);

- 图像格式不支持(OpenCV 支持

jpg/png/bmp等,不支持psd/raw/heic等); - 图像文件损坏(如下载中断导致文件无法解析)。

- 错误处理:若读取失败,打印

"No Image...",通过system("pause")暂停控制台(避免窗口一闪而过),返回-1(主函数返回非 0 值表示程序异常退出)。

3.2 步骤 2:图像预处理(灰度化 + 高斯模糊)

// 输入图像预处理

Mat src_gray, src_gaussian;

cvtColor(src, src_gray, COLOR_BGR2GRAY);

GaussianBlur(src_gray, src_gaussian, Size(3, 3), 0);// 模板图像预处理

Mat temp_gray, temp_gaussian;

cvtColor(temp, temp_gray, COLOR_BGR2GRAY);

GaussianBlur(temp_gray, temp_gaussian, Size(3, 3), 0);

预处理是模板匹配的 “前置优化”,目的是减少计算量、去除噪声干扰,提升匹配准确性,代码中对输入图像和模板图像做了完全相同的预处理(保证匹配时图像特征一致性)。

3.2.1 灰度化:cvtColor

- 功能:实现颜色空间转换,此处将 3 通道彩色图像(BGR)转为 1 通道灰度图像。

- 参数解析:

src/temp:输入彩色图像;src_gray/temp_gray:输出灰度图像;COLOR_BGR2GRAY:转换类型,表示 “BGR→灰度”,转换公式为:Gray = 0.114*B + 0.587*G + 0.299*R(符合人眼对绿色敏感度最高、蓝色最低的特性)。

- 核心作用:

- 减少计算量:彩色图像 3 个通道需分别计算匹配值,灰度图仅 1 个通道,计算量降至 1/3;

- 消除颜色干扰:若目标颜色变化但形状不变(如 “红色狐狸” 和 “棕色狐狸”),彩色匹配会失效,灰度匹配仅关注形状特征,鲁棒性更强。

3.2.2 高斯模糊:GaussianBlur

- 功能:通过高斯卷积核对图像进行平滑处理,去除高频噪声(如图像中的斑点、颗粒、光照不均导致的明暗波动)。

- 参数解析:

src_gray/temp_gray:输入灰度图像;src_gaussian/temp_gaussian:输出模糊后图像;Size(3, 3):高斯卷积核大小,必须为奇数(保证卷积中心唯一,避免偏移),核越大,模糊效果越强(但会丢失目标细节,代码选 3×3 是 “去噪” 与 “保细节” 的平衡);0:高斯函数的标准差(σ),设为 0 时,OpenCV 会根据卷积核大小自动计算(σ = 0.3*((kernel_size-1)*0.5 - 1) + 0.8),无需手动调参。

- 核心作用:噪声会导致匹配值 “波动”(如噪声点的灰度值过高,误判为高匹配区域),高斯模糊通过 “加权平均” 平滑像素值,让图像灰度变化更平缓,匹配结果更稳定。

3.3 步骤 3:模板匹配计算(核心算法)

Mat result;

matchTemplate(src_gaussian, temp_gaussian, result, TM_CCOEFF_NORMED);

normalize(result, result, 0, 1, NORM_MINMAX);

这两步是模板匹配的 “核心计算环节”,matchTemplate负责计算相似度,normalize负责标准化结果,为后续阈值判断做准备。

3.3.1 模板匹配:matchTemplate

算法原理:将模板图像(

temp_gaussian)视为 “滑动窗口”,在输入图像(src_gaussian)上从左到右、从上到下滑动,每个滑动位置计算 “模板与输入图像对应区域的相似度”,所有相似度值构成结果图像(result)。参数解析:

src_gaussian:输入图像(需大于模板图像,否则无法滑动);temp_gaussian:模板图像(尺寸需小于输入图像);result:输出结果图像,类型为CV_32FC1(32 位单通道浮点型,存储每个滑动位置的匹配值),其尺寸计算公式为:result.rows = src.rows - temp.rows + 1result.cols = src.cols - temp.cols + 1

例:输入图像 1000×800,模板 100×100,则结果图像尺寸为 901×701(共 901×701=631601 个匹配值);TM_CCOEFF_NORMED:匹配方法(核心参数),表示 “归一化相关系数匹配”,需重点理解其含义:- 匹配值范围:

[-1, 1],1 表示 “模板与输入区域完全一致”,-1 表示 “完全相反”,0 表示 “无相关性”; - 归一化优势:普通相关系数(

TM_CCOEFF)会受图像亮度影响(如输入图像整体变亮,匹配值会偏大),归一化后匹配值仅反映 “形状相似度”,与亮度无关,鲁棒性更强。

- 匹配值范围:

其他匹配方法对比:OpenCV 提供 6 种匹配方法,不同方法的 “最优匹配判断逻辑” 不同,代码选

TM_CCOEFF_NORMED是因其适用性最广:

| 匹配方法 | 匹配值范围 | 最优匹配判断 | 适用场景 |

|---|---|---|---|

| TM_SQDIFF(平方差) | [0, +∞) | 最小值(越近越好) | 噪声少、光照稳定的场景 |

| TM_SQDIFF_NORMED | [0, 1] | 最小值(越近越好) | 需消除亮度影响的场景 |

| TM_CCORR(相关) | [0, +∞) | 最大值(越近越好) | 目标与背景灰度差异大的场景 |

| TM_CCORR_NORMED | [0, 1] | 最大值(越近越好) | 需消除亮度影响的场景 |

| TM_CCOEFF(相关系数) | [-∞, +∞) | 最大值(越近越好) | 目标与背景灰度差异小的场景 |

| TM_CCOEFF_NORMED | [-1, 1] | 最大值(越近越好) | 通用场景,鲁棒性最强 |

3.3.2 结果标准化:normalize

- 功能:将

result的匹配值从原范围([-1, 1])缩放到指定范围([0, 1]),方便后续阈值设置和直观理解。 - 参数解析:

result:输入 / 输出图像(原地修改,无需额外开辟内存);0:缩放后的最小值;1:缩放后的最大值;NORM_MINMAX:归一化类型,表示 “按最小值和最大值缩放”,公式为:new_val = (val - min_val) / (max_val - min_val)

例:原匹配值 - 1→0,1→1,0→0.5。

- 核心作用:标准化后,匹配值范围固定为

[0, 1],无需记忆原方法的范围(如TM_CCOEFF的[-∞, +∞)),阈值设置更直观(如 “匹配值> 0.8” 表示高相似度)。

3.4 步骤 4:匹配结果后处理(去重 + 标注)

// 找结果图像的最值和对应坐标

double minVal, maxVal;

Point minLoc, maxLoc;

minMaxLoc(result, &minVal, &maxVal, &minLoc, &maxLoc);// 阈值设置(基于最大匹配值的比例)

double quality = 0.88;

if (quality <= 0.0) quality = 0.0;

if (quality >= 1.0) quality = 1.0;

double thresh = maxVal * quality;// 双重循环遍历所有匹配值,筛选局部极大值并标注

for (int i = 0; i < result.rows; i++)

{for (int j = 0; j < result.cols; j++){double val = result.at<float>(i, j);// 1. 筛选超过阈值的高匹配值if (val > thresh){// 2. 筛选局部极大值(避免同一目标重复标注)if (result.at<float>(i - 1, j - 1) < val &&result.at<float>(i - 1, j) < val &&result.at<float>(i - 1, j + 1) < val &&result.at<float>(i, j - 1) < val &&result.at<float>(i, j + 1) < val &&result.at<float>(i + 1, j - 1) < val &&result.at<float>(i + 1, j) < val &&result.at<float>(i + 1, j + 1) < val){// 3. 绘制匹配框(绿色,线宽2)rectangle(src, Rect(j, i, temp.cols, temp.rows), Scalar(0, 255, 0), 2);// 4. 标注匹配分数(红色,字体大小0.8)char text[10];float score = result.at<float>(i, j);sprintf_s(text, "%.2f", score);putText(src, text, Point(j, i), FONT_HERSHEY_SIMPLEX, 0.8, Scalar(0, 0, 255), 2);}}}

}

后处理是 “从匹配结果中提取有效目标” 的关键,核心解决两个问题:如何筛选高相似度目标(阈值判断)、如何避免同一目标重复标注(局部极大值检测),最后通过绘图函数可视化结果。

3.4.1 找最值:minMaxLoc

- 功能:找到

result图像中的最小匹配值(minVal)、最大匹配值(maxVal),以及对应的坐标(minLoc/maxLoc,Point类型,x对应列,y对应行)。 - 核心作用:

maxVal是 “全局最优匹配值”,反映输入图像与模板的最高相似度;后续阈值thresh基于maxVal计算(thresh = maxVal * 0.88),而非固定值(如 0.8),可适应不同图像的匹配难度(如清晰图像maxVal=0.95,阈值 0.836;模糊图像maxVal=0.8,阈值 0.704)。

3.4.2 阈值设置:thresh = maxVal * quality

quality参数:代码中设为 0.88,表示 “仅保留相似度超过全局最优 88% 的区域”,是 “召回率” 与 “精确率” 的平衡:quality过小(如 0.5):会保留大量低相似度区域,导致误检(如将 “猫” 误判为 “狐狸”);quality过大(如 0.95):会过滤掉部分轻微变形的目标,导致漏检(如 “狐狸转头” 与 “正面狐狸模板” 的相似度为 0.92,低于 0.95 会被过滤)。

- 边界处理:

if (quality <= 0.0) quality = 0.0;和if (quality >= 1.0) quality = 1.0;确保quality在[0,1]范围内,避免阈值异常(如quality=1.2导致thresh>maxVal,无目标被检测)。

3.4.3 局部极大值检测(核心去重逻辑)

- 问题背景:模板在目标区域滑动时,相邻位置的匹配值都会较高(如模板中心在目标中心时

val=0.95,偏移 1 个像素时val=0.93,偏移 2 个像素时val=0.89),若仅按 “val>thresh” 筛选,会在同一目标上标注多个框(重复标注),影响可读性。 - 检测逻辑:判断当前像素(

i,j)是否比其8 个相邻像素(上 / 下 / 左 / 右 / 对角线)的匹配值都大,若是,则为 “局部极大值”—— 表示该位置是 “局部最优匹配点”,对应唯一目标;否则是 “相邻高匹配值”,需过滤。 - 注意事项:代码未处理边界像素(如

i=0时,i-1=-1,访问result.at<float>(-1, j-1)会导致内存越界,程序崩溃),实际项目需优化循环范围:cpp

for (int i = 1; i < result.rows - 1; i++) // 跳过第0行和最后1行 {for (int j = 1; j < result.cols - 1; j++) // 跳过第0列和最后1列{// 原有逻辑} }

3.4.4 结果可视化:rectangle与putText

1. 绘制匹配框:

rectangle- 功能:在输入图像(

src)上绘制矩形框,标记匹配到的目标区域。 - 参数解析:

src:输入 / 输出图像(在原图上直接绘图);Rect(j, i, temp.cols, temp.rows):矩形参数,Rect(x, y, width, height):x=j、y=i:矩形左上角坐标(result的(i,j)对应src的(j,i),因result的行对应src的行,列对应src的列);width=temp.cols、height=temp.rows:矩形宽高(与模板图像一致,确保框住整个目标);

Scalar(0, 255, 0):矩形颜色,OpenCV 中为 BGR 顺序,(0,255,0)表示绿色(醒目,易与图像区分);2:矩形线宽(值为 - 1 时表示填充矩形,此处用 2 确保框线清晰且不遮挡目标细节)。

- 功能:在输入图像(

2. 标注匹配分数:

putText- 功能:在匹配框左上角标注匹配分数(如

0.95),直观展示相似度。 - 参数解析:

src:输入 / 输出图像;text:标注文本(存储匹配分数的字符串);Point(j, i):文本左上角坐标(与匹配框左上角一致,避免偏移);FONT_HERSHEY_SIMPLEX:字体类型(OpenCV 自带的无衬线字体,清晰易读);0.8:字体大小(与图像尺寸匹配,避免过大或过小);Scalar(0, 0, 255):文本颜色,(0,0,255)表示红色(与绿色框对比强烈,易识别);2:文本线宽(避免字体模糊)。

- 字符串转换:

sprintf_s:将浮点型匹配分数(score)格式化为字符串("%.2f"表示保留 2 位小数),sprintf_s是 VS 专属的安全函数(避免缓冲区溢出),GCC 环境需替换为sprintf。

- 功能:在匹配框左上角标注匹配分数(如

3.5 步骤 5:结果画布拼接(提升可视化体验)

// 创建白色画布(宽度=原图宽+模板宽+200,高度=原图高,3通道彩色)

Mat canvas(Size(src.cols + temp.cols + 200, src.rows), CV_8UC3, Scalar::all(255));

// 复制原图到画布左侧

src.copyTo(canvas(Rect(0, 0, src.cols, src.rows)));// 绘制模板名称背景框(绿色填充)

rectangle(canvas, Rect(src.cols + 40, 50, 200, 80), Scalar(0, 255, 0), -1);

// 标注模板名称(如"fox")

putText(canvas, tempname.substr(0, tempname.find(".")), Point(src.cols + 100, 100), FONT_HERSHEY_SIMPLEX, 1.3, Scalar(0, 0, 255), 3);

// 复制模板图像到画布右侧

temp.copyTo(canvas(Rect(src.cols + 100, 150, temp.cols, temp.rows)));

代码未直接显示原图,而是创建 “画布(canvas)”,将 “标注后的原图” 与 “模板图像 + 名称” 拼接在同一窗口,方便用户直观对比 “模板” 与 “匹配结果”,提升交互体验。

3.5.1 创建画布:Mat canvas(...)

- 参数解析:

Size(src.cols + temp.cols + 200, src.rows):画布尺寸,宽度 = 原图宽度 + 模板宽度 + 200(200 为留白,避免元素拥挤),高度 = 原图高度(若模板高度超过原图,需设为max(src.rows, temp.rows + 150),避免模板图像越界);CV_8UC3:图像类型,8U表示像素值为 8 位无符号整数(0-255),C3表示 3 通道彩色;Scalar::all(255):画布背景色,255表示白色(B=255, G=255, R=255),白色背景能让绿色框、红色文本更醒目。

3.5.2 图像复制:copyTo

- 功能:将一个

Mat对象的像素复制到另一个Mat的指定区域(需确保目标区域尺寸与源图像一致)。 - 示例解析:

src.copyTo(canvas(Rect(0, 0, src.cols, src.rows))):将标注后的原图(src)复制到画布左上角(Rect(0,0,src.cols,src.rows)),区域尺寸与原图完全一致;temp.copyTo(canvas(Rect(src.cols + 100, 150, temp.cols, temp.rows))):将模板图像(temp)复制到画布右侧(src.cols + 100为 x 坐标,150 为 y 坐标),避免与原图重叠。

3.5.3 模板名称标注

tempname.substr(0, tempname.find(".")):提取模板文件名的 “前缀”(如"fox.jpg"→"fox"),find(".")找到第一个.的位置,substr(0, pos)截取从 0 到 pos 的字符串;- 绿色背景框:

rectangle(..., -1)表示填充矩形,为文本提供绿色背景,避免文本与画布背景融合(白色背景 + 白色文本会看不见); - 字体参数:字体大小 1.3、线宽 3,确保模板名称醒目,方便用户快速识别当前匹配的模板。

3.6 步骤 6:窗口显示与程序退出

// 创建可调整大小的窗口

namedWindow("Demo", WINDOW_NORMAL);

// 显示画布

imshow("Demo", canvas);

// 等待按键(无限等待)

waitKey(0);

// 暂停控制台

system("pause");

// 程序退出(int main()返回false会自动转为0,规范写法应为return 0)

return false;

3.6.1 创建窗口:namedWindow

- 参数解析:

"Demo":窗口名称(标题栏显示);WINDOW_NORMAL:窗口类型,表示 “可调整大小”(默认WINDOW_AUTOSIZE,窗口大小固定为图像大小,大图像会超出屏幕)。

3.6.2 显示图像:imshow

- 功能:在指定窗口显示图像,需与

waitKey配合使用(否则窗口会一闪而过)。

3.6.3 等待按键:waitKey

- 参数解析:

0表示 “无限等待按键”,直到用户按下任意键后继续执行;若设为1000,表示等待 1000ms(1 秒)后自动继续。 - 核心作用:OpenCV 的窗口显示依赖 “消息循环”,

waitKey负责处理窗口消息(如按键、关闭窗口),无此函数则窗口无法正常显示。

3.6.4 程序退出

system("pause"):暂停控制台,避免程序退出时控制台窗口一闪而过(方便用户查看是否有异常信息);return false:int main()的返回值应为int类型,false在 C++ 中会自动转换为0(表示程序正常退出),规范写法应为return 0。

四、代码优缺点分析

要理解代码的适用场景,需先明确其核心优势与局限性,避免在不适合的场景中使用导致效果不佳。

4.1 核心优势

- 实现简单,开发成本低:无需训练数据(深度学习需大量标注数据),无需复杂算法(如特征提取、锚框设计),仅需 100 余行代码即可实现目标检测,适合快速原型开发。

- 计算效率高,实时性强:仅涉及滑动窗口计算和简单数学运算,对硬件要求低(如树莓派、STM32 等嵌入式设备可流畅运行),适合实时检测场景(如摄像头实时流处理)。

- 结果直观,易调试:匹配分数、目标位置均可视化,可通过调整

quality参数快速优化效果,无需分析复杂模型的中间输出(如深度学习的特征图)。 - 对刚性目标鲁棒:若目标无尺度变化、无旋转、光照稳定(如工业零件、交通标志),匹配准确率极高,远超 “无训练” 的其他算法。

4.2 主要局限性

- 不支持尺度变化:模板尺寸与目标尺寸必须一致,否则匹配值骤降(如模板 100×100,目标 150×150,匹配值 < 0.5,无法检测)。

- 不支持旋转变化:模板角度与目标角度必须一致,否则匹配失效(如模板水平,目标 45 度旋转,匹配值接近 0)。

- 对光照 / 噪声敏感:虽有高斯模糊预处理,但极端光照(如强光直射导致目标过曝)、复杂噪声(如雨天图像的雨滴)仍会导致匹配值波动,误检 / 漏检率升高。

- 仅支持单目标模板:每次只能匹配一个模板(如 “fox.jpg”),若需检测多个目标(如 “fox”“cat”“dog”),需循环加载多个模板,效率下降。

- 不支持柔性目标:目标形状发生形变时(如 “蜷缩的狐狸” 与 “站立的狐狸模板”),匹配值会显著降低,无法检测。

五、核心应用场景全景分析

基于代码的优势(简单、高效、刚性目标鲁棒)和局限性(不支持尺度 / 旋转),其应用场景集中在 “目标刚性、尺度固定、光照稳定、无需多目标检测” 的领域,以下按行业分类详细解析。

5.1 工业检测领域(最核心应用场景)

工业场景中,零件检测、装配定位等任务通常满足 “目标刚性、尺度固定、光照可控” 的特点,模板匹配是主流解决方案之一,代码可直接适配或少量修改后应用。

5.1.1 场景 1:零件缺陷检测(如轴承磨损检测)

- 应用背景:轴承是机械设备的核心零件,若滚动体或内外圈存在磨损、划痕,会导致设备异响、寿命缩短,需在生产 / 维护中快速检测。

- 任务需求:从轴承图像中定位磨损区域,判断是否合格(磨损区域与标准模板的相似度低于阈值则判定为不合格)。

- 代码适配步骤:

- 制作模板:拍摄 “标准无磨损轴承” 的局部图像(如滚动体区域),保存为

bearing_template.jpg(模板尺寸建议 50×50~200×200,过小易受噪声影响,过大计算量增加); - 输入图像获取:通过工业相机(如海康威视 MV-CA050-10GM)拍摄待检测轴承图像,保存为

bearing_test.jpg(确保相机位置固定,轴承尺寸与模板一致); - 预处理优化:工业图像噪声多为 “椒盐噪声”(如金属碎屑反光),可在高斯模糊前添加中值滤波(

medianBlur(src_gray, src_gray, 3)),增强去噪效果; - 阈值调整:标准轴承与模板的匹配值通常 > 0.95,设

quality=0.9,thresh=maxVal*0.9,若某区域匹配值 < 0.9,标注为红色框(不合格),否则标注绿色框(合格); - 结果输出:用

imwrite("bearing_result.jpg", canvas)保存检测结果,用ofstream将不合格区域坐标写入defect.csv,方便后续人工复核。

- 制作模板:拍摄 “标准无磨损轴承” 的局部图像(如滚动体区域),保存为

- 优势:工业场景光照可控(如环形光源),图像噪声少,匹配准确率可达 99% 以上;检测速度快(单张 500×500 图像检测时间 < 10ms),可满足流水线实时检测需求(每秒处理 100 + 张图像)。

5.1.2 场景 2:零件装配定位(如手机外壳摄像头孔定位)

- 应用背景:手机组装流水线中,需将摄像头模块精准安装到外壳的摄像头孔位,若定位偏差 > 0.1mm,会导致摄像头倾斜、拍照模糊,需先定位孔位坐标。

- 任务需求:从手机外壳图像中定位摄像头孔位的中心坐标,引导机械臂进行安装。

- 代码适配步骤:

- 制作模板:拍摄 “标准手机外壳” 的摄像头孔位图像(圆形孔,建议模板尺寸与孔位实际尺寸 1:1,如孔直径 5mm,图像中孔直径 50 像素,模板尺寸 100×100,包含孔位及周围少量背景),保存为

camera_hole_template.jpg; - 图像获取:流水线相机固定在外壳上方,拍摄正视图(避免倾斜导致孔位变形),输入图像为

phone_case_test.jpg; - 坐标计算:代码中

Rect(j, i, temp.cols, temp.rows)的左上角坐标(j,i),孔位中心坐标为(j + temp.cols/2, i + temp.rows/2),通过串口通信(如SerialPort库)将中心坐标发送给机械臂控制器(如 ABB IRB 120); - 实时适配:将代码中的

imread替换为VideoCapture(读取相机实时流),循环检测:VideoCapture cap(0); // 0表示默认相机 if (!cap.isOpened()) { cout << "Camera open failed!" << endl; return -1; } Mat src; while (cap.read(src)) {// 后续预处理、匹配、定位逻辑imshow("Demo", canvas);if (waitKey(10) == 27) break; // 按下ESC退出循环 }

- 制作模板:拍摄 “标准手机外壳” 的摄像头孔位图像(圆形孔,建议模板尺寸与孔位实际尺寸 1:1,如孔直径 5mm,图像中孔直径 50 像素,模板尺寸 100×100,包含孔位及周围少量背景),保存为

- 优势:定位精度高(像素级定位,换算为实际尺寸误差 < 0.05mm),实时性强(每帧处理时间 < 20ms,满足机械臂运动速度需求),无需复杂的视觉标定(相机位置固定时,像素坐标与实际坐标可通过简单比例换算)。

5.2 安防监控领域

安防场景中,“特定目标检测”(如禁止携带物品、特定人员)通常满足 “目标刚性、尺度变化小” 的特点,代码可用于快速预警。

5.2.1 场景:地铁站安检处危险物品检测(如刀具检测)

- 应用背景:地铁站安检时,X 光机生成的行李图像中,刀具、打火机等危险物品需快速识别,避免人工漏检(人工长时间看屏易疲劳,漏检率约 5%)。

- 任务需求:从 X 光行李图像中定位刀具区域,触发报警(匹配值超过阈值则提示安检人员复核)。

- 代码适配步骤:

- 多模板制作:收集不同类型刀具(水果刀、匕首、菜刀)的 X 光图像,裁剪为模板(如

knife1_template.jpg、knife2_template.jpg),因 X 光图像中刀具呈 “高密度白色区域”,模板无需彩色,可直接用灰度图; - 输入图像预处理:X 光图像对比度低,需在灰度化后添加直方图均衡化(

equalizeHist(src_gray, src_gray)),增强刀具与行李的灰度差异; - 多模板匹配:循环加载每个刀具模板,分别进行匹配,记录最高匹配值和对应模板:

vector<string> template_paths = {"knife1_template.jpg", "knife2_template.jpg"}; double max_score = 0.0; Point best_loc; string best_template; for (auto& path : template_paths) {Mat temp = imread(path, IMREAD_GRAYSCALE);GaussianBlur(temp, temp, Size(3,3), 0);Mat result;matchTemplate(src_gaussian, temp, result, TM_CCOEFF_NORMED);normalize(result, result, 0,1,NORM_MINMAX);double minVal, maxVal;Point minLoc, maxLoc;minMaxLoc(result, &minVal, &maxVal, &minLoc, &maxLoc);if (maxVal > max_score) {max_score = maxVal;best_loc = maxLoc;best_template = path;} } - 报警逻辑:设

quality=0.75,若max_score > maxVal*0.75,通过声光报警器(如 Arduino 连接蜂鸣器 + LED)触发报警,并在监控界面弹出红色提示框;

- 多模板制作:收集不同类型刀具(水果刀、匕首、菜刀)的 X 光图像,裁剪为模板(如

- 优势:X 光图像光照固定(无外界光干扰),刀具形状刚性,匹配准确率高(漏检率 < 1%);代码轻量化,可嵌入安检机的嵌入式系统(如 Linux-based 工控机),无需额外 GPU 设备。

5.3 医学影像领域(辅助诊断场景)

医学影像中,“特定结构定位”(如 X 光片的骨骼、CT 的肺部结节)任务满足 “目标刚性、尺度相对固定” 的特点,模板匹配可作为医生的辅助工具,提升诊断效率。

5.3.1 场景:胸部 X 光片肋骨定位

- 应用背景:医生在阅读胸部 X 光片时,需先定位肋骨(判断肋骨是否骨折、畸形),手动定位耗时(每张片需 30 秒~1 分钟),模板匹配可快速标注肋骨位置,辅助医生聚焦分析。

- 任务需求:从胸部 X 光片(灰度图)中定位所有肋骨区域,标注肋骨编号(如第 3 肋骨、第 4 肋骨)。

- 代码适配步骤:

- 模板制作:选取 “标准胸部 X 光片”,裁剪第 1~12 肋骨的局部图像(每根肋骨一个模板,如

rib3_template.jpg、rib4_template.jpg),模板需包含肋骨的典型特征(如肋骨的弯曲弧度、与胸椎的连接部分); - 图像预处理:医学影像通常存在 “灰度不均”(如肺部区域较暗,心脏区域较亮),需先进行直方图均衡化(

equalizeHist),再进行高斯模糊(Size(5,5),医学影像噪声多为低频噪声,需稍大核去噪); - 多肋骨定位:循环匹配每根肋骨的模板,因肋骨呈 “纵向排列”,可限制匹配区域(如第 3 肋骨仅在 X 光片的上 1/3 区域匹配,减少误检):

// 第3肋骨匹配区域:x=50~400,y=100~300(根据X光片尺寸调整) Mat src_roi = src_gaussian(Rect(50, 100, 350, 200)); Mat result; matchTemplate(src_roi, rib3_template, result, TM_CCOEFF_NORMED); // 后续阈值判断、局部极大值检测... // 坐标映射:将ROI内的坐标转换为原图坐标(x +=50, y +=100) - 结果标注:匹配到肋骨后,用不同颜色框标注(如第 3 肋骨绿色、第 4 肋骨蓝色),并标注肋骨编号(

putText(src, "Rib 3", Point(j,i), ...)); - 结果保存:用

imwrite保存标注后的 X 光片,存入医院 PACS 系统(医学影像存储与传输系统),供医生查看。

- 模板制作:选取 “标准胸部 X 光片”,裁剪第 1~12 肋骨的局部图像(每根肋骨一个模板,如

- 优势:辅助医生快速定位肋骨,减少手动定位时间(每张片处理时间 < 200ms);标注结果客观,避免医生因疲劳导致的漏看肋骨;代码无需训练,可快速适配不同医院的 X 光机(仅需调整模板)。

5.4 交通领域(智能交通系统)

交通场景中,“交通标志识别、车牌定位” 等任务满足 “目标刚性、尺度相对固定” 的特点,模板匹配可用于低算力设备(如路边摄像头、车载嵌入式系统)。

5.4.1 场景:限速交通标志检测(如限速 60km/h)

- 应用背景:自动驾驶或智能交通系统(ITS)需识别道路上的限速标志,控制车辆速度(如检测到限速 60,车辆自动将速度降至 60 以下),或抓拍超速车辆。

- 任务需求:从道路相机拍摄的图像中检测限速标志,识别限速值(如 60、80)。

- 代码适配步骤:

- 模板制作:收集不同限速标志的图像(如限速 60、80、100),裁剪标志的圆形区域(含数字),保存为

speed60_template.jpg、speed80_template.jpg(交通标志尺寸固定,如圆形限速标志直径为 60cm,相机距离 10m 时,图像中标志尺寸约为 50×50 像素,模板尺寸与之匹配); - 图像预处理:道路图像光照变化大(如晴天、阴天、傍晚),需先进行 “CLAHE”(对比度受限的自适应直方图均衡化),增强标志与背景的对比:

Ptr<CLAHE> clahe = createCLAHE(2.0, Size(8,8)); clahe->apply(src_gray, src_gray); // 自适应均衡化,避免局部过曝 - 实时检测:道路相机实时拍摄图像(帧率 25fps),代码用

VideoCapture读取视频流,每帧图像进行模板匹配:VideoCapture cap("road_video.mp4"); // 读取视频文件或相机流 while (cap.read(src)) {// 预处理、匹配、标注...imshow("Speed Sign Detection", canvas);if (waitKey(40) == 27) break; // 40ms/帧,对应25fps } - 限速值识别:匹配到限速标志后,根据模板类型确定限速值(如匹配

speed60_template则限速 60),通过 CAN 总线将限速值发送给自动驾驶控制器;

- 模板制作:收集不同限速标志的图像(如限速 60、80、100),裁剪标志的圆形区域(含数字),保存为

- 优势:代码计算量小,可在车载嵌入式设备(如 NVIDIA Jetson Nano)上实时运行(帧率 > 20fps);交通标志形状标准(圆形限速、三角形警告),匹配准确率高(晴天准确率 > 95%);无需训练,可快速添加新的限速值(如限速 120,仅需添加

speed120_template.jpg)。

5.5 零售领域(商品识别与货架管理)

零售场景中,“商品识别、货架商品摆放检查” 等任务满足 “商品包装刚性、尺度固定” 的特点,模板匹配可用于无人超市、智能货架管理。

5.5.1 场景:无人超市商品扫码辅助(如可乐罐识别)

- 应用背景:无人超市中,顾客需将商品放在扫码区,系统自动识别商品并扣款,若商品条形码损坏或位置偏移,扫码失败,需通过图像识别辅助识别商品。

- 任务需求:从扫码区图像中识别商品(如可乐罐),确定商品类型(如可口可乐 330ml),自动关联价格。

- 代码适配步骤:

- 模板制作:拍摄超市所有商品的正面图像(如

coke330_template.jpg、pepsi330_template.jpg),模板需包含商品包装的典型特征(如可乐罐的红色标签、白色字体); - 图像获取:扫码区安装小型相机(如罗技 C920e),拍摄商品图像(确保扫码区光照固定,如 LED 灯带照明,避免阴影);

- 商品定位:扫码区背景简单(多为白色或灰色),商品与背景对比强烈,无需复杂预处理(仅灰度化 + 3×3 高斯模糊),匹配阈值可设

quality=0.8(商品包装可能有轻微变形,需降低阈值); - 商品识别:匹配到商品后,根据模板名称确定商品类型(如

coke330_template对应 “可口可乐 330ml”),从数据库中查询价格(如 3.5 元); - 结果输出:在扫码区屏幕显示商品名称和价格(如 “可口可乐 330ml - 3.5 元”),并触发扣款(通过支付宝 / 微信支付接口);

- 模板制作:拍摄超市所有商品的正面图像(如

- 优势:辅助条形码扫码,解决条形码损坏导致的无法识别问题;代码简单,可快速部署到无人超市的扫码设备(如自助结账机);商品模板更新方便(新增商品仅需拍摄模板,无需修改代码)。

六、代码优化与扩展建议

针对代码的局限性,可通过以下优化手段提升其适用性,满足更复杂的场景需求。

6.1 解决尺度变化:多尺度模板匹配

- 思路:将模板按不同比例缩放(如 0.5x、0.8x、1.0x、1.2x、1.5x),或缩放输入图像,分别进行匹配,取最高匹配值。

- 代码示例:

vector<double> scales = {0.8, 1.0, 1.2}; // 模板缩放比例 double max_score = 0.0; Point best_loc; Size best_size; for (double scale : scales) {Mat scaled_temp;// 缩放模板(INTER_LINEAR:双线性插值,保证缩放后图像平滑)resize(temp_gaussian, scaled_temp, Size(), scale, scale, INTER_LINEAR);// 若缩放后模板大于输入图像,跳过if (scaled_temp.rows > src_gaussian.rows || scaled_temp.cols > src_gaussian.cols)continue;Mat result;matchTemplate(src_gaussian, scaled_temp, result, TM_CCOEFF_NORMED);normalize(result, result, 0,1,NORM_MINMAX);double minVal, maxVal;Point minLoc, maxLoc;minMaxLoc(result, &minVal, &maxVal, &minLoc, &maxLoc);if (maxVal > max_score) {max_score = maxVal;best_loc = maxLoc;best_size = scaled_temp.size(); // 记录最佳模板尺寸} } // 绘制最佳匹配框 rectangle(src, Rect(best_loc.x, best_loc.y, best_size.width, best_size.height), Scalar(0,255,0), 2);

6.2 解决旋转变化:旋转模板匹配

- 思路:将模板按不同角度旋转(如 0°、15°、30°、45°、60°、75°、90°),分别进行匹配,取最高匹配值。

- 代码示例:

vector<int> angles = {0, 15, 30, 45, 60, 75, 90}; // 旋转角度 double max_score = 0.0; Point best_loc; Mat best_rot_temp; for (int angle : angles) {// 计算旋转矩阵(以模板中心为旋转中心)Point2f center(temp_gaussian.cols/2.0, temp_gaussian.rows/2.0);Mat rot_mat = getRotationMatrix2D(center, angle, 1.0);// 旋转模板(WARP_FILL_OUTLIERS:用黑色填充旋转后的空白区域)Mat rot_temp;warpAffine(temp_gaussian, rot_temp, rot_mat, temp_gaussian.size(), WARP_FILL_OUTLIERS, Scalar(0));// 匹配旋转后的模板Mat result;matchTemplate(src_gaussian, rot_temp, result, TM_CCOEFF_NORMED);normalize(result, result, 0,1,NORM_MINMAX);double minVal, maxVal;Point minLoc, maxLoc;minMaxLoc(result, &minVal, &maxVal, &minLoc, &maxLoc);if (maxVal > max_score) {max_score = maxVal;best_loc = maxLoc;best_rot_temp = rot_temp;} } // 绘制最佳匹配框 rectangle(src, Rect(best_loc.x, best_loc.y, best_rot_temp.cols, best_rot_temp.rows), Scalar(0,255,0), 2);

6.3 提升实时性:区域 - of-Interest(ROI)匹配

- 思路:若已知目标大致位置(如交通标志多在道路上方),仅在 ROI 内进行匹配,减少计算区域,提升速度。

- 代码示例:

// 交通标志ROI:图像上1/3区域,x=50~550,y=20~220 Rect roi_rect(50, 20, 500, 200); Mat src_roi = src_gaussian(roi_rect); // 仅在ROI内匹配 Mat result; matchTemplate(src_roi, temp_gaussian, result, TM_CCOEFF_NORMED); // 局部极大值检测... // ROI坐标映射到原图:best_loc.x += roi_rect.x; best_loc.y += roi_rect.y; rectangle(src, Rect(best_loc.x, best_loc.y, temp.cols, temp.rows), Scalar(0,255,0), 2);

七、总结

本文解析的 OpenCV 模板匹配代码是 “无训练目标检测” 的经典实现,核心流程围绕 “图像读取→预处理→匹配计算→后处理→可视化” 展开,通过灰度化、高斯模糊减少干扰,通过TM_CCOEFF_NORMED计算相似度,通过局部极大值检测避免重复标注,最终实现目标定位与分数标注。

代码的优势在于简单、高效、刚性目标鲁棒,适用于工业检测、安防监控、医学影像、交通、零售等领域的 “固定尺度、刚性目标、光照稳定” 场景;局限性在于不支持尺度 / 旋转变化,需通过多尺度、旋转模板等优化手段扩展适用性。

完整代码:

#include<iostream>

#include<opencv2/opencv.hpp>

using namespace std;

using namespace cv;

int main()

{Mat src = imread("test.jpg");string tempname = "fox.jpg";Mat temp = imread(tempname);if (src.empty() || temp.empty()){cout << "No Image..." << endl;system("pause");return -1;}Mat src_gray, src_gaussian;cvtColor(src, src_gray, COLOR_BGR2GRAY);GaussianBlur(src_gray, src_gaussian, Size(3, 3), 0);Mat temp_gray, temp_gaussian;cvtColor(temp, temp_gray, COLOR_BGR2GRAY);GaussianBlur(temp_gray, temp_gaussian, Size(3, 3), 0);Mat result;matchTemplate(src_gaussian, temp_gaussian, result, TM_CCOEFF_NORMED);normalize(result, result, 0, 1, NORM_MINMAX);double minVal, maxVal;Point minLoc, maxLoc;minMaxLoc(result, &minVal, &maxVal, &minLoc, &maxLoc);double quality = 0.88; if (quality <= 0.0)quality = 0.0;if (quality >= 1.0)quality = 1.0;double thresh = maxVal * quality;for (int i = 0; i < result.rows; i++){for (int j = 0; j < result.cols; j++){double val = result.at<float>(i, j);if (val > thresh){if (result.at<float>(i - 1, j - 1) < val &&result.at<float>(i - 1, j) < val &&result.at<float>(i - 1, j + 1) < val &&result.at<float>(i, j - 1) < val &&result.at<float>(i, j + 1) < val &&result.at<float>(i + 1, j - 1) < val &&result.at<float>(i + 1, j) < val &&result.at<float>(i + 1, j + 1) < val){rectangle(src, Rect(j, i, temp.cols, temp.rows), Scalar(0, 255, 0), 2);char text[10];float score = result.at<float>(i, j);sprintf_s(text, "%.2f",score);putText(src, text, Point(j, i), FONT_HERSHEY_SIMPLEX, 0.8, Scalar(0, 0, 255), 2);}}}}Mat canvas(Size(src.cols + temp.cols + 200, src.rows), CV_8UC3, Scalar::all(255));src.copyTo(canvas(Rect(0, 0, src.cols, src.rows)));rectangle(canvas, Rect(src.cols +40 , 50, 200, 80), Scalar(0,255,0), -1);putText(canvas, tempname.substr(0, tempname.find(".")), Point(src.cols + 100 , 100), FONT_HERSHEY_SIMPLEX, 1.3, Scalar(0,0,255), 3);temp.copyTo(canvas(Rect(src.cols + 100, 150, temp.cols, temp.rows)));namedWindow("Demo", WINDOW_NORMAL);imshow("Demo", canvas);waitKey(0);system("pause");return false;

}