【ComfyUI】Flux Schnell Fp8量化版图像生成

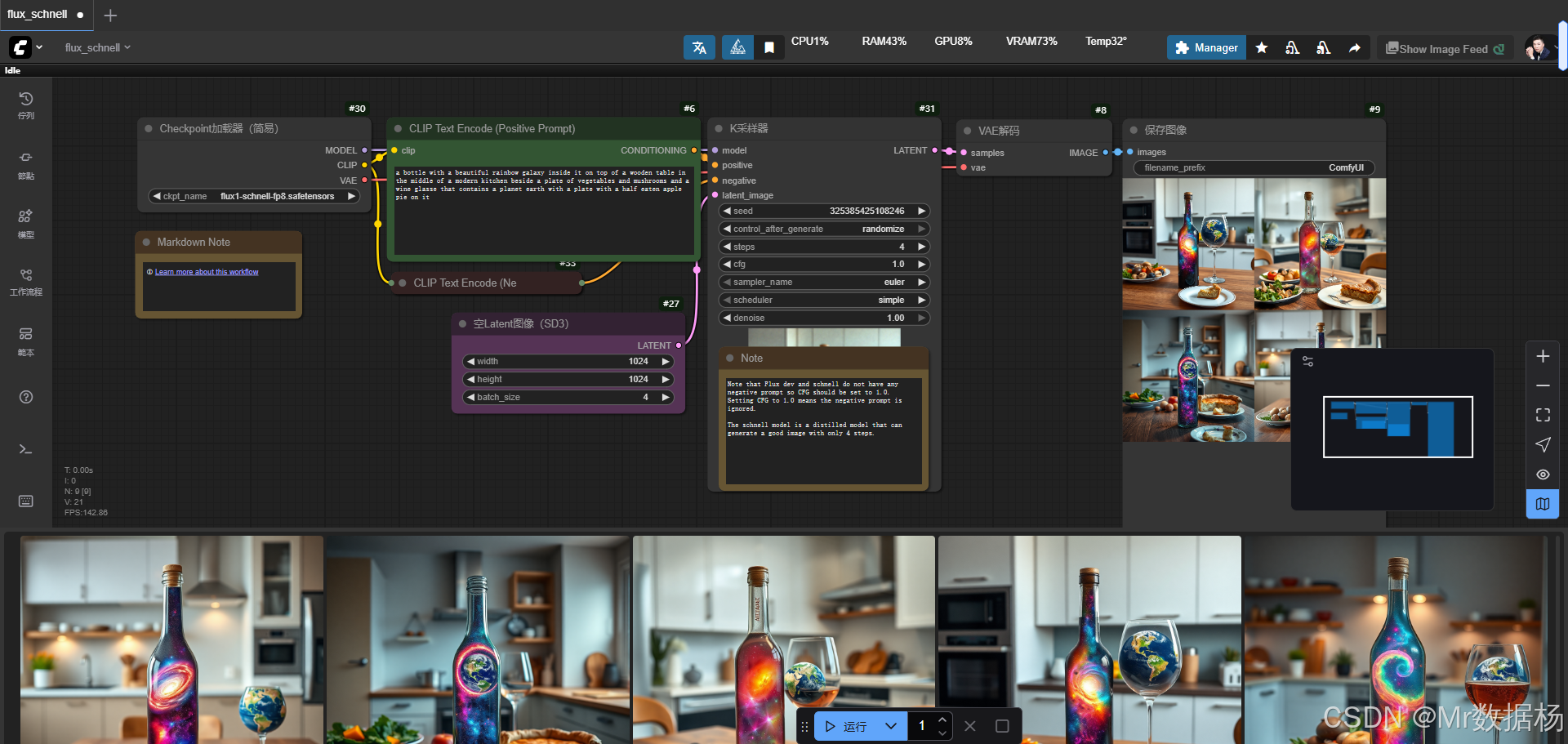

今天展示的案例是一个基于 Flux.1 Krea Dev 微调模型 的 ComfyUI 工作流,该工作流通过加载多组核心模型,结合正负提示词与采样器,将照片真实感推向极致。

整体流程覆盖了模型加载、文本编码、潜空间生成与解码直至最终图像保存,适合在追求高保真细节和真实质感的创作场景中应用。

文章目录

- 工作流介绍

- 核心模型

- Node节点

- 工作流程

- 应用场景

- 开发与应用

工作流介绍

该工作流以 FLUX.1-Krea Dev 为主干模型,配合 VAE 和 CLIP 文本编码器进行图像生成。整体流程的设计使得从输入文本到最终图像的链路清晰而高效,具备极强的还原度与风格表现力。在此过程中,UNet 提供扩散推理的核心能力,DualCLIPLoader 与 TextEncoder 提供语义嵌入,VAE 则完成潜空间与像素空间的映射,整个链路通过 KSampler 控制迭代采样,保证生成结果的稳定与逼真。

核心模型

核心模型部分包含扩散模型、文本编码器和变分自编码器(VAE),三者分别承担了不同的功能模块。扩散模型是生成图像的基础,负责在潜空间中进行逐步采样与重构。文本编码器通过 CLIP 和 T5 双重模型完成正负提示词的特征向量化,使得语义信息能够有效传递到扩散过程中。VAE 则完成潜在特征与实际图像之间的解码与映射,确保结果的视觉质量与细节保真。

| 模型名称 | 说明 |

|---|---|

| flux1-krea-dev_fp8_scaled.safetensors | 核心扩散模型,负责潜空间的采样与生成,提升真实感表现 |

| clip_l.safetensors | 文本编码器 CLIP Large 版本,用于捕捉提示词的语义特征 |

| t5xxl_fp16.safetensors | T5 大模型文本编码器,增强语言理解与复杂提示解析能力 |

| ae.safetensors | VAE 模型,负责潜空间与图像空间的相互转换,保证细节与色彩还原 |

Node节点

工作流节点涵盖了图像生成的全链路组件,每个节点承担特定功能并相互衔接。UNETLoader 与 VAELoader 提供核心模型的加载能力,DualCLIPLoader 与 CLIPTextEncode 用于处理输入提示与负面提示,EmptySD3LatentImage 初始化潜空间,KSampler 在采样过程中控制噪声与步数,ConditioningZeroOut 辅助调整条件输入,最终 VAEDecode 将潜变量解码为图像并通过 SaveImage 节点完成结果保存。整体节点设计使得用户可以灵活组合与修改提示,从而得到最优生成效果。

| 节点名称 | 说明 |

|---|---|

| UNETLoader | 加载扩散模型 UNet,提供核心推理能力 |

| VAELoader | 加载 VAE 模型,建立潜空间与图像空间的映射 |

| DualCLIPLoader | 同时加载 CLIP 与 T5 文本编码器,增强提示词解析能力 |

| CLIPTextEncode | 将文本提示词转化为条件向量,用于正向与负向约束 |

| EmptySD3LatentImage | 初始化空潜空间,用于后续采样与图像生成 |

| KSampler | 控制扩散采样过程,包括步数、算法与噪声调度 |

| ConditioningZeroOut | 对输入条件进行归零或调整,辅助控制生成效果 |

| VAEDecode | 将潜空间特征解码为最终图像 |

| SaveImage | 保存生成图像到指定目录 |

工作流程

该工作流的执行过程从模型加载到图像保存,形成了一条紧密衔接的链路。流程的起点是 UNETLoader、VAELoader 与 DualCLIPLoader,它们共同负责加载扩散模型、VAE 模型和文本编码器,为后续生成提供必要的计算支撑。随后,EmptySD3LatentImage 初始化潜空间,作为采样的起点。通过 CLIPTextEncode 对正面提示与负面提示进行语义编码后,KSampler 在采样阶段接管任务,结合正负条件和噪声控制,逐步迭代生成潜变量。ConditioningZeroOut 则作为辅助环节,用于在条件输入中清除不必要的干扰。采样完成的潜变量由 VAEDecode 解码为图像,最后由 SaveImage 节点输出到指定路径。整个流程高度模块化,既保证了灵活性,也使得结果的可控性和可重复性更强。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型加载 | 加载 UNet 扩散模型、VAE 模型与文本编码器,为生成提供核心算力与语义解析能力 | UNETLoader, VAELoader, DualCLIPLoader |

| 2 | 潜空间初始化 | 构建图像的潜在表示,定义分辨率与通道数,为采样阶段奠定基础 | EmptySD3LatentImage |

| 3 | 文本提示编码 | 将正负提示词转化为向量化条件,输入至采样器作为语义指导 | CLIPTextEncode |

| 4 | 条件优化 | 通过清除或调整条件,保证输入向量的有效性与准确性 | ConditioningZeroOut |

| 5 | 扩散采样 | 执行扩散采样迭代,结合噪声调度与提示条件逐步生成潜变量 | KSampler |

| 6 | 图像解码 | 将生成的潜变量还原为像素图像,实现潜空间到真实画面的转换 | VAEDecode |

| 7 | 图像保存 | 将最终结果输出并保存至指定路径 | SaveImage |

应用场景

该工作流适用于多个高保真视觉生成场景。依托 FLUX.1 Krea Dev 的强大真实感表现力,能够在角色再创作、肖像修复、时尚摄影级渲染等领域展现出色的效果。对比常规扩散模型,该流程在细节保真、肤质纹理、光影氛围等方面拥有明显优势,特别适合创作者和设计师在需要高精度、接近真实摄影效果的场合中使用。例如,影视剧人物的二次创作可以通过输入提示词实现风格与形象的精准还原,电商与广告行业也可依赖该流程生成符合需求的高质量素材。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 影视角色再创作 | 将已有影视角色结合新风格重塑形象 | 二创画师、影视设计师 | 融合风格后的角色肖像 | 保持原有特征的同时增加创意表现 |

| 高端人像生成 | 提供接近真实摄影的肖像作品 | 摄影工作室、设计师 | 高分辨率人像图 | 突出肤质、光影与氛围的细节 |

| 时尚产品渲染 | 渲染服装与配饰的精细画面 | 电商设计师、广告公司 | 服饰与配饰展示图 | 真实光影与材质还原度极高 |

| 艺术风格实验 | 在真实基础上引入抽象与风格化效果 | 艺术创作者 | 带风格化处理的肖像或场景 | 平衡写实与艺术风格的表现 |

| 广告与宣传 | 生成高质量视觉素材以提升传播效果 | 品牌营销人员 | 主题场景与模特宣传图 | 高保真细节增强视觉冲击力 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

ComfyUI使用教程、开发指导、资源下载

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用