[论文阅读] 人工智能 + 软件工程 | 从Dialogflow到Rasa:MUTABOT如何让聊天机器人缺陷无所遁形?

从Dialogflow到Rasa:MUTABOT如何让聊天机器人缺陷无所遁形?

论文信息

- 论文原标题:Extending MUTABOT for Multi-Platform Mutation Testing of Task-Oriented Chatbots(扩展MUTABOT以支持任务型聊天机器人的多平台突变测试)

- 论文链接:https://arxiv.org/pdf/2509.01389

一段话总结

为解决酒店预订、点餐等任务型聊天机器人测试中“场景覆盖不全、缺陷难发现”的问题,研究者将原仅支持Dialogflow的突变测试工具MUTABOT扩展为支持Dialogflow+Rasa多平台,通过设计11类模拟真实缺陷的“突变体”(如删意图、改会话过期时间)评估测试效果;以娱乐(猜拳)、餐饮(点餐)、客服3个Rasa机器人为实验对象,用主流工具Botium生成测试用例后发现,Botium仅能检测43%-77%的突变体,且暴露出现有工具“预言器不准、场景太简单、依赖训练数据”三大核心问题,最终证明需进一步优化聊天机器人测试技术,而MUTABOT为多平台测试提供了新方案。

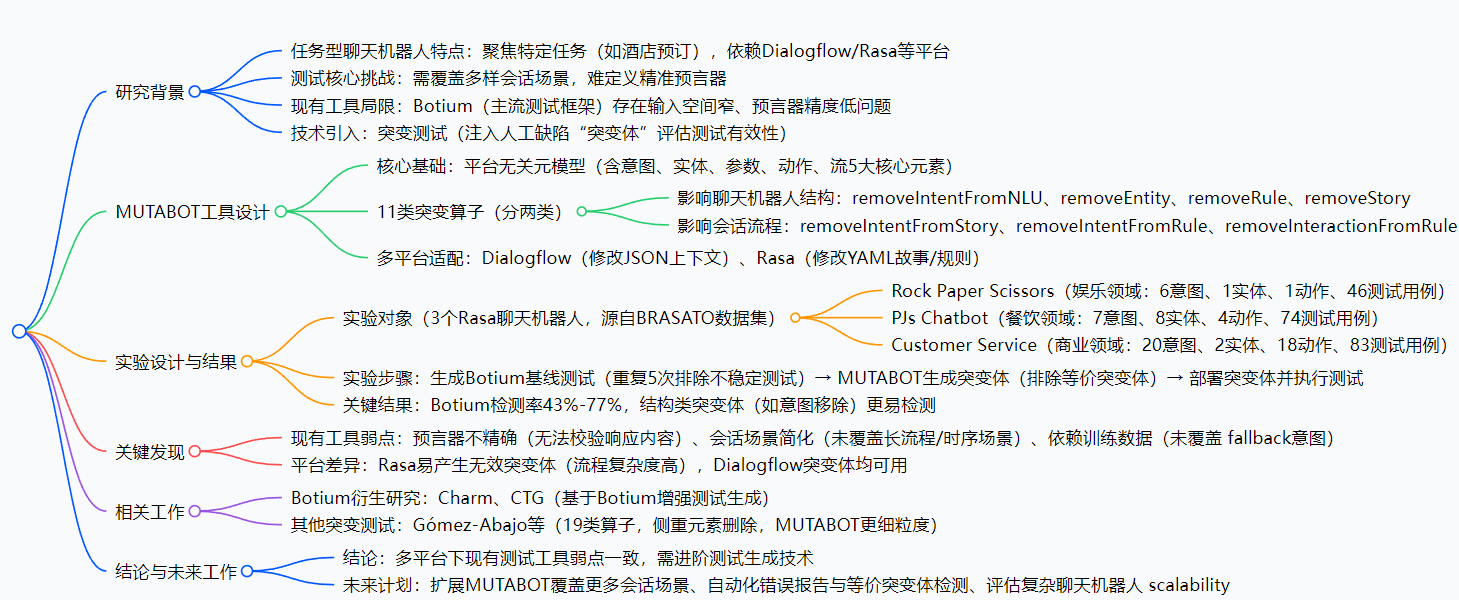

思维导图

研究背景:为什么要做这个研究?

咱们先搞懂一个前提:任务型聊天机器人≠ChatGPT。比如你手机里的“点餐机器人”(选餐→填地址→确认下单)、“酒店预订机器人”,它们只干特定领域的事,不像ChatGPT啥都聊。这类机器人主要靠Dialogflow(谷歌)、Rasa(开源)这些平台开发,但想保证它们“不出错”,测试是个大难题——

举个例子:点餐机器人要覆盖“选汉堡→改配送时间→加薯条→取消订单”等N种会话场景,测试时不仅要穷举场景,还得判断机器人的回复对不对(比如你说“改地址到A小区”,机器人回复“已更改为B小区”,这就错了,但怎么让测试工具自动识别?这就是“预言器”的难题)。

之前大家常用的测试工具是Botium,但它有个大问题:比如机器人因“实体缺失”返回“你选了None套餐”,Botium只看“机器人识别的意图对不对”(比如意图是“选套餐”,没毛病),就判定测试通过,完全没发现“None套餐”这个错误——这就是“预言器不精确”。

另外,之前有个叫MUTABOT的工具,能通过“注缺陷”(比如故意删掉“选套餐”意图)来测测试工具的能力,但它只支持Dialogflow,不支持很多公司用的Rasa。所以研究者才想:把MUTABOT扩展到多平台,既能解决测试工具的“瞎判”问题,又能覆盖更多机器人类型。

创新点:这篇论文的“独特亮点”在哪?

- 多平台适配,打破工具局限:首次让MUTABOT同时支持Dialogflow和Rasa,解决了之前“测不了Rasa机器人”的问题,不管公司用哪个平台开发,都能用MUTABOT测。

- 细粒度突变算子,更贴真实缺陷:设计了11类“注缺陷”的方法,比之前的研究(只侧重“删元素”)更细致。比如“改会话过期时间”(模拟用户聊到一半,机器人忘了之前的内容)、“切换参数传递模式”(模拟下单后地址没传给支付步骤),这些都是真实场景里常出的bug。

- 平台无关元模型,打好多平台基础:先定义了“意图、实体、参数、动作、流”5大核心元素,不管是Dialogflow还是Rasa,都能对应到这些元素上,不用为每个平台重写工具逻辑,效率更高。

- 实证揭露行业痛点:不只是做了个工具,还通过实验明确指出Botium等现有工具的3个致命弱点,给后续测试工具优化指了明路(比如要加强“流程场景测试”“精准预言器”)。

研究方法和思路:一步步看懂MUTABOT是怎么造出来的?

研究者的思路很清晰,分4步走,每一步都解决一个关键问题:

步骤1:设计“平台无关元模型”——解决“多平台怎么统一适配”

先把Dialogflow和Rasa的机器人“拆成通用零件”,定义了5个核心元素:

- 意图:用户想干嘛(比如“选套餐”“改地址”);

- 实体:会话里的关键数据(比如“汉堡”“A小区”);

- 参数:存数据的变量(Rasa里叫“Slots”,比如存用户地址);

- 动作:机器人的操作(比如“回复选餐列表”“调用支付API”);

- 流:会话的交互顺序(比如“选餐→问地址→确认”)。

不管哪个平台的机器人,都能对应到这5个元素,为后续多平台适配打基础。

步骤2:设计11类“突变算子”——解决“怎么注缺陷,模拟真实bug”

把算子分成两类,覆盖“机器人结构”和“会话流程”的缺陷:

| 类型 | 算子例子 | 作用(模拟的bug) |

|---|---|---|

| 结构类(4个) | removeIntentFromNLU | 删掉训练数据里的“选套餐”意图,模拟漏训练 |

| removeEntity | 删掉“地址”实体,模拟关键数据没定义 | |

| 流程类(7个) | changeSessionExpTimeInt | 把会话过期时间从30分钟改成1分钟,模拟失忆 |

| toggleCarryOverSlots | 会话结束时清空地址参数,模拟数据没传递 |

步骤3:多平台适配——解决“不同平台怎么注缺陷”

- 对Dialogflow:改它的JSON配置文件(比如改“上下文”参数,控制会话流程);

- 对Rasa:改它的YAML配置文件(比如改“故事”里的交互步骤,或“规则”里的触发条件)。

步骤4:实验验证——解决“MUTABOT有用吗?现有工具到底行不行?”

实验准备:

- 选3个Rasa机器人(来自公开数据集BRASATO):

- 猜拳机器人(娱乐):6个意图,46个测试用例;

- 点餐机器人(餐饮):7个意图,74个测试用例;

- 客服机器人(商业):20个意图,83个测试用例。

- 用Botium生成测试用例(模拟用户和机器人聊天的对话序列)。

实验步骤:

- 跑Botium测试5次,排除“不稳定测试”(比如偶尔通偶尔不通的用例);

- 用MUTABOT给3个机器人注突变体,手动删掉“等价突变体”(注了缺陷但机器人行为没变的,比如删了一个没用的意图);

- 把注了缺陷的机器人部署到Rasa,再跑Botium测试,统计“能检测出缺陷的比例”(即“杀死突变体”的比例)。

主要成果和贡献:这研究到底有啥用?

1. 核心成果(用表格更清楚)

| 研究问题(RQ) | 实验方法 | 结果 | 大白话解读 |

|---|---|---|---|

| Botium能检测多少突变体? | 3个Rasa机器人+11类突变体 | 总体检测率43%-77%,结构类50%-87%,流程类23%-58% | Botium对“删意图/实体”这类明显缺陷还行,对“改过期时间”这类流程缺陷基本测不出来 |

| 多平台突变测试有啥差异? | Dialogflow vs Rasa | Rasa易生无效突变体(流程复杂),Dialogflow无 | Rasa机器人流程灵活,注缺陷容易搞崩,Dialogflow更简单稳定 |

| 现有工具的核心弱点是啥? | 分析测试失败原因 | 3个弱点:预言器不准、场景简单、依赖训练数据 | Botium不会看回复内容对错,只测短场景,没训练过的场景(比如用户乱输入)完全不测 |

2. 给行业带来的价值

- 对开发者:知道现有工具(比如Botium)的盲区,以后测试时要重点补“流程场景”(比如多轮交互)和“精准校验”(比如检查回复里的地址对不对);

- 对测试工具开发者:指明优化方向——要做“多平台支持”“细粒度缺陷检测”“智能预言器”;

- 提供可复用工具:MUTABOT能直接用在Dialogflow和Rasa机器人测试里,节省重复开发时间。

3. 开源资源

- 实验用的3个Rasa机器人源码:

- 猜拳机器人:https://github.com/naveedeveloper/RASA-RPS-Challenger

- 点餐机器人:https://github.com/ChristianCitterio/pjs_chatbot_rasa

- 客服机器人:https://github.com/farhadmohmand66/customer_care_chatBot

- MUTABOT工具:详见论文附录或作者GitHub仓库(论文未完全公开,可关注arXiv更新)

关键问题(问答形式)

Q1:MUTABOT是怎么做到同时支持Dialogflow和Rasa的?

A:核心是“平台无关元模型”——先把两个平台的机器人都拆成“意图、实体、参数、动作、流”5个通用元素,注缺陷时只针对这些通用元素操作(比如“删意图”),再根据平台特性把操作转成具体配置修改(Dialogflow改JSON,Rasa改YAML),不用为每个平台重写逻辑。

Q2:为什么Botium对“流程类突变体”的检测率这么低(23%-58%)?

A:因为Botium只生成“短交互场景”(比如“选餐→确认”),没覆盖“长流程+时序场景”。比如“改会话过期时间”这个缺陷,需要模拟“用户选餐→停10分钟(超过过期时间)→再问地址”,Botium根本没设计这种测试用例,自然测不出来。

Q3:“预言器不精确”具体会导致什么问题?举个例子说明。

A:预言器是“判断机器人回复对不对的工具”,Botium的预言器只看“意图对不对”,不看“内容对不对”。比如点餐机器人因“实体缺失”,把“选汉堡”回复成“你选了None套餐”,Botium看到“意图是选套餐”没错,就判定测试通过,完全没发现“None套餐”这个错误——这会导致明显的用户体验问题,但测试时查不出来。

Q4:MUTABOT的突变算子和之前的研究比,好在哪?

A:之前的研究(比如Gómez-Abajo等人)只侧重“删元素”(比如删意图、删规则),而MUTABOT多了“流程类算子”(比如改会话过期时间、切换参数传递模式),能模拟更复杂的真实缺陷。比如“参数没传递”这个bug,之前的工具注不出来,MUTABOT能通过“toggleCarryOverSlots”算子模拟。

总结

这篇论文的核心是“解决多平台任务型聊天机器人的测试难题”:首先扩展了MUTABOT工具,让它能测Dialogflow和Rasa两种主流平台的机器人;然后通过11类细粒度突变体,找到了现有工具(Botium)的3个致命弱点;最后用实验证明,现有测试技术远不能满足需求,需要往“多场景覆盖”“精准预言器”“多平台适配”方向优化。

它的价值不只是做了一个工具,更给行业指了明路——以后做聊天机器人测试,不能只盯着“表面意图”,还要关注“深层流程”和“内容正确性”。当然,研究也有不足,比如只测了3个Rasa机器人,未来还需要在更复杂的机器人(比如多轮客服)上验证效果。