论文阅读:SaTML 2023 A Light Recipe to Train Robust Vision Transformers

https://ieeexplore.ieee.org/abstract/document/10136149

速览

训练鲁棒视觉变换器的轻量级配方

该论文《A Light Recipe to Train Robust Vision Transformers》发表于2023年IEEE Conference on Secure and Trustworthy Machine Learning (SaTML),旨在探索视觉变换器(ViTs)在对抗性训练中的潜力,以提升机器学习模型对规避攻击的鲁棒性。尽管以往研究多聚焦于改进卷积神经网络(CNNs),但该论文指出,ViTs同样适合对抗性训练,并能在性能上达到竞争水平。

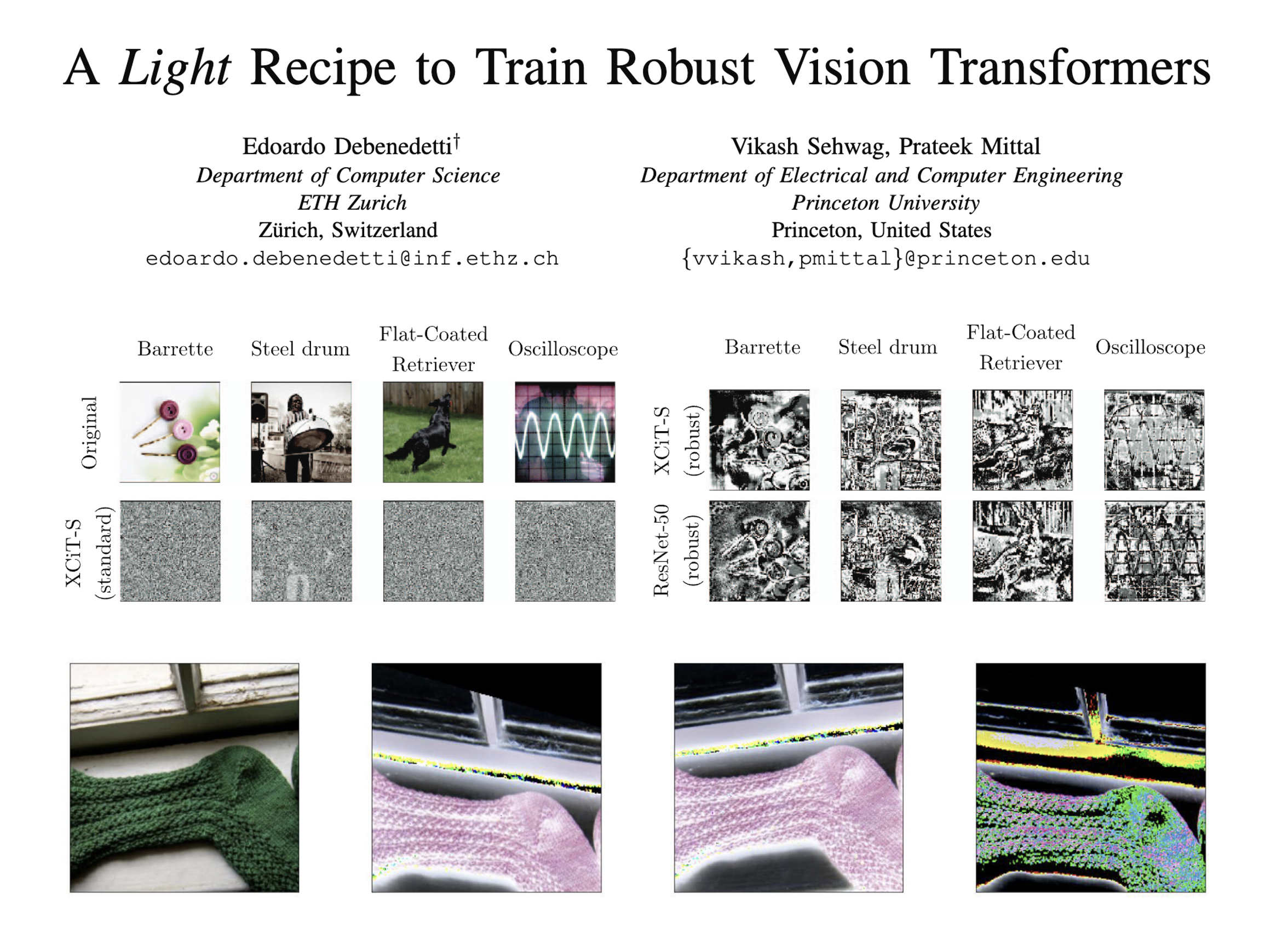

该论文通过在ImageNet数据集的一个子集上进行严格的消融研究,发现了一种定制的对抗性训练配方。研究指出,传统的ViT训练配方推荐使用强数据增强,以弥补注意力模块缺乏视觉归纳偏差的不足。然而,这种配方在对抗性训练中表现欠佳。相反,该论文提出,省略所有重型数据增强,并添加一些额外的技巧(如ε-warmup和更大的权重衰减),可以显著提升鲁棒ViT的性能。此外,该论文还展示了这种配方能够推广到不同类别的ViT架构和大规模模型,并在完整的ImageNet-1k上取得良好的效果。

该论文进一步探讨了模型鲁棒性的原因,发现使用这种配方训练的ViT在训练过程中更容易生成强攻击,这使得模型在测试时具有更好的鲁棒性。此外,论文还提出了一种量化对抗性扰动语义性质的方法,并揭示了其与模型鲁棒性的相关性。该论文建议,研究社区应避免将传统的ViT训练配方直接应用于鲁棒训练,并重新思考对抗性训练中常见的训练选择。

该论文的主要贡献包括:通过消融研究发现了一种轻量级且有效的对抗性训练配方;展示了该配方在不同规模的数据集和模型以及不同类别的ViT架构上的泛化能力;证明了该配方在预训练上的优势可以转移到下游数据集的微调中;并揭示了ViT鲁棒性与对抗性攻击的有效性之间的关系。该论文的研究为提升ViT在对抗性环境下的鲁棒性提供了新的视角和方法,对计算机视觉领域的安全性和可靠性研究具有重要意义。