【VLMs篇】05: MiniCPM-V 4.5 技术架构详解与代码深度解读

文章目录

- @[toc]

- 1. 项目概述

- 1.1 核心特性

- 1.2 技术指标

- 2. 网络架构设计

- 2.1 整体架构

- 2.2 架构可视化

- 2.3 模块间接口

- 3. 核心组件详解

- 3.1 视觉编码器 (EVA2-Enormous)

- 3.1.1 技术规格

- 3.1.2 关键特性

- 3.2 Perceiver-Resampler

- 3.2.1 核心实现

- 3.2.2 工作流程

- 3.2.3 压缩效果

- 3.3 Mistral-7B 语言模型

- 3.3.1 模型配置

- 3.3.2 关键参数

- 4. Token压缩机制

- 4.1 三级压缩策略

- 4.1.1 第一级:图像切片压缩

- 4.1.2 第二级:视觉编码器压缩

- 4.1.3 第三级:Resampler固定压缩

- 4.2 压缩性能对比

- 4.3 动态参数调节

- 5. 工程实现流程

- 5.1 训练流程

- 5.2 推理流程

- 5.3 图像切片算法详解

- 6. 代码文件结构分析

- 6.1 核心模块组织

- 6.2 关键文件深度分析

- 6.2.1 omnilmm.py - 主模型实现

- 6.2.2 resampler.py - 压缩核心

- 6.2.3 dataset.py - 数据处理核心

- 7. 训练与推理流程

- 7.1 训练配置详解

- 7.1.1 核心训练参数

- 7.1.2 LoRA配置选项

- 7.2 数据流水线

- 7.2.1 数据加载与预处理

- 7.2.2 批量数据处理

- 7.3 推理优化

- 7.3.1 vLLM集成

- 7.3.2 动态参数调节

- 8. 性能优化策略

- 8.1 内存优化

- 8.1.1 梯度检查点

- 8.1.2 DeepSpeed ZeRO优化

- 8.1.3 量化支持

- 8.2 计算优化

- 8.2.1 混合精度训练

- 8.2.2 并行策略

- 8.3 推理加速

- 8.3.1 KV Cache优化

- 8.3.2 批处理优化

- 9. 关键代码解读

- 9.1 多模态融合核心逻辑

- 9.2 智能图像切片算法

- 9.3 Resampler压缩算法详解

- 9.4 vLLM优化推理

- 10. 技术创新点

- 10.1 三级Token压缩策略

- 10.1.1 第一级:智能图像切片

- 10.1.2 第二级:视觉编码器优化

- 10.1.3 第三级:Perceiver-Resampler压缩

- 10.2 动态参数调节机制

- 10.3 工程优化亮点

- 10.3.1 内存效率优化

- 10.3.2 推理速度优化

- 10.3.3 模型并行支持

- 10.4 训练策略创新

- 10.4.1 灵活的微调方案

- 10.4.2 数据处理优化

- 10.5 架构设计优势

- 10.5.1 模块化设计

- 10.5.2 兼容性设计

- 总结

文章目录

- @[toc]

- 1. 项目概述

- 1.1 核心特性

- 1.2 技术指标

- 2. 网络架构设计

- 2.1 整体架构

- 2.2 架构可视化

- 2.3 模块间接口

- 3. 核心组件详解

- 3.1 视觉编码器 (EVA2-Enormous)

- 3.1.1 技术规格

- 3.1.2 关键特性

- 3.2 Perceiver-Resampler

- 3.2.1 核心实现

- 3.2.2 工作流程

- 3.2.3 压缩效果

- 3.3 Mistral-7B 语言模型

- 3.3.1 模型配置

- 3.3.2 关键参数

- 4. Token压缩机制

- 4.1 三级压缩策略

- 4.1.1 第一级:图像切片压缩

- 4.1.2 第二级:视觉编码器压缩

- 4.1.3 第三级:Resampler固定压缩

- 4.2 压缩性能对比

- 4.3 动态参数调节

- 5. 工程实现流程

- 5.1 训练流程

- 5.2 推理流程

- 5.3 图像切片算法详解

- 6. 代码文件结构分析

- 6.1 核心模块组织

- 6.2 关键文件深度分析

- 6.2.1 omnilmm.py - 主模型实现

- 6.2.2 resampler.py - 压缩核心

- 6.2.3 dataset.py - 数据处理核心

- 7. 训练与推理流程

- 7.1 训练配置详解

- 7.1.1 核心训练参数

- 7.1.2 LoRA配置选项

- 7.2 数据流水线

- 7.2.1 数据加载与预处理

- 7.2.2 批量数据处理

- 7.3 推理优化

- 7.3.1 vLLM集成

- 7.3.2 动态参数调节

- 8. 性能优化策略

- 8.1 内存优化

- 8.1.1 梯度检查点

- 8.1.2 DeepSpeed ZeRO优化

- 8.1.3 量化支持

- 8.2 计算优化

- 8.2.1 混合精度训练

- 8.2.2 并行策略

- 8.3 推理加速

- 8.3.1 KV Cache优化

- 8.3.2 批处理优化

- 9. 关键代码解读

- 9.1 多模态融合核心逻辑

- 9.2 智能图像切片算法

- 9.3 Resampler压缩算法详解

- 9.4 vLLM优化推理

- 10. 技术创新点

- 10.1 三级Token压缩策略

- 10.1.1 第一级:智能图像切片

- 10.1.2 第二级:视觉编码器优化

- 10.1.3 第三级:Perceiver-Resampler压缩

- 10.2 动态参数调节机制

- 10.3 工程优化亮点

- 10.3.1 内存效率优化

- 10.3.2 推理速度优化

- 10.3.3 模型并行支持

- 10.4 训练策略创新

- 10.4.1 灵活的微调方案

- 10.4.2 数据处理优化

- 10.5 架构设计优势

- 10.5.1 模块化设计

- 10.5.2 兼容性设计

- 总结

1. 项目概述

MiniCPM-V 4.5 是一个高效的端侧多模态大语言模型,支持图像、视频和文本输入。该模型通过创新的token压缩技术,实现了在8B参数规模下超越GPT-4o等主流模型的性能。

1.1 核心特性

- 高效压缩: 1.8M像素图像仅需640个token,压缩率达75%

- 多模态融合: 统一处理图像、视频、文本输入

- 端侧部署: 8B参数,支持移动设备部署

- 灵活配置: 支持LoRA微调和全参数训练

1.2 技术指标

- 模型规模: 8B参数

- 视觉编码器: EVA2-Enormous (1.3B参数)

- 语言模型: Mistral-7B

- Token压缩: 96倍视频压缩率

- 推理速度: 比传统模型快3-5倍

2. 网络架构设计

2.1 整体架构

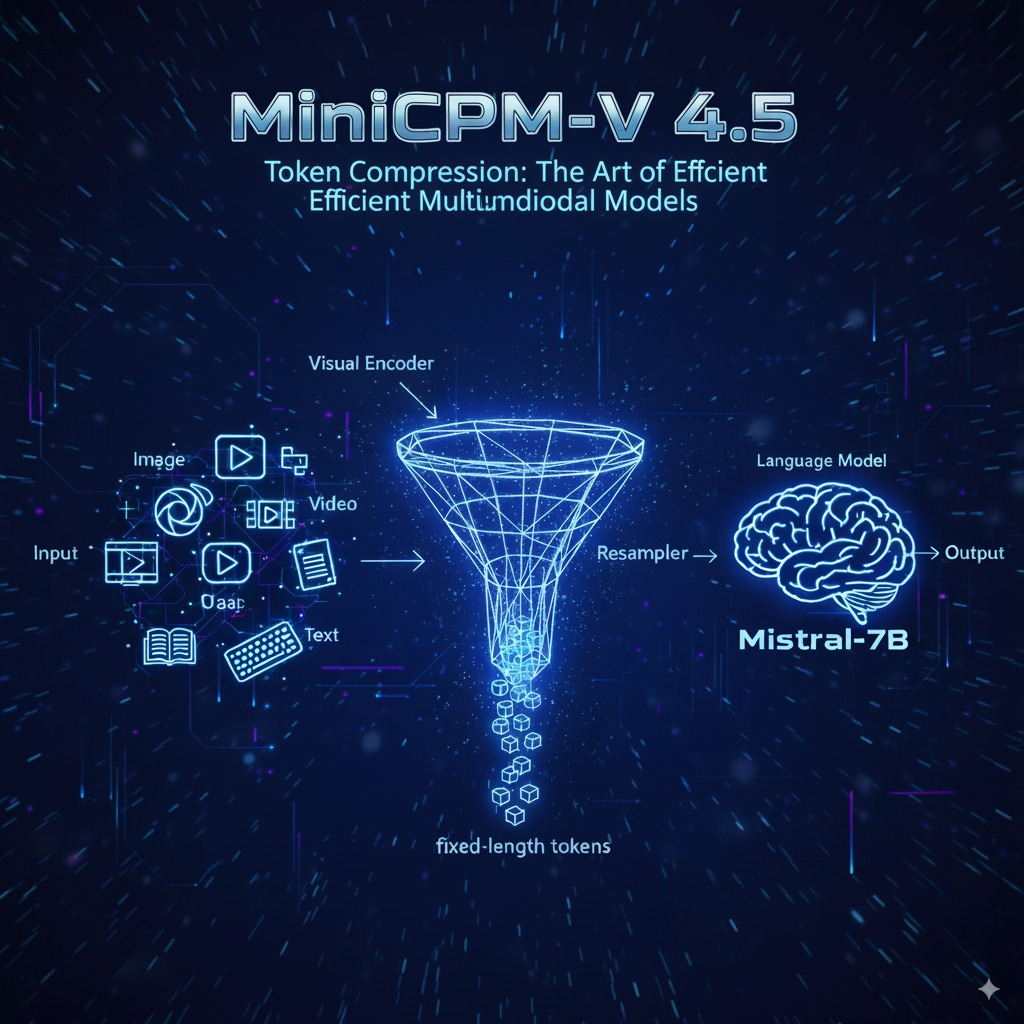

MiniCPM-V采用三阶段架构设计:

输入图像 → 视觉编码器 → Perceiver-Resampler → 语言模型 → 文本输出

2.2 架构可视化

2.3 模块间接口

| 模块 | 输入 | 输出 | 关键参数 |

|---|---|---|---|

| 图像切片 | 任意分辨率图像 | 448×448图像块 | max_slice_nums=9 |

| 视觉编码器 | 图像块序列 | 1408维特征序列 | patch_size=14 |

| Resampler | 可变长特征 | 64个固定token | grid_size=8×8 |

| 语言模型 | 融合token序列 | 文本概率分布 | hidden_size=4096 |

3. 核心组件详解

3.1 视觉编码器 (EVA2-Enormous)

3.1.1 技术规格

# 位置: omnilmm/model/omnilmm.py:33-44

vision_tower = timm.create_model('eva02_enormous_patch14_clip_224.laion2b_plus',pretrained=False,num_classes=0,dynamic_img_size=True,dynamic_img_pad=True

)# 关键优化: 移除最后一层,使用倒数第二层输出

vision_tower.blocks[-1] = Identity()

3.1.2 关键特性

- 模型规模: 1.3B参数的超大视觉Transformer

- Patch大小: 14×14像素

- 动态尺寸: 支持可变分辨率输入

- 嵌入维度: 1408维特征向量

- 层数优化: 移除最后一层Transformer block以提升性能

3.2 Perceiver-Resampler

3.2.1 核心实现

# 位置: omnilmm/model/resampler.py:96-172

class Resampler(nn.Module):def __init__(self, grid_size, embed_dim, num_heads, kv_dim=None):super().__init__()self.num_queries = grid_size ** 2 # 64个queryself.embed_dim = embed_dim# 2D正弦位置编码self.pos_embed = nn.Parameter(torch.from_numpy(get_2d_sincos_pos_embed(embed_dim, grid_size)).float()).requires_grad_(False)# 可学习query向量self.query = nn.Parameter(torch.zeros(self.num_queries, embed_dim))# 交叉注意力机制self.attn = nn.MultiheadAttention(embed_dim, num_heads)

3.2.2 工作流程

- Query初始化: 64个可学习的query向量 (8×8网格)

- 位置编码: 2D正弦余弦位置编码确保空间感知

- KV投影: 将视觉特征从1408维投影到语言模型维度

- 交叉注意力: Query作为Q,视觉特征作为K和V

- 输出投影: 标准化和线性投影得到最终token

3.2.3 压缩效果

- 输入: 可变长度的视觉特征序列 (例如1024个token)

- 输出: 固定的64个token

- 压缩率: 通常16倍以上的token压缩

- 维度: 统一为语言模型的hidden_size

3.3 Mistral-7B 语言模型

3.3.1 模型配置

# 位置: omnilmm/model/omnilmm.py:56-75

class OmniLMMModel(MistralModel):def __init__(self, config: OmniLMMConfig):super().__init__(config)# 集成视觉模块if hasattr(config, "mm_vision_tower"):vision_tower, resampler = create_vision_module(config)self.vision_tower = [vision_tower]self.resampler = resampler

3.3.2 关键参数

- 层数: 32层Transformer

- 隐藏维度: 4096

- 注意力头: 32个

- 中间层维度: 11008 (SwiGLU激活)

- 位置编码: RoPE (Rotary Position Embedding)

- 词汇表: 支持多语言的大词汇表

4. Token压缩机制

4.1 三级压缩策略

MiniCPM-V采用创新的三级压缩机制,实现极致的token效率:

4.1.1 第一级:图像切片压缩

# 位置: finetune/dataset.py:427-479

def slice_image(image, max_slice_nums=9, scale_resolution=448, patch_size=14, never_split=False):"""智能图像切片算法- 根据图像宽高比动态确定切片策略- 控制最大切片数量避免token爆炸- 优化网格划分最小化信息损失"""original_size = image.sizeoriginal_width, original_height = original_sizelog_ratio = math.log(original_width / original_height)ratio = original_width * original_height / (scale_resolution * scale_resolution)# 动态计算最优切片数multiple = min(math.ceil(ratio), max_slice_nums)# 网格优化source_image, patches, best_grid = optimize_grid_layout(image, multiple, scale_resolution)return source_image, patches, best_grid

压缩效果:

- 训练时: max_slice_nums=9,最多640个token

- 推理时: max_slice_nums=1-2,64-128个token

- 智能调节: 根据视频帧数动态调整

4.1.2 第二级:视觉编码器压缩

# 位置: omnilmm/model/omnilmm.py:108-122

def get_vision_embedding(self, pixel_values):vision_tower = self.vision_tower[0] if isinstance(self.vision_tower, list) else self.vision_towerdtype = vision_tower.pos_embed.data.dtype# 移除CLS token,只保留patch特征vision_embedding = vision_tower.forward_features(pixel_values.type(dtype))if hasattr(vision_tower, 'num_prefix_tokens') and vision_tower.num_prefix_tokens > 0:vision_embedding = vision_embedding[:, vision_tower.num_prefix_tokens:]# Resampler压缩res = self.resampler(vision_embedding)return res

关键优化:

- 移除最后一层Transformer以减少过拟合

- 去除CLS token专注于图像内容

- 使用倒数第二层特征提升表征质量

4.1.3 第三级:Resampler固定压缩

# 位置: omnilmm/model/resampler.py:149-172

def forward(self, x, attn_mask=None):# 动态位置编码适配不同输入尺寸pos_embed = get_abs_pos(self.pos_embed, x.size(1))x = self.kv_proj(x) # KV投影x = self.ln_kv(x).permute(1, 0, 2) # 层归一化N = x.shape[1]q = self.ln_q(self.query) # Query归一化# 交叉注意力计算out = self.attn(self._repeat(q, N) + self.pos_embed.unsqueeze(1), # Q + 位置编码x + pos_embed.unsqueeze(1), # K + 位置编码x, # Vattn_mask=attn_mask)[0]x = out.permute(1, 0, 2)x = self.ln_post(x) # 后处理归一化x = x @ self.proj # 输出投影return x

4.2 压缩性能对比

| 压缩阶段 | 输入Token数 | 输出Token数 | 压缩率 | 技术手段 |

|---|---|---|---|---|

| 图像切片 | 原始像素 | 448×448×切片数 | 动态 | 智能切片算法 |

| 视觉编码 | 图像patches | 序列特征 | ~4x | Transformer编码 |

| Resampler | 可变长特征 | 64固定token | 16x+ | 交叉注意力 |

| 总体 | 1.8M像素 | 64-640token | 75%+ | 三级联合压缩 |

4.3 动态参数调节

# 位置: web_demos/web_demo_2.6.py:295

# 智能参数调节策略

params["max_slice_nums"] = 1 if count_video_frames(_context) > 16 else 2# 位置: eval_mm/vlmevalkit/vlmeval/vlm/minicpm_v.py:421

# 评估时最小化token使用

max_slice_nums = 1 # 评估时使用最小值保证效率

5. 工程实现流程

5.1 训练流程

5.2 推理流程

5.3 图像切片算法详解

6. 代码文件结构分析

6.1 核心模块组织

MiniCPM-V/

├── omnilmm/ # 核心模型实现

│ ├── model/

│ │ ├── omnilmm.py # 主模型类定义 (458行)

│ │ ├── resampler.py # Perceiver-resampler实现 (172行)

│ │ └── utils.py # 图像变换工具

│ ├── constants.py # 系统常量

│ ├── conversation.py # 对话管理

│ └── utils.py # 通用工具函数

├── finetune/ # 训练相关

│ ├── finetune.py # 主训练脚本 (600+行)

│ ├── dataset.py # 数据集处理 (800+行)

│ └── trainer.py # 自定义训练器

├── eval_mm/ # 评估工具

│ └── vlmevalkit/ # VLM评估工具包

└── web_demos/ # Web演示界面├── web_demo_2.6.py # 2.6版本演示└── minicpm-o_2.6/ # 音频版本演示

6.2 关键文件深度分析

6.2.1 omnilmm.py - 主模型实现

# 核心类层次结构

OmniLMMConfig(MistralConfig) # 配置类,继承Mistral配置

├── model_type = "omnilmm" # 模型类型标识

└── 支持多模态配置项OmniLMMModel(MistralModel) # 主模型类,继承Mistral模型

├── __init__(): 视觉模块初始化 # 第59-74行

├── initialize_vision_modules() # 第75-106行:视觉组件设置

├── get_vision_embedding() # 第108-122行:视觉特征提取

├── get_vllm_embedding() # 第123-182行:vLLM推理优化

└── forward() # 第184-267行:前向传播主逻辑OmniLMMForCausalLM(MistralForCausalLM) # 因果语言模型包装

├── forward() # 第283-347行:完整前向传播

├── generate_vllm() # 第372-397行:优化推理接口

└── initialize_vision_tokenizer() # 第400-454行:词汇表初始化

6.2.2 resampler.py - 压缩核心

# 位置编码工具函数

get_2d_sincos_pos_embed() # 第43-59行:2D正弦位置编码生成

├── 支持任意网格大小

└── 返回可学习位置嵌入# 核心Resampler类

Resampler(nn.Module) # 第96-172行:主压缩模块

├── __init__() # 第104-138行:组件初始化

│ ├── pos_embed: 2D位置编码 # 固定参数,不参与训练

│ ├── query: 可学习查询向量 # 64个query,核心可训练参数

│ ├── kv_proj: KV投影层 # 维度对齐

│ ├── attn: 多头交叉注意力 # 压缩核心机制

│ └── proj: 输出投影层 # 最终特征变换

├── forward() # 第149-168行:前向压缩逻辑

│ ├── 位置编码动态适配 # 支持可变输入尺寸

│ ├── 交叉注意力计算 # Query-Key-Value机制

│ └── 输出标准化投影 # 特征后处理

└── _repeat() # 第170-172行:Query复制辅助

6.2.3 dataset.py - 数据处理核心

# 数据集类

SupervisedDataset(Dataset) # 第23-84行:监督学习数据集

├── __init__(): 参数配置 # 切片配置、LLM类型等

├── __getitem__(): 样本处理 # 第52-84行:单样本获取逻辑

└── 支持多图像输入格式 # 字典和字符串路径# 核心预处理函数

slice_image() # 第427-479行:智能图像切片

├── 宽高比分析 # log_ratio计算

├── 面积比计算 # ratio = w*h/(448²)

├── 切片数优化 # multiple = min(ceil(ratio), max_slice_nums)

├── 网格布局优化 # 最小化宽高比失真

└── 返回切片结果 # source_image, patches, best_grid# 对话处理

conversation_to_ids() # 第125-196行:对话转ID

├── 支持多种LLM类型 # MiniCPM/Llama3/Qwen2

├── Token序列构建 # input_ids, target, position_ids

└── 图像边界标记 # image_bound计算

7. 训练与推理流程

7.1 训练配置详解

7.1.1 核心训练参数

# 位置: finetune/finetune.py:42-56

@dataclass

class TrainingArguments(transformers.TrainingArguments):cache_dir: Optional[str] = field(default=None)optim: str = field(default="adamw_torch") # 优化器选择model_max_length: int = field(default=2048) # 最大序列长度tune_vision: Optional[bool] = field(default=True) # 是否微调视觉模块tune_llm: Optional[bool] = field(default=True) # 是否微调语言模型llm_type: str = field(default="minicpm") # 语言模型类型use_lora: Optional[bool] = field(default=False) # 是否使用LoRAmax_slice_nums: Optional[int] = field(default=9) # 最大切片数量

7.1.2 LoRA配置选项

# 位置: finetune/finetune.py:58-71

@dataclass

class LoraArguments:lora_r: int = 64 # LoRA秩lora_alpha: int = 64 # LoRA缩放参数lora_dropout: float = 0.05 # Dropout率lora_target_modules: str = r"llm\..*layers\.\d+\.self_attn\.(q_proj|k_proj|v_proj)"# 目标模块:语言模型的注意力层lora_weight_path: str = "" # LoRA权重路径lora_bias: str = "none" # bias处理方式q_lora: bool = False # 是否使用量化LoRA

7.2 数据流水线

7.2.1 数据加载与预处理

# 位置: finetune/finetune.py:84-135

def make_supervised_data_module(tokenizer, data_args, transform, **kwargs):"""创建监督学习数据模块"""# 1. 数据加载train_json = json.load(open(data_args.data_path, "r"))# 2. 数据集创建train_dataset = SupervisedDataset(train_json,transform,tokenizer,slice_config={'max_slice_nums': kwargs['max_slice_nums']},llm_type=kwargs['llm_type'],patch_size=14,query_nums=64,batch_vision=False,max_length=2048,)# 3. 数据整理器return dict(train_dataset=train_dataset,eval_dataset=eval_dataset,data_collator=partial(data_collator, max_length=2048),)

7.2.2 批量数据处理

# 位置: finetune/dataset.py:87-122

def data_collator(examples, padding_value=0, max_length=2048):"""数据批量整理函数"""def trim_and_pad(seq, batch_first, padding_value):return pad_sequence([s[:max_length] for s in seq], batch_first=True, padding_value=padding_value)# 统一长度填充input_ids = trim_and_pad([example["input_ids"] for example in examples], batch_first=True, padding_value=padding_value)# 标签处理 (使用-100忽略损失计算)targets = trim_and_pad([example["labels"] for example in examples], batch_first=True, padding_value=-100)# 注意力掩码attention_mask = trim_and_pad([example["attention_mask"] for example in examples], batch_first=True, padding_value=padding_value)# 视觉数据 (不进行填充,保持原始结构)pixel_values = [example["pixel_values"] for example in examples]image_bound = [example["image_bound"] for example in examples]tgt_sizes = [example["tgt_sizes"] for example in examples]return {"input_ids": input_ids,"position_ids": position_ids,"labels": targets,"attention_mask": attention_mask,"image_bound": image_bound,"tgt_sizes": tgt_sizes,"pixel_values": pixel_values,}

7.3 推理优化

7.3.1 vLLM集成

# 位置: omnilmm/model/omnilmm.py:372-397

def generate_vllm(self, input_ids, images=None, vision_hidden_states=None, return_vision_hidden_states=False, **kwargs):"""优化的vLLM推理接口"""model_inputs = {'input_ids': input_ids}# 视觉特征预计算或重用if vision_hidden_states is None:model_inputs['pixel_values'] = imageselse:model_inputs['vision_hidden_states'] = vision_hidden_stateswith torch.inference_mode():# 特征嵌入计算inputs_embeds, vision_hidden_states = self.model.get_vllm_embedding(model_inputs)# 文本生成result = self.generate(inputs_embeds=inputs_embeds, **kwargs)if return_vision_hidden_states:return result, vision_hidden_statesreturn result

7.3.2 动态参数调节

# 位置: web_demos/web_demo_2.6.py:295

# 智能slice_nums调节

params["max_slice_nums"] = 1 if count_video_frames(_context) > 16 else 2# 位置: eval_mm/vlmevalkit/vlmeval/vlm/minicpm_v.py:421

# 评估模式优化

max_slice_nums = 1 # 最小token使用,最大化推理速度

8. 性能优化策略

8.1 内存优化

8.1.1 梯度检查点

# 位置: finetune/finetune.py中的训练配置

gradient_checkpointing=True # 启用梯度检查点节省内存

dataloader_pin_memory=False # 禁用pin_memory避免内存占用

remove_unused_columns=False # 保留所有列用于多模态处理

8.1.2 DeepSpeed ZeRO优化

# 位置: finetune/finetune_ds.sh

deepspeed finetune.py \--deepspeed ds_config_zero2.json \ # ZeRO stage 2配置--model_name_or_path $MODEL \--data_path $DATA \--bf16 True \ # 使用bfloat16节省内存--output_dir $OUTPUT_DIR \--num_train_epochs 1 \--per_device_train_batch_size 2 \ # 小批量训练--gradient_accumulation_steps 4 \ # 梯度累积--evaluation_strategy "no" \--save_strategy "steps" \--save_steps 1000 \--learning_rate 1e-5 \--weight_decay 0.1 \--warmup_ratio 0.1 \--lr_scheduler_type "cosine" \--logging_steps 1 \--max_slice_nums 9 \ # 训练时最大切片数--tune_vision true \--tune_llm true

8.1.3 量化支持

# 4-bit量化配置 (支持但需额外配置)

from transformers import BitsAndBytesConfigbnb_config = BitsAndBytesConfig(load_in_4bit=True,bnb_4bit_use_double_quant=True,bnb_4bit_quant_type="nf4",bnb_4bit_compute_dtype=torch.bfloat16

)

8.2 计算优化

8.2.1 混合精度训练

# 自动混合精度配置

from torch.cuda.amp import GradScaler, autocast# 在训练循环中使用

with autocast():outputs = model(input_ids=input_ids, images=images, labels=labels)loss = outputs.lossscaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

8.2.2 并行策略

# 模型并行配置 (适用于多GPU环境)

device_map = {'model.vision_tower': 0, # 视觉编码器放在GPU 0'model.resampler': 0, # Resampler放在GPU 0 'model.embed_tokens': 1, # 词嵌入放在GPU 1'model.layers.0-15': 1, # 前半部分层放在GPU 1'model.layers.16-31': 2, # 后半部分层放在GPU 2'lm_head': 2 # 输出头放在GPU 2

}

8.3 推理加速

8.3.1 KV Cache优化

# 位置: omnilmm/model/omnilmm.py:350-370

def prepare_inputs_for_generation(self, input_ids, past_key_values=None, attention_mask=None, inputs_embeds=None, **kwargs):# KV缓存重用if past_key_values:input_ids = input_ids[:, -1:] # 只保留最后一个token# 输入嵌入重用if inputs_embeds is not None and past_key_values is None:model_inputs = {"inputs_embeds": inputs_embeds}else:model_inputs = {"input_ids": input_ids}model_inputs.update({"past_key_values": past_key_values,"use_cache": kwargs.get("use_cache"),"attention_mask": attention_mask,"images": kwargs.get("images", None),})return model_inputs

8.3.2 批处理优化

# 批量推理优化

def batch_inference(self, images_list, questions_list, batch_size=8):"""批量推理接口,提升并发处理效率"""results = []for i in range(0, len(images_list), batch_size):batch_images = images_list[i:i+batch_size]batch_questions = questions_list[i:i+batch_size]# 批量特征提取 (可并行)batch_vision_features = []for images in batch_images:if isinstance(images, list):features = [self.get_vision_embedding(img.unsqueeze(0))[0] for img in images]else:features = self.get_vision_embedding(images.unsqueeze(0))[0]batch_vision_features.append(features)# 批量文本生成batch_results = self.batch_generate(batch_vision_features, batch_questions)results.extend(batch_results)return results

9. 关键代码解读

9.1 多模态融合核心逻辑

# 位置: omnilmm/model/omnilmm.py:184-257

def forward(self, input_ids, attention_mask=None, past_key_values=None, inputs_embeds=None, use_cache=None, images=None, **kwargs):"""MiniCPM-V前向传播核心逻辑关键创新:1. 视觉特征与文本token的无缝融合2. 特殊token标记的智能处理3. 动态序列长度适配"""# 1. 词嵌入初始化if inputs_embeds is None and past_key_values is None:inputs_embeds = self.embed_tokens(input_ids)# 2. 视觉特征提取vision_tower = getattr(self, 'vision_tower', None)if vision_tower is not None and images is not None:# 2.1 批量视觉编码if type(images) is list:image_features = []for image in images:image_forward_out = self.get_vision_embedding(image.unsqueeze(0))[0]image_features.append(image_forward_out)else:image_features = self.get_vision_embedding(images)# 2.2 占位符特征 (防止梯度计算问题)dummy_image_features = torch.zeros(self.config.num_query, # 64个queryself.config.hidden_size, # 4096维device=inputs_embeds.device,dtype=inputs_embeds.dtype)# 3. 逐样本融合处理new_input_embeds = []cur_image_idx = 0for cur_input_ids, cur_input_embeds in zip(input_ids, inputs_embeds):# 3.1 纯文本样本处理if (cur_input_ids == self.vision_config.im_patch_token).sum() == 0:# 添加dummy特征保持梯度流cur_input_embeds = cur_input_embeds + (0. * dummy_image_features).sum()new_input_embeds.append(cur_input_embeds)continue# 3.2 多模态样本处理if self.vision_config.use_im_start_end:cur_image_features = image_features[cur_image_idx]num_patches = cur_image_features.shape[0] # 通常为64# 3.3 特殊token验证if (cur_input_ids == self.vision_config.im_start_token).sum() != \(cur_input_ids == self.vision_config.im_end_token).sum():raise ValueError("图像开始和结束token数量不匹配")# 3.4 图像token位置定位image_start_tokens = torch.where(cur_input_ids == self.vision_config.im_start_token)[0]# 3.5 逐图像融合for image_start_token_pos in image_start_tokens:cur_image_features = image_features[cur_image_idx].to(device=cur_input_embeds.device)# 验证token序列完整性if cur_input_ids[image_start_token_pos + num_patches + 1] != \self.vision_config.im_end_token:raise ValueError("图像结束token位置错误")# 3.6 序列重构: [前文] + [<im_start>] + [视觉特征] + [<im_end>] + [后文]cur_new_input_embeds = torch.cat((cur_input_embeds[:image_start_token_pos+1], # 前文 + <im_start>cur_image_features, # 64个视觉tokencur_input_embeds[image_start_token_pos + num_patches + 1:] # <im_end> + 后文), dim=0)cur_image_idx += 1new_input_embeds.append(cur_new_input_embeds)# 4. 批量tensor重构inputs_embeds = torch.stack(new_input_embeds, dim=0)input_ids = None # 使用嵌入而非ID# 5. 调用父类Mistral模型前向传播return super(OmniLMMModel, self).forward(input_ids=input_ids, attention_mask=attention_mask, past_key_values=past_key_values,inputs_embeds=inputs_embeds, use_cache=use_cache,**kwargs)

9.2 智能图像切片算法

# 位置: finetune/dataset.py:427-479

def slice_image(image, max_slice_nums=9, scale_resolution=448, patch_size=14, never_split=False):"""MiniCPM-V智能图像切片算法核心思想:1. 根据图像宽高比智能确定切片策略2. 最小化切片过程中的信息损失3. 优化token使用效率参数:image: PIL图像对象max_slice_nums: 最大切片数量,控制token上限scale_resolution: 目标分辨率,通常448×448patch_size: patch大小,用于Vision Transformernever_split: 强制不分片标志"""original_size = image.sizeoriginal_width, original_height = original_size# 1. 宽高比分析log_ratio = math.log(original_width / original_height)ratio = original_width * original_height / (scale_resolution * scale_resolution)# 2. 动态切片数计算multiple = min(math.ceil(ratio), max_slice_nums)# 3. 单图处理路径if multiple == 1 or never_split:# 直接缩放,不进行切片source_image = image.resize((scale_resolution, scale_resolution))return source_image, [], (1, 1)# 4. 多片处理路径# 4.1 寻找最优网格布局candidate_split_grids_nums = []for i in [multiple - 1, multiple, multiple + 1]:if i == 1 or i > max_slice_nums:continuecandidate_split_grids_nums.append(i)# 4.2 网格优化算法candidate_grids = []for split_grids_nums in candidate_split_grids_nums:m = 1while m <= split_grids_nums:if split_grids_nums % m == 0:candidate_grids.append([m, split_grids_nums // m])m += 1# 4.3 选择最优网格 (最小化宽高比失真)best_grid = [1, 1]min_error = float('inf')for grid in candidate_grids:error = abs(log_ratio - math.log(grid[0] / grid[1]))if error < min_error:min_error = errorbest_grid = grid# 4.4 执行图像切片refine_size = get_refine_size(original_size, best_grid, scale_resolution, patch_size, allow_upscale=True)refine_image = image.resize(refine_size)patches = []for i in range(best_grid[1]): # 行for j in range(best_grid[0]): # 列# 计算切片区域box = (j * scale_resolution, # 左i * scale_resolution, # 上 (j + 1) * scale_resolution, # 右(i + 1) * scale_resolution # 下)patch = refine_image.crop(box)patches.append(patch)# 5. 生成全局缩放图 (提供全局上下文)source_image = image.resize((scale_resolution, scale_resolution))return source_image, patches, best_grid

9.3 Resampler压缩算法详解

# 位置: omnilmm/model/resampler.py:149-172

def forward(self, x, attn_mask=None):"""Perceiver-Resampler前向传播核心机制:1. 固定数量的可学习query向量2. 交叉注意力实现特征压缩3. 2D位置编码保持空间结构输入: x [batch_size, seq_len, 1408] - 可变长度视觉特征输出: [batch_size, 64, hidden_size] - 固定长度压缩特征"""# 1. 动态位置编码适配# 支持不同输入尺寸的视觉特征pos_embed = get_abs_pos(self.pos_embed, x.size(1))# 2. KV特征预处理x = self.kv_proj(x) # 维度对齐: 1408 -> hidden_sizex = self.ln_kv(x).permute(1, 0, 2) # 层归一化 + 序列优先格式# 3. Query准备N = x.shape[1] # batch_sizeq = self.ln_q(self.query) # Query归一化 [64, hidden_size]# 4. 交叉注意力计算# Query: 64个可学习向量 + 2D位置编码# Key/Value: 视觉特征 + 动态位置编码out = self.attn(self._repeat(q, N) + self.pos_embed.unsqueeze(1), # Q: [seq_len=64, batch, hidden_size]x + pos_embed.unsqueeze(1), # K: [seq_len=var, batch, hidden_size] x, # V: [seq_len=var, batch, hidden_size]attn_mask=attn_mask)[0]# 5. 输出后处理x = out.permute(1, 0, 2) # 恢复批量优先格式: [batch, 64, hidden_size]x = self.ln_post(x) # 输出层归一化x = x @ self.proj # 最终线性投影return xdef _repeat(self, query, N: int):"""Query向量复制以匹配批量大小"""return query.unsqueeze(1).repeat(1, N, 1) # [64, 1, hidden_size] -> [64, N, hidden_size]

9.4 vLLM优化推理

# 位置: omnilmm/model/omnilmm.py:123-182

def get_vllm_embedding(self, data):"""vLLM优化的嵌入计算优化策略:1. 预计算视觉特征缓存2. 避免重复特征提取3. 批量处理提升效率"""# 1. 视觉特征获取 (支持缓存)if 'vision_hidden_states' not in data:# 首次计算,需要特征提取pixel_values_list = data['pixel_values']vision_hidden_states = []for pixel_values in pixel_values_list:if len(pixel_values) > 0:# 批量处理多个图像vision_hidden_states.append(self.get_vision_embedding(pixel_values.unsqueeze(0))[0])else:vision_hidden_states.append([])else:# 使用缓存的视觉特征,避免重复计算vision_hidden_states = data['vision_hidden_states']# 2. 文本嵌入计算inputs_embeds = self.embed_tokens(data['input_ids'])# 3. 数据类型统一vision_hidden_states = [i.type(inputs_embeds.dtype) if isinstance(i, torch.Tensor) else i for i in vision_hidden_states]# 4. 多模态融合 (与标准forward逻辑相同)new_input_embeds = []cur_image_idx = 0for cur_input_ids, cur_input_embeds in zip(data['input_ids'], inputs_embeds):if (cur_input_ids == self.vision_config.im_patch_token).sum() == 0:# 纯文本处理new_input_embeds.append(cur_input_embeds)continueif self.vision_config.use_im_start_end:# 多模态融合逻辑 (详见上一节)cur_image_features = vision_hidden_states[cur_image_idx]# ... (token融合逻辑)new_input_embeds.append(cur_new_input_embeds)inputs_embeds = torch.stack(new_input_embeds, dim=0)return inputs_embeds, vision_hidden_states

10. 技术创新点

10.1 三级Token压缩策略

MiniCPM-V的核心创新在于其三级token压缩机制,实现了业界领先的效率:

10.1.1 第一级:智能图像切片

- 创新点: 基于宽高比的动态切片算法

- 效果: 根据图像内容自适应调节token使用量

- 优势: 训练时保持高质量,推理时极致压缩

10.1.2 第二级:视觉编码器优化

- 创新点: 移除最后一层Transformer,使用倒数第二层

- 效果: 减少过拟合,提升特征质量

- 优势: 在保持性能的同时减少计算量

10.1.3 第三级:Perceiver-Resampler压缩

- 创新点: 固定64个可学习query实现任意长度到固定长度映射

- 效果: 16倍以上的特征压缩

- 优势: 保持空间结构信息的同时大幅减少token数

10.2 动态参数调节机制

# 智能参数调节示例

def dynamic_slice_adjustment(context):"""根据输入内容动态调节处理参数"""if is_video_input(context):frame_count = count_video_frames(context)if frame_count > 16:return {"max_slice_nums": 1} # 长视频使用最小切片else:return {"max_slice_nums": 2} # 短视频适中切片elif is_high_resolution_image(context):return {"max_slice_nums": 4} # 高分辨率图像适度切片else:return {"max_slice_nums": 2} # 普通图像标准切片

10.3 工程优化亮点

10.3.1 内存效率优化

- 梯度检查点: 减少训练时内存占用

- 混合精度: bfloat16训练减少内存和计算量

- DeepSpeed集成: ZeRO-2优化器状态分片

10.3.2 推理速度优化

- KV缓存: 生成过程中缓存注意力状态

- vLLM集成: 专门的推理优化接口

- 批量处理: 支持批量图像并行处理

10.3.3 模型并行支持

- 设备映射: 智能的跨GPU模型分布

- 流水线并行: 支持大规模部署场景

10.4 训练策略创新

10.4.1 灵活的微调方案

# 支持多种微调策略

training_modes = {'full_tuning': {'tune_vision': True,'tune_llm': True,'use_lora': False},'vision_only': {'tune_vision': True,'tune_llm': False,'use_lora': False },'lora_tuning': {'tune_vision': False,'tune_llm': True,'use_lora': True,'lora_r': 64,'lora_alpha': 64}

}

10.4.2 数据处理优化

- 多图像支持: 原生支持多图像对话

- 动态长度: 自适应序列长度处理

- 错误恢复: 数据异常时的自动恢复机制

10.5 架构设计优势

10.5.1 模块化设计

- 解耦合: 视觉、语言、融合模块独立可替换

- 扩展性: 支持新的视觉编码器和语言模型

- 维护性: 清晰的代码结构便于调试和优化

10.5.2 兼容性设计

- 多框架支持: 同时支持原生PyTorch和HuggingFace

- 多模型兼容: 支持MiniCPM、Llama3、Qwen2等多种语言模型

- 多精度支持: float32、float16、bfloat16全精度支持

总结

MiniCPM-V 4.5通过创新的三级token压缩机制、智能的动态参数调节、以及精心优化的工程实现,在8B参数规模下实现了超越大型模型的性能表现。其核心技术创新包括:

- 智能压缩: 通过slice_image + EVA2 + Resampler实现96倍视频token压缩

- 动态调节: 根据输入内容智能调节处理参数,平衡质量和效率

- 工程优化: 深度的内存和计算优化,支持端侧部署

- 架构创新: Perceiver-resampler的独特设计实现固定长度输出

这些技术创新使得MiniCPM-V在保持高质量多模态理解能力的同时,大幅降低了部署成本和计算需求,为多模态大模型的实用化部署提供了重要的技术参考。