从 GPT 到 LLaMA:解密 LLM 的核心架构——Decoder-Only 模型

🔥从 GPT 到 LLaMA:解密 LLM 的核心架构——Decoder-Only 模型

“为什么所有大模型(LLM)都长一个样?”

因为它们都有一个共同的“基因”——Decoder-Only 架构。

在前面两节中,我们学习了:

- BERT:Encoder-Only,擅长“理解语言”

- T5:Encoder-Decoder,统一“理解+生成”

而今天,我们要进入真正引爆 AI 浪潮的主角世界——

🚀 Decoder-Only 模型,也就是当前所有大语言模型(LLM)的“母体”。

从 GPT-1 到 ChatGPT,从 LLaMA 到 GLM,它们虽然名字不同,但都基于同一个核心架构:仅由 Decoder 堆叠而成的 Transformer。

本文将带你深入理解:

- Decoder-Only 是什么?

- GPT 系列如何一步步引爆 LLM 时代?

- LLaMA 和 GLM 又做了哪些关键改进?

准备好了吗?我们出发!

🧬 一、什么是 Decoder-Only 架构?

在原始 Transformer 中,Decoder 本是用于“生成目标语言”的部分,它包含两个注意力机制:

- Masked Self-Attention:只能看到前面的 token(防止“偷看答案”)

- Encoder-Decoder Attention:接收 Encoder 的语义信息

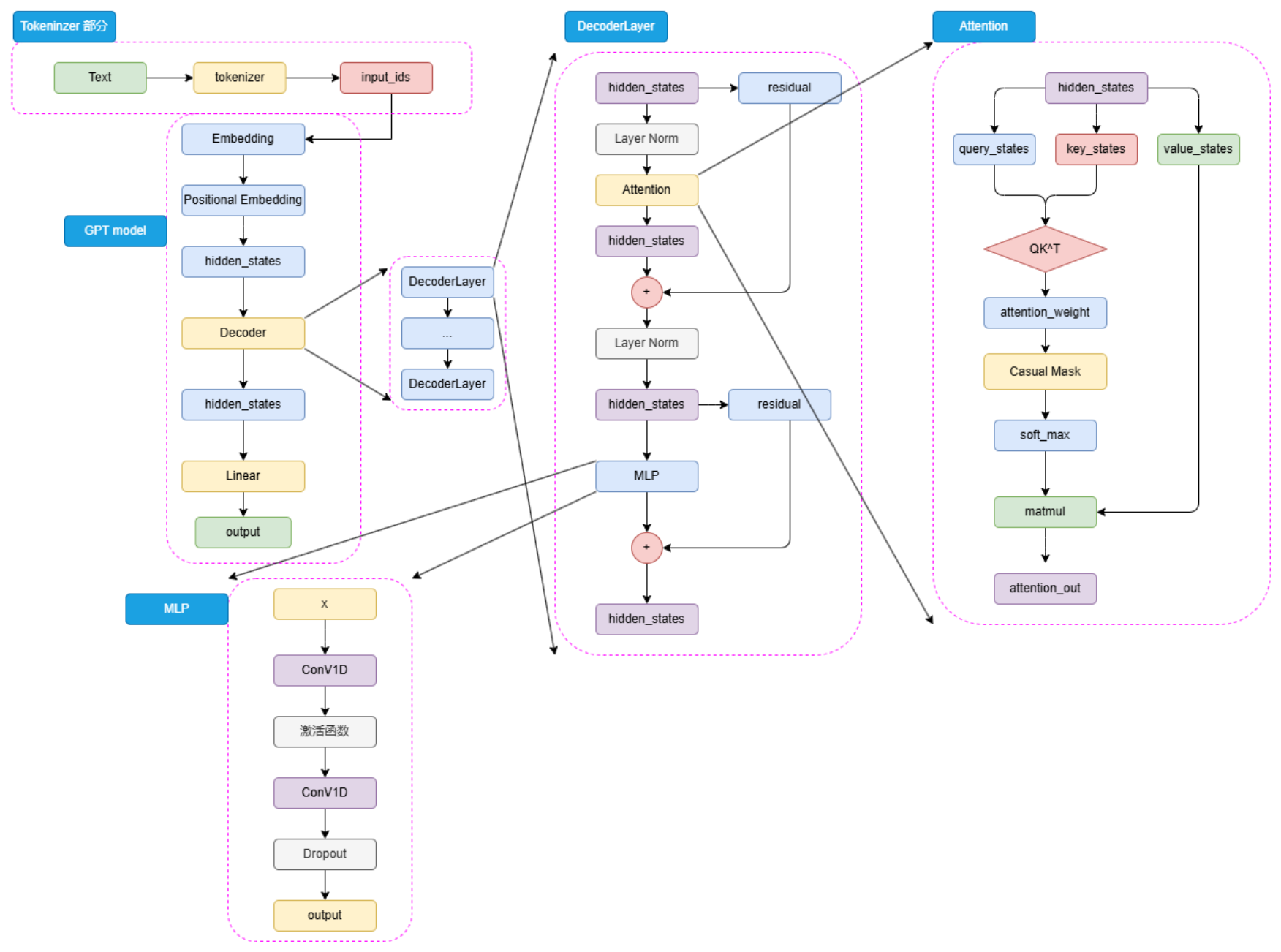

上图为Decoder-Only 模型的模型架构图,Decoder-Only 模型(如 GPT)做了一个大胆的决定:

❌ 去掉 Encoder

❌ 去掉 Encoder-Decoder Attention

✅ 只保留 Masked Self-Attention,自己理解、自己生成

输入文本 → Tokenizer → Embedding → N 层 Decoder → 输出文本这种架构天生适合 自回归生成(Autoregressive Generation):

- 输入:“今天天气”

- 模型预测:“好”

- 接着输入:“今天天气好”,预测下一个词……

- 如此循环,生成完整句子。

✅ 优势:简单、高效、可无限生成文本

❌ 缺点:无法双向理解(但大模型通过“体量”弥补了这一点)

🚀 二、GPT:Decoder-Only 的开山鼻祖

1. 模型架构:Pre-LN + Masked Self-Attention

GPT 的结构与 BERT 类似,但关键区别在于:

| 组件 | GPT 做法 |

|---|---|

| 位置编码 | 使用 Transformer 原始的 Sinusoidal 编码(非可学习) |

| LayerNorm | 采用 Pre-Norm:先归一化再进注意力(更稳定) |

| 注意力机制 | 仅保留 Masked Self-Attention,无 Encoder 交互 |

| MLP 层 | 早期用卷积,后期改用全连接 |

🔍 Pre-Norm 是什么?

在残差连接前做 LayerNorm,能有效缓解梯度消失,适合深层网络。

2. 预训练任务:CLM(因果语言模型)

GPT 使用 CLM(Causal Language Modeling),也就是:

根据前面的词,预测下一个词

例如:

- 输入:

The cat sat on the - 输出:

mat

这本质上是 N-gram 的神经网络升级版,完全契合人类语言生成习惯。

✅ 优势:

- 不需要标注数据,直接用文本训练

- 与下游生成任务(如写作、对话)完全一致

3. GPT 系列的“力大砖飞”之路

| 模型 | 参数量 | 隐藏层 | 层数 | 预训练数据 | 关键突破 |

|---|---|---|---|---|---|

| GPT-1 | 0.12B | 768 | 12 | 5GB | 首提“预训练+微调” |

| GPT-2 | 1.5B | 1600 | 48 | 40GB | 支持 zero-shot |

| GPT-3 | 175B | 12288 | 96 | 570GB | few-shot + 涌现能力 |

📌 GPT-3 的三大革命:

- 参数爆炸:1750亿参数,首次展现“涌现能力”

- 上下文学习(In-context Learning):无需微调,只需给几个例子(few-shot)就能学会新任务

- 稀疏注意力:应对长文本,提升训练效率

💡 举例:情感分类的 few-shot prompt

判断情感:'这真是个绝佳机会' → 正向(1) 示例:'你太棒了' → 1;'太糟糕了' → 0;'好主意' → 1 问题:'这真是个绝佳机会' → ?

这种“提示即编程”的方式,直接催生了 Prompt Engineering 的兴起。

🐫 三、LLaMA:开源 LLM 的标杆

如果说 GPT 是闭源王者,那 LLaMA 就是开源世界的“平民英雄”。

Meta 从 2023 年起陆续发布 LLaMA-1/2/3,成为当前开源 LLM 的事实标准架构。

1. 模型架构:GPT 的“优化版”

LLaMA 整体沿用 GPT 架构,但做了多项关键改进:

| 改进点 | 说明 |

|---|---|

| RoPE 位置编码 | 旋转式位置编码,支持超长上下文(8K~32K) |

| RMSNorm | 替代 LayerNorm,训练更稳定 |

| SwiGLU 激活函数 | 比 ReLU/GELU 更强的非线性能力 |

| GQA(分组查询注意力) | 减少 KV Cache,提升推理速度 |

🔍 GQA 是什么?

将多个注意力头共享 KV 向量,平衡 MQA(单KV)和 MHA(全KV)的性能与效率。

2. LLaMA 系列发展史

| 版本 | 参数 | 上下文 | 训练数据 | 亮点 |

|---|---|---|---|---|

| LLaMA-1 | 7B~65B | 2K | 1T token | 开源,引爆社区 |

| LLaMA-2 | 7B~70B | 4K | 2T token | 支持对话微调 |

| LLaMA-3 | 8B~70B | 8K | 15T token | 128K词表,接近GPT-4 |

✅ LLaMA-3 的 128K 词表大幅提升多语言和代码能力。

🇨🇳 四、GLM:中文 LLM 的独特探索

由智谱 AI(Zhipu AI)开发的 GLM 系列,是中国最早开源的大模型之一。

1. 模型架构:Post-Norm + 简洁设计

GLM 初期尝试了一条不同于 GPT 的路径:

| 特点 | 说明 |

|---|---|

| Post-Norm | 残差连接后归一化,增强鲁棒性 |

| 单层输出头 | 减少参数,提升稳定性 |

| GELU 激活函数 | 平滑非线性,优于 ReLU |

⚠️ 注意:主流模型多用 Pre-Norm,但 GLM 认为 Post-Norm 更稳定。

2. 预训练任务:GLM(空白填充)

GLM 的核心创新是 GLM 预训练任务——结合 MLM 和 CLM:

- 随机遮蔽连续一段文本

- 模型需从上下文预测这段文本,并按顺序生成其中每个 token

例如:

- 输入:

I <MASK> because you <MASK> - 输出:

love you和are a wonderful person

✅ 优势:兼顾理解与生成

❌ 劣势:训练复杂,大模型时代被 CLM 取代

📌 现状:从 ChatGLM2 起,GLM 系列也回归 CLM + GPT 架构。

3. GLM 家族发展

| 模型 | 参数 | 上下文 | 关键能力 |

|---|---|---|---|

| ChatGLM-6B | 6B | 2K | 首个开源中文 LLM |

| ChatGLM2-6B | 6B | 32K | 支持长文本 |

| ChatGLM3-6B | 6B | 32K | 支持函数调用、代码解释器 |

| GLM-4 | 未开源 | 128K | 英文性能对标 GPT-4 |

| GLM-4-9B | 9B | 8K | 开源轻量版,支持工具调用 |

💡 ChatGLM3 开始支持 Agent 开发,可调用工具、执行代码,迈向 AI 自主行动。

🆚 五、三大模型架构对比

| 模型 | 架构 | 预训练任务 | 是否开源 | 代表能力 |

|---|---|---|---|---|

| GPT | Decoder-Only | CLM | ❌ 闭源 | 通用生成、few-shot |

| LLaMA | Decoder-Only | CLM | ✅ 开源 | 高效、可定制 |

| GLM | Decoder-Only | GLM → CLM | ✅ 开源 | 中文强、支持 Agent |

🌟 六、Decoder-Only 为何能统治 LLM 时代?

尽管 BERT 和 T5 在 NLU 任务上曾领先,但 Decoder-Only 最终胜出,原因如下:

-

生成即王道

大模型的核心价值是“对话”“写作”“编程”,生成能力比理解更重要。 -

任务统一性

所有任务都可以转化为“输入提示 → 输出答案”,无需复杂微调。 -

涌现能力(Emergent Ability)

当模型足够大时,CLM 训练的模型反而在理解任务上超越 BERT。 -

工程友好

架构简单,易于分布式训练和推理优化。

📣 结语:LLM 的未来,始于 Decoder-Only

从 GPT-1 的默默无闻,到 GPT-3 的横空出世,再到 LLaMA 和 GLM 的开源繁荣,

Decoder-Only 架构 用十年时间证明了:

“简单、专注、规模” 才是通向 AGI 的最短路径。

如今,几乎所有主流 LLM(包括 Qwen、Baichuan、Yi 等)都基于这一架构。

🔁 所以,要理解大模型,你必须先读懂 GPT。

📚 参考资料:

- 《Language Models are Few-Shot Learners》(GPT-3)

- 《LLaMA: Open and Efficient Foundation Language Models》

- 《GLM: General Language Model Pretraining with Autoregressive Blank Infilling》

- HuggingFace、Meta AI、Zhipu AI 官方文档

- https://github.com/datawhalechina/happy-llm